1 概述

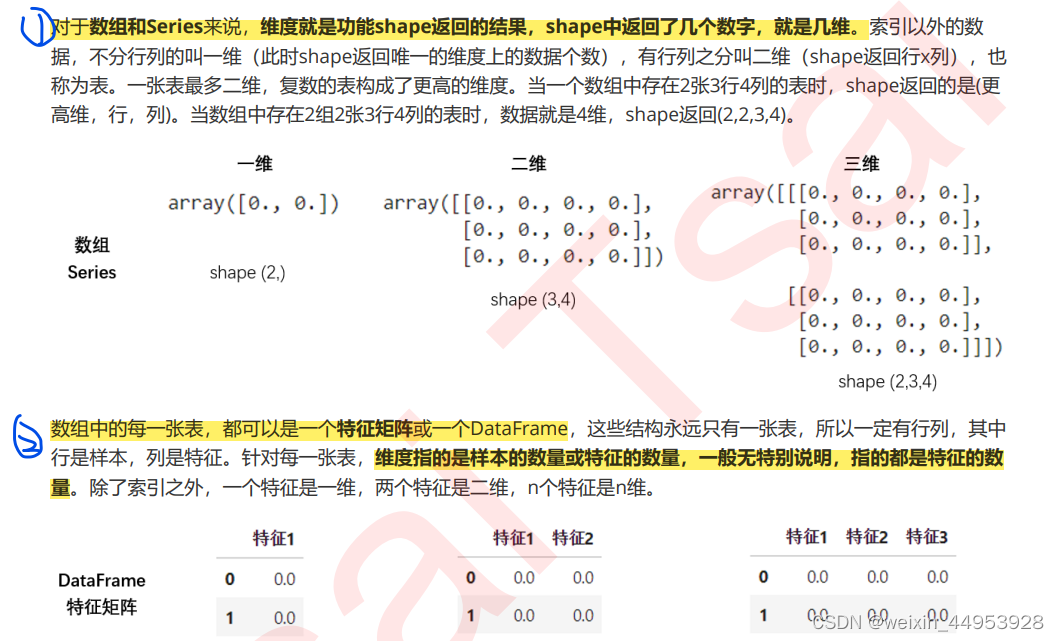

1.1 从什么叫“维度”说开来

1.2 sklearn中的降维算法

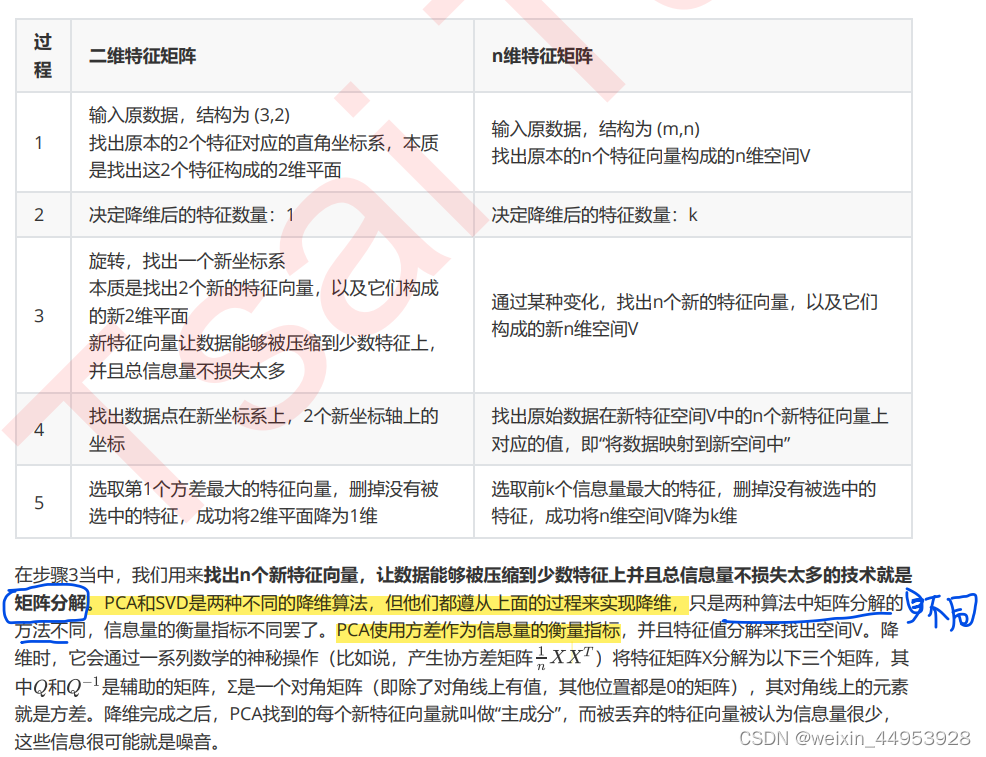

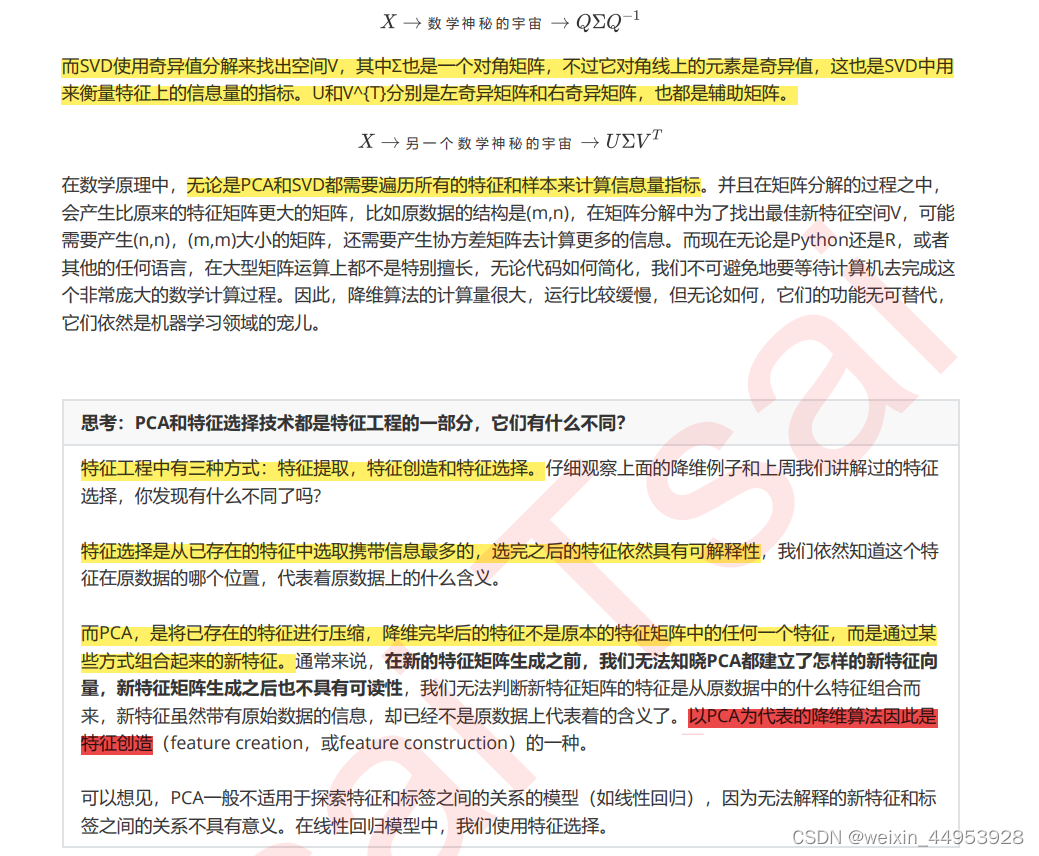

2 PCA与SVD (特征创造)

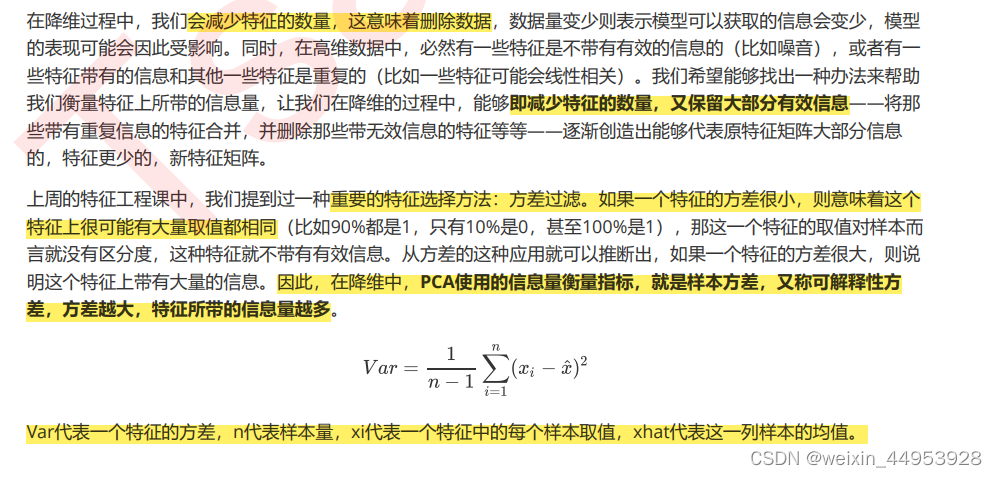

为什么方差计算公式中为什么除数是n-1?

这是为了得到样本方差的无偏估计,更多大家可以自己去探索~

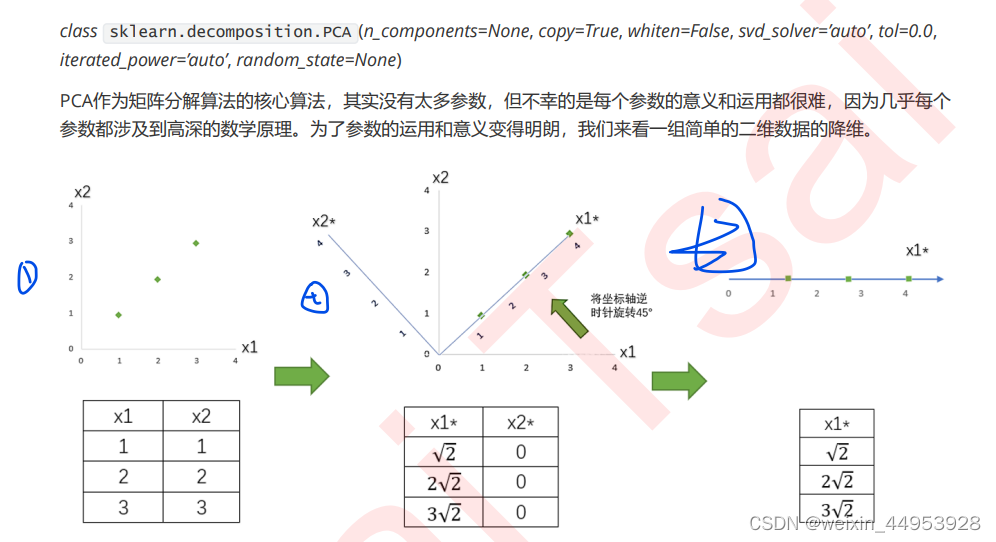

2.1 降维究竟是怎样实现?

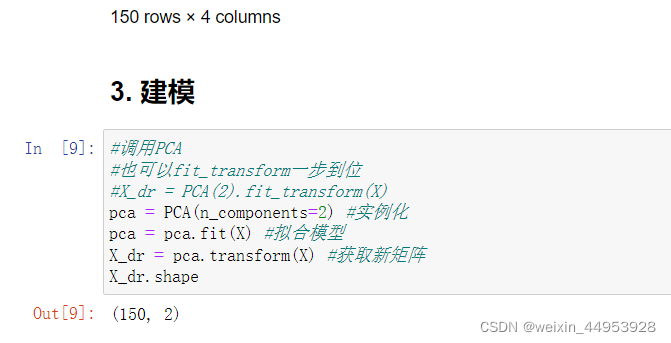

2.2 重要参数n_components(即降维后需要保留的特征数量)

- pca = PCA(n_components=2)

- PCA(n_components=“mle”)

- 按信息量占比选超参数:PCA(n_components=0.97,svd_solver=“full”)

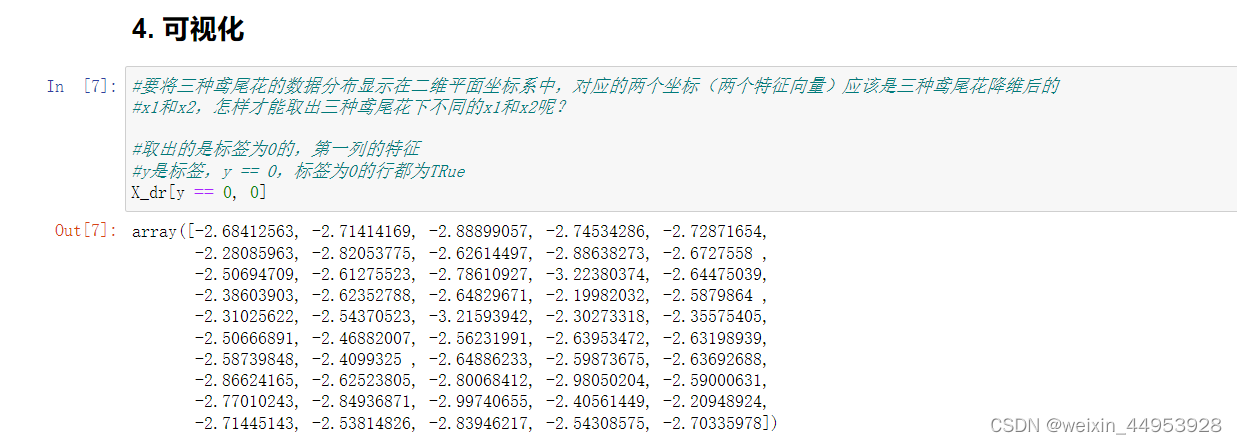

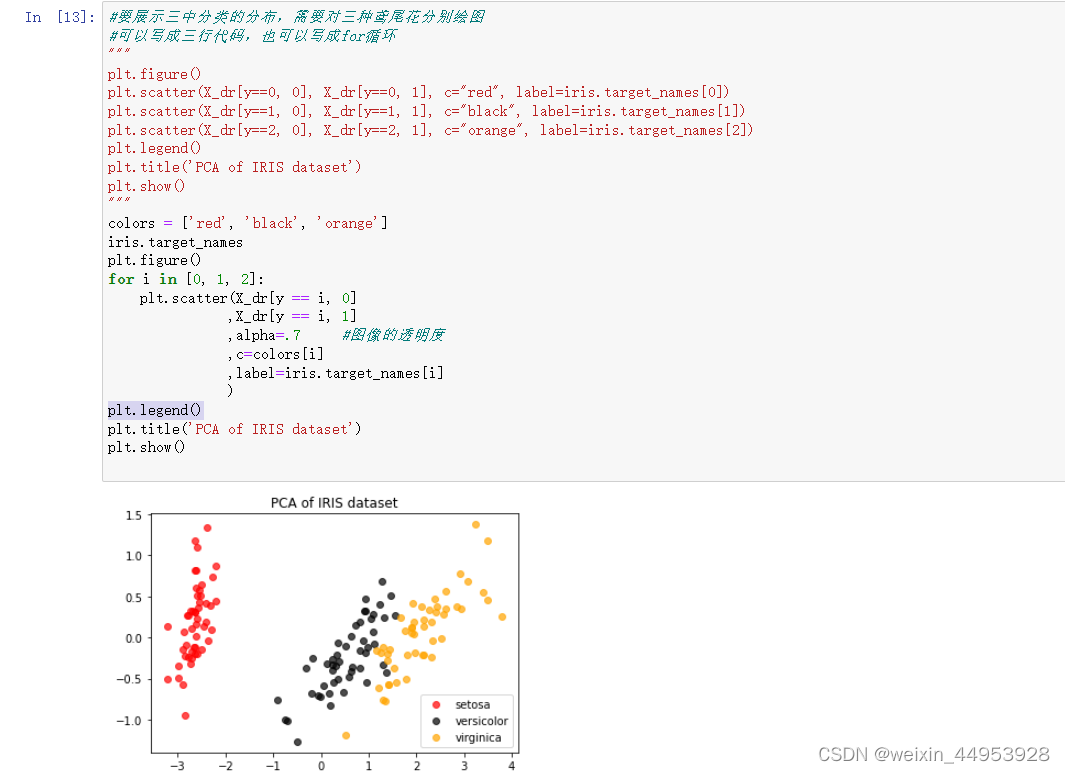

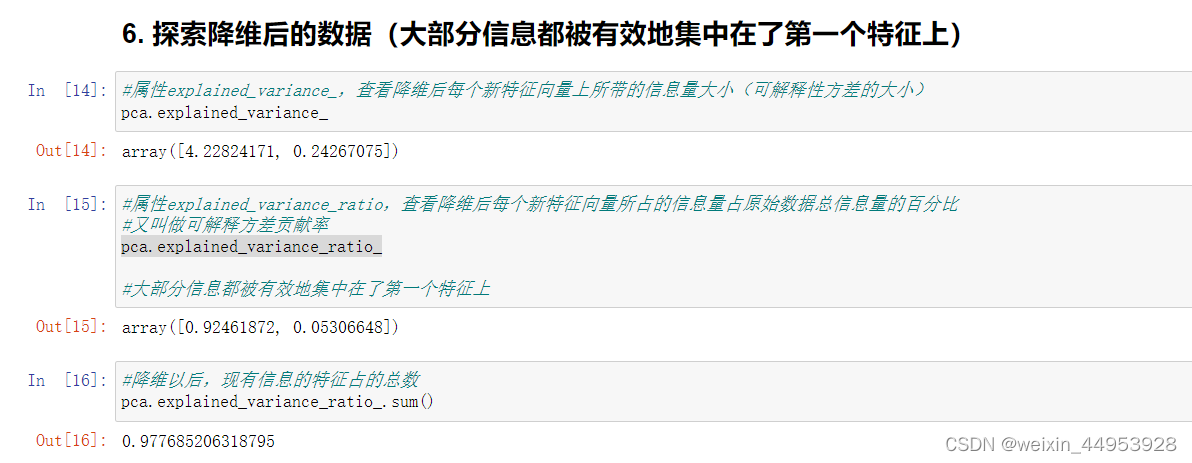

2.2.1 迷你案例:高维数据的可视化

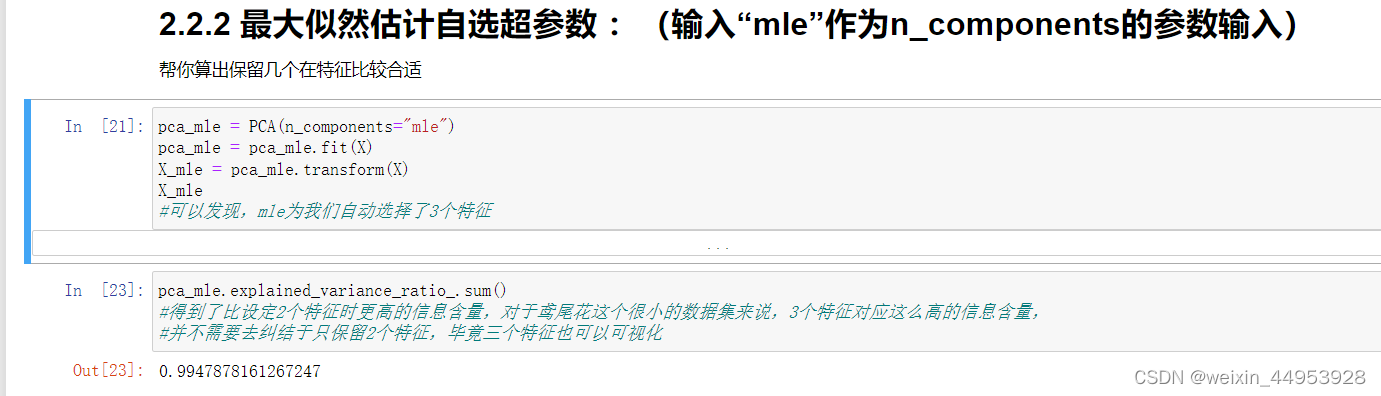

2.2.2 最大似然估计自选超参数 :(输入“mle”作为n_components的参数输入)

帮你算出保留几个在特征比较合适

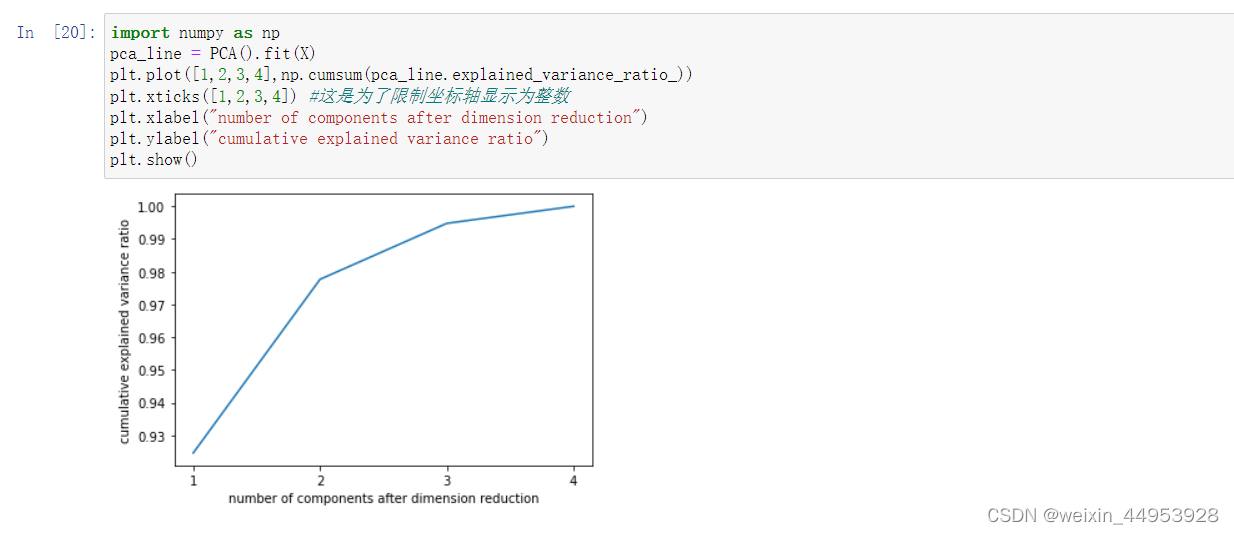

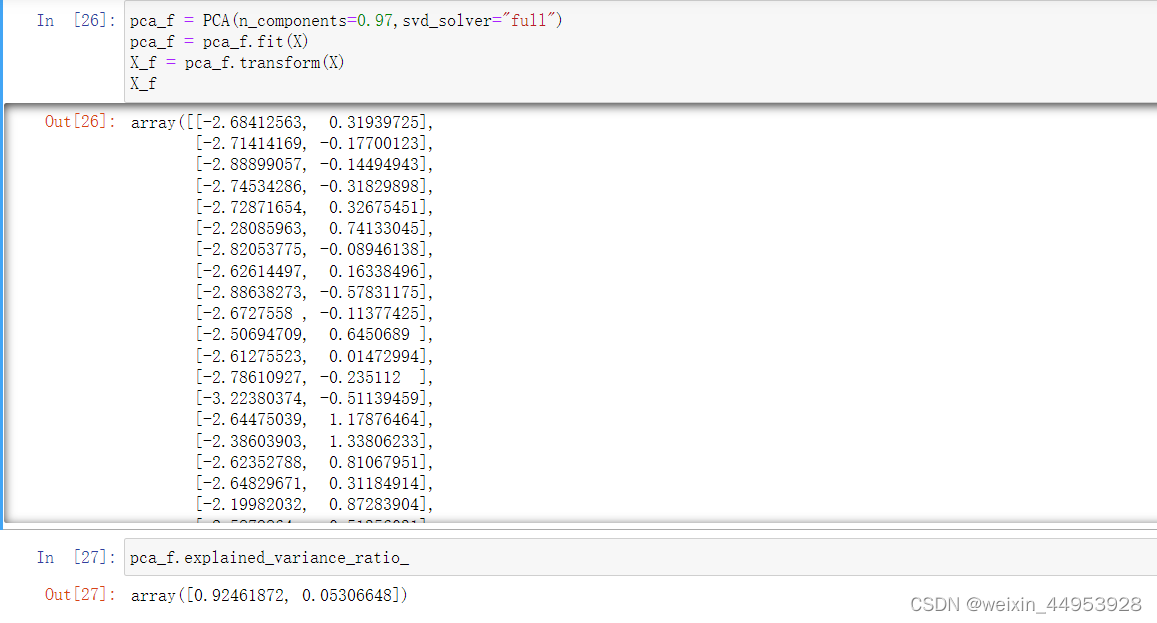

2.2.3 按信息量占比选超参数:PCA(n_components=0.97,svd_solver=“full”)

输入[0,1]之间的浮点数,并且让参数svd_solver ==‘full’,表示希望降维后的总解释性方差占比大于n_components

指定的百分比,即是说,希望保留百分之多少的信息量。

比如说,如果我们希望保留97%的信息量,就可以输入n_components = 0.97,PCA会自动选出能够让保留的信息量超过97%的特征数量。

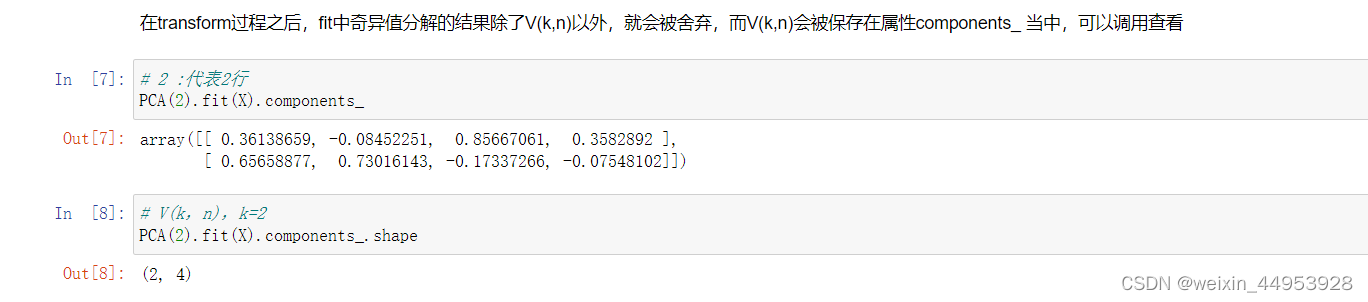

2.3 PCA中的SVD

2.3.1 PCA中的SVD哪里来?

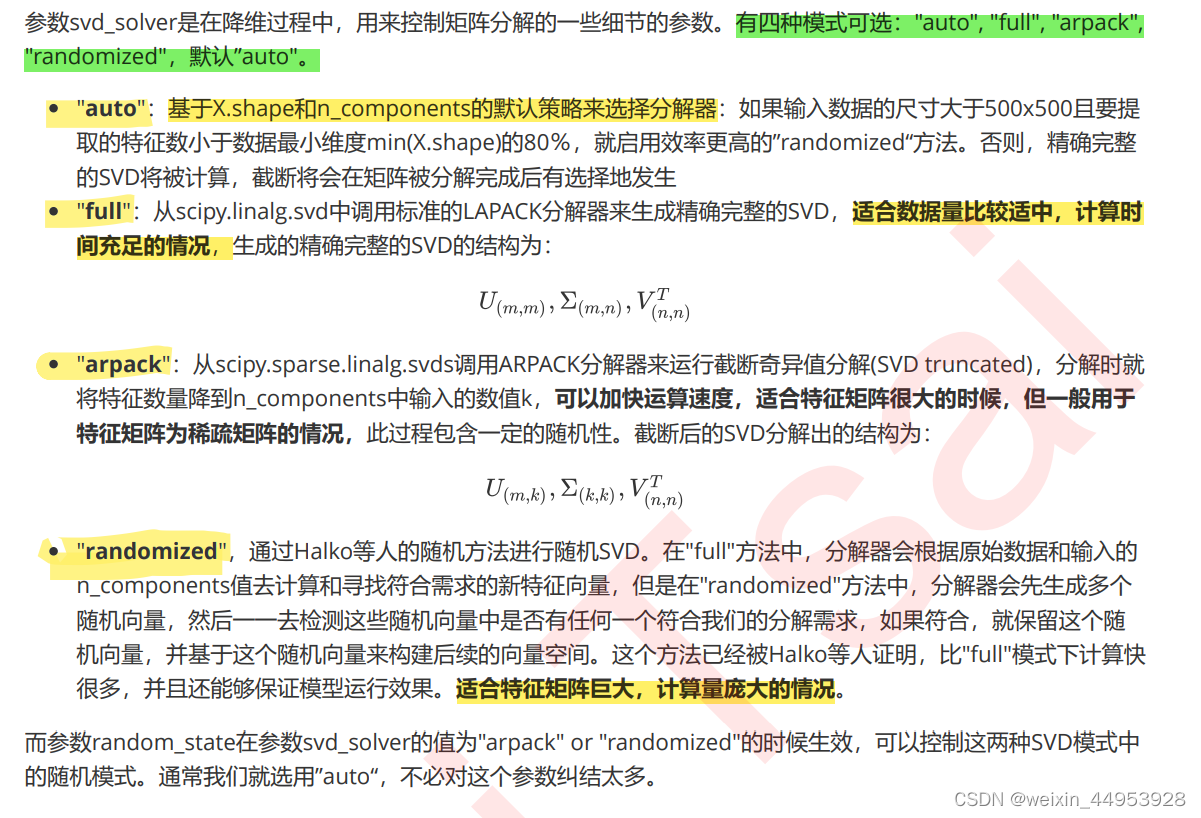

2.3.2 重要参数svd_solver 与 random_state

2.3.3 重要属性components