这篇论文是收录在The Thirty-Fifth AAAI Conference on Artificial Intelligence (AAAI-21)上面关于图神经网络的一篇论文。我看完的感觉是,真的很厉害了!内容很多,看完收获满满!

这篇论文解决了什么问题??

1. 解释了GNN中传播的本质

2.提出了一个新的GNN模型——GCCN

这篇论文采用什么方法解决这个问题的?

1. 文章先介绍了在线性系统中的梯度下降——后面会用到这个过程,然后介绍了各种GNN模型——后面证明本质的时候会用到。然后文章提出了一个GRL框架,通过对这个GRL利用求解的数学优化方式得到了各种GNN的迭代公式。因此就证明,其实各种GNN模型都是对这个GRL的数学优化过程的体现,GNN模型中的传播过程就相当于这个数学优化求解过程。从而,就证明了GNN中传播的本质就是数学优化。

细节在这(暂时是仅我可见,因为有些写论文的思路)https://blog.csdn.net/qq_44689178/article/details/123610130![]() https://blog.csdn.net/qq_44689178/article/details/123610130

https://blog.csdn.net/qq_44689178/article/details/123610130

2. 据作者说,是受到了共轭梯度下降的启发,提出了这个模型。

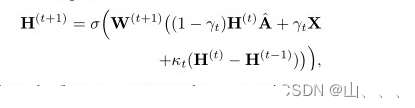

? ?这个模型的形式,就是在GCNⅡ的基础上增加了一个残差( Ht — Ht-1 )

增加了这个残差,可以让模型收敛更快,效果更好!

论文的实验怎么做的?

探究了GCCN在直推式( transductive)和归纳式( inductive)中的表现情况。采用了三到四种共九个数据集,对比了经典算法以及最近提出的一些表现好的算法。

文章的Introduction

看完这一部分,发现有些方向是我没听过的,所以做个记录。这一部分我只记录类似GNN综述的部分。

图神经网络(GNNs) 由于其在不规则数据建模方面的潜力,已成为深度学习领域的一个热门话题。GNN在计算机视觉、自然语言处理、交通预测、化学和医学分析等领域得到了广泛的应用,并取得了良好的性能。现有的GNN可分为两类,谱方法和空间法。

图卷积网络(GCN) (Kipf and Welling 2017)是一个简单、性能良好且富有洞察力的GNN,它通过证明了传播可以由谱图卷积的一阶近似激发,将以上两种观点连接起来。——经典模型

最近的进展也证明了基于空间和基于谱的GNN等效(Balcilar et al,2020年)。从传播的角度增强GCN已经付出了很多努力(Gilmer et al. 2017),如图注意网络(GAT)中的可学习传播权值(Velickovic et al. 2018)、门控注意网络(GaAN) (Zhang et al. 2018)和Probabilistic?GCN (Yang et al. 2020)。Geom-GCN中的结构邻域(Pei etal. 2020)和N-GCN(Abu-El-Haijaetal.2019a)、MixHop(Abu-El-Haija etal. 2019b)、LanczosNet (Liao etal.2019)和Krylov GCN(Luan etal.2019)中的多尺度(多跳)组合。它们的共同理念是:传播是GNN的本质。并且,GCNs的成功归功于传播引入的Laplacian平滑(Li, Han, And Wu 2018)。

不幸的是,GNN最严重的问题是过度平滑,这是通过叠加多个图卷积层进行多次传播造成的,导致性能急剧下降。最近,(Oono和Suzuki 2020)通过将GCN的正向传播推广为一个特定的动力系统,表明了GNN表达能力的指数损失。

为了防止过平滑,提出了两种方法。一方面,第一类中的方法限制了传播。Disen-tangled GCN (Ma et al. 2019)使得每个属性只在部分边缘上传播。DropEdge (Rong et al. 2020)在每个训练回合中随机从输入图中删除一定数量的边,以减少消息传递的不利影响。另一方面,第二类方法用原始属性约束传播结果。PageRank-GCN (Klicpera, Bojchevski, Günnemann 2019)将个性化的PageRank整合到GCN中,结合原始属性。JKNet (Xu et al. 2018)采用密集连接进行多跳消息传递,而DeepGCN (Li et al. 2019)和(GC- NII) (Chen et al. 2020)将残留层合并到GCNs中,以促进深度架构的开发。