文章目录

这次OpenAI官方汇总了一些第三方强化学习环境,其网址为:

https://www.gymlibrary.ml/pages/third_party_environments/

主要包括以下几类

- 视频游戏类

- 棋牌类游戏

- 机器人环境

- 自动驾驶和交通控制类

- 其它一些

这个覆盖内容比较广,从游戏,机器人,自动驾驶,信号灯控制到能源控制,推荐系统等等都有涉及。

废话不多说,赶紧上车!

视频游戏类

飞行小鸟

- https://github.com/Talendar/flappy-bird-gym

gym-derk

- https://gym.derkgame.com/

这是一个3V3的MOBA类游戏,支持几百个实例并行计算,但是是收费的。

MineRL

迷你世界的游戏封装,主要聚焦在稀疏奖励部分。

- https://github.com/minerllabs/minerl

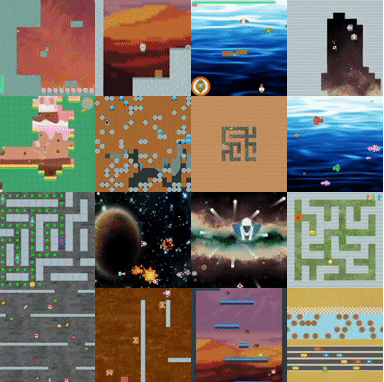

Procgen

16个环境,主要聚焦在强化学习泛化学习技巧

- https://github.com/openai/procgen

Slime Volleyball

1V1博弈类视频游戏

- https://github.com/hardmaru/slimevolleygym

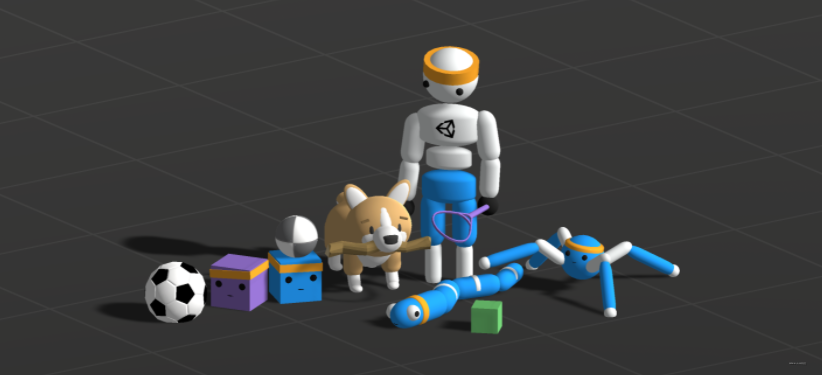

ML-Agents

- https://github.com/Unity-Technologies/ml-agents

Unity写地游戏环境,提供2D,3D,AR、VR类游戏。

棋牌类

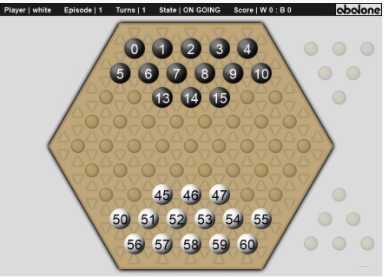

abalone

两个玩家的abstract strategy类游戏:

- https://github.com/towzeur/gym-abalone

spoof

三币游戏,两个玩家,非完美信息,零和博弈类问题:

- https://github.com/MouseAndKeyboard/gym-spoof

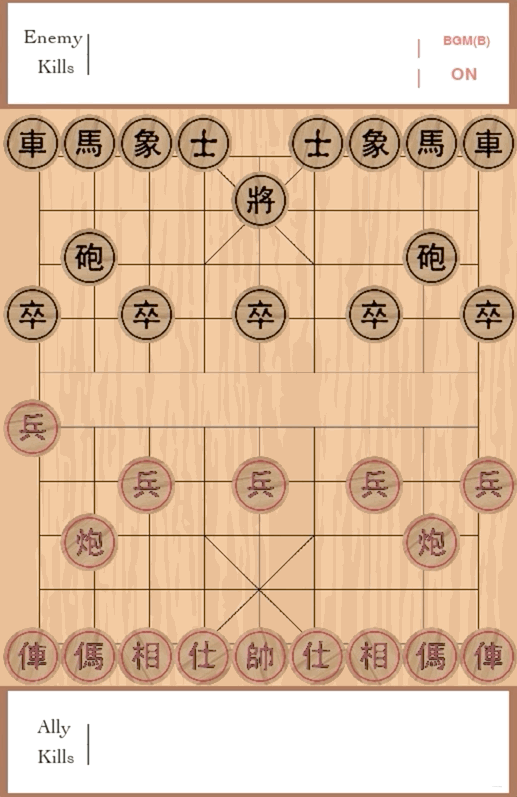

象棋游戏

中国象棋游戏:

- https://github.com/tanliyon/gym-xiangqi

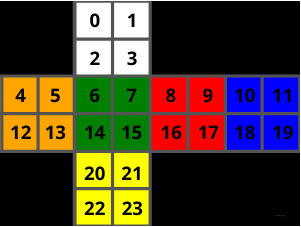

魔方环境

提供了多种魔方环境:

- https://github.com/DoubleGremlin181/RubiksCubeGym

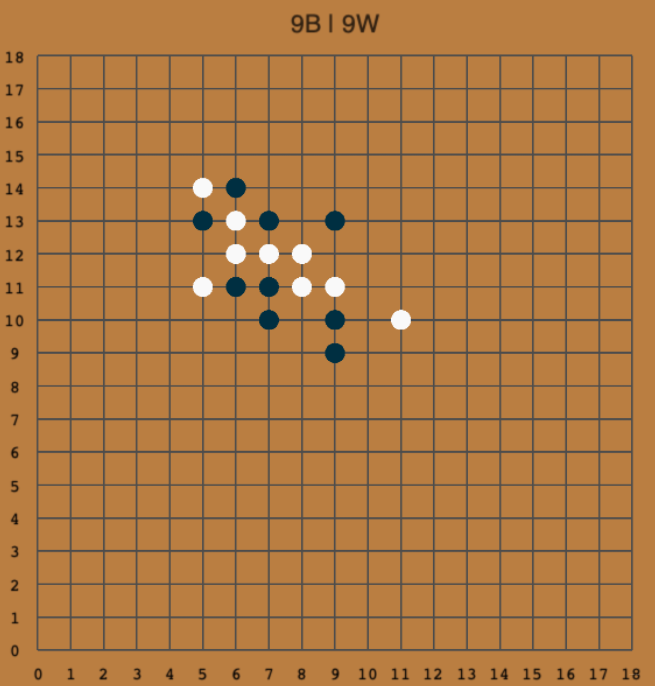

围棋

- https://github.com/aigagror/GymGo

机器人环境

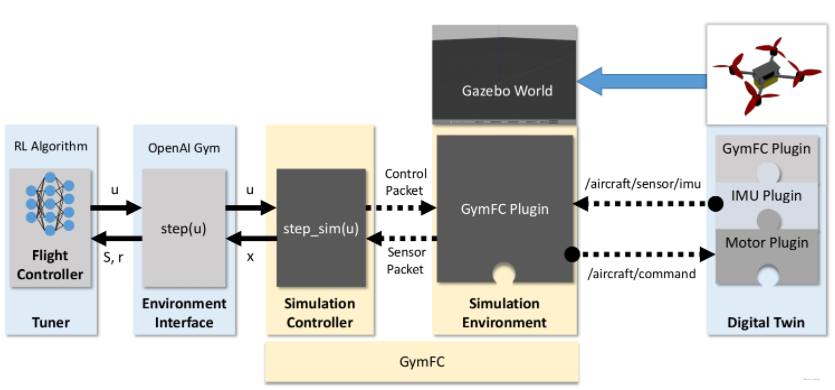

GymFC

GymFC是一个用于合成神经飞行控制器的模块化框架。该架构集成了数字孪生概念,以提供训练有素的策略向硬件的无缝转移。OpenAI环境已被用于为世界上第一个开源神经网络飞行控制固件Neuroflight生成策略。

- https://github.com/wil3/gymfc/

gym-gazebo

在gazebo种做的一些强化学习控制环境:

等等这些做了有个七八个。

- https://github.com/erlerobot/gym-gazebo/

goddard

一个模拟经典最优控制问题的环境,其中垂直上升的火箭的推力应被确定为使其达到最大可能的高度,同时受到不同的空气动力阻力、重力和质量的影响。

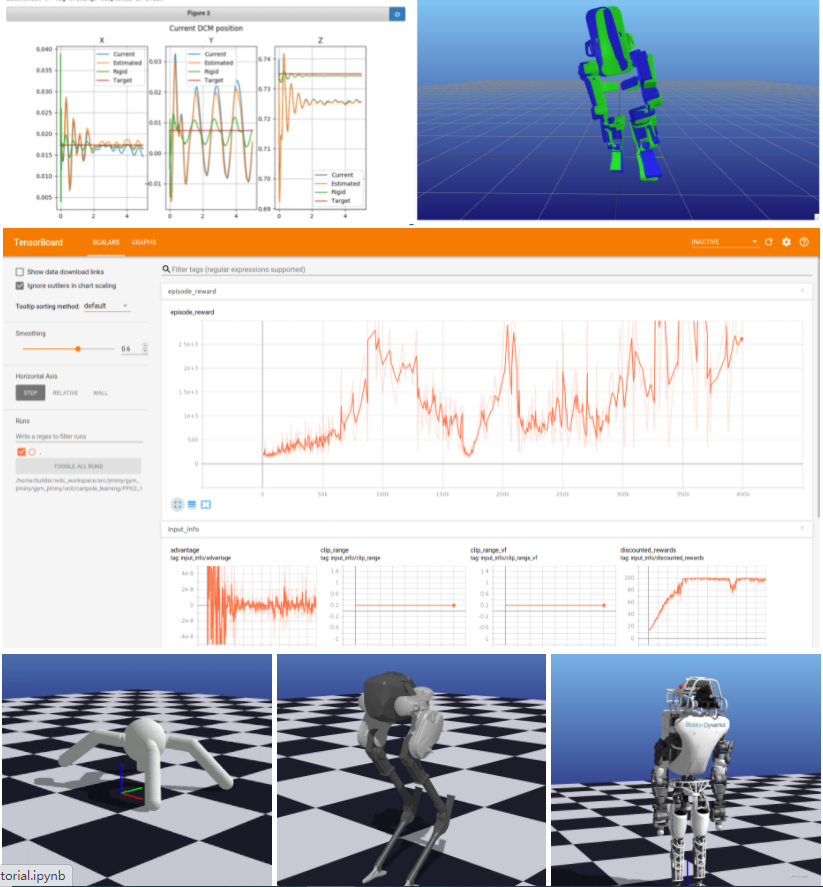

jiminy

gym-jiminy提出了最初的OpenAI机器人健身房的扩展,使用Jiminy,这是一个极其快速和轻量级的多关节系统模拟器,使用Pinocchio进行物理评估和Meshcat进行基于网络的3D渲染。

miniworld

MiniWorld是一个简约的3D室内环境模拟器,用于强化学习和机器人学研究。它可以用来模拟有房间、门、走廊和各种物体的环境(例如:办公室和家庭环境、迷宫)。MiniWorld可以被看作是VizDoom或DMLab的一个更简单的替代品。它是100%用Python编写的,旨在让学生容易修改或扩展。

pybullet-drones

多智能体四旋翼环境:

- https://github.com/utiasDSL/gym-pybullet-drones

- https://github.com/utiasDSL/gym-pybullet-drones

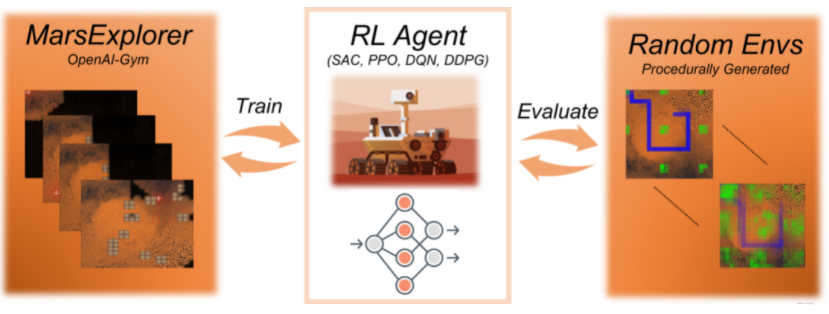

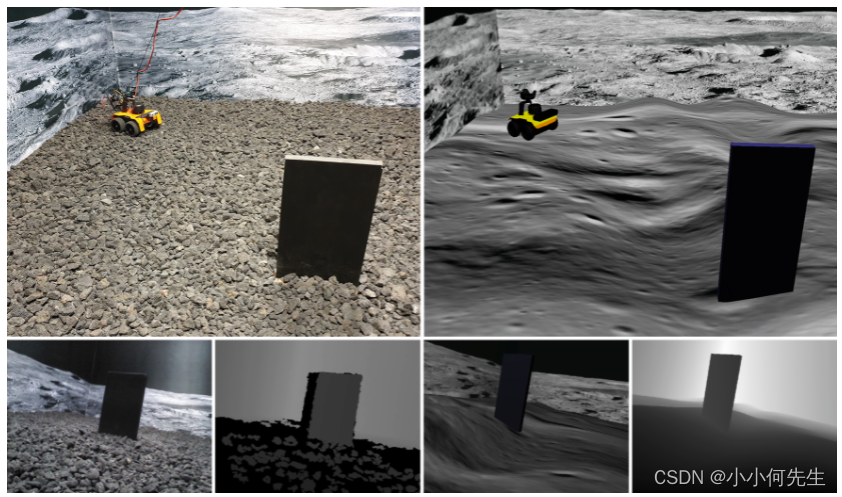

火星探险家

火星探险家是一个与openai-gym兼容的环境,它的设计和开发是为了弥补强大的深度强化学习方法和未知地形的探索/覆盖问题之间的差距。

- https://github.com/dimikout3/MarsExplorer

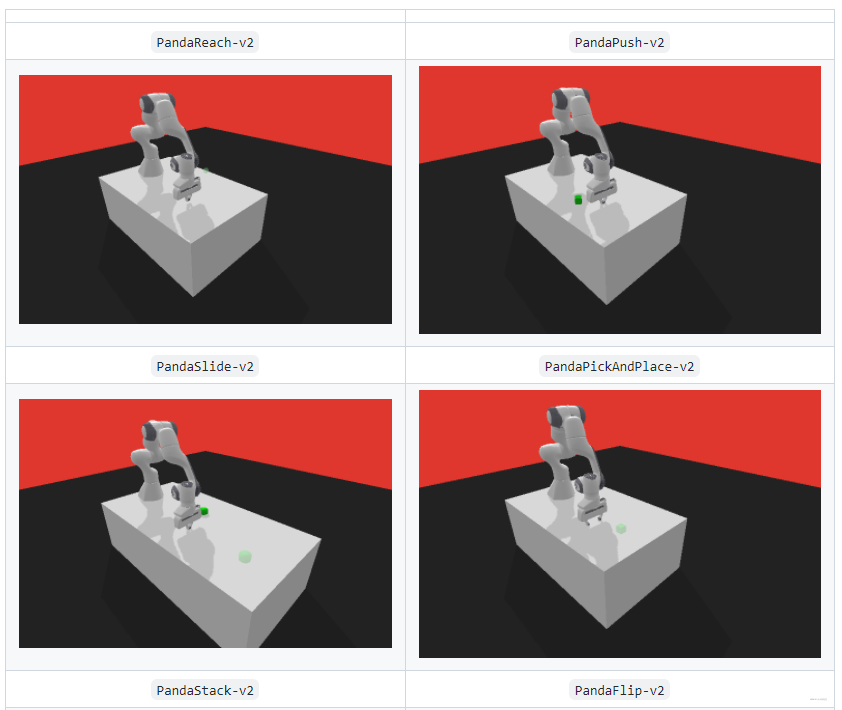

机械臂抓取环境

基于PyBullet开发的机械臂抓取环境:

- https://github.com/qgallouedec/panda-gym/

robo-gym

一个开源的支持分布式从仿真到真实环境的工具:

- https://github.com/jr-robotics/robo-gym

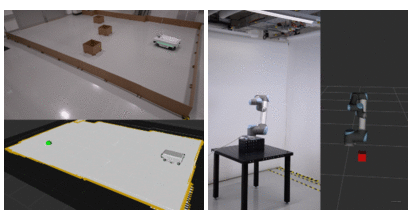

OffWorld Gym

一个仿真实环境做的环境:

- https://github.com/offworld-projects/offworld-gym

自动驾驶和交通控制类

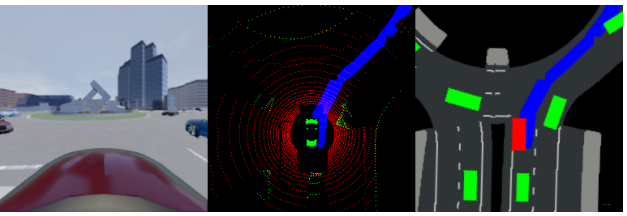

gym-carla

基于carla的gym第三方环境:

- https://github.com/cjy1992/gym-carla

Gym-Duckietown

一个Duckietown宇宙的模拟器,用纯Python/OpenGL(Pyglet)编写。它把你的代理,一个Duckiebot,放在Duckietown的一个实例中:一个有转弯、交叉口、障碍物、Duckie行人和其他Duckiebot的道路循环。这可能是一个相当繁忙的地方

- https://github.com/duckietown/gym-duckietown

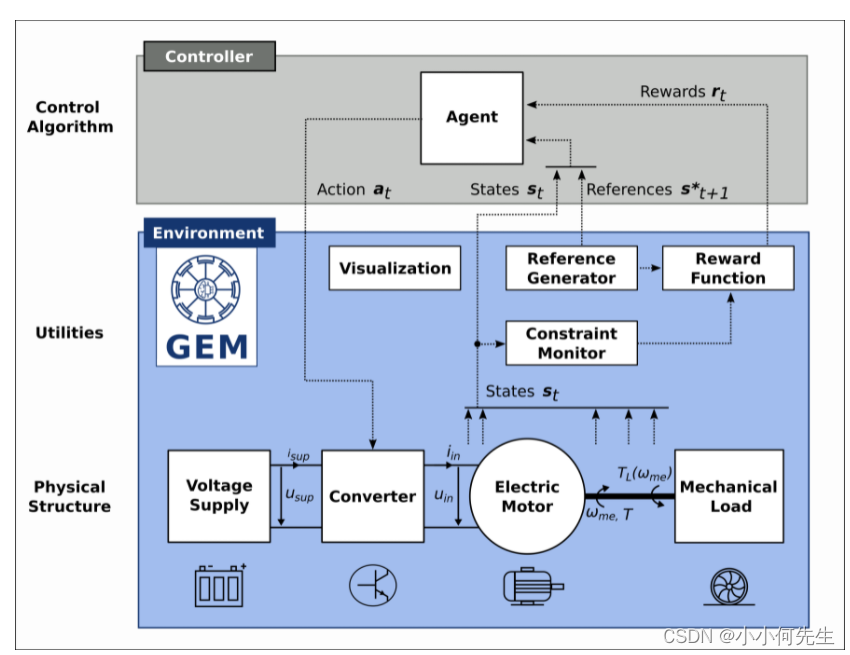

电机类环境

- https://github.com/upb-lea/gym-electric-motor

highway-env

一个用于自主驾驶的行为规划的环境,强调高水平的感知和决策,而不是低水平的感应和控制。该任务的难度在于理解与其他司机的社会互动,因为他们的行为是不确定的。提出了几个场景,如高速公路、合并、交叉口和环岛。

- https://github.com/eleurent/highway-env

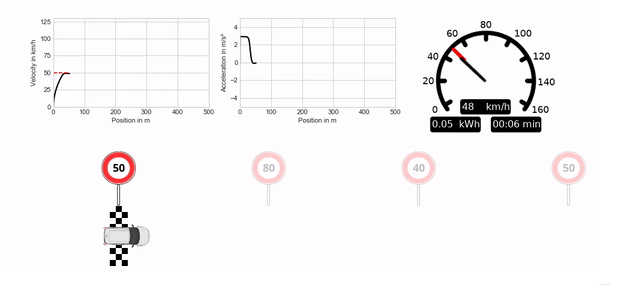

longicontrol

一个用于电动汽车随机纵向控制的环境。它旨在成为自主驾驶领域内一个连续的现实世界问题的描述性和可理解的例子。

- https://github.com/dynamik1703/gym_longicontrol

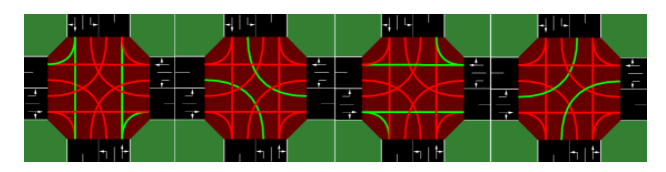

交通信号灯控制环境

- https://github.com/LucasAlegre/sumo-rl

其它一些

Gridworld

网格环境。

- https://github.com/addy1997/Gridworld

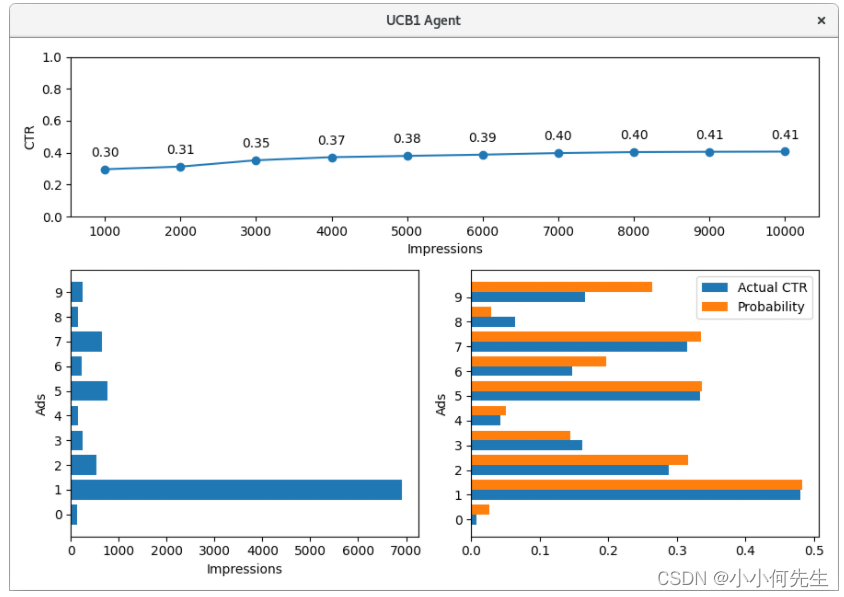

gym-adserver

一个实现典型的多臂强盗场景的环境,其中广告服务器必须选择最好的广告来显示在网页上。其中包括一些实例代理。随机、epsilon-Greedy、Softmax和UCB1。

- https://github.com/falox/gym-adserver

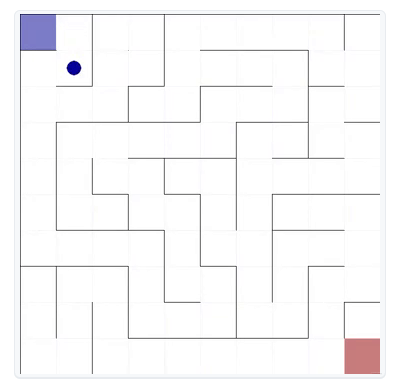

gym-maze

2D寻路环境:

- https://github.com/MattChanTK/gym-maze

用于推荐系统中的环境

-

- https://github.com/zuoxingdong/gym-recsys

对于数学问题求解的环境

- https://github.com/JohnnyYeeee/math_prog_synth_env

解决NLP问题的环境

- https://github.com/rajcscw/nlp-gym

obstacle-tower-env

障碍塔是一个按程序生成的环境,由多个楼层组成,由学习型代理解决。它旨在测试学习代理在计算机视觉、运动技能、高级规划和概括方面的能力。它将平台式游戏与谜题和规划问题结合起来,关键是随着代理的进步,难度也在增加。

- https://github.com/Unity-Technologies/obstacle-tower-env

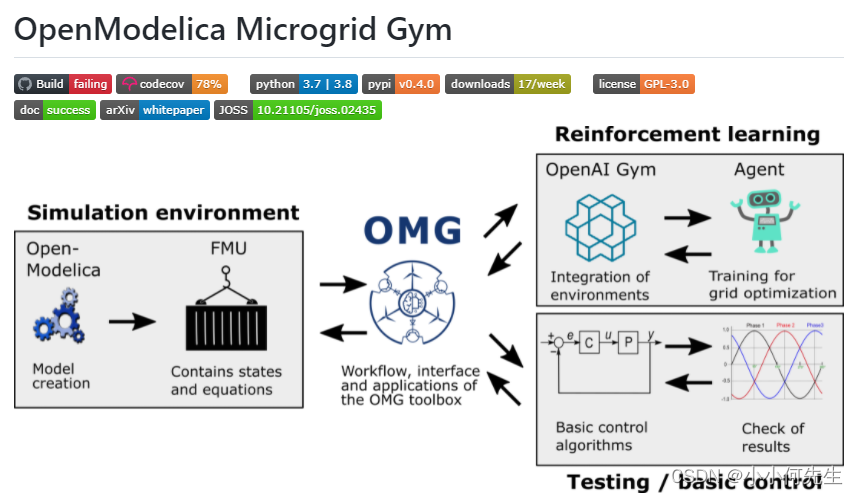

电网能源优化

- https://github.com/upb-lea/openmodelica-microgrid-gym

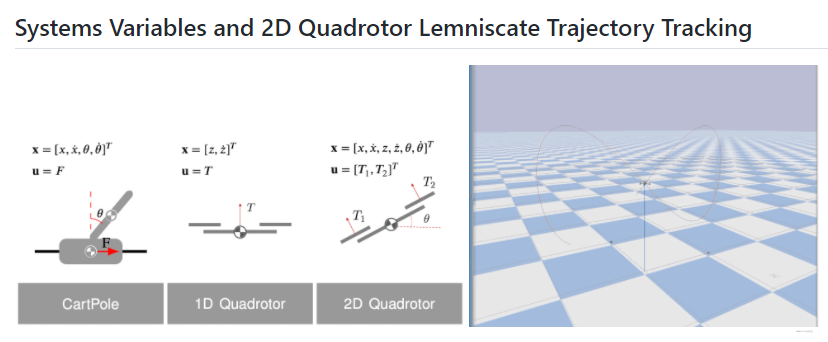

稳定控制类

- https://github.com/utiasDSL/safe-control-gym

虚拟淘宝

- https://github.com/eyounx/VirtualTaobao/