目录

一、?名词简介(Epoch,Batch,Iteration,Batch_Size)

一、?名词简介(Epoch,Batch,Iteration,Batch_Size)

| 名词 | 定义 |

| Epoch(一代) | 使用训练集的全部数据对模型进行一次完整训练,“一代训练” |

| Batch(一批) | 使用数据集中的一小部分样本对模型权重进行一次反向传播的参数更新,“一批数据” |

| Iteration(一次迭代) | 使用一个Batch数据对模型进行一次参数更新的过程,“一次训练” |

| batch_size(一批次包含样本数) | 一个mini-batch所包含的样本数目称为batch_size |

二、为什么要使用多于一个Epoch?

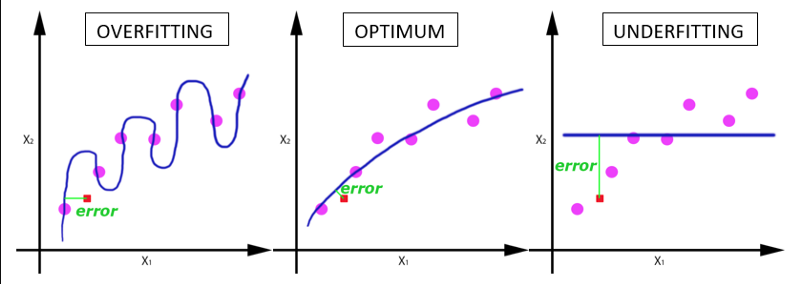

在神经网络中传递完整的数据集一次是不够的,而且我们需要将完整的数据集在同样的神经网络中传递多次。但请记住,我们使用的是有限的数据集,并且我们使用一个迭代过程即梯度下降来优化学习过程。如下图所示。因此仅仅更新一次或者说使用一个epoch是不够的,但是过多的epoch又会导致过拟合。?

? ? ? ? ? ? ? ? ? ? ? ? ? ? 过拟合? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? 适中? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?? ? ? ? 欠拟合?

三、举例说明

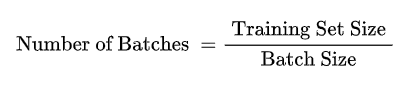

实际上,梯度下降的几种方式的根本区别就在于上面公式中的 Batch_Size 不同。?

用mnist 数据集举例:

mnist 数据集有60000张图片作为训练数据,10000张图片作为测试数据。假设现在选择 Batch_Size = 100对模型进行训练。

每个 Epoch (一代)要训练的图片数量:60000(训练集上的所有图像)

训练集具有的 Batch (批次)个数:60000/100=600

每个 Epoch (一代)需要完成的 Batch 个数:600

每个 Epoch (一代)具有的 Iteration (一次迭代)个数:600(完成一个Batch训练,相当于参数迭代一次)

每个 Epoch (一代)中发生模型权重更新的次数:600

训练 10 个Epoch(一代)后,模型权重更新的次数:600*10=6000

不同Epoch的训练,其实用的是同一个训练集的数据。第1个Epoch和第10个Epoch虽然用的都是训练集的图片,但是对模型的权重更新值却是完全不同的。因为不同Epoch的模型处于代价函数空间上的不同位置,模型的训练代越靠后,越接近谷底,其代价越小。?

四、如何确定batch_size?

根据数据集的大小和样本数目确定batch_size:

1. 样本类别数目较少,而且模型没有BN层,batch_size就设置得较小一点。

2. 样本类别数目较多,而且模型没有BN层,batch_size就设置得较大一点。尽量保证一个batch里面各个类别都能取到样本。

3. 数据集很小,可以采取Full Batch Learning(每次用所有的训练集进行训练)。

batch_size的大小设置为8的倍数。

有BN层的模型,而且数据集也很大,类别也较多时,batch_size尽量越大越好。?

五、什么是BN层??

提到归一化,先解释一下为什么要做归一化,神经网络在开始训练前,都会对数据做一个归一化处理,把数据变成均值为0,方差为1,这样要能让网络更好更快地收敛。那么我们知道,网络学习的本质其实是学习数据的分布,训练数据与测试数据的分布一样,训练出来的网络才能在测试集中取得不错的效果,但另一方面,如果输入网络训练的每一批数据的分布都不一样的话,那么网络就要在每次训练迭代的过程中去适应不同的分布,这会大大降低网络的训练速度。这也是网络开始训练前要对数据做归一化预处理的一个原因。

而网络一旦训练起来,参数就要发生更新,除了输入层,其他层的数据分布都是不断变化的,因为在训练的时候,网络参数的变化就会导致后面输入数据的分布变化。而BN就是为了解决这个问题的。有人说,那对每一层的输出都做一次归一化(例如归一化到均值为0,方差为1),然后再继续训练不就行了吗?但是事实上如果这样做的话会改变掉网络之前已经学习到的特征,例如某一层的网络的输出是大部分比较靠近0的右边的,经过ReLu激活函数后(大于0的会线性激活),大部分都会被激活,但如果强行进行归一化,则大部分输出都无法激活了,这样的话,原来学习到的特征不就被破坏掉了吗?针对这个问题,BN对上面的方法做了一点改进:变换重构,引入可以学习的参数,这是BN算法的关键之处。因为:

BN就是对每一层输出进行归一化,然后通过BN中学习到的参数,来还原被归一化之前的数据特征。

Batch Normalization (BN层)-----批归一化-----作用

1.加快网络训练和收敛的速度。(这是BN的主要作用)

2.控制梯度爆炸,防止梯度消失

3.防止过拟合

参考文档

1. 训练神经网络 | 三个基本概念:Epoch, Batch, Iteration_OnlyCoding…的博客-CSDN博客

2.?Batch Normalization (BN层)-----批归一化_ZJE_ANDY的博客-CSDN博客_bn层归一化