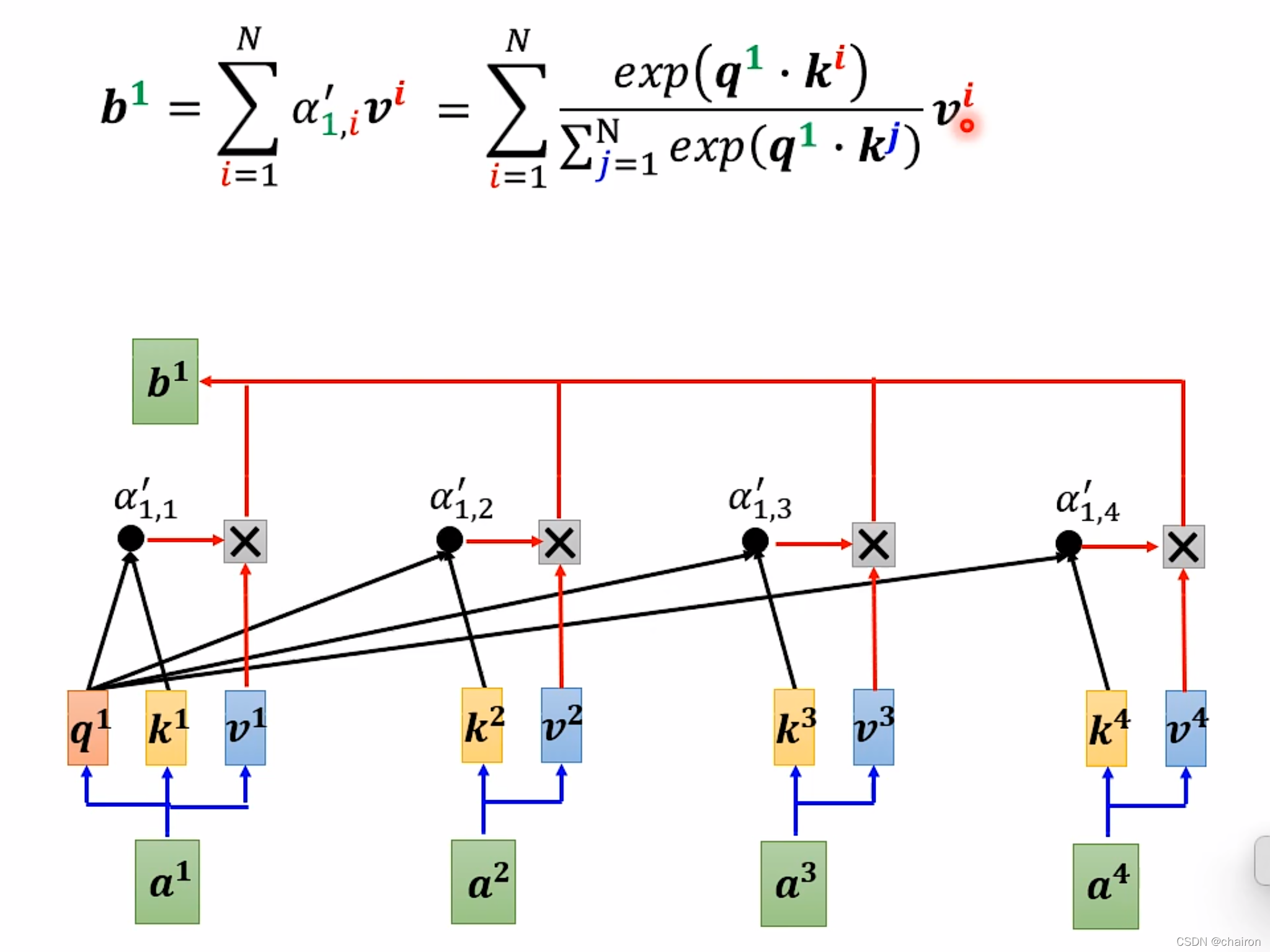

self-attention只是网络中的一小部分,但是当输入序列N很大的时候,网络的计算量大多数会来自于self-attention,其计算量和输入序列

N

2

N^2

N2成正比。

什么时候输入的N会很大呢?

当输入是图像的时候。假设每一个像素作为一个输入,256x256的图片输入的N=

25

6

2

256^2

2562,self-attention的计算量则是

25

6

4

256^4

2564

减少计算量

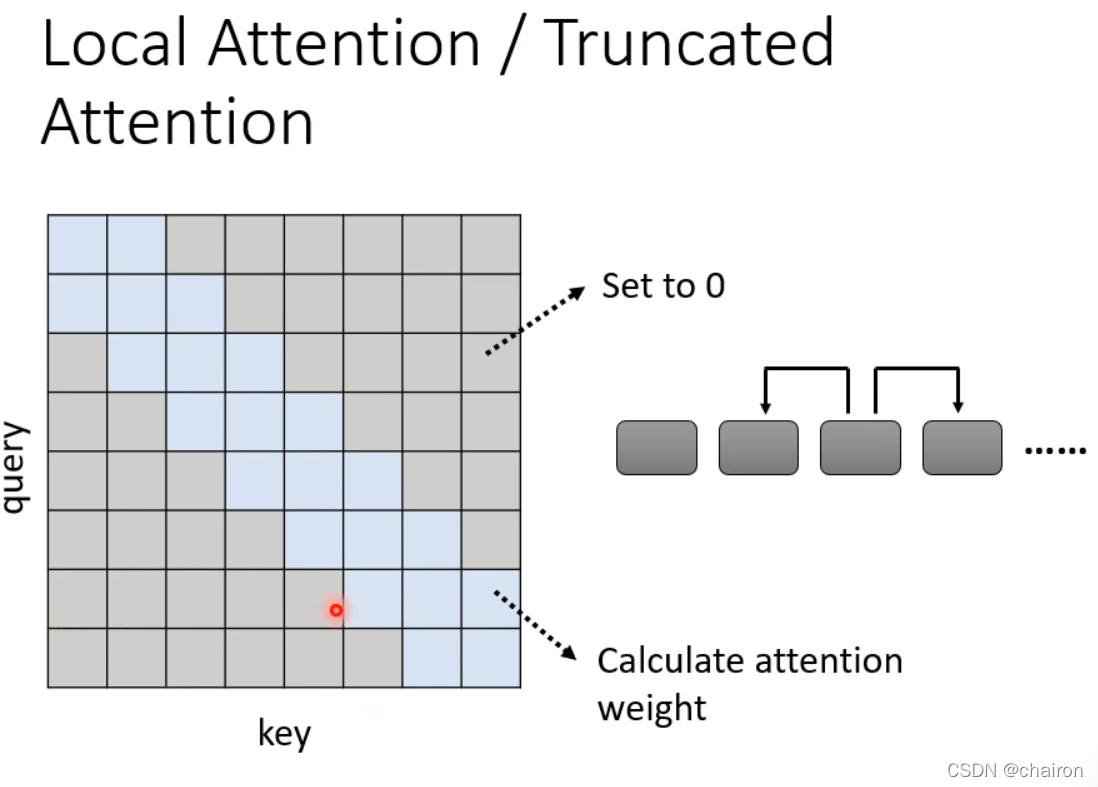

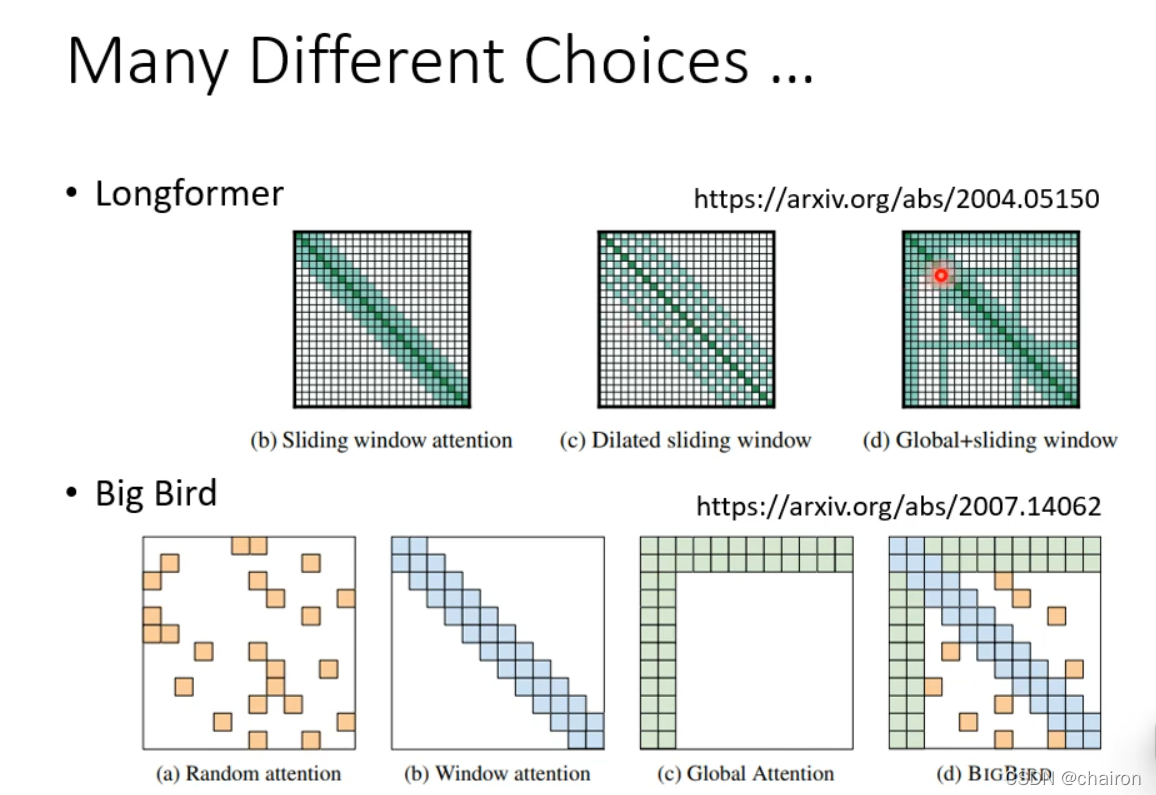

1. Local Attention/Truncated Attention

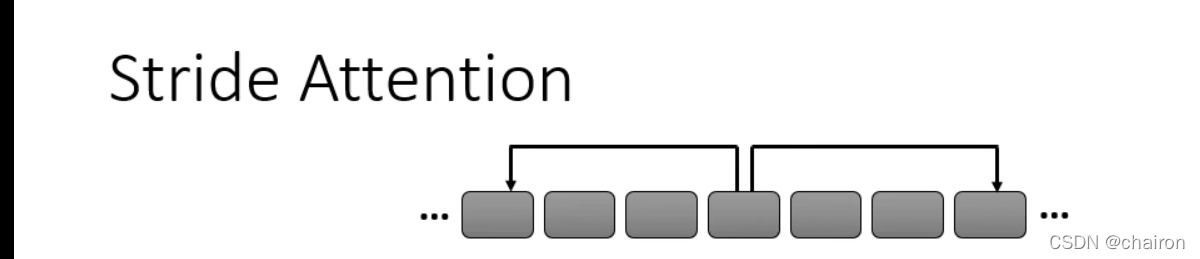

2. Stride Attention

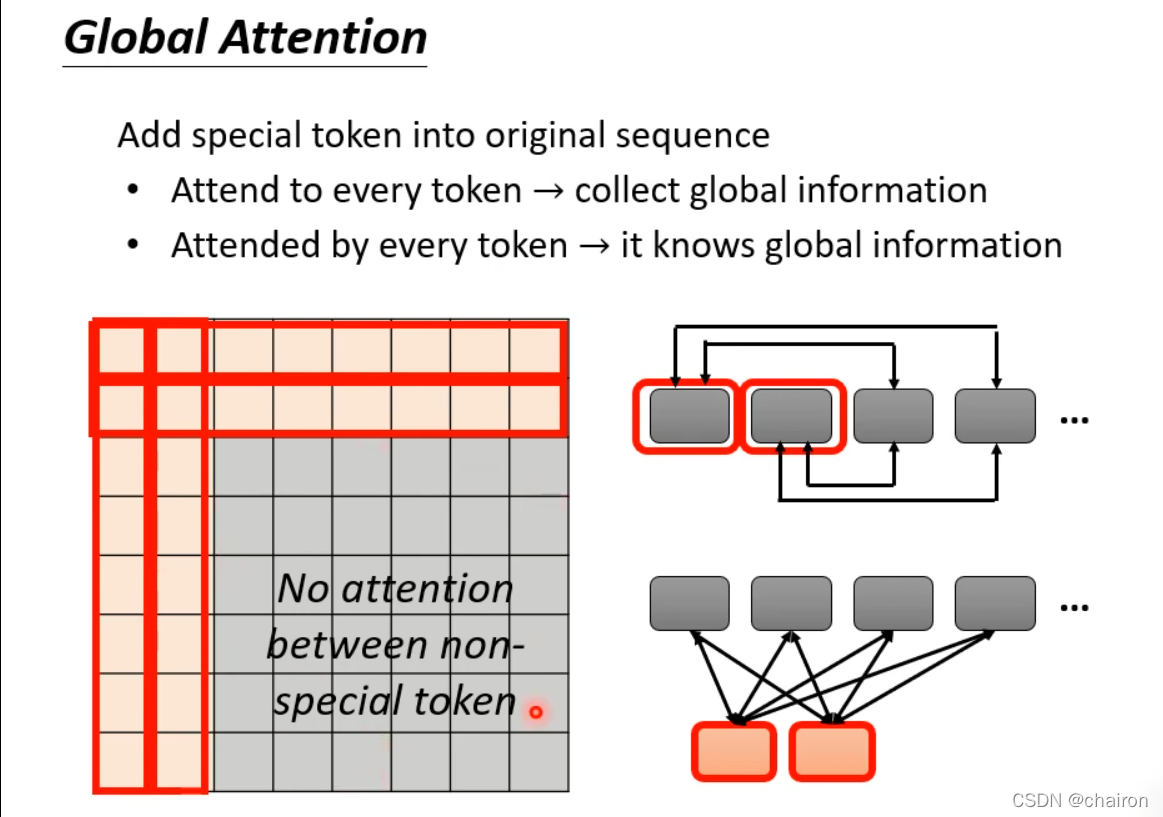

3. Global Attention

添加全局的token:包含所有token信息,也被所有的token包含

- 可以选择原始数据中的token作为Gloal token

- 可以另外新加token对所有的token进行映射

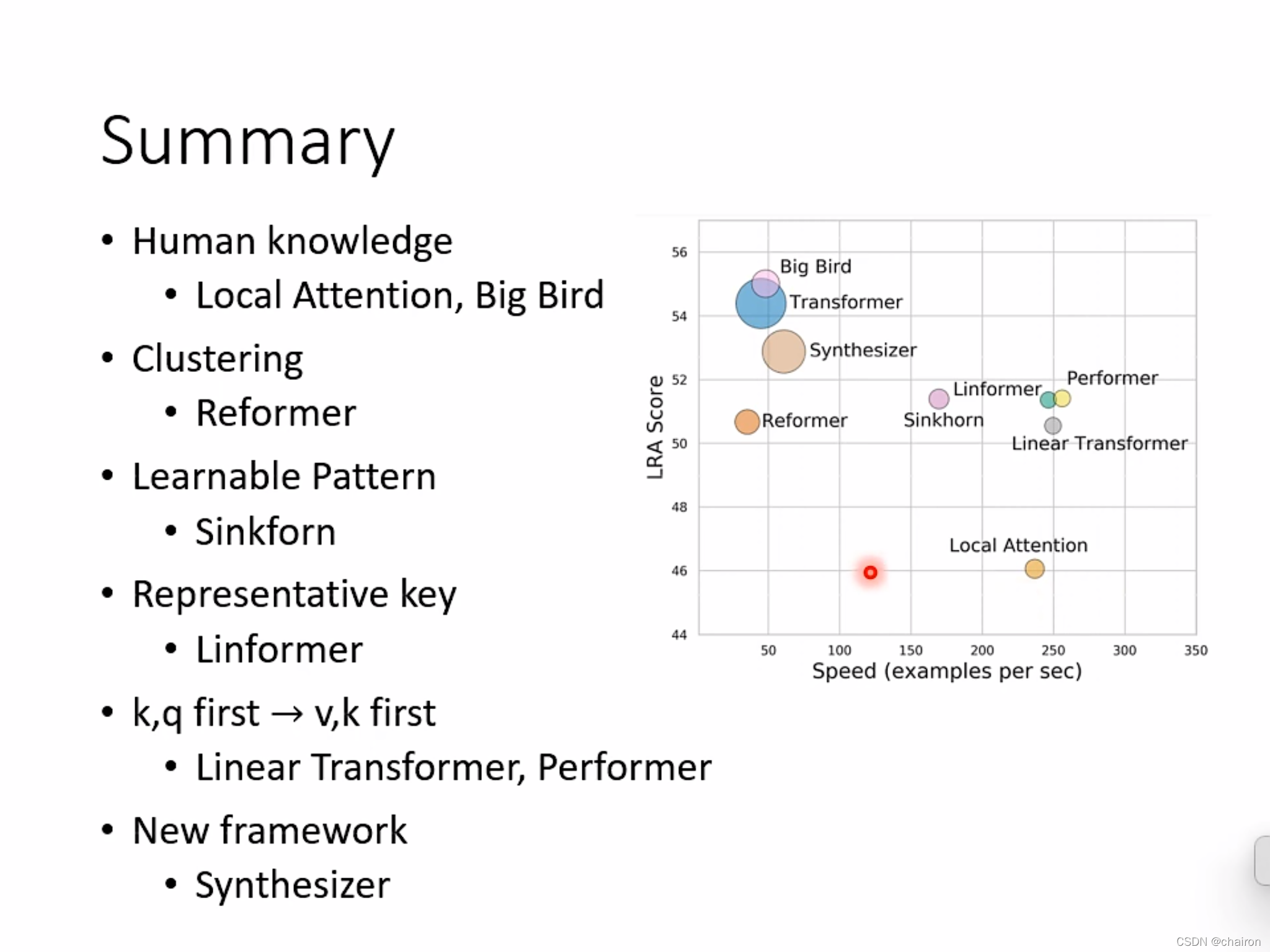

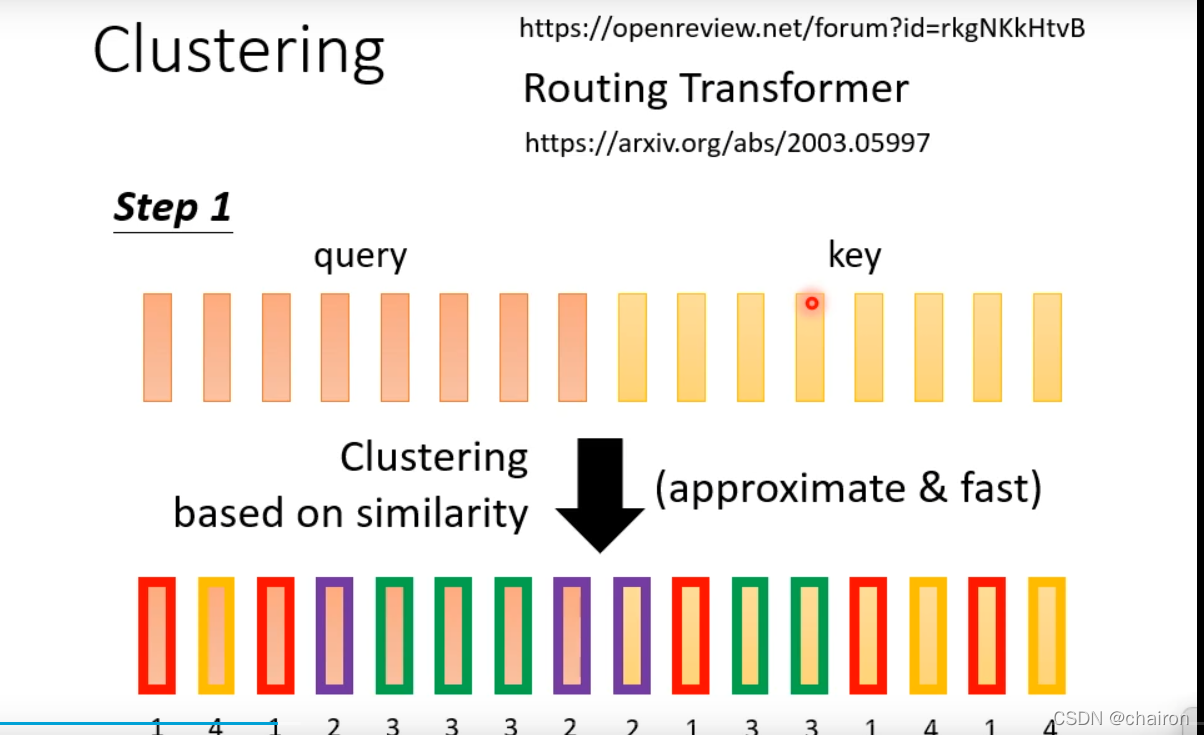

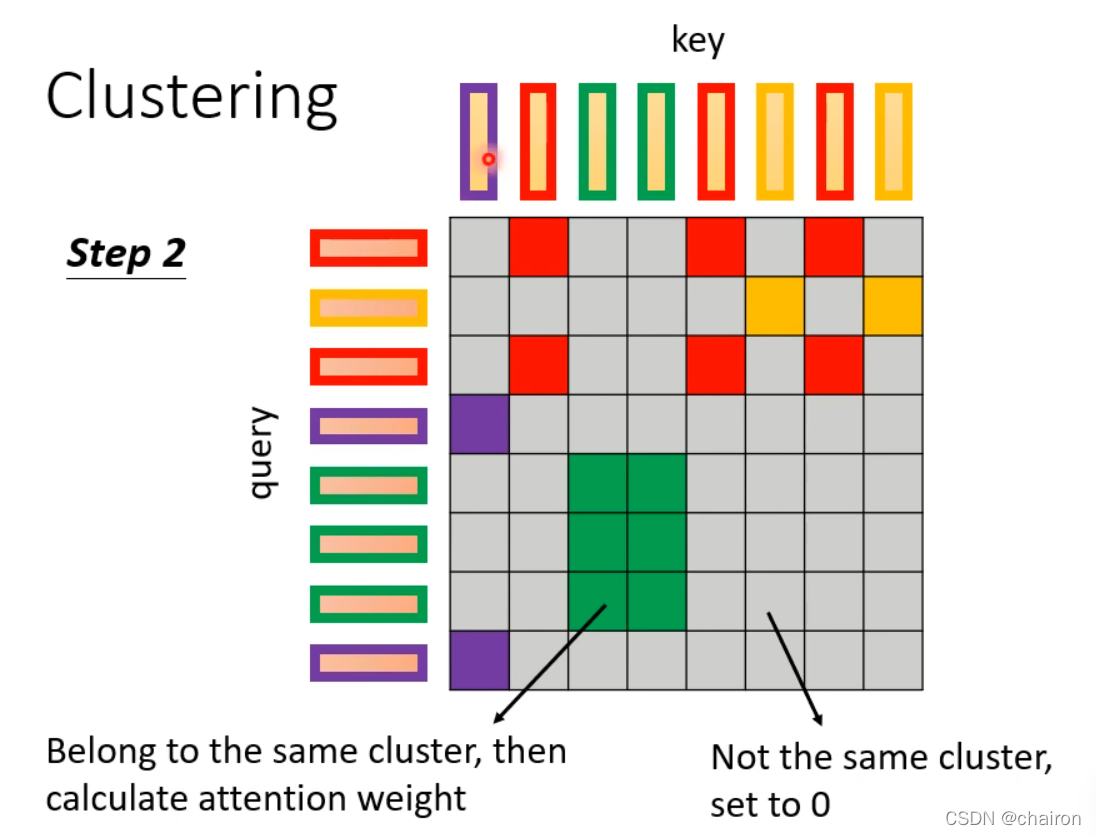

相似性聚簇,在同一个类别里面的q和v才进行计算attention

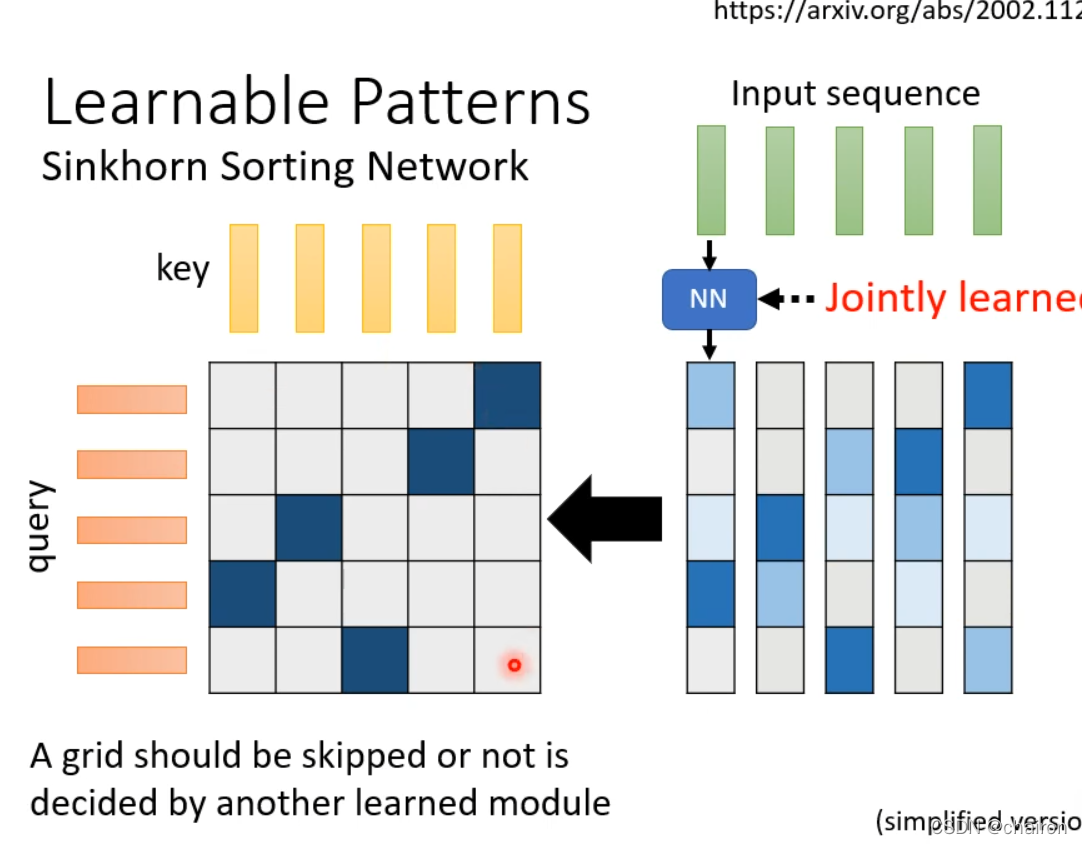

Learnable Patterns:通过网络自己学习哪些地方需要计算attention

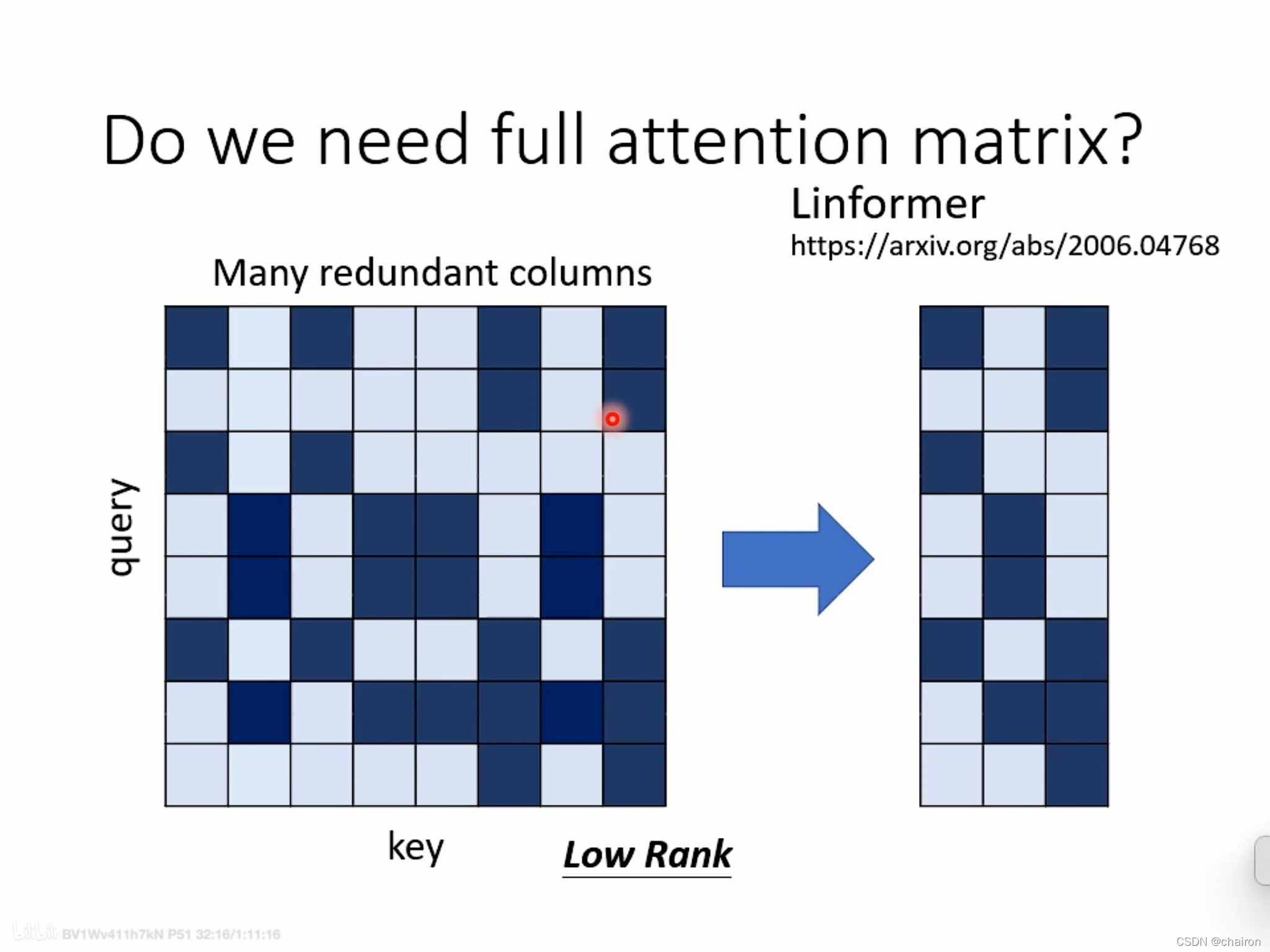

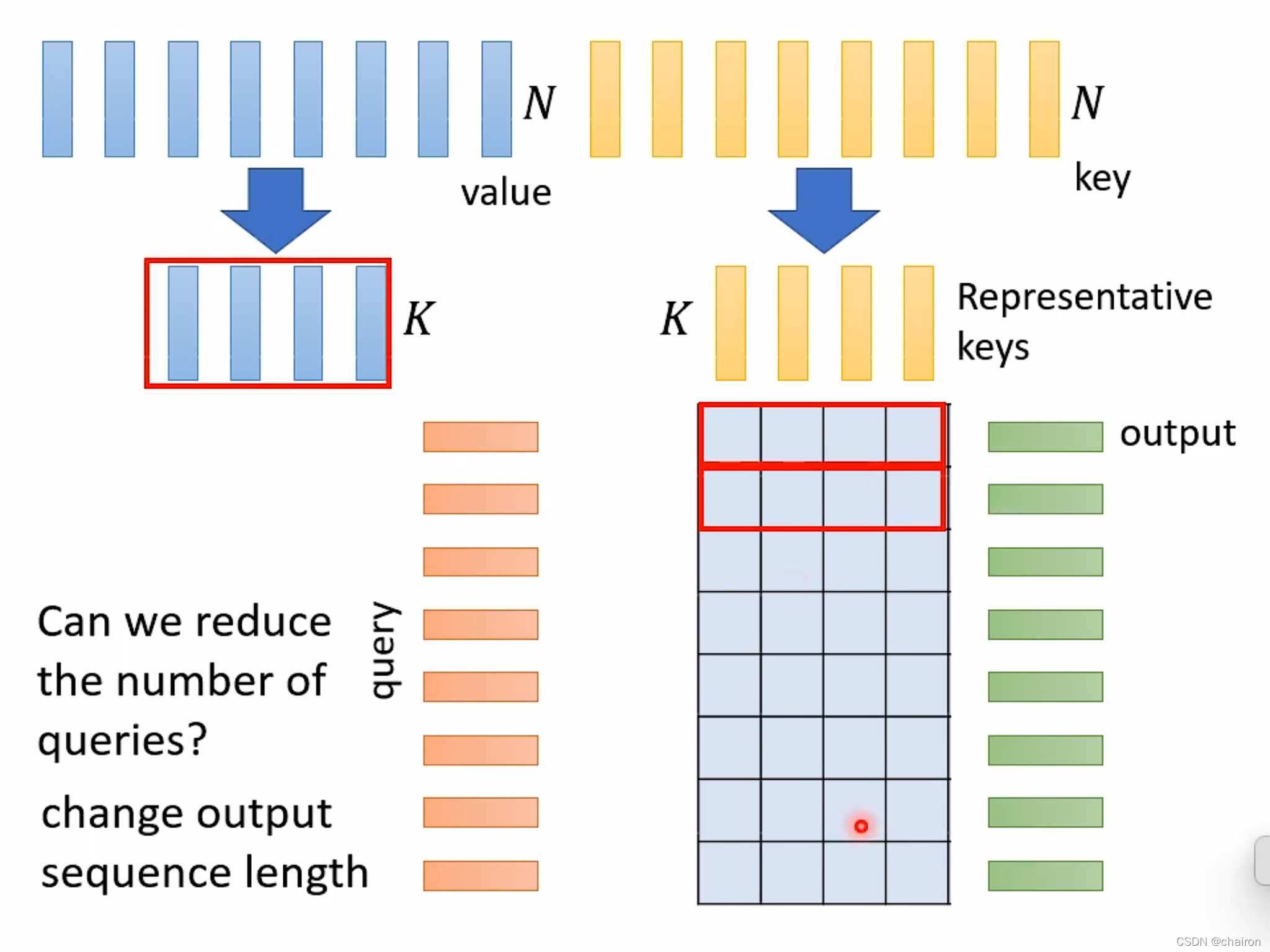

Linfomer:很多col的attention存在冗余,因此只对部分col做attention,即在长度为N的K、V中选取其中具有代表性的K个K、V计算N个Q的attention。query长度不改变是为了保障输出维度一致。

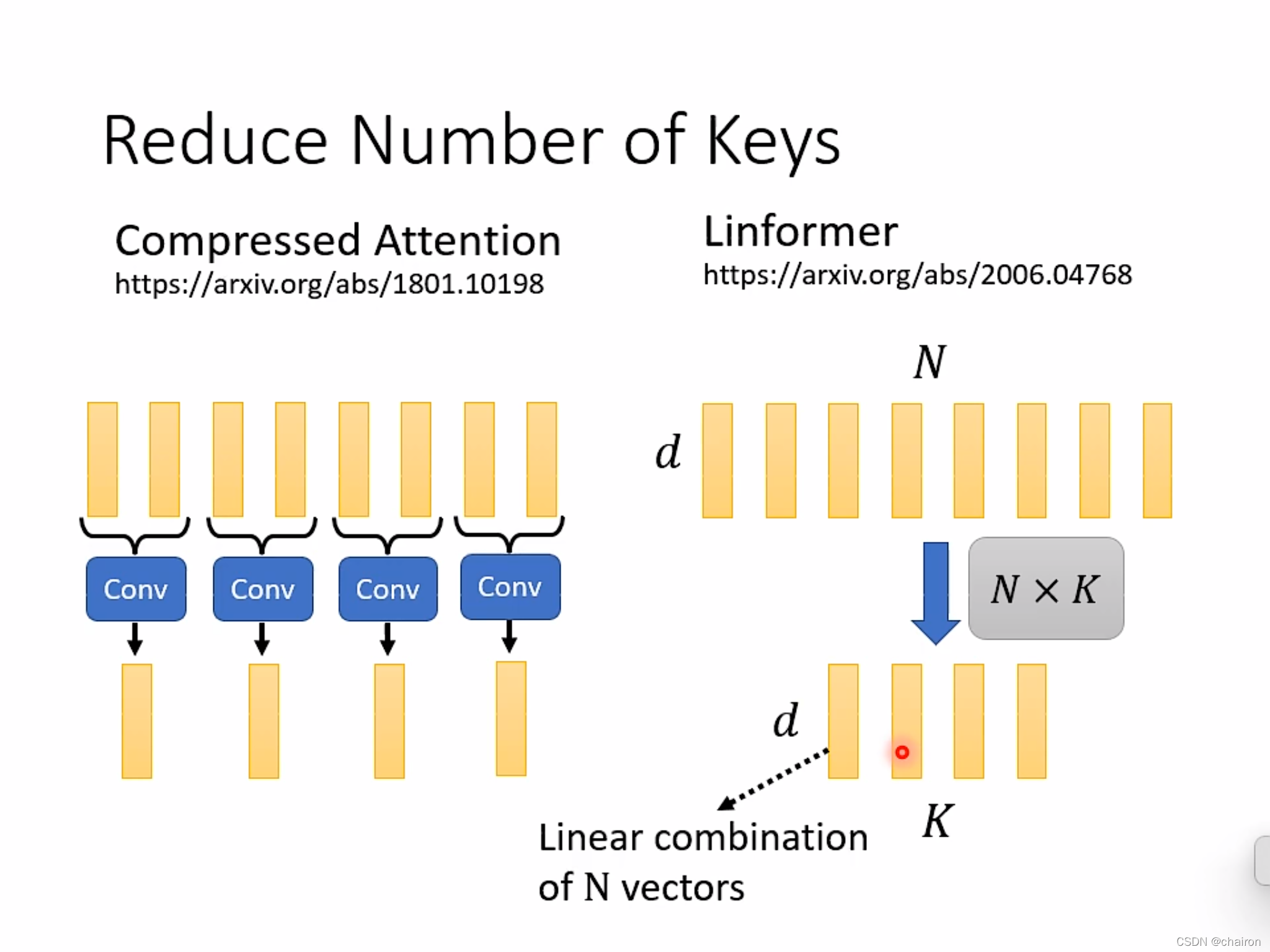

那么是如何减少K和V的数目N减少到K的呢?

- Caompressed Attention:通过卷积的方法

- Linformer:N个向量进行随机的线性组合

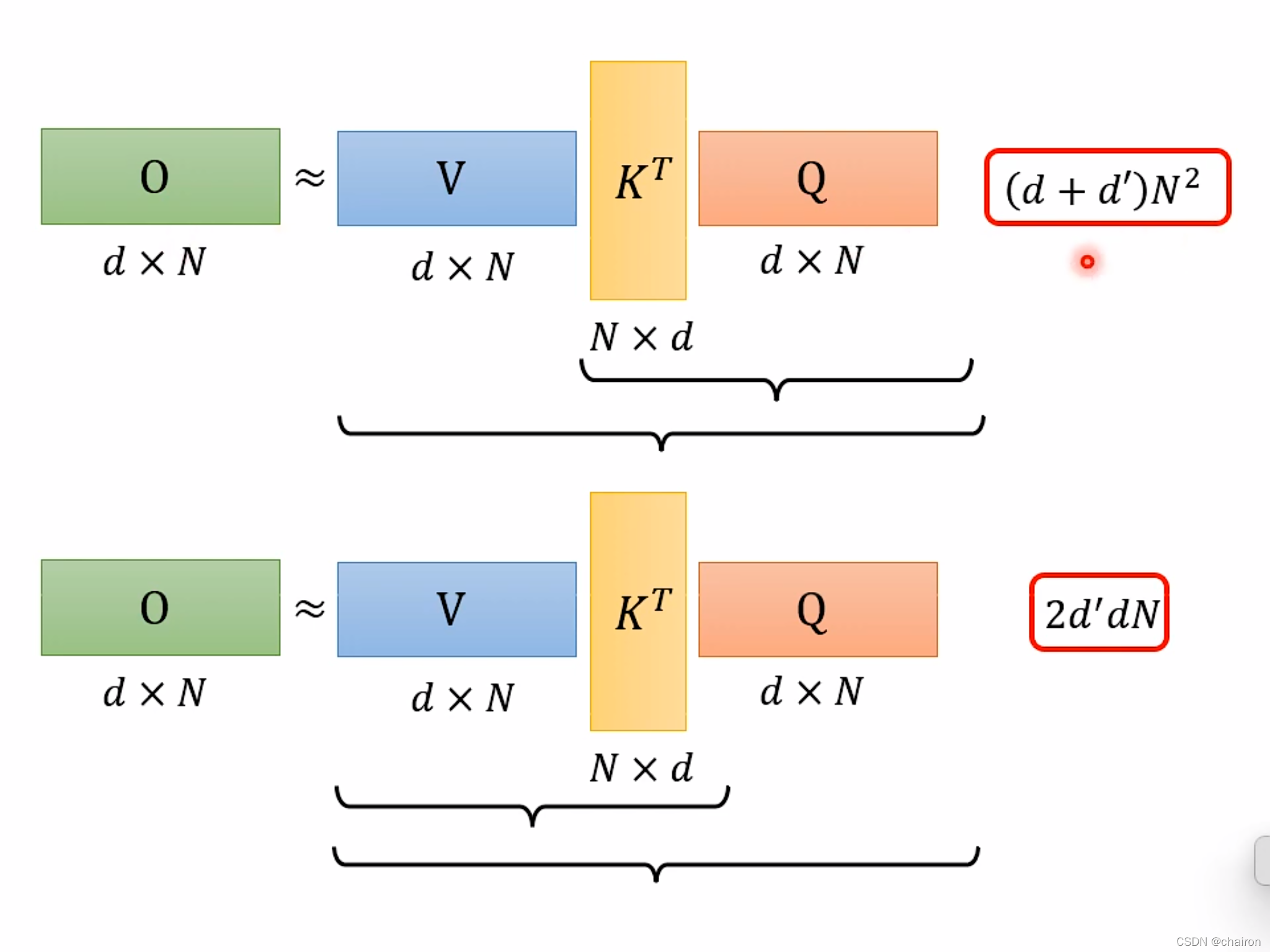

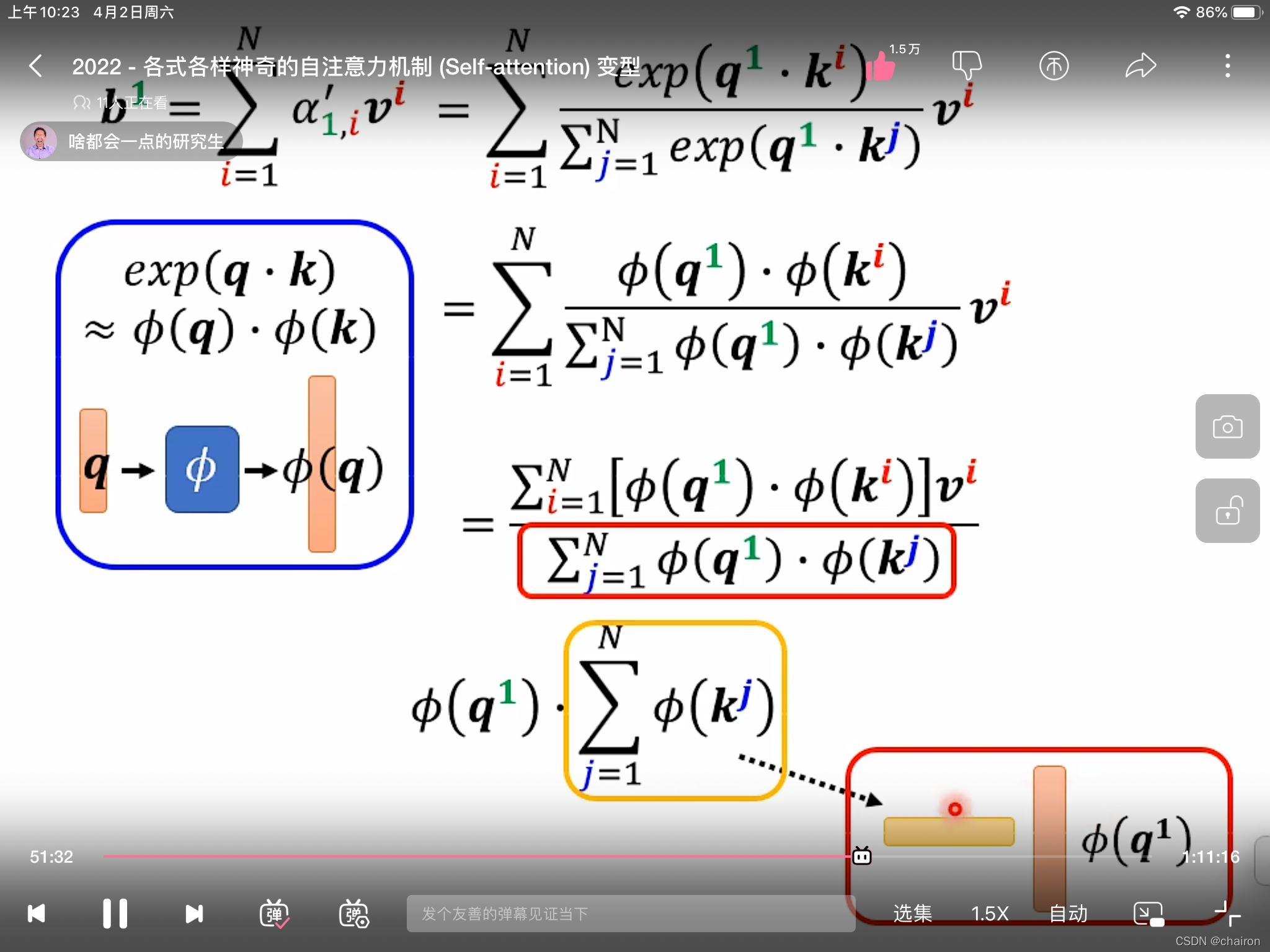

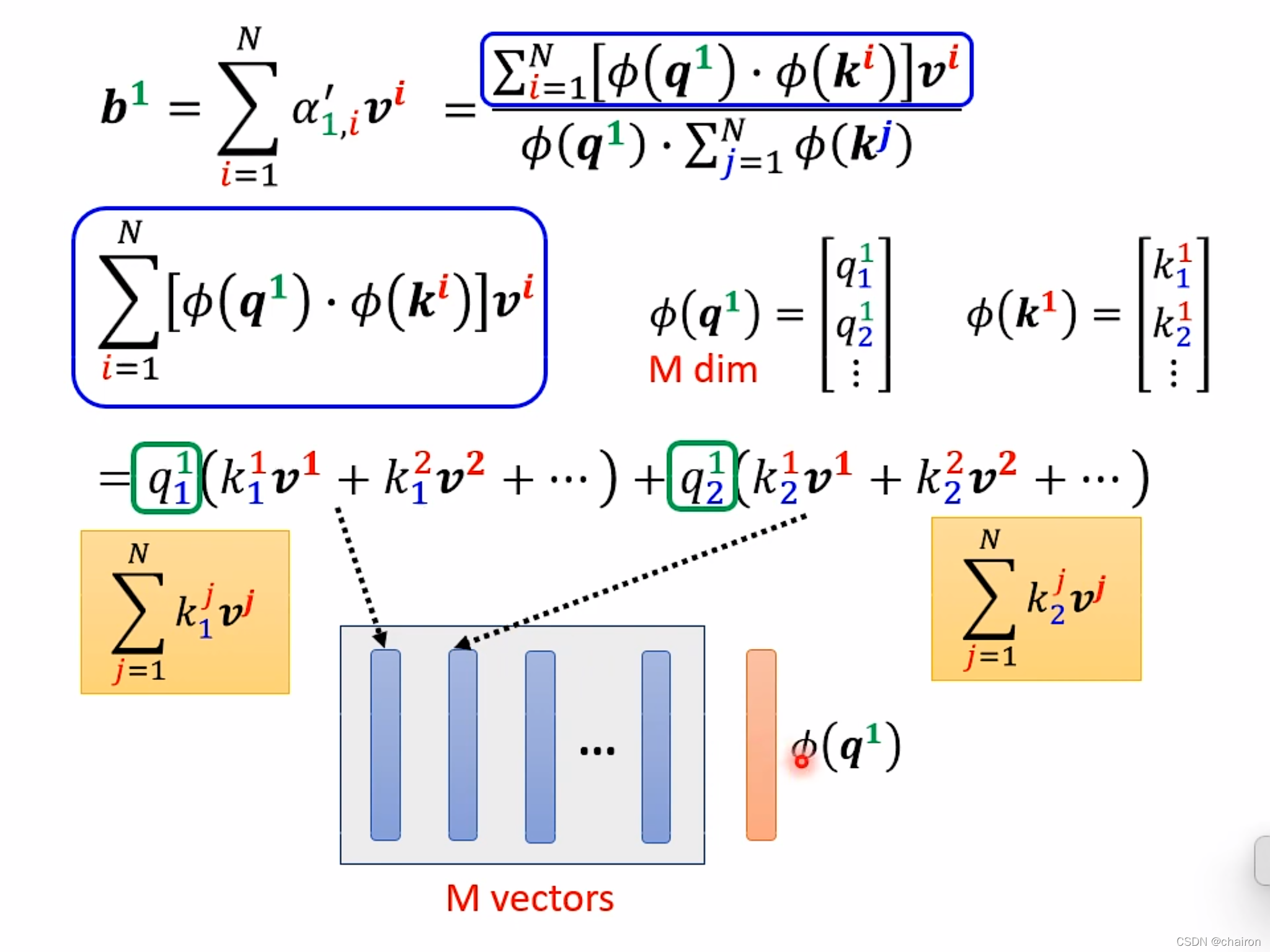

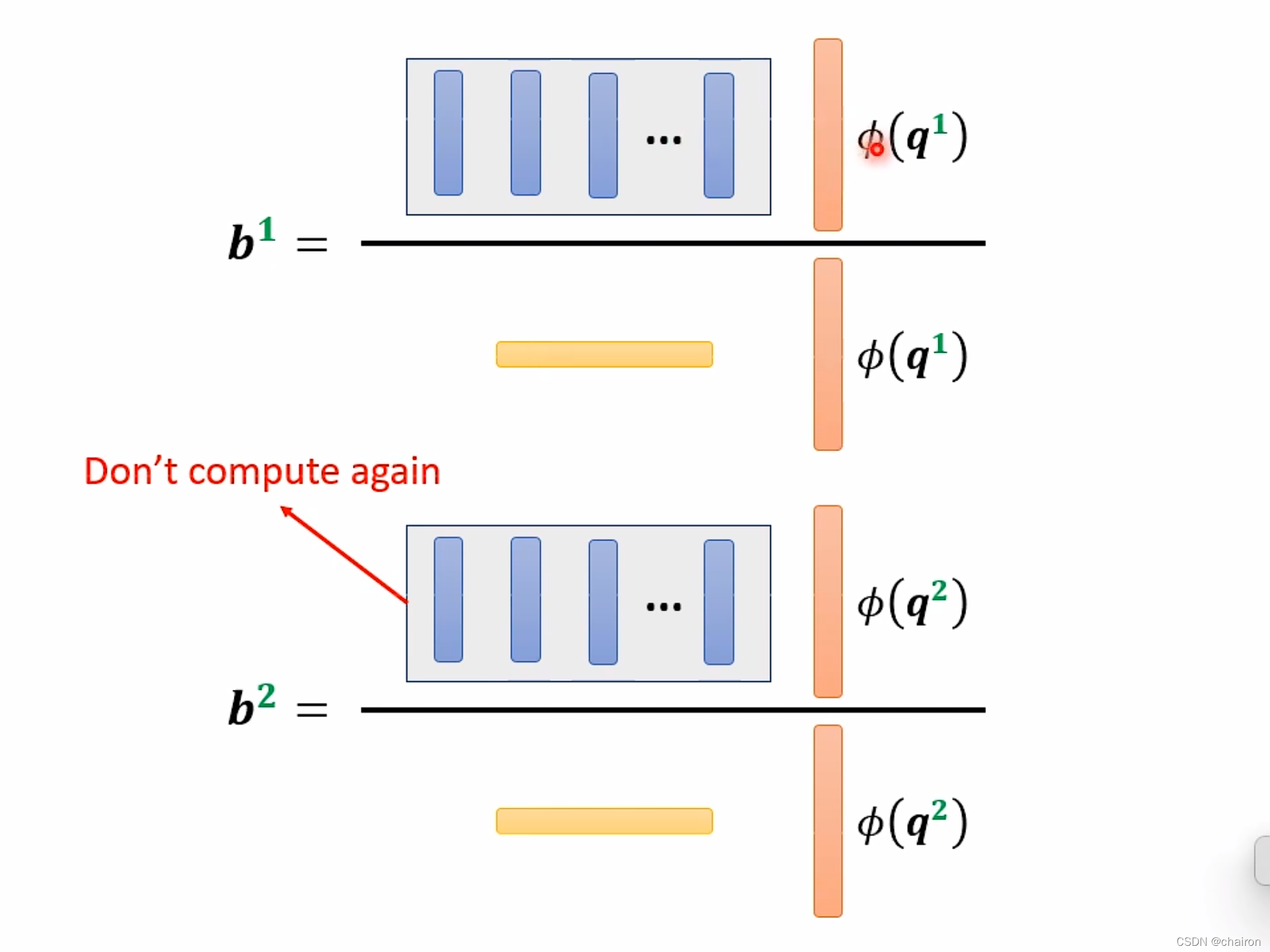

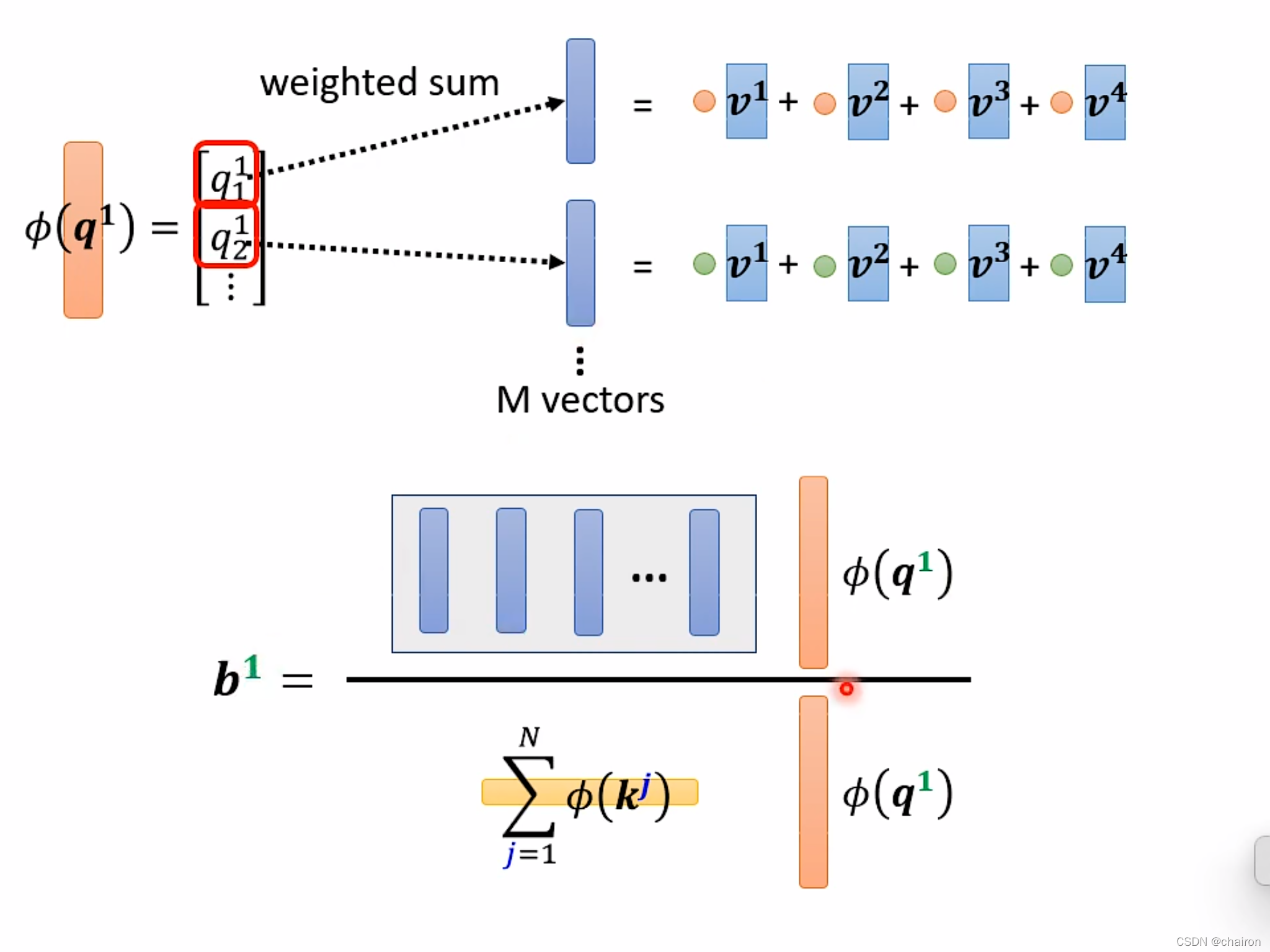

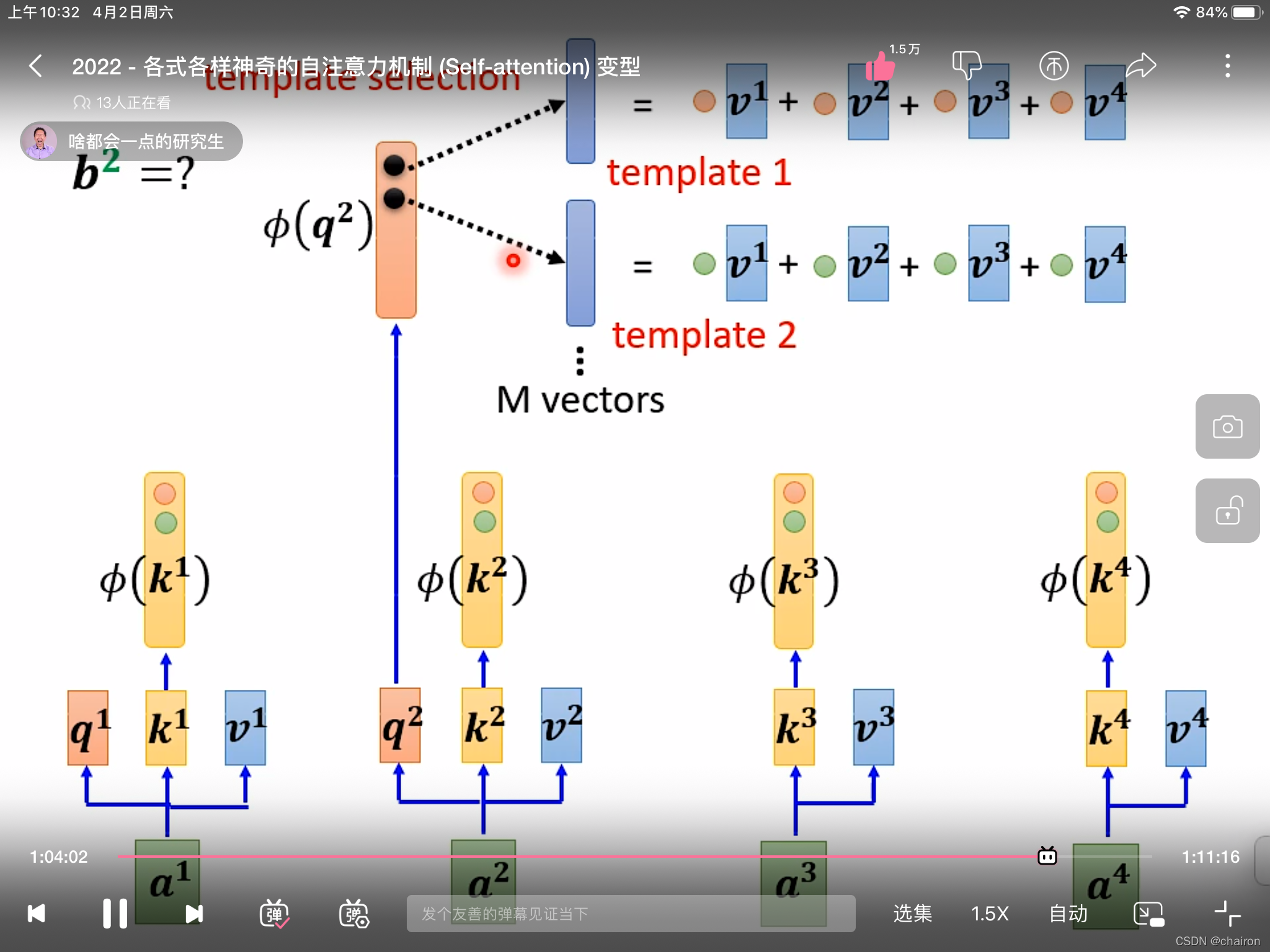

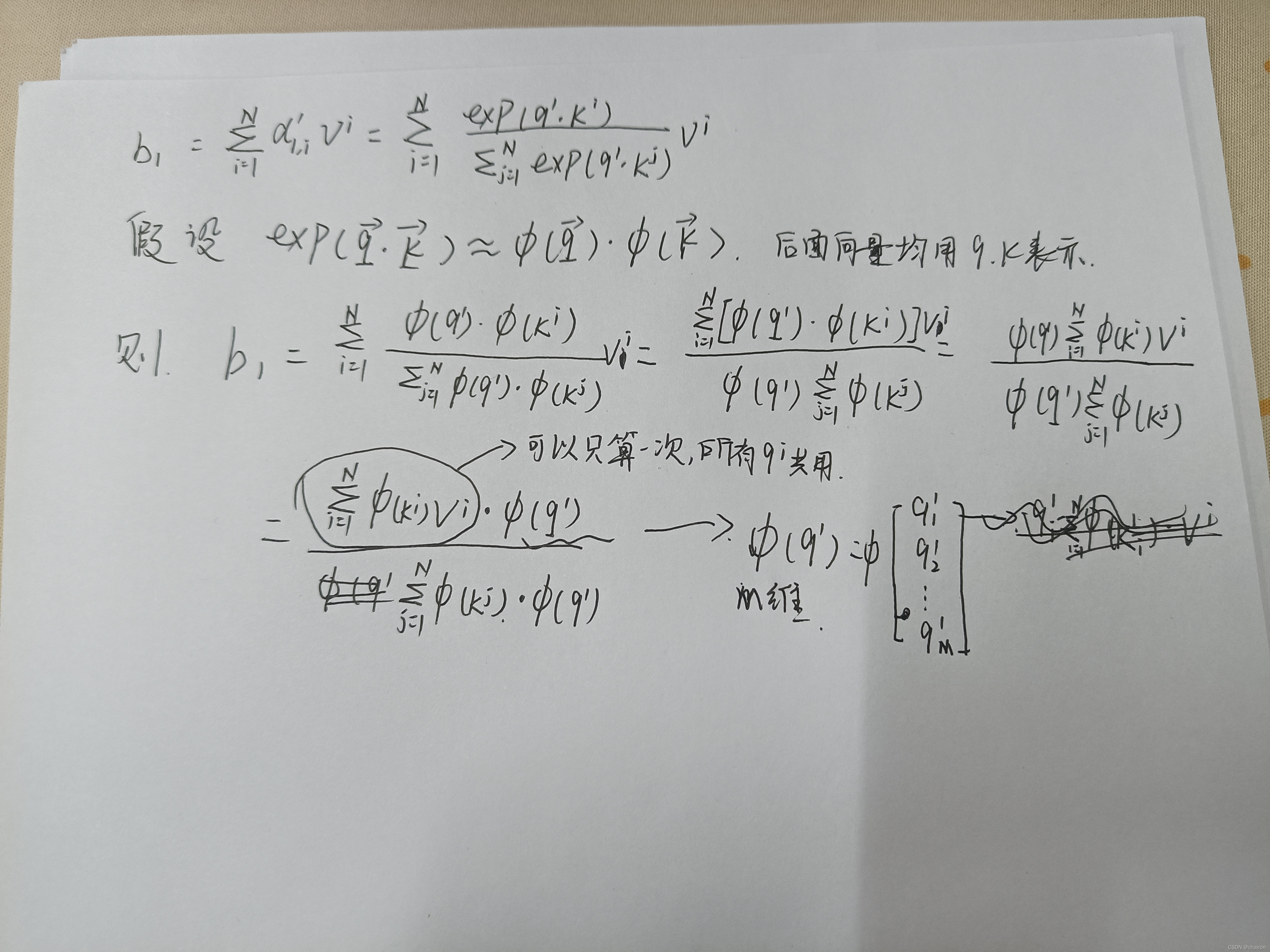

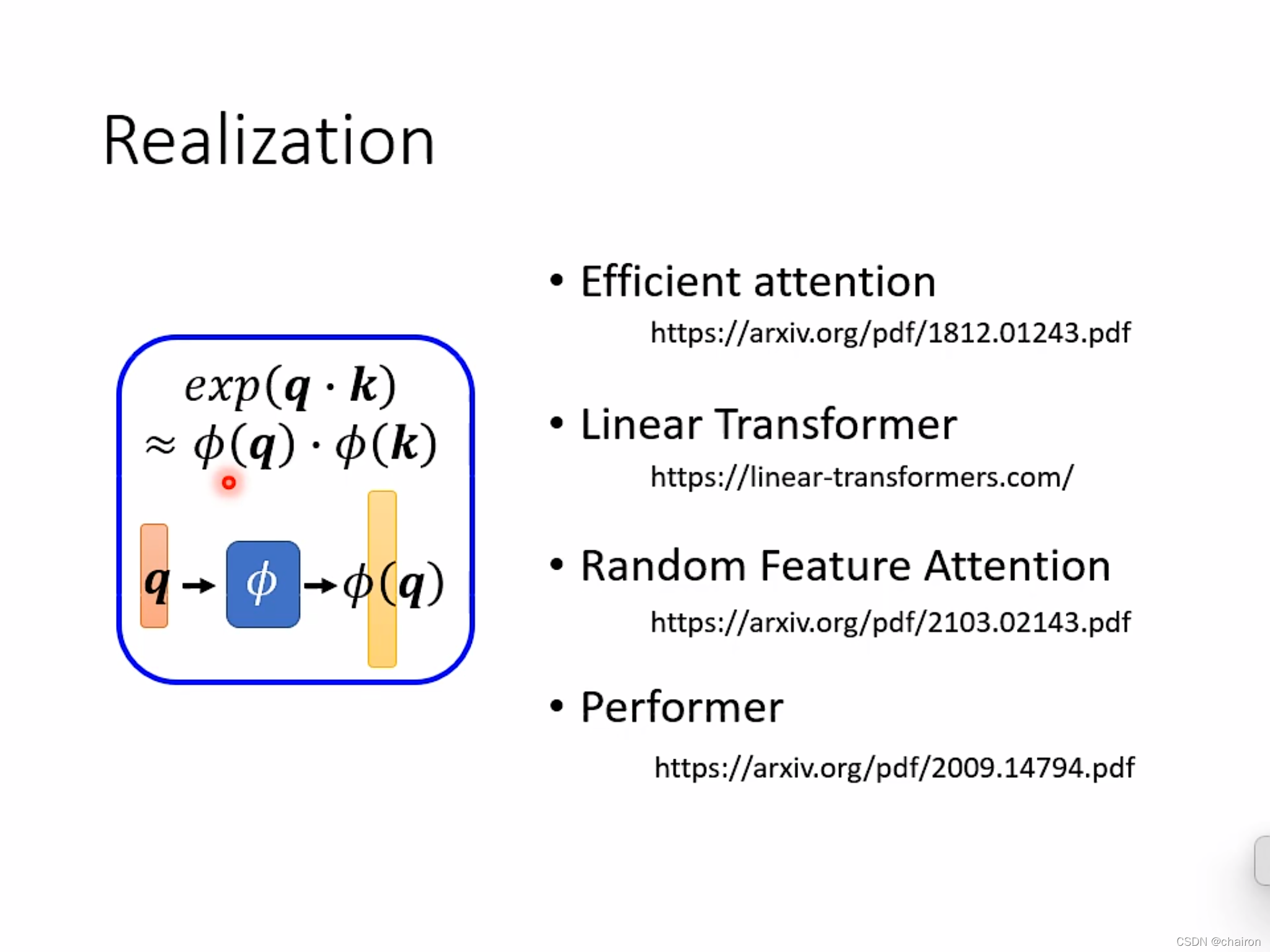

其实注意力机制的计算量是可以减少的!

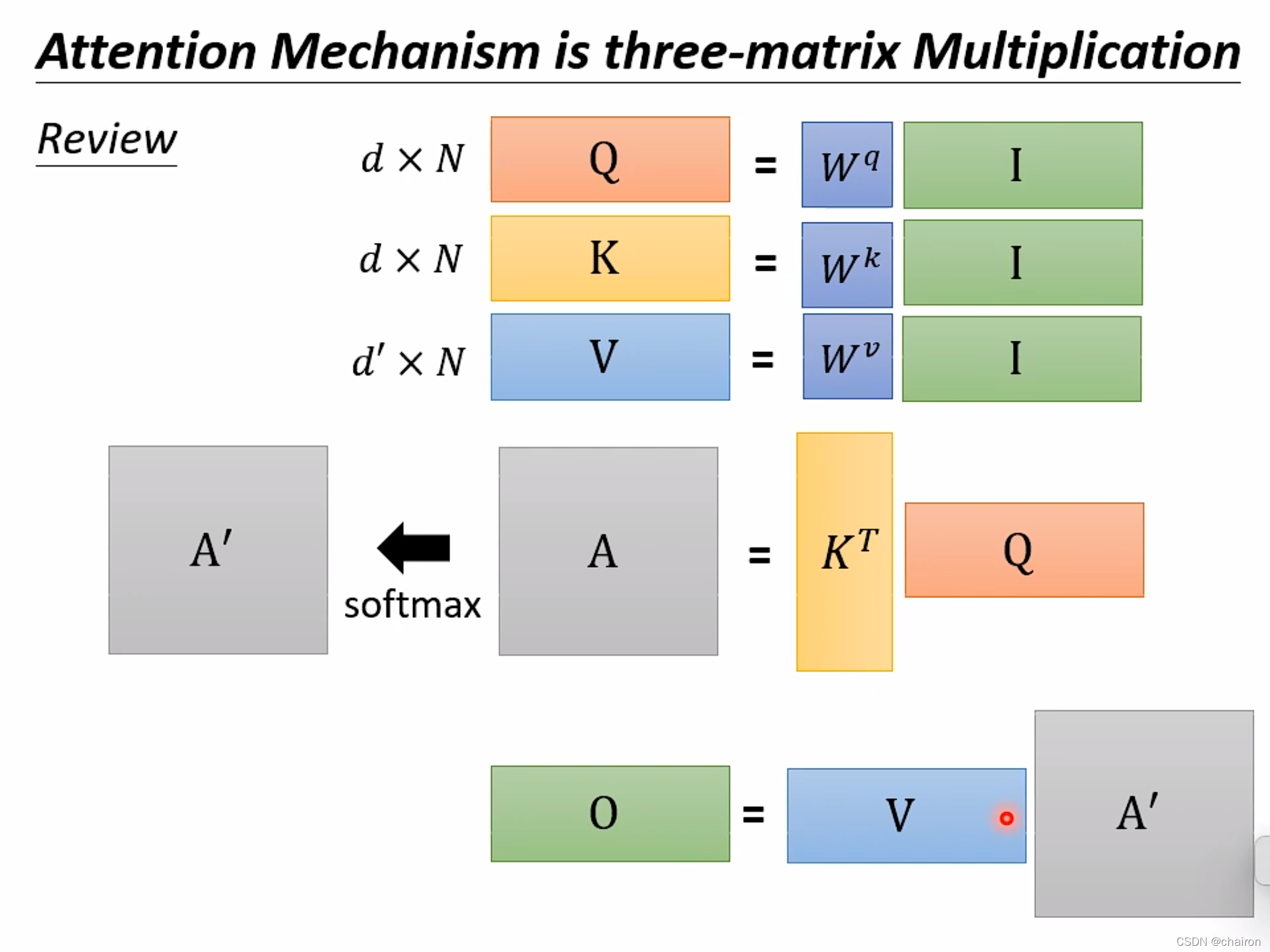

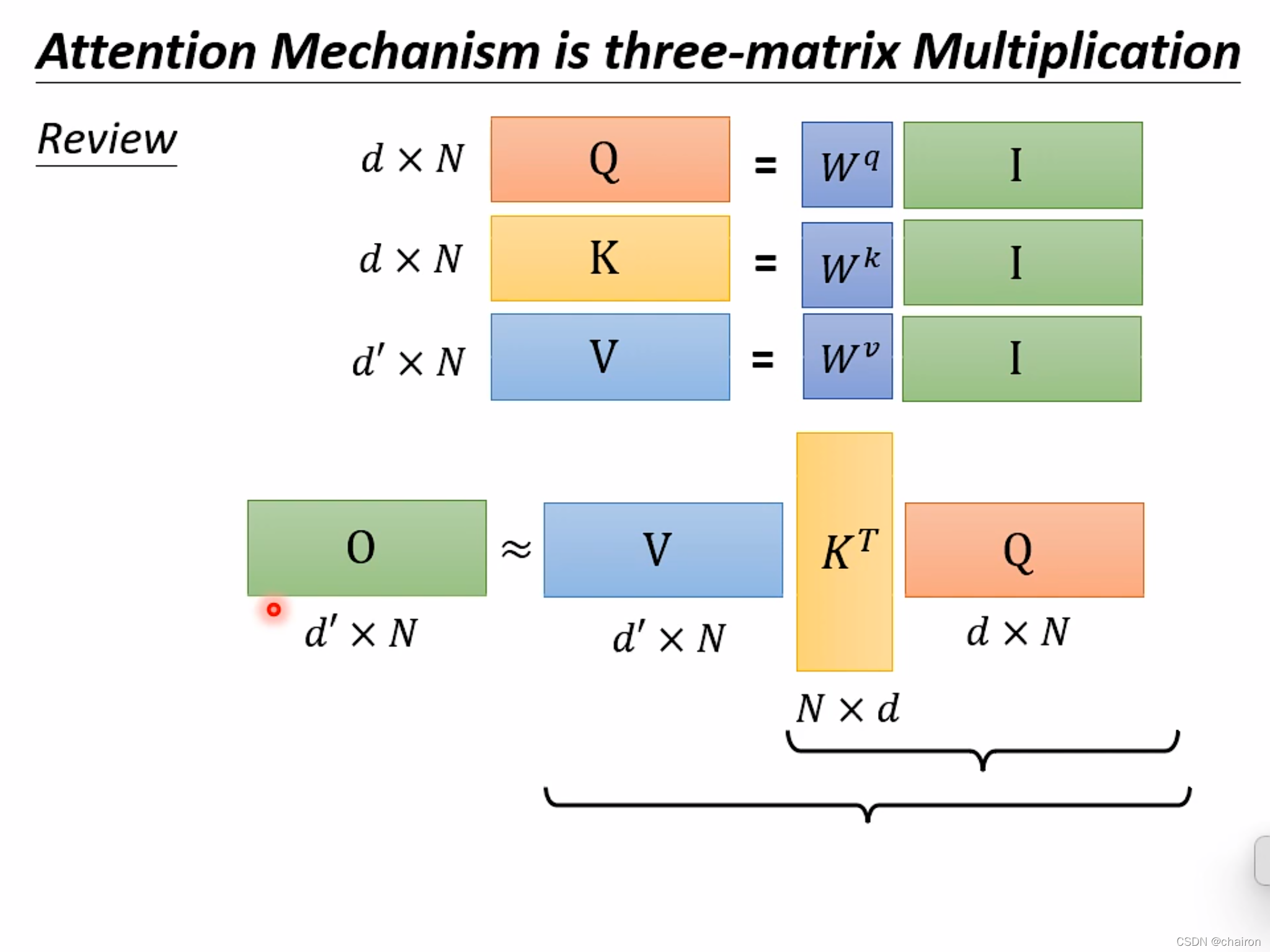

O = V ? ( K T ? Q ) = ( V ? K T ) ? Q , a t t e n t i o n = T ? Q O=V*(K^T*Q)=(V*K^T)*Q, attention=T*Q O=V?(KT?Q)=(V?KT)?Q,attention=T?Q

O = ( V ? K T ) ? Q O=(V*K^T)*Q O=(V?KT)?Q计算量要小很多

计算过程中也可减少计算量

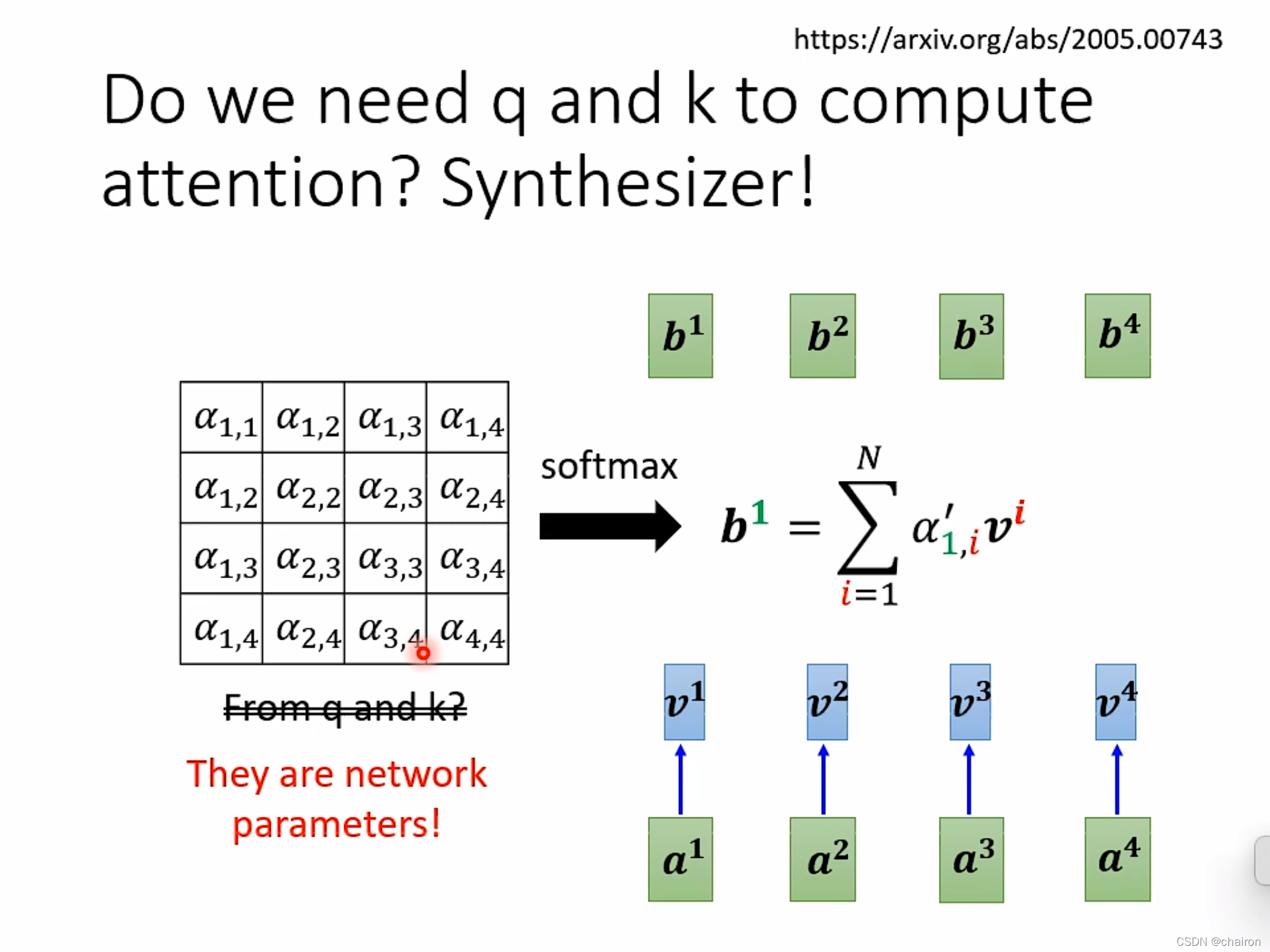

也许attention的计算不需要通过K、V向量进行计算,可以直接看作网络的参数

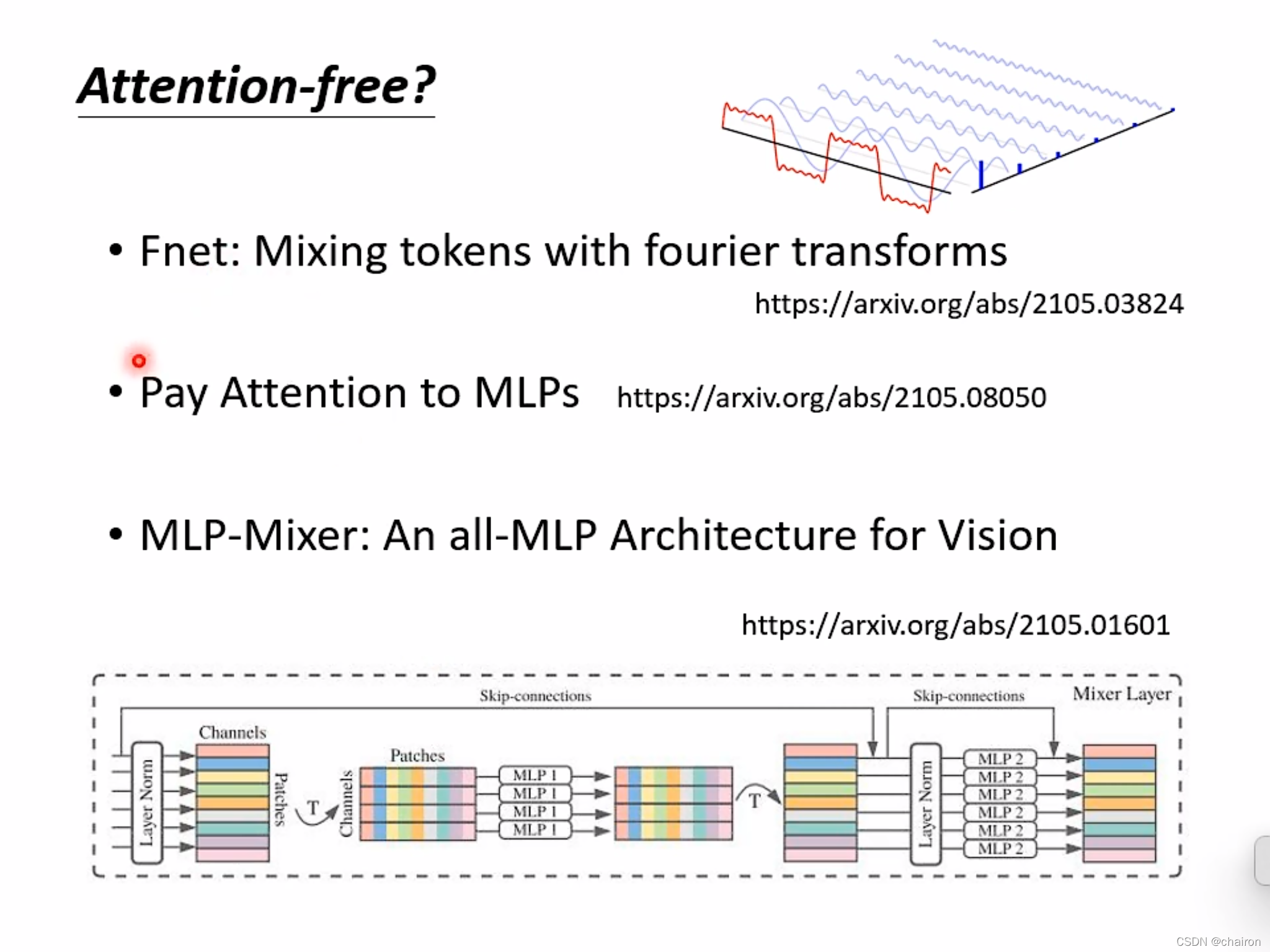

也许不需要attention机制网络效果也不错?