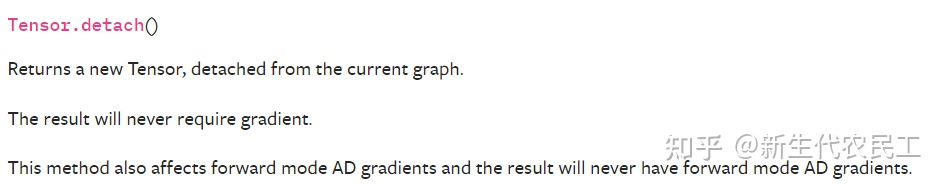

这里是官方文档对detach的定义

实际上,detach()就是返回一个新的tensor,并且这个tensor是从当前的计算图中分离出来的。但是返回的tensor和原来的tensor是共享内存空间的。

import torch

a = torch.tensor([1.0, 2.0, 3.0], requires_grad = True)

a = a.detach() # 会将requires_grad 属性设置为False

print(a.requires_grad)举个例子来说明一下detach有什么用。 如果A网络的输出被喂给B网络作为输入, 如果我们希望在梯度反传的时候只更新B中参数的值,而不更新A中的参数值,这时候就可以使用detach()

a = A(input)

a = a.deatch() # 或者a.detach_()进行in_place操作

out = B(a)

loss = criterion(out, labels)

loss.backward()如果希望修改A的参数, 而不希望修改B的参数, 那么就需要手动将B中参数的requires_grad属性设置为False

for param in B.parameters():

param.requires_grad = False还有一点需要注意的是Tensor.detach()和Tensor.data()的区别

Tensor.data()和Tensor.detach()一样, 都会返回一个新的Tensor, 这个Tensor和原来的Tensor共享内存空间,一个改变,另一个也会随着改变,且都会设置新的Tensor的requires_grad属性为False。这两个方法只取出原来Tensor的tensor数据, 丢弃了grad、grad_fn等额外的信息。区别在于Tensor.data()方法不能被autograd追踪到,如果你修改了Tensor.data()返回的新Tensor,原来的Tensor也会改变, 但是这时候的微分并没有被追踪到,那么当你执行loss.backward()的时候并不会报错,但是求的梯度就是错误的!因此, 如果你使用了Tensor.data()方法, 那么切记一定不要随便修改返回的新Tensor的值。如果你使用的是Tensor.detach()方法, 当你修改他的返回值并进行求导操作,会报错。 因此,Tensor.detach()是安全的。

转载链接:https://zhuanlan.zhihu.com/p/410199046

?