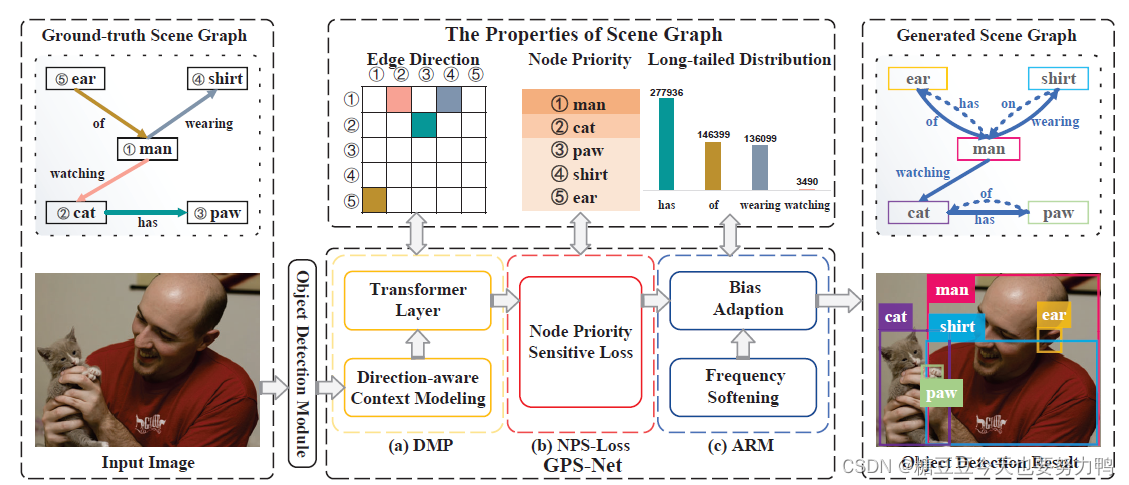

左边的目标检测就不说了,直接看中间的GPS-Net

1.DMP(Direction-Aware Message Passing)

方向敏感的消息传递

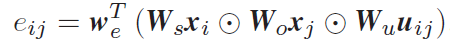

其中:

xi和xj是结点特征,视觉特征、物体分类置信度、空间特征cat在一起,再映射到512维

uij是i和j的union box的特征

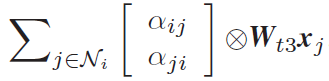

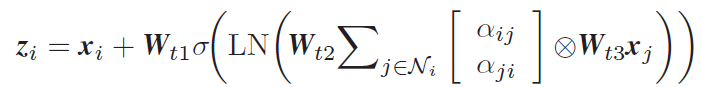

然后eij做正则化得到αij,并把αij和αji叠起来,如下式所示

Ni的意思是结点i的邻接结点

以上是下面DMP示意图的绿色部分,即方向敏感的上下文建模

下面是橙色部分,即Transformer层

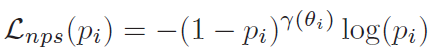

2.NPS-loss(Node Property Sensitive Loss)

结点优先度敏感loss

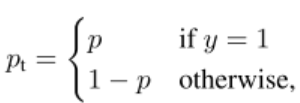

参照的是focal loss,我个人对这个focal loss是这样理解的:

举个例子,如果一个样本是正样本(gt=1),且模型预测的概率是0.9(pt=0.9),从直觉上理解,这个样本就是容易分类的,那么1-pt=0.1,log前面的系数(0.1的γ次方)就是一个很小的数,这代表这个容易分类的样本不占loss太大的权重,不用重点关注;

如果还是这个样本(gt=1),但是模型预测的概率只有0.1,那么从直觉上讲,这个样本就属于难分类的样本,1-pt=0.9,那么它的权重就变大了(0.9的γ次方),也就是所谓的“更关注难分类的样本”

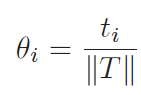

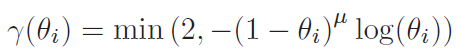

回到论文中的NPS-Loss,首先计算θi,即结点i的优先度,ti是结点i所在的三元组数量,T是这张图片总共含有的三元组数量

θi越大,说明这个结点优先度越高,但是γ(θi)越小,因为优先度高的结点是易分类样本;优先度低的结点是难分类样本,γ会更大一些

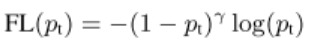

下面这个式子就是focal loss了

注:NPS-Loss只用于物体分类

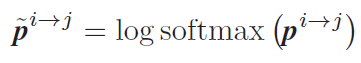

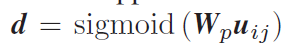

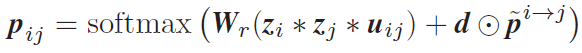

3.ARM(Adaptive Reasoning Module)

自适应推理模块

首先对各类谓语的频率做了log softmax

最终的谓语概率分布:

这个式子的意思是根据物体对的视觉特征去调整bias

--------------------------------------一些碎碎念----------------------------------------

开始逐渐习惯居家生活

并且不想回学校:(

过了这周就可以结两门课了好快啊

希望实验一切顺利