A One-Stage Domain Adaptation Network with Image Alignment for Unsupervised Nighttime Semantic Segmentation一种用于无监督夜间语义分割的带图像对齐的单阶段域自适应网络

0.摘要

在本文中,我们解决了夜间图像的语义分割问题,在自动驾驶中,夜间图像与日间图像具有同等重要的作用,但由于照明条件非常差和注释数据集稀少,语义分割也更具挑战性。它可以被视为一个无监督的域自适应(UDA)问题,即应用白天采集的其他标记数据集来指导网络训练,同时减少域偏移,使训练后的模型能够很好地推广到夜间图像的期望域。然而,目前的通用UDA方法不足以解决白天和夜间域之间的显著外观差异。为了克服如此大的域差距,我们提出了一种新的域自适应网络“DANIA”,用于夜间语义图像分割,该网络利用标记的白天数据集(源域)和包含粗略对齐的白天-晚上图像对(目标白天和夜间域)的未标记数据集。这三个域用于通过网络中的对抗训练执行多目标自适应。具体来说,对于未标记的昼夜图像对,我们使用白天图像上静态对象类别的像素级预测作为伪监督来分割对应的夜间图像。我们还包括一个图像对齐步骤,通过估计流量来细化白天图像产生的伪监控,从而减轻昼夜图像对之间不对齐造成的不准确。最后,采用重加权策略进一步改进预测,尤其是提高了小目标的预测精度。提出的DANIA是一个用于夜间语义分割的单阶段自适应框架,它不作为单独的预处理阶段训练额外的昼夜图像传输模型。在黑暗的苏黎世和夜间驾驶数据集上进行的大量实验表明,我们的DANIA在夜间语义分割方面达到了最先进的性能。

1.概述

为了将给定图像的每个像素标记为一个对象类别,语义分割是一项基本的计算机视觉任务,有利于许多应用,如自动驾驶[1]、[2]、医学成像[3]和人类解析[4]。近年来,随着深度学习技术和计算能力的进步,对白天在良好光照条件下拍摄的自然场景图像进行语义分割的最新性能得到了显著提高[5]、[6]、[7]。值得注意的是,这种性能改进归功于大量像素级注释图像。然而,由于缺乏用于训练的注释良好的数据集,在雾天[8]和夜间[9]、[10]、[11]等恶劣天气/光照条件下拍摄的图像分割性能仍然不令人满意。由于存在许多不可识别的区域和视觉危害[12],例如曝光不足/过度和运动模糊,手动为那些真实的恶劣天气或夜间场景图像创建像素级注释要困难得多。在本文中,我们主要研究夜间的语义图像分割,它与白天的语义图像分割一样频繁和重要,尤其是对于自动驾驶。

直接应用白天数据集上训练的网络来分割夜间图像会遭受严重的数据偏差[11],并可能导致精度下降50%,如我们后面的实验所示(如表1)。许多无监督域适配(UDA)方法已经被提出,通过弥合标记域和未标记域之间的差距来解决这种数据偏差[13],[14],[15]。将白天和夜间分别作为标记域和未标记域,UDA可以通过特征分布对齐或对抗性训练为夜间语义分割提供通用解决方案。许多通用UDA方法都是在合成到真实[16]、[17]的设置下设计的——使用标记的合成数据集和未标记的真实数据集来减轻大规模真实数据手动注释的负担。然而,由于缺乏大规模标记的合成夜间图像数据集,该设置不适用于夜间语义分割

鉴于白天和夜间之间的外观(例如照明)差异很大,因此也很难使用通用UDA方法将网络训练直接从(标记的)白天域调整到(未标记的)夜间域,如我们后面的实验(例如表2)所示。为了解决这个问题,有人提出了几种UDA方法的变体,将语义分段模型从白天转移到夜间,而无需在夜间域中使用标签。在[9]、[18]、[19]中,引入了一个中间的暮光域作为桥梁,以构建从白天到夜间的平滑适应。在[9]、[11]、[19]、[20]、[21]、[22]中,对图像传输网络进行了训练,以使夜间或白天的图像风格化,并构建用于域自适应的合成数据集。然而,这两项工作受到两个主要限制:

- 负迁移。所有这些方法都需要额外的预处理阶段,在白天和夜间之间训练图像传输模型。这不仅耗时,而且使后期阶段的性能高度依赖于预处理阶段的性能。尤其是,当域间距较大时,无法保证传输的像素能够保持与原始图像中完全相同的语义信息[23]。

- 中间域的使用。上述一些方法将黄昏作为白天和黑夜之间的中间区域,执行多阶段自适应,这会带来更多计算负担。此外,与白天和夜晚相比,黄昏场景图像更难捕捉,因为它根据太阳仰角进行了严格的定义[18]。

针对上述局限性,本文利用最新发布的Dark Zurich数据集[9]、[19],提出了一种新的带图像对齐的单阶段域适应网络(dannia)用于夜间语义分割。该数据集包含了利用GPS记录进行粗对齐的未标记的昼夜场景图像对。提出的DANIA从城市景观数据(源域)到Dark Zurich日间数据(Dark Zurich- d,目标日间数据)和夜间数据(Dark Zurich- n,目标夜间数据)进行多目标适配。具体来说,我们首先将cityscape模型(包含带有标签的大规模训练图像)改编为Dark Zurich-D模型,因为它们都是在白天拍摄的。然后,使用Dark Zurich-D的预测作为Dark Zurich-N的伪监督来进行网络训练。利用图像重光照子网络,使不同区域的图像强度分布更加接近。在[13]之后,我们应用权重共享语义分割网络对重光照图像进行预测,并在输出空间中进行对抗学习,以确保不同域间的布局非常接近。为了缓解GPS记录造成的误差,我们引入了一种图像对准策略来估计昼夜图像对下的流量,然后用它来校正白天图像提供的伪标签。此外,还提出了一种加权策略来提高小目标的预测精度。我们在Dark Zurich和Nighttime Driving数据集上进行了广泛的实验,以证明提出的DANIA对夜间语义分割的有效性

这项工作的初步结果已发表在会议论文集[24]上。与已发表的会议论文相比,本文进行了重写,新增了许多内容,并进行了以下扩展:

- 该方法通过结合图像对齐来改善昼夜图像对的不对齐,并对所有的实验进行更新,以反映该方法在会议版本中的性能提高。

- 提供了更广泛的比较结果,包括与最近应用最先进的UDA方法进行语义分割的比较,与本工作中引入的新特征进行消融研究,以及在测试阶段使用白天-夜晚对的场景。

- 增加了更多的分析结果和讨论,例如,密度分布的直方图可视化,以及所提方法中各种图像预处理方法的使用。

2.相关工作

2.1.基于领域自适应的图像语义分割

研究了领域自适应方法,将从源领域学到的知识转移到目标领域,目标领域具有相似的对象,但数据分布不同,从而可以在没有自身监督的情况下获得目标领域的可比预测。近年来,许多UDA方法被提出用于语义分割,以避免人工密集标注的高成本。在[25]中,Hoffman等人提出了一种新颖的带有类别约束[26]的全卷积领域对抗学习方法用于语义分割。Tsai等人[13]后来开发了多级对抗网络,在输出空间进行域自适应。Luo等人通过考虑类级联合分布对齐,进一步改进了全局对抗性对齐。

除了对抗学习技术外,图像转换和风格转换技术[28]从源图像到目标图像,或从目标图像到源图像,已经被广泛应用于领域自适应[29],[30]。在[31]、[32]、[33]中,在源域和目标域之间进行图像平移的过程中,得到了域不变表示。另一个研究领域[15],[34]采用课程式学习,先学习目标领域的易属性,然后利用其正则化语义切分模型。近年来,自训练也成为一种常用的提高性能的策略,在多轮网络训练中,通过迭代预测和微调一组伪标签来提高性能,如[14],[35],[36],[37],[38]

以上所有方法都专注于合成到真实(即GTA5[16]或SYNTHIA[17]到cityscape)或跨城市图像(即cityscape到CrossCity[39])的域适应,这些都是白天到白天的适应。在本文中,我们转而关注具有显著不同照明模式[9]的白天和夜间域之间的适应。这些通用的领域自适应方法不能很好地处理日间和夜间图像之间显著的领域差距,在夜间语义分割中效果不佳。

2.2.夜间的语义分割

作为UDA的一个子问题,现有的夜间语义分割方法都源于上述UDA方法。Dai等人首先利用中间暮色域,逐步将白天场景训练的语义模型适应为夜间场景。Sakaridis等人的[9],[19]进一步将其扩展到一个有指导的课程适应框架,该框架使用程式化的合成图像和未标记的真实图像来利用场景图像的跨时间对应关系。然而,这种逐步适应的方法通常需要训练多个语义分词模型,例如[9]中三个模型分别针对三个不同的领域,效率非常低。在接下来的工作中,[20],[21],[22]还训练了一些额外的图像传输模型,如CycleGAN[28],在训练语义分割模型之前进行从日到夜或从夜到日的图像传输。在这些方法中,自适应和语义分割的性能高度依赖于预处理阶段预先训练的图像传输模型

Vertens等人[40]提出利用热红外图像作为RGB图像的补充输入,进行夜间语义分割,因为热辐射对光照变化不是很敏感。在[10]中,提出了一种基于两阶段对抗训练的雨夜场景语义分割方法,该方法对雨夜场景进行了昼-夜近场景对之间的域适应。最近,Zheng等人提出了一种任务不确定的图像翻译方法,该方法将领域特定和领域不变信息解耦,以提高在恶劣天气下的语义分割和目标检测的性能。

与上述方法不同的是,本文提出的DANIA在不使用任何其他图像模态的情况下,对夜间语义分割网络进行了一阶段端到端对抗学习训练。

2.3.图像对齐

图像对齐的目的是建立一对图像之间的空间对应关系。它是计算机视觉中的一个基本问题,在许多领域都有重要的应用,包括视觉定位[41]、[42]、[43]、双视几何估计[44]、三维重建[45]和光流估计[46]、[47]。现有的图像对准技术根据图像对之间对应关系的表示,基本上可以分为参数对准和非参数对准两大类[46]。典型的参数化方法使用RANSAC[48]从稀疏图像特征(如SIFT[49]和LIFT[50])中估计变换矩阵。非参数化方法的目标是通过像素级一致性约束[51],[52]来优化两幅图像之间的密集对应(例如,光流和视差图)。也有一些混合方法同时执行参数和非参数方法[46],[53],[54],[55],[56]用于图像对齐。

本文采用GPS参数大致对齐的方法获取昼夜图像对。我们发现,在这样一幅日夜图像对上,对应点的偏移量可以达到数百个像素的量级,这可能会影响本文提出的UDA算法的有效性。为了解决这一问题,我们将最新的图像对齐技术[46]集成到我们的方法中,以更好地对齐昼夜对,进一步提高夜间语义分割的性能

3.提出的方法

3.1.架构概括

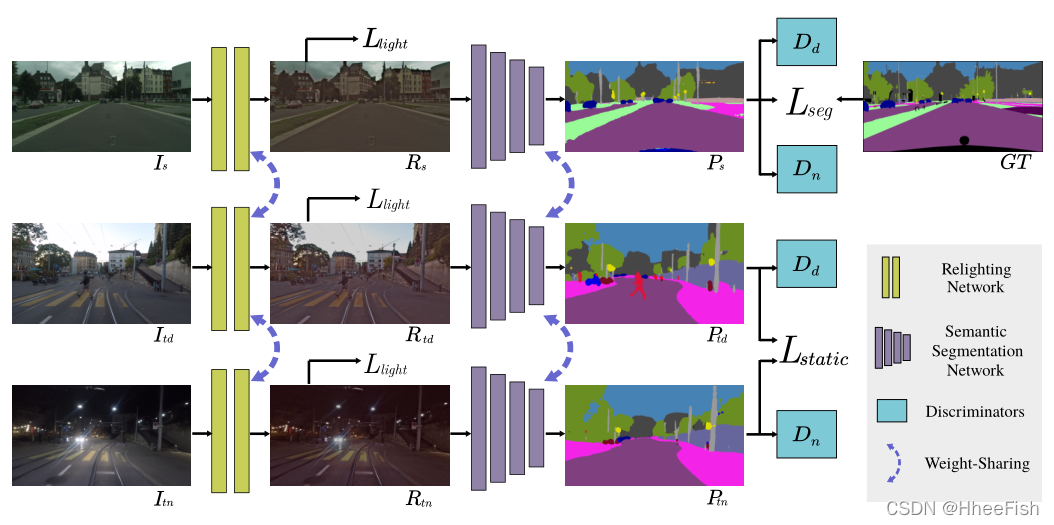

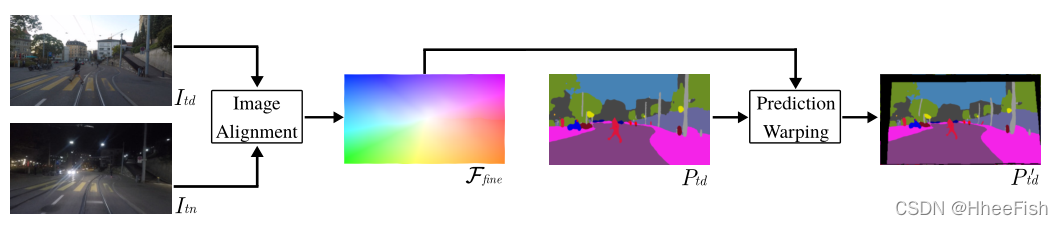

图1。拟建DANIA的架构。三幅输入图像Is、Itd和Itn分别来自源域S(城市景观)和两幅目标域Td和Tn(Dark Zurich-D和Dark Zurich-N)。它们通过一个重量共享的图像重照明网络,该网络可以使它们的分布通过光损失灯光彼此接近。所有的输出都被输入到一个权重共享分割网络中,以分别获得三个域的预测,即Ps、Ptd和Ptn。对于Is的预测,使用源数据集中的地面真值分割计算语义分割损失Lseg。此外,Itd对静态对象类别的预测为Itn的相应类别提供了较弱的监督,这反映在静态损失Lstatic上。请注意,重新照明网络和语义分段网络的组成构成了生成器G。两个鉴别器Dd和Dn分别用于区分源域S或目标域Td和源域S或目标域Tn的输出。请注意,在计算静态损失时,静态损失流量的梯度仅通过P Stn、静态对象类别的预测和日间预测作为标签分离。

我们的方法涉及一个源域S和两个目标域Td和Tn,其中S、Td和Tn分别代表城市景观(白天)、Dark Zurich-D(白天)和Dark Zurich-N(夜间)。注意,只有cityscape的源域S在训练中有ground-truth语义分割。所提出的DANIA同时进行从S到Td和S到Tn的域自适应,由三个不同模块组成:图像重照明网络、语义分割网络和两个鉴别器,如图1所示。

注意,在我们的方法中,Td被视为S和Tn之间的中间域——Td与S共享光照相似性,与Tn共享内容相似性。我们的方法假设S和Td之间的域间距小于S和Tn之间的间距,因此,日间分支可以帮助夜间分支。

3.2.网络架构

下文详细阐述了拟建DANIA的所有模块。

3.2.1.图像重新照明网络

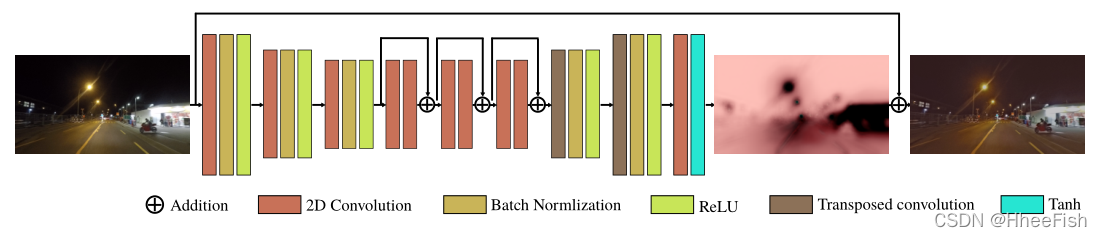

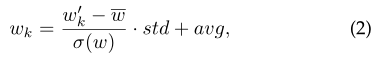

图2。图像重新照明网络的结构。它由四个卷积层、三个残差块和两个转置卷积层组成,每个卷积层后面除了最后一个卷积层之外,还有一个批量归一化层。然后将最后一层的输出添加到输入图像中,以获得重新照明的图像。

受[57]的启发,我们设计了一个图像重照明网络,使来自不同领域的图像的强度分布彼此接近,从而使后面的语义分割网络对光照变化不那么敏感。重新照明网络将三个域中的场景图像Is、Itd和Itn作为输入,分别生成重新照明图像Rs、Rtd和Rtn。重照明网络共享来自三个域的所有输入图像的权重,该网络的详细结构见图2。

3.2.2.语义分割网络

我们选择了三个广泛使用的语义切分网络纳入我们的方法:Deeplab-v2[58]、RefineNet[59]和PSPNet[60]。请注意,在所有这些协议中,公共主干都是ResNet-101[61]。对于这个模块,我们共享来自三个域的所有输入图像的权重。语义分割网络以Rs、Rtd和Rtn为输入,分别为这三个域分割切分预测(类别似然图)Ps、Ptd和Ptn。图像重照明网络和语义分割网络的组合构成了拟议DANIA的生成器G。

3.2.3.鉴别器

如[13]中所述,鉴别器设计用于通过在输出空间中执行对抗性学习来区分分割预测是来自源域还是来自任一目标域。在[13]之后,我们利用所有完全卷积层修改了[62]中的体系结构。特别地,它包括5个卷积层,信道号为{64、128、256、256、1},内核大小为4×4。前两个回旋层的步幅为2,其余层为1。由于我们有两个目标域Td和Tn,我们设计了两个鉴别器Dd和Dn来分别区分输出是来自S还是Td以及来自S还是Tn。这两个鉴别器具有相同的结构,权重是联合训练的。

3.3.概率重新加权

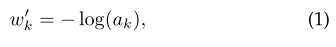

由于源域中不同目标类别的像素数量不均衡,在训练鉴别器时,通过将一个像素预测为道路、建筑、树等大型目标类别,网络训练通常更容易收敛。在这种情况下,很难通过输出空间的全局对齐来正确预测数据集中标注相对较少的小对象的像素,比如极点、符号和光线。为了解决这一问题,我们提出了一种重新加权策略来调整预测的类别似然图。具体来说,对于每个类别k∈C,我们首先定义一个权重

式中ak为源域中被标记为类别k的所有有效像素的比例。显然ak的值越小,w‘k的值就越大,使用这样的权重可以帮助对较小尺寸的对象进行分类。在这里,计算对数是为了防止对小型对象类别的权重过大。在我们的实验中,我们进一步将这个权重归一化

式中,w-和σ(w)分别是w’k, k∈C的均值和标准差。参数std和avg是我们预先选择的两个正常数,以使wk的取值范围主要为正。在培训过程中,我们根据经验设定std = 0.1, avg = 1.0。然后将每个归一化权值wk与预测似然图P对应的类别通道相乘,其中P∈{Ptd, Ptn}。因此,通过对乘法结果进行argmax操作,得到最终的语义分割结果F

3.4.昼夜对应

图3所示。建立昼夜图像对之间的对应关系和预测变形的过程。这个样本中的估计流量显示了图像对之间的放大和缩小效果。

如图1所示,Ptd和Ptn之间存在大量的像素偏移,这是由于白天和夜间图像之间的视图变化和摄像机运动造成的。这种昼夜对之间不可忽略的偏差限制了白天图像可以提供给夜间图像的可靠预测参考。因此,我们整合了一种图像对齐方法[46],在白天图像Itd和夜间图像Itn之间建立密集对应关系,避免了低置信的伪标签。

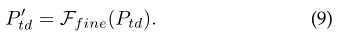

[46]之后,在ImageNet上进行预训练的ResNet-50分别提取Itd和Itn的多级深度特征。然后利用RANSAC算法估计两幅图像之间的单应性,该单应性可以看作是两幅图像之间的粗流。然后,在MegaDepth[63]数据集上训练一个细流网络[46],对粗流Fcoarse进行细化,得到细流图Ffine。最后,利用估计的流量Ffine对语义分割预测Ptd进行变形,得到P‘td,如图3所示

3.5.目标函数

在本小节中,我们介绍了端到端DANIA训练中涉及的所有目标函数,包括光损失、语义分割损失、静态损失和对抗损失。

3.5.1.光损失

为了保证图像重照明网络后输出的Rs、Rtd和Rtn的强度分布接近,提出了光损耗的方法。光损耗由四种损耗函数组合而成:总变异损耗Ltv、曝光控制损耗Lexp、结构相似损耗Lssim和风格转移损耗Lstyle。

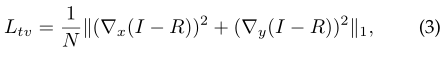

总变异损失Ltv[64]被广泛应用于图像去噪[65]和图像合成[66],使图像更加平滑。在本文中,我们使用这样的损失函数去除了粗糙的纹理,如噪声,以促进语义分割。损失Ltv定义为

其中I∈ {Is,Itd,Itn}表示输入图像,R∈ {Rs,Rtd,Rtn}是重新照明网络的输出,N是I中的像素数,?x和?y分别表示沿x和y方向相邻像素之间的强度梯度,||·||1是所有像素总和的L1范数。

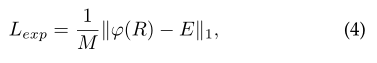

为了在白天和夜间场景中获得类似的照明效果,我们采用[67]中提出的以下曝光损失Lexp来控制曝光水平:

式中,φ是32×32平均池函数,M表示以φ?的像素数

根据[67],曝光损失最小化了来自微光图像的局部区域的平均强度和预定义的良好曝光水平E之间的距离,以调整微光图像的曝光水平。相反,我们利用这个损失函数,根据夜间图像的强度调整白天图像的曝光水平。因此,与[67]不同,此处E上的所有像素具有相同的值,该值被动态设置为该训练批中夜间图像的平均强度值,并且该值在每次迭代中都会发生变化。出于同样的目的,我们还计算了Gram矩阵[68],该矩阵具有捕捉视觉风格的显著能力,下面[69]计算了风格损失

其中GR和GItn是重新照明图像R和输入夜间图像Itn的Gram矩阵

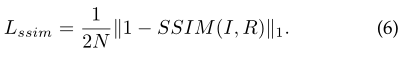

结构相似性损失Lssim[70]被广泛用于图像重建[71],[72]。在这里,我们应用该损失函数来确保生成的重新照明图像R能够保持原始图像I的结构。损失Lssim定义如下:

如[71]中所述,我们在该损失函数中使用了一个简化的SSIM(结构相似性指数测度)和一个3×3的块滤波器。

最后,通过组合所有四个损耗项,我们的光损失定义为 :

其中,在所有实验中,αtv、αexp、αstyle和αssim分别设置为10、1、10和1。

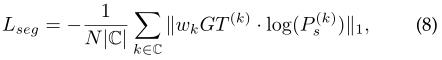

3.5.2.语义分割损失

我们采用广泛使用的加权交叉熵损失来训练源域中的语义图像分割:

其中,P(k)s是来自源图像的预测Ps的第k个通道,wk是等式(2)中定义的权重,GT(k)是第k类的基本真值的一个热编码。

3.5.3.静态损耗

基于白天图像在仅考虑静态对象类别时与其对应的夜间图像具有语义相似性这一事实,我们在此引入静态损失,为夜间图像中的静态对象类别(例如道路、人行道、墙、栅栏、杆、灯、标志、植被、地形和天空)提供像素级的伪监控。

更正式地说,考虑到细分预测Ptn∈ RH×W×C,我们只考虑对应于静态类别的信道来计算这个损失。让我们把CS表示为静态对象类别的总数,那么它将保持PStn∈ RH×W×CS。

为了减少由于未对准而由Ptd提供的错误监控,我们使用从昼夜图像对估计的精细流动线来扭曲Ptd。最后,可以通过以下方法获得精确的日间预测:

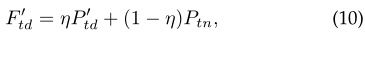

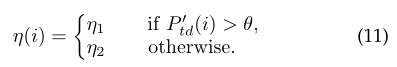

全局图像对齐有助于校正白天图像的预测,尤其是对于大尺寸物体。然而,这可能会影响对小对象和大对象边界周围像素的预测,即,极点可能会扭曲到错误的位置。在某些情况下,边界附近的区域可能会丢失语义伪标签,如图3所示。为了缓解扭曲操作造成的这些副作用,我们通过使用夜间预测Ptn的简单加权融合方案进一步校正P’td: .

式中η是与P’td形状相同的置信矩阵,每个像素i处的置信值可通过以下公式计算:

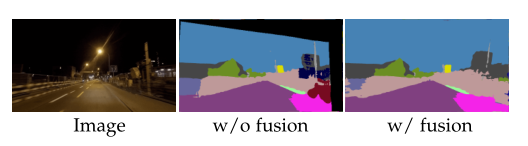

这里我们分别设置η1=0.8、η2=0.6和θ=0.4。我们的融合操作受到[9],[19]中提出的置信度自适应预测融合的启发,该融合旨在基于其相应的日间预测,同时考虑两个预测的动态和静态内容,细化最终的暗图像预测。具体来说,我们静态损耗中的融合旨在利用夜间预测对白天预测进行细化,以获得更好的伪标签来训练网络。注意,通过应用公式(11),融合是P’td和Ptn的非线性组合。如图4所示,建议的融合可以纠正许多错误扭曲的标签,例如,本例中建筑物上的标签。

图4所示。在没有和应用融合方案的情况下,伪标签F?std的可视化

然后,我们应用公式(2)计算重新加权预测F?’td,并考虑静态类别,似然图F?std∈ RH×W×CS将用于提供监督。

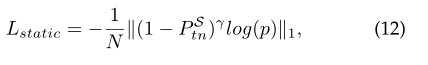

我们使用focal损失[73]来弥补不同类别训练样本之间的不平衡。最后,静态损耗Lstatic的定义如下: .

其中N是分割地面真值中有效像素的总数,γ是聚焦参数(在所有实验中设置为1),p是正确类别的似然图。与[73]中的焦损不同,我们通过以下公式计算c类3×3局部区域中每个像素i处的p:

其中,o是语义伪地面真值的一个热编码,它是通过将每个像素的最大元素设置为1,将其他元素设置为0,从F?std导出的,j表示以i为中心的3×3区域的每个位置。在扭曲和融合操作后,伪地面真值仍然与预测值不完全一致。3×3区域的使用有助于提高容错率,消除伪标签的缺陷。

3.5.4.对抗损失

我们使用两个鉴别器进行对抗性学习,用于区分输出是来自源域还是来自两个目标域之一,即S或Td和S或Tn。我们采用最小二乘损失函数[74]来使得Ptd和Ptn接近Ps。具体而言,我们将这两种对抗性损失(Ladv)的组合定义为:

其中Ptd = G(Itd), Ptn = G(Itn), r为源域标签,其分辨率与[13]鉴别器的输出分辨率相同。

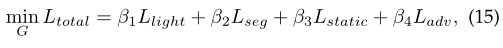

因此,生成网络的总损耗Ltotal (G)由Llight、Lseg、Lstatic和Ladv组合定义:

其中β1, β2, β3, β4在所有实验中分别设为0.01,1,1,0.01。对

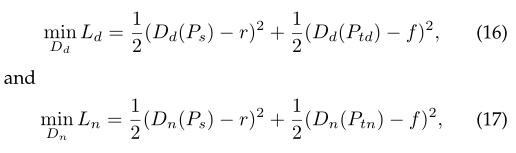

生成网络和相应的鉴别器进行交替训练,分别定义鉴别器的目标函数Ds和Dn

其中f是目标域的标签,与鉴别器的输出具有相同的分辨率。

4.实验

4.1.实验设置

我们在单个NVIDIA Tesla V100 16GB GPU上使用PyTorch实现了提议的DANIA。在[58]之后,我们使用随机梯度下降(SGD)优化器训练我们的网络,其动量为0.9,权值衰减为5 × 10?4。将基本学习率设置为2.5 × 10?4,然后我们采用poly学习率策略,以0.9的幂次降低基本学习率。批处理大小设置为2,训练迭代的总次数设置为50,000。我们使用Adam优化器[77]来训练鉴别器,系数设为(0.9,0.99)。鉴别器的学习速率设置为2.5 × 10?4,并遵循与生成器相同的衰减策略。此外,我们在cityscape数据集上采用0.5 - 1.0尺度下512个作物规模的随机种植,在Dark Zurich数据集上采用0.9 - 1.1尺度下960个作物规模的随机种植,在训练中采用随机水平翻转。为了使训练更容易收敛,我们使用了在cityscape上预先训练了15万次迭代的语义分割模型,并在表1中报告了不同分割模型在cityscape和Dark Zurich验证集上的性能。

5.结论

在本文中,我们提出了一种新的端到端神经网络DANIA用于无监督夜间语义分割,它从一个标记的白天数据集到一个未标记的白天图像对进行一阶段自适应。在该方法中,首先利用具有特殊光损失函数的图像重照明网络,使不同区域的图像强度分布趋于接近。未标记Dark Zurich-D数据被用来在有标记的白天图像(城市景观)和未标记的夜间图像(Dark Zurich-N)之间架起桥梁。此外,引入图像对齐步骤来解决昼夜图像对之间的不对齐问题。通过利用Dark Zurich-D和城市景观之间相似的照明模式,以及Dark Zurich-D和Dark Zurich-N之间静态对象类别的调整对齐,我们的DANIA执行多目标域适应和重新加权策略来提高小对象的性能。实验结果证明了每个设计组件的有效性,并表明我们的DANIA在暗苏黎世和夜间驾驶测试数据集上达到了最先进的性能。

参考文献

[1] A. Geiger, P . Lenz, and R. Urtasun, “Are we ready for autonomous driving?” in IEEE Conference on Computer Vision and Pattern Recognition, 2012, pp. 3354–3361.

[2] Z. Wu, X. Wu, X. Zhang, S. Wang, and L. Ju, “Semantic stereo matching with pyramid cost volumes,” in IEEE International Conference on Computer Vision, 2019, pp. 7484–7493.

[3] X. Chen, B. M. Williams, S. R. Vallabhaneni, G. Czanner, R. Williams, and Y . Zheng, “Learning active contour models for medical image segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 11 632–11 640.

[4] X. Zhang, Y . Chen, B. Zhu, J. Wang, and M. Tang, “Part-aware context network for human parsing,” in IEEE Conference on Computer Vision and Pattern Recognition, 2020, pp. 8971–8980.

[5] J. Fu, J. Liu, H. Tian, Y . Li, Y . Bao, Z. Fang, and H. Lu, “Dual attention network for scene segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 3146–3154.

[6] Z. Huang, X. Wang, L. Huang, C. Huang, Y . Wei, and W. Liu, “Ccnet: Criss-cross attention for semantic segmentation,” in IEEE International Conference on Computer Vision, 2019, pp. 603–612.

[7] J. Wang, K. Sun, T. Cheng, B. Jiang, C. Deng, Y . Zhao, D. Liu, Y . Mu, M. Tan, X. Wang, W. Liu, and B. Xiao, “Deep high-resolution representation learning for visual recognition,” IEEE T ransactions on Pattern Analysis and Machine Intelligence, vol. 43, no. 10, pp. 3349–3364, 2021.

[8] C. Sakaridis, D. Dai, and L. Van Gool, “Semantic foggy scene understanding with synthetic data,” International Journal of Computer Vision, vol. 126, no. 9, pp. 973–992, 2018.

[9] C. Sakaridis, D. Dai, and L. V . Gool, “Guided curriculum model adaptation and uncertainty-aware evaluation for semantic nighttime image segmentation,” in IEEE International Conference on Computer Vision, 2019, pp. 7374–7383.

[10] S. Di, Q. Feng, C.-G. Li, M. Zhang, H. Zhang, S. Elezovikj, C. C. Tan, and H. Ling, “Rainy night scene understanding with near scene semantic adaptation,” IEEE T ransactions on Intelligent T ransportation Systems, vol. 22, no. 3, pp. 1594–1602, 2021.

[11] Z. Zheng, Y . Wu, X. Han, and J. Shi, “Forkgan: Seeing into the rainy night,” in European Conference on Computer Vision. Springer, 2020, pp. 155–170.

[12] O. Zendel, M. Murschitz, M. Humenberger, and W. Herzner, “How good is my test data? introducing safety analysis for computer vision,” International Journal of Computer Vision, vol. 125, no. 1-3, pp. 95–109, 2017.

[13] Y .-H. Tsai, W.-C. Hung, S. Schulter, K. Sohn, M.-H. Yang, and M. Chandraker, “Learning to adapt structured output space for semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 7472–7481.

[14] Y . Li, L. Yuan, and N. Vasconcelos, “Bidirectional learning for domain adaptation of semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 6936–6945.

[15] Q. Lian, F. Lv , L. Duan, and B. Gong, “Constructing self-motivated pyramid curriculums for cross-domain semantic segmentation: A non-adversarial approach,” in IEEE International Conference on Computer Vision, 2019, pp. 6758–6767.

[16] S. R. Richter, V . Vineet, S. Roth, and V . Koltun, “Playing for data: Ground truth from computer games,” in European Conference on Computer Vision. Springer, 2016, pp. 102–118.

[17] G. Ros, L. Sellart, J. Materzynska, D. Vazquez, and A. M. Lopez, “The synthia dataset: A large collection of synthetic images for semantic segmentation of urban scenes,” in IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 3234–3243.

[18] D. Dai and L. Van Gool, “Dark model adaptation: Semantic image segmentation from daytime to nighttime,” in 2018 21st International Conference on Intelligent T ransportation Systems (ITSC). IEEE, 2018, pp. 3819–3824.

[19] C. Sakaridis, D. Dai, and L. Van Gool, “Map-guided curriculum domain adaptation and uncertainty-aware evaluation for semantic nighttime image segmentation,” IEEE T ransactions on Pattern Analysis and Machine Intelligence, pp. 1–1, 2020.

[20] E. Romera, L. M. Bergasa, K. Yang, J. M. Alvarez, and R. Barea, “Bridging the day and night domain gap for semantic segmentation,” in 2019 IEEE Intelligent Vehicles Symposium (IV). IEEE, 2019, pp. 1312–1318.

[21] L. Sun, K. Wang, K. Yang, and K. Xiang, “See clearer at night: towards robust nighttime semantic segmentation through day-night image conversion,” in Artificial Intelligence and Machine Learning in Defense Applications, vol. 11169. International Society for Optics and Photonics, 2019, p. 111690A.

[22] S. Nag, S. Adak, and S. Das, “Whats there in the dark,” in IEEE International Conference on Image Processing. IEEE, 2019, pp. 2996– 3000.

[23] G. Kang, Y . Wei, Y . Yang, Y . Zhuang, and A. G. Hauptmann, “Pixellevel cycle association: A new perspective for domain adaptive semantic segmentation,” in Advances in Neural Information Processing Systems, 2020.

[24] X. Wu, Z. Wu, H. Guo, L. Ju, and S. Wang, “Dannet: A one-stage domain adaptation network for unsupervised nighttime semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, June 2021, pp. 15 769–15 778.

[25] J. Hoffman, D. Wang, F. Yu, and T. Darrell, “Fcns in the wild: Pixellevel adversarial and constraint-based adaptation,” arXiv preprint arXiv:1612.02649, 2016.

[26] D. Pathak, P . Krahenbuhl, and T. Darrell, “Constrained convolutional neural networks for weakly supervised segmentation,” in IEEE International Conference on Computer Vision, 2015, pp. 1796– 1804.

[27] Y . Luo, L. Zheng, T. Guan, J. Yu, and Y . Yang, “Taking a closer look at domain shift: Category-level adversaries for semantics consistent domain adaptation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 2507–2516.

[28] J.-Y . Zhu, T. Park, P . Isola, and A. A. Efros, “Unpaired image-toimage translation using cycle-consistent adversarial networks,” in IEEE International Conference on Computer Vision, 2017, pp. 2223– 2232.

[29] J. Hoffman, E. Tzeng, T. Park, J.-Y . Zhu, P . Isola, K. Saenko, A. Efros, and T. Darrell, “Cycada: -consistent adversarial domain adaptation,” in International Conference on Machine Learning, 2018, pp. 1989–1998.

[30] Z. Wu, X. Han, Y .-L. Lin, M. Gokhan Uzunbas, T. Goldstein, S. Nam Lim, and L. S. Davis, “Dcan: Dual channel-wise alignment networks for unsupervised scene adaptation,” in European Conference on Computer Vision, 2018, pp. 518–534.

[31] S. Sankaranarayanan, Y . Balaji, A. Jain, S. Nam Lim, and R. Chellappa, “Learning from synthetic data: Addressing domain shift for semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 3752–3761.

[32] X. Zhu, H. Zhou, C. Yang, J. Shi, and D. Lin, “Penalizing top performers: Conservative loss for semantic segmentation adaptation,” in European Conference on Computer Vision, 2018, pp. 568–583.

[33] W.-L. Chang, H.-P . Wang, W.-H. Peng, and W.-C. Chiu, “All about structure: Adapting structural information across domains for boosting semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 1900–1909.

[34] Y . Zhang, P . David, and B. Gong, “Curriculum domain adaptation for semantic segmentation of urban scenes,” in IEEE International Conference on Computer Vision, 2017, pp. 2020–2030.

[35] Y . Zou, Z. Yu, B. Vijaya Kumar, and J. Wang, “Unsupervised domain adaptation for semantic segmentation via class-balanced self-training,” in European Conference on Computer Vision, 2018, pp. 289–305.

[36] Z. Wang, M. Yu, Y . Wei, R. Feris, J. Xiong, W.-m. Hwu, T. S. Huang, and H. Shi, “Differential treatment for stuff and things: A simple unsupervised domain adaptation method for semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2020, pp. 12 635–12 644.

[37] M. Kim and H. Byun, “Learning texture invariant representation for domain adaptation of semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2020, pp. 12 975– 12 984.

[38] Y . Yang and S. Soatto, “Fda: Fourier domain adaptation for semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2020, pp. 4085–4095.

[39] Y .-H. Chen, W.-Y . Chen, Y .-T. Chen, B.-C. Tsai, Y .-C. Frank Wang, and M. Sun, “No more discrimination: Cross city adaptation of road scene segmenters,” in IEEE International Conference on Computer Vision, 2017, pp. 1992–2001.

[40] J. V ertens, J. Zrn, and W. Burgard, “Heatnet: Bridging the daynight domain gap in semantic segmentation with thermal images,” in 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2020, pp. 8461–8468.

[41] J. L. Sch?nberger, M. Pollefeys, A. Geiger, and T. Sattler, “Semantic visual localization,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 6896–6906.

[42] T. Sattler, W. Maddern, C. Toft, A. Torii, L. Hammarstrand, E. Stenborg, D. Safari, M. Okutomi, M. Pollefeys, J. Sivic et al., “Benchmarking 6dof outdoor visual localization in changing conditions,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 8601–8610.

[43] C. Toft, E. Stenborg, L. Hammarstrand, L. Brynte, M. Pollefeys, T. Sattler, and F. Kahl, “Semantic match consistency for long-term visual localization,” in European Conference on Computer Vision, 2018, pp. 383–399.

[44] J. Zhang, D. Sun, Z. Luo, A. Yao, L. Zhou, T. Shen, Y . Chen, L. Quan, and H. Liao, “Learning two-view correspondences and geometry using order-aware network,” in IEEE International Conference on Computer Vision, 2019, pp. 5845–5854.

[45] S. Agarwal, Y . Furukawa, N. Snavely , I. Simon, B. Curless, S. M. Seitz, and R. Szeliski, “Building rome in a day ,” Communications of the ACM, vol. 54, no. 10, pp. 105–112, 2011.

[46] X. Shen, F. Darmon, A. A. Efros, and M. Aubry , “Ransac-flow: generic two-stage image alignment,” in European Conference on Computer Vision, 2020.

[47] P . Truong, M. Danelljan, and R. Timofte, “GLU-Net: Global-local universal network for dense flow and correspondences,” in IEEE Conference on Computer Vision and Pattern Recognition, 2020.

[48] M. A. Fischler and R. C. Bolles, “Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography,” Communications of the ACM, vol. 24, no. 6, pp. 381–395, 1981.

[49] D. G. Lowe, “Distinctive image features from scale-invariant keypoints,” International Journal of Computer Vision, vol. 60, no. 2, pp. 91–110, 2004.

[50] K. M. Yi, E. Trulls, V . Lepetit, and P . Fua, “Lift: Learned invariant feature transform,” in European Conference on Computer Vision. Springer, 2016, pp. 467–483.

[51] T. Zhou, P . Krahenbuhl, M. Aubry , Q. Huang, and A. A. Efros, “Learning dense correspondence via 3d-guided cycle consistency ,” in IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 117–126.

[52] Y . Wang, Y . Yang, Z. Yang, L. Zhao, P . Wang, and W. Xu, “Occlusion aware unsupervised learning of optical flow,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 4884–4893.

[53] R. Kumar, P . Anandan, and K. Hanna, “Direct recovery of shape from multiple views: A parallax based approach,” in IEEE International Conference on Computer Vision, vol. 1. IEEE, 1994, pp. 685–688.

[54] H. S. Sawhney , “3d geometry from planar parallax,” in IEEE Conference on Computer Vision and Pattern Recognition, vol. 94, 1994, pp. 929–934.

[55] M. Irani, P . Anandan, and M. Cohen, “Direct recovery of planarparallax from multiple frames,” IEEE T ransactions on Pattern Analysis and Machine Intelligence, vol. 24, no. 11, pp. 1528–1534, 2002.

[56] J. Wulff, L. Sevilla-Lara, and M. J. Black, “Optical flow in mostly rigid scenes,” in IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 4671–4680.

[57] T. Jenicek and O. Chum, “No fear of the dark: Image retrieval under varying illumination conditions,” in IEEE International Conference on Computer Vision, 2019, pp. 9696–9704.

[58] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy , and A. L. Yuille, “Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs,” IEEE T ransactions on Pattern Analysis and Machine Intelligence, vol. 40, no. 4, pp. 834–848, 2017.

[59] G. Lin, A. Milan, C. Shen, and I. Reid, “Refinenet: Multi-path refinement networks for high-resolution semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 1925–1934.

[60] H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia, “Pyramid scene parsing network,” in IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 2881–2890.

[61] K. He, X. Zhang, S. Ren, and J. Sun, “Deep residual learning for image recognition,” in IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 770–778.

[62] A. Radford, L. Metz, and S. Chintala, “Unsupervised representation learning with deep convolutional generative adversarial networks,” International Conference on Learning Representations, 2015.

[63] Z. Li and N. Snavely , “Megadepth: Learning single-view depth prediction from internet photos,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 2041–2050.

[64] L. I. Rudin, S. Osher, and E. Fatemi, “Nonlinear total variation based noise removal algorithms,” Physica D: nonlinear phenomena, vol. 60, no. 1-4, pp. 259–268, 1992.

[65] K. Zhang, W. Zuo, Y . Chen, D. Meng, and L. Zhang, “Beyond a gaussian denoiser: Residual learning of deep cnn for image denoising,” IEEE T ransactions on Image Processing, vol. 26, no. 7, pp. 3142–3155, 2017.

[66] T.-C. Wang, M.-Y . Liu, J.-Y . Zhu, A. Tao, J. Kautz, and B. Catanzaro, “High-resolution image synthesis and semantic manipulation with conditional gans,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 8798–8807.

[67] C. G. Guo, C. Li, J. Guo, C. C. Loy , J. Hou, S. Kwong, and R. Cong, “Zero-reference deep curve estimation for low-light image enhancement,” in IEEE Conference on Computer Vision and Pattern Recognition, June 2020, pp. 1780–1789.

[68] L. A. Gatys, A. S. Ecker, and M. Bethge, “Texture synthesis using convolutional neural networks,” in Advances in Neural Information Processing Systems, 2015, pp. 262–270.

[69] Y . Li, C. Fang, J. Yang, Z. Wang, X. Lu, and M. H. Yang, “Universal style transfer via feature transforms,” in Advances in Neural Information Processing Systems, vol. 2017, 2017, pp. 386–396.

[70] Z. Wang, A. C. Bovik, H. R. Sheikh, and E. P . Simoncelli, “Image quality assessment: from error visibility to structural similarity ,” IEEE T ransactions on Image Processing, vol. 13, no. 4, pp. 600–612, 2004.

[71] C. Godard, O. Mac Aodha, and G. J. Brostow, “Unsupervised monocular depth estimation with left-right consistency ,” in IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 270–279.

[72] C. Chen, Q. Chen, J. Xu, and V . Koltun, “Learning to see in the dark,” in IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 3291–3300.

[73] T.-Y . Lin, P . Goyal, R. Girshick, K. He, and P . Dollár, “Focal loss for dense object detection,” in IEEE International Conference on Computer Vision, 2017, pp. 2980–2988.

[74] X. Mao, Q. Li, H. Xie, R. Y . Lau, Z. Wang, and S. Paul Smolley , “Least squares generative adversarial networks,” in IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 2794– 2802.

[75] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele, “The cityscapes dataset for semantic urban scene understanding,” in IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 3213–3223.

[76] C. Sakaridis, D. Dai, and L. Van Gool, “Acdc: The adverse conditions dataset with correspondences for semantic driving scene understanding,” arXiv preprint arXiv:2104.13395, 2021.

[77] D. P . Kingma and J. Ba, “Adam: A method for stochastic optimization,” International Conference on Learning Representations, 2014.

[78] T.-H. Vu, H. Jain, M. Bucher, M. Cord, and P . Pérez, “Advent: Adversarial entropy minimization for domain adaptation in semantic segmentation,” in IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 2517–2526.

[79] F. Pan, I. Shin, F. Rameau, S. Lee, and I. S. Kweon, “Unsupervised intra-domain adaptation for semantic segmentation through selfsupervision,” in IEEE Conference on Computer Vision and Pattern Recognition, 2020, pp. 3764–3773.

[80] O. Kupyn, T. Martyniuk, J. Wu, and Z. Wang, “Deblurgan-v2: Deblurring (orders-of-magnitude) faster and better,” in IEEE International Conference on Computer Vision, 2019, pp. 8878–8887.