一、GBDT梯度提升决策树的概念

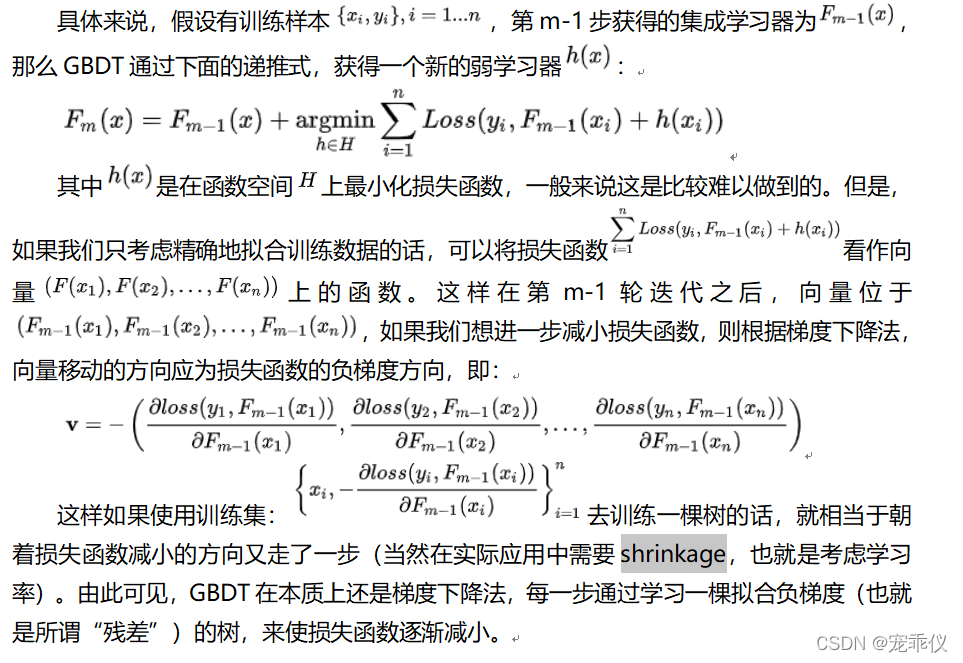

GBDT算法是是有boosting思想和决策树组成的,是一个由多个弱学习器组成的集成学习。GBDT算法的每一个弱学习器模型的建立是为了消除上一次的残差(使用函数空间梯度下降的方法)

注意:残差是通过损失的出来的,学习率shrinkage 得用

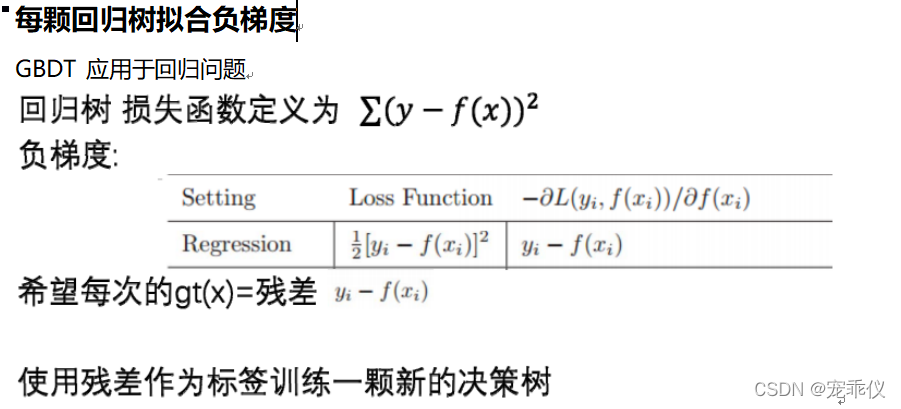

二、GBDT应用于回归(残差、负梯度、回归树)

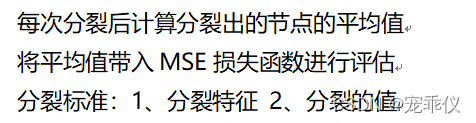

1、回归树

2、每棵树训练的真实值是负梯度(残差)

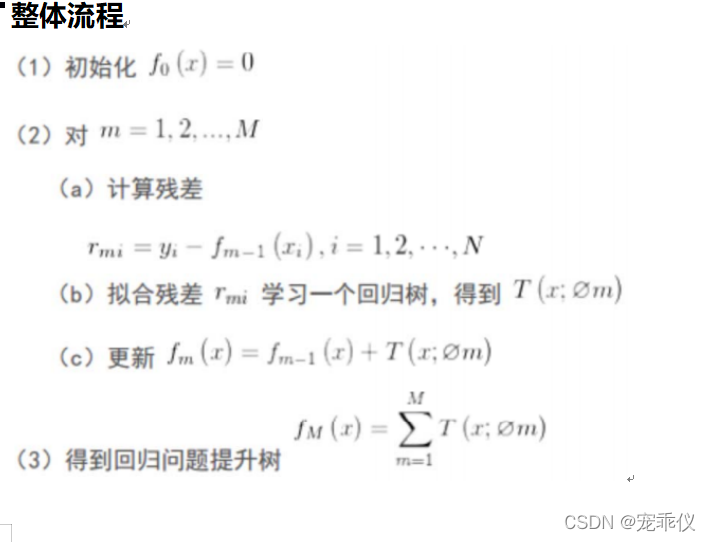

3、GBDT应用于回归问题的总体流程

4、GBDT应用于回归问题总结

? ?

?

?三、应用GBDT做二分类任务

1、原理

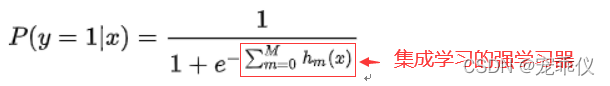

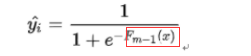

分类模型的预测y_hat??

其中![]() 就是学习到的决策树 (弱学习器)

就是学习到的决策树 (弱学习器)

使用逻辑回归作为二分类任务的base model

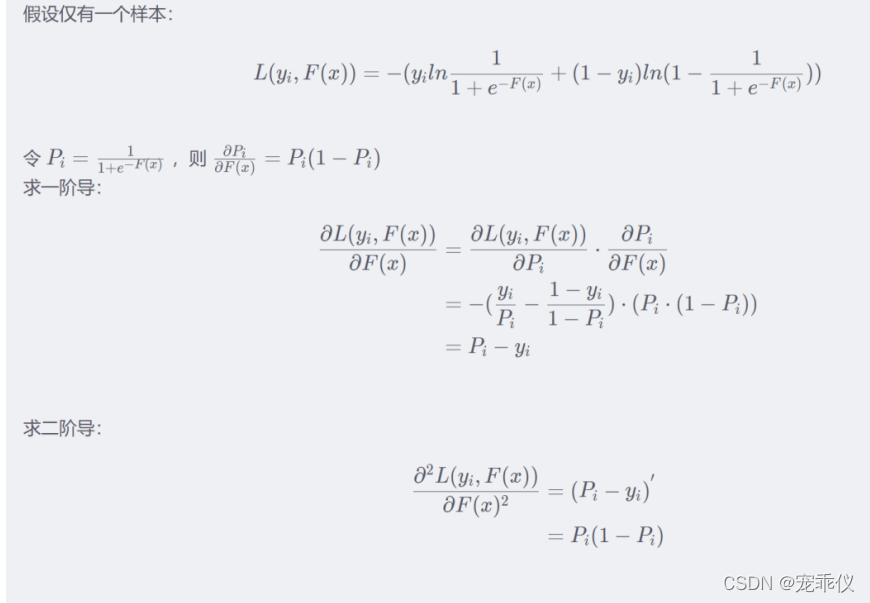

则单个样本的损失函数为

![]()

?

?

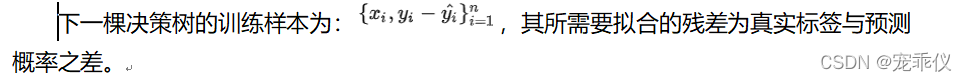

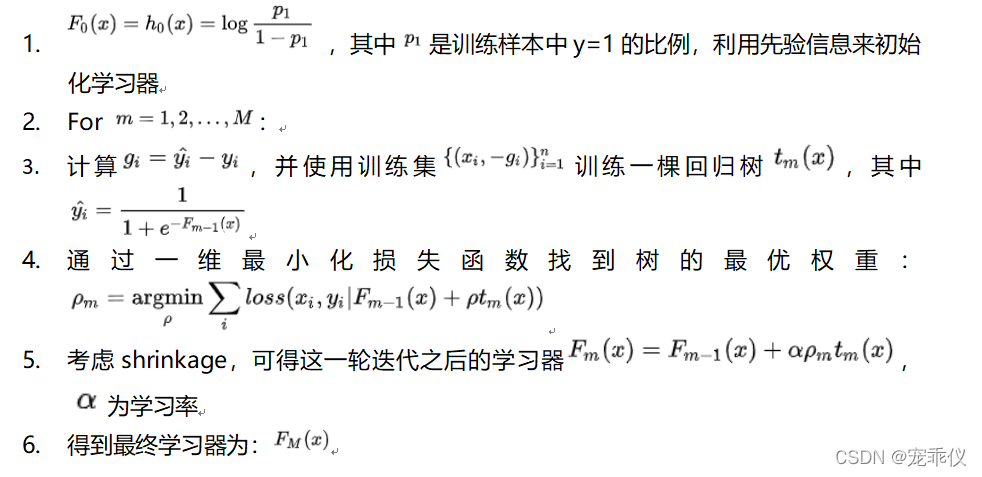

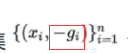

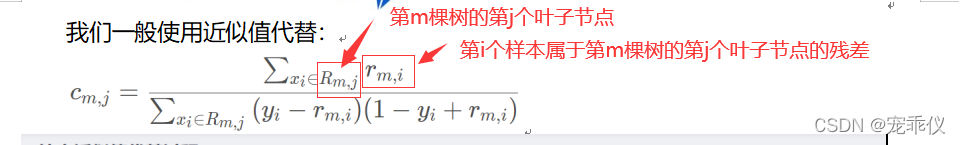

?2、GBDT应用于二分类算法流程总结

注意:? 这个负梯度的是传给下一时刻的预期值的

这个负梯度的是传给下一时刻的预期值的

?

?

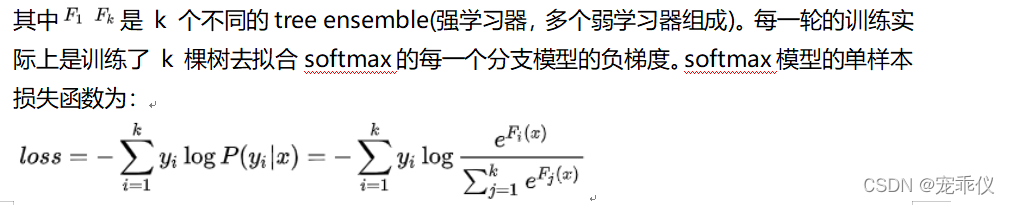

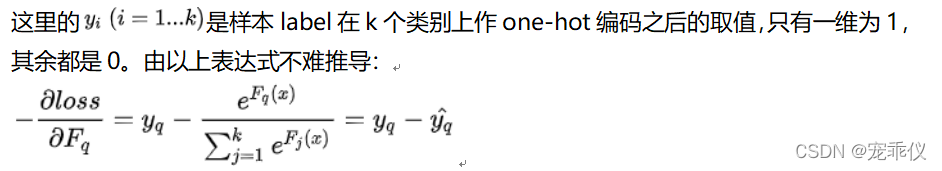

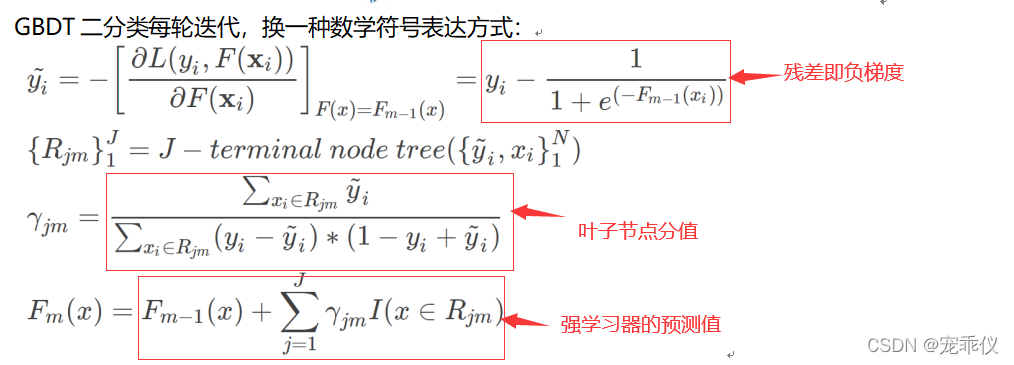

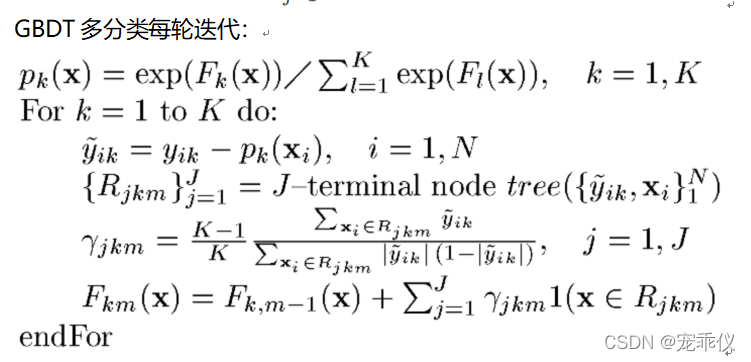

?四、GBDT做多分类任务

1、原理

使用softmax作为base model

每个样本属于每个类别的概率

?

五、GBDT用于回归、二分类、多分类任务的相同点和不同点:

1、相同点:

? ? ? ? ? ? ?都是使用残差拟合下一棵树,使用了回归树

? ? ? ? ? ? ?分裂指标都是mse

2、不同点:

-

?使用损失函数的不同

-

叶子节点分值计算不同

-

初始值的方式不同

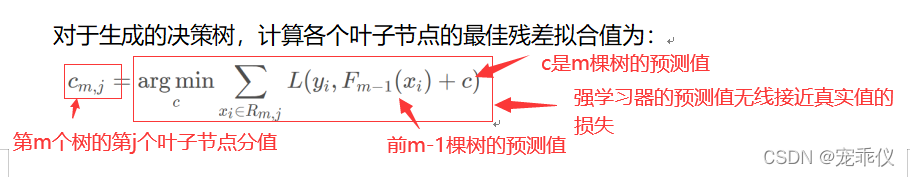

六、叶子节点分值计算

?

1、回归的叶子节点分值是求平均

2、二分类的叶子节点分支

?于是我们所得到叶子分值的近似值?

?于是我们所得到叶子分值的近似值?

?

?

3、多分类的叶子节点分支

七、特征选择

?

?

?

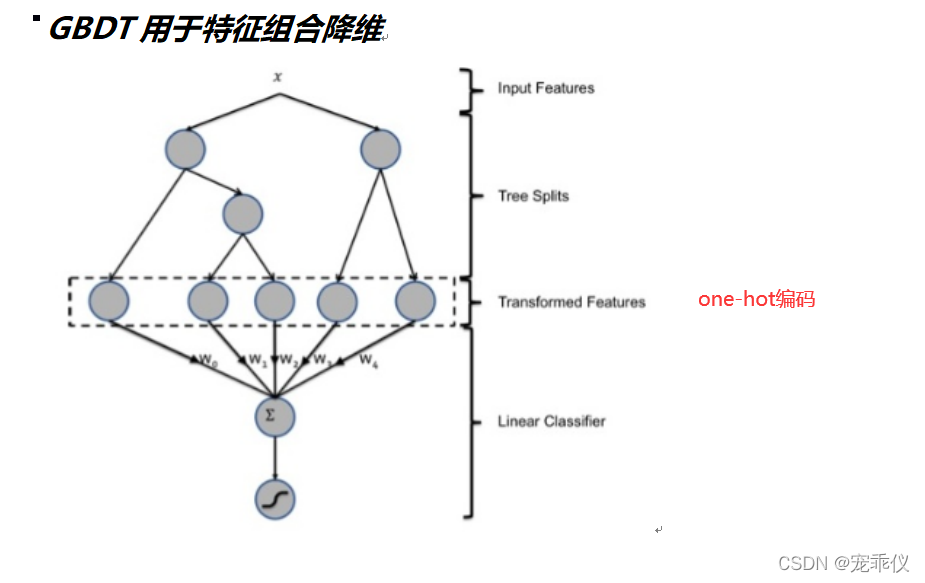

八、特征组合降维在GBDT+LR架构上的应用

1、架构图

?

2、流程

2.1 训练

- 训练好GBDT用作二分类的强学习器

- 把GBDT训练好的模型的特征进行编码

- 训练lr模型

2.2 预测

- 新的数据进入gbdt获取到特征编码(one-hot)

- 把特征编码后的进行逻辑回归预测

?