DuReaderretrieval: A Large-scale Chinese Benchmark for Passage Retrieval fromWeb Search Engine

作者:Yifu Qiu

机构:百度

简介

当前现存段落检索数据集存在以下两个问题:

- False Negative,错误标注

- semantically similar questions, 训练集、验证集中存在相似问题,导致数据泄露问题

基于此,提出了DuReader Retrieval 数据集,弥补以上两个问题,并且在baselines模型上验证效果,发现本书数据集仍然具有较大进步空间。

数据集介绍

DuReader Retrieval 数据集,数据来自百度搜索,标注方式采用远程标注,

- 基于DuReader数据集,手写答案

- 答案与段落进行匹配,使用span-level F1做为评价指标

- 当F1的分数大于阈值0.5,标注为positive,反则标注negative

- 篇章长度控制,1)如果一个篇章长度小于256,则认为这个篇章为段落,2)对于篇章中的每个段落,如果长度小于256,则进行拼接后面的段落直到长度超过256。被拼接中有一个段落的标签为positive,则认为拼接后的段落为positive。

- 删除篇章的title,提升检索难度

Reducing False Negatives

为了减少标注错误的语料,

- 使用BM25以及四个神经网络检索模型,召回top-50段落,并使用ensemble 重排模型选择 top-5做为最终结果。

- 标注人员进行标签,是否前top-5的问题段落有关联关系。

- 至少两名检查员进行检查,如果准确率低于阈值(如:97%),则让标注人员继续标注,直到准确率打标。

- 最后,the average positive paragraph per query is increased from 2.43 to 4.91.

Removing Similar Questions

减少数据泄露问题,

- 使用问题匹配模型,输出问题对的相似度,范围(0, 1)。如果问题相似度阈值超过0.5。认为这两个问题是相似的

- 最终,选择出566问题在dev和test数据集中与train数据集中的问题相似。并删除566个问题

实验

baseline:

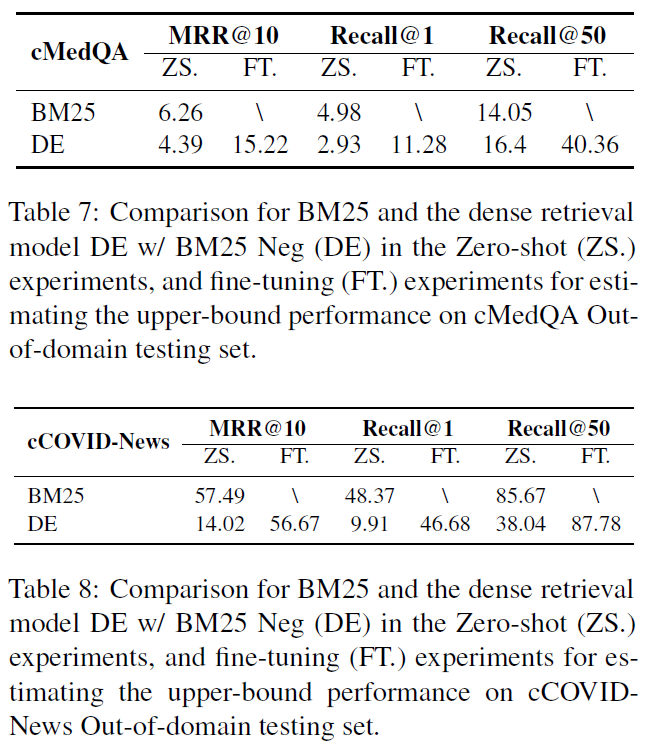

- BM25

- DE w/ BM25 Neg

- CE w/ BM25 Neg

- CE w/ DE Neg

baseline之间的关系, 2是检索是神经网络 3 重排是神经网络 4 检索和重排都是神经网络 使用BM25抽取负样本,对2和3进行初始化,然后2 检索负样本做为4的训练集

评价指标:

MRR

recall@1

recall@50

结果

基于神经网络的模型效果明显好于BM25.

同时,还对相似问题去除做了对比,发现CE w/o Sim Q 不带相似问题,在others问题上表现更好

在zero-shot上表现明显弱于传统方法,经过fine-tuning后,效果有所提升,所以领域适用性并不好

总结

模型在数据集中存在的问题:

- 实体匹配错误 (taobao -> alipay)39%

- 数字匹配错误 (2016->2017)5%

- 修饰词匹配错误 (吃完海鲜->早晨)9.4%

- 语义理解错误 (从台北怎么去瑞芳-> 从瑞芳怎么去台北)1%

- 鲁棒性(拼写错误和关键词敏感) 22.6%

因此,模型在DuReader Retrieval数据集中仍存在较大的进步空间。