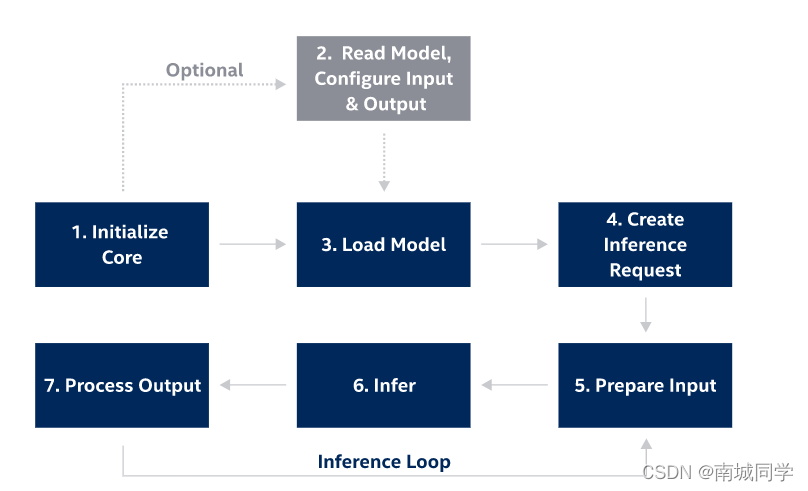

使用C++ API实现推理步骤:

- 创建Core对象,加载推理引擎Core,该引擎需要从当前路径加载plugins.xml文件;

Core ie;

- 读取IR文件 (.xml and .bin files),也可直接加载.onnx文件;

.xml和.bin文件放在同一目录下,但是代码中只加载.xml即可;

CNNNetwork network = ie.ReadNetwork(input_model);

- 配置 input & output;

输入格式设置:

InputInfo::Ptr input_info = network.getInputsInfo().begin()->second;

std::string input_name = network.getInputsInfo().begin()->first;

//通过设置调整大小算法,将输入标记为可调整大小。

//在这种情况下,能够将任何形状的输入blob设置为一个推断请求。 在推断期间自动执行调整大小和布局转换 。

input_info->getPreProcess().setResizeAlgorithm(RESIZE_BILINEAR);

input_info->setLayout(Layout::NHWC);

input_info->setPrecision(Precision::U8);

输出格式设置:

DataPtr output_info = network.getOutputsInfo().begin()->second;

std::string output_name = network.getOutputsInfo().begin()->first;

output_info->setPrecision(Precision::FP32);

- 载入模型到AI推理计算设备;

- 计算棒

"MYRIAD";

ExecutableNetwork executable_network = ie.LoadNetwork(network, "CPU");

- 创建Infer Request;

InferRequest infer_request = executable_network.CreateInferRequest();

- 准备输入数据;

//读取输入图像到一个blob,并将其设置为一个不需要调整大小和布局转换的推断请求。

cv::Mat image = imread_t(input_image_path);

Blob::Ptr imgBlob = wrapMat2Blob(image); // just wrap Mat data by Blob::Ptr

// 不分配新内存

infer_request.SetBlob(input_name, imgBlob); // infer_request 接受任意大小的输入blob

- 推理;

infer_request.Infer();

- 输出处理;

Blob::Ptr output = infer_request.GetBlob(output_name);

ClassificationResult_t classificationResult(output, { input_image_path });

classificationResult.print();

官方文档参考:Integrate Inference Engine with Your C++ Application

完整Demo下载:hello_openvino_2021.7z

Demo运行说明:

- 根据本机OpenVINO资源安装路径修改CMake文件;

- Visual Studio 调为“Release x64”环境 ;

- 修改模型和图片资源的绝对路径;

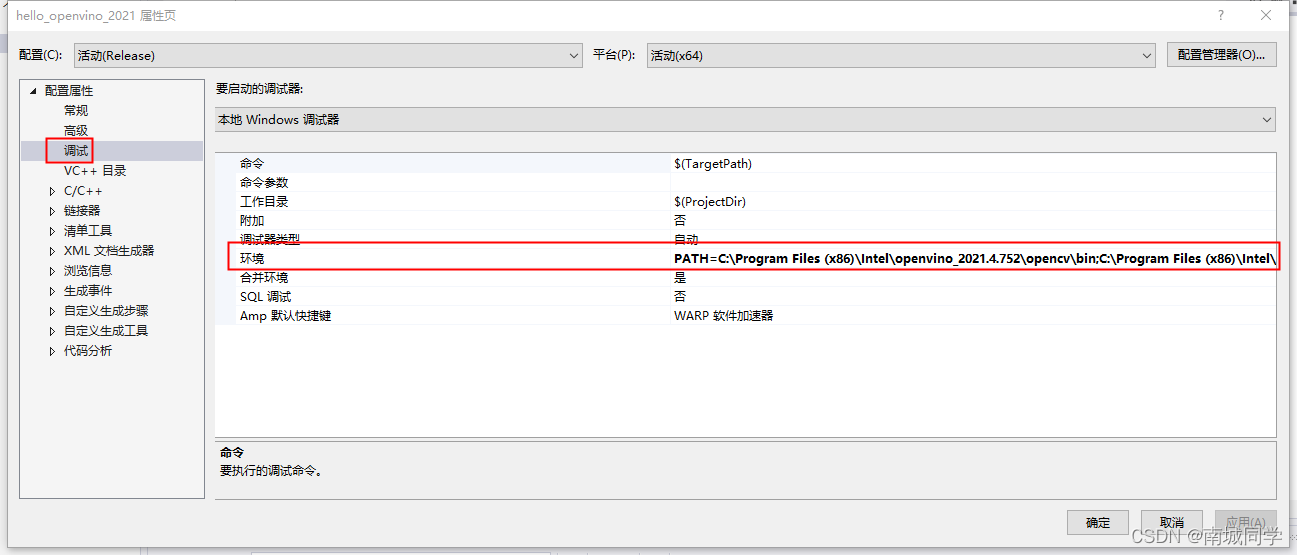

- 运行时提示缺少“xxx.dll”,在“属性–>调试 – >环境”中,添加“PATH=xxx”。

PATH=C:\Program Files (x86)\Intel\openvino_2021.4.752\opencv\bin;C:\Program Files (x86)\Intel\openvino_2021.4.752\deployment_tools\inference_engine\bin\intel64\Release;C:\Program Files (x86)\Intel\openvino_2021.4.752\deployment_tools\inference_engine\external\tbb\bin;C:\Program Files (x86)\Intel\openvino_2021.4.752\deployment_tools\ngraph\lib;