题外话——词云

咳咳,beautiful soup先撂一撂,今天给大家整点题外话:之前研究了一下词云,和大家分享一下:

安装相关的库

# 总之哪个库没有下那个

pip3 install jieba

pip3 install PIL

pip3 install Wordcloud

实操

1. 总得有个数据源吧?

从文豪舍友那里拿来一篇他写的课程论文,今天我们就一起来看看他写了点啥:

2.使用 jieba(结巴?)库对文豪舍友的论文进行分词

import jieba

from wordcloud import WordCloud

from PIL import Image

import numpy

# 读取文件

with open('./月光下的钢琴诗人.txt', 'r', encoding='utf-8') as f:

text = f.read()

# 使用jieba库进行分词

text_cut = jieba.lcut(text)

print(text_cut)

运行结果:

最后返回了一个列表给我们,为了更准确的了解到文豪舍友到底写了些什么,为什么他能够拿到90多分而我就不行呢,我们继续把列表里面的单个字的词汇和标点符号去掉:

import jieba

from wordcloud import WordCloud

from PIL import Image

import numpy

# 读取文件

with open('./月光下的钢琴诗人.txt', 'r', encoding='utf-8') as f:

text = f.read()

# 使用jieba库进行分词

text_cut = jieba.lcut(text)

list0 = []

for item in text_cut:

if len(item) != 1:

list0.append(item)

print(list0)

运行结果:去除了大量没有什么意义的诸如的、是、他等单个词汇现在我们留下的都是一些词组

3. 使用 wordcloud库 创建词云

首先为了结果的美观,我们可以先准备一张图片,在下面的步骤中可以以准备的图片中的形状为底板创建词云:

import jieba

from wordcloud import WordCloud

from PIL import Image

import numpy

# 读取文件

with open('./月光下的钢琴诗人.txt', 'r', encoding='utf-8') as f:

text = f.read()

# 使用jieba库进行分词

text_cut = jieba.lcut(text)

list0 = []

for item in text_cut:

if len(item) != 1:

list0.append(item)

# 创建词云对象并生成词云图

# 把处理过的存放词汇的列表转换成字符串,用符号隔开

text_fin = ' '.join(list0)

# 将图片转换为数组类型

alice_image = numpy.array(Image.open('China.png'))

# 创建 Wordcloud 对象

# front_path 字段可以设置字体这里设置为黑体

# backgroud_colour 字段可以设置背景颜色

# mask 字段设置图片样式,如果为空默认为一个预定义好的矩形

word_cloud = WordCloud(font_path='simhei.ttf', background_color='black', mask=alice_image)

# 准备工作已经完成,开始生成吧!

wc = word_cloud.generate(text_fin)

# 转成图片

image = wc.to_image()

# 显示

image.show()

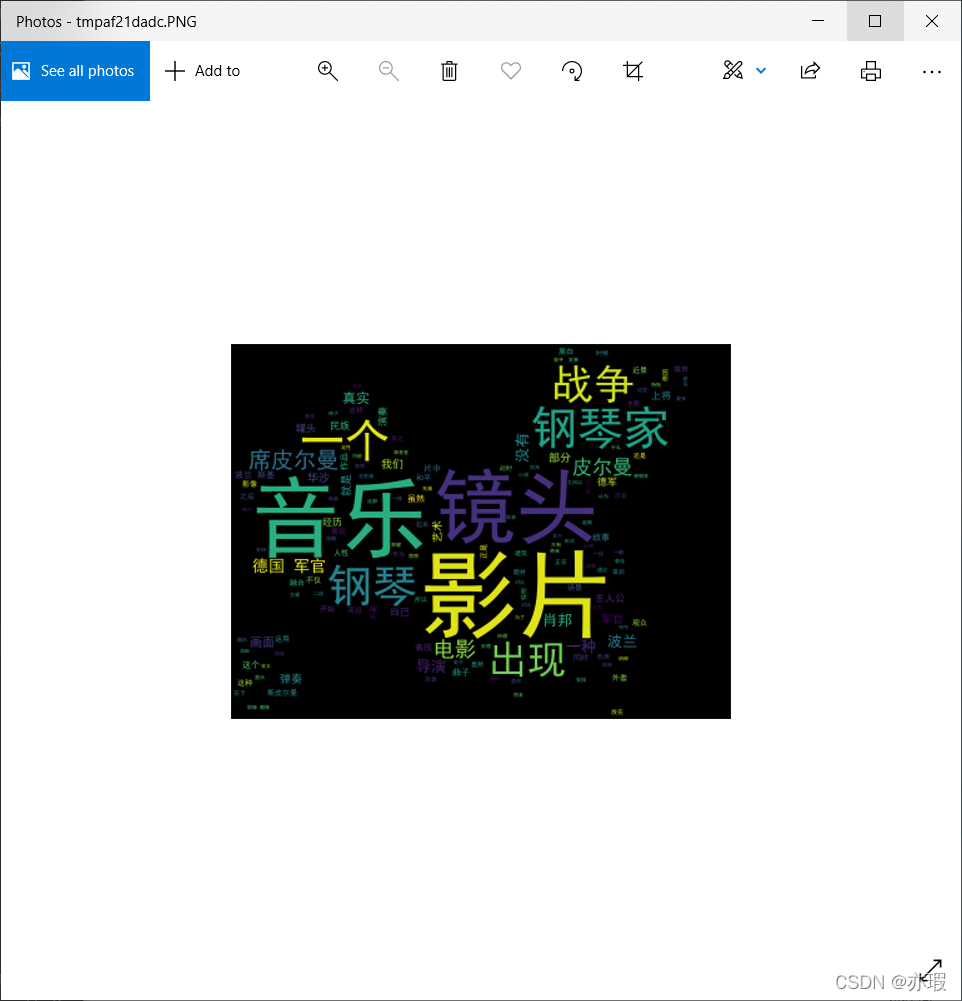

运行结果:

大文豪的论文的词云图就被我做出来了,我得去好好研究研究了,他究竟写了啥了

今日结束,明日继续!