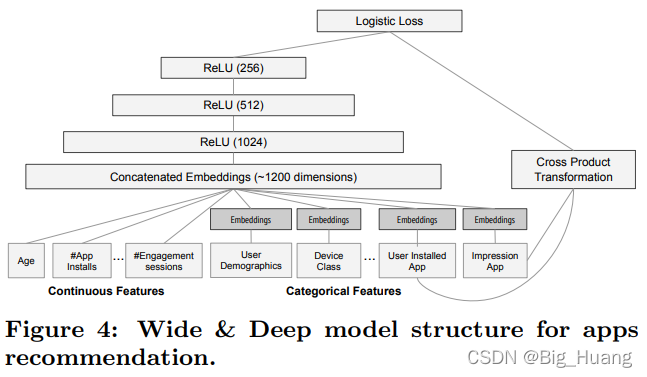

????????WideDeep 模型是Google在2016年提出的,在业界具有非常大的影响力,模型由单层Wide部分和多层的Deep部分组成的混合模型。Wide 体现 “记忆能力” 主要是模型直接学习并利用历史数据中物品或者特征的“共现频率”能力。而Deep部分体现 “ 泛化能力 ” 主要是根据特征发掘甚至从未出现过的稀有特征与最终标签相关性的能力。? 再简单理解就是Wide部分采用简单的线性回归模型,直接发掘了历史数据的分布规则,例如针对成对出现的特征; 而Deep部分则是通过深层的神经网络发掘数据中潜在的关系。

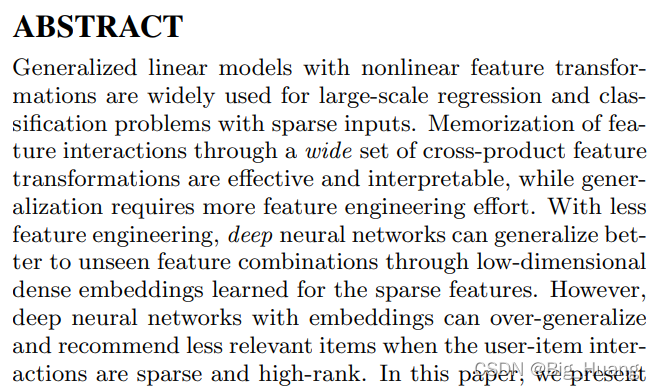

具体可以参考下原文的摘要部分,虽然有点晦涩,但是仔细品还是能有很好的体会

????????《深度学习推荐系统》作者王喆在多个地方都描述过推荐算法要与实际业务相关联,WideDeep模型就是深刻抓住业务本质特点,在采用深层网络提升泛化能力的同时,使用传统模型,直接获取相关联的特征直接的浅层关系。

? ? ? ? 只考虑模型本身其实不是特别难,但是论文是实际应用的推荐系统,原作中还对推荐系统的一些内容进行阐述,尤其是训练方式采用在线优化算法FTRL,关于这块内容找到一个很好很好的学习帖子:

在线优化算法 FTRL 的原理与实现 - massquantity - 博客园 (cnblogs.com)![]() https://www.cnblogs.com/massquantity/p/12693314.html????????以及?Cross Product Transformation (这块内容我不是特别理解,因为找到很多复现的版本都没有用这部分内容,大多使用线性回归,不过本身来说这块内容就是和业务直接相关的,设计之初的目的性就是在的嘛,这块先给自己挖个坑吧)

https://www.cnblogs.com/massquantity/p/12693314.html????????以及?Cross Product Transformation (这块内容我不是特别理解,因为找到很多复现的版本都没有用这部分内容,大多使用线性回归,不过本身来说这块内容就是和业务直接相关的,设计之初的目的性就是在的嘛,这块先给自己挖个坑吧)

代码复现:

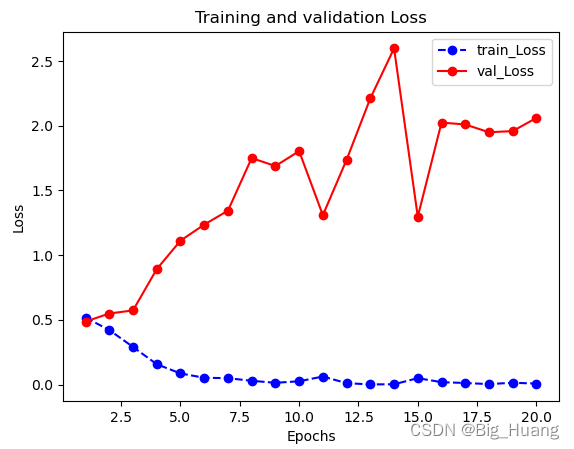

? ? ? ? 写的很直白,完全按照图示来编写的,同样也在circto数据上简单训练了下,但是很快过拟合了,数据量太小了。。。

? ? ? ? 数据和训练部分代码因为和之前都一样,可以参考DeepCrossing:

class Wide(nn.Module):

def __init__(self, dense_feas_num):

super().__init__()

self.layer = nn.Linear(dense_feas_num, 1)

def forward(self, x):

return self.layer(x)

class Deep(nn.Module):

def __init__(self, feature_info, embeding_dim):

super().__init__()

self.dense_features, self.sparse_features, self.sparse_features_nunique = feature_info

self.__dense_features_nums = len(self.dense_features)

self.__sparse_features_nums = len(self.sparse_features)

self.embeding_layers = nn.ModuleDict({

"embed_" + str(key) : nn.Embedding(embed_num, embeding_dim)

for key, embed_num in self.sparse_features_nunique.items()

})

self.layer1 = nn.Linear(embeding_dim * self.__sparse_features_nums + self.__dense_features_nums, 1024)

self.relu1 = nn.ReLU()

self.layer2 = nn.Linear(1024, 512)

self.relu2 = nn.ReLU()

self.layer3 = nn.Linear(512, 256)

self.relu3 = nn.ReLU()

self.lastLayer = nn.Linear(256, 1)

def forward(self, x):

dense_inputs, sparse_inputs = x[:, :self.__dense_features_nums], x[:, self.__dense_features_nums:]

sparse_inputs = sparse_inputs.long()

sparse_embeds = [self.embeding_layers["embed_" + key](sparse_inputs[:, idx]) for idx, key in enumerate(self.sparse_features)]

sparse_embeds = torch.cat(sparse_embeds, axis=-1)

deep_input = torch.cat([sparse_embeds, dense_inputs], axis=-1)

out = self.relu1(self.layer1(deep_input))

out = self.relu2(self.layer2(out))

out = self.relu3(self.layer3(out))

return self.lastLayer(out)

class WideDeep(nn.Module):

def __init__(self, feature_info, embeding_dim=10):

super().__init__()

dense_features, _, _ = feature_info

self.__dense_features_nums = len(dense_features)

self.deep = Deep(feature_info, embeding_dim=embeding_dim)

self.wide = Wide(self.__dense_features_nums)

def forward(self, x):

dense_inputs, sparse_inputs = x[:, :self.__dense_features_nums], x[:, self.__dense_features_nums:]

sparse_inputs = sparse_inputs.long()

wide_out = self.wide(dense_inputs)

deep_out = self.deep(x)

assert (wide_out.shape == deep_out.shape)

return F.sigmoid(0.5 * (wide_out + deep_out))

?

参考:

1. 《深度学习推荐系统》