注:可直接跳至后面查看代码和解释

起因:

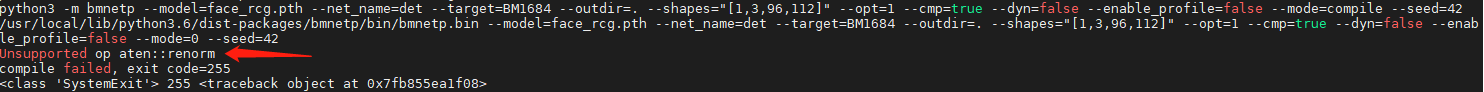

今天把一个训练好的人脸识别模型 放到 比特大陆的盒子上进行部署,因为比特大陆盒子上使用的npu,在模型转换的时候报错不支持的op renorm

(转换模型的方法在前面的文章有,摘同事的代码,好像需要配置环境,回头让他帮忙写下)

renorm

然后就搜了下renorm的意思

官网的解释如上。

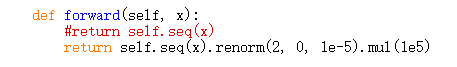

我的代码长这样:

既然转换时不支持此op,所以就把最后的renorm代码去掉了,直接返回 self.seq(x)

然后把renorm当作结果的后处理进行处理。

renorm 解释

import torch

feat = torch.Tensor([[1,2,3],[4,5,6],[7,8,9]])

feat = feat.renorm(2, 0, 1e-5).mul(1e5)

print(feat)

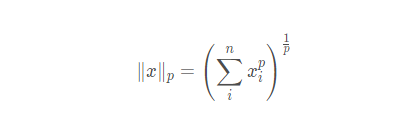

这里renorm(2,0,1e-5)中参数解释如下

2: L2 范式

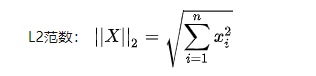

可能有的朋友不知道L2范数是什么,这里贴个Lp范数的公式

则L2 范数可以写成

0:官方解释是需要切片得到子张量的维数。根据我的测试,在这里表示按行计算L2范数

1e-5 :表示maxnorm的值,表示高于此值的需要除以刚刚算出来的L2范数,再乘以该值

举个例子:

import torch

a = torch.Tensor([[1,2,3],[4,5,6],[7,8,9]])

# 官方公式计算结果

print(a.renorm(2,0,1e-5).mul(1e5),'\n')

# 按行求L2范数

a_l2 = torch.sum(a*a,dim=1)**0.5

print(a_l2,'\n')

# 把范数大于 1e-5 的

for i in range(len(a_l2)):

if a_l2[i]>1e-5:

a[i] = a[i]/a_l2[i]/1e-5*1e5

# 这里是按照公式自己计算的结果

print(a)

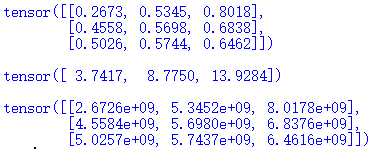

结果如下:

可以看出除了保留位数有区别,基本是一致的。

最后我这里不用torch就是想绕过torch,这里给一个numpy重写的代码

numpy 实现

import numpy as np

max_num_val = 1e-5

b = np.array([[1,2,3],[4,5,6],[7,8,9]])

b_l2 = np.linalg.norm(b,axis=1)

#b_l2 = b_l2.reshape(3,1)

# 这里调整 numpy 对应除法,需要给l2范数增加一个维度,或者使用转置矩阵(注释掉的代码)

b_l2 = np.expand_dims(b_l2, 1)

print(b_l2,'\n')

b_l2[b_l2<=max_num_val] = 1

#res = (b.T/b_l2).T

res = b/b_l2

print(res)