学习tf是因为莫烦在用;昨天差不多看完了,想看李宏毅老师的课,结果发现他用的是pytorch,所以还需要再学下pytorch,找了教程。那就多线程工作叭!

--------------TIMELINE OF TODDAY--------

-------------今天又起的很早,5点半就起床,现在写完todo才6点。先去大致看下李老师的课,pythorch课程。

才6点已经有12个人在看视频了!!!加油哦!!

----6:07-------大概看了一下,pytorch的课还是选择刘二大人的,比较轻松口语化,然后能再复习一遍,基础知识;现在开始听李老师的课了!!!

------------0718,2/32,希望能找到ppt来辅助复习!

-----------0748收拾宿舍,接点水,现在回来继续看,做笔记的方式也需要改进。

先去找找有没有课件,不仅找到了课件,还看到了更新一版本的课程!!!

—0757还找到了作业!!!太开心了!!J继续看

---------鹅鹅鹅突然发现我想看的其实是他机器学习的课程额鹅鹅鹅,啊先去听这个深度学习叭!!!!

-------0953看了INTRODUCTION的两个视频!!!讲的也太好了!!!

1、第一次真正了解机器学习的作用——拟合函数;而深度学习可以很好地对函数进行拟合

2、激活函数的作用——将线性的函数变为非线性函数,这样可以拟合曲线。不然,线性永远是线性函数。课件中一维的时候有图像,更加立体。

------去打杯水,回来继续看!!!!0958回来了,然后看到了有作业。我在想要不要先总结,做完作业再继续看呢?阿我去,又发现了2022的课。还没有更新完,并且侧重不同。那先听2021的叭,不过2022的里有pytorch,感觉可以听听!!!

噢噢噢2021的里面也有pytorch~

找到了homework解析的位置!!!

发现2022的网课也是2021的哈哈哈

内容差不多,感觉2022更清晰一点,在表格里,先看2022的叭!!!课程都是精进的嘛

这么说,我现在决定看李宏毅2022的机器学习,然后目前已经看过Lecture1

ooo ,他还有课程的pre,就是去年的课程,真不错,资料详尽!!!了解了怎么看的,我目前是完成了L1课前看的资料。

预习了一下L1正课的pdf

12:40刚刚去吃完饭,然后顺便看完了pytorch1的课,大体掌握的差不多,很tf思路差不多,但比tf更底层一点,比如需要自己去更新gradient之类的。然后在桌子上趴了一会,脑子里不知道过了啥,但是也是睡着了,很舒服。

现在洗把脸,继续听课了,迫不及待。

–1243开始预习,学习!!!

----1306听完了2,是一个讲example,如何看pytorch文档,以及常见torch错误的tutorial,很贴心了!!!

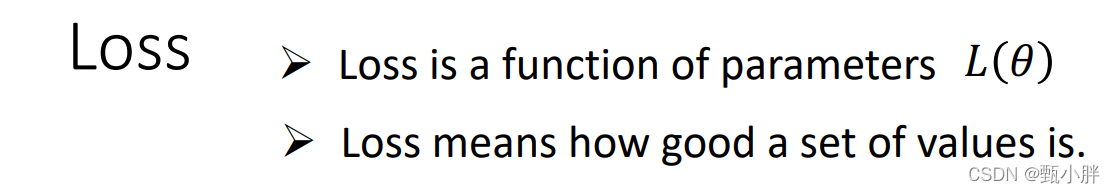

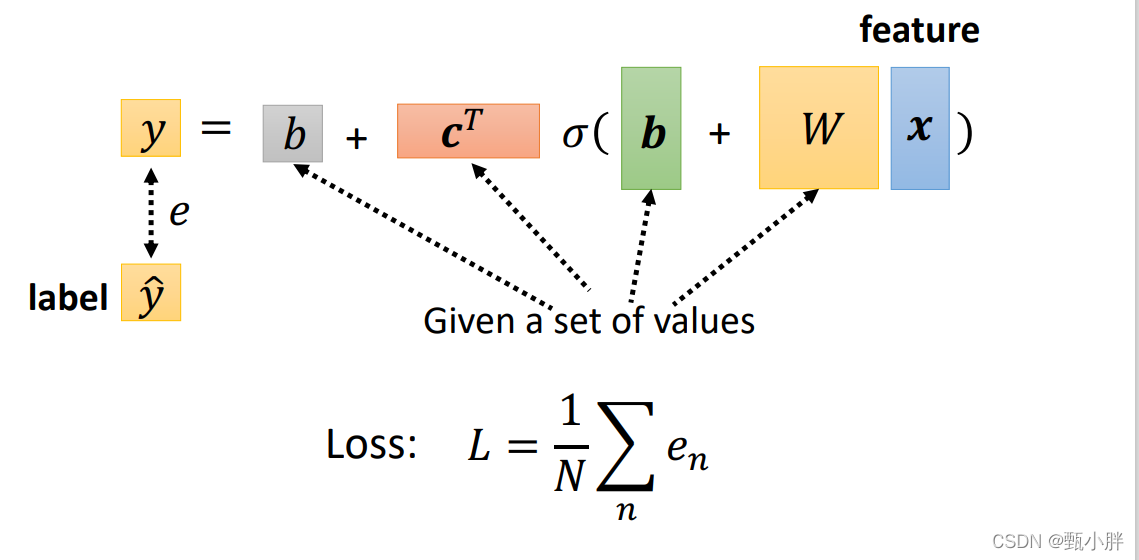

顺便想了一下batch的作用。首先看下loss的定义,是对一组值的好坏的估计,所以这个一组,就是batch。也就是说,我们进行优化的时候,不一定是看一个数据的值进行优化(batch!=1),也可以看一组数据的值。

具体地的,其实我们在进行参数优化,对参数求偏导时,由于函数固定,所以求偏导的公式是固定的,但是得出来的具体的gradient的不一样的,主要因为最后forward的一组y不同,导致最后的Loss不同,所以代入求导公示后gradient就不同。

----13:13现在预习一下Colab怎么用,看下视频

----1331看完colab的视频了,打算去试一下。顺便把hw1做了!

—1405弄了好久colab,接了个水,看下作业视频叭

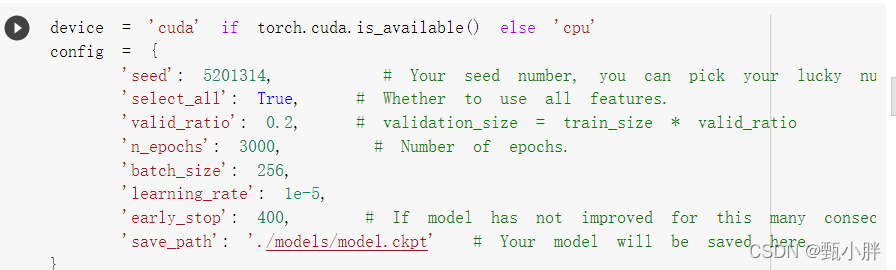

—1428看完了hw1的讲解,真的好贴心心啊!!!而且居然还有不同的baseline。

我要开始看代码了!

----1451大致理解了下代码,跑了一下;先在kaggle上submmit一下

居然已经submit不了了

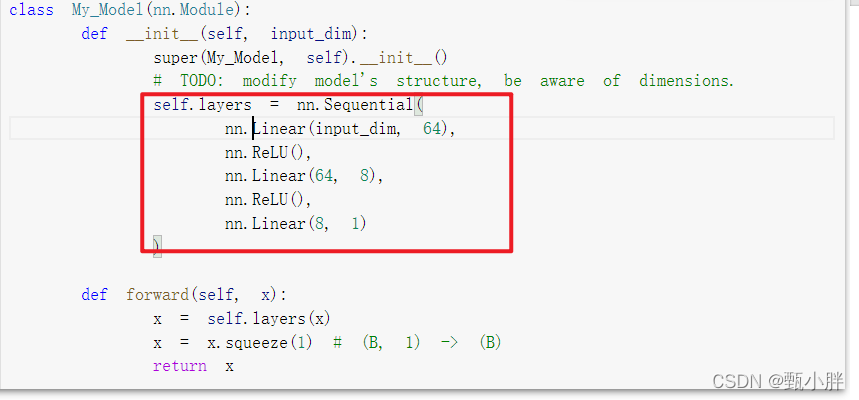

我把网络结构中的nerual改了一下,看看会不会好一些,改之前的我没有记录

跑的时候顺便看下特征

数了半天,终于把数据数明白了,网络有点大了,训了15分钟。

这个数据特征我感觉前几次测的和后面高度相关,会不会产生问题啊!!!

先看下结果。

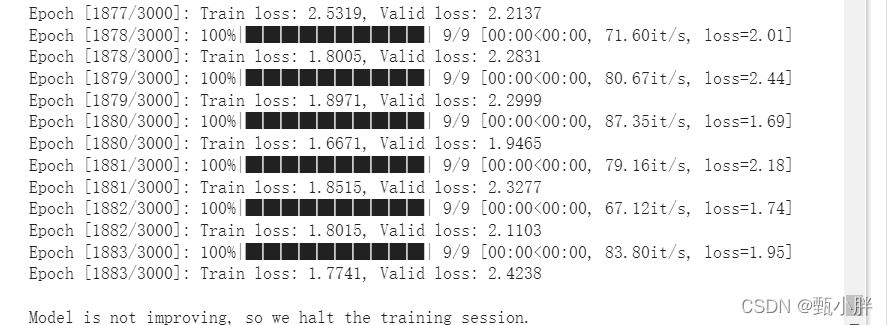

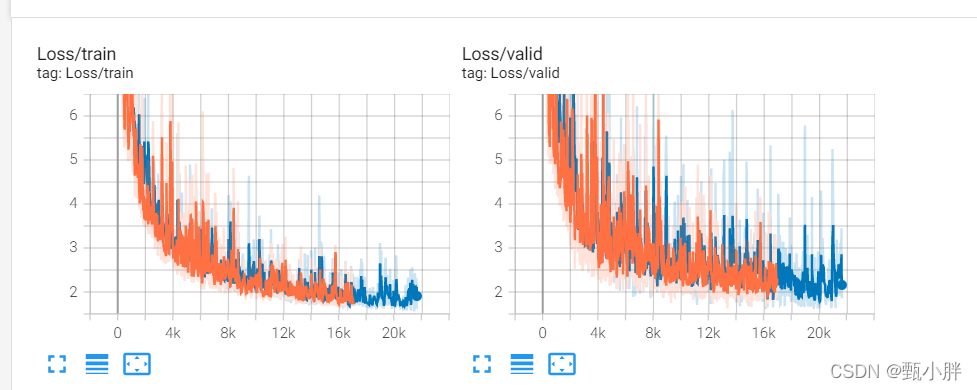

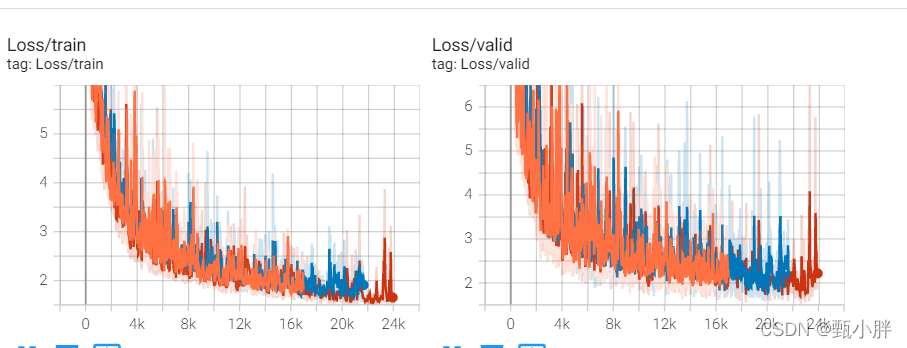

这个tensorbord好厉害啊,可以直接比较两次训练情况,可以看到两次都提前终止了,后面这个跑的更久一点,但并没什么改善,升值感觉不太好。

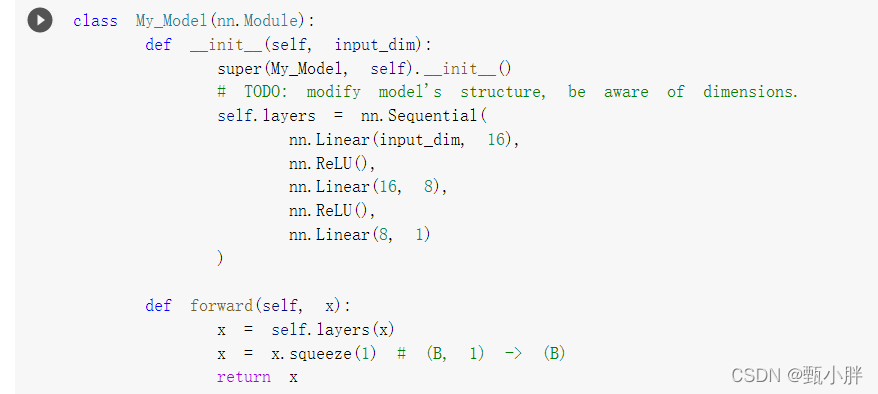

把结构再改回来,试着改下特征把。

改完结构先run一下。

我怀疑是因为我没有直接run整个的,所以之前的class定义用的都是之前的,我把前几天测的covid情况更改了,鹅鹅鹅改的很蹩脚,现在用脑子想想,觉得改的也不对,这个应该是有很大贡献值的特征啊。我去看看别人有没有好的方法。

kaggle上的讨论很少, 官方课程网站需要发邮件申请,先看下面的叭。

----1548看看新的课啦~~

LECTURE 2

1、看了一些,发现刚才可能是opmization没做好

----1630看完了第一小part–讲的是调模型攻略!!!感觉对于调模型很有帮助!再一次接触到了bias和overfitting的概念,清晰了不少!!!自己也能理解了一些为什么多feature也可以更好地拟合,自己举了例子,画了图。

----1637接完水,预习一下下一讲,继续听!!!

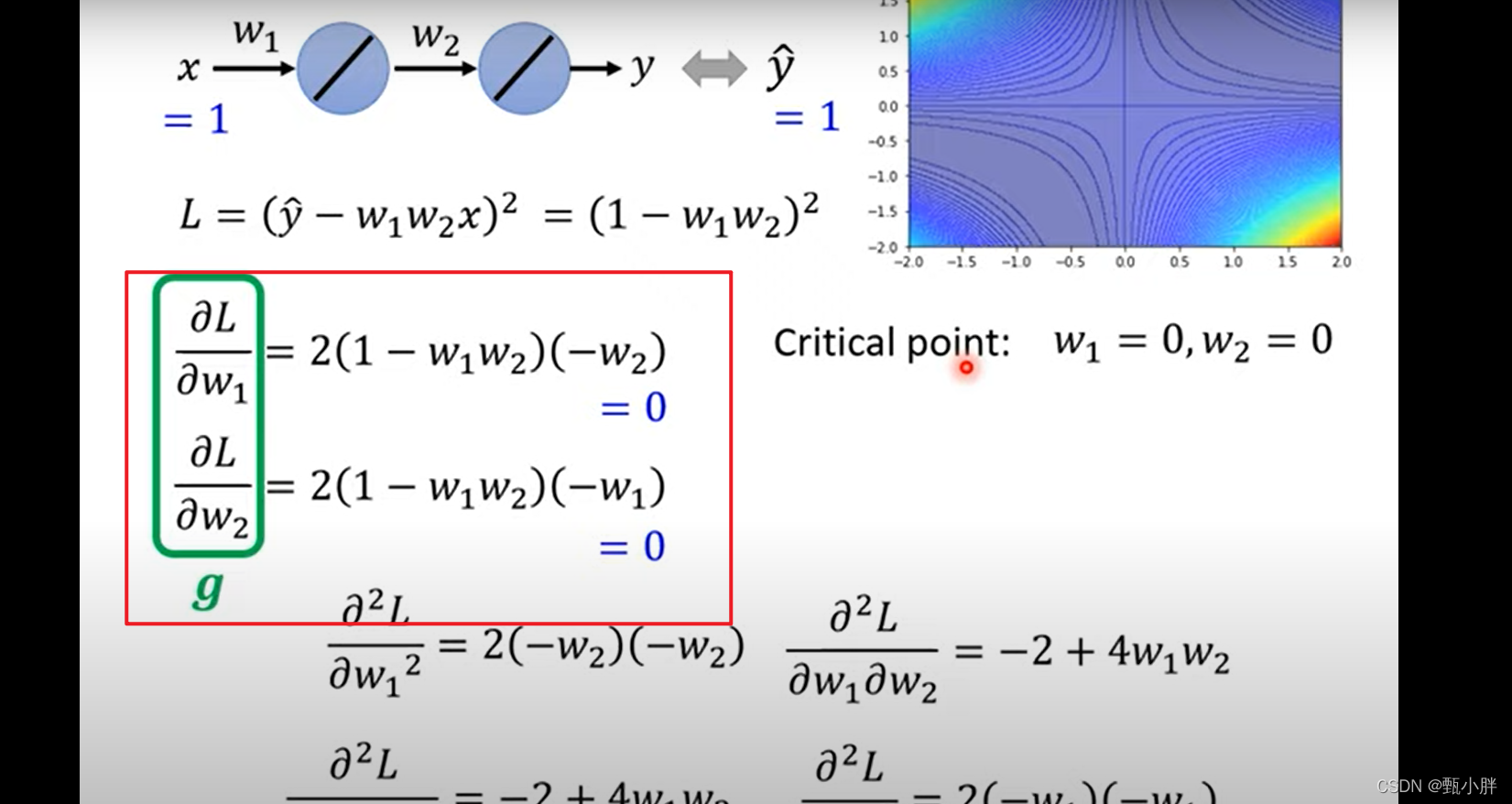

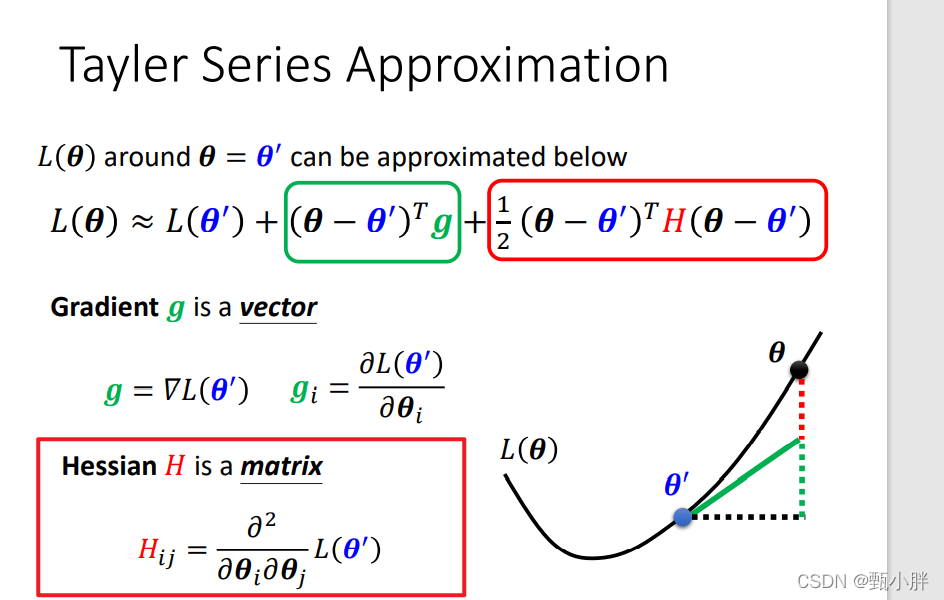

这幅图很好,因为把g算出来了,g其实也是关于w的函数,最后具体得多少得看你的w。

判断鞍点:VHV是否>0->H是否为正定->H的特征值是否为正->H为L二次导矩阵,代入theta周围值(其实也就是原来的值,还没有被优化的值),有具体值,可以算特征值。

1723.。。。。。。。md真的好有意思啊。。先下一下slides预习一下,一会吃啊饭的时候也可以听听

-------1946处理完了快递事宜,和父母视了频,还又看了一节关于优化的内容,对于优化器有了更深的理解,从Adagrad(解决不同参数情况不一样问题),RMSprop(解决同一参数不同阶段的不同情况问题),到Adam,到learning-rate decay(距离终点越来越近)到warmup。感觉又学到了很多东西!期待“移山”技术

----2009一不小心看完Lecture2的materials了!!!后面这一刻主要讲损失函数的选择也会影响你的优化。比如,对于分类问题,选择CE会比MSE好,因为当loss比较大的时候,MSE会面临g比较小,卡住的问题。

去看下课堂的课件,再听下课,就去复习Catti和做一套catti真题了!!

—2015这个课有一个多小时,是讲宝可梦和数码宝贝分类器的,打算明天看了,今天先复习Catti和消化今天学的叭!