导读

曲线拟合的应用在生活中随处可见,不知道大家是否还记得物理实验中的自由落体运动中下降高度与时间关系之间的探究,在初速度为0的情况下,我们想要探究下降高度与时间的关系。

我们当时采用的方法是通过设置不同的下降时间来记录下降的高度,测量记录多组数据之后,再利用二维坐标系将记录的点绘制到坐标系当中去,然后保证绘制的曲线到这些点的距离之和最小,最终得到的曲线就是h与t的关系。

绘制出h和t的关系之后,我就可以知道任意取值t在初速度为0的情况下,下降高度h对应的值。除此之外,曲线拟合的应用还有很多例如房价预测、经济预测、股价预测等。

不知道,大家有没有思考过,为什么我们可以通过测量值来绘制出t和h的关系曲线呢?这里面用到的逻辑究竟是什么呢?其实关于曲线的拟合通常有两种解决方案:

- 我们已经知道了自变量(x)和因变量(y)的关系,只是不知道参数,通过观察值来计算出参数,就能计算出自变量和因变量之间的关系

- 利用万能函数逼近器神经网络来拟合曲线,通过定义代价函数,利用已有观察值的输入值来计算出预测值,再计算出预测值与观测值的输出值之间的差距,在通过反向传播,来计算出神经网络的参数

下面我们主要探讨如何利用方法1来实现曲线的拟合

曲线拟合

曲线拟合还可以分为两种情况,第一种就是没有约束的曲线拟合,第二种就是带有约束条件的曲线拟合。scipy中提供了curve_fit函数使用非线性的最小二乘法用来拟合没有约束条件的曲线,提供了least_squares函数用来拟合带有约束条件的曲线。

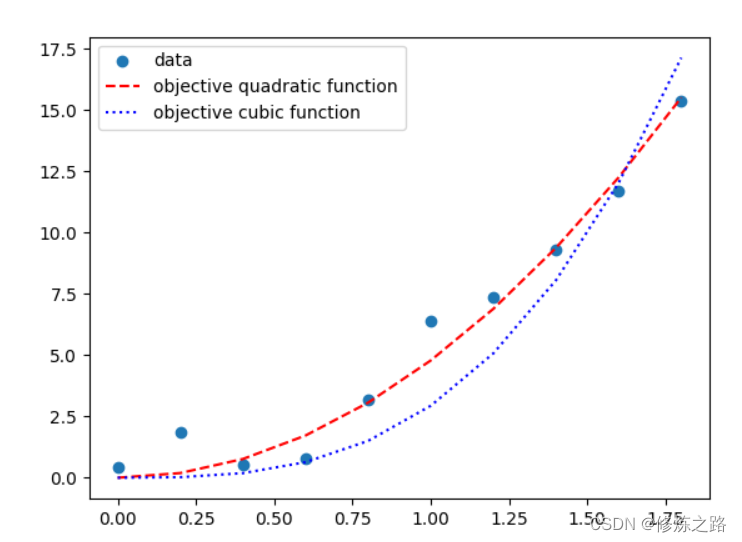

- 没有约束条件的曲线拟合

import numpy as np

from scipy.optimize import curve_fit

import matplotlib.pyplot as plt

#设置随机数的种子

np.random.seed(28)

def simlate_data(time_array):

#用来模拟测量误差

measurement_error = np.random.randn(len(time_array))

g = 9.8

#模拟数据

h_array = 0.5 * g * time_array ** 2 + measurement_error

return h_array

def objective_fun(x,a):

#定义二次函数作为目标函数

return a * x**2

def objective_fun1(x,a):

#定义三次函数作为目标函数

return a * x**3

#定义输入数据(t)和输出数据(h)

time_array = np.arange(0,10,1) * 0.2

h_array = simlate_data(time_array)

#计算定义函数的参数

popt,_ = curve_fit(objective_fun,time_array,h_array)

#获取参数

a = popt

popt1,_ = curve_fit(objective_fun1,time_array,h_array)

a1 = popt1

#绘制数据点和预测的函数

plt.scatter(time_array,h_array)

plt.plot(time_array,objective_fun(time_array,a),"--",color="r")

plt.plot(time_array,objective_fun1(time_array,a1),":",color="b")

plt.legend(["data","objective quadratic function","objective cubic function"])

plt.show()

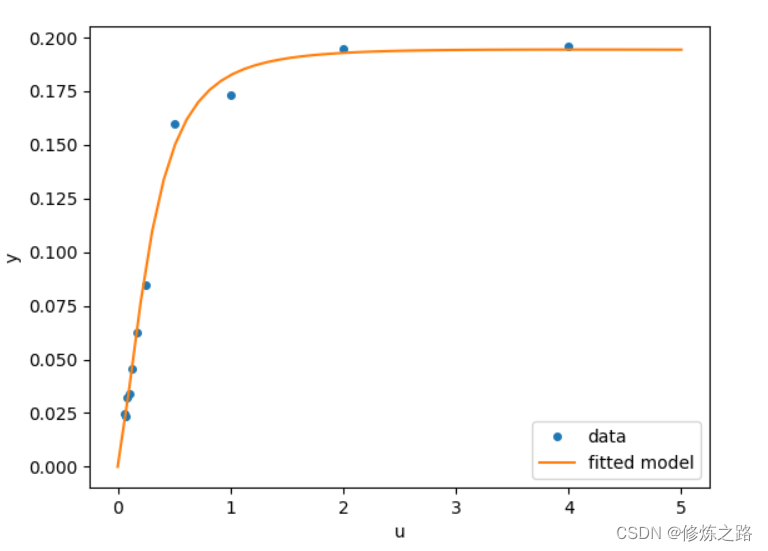

- 带约束条件的曲线拟合

有时候在求解曲线参数的时候,会对参数的边界做出一些限制,下面就展示了在对参数的边界做出限制的情况下如何来求解的问题。我们使用jac矩阵结合最小二乘法来计算曲线的参数

import numpy as np

from scipy.optimize import least_squares

import matplotlib.pyplot as plt

def model(x,u):

"""定义拟合的曲线

:param x:输入值自变量

:param u:输入值函数的参数

:return:返回值因变量

"""

return x[0] * (u ** 2 + x[1] * u) / (u ** 2 + x[2] * u + x[3])

def fun(x,u,y):

return model(x,u) - y

def jac(x,u,y):

J = np.empty((u.size,x.size))

den = u ** 2 + x[2] * u + x[3]

num = u ** 2 + x[1] * u

J[:,0] = num / den

J[:,1] = x[0] * u / den

J[:,2] = -x[0] * num * u / den ** 2

J[:,3] = -x[0] * num / den ** 2

return J

#输入值自变量

u = np.array([4.0, 2.0, 1.0, 5.0e-1, 2.5e-1, 1.67e-1, 1.25e-1, 1.0e-1,

8.33e-2, 7.14e-2, 6.25e-2])

#输入值因变量

y = np.array([1.957e-1, 1.947e-1, 1.735e-1, 1.6e-1, 8.44e-2, 6.27e-2,

4.56e-2, 3.42e-2, 3.23e-2, 2.35e-2, 2.46e-2])

#函数的参数

x0 = np.array([2.5, 3.9, 4.15, 3.9])

#利用jac矩阵结合最小二乘法来计算曲线的参数,设置参数的取值在(0,100)之间

res = least_squares(fun, x0, jac=jac, bounds=(0, 100), args=(u, y), verbose=1)

#需要预测值得输入值

u_test = np.linspace(0, 5)

#利用计算的曲线参数来计算预测值

y_test = model(res.x, u_test)

plt.plot(u, y, 'o', markersize=4, label='data')

plt.plot(u_test, y_test, label='fitted model')

plt.xlabel("u")

plt.ylabel("y")

plt.legend(loc='lower right')

plt.show()