经典论文

Decoupling Representation and Classifier for Long-Tailed Recognition [ICLR2020]

解耦论文GitHub

- two-stage 解耦表征学习+分类

- Classifier Re-training (cRT):re-train the classifier with class-balanced sampling

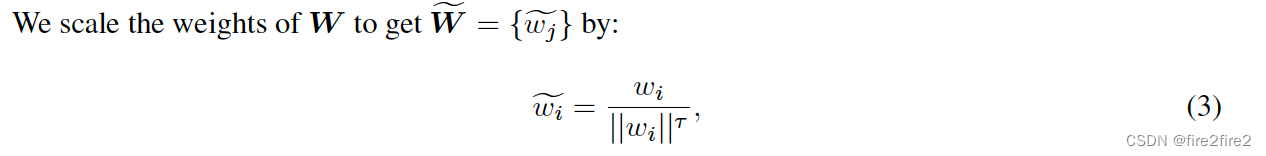

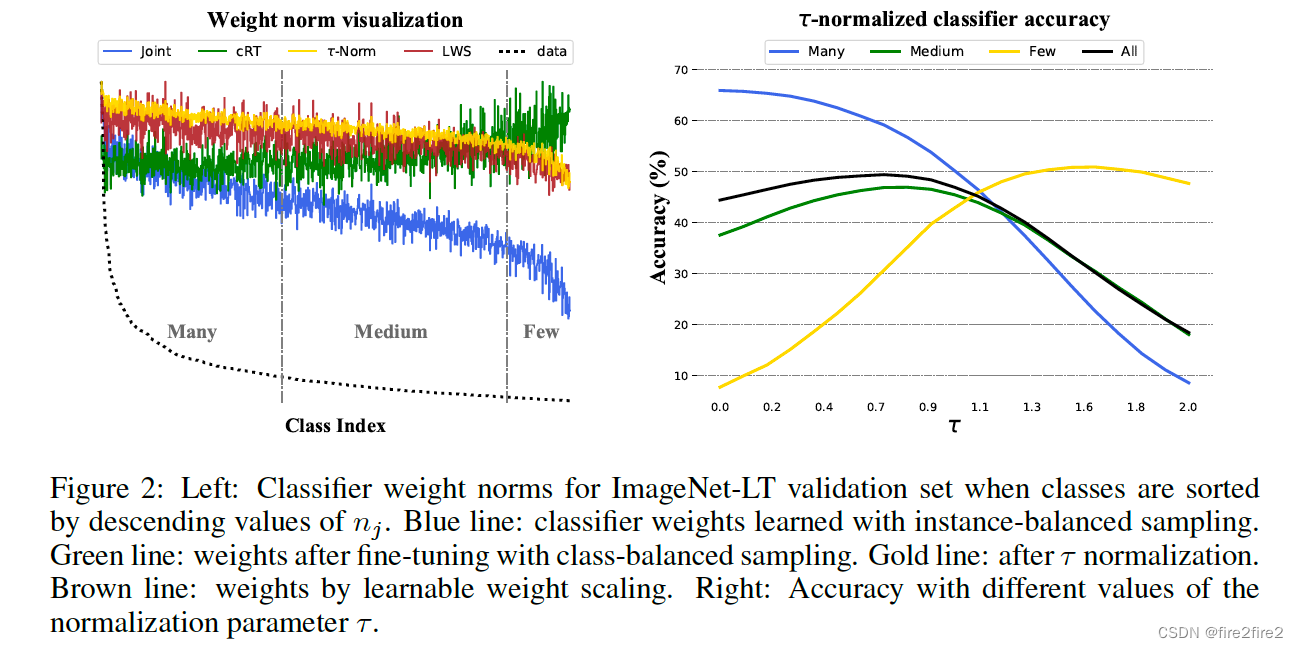

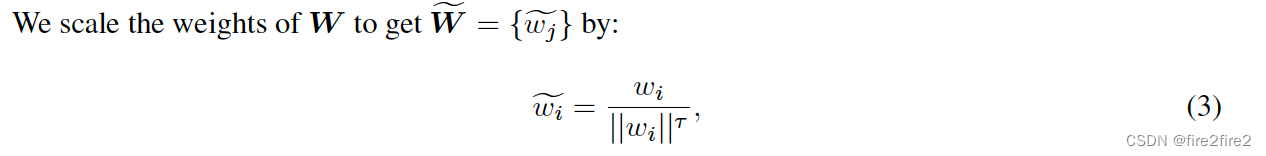

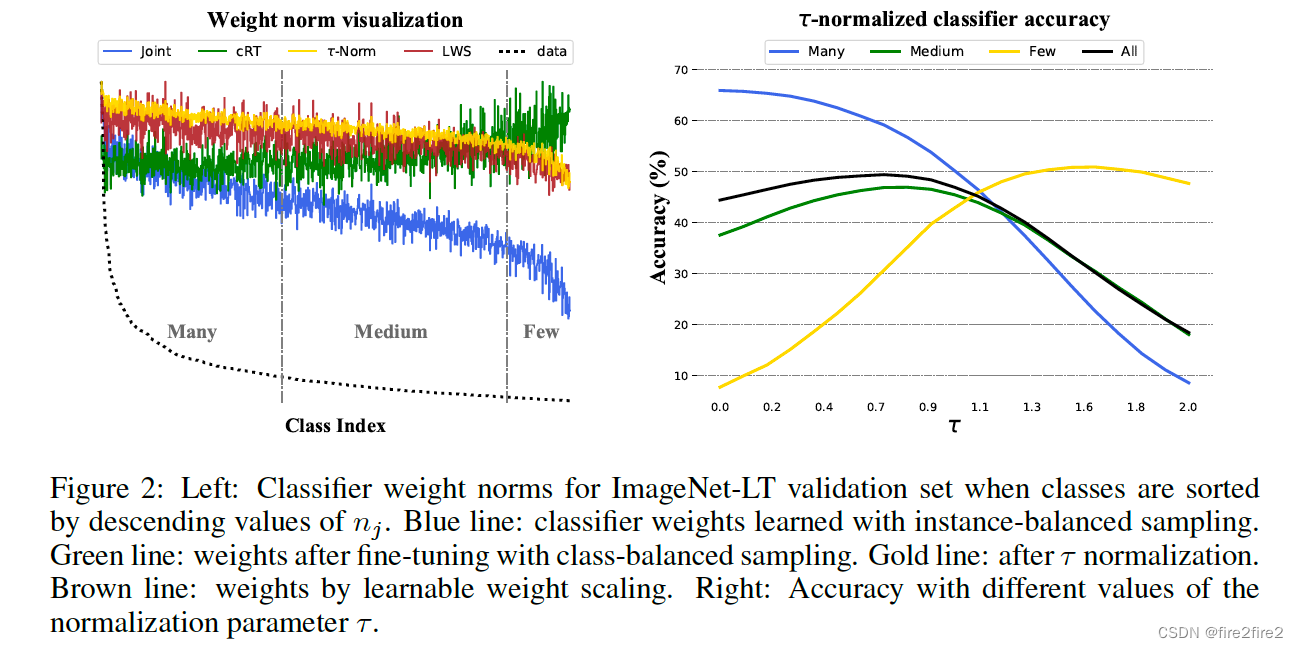

- t-normalized classifier (t -normalized):出发点为分类器对head类的权重值一般较大,降低head类对应的神经元的weight就可以降低对head类预测的偏向。

以下实验也证明了这个想法:

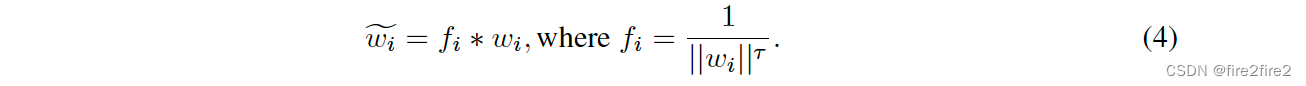

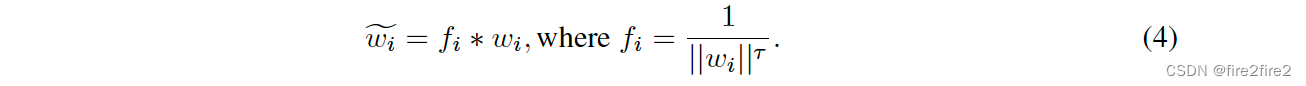

- Learnable weight scaling (LWS):上面的norm方法中的t为超参数,这里LWS中作为可学习的参数。

- Nearest Class Mean classifier (NCM):求出每个类的聚类中心,再与聚类中心算相似度进行分类。

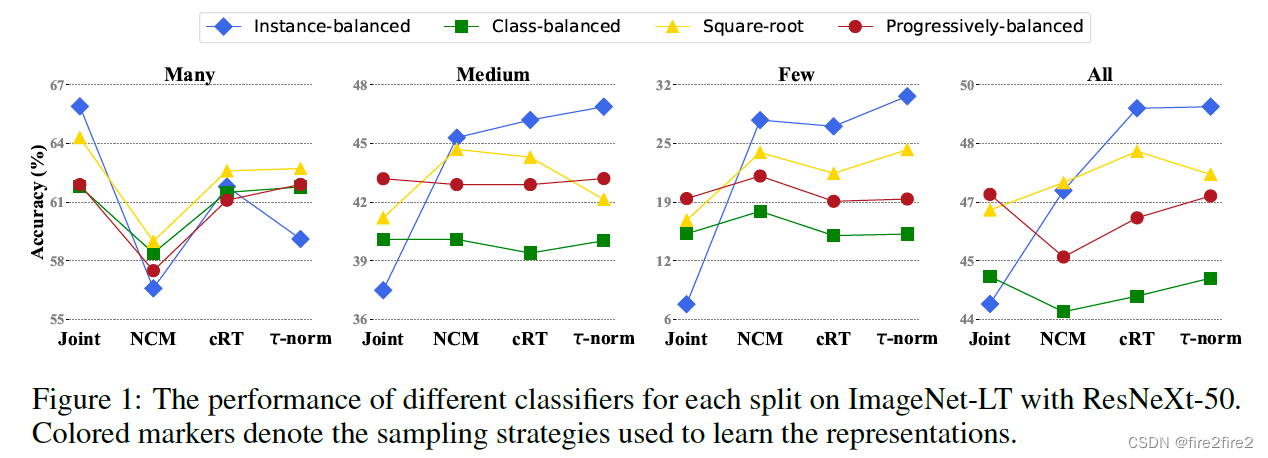

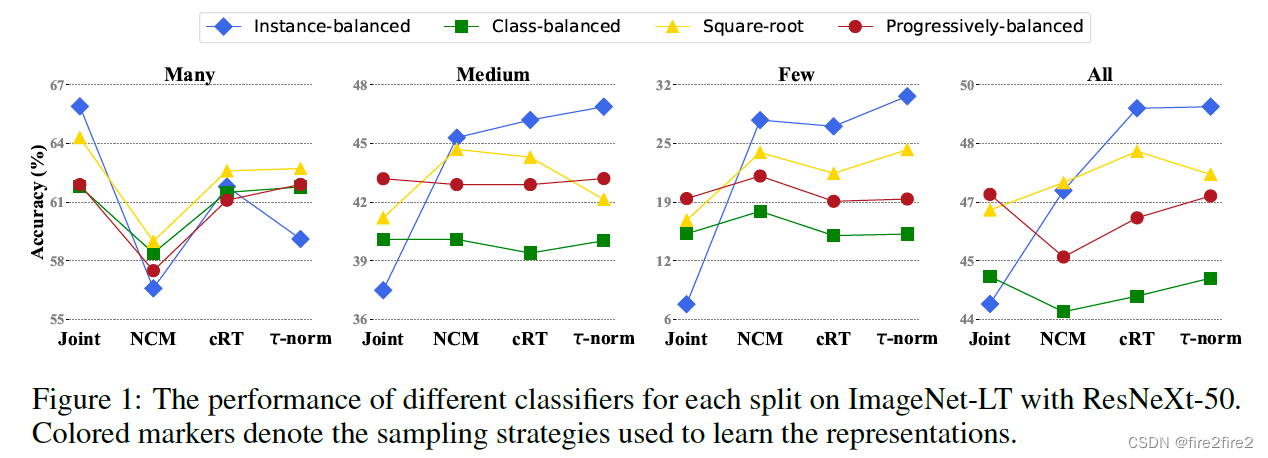

- 效果

- 总结

- 思想:解耦后,表征学习学到合理的特征后,只需调整分类器的划分边界bias即可对长尾数据实现较好的分类。

- 采用instance-balanced去学习表征效果最好

- 相较于joint方法,4种分类器解耦方法在many类上的acc均下降

- all,few和medium采用t-norm调整分类器效果最好

Bag of Tricks for Long-Tailed Visual Recognition with Deep Convolutional Neural Networks [AAAI 2022]

Bag of Tricks Github

|