Pytorch 编码

准备数据

PyTorch提供了两种类型的数据抽象,称为张量和变量。

张量

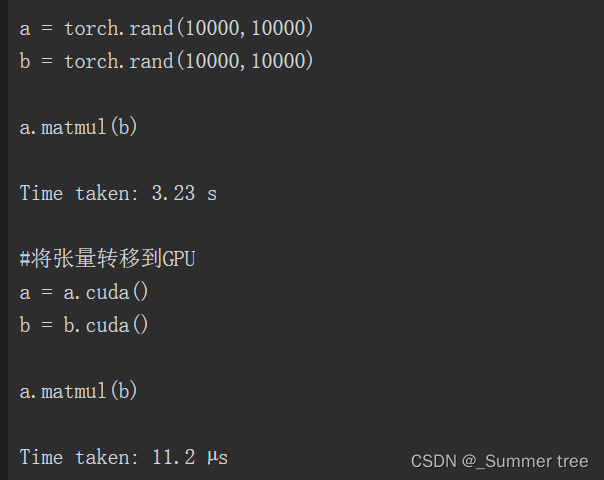

- 张量类似于numpy中的数组,它们也可以在GPU上使用,并能够改善性能。

- 张量类似Python数组,并可以改变大小

- PyTorch的大多数张量运算都和NumPy运算非常类似。

- 4维张量类型的一个常见例子是批图像。为了可以更快地在多样例上执行相同的操作,现代的CPU和GPU都进行了专门优化

- 必须使用5维张量的一个例子是视频数据。视频可以划分为帧

- PyTorch提供了一个名为cuda()的简单函数,将张量从CPU复制到GPU。所有张量都可以通过调用cuda()函数转移到GPU上。

变量

-

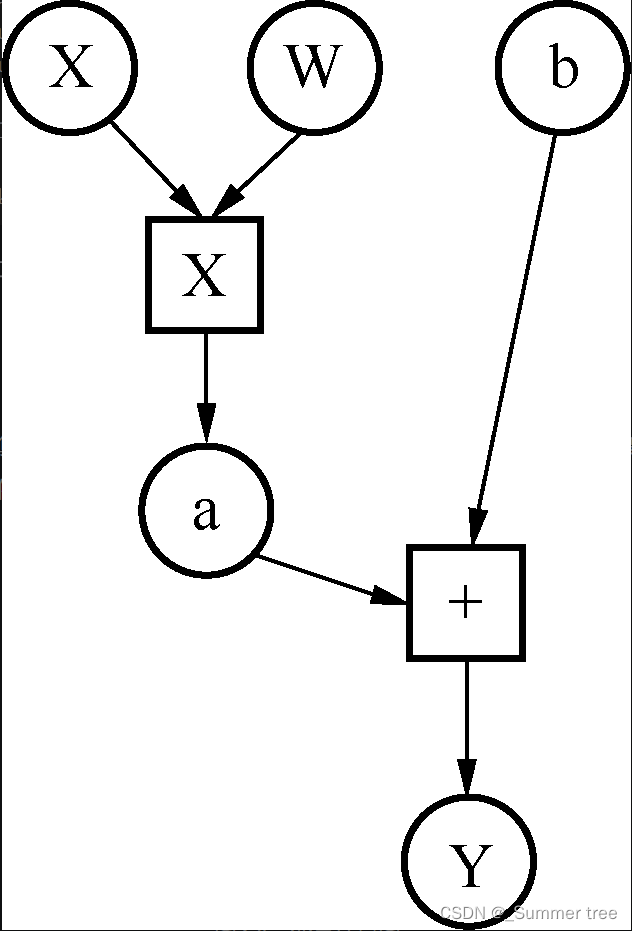

深度学习算法经常可以表示成计算图。图2.4所示为一个在示例中构建的变量计算图的简单例子

每个小圆圈表示一个变量,变量形成了一个轻量封装,将张量对象、梯度,以及创建张量对象的函数引用封装起来。

梯度是指loss函数相对于各个参数(W, b)的变化率 -

默认情况下,变量的梯度是none。

-

变量中的grad_fn指向了创建它的函数。

-

变量中的grad_fn指向了创建它的函数。

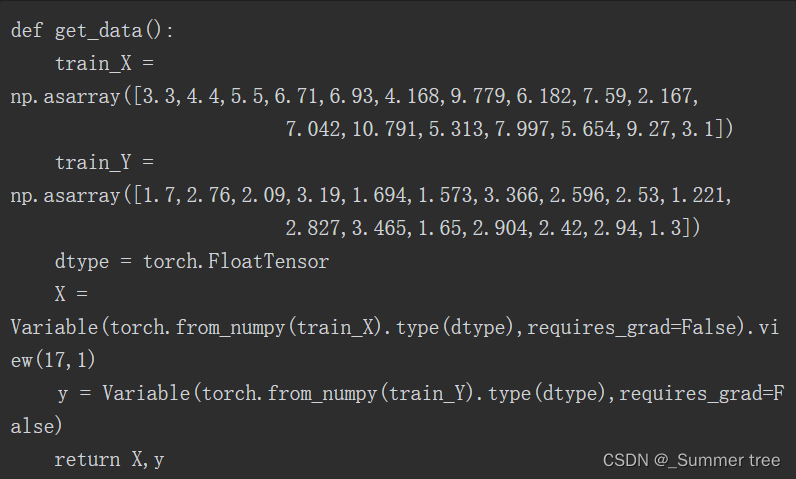

为神经网络创建数据

- get_data函数创建了两个变量:x和y,尺寸为(17, 1)和(17)

创建学习参数

- 共有两个学习参数:w和b。

- 学习参数使用随机值初始化并创建,其中参数require_grad的值设为True,这与变量x和y不同,变量x和y创建时require_grad的值是False。

神经网络模型

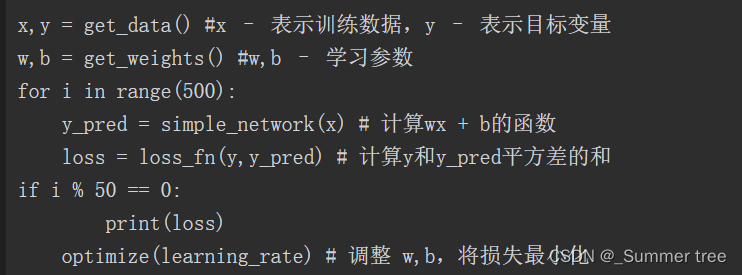

在线性关系的假定下,实现了尝试把输入映射为输出的简单神经网络。线性关系可以表示为y= wx+ b,其中w和b是学习参数。网络要学习w和b的值,这样wx+ b才能更加接近真实的y

网络的实现

- PyTorch在torch.nn中提供了称为层(layer)的高级抽象,层将负责多数常见的技术都需要用到的后台初始化和运算工作

- 我们已经计算出了y值,接下来要了解模型的性能,必须通过loss函数评估。

损失函数

- 对于回归问题,我们使用称为误差平方和(也称为和方差,SSE)的损失函数。

- 我们对y的预测值和真实值之差求平方。SSE有助于模型评估预测值和真实值的拟合程度。torch.nn库中有不同的损失函数,如均方差(又称方差,MSE)损失和交叉熵损失

- 除了计算损失值,我们还进行了backward操作,计算出了学习参数w和b的梯度。

- 由于我们会不止一次使用loss函数,因此通过调用grad.data.zero_()方法来清除前面计算出的梯度值。

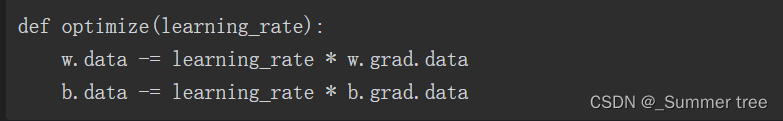

优化神经网络

- 损失值计算出来后,用计算出的梯度值进行优化,以让损失值降低。

- 学习率是一个超参数,可以让用户通过较小的梯度值变化来调整变量的值,其中梯度指明了每个变量(w和b)需要调整的方向

加载数据

PyTorch提供了很多工具类,工具类通过多线程、数据增强和批处理抽象出了如数据并行化等复杂性

本章将介绍两个重要的工具类:Dataset类和DataLoader类。

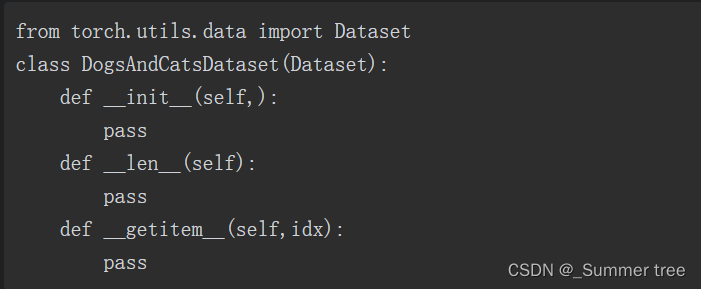

Dataset类

任何和Dataset类表现类似的自定义类都应和下面的代码类似

- 在init方法中,将进行任何需要的初始化。

- len(self)运算负责返回数据集中的最大元素个数

- getitem (self,idx)运算根据每次调用时的idx返回对应元素。

在单个的数据实例上应用深度学习算法并不理想。我们需要一批数据,现代的GPU都对批数据的执行进行了性能优化。DataLoader类通过提取出大部分复杂度来帮助创建批数据。

DataLoader类

- DataLoader类位于PyTorch的utils类中,它将数据集对象和不同的取样器联合 如SequentialSampler和RandomSampler

- 使用单进程或者多进程的的迭代器,为我们提供批量图片