神经网络

神经网络由多个layer(单层)组成,一层就是一个函数。

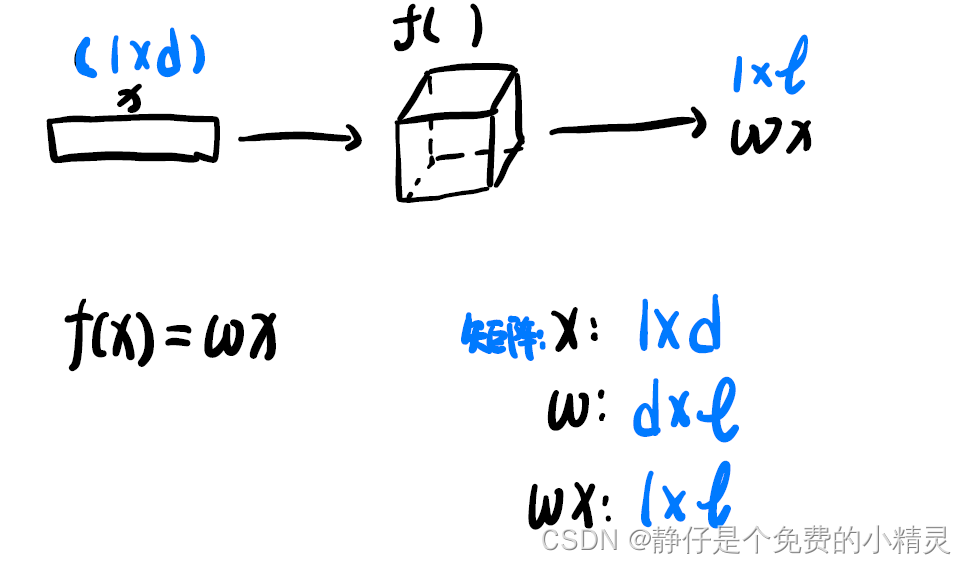

这是一个最简单的网络结构,

f

(

)

f()

f()就是一个layer 输入样本

x

x

x为一个

1

×

d

1\times d

1×d的矩阵,通过

f

(

)

f()

f()得到

1

×

l

1\times l

1×l的输出

w

x

wx

wx,其中

w

w

w是

d

×

l

d\times l

d×l的矩阵。

使用神经网络进行预测,

真实标签:

Y

Y

Y

预测标签:

Y

^

\hat{Y}

Y^

损失:loss =

∣

Y

^

?

Y

∣

2

=

(

w

x

?

Y

)

2

|\hat{Y}-Y|^{2}=(wx-Y)^{2}

∣Y^?Y∣2=(wx?Y)2

对

w

w

w求导:

d

L

d

w

=

2

(

w

x

?

y

)

x

\frac{d L}{d w}=2(w x-y) x

dwdL?=2(wx?y)x

学习率:

l

r

lr

lr即learn rate,是一个经验值

学习率更新:

w

←

w

?

l

r

×

d

L

d

w

w \leftarrow w-lr\times \frac{d L}{d w}

w←w?lr×dwdL?

停止迭代的方法:通常使用设置迭代次数,迭代多少次后就停止迭代

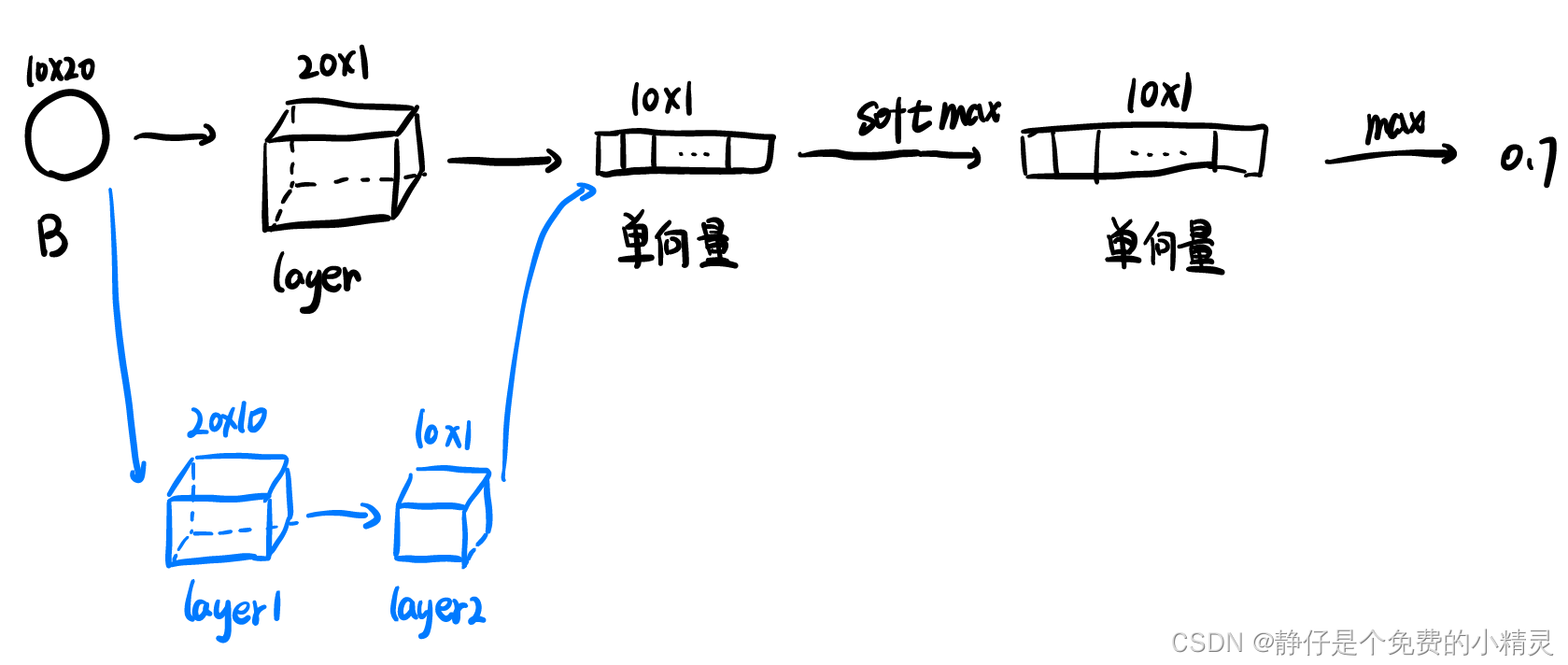

多示例网络

输入为一个包,通过layer将包处理为单项量,如图所示,可以使用一个layer(黑色),也可以使用两个网络(蓝色)。

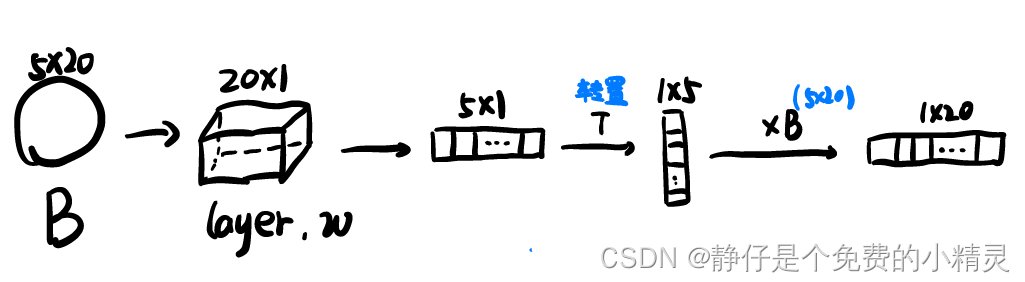

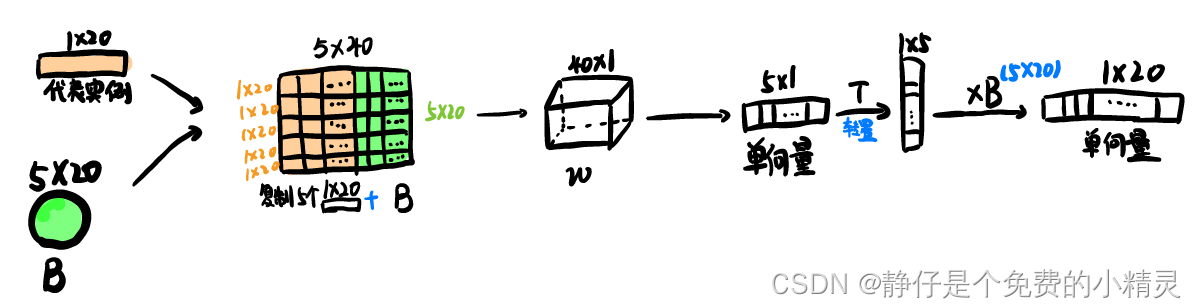

注意力机制

自注意力机制

考虑到了一个包中代表实例域其它实例之间的关系

代表实例可以实从包

B

B

B中提取出来的,也就是自,可以使用多种不同的方式提取,视具体的算法而定。

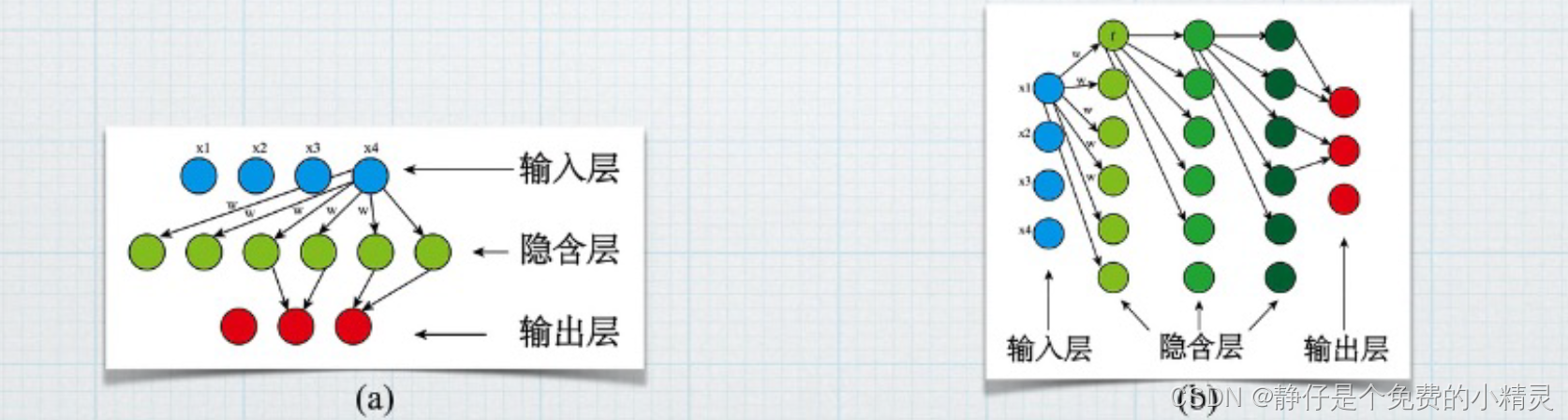

BP神经网络

BP神经网络是一种典型的非线性算法。由输入层,输出层和若干隐含层构成。

如图(a)所示,当只有一个隐含层时,这样的神经网络属于传统的浅层神经网络,如图(b)所示,当有多个隐含层时,这样的神经网络属于深度学习的神经网络。

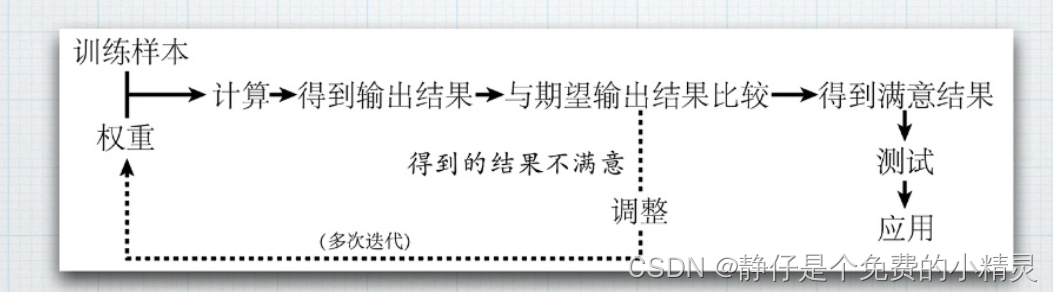

BP神经网络的核心步骤如下图所示:

Neural Networks for Multi-Instance Learning

用于多实例学习的神经网络,这篇论文是周志华老师2002年发表的,主要提出了将多示例应用于神经网络的方法。

主要提出了这个损失函数:

E

=

∑

i

=

1

N

E

i

=

∑

i

=

1

N

1

2

(

max

?

1

≤

j

≤

M

j

O

i

j

?

d

i

)

2

E=\sum_{i=1}^{N} E_{i}=\sum_{i=1}^{N} \frac{1}{2}\left(\max _{1 \leq j \leq M_{j}} O_{i j}-d_{i}\right)^{2}

E=i=1∑N?Ei?=i=1∑N?21?(1≤j≤Mj?max?Oij??di?)2

其中

E

i

E_{i}

Ei?表示第

i

i

i个包的损失,

O

i

j

O_{ij}

Oij?表示网络对实例

B

i

j

B_{ij}

Bij?标签的预测值,

d

i

d_{i}

di?表示包

B

i

B_i

Bi?的实际标签,即期望输出的预测值。