Deep Covariance Alignment for Domain Adaptive Remote Sensing Image Segmentation域自适应遥感图像分割中的深度协方差对齐

0.摘要

无监督域自适应(UDA)图像分割近年来受到越来越多的关注,其目的是提高从源域到目标域的知识传递的泛化能力。然而,在高空间分辨率遥感图像(RSI)中,来自不同领域(如城市和农村)的同一类别可能看起来完全不同,分布极不一致,这严重限制了UDA的精度。为了解决这个问题,在本文中,我们提出了一种新的深度协方差对齐(DCA)模型,用于UDA RSI分割。DCA可以显式地对齐类别特征,学习共享域不变的判别特征表示,从而增强模型泛化能力。具体来说,类别特征池(CFP)模块首先用于通过组合粗输出和深度特征来提取类别特征。然后,我们利用一种新的协方差正则化(CR)来加强类别内特征的更紧密性和类别间特征的进一步分离。与现有的类别对齐方法相比,我们的CR旨在正则化特征的不同维度之间的相关性,从而在处理不平衡和不一致分布的不同类别特征时表现得更加稳健。最后,我们提出了一种分阶段训练DCA的方法,以减少误差积累。在LoveDA数据集的农村到城市和城市到农村场景上的实验表明,我们提出的DCA方法优于其他最先进的UDA分割方法。

1.概述

遥感图像(RSI)分割旨在为每个图像像素分配相应的像素级土地覆盖类型,这在许多应用中发挥着越来越重要的作用[1]–[4]。然而,对标记训练样本的大量需求以及不同地理区域(如城市和农村)的不同风格严重限制了RSI细分的发展。针对数据缺乏和差异的一种常见解决方案是无监督领域自适应(unsupervised domain adaptive,UDA),其目标是提高不同领域的模型可推广性。UDA的目的是将从标记的源域训练的模型调整到未标记的目标域,从而缓解RSI分割任务中注释训练样本的不足

最近,随着基于深度卷积神经网络(CNN)[12],[13]的语义分割方法[5]-[11]的成功,UDA分割得到了迅速发展。在UDA语义分割中,最近的工作通常可分为两组,即对抗性训练(AT)方法[14]–[17]和自我训练(ST)方法[18]–[20]。A-T方法采用特征提取器来捕获域不变特征,并执行鉴别器来区分它们。Tsai等人[14]构建了一个多级对抗网络(AdapteSeg),以便在不同的功能级别上有效地执行输出空域自适应。Luo等人[15]设计了一个类别级对抗网络(CLAN),以进行更精细的级别域校准。Wang等人[16]提出了一个细粒度的对抗性学习框架(FADA),以协调共享功能。[17]中进一步提出了一种可转移归一化(TransNorm)方法,以改善UDA中的可转移性。然而,这些方法几乎都是基于AT的生成性对抗网络(GAN)[21],这很难训练。

此外,ST方法在UDA分割任务中也得到了广泛的应用,该任务涉及到在源域训练的模型对目标域产生伪标签,最后对模型进行微调。通常,Lian et al.[18]提出了跨领域适应金字塔课程(PyCDA),为UDA构建自我激励的金字塔课程。Zou等[19]进一步提出了类平衡自训练(CBST)策略,避免大类在伪标签生成中逐渐占据主导地位,并引入空间先验对生成的伪标签进行提炼。在[20]中提出了一种实例自适应训练(IAST)方法来选择平衡样本。ST方法总是以一种从粗到细的方式工作,通常用一种分阶段的机制进行训练。

以前的UDA方法也被应用于RSI分割任务[22]-[26]。大多数方法的目的是通过GAN[21]进行光度对准,这可以归为AT方法。尽管这些方法取得了一些有希望的结果,实际上,这些算法的进步是有限的几个原因。首先,在rsi中,地表覆盖的表现总是完全不同的。特别是,来自不同地区,即城市和农村的同一类别,在物体尺度和光谱值上可能看起来完全不同。如图1(a)所示,城市和农村的建筑和道路差异非常大。其次,不平衡和不一致的类别分布也对UDA RSI分割提出了特殊的挑战。如图1(b)所示,城市和农村的类别分布差异较大,这进一步增加了UDA RSI分割任务中模型泛化的难度。

为了解决这些问题,一个方向是在两个不同的域之间对齐类别级特征。[28]和[29]的作品采用在源域上计算的类别锚点来指导两个域的对齐,将类别中心约束为一个简单的欧氏距离。这种设计的问题在于没有考虑到类间特征之间的关系。因此,[30]中进一步使用了三重态损耗来规范类间特征之间的距离。虽然上述分类对齐方法已经取得了一些可喜的成果,但对于UDA RSI分割任务,仍存在一些亟待解决的问题。首先,对于rsi而言,类别内方差越大,两个域之间类别分布越不平衡,将严重误导不同类别特征之间距离的计算。此外,同时调整类内和类间的相对大小时,很难掌握决策边界,这往往需要一个复杂的手工阈值设置。

为了解决上述问题,在本文中,我们提出了一种新的深度协方差对齐(DCA)方法用于UDA RSI分割。该模型通过显式对齐类别特征来学习源领域到目标领域的共享领域不变判别知识。首先,利用分类特征池(CFP)模块,结合粗输出和深度特征提取分类特征;然后,我们利用一种新的协方差正则化(CR),使类内特征更接近,类间特征进一步分离。与现有的类别对齐方法相比,我们的CR旨在规范特征的不同维度之间的相关性,从而在处理分布不平衡和不一致的类别特征发散时表现出更强的鲁棒性。此外,我们的CR可以在没有任何复杂的手工设置的情况下进行培训。最后,为了减少错误积累,我们为我们提出的DCA提出了一个基于ST的阶段训练机制。

本文的其余部分组织如下:第二节回顾了相关的工作。第三节描述了我们提出的方法的细节。第四部分通过实验验证了本文方法的有效性,并与其他方法进行了比较。第五部分对本文进行了总结,并对今后的工作提出了建议。

2.相关工作

2.1.UDA RSI分割

近年来,随着[22]-[26]的提出,UDA RSI分割取得了很大的进展。这些方法大多集中于通过GAN[21]进行预成形光度比对,在图像空间、特征空间和输出空间对源图像和目标图像进行比对。Tasar等人[22]提出了颜色映射生成对抗网络(ColorMapGANs)来生成假的训练图像,以微调已经训练过的分类器。Ji等人[23]进一步使用GAN对多源rsi进行排列。然而,这些基于AT的模型很难训练,而且它们通常对齐来自不同领域的分布,但实际上并不获得来自不同领域的特征之间的映射。其他方法采用ST的思想,对目标域内的样本生成伪标签,并对分类器[31],[32]提供额外的监督。例如,Tong等[31]提出了一种基于st的UDA土地覆盖语义分割方法,使用可转移的深度模型。然而,容易出错的伪标签容易误导分类器,积累错误,限制了ST方法的有效性。

尽管这些方法已经取得了一些有希望的结果,但大多数方法都忽略了不同地理区域之间的不同风格。而对于城市和农村地区,土地覆盖的表现形式在类分布、物尺度和像元光谱上完全不同。为了提高UDA RSI分割的模型泛化能力,Wang等人[27]最初创建了一个突破性的LoveDA数据集,其中包含了不同的城市和农村RSI。该数据集旨在提高城市域和农村域的模型泛化能力,但大的类特征差异和类分布不一致严重限制了这一能力。

2.2.UD中的分类对齐方法

虽然上面提到的基于GAN的AT方法可以最小化域间隙,但并不能保证不同类别的特征可以很好地分离。因此,在[15]和[33]中利用类别级特征对齐的思想进行UDA分割。提出了特征和类别[34]、[35]的局部联合分布匹配方法。[36]中进一步引入了类别标签,以对预测标签的分布实施全局语义约束。最小化输出[37]的熵(不确定性)的思想也被用来隐式地实施类别级对齐

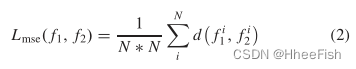

相对于上述方法中的隐式特征对齐,[28]-[30]提出了基于类别锚引导方法直接对两个域中的类别特征进行对齐,从而获得了更有竞争力的性能。其中,[28]、[29]采用了在源域上计算的类别锚点来指导两个域的对齐,可以看作是对类别中心的硬约束。硬约束为不同类别特征f1和f2之间的距离d,可简单定义为均方误差(MSE)函数为

其中|| ||表示欧氏距离。f1和f2分别代表来自两个不同域的同一类别的两个特征。这个距离d被用来通过一个损失函数Lmse来拉近类别内的距离

这里N表示类别总数,fi1和fi2分别是来自源域和目标域的第i个类别特征。

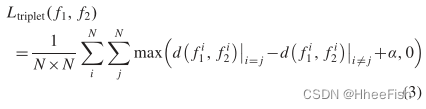

然而,这一策略并没有明确扩大不同类别特征中心之间的边缘。因此,Ma等人[30]提出了一种面向类别的源域三重态损失,该三重态损失施加了一种软约束来正则化类别中心,主动使高级特征空间中的类别间距离比类别内距离大一定范围。三态损耗Ltriplet表达式为

其中α表示规定的范围。然而,对于差异较大的不同类别,训练的最佳边际也是不同的,这需要一个经验丰富的手工设置。因此,[30]中的工作只对源域图像应用Ltriplet,源域图像有可靠的分类标签进行监督

3.提出的DCA方法

在本节中,我们将介绍我们提议的DCA的体系结构和详细的培训过程。首先,我们引入CFP模块提取类别特征。然后,我们描述了我们提出的CR的制定和动机,以及它的应用,以校准域内和跨域特征。最后,我们介绍了如何培训我们提出的DCA。

3.1.CFP模块

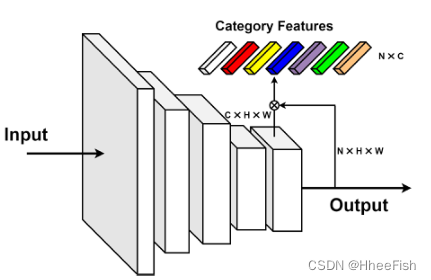

图2所示。类别特性池(CFP)模块框架。

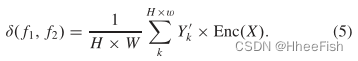

具体来说,我们使用Deeplab v2[38]作为基础分割模型,其中ResNet50[12]作为编码器Enc,根据[28],在特征空间中同一类聚类中的像素,其中每个类别的特征的质心可以代表类别特征的分布。因此,我们提出了CFP模块,将粗输出和深度特征相结合,从输入图像X中提取类别特征。如图2所示,首先提取深度特征Enc(X)∈RC×H×W,粗输出Y’∈RN×H×W,来自给定的输入图像X, 其中C, N分别表示通道数和类别数,h, w分别表示高度和宽度。然后将类别特征f∈RN×C计算为(f1和f2是CFP模块提取的两种类别特征)

其中

同样,CFP提取的类别特征f也被用作每个类别特征的类别质心,作为特征分布的代表。然而,值得注意的是,与[28]-[30]中的方法不同,我们的f只在一批图像中计算,而不是在域内的所有图像中计算,这节省了大量的时间,提高了效率。另外,我们不使用标签Y来纠正[28]-[30]中的类别特征f,因为粗输出Y’已经受到可靠标签Y的监督

3.2.协方差正规化Covariance Regularization(CR)

3.2.1.CR的动机

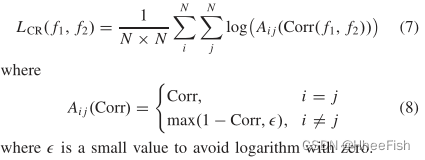

为了使类别特征保持一致,我们希望类别内特征可以更紧密,类别间特征可以更远。给定CFP模块提取的两个类别特征f1和f2,我们提出一种CR方法对特征进行对齐,定义为

其中,σf1和σf2分别为f1和f2的平均值,μf1和μf2分别为f1和f2的方差。E表示期望函数。Corr(f1, f2)构建了一个N × N的协方差矩阵来表示不同类别特征之间的关系。Corr(f1, f2)在数学领域也被称为线性相关系数,它是马氏距离,而不是前述方法中使用的欧氏距离[28]-[30]。

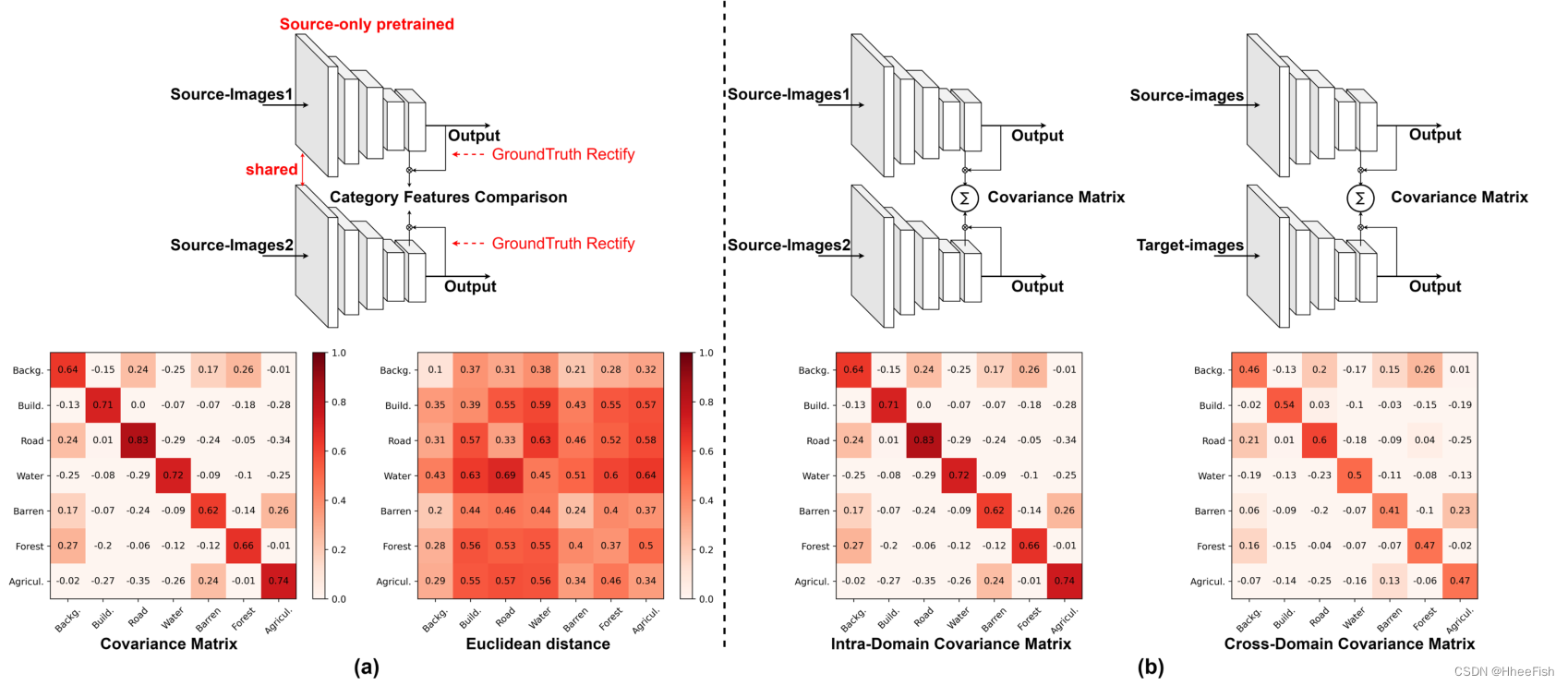

图3所示。(a)我们提出的协方差矩阵与[28]、[29]和[30]中使用的欧氏距离的比较。(b)类别特征在不同领域的差异,用我们提出的协方差矩阵表示。值得注意的是,在(a)和(b)中使用的是仅共享源的预训练网络。在III-A节中描述的实际训练中没有使用地面真实校正

为了进一步说明我们进行CR的动机,我们对所提出的CR进行了一个可解释的实验,如图3所示。在图3(a)中,我们从源域中划分出两组图像,通过只对源进行预训练的网络进行输入。然后对CFP模块提取的f1和f2进行类别特征比较。从图3(a)可以看出,与[28]-[30]中使用的欧氏距离相比,我们提出的CR可以更明确地表示不同类别特征之间的关系。另外,如图3(b)所示,我们将源图像和目标图像输入到网络中计算协方差矩阵。从图3(b)可以看出,源域与目标域的差异可以通过协方差矩阵清楚地表示出来。对于协方差矩阵,我们希望对角元素接近于1,非对角元素小于0,因此CR表示为

我们从三个方面总结了CR的新颖性。首先,如图3所示,我们提出的CR在计算类别特征之间的距离时具有更强的鲁棒性。由于rsi中类别内方差较大,会误导类别特征的计算,因此[28]、[29]、[30]中使用的欧氏距离不能清楚地表示类别距离。但根据(6),我们的CR用方差σf归一化,从而减轻了类别内方差的影响。另外,由于两个域的类别分布极不平衡、不一致,欧氏距离的计算几乎依赖于比例较大的类别,无法有效地对类别特征进行正则化。然而,作为马氏距离的一种,我们的CR也是尺度不变的,不受维数的影响,这意味着比例小的类别也会对距离的计算产生很大的影响。因此,对于类别内方差较大且类别分布不一致的rsi,我们提出的CR比现有的类别对齐方法更能在两个域之间对齐类别特征。

第二,不像欧氏距离只依赖于差值,我们的CR更关心向量不同维数之间的关系。现有方法[28]-[30]在提取高维类别特征后,利用欧几里得距离对类别特征进行硬约束,忽略了不同维度之间的关系。相反,我们的CR鼓励模型提取线性相关或线性无关的特征。例如,对于相同的类别,CR强制在模型中刺激特征的相同维数,而对于不同的类别刺激特征的不变维数。因此,我们的CR可以从维度方面对齐类别特征,而不是不稳定计算的值差。

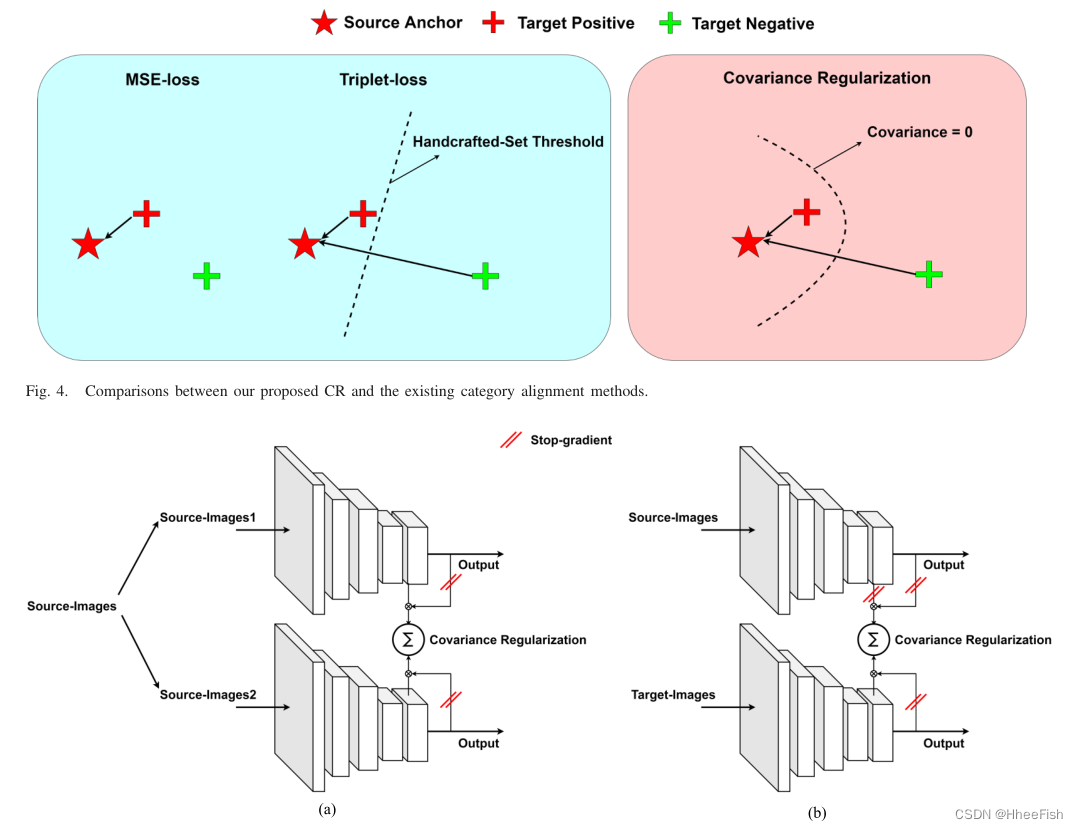

最后,与现有的分类对齐方法相比,本文提出的CR能更有效地适应UDA模型。如图4所示,我们的CR与[28]-[30]的方法相比具有突出的优势。首先,[28]、[29]中使用的MSE不对齐不同的类别特征。虽然[30]中提出的三元组可以正则化不同的类别特征,但同时调整类内和类间的相对大小时,很难学习到决策边界,这往往需要根据(3)进行复杂的手工阈值设置。我们的CR不仅可以对齐不同的类别特征,还可以保存设置阈值的步骤,因为corvariance = 0是一个原生阈值。当相关系数>为0时,类别特征为线性相关;当相关系数≤0时,类别特征为线性无关或负相关。因此,协方差= 0是对齐类别内和类别间特征的最佳决策边界,不需要任何其他手工设置。

3.2.2.域内CR(Intradomain CR)和域间CR(Cross-Domain CR)

图5所示。拟议(a) ICR和(b) CCR的架构。

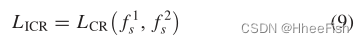

如图5(a)所示,对于ICR,给定一批图像,我们首先将其随机分为两组,然后对两组类别特征进行CR规范化。受[39]的启发,在ICR中,我们对输出停止梯度,只优化深度表示的学习,因为输出受到标签的可靠监督。值得注意的是,ICR只在源域中使用,因为源域中的粗输出受到可靠标签的监督,而可靠标签更加准确。正则化损失LICR表示为

式中,f1s和f2s分别为源域中不同组的类别特征。

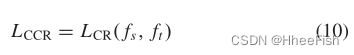

CCR进一步用于在不同域之间对齐类别特征。而在CCR中,来自源域的类别特征和来自两个域的输出是固定的,而从目标图像捕获的类别特征是优化的。由于源域具有更正确的监管,我们将它们指定为可信的参考,我们可以将目标特征与源特征对齐。同理,LCCR定义为

其中fs和ft分别是来自源域和目标域的类别特征。

通过ICR和CCR,我们鼓励在两个领域内更紧密的类内特征和进一步分离的类间特征,这将更逐步地适应所提出的DCA模型。

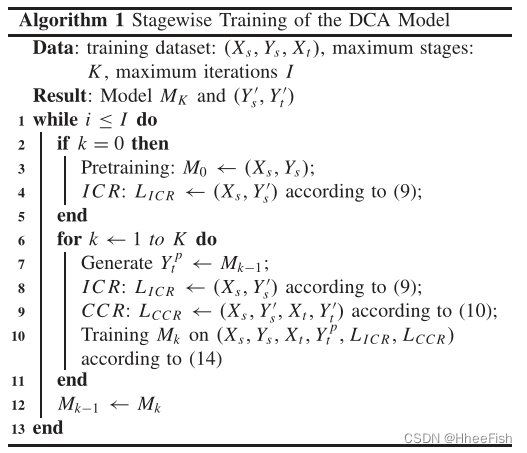

3.2.3.DCA训练

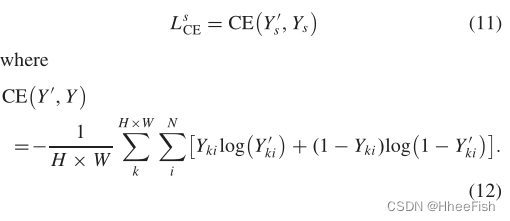

与前面提到的ST方法类似,我们用一个分阶段的过程来训练DCA模型。提出训练过程是为了避免ST中容易产生错误的伪标签的积累,这会产生错误的监督信号,导致更多错误的伪标签不断迭代,最终导致网络陷入局部最小值,性能较差。过程如算法1所示。首先,在源域上对分割模型[38]进行预训练。采用标准交叉熵损失函数CE(Y’,Y)来监督

同时,利用ICR对源域中的类别特征进行对齐。在每个阶段的开始,我们生成或更新伪标签Ypt来监督目标预测Y’t

接下来,我们用Lsce、LtCE和拟议的LICR和LCCR对DCA进行了几个阶段的训练

4.实验结果

为了验证我们提出的方法的有效性,我们在高级UDA RSI分割数据集LoveDA[27]上进行了广泛的实验。在本节中,我们首先介绍数据集和实现细节。然后,我们对数据集进行详细的广泛消融实验。最后,我们报告了农村到城市和城市到农村两种情景的结果,包括不同方法的视觉结果。

4.1.数据集

LoveDA数据集包含了来自三个不同城市的5987幅高空间分辨率(1024 × 1024像素)图像。与现有数据集相比,LoveDA数据集包含两个领域(城市和农村),侧重于提高不同城市和农村场景下模型的泛化能力。对于从农村到城市的任务,有1366幅源图像(农村)和677幅目标图像(城市)用于训练,820幅目标图像(城市)用于测试。在城市到农村任务中,1156幅源图像(城市)和992幅目标图像(农村)用于训练,976幅目标图像(农村)用于测试。详细的数据分割在[27]中进行了描述。

4.2.实验设置

4.2.1.实验环境

所有实验均在NVIDIA A100 GPU的服务器计算机上进行。该框架的实现基于开源工具箱Pytorch。每个实验进行5次,报告平均结果。

4.2.2.实现细节

我们使用交集over union (IoU)来报告语义分割的准确性。对于每个类别的IoU, mIoU表示所有类别的IoU的均值。

所有方法采用相同的特征提取器和鉴别器,其中提取器采用DeepLabV2[38]和ResNet50[12],鉴别器采用全卷积层[14]构造。所有网络中使用的骨干都在ImageNet[41]上进行了预训练。根据[27]的实验,在训练过程中,我们使用了动量为0.9,权重衰减为0.0005的随机梯度下降(SGD)优化器。初始学习率设置为0.01,并应用幂值0.9的poly调度。为了增强数据,从原始图像(1024 × 1024像素)中随机裁剪512 × 512个patch进行训练,随机镜像和旋转。在测试部分,我们对原始图像进行幻灯片预测,以减轻分辨率对分割结果的影响。在分阶段训练算法1中,两个实验都将最大阶段K设为5,最大迭代次数I设为10 000。

4.3. DCA消融研究

4.3.1.与类别对齐方法的比较

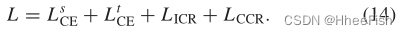

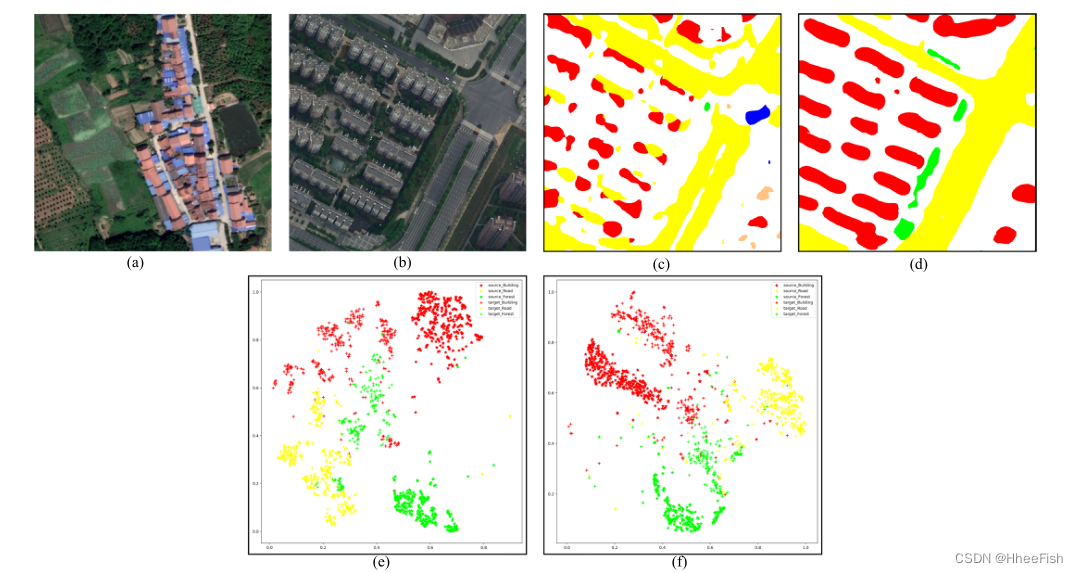

表一与基线方法和ca分类对齐方法的性能比较

为了验证我们的DCA的效率,我们首先将我们的DCA方法与纯源方法和基线方法进行比较。在这里,我们将基线方法定义为使用普通ST策略,该策略简单地在源域预训练模型,并根据(13)直接生成伪标签来监督目标图像,而不需要任何其他先验。接下来,我们将本文提出的CR与其他分类比对方法进行了公平的比较,即[28]中采用了基于mse的比对,[30]中采用了基于三元组的比对。对于三元组对齐法,我们根据(3)多次尝试寻找最佳α,最终将其设为0.5。具体结果见表一。

如表一所示,ST基线可以很大程度上促进纯源预训练模型的泛化。此外,MSE对齐方法对mIoU进行了改进,验证了分类对齐方法的有效性。然而,三元组对齐方法并不能有效地提高精度。原因可能是三元组的训练比较复杂,不能用于UDA RSI分割。此外,我们提出的DCA与其他方法相比,可以取得显著的改进。在农村到城市的实验中,我们的DCA在mIoU上提高了9.19%,在城市到农村的实验中mIoU提高了9.65%,这大大优于其他方法。这表明,通过对分类特征进行对齐,可以大大提高模型的泛化能力。

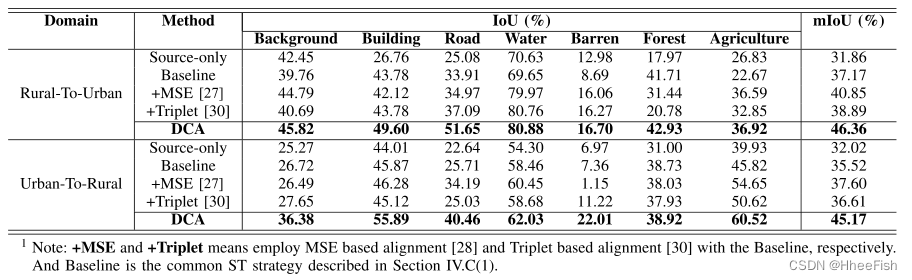

4.3.2.类别特征分布的可视化结果

图6所示。在农村-城市实验中,所提出的DCA与基线方法的对比分析。(a)来自农村领域的源图像。(b)来自城市域的目标图像。? (d)基线方法和我们的DCA方法的分割结果。然后,我们将?和(d)的高维特征映射到具有t-随机邻域嵌入(SNE)[40]的二维空间,如(e)和(f)所示。

为了进一步说明我们提出的DCA的新颖性,我们可视化了深层类别特征在潜在空间中的分布。为此,给定一幅域差异较大的源图像和一幅目标图像,我们使用t-SNE[40]将它们的高维深度特征映射到二维空间,如图6所示。我们重点研究了两个域的不同类别之间的特征分布。如图6(e)所示,对于基线方法,由于域漂移,学习到的建筑物、道路和森林的特征是分开的。可以看出,如果没有CR对齐,基线方法就不能明确地学习来自不同域的相同类别的共享表示。相反,我们可以从图6(f)中观察到,我们提出的DCA可以使类内特征更接近,类间特征进一步分离,从而构建出更准确的UDA分割结果,如图6(d)所示。

4.3.3.与UDA分割方法的比较

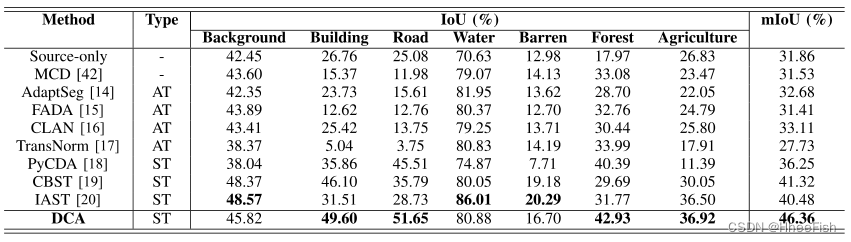

表二在农村到城市的实验中与最先进的uda分割方法的性能比较

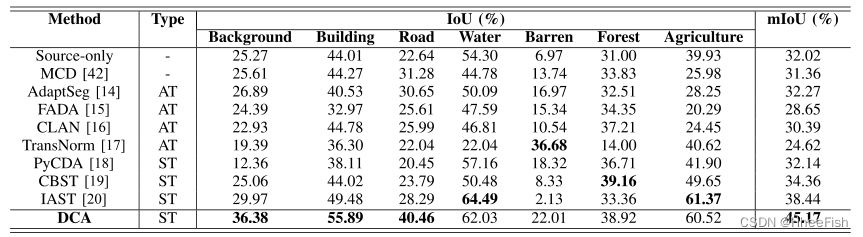

表三在城市到农村的实验中与最先进的uda分割方法的性能比较

LoveDA数据集包含两个场景:农村到城市和城市到农村。我们在LoveDA数据集[27]上进行了两种场景的实验,以评估我们的DCA与其他最先进的UDA分割方法的有效性,如表II和表III所示。

从表2可以看出,在农村到城市的实验中,DCA的mIoU最高,为46.36%,比目前最先进的CBST方法高出5.04%。具体来说,DCA带来了对建筑、道路和森林欠条的极大改善。但由于背景和贫瘠,欠条并没有明显改善。原因可能是这两类人的特征过于复杂,难以统一。在表三所示的城乡实验中,DCA的mIoU也达到了45.17%,与其他方法相比差距较大。这些改进主要来自于建筑和道路,这意味着我们的DCA可以有效地提取这些类别从乡村域到城市域的共享特征。实验结果证明了所提出的DCA方法的有效性。从表2可以看出,在农村到城市的实验中,DCA的mIoU最高,为46.36%,比目前最先进的CBST方法高出5.04%。具体来说,DCA带来了对建筑、道路和森林欠条的极大改善。但由于背景和贫瘠,欠条并没有明显改善。原因可能是这两类人的特征过于复杂,难以统一。在表三所示的城乡实验中,DCA的mIoU也达到了45.17%,与其他方法相比差距较大。这些改进主要来自于建筑和道路,这意味着我们的DCA可以有效地提取这些类别从乡村域到城市域的共享特征。实验结果证明了所提出的DCA方法的有效性。

4.3.4.可视化结果

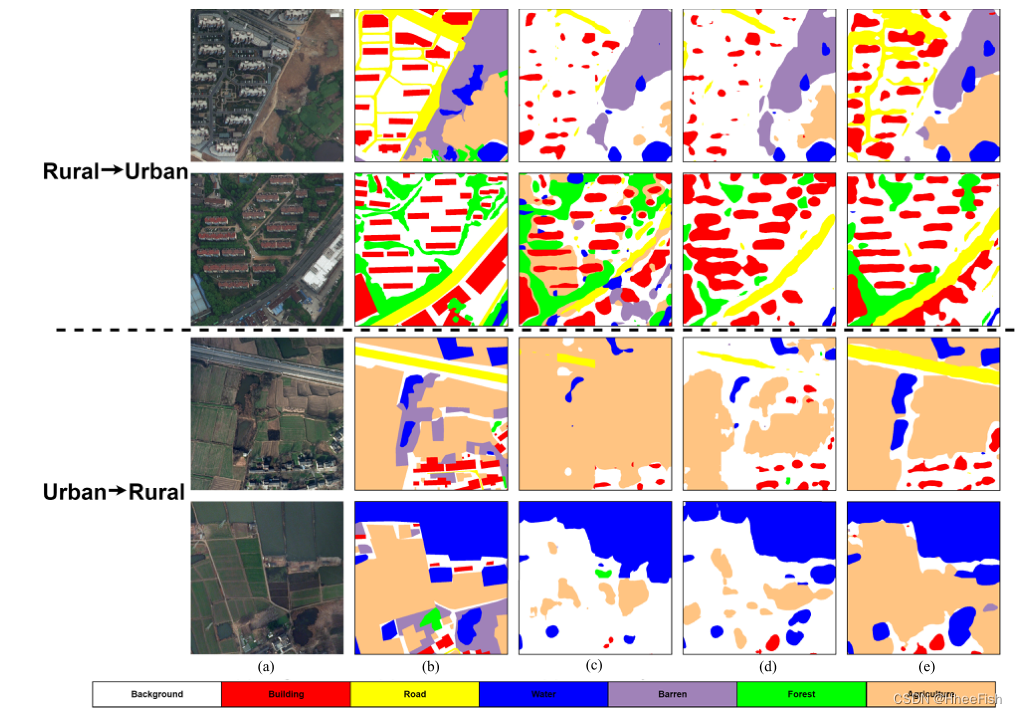

图7所示。在Val数据集上与其他方法进行定性比较。(一)原图。(b)地面真值。?只有Source。(d)CBST。(e) DCA

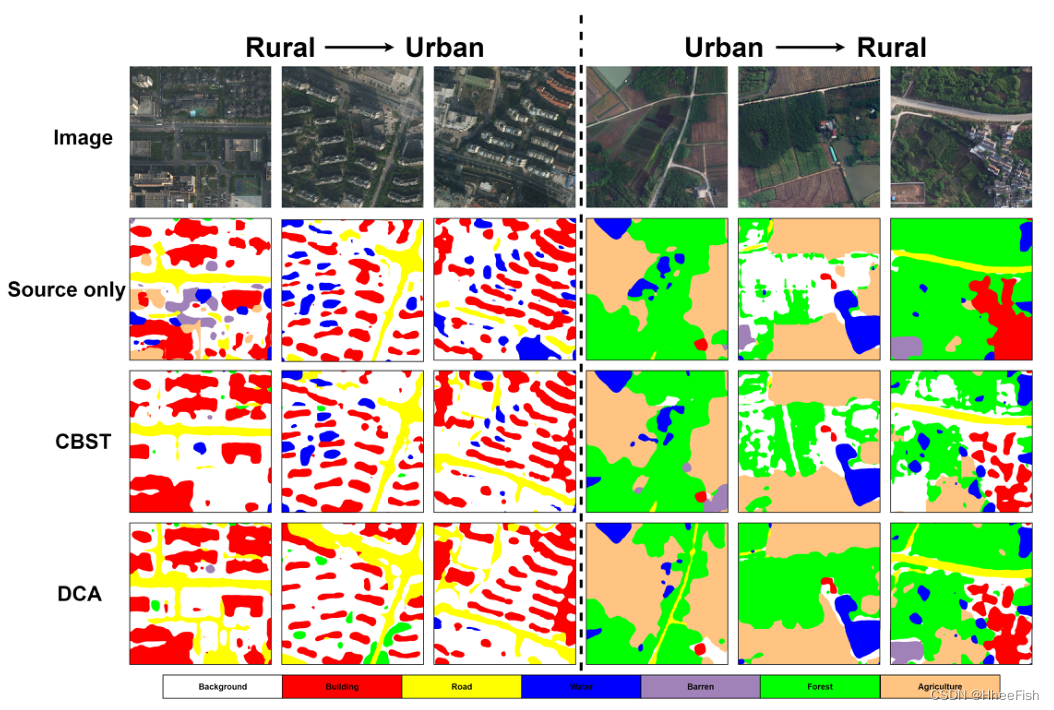

图8所示。在测试数据集上对所提出的方法和其他方法进行定性比较。

定性结果如图7、图8所示。由于我们在测试数据集上没有对应的地面真值,所以我们也在图7的Val数据集上显示结果,与地面真值进行比较。图8显示了测试数据集上的可视化结果。可以看出,我们的DCA可以产生比source-only method和CBST[19]更好的UDA segmentation prediction。具体来说,在从农村到城市的实验中,我们的DCA预测了更完整的建筑和道路建设。在城市到农村的实验中,农业的分割结果更加准确。可视化结果也证明了我们所提出框架的有效性。

5.结论

在这篇文章中,我们提出了一个新的DCA框架用于UDA RSI分割。我们提出的DCA使用一种新的CR使类内特征更接近,类间特征进一步分离,从而显式提取了共享域不变的判别特征表示,增强了模型泛化能力。在LoveDA数据集上的大量实验表明,与其他最新的方法相比,所提出的DCA的有效性和效率。在未来,我们将探索定量实验的发展,以分析我们的DCA所执行的结果的可视化和解释,并与其他方法进行比较。此外,我们还将研究区域自适应分割任务在rsi中的熟练程度,并考虑其他对齐方法来进一步提高分割性能。

参考文献

[1] D. Li, G. Zhang, Z. Wu, and L. Yi, “An edge embedded markerbased watershed algorithm for high spatial resolution remote sensing image segmentation,” IEEE Trans. Image Process., vol. 19, no. 10, pp. 2781–2787, Oct. 2010.

[2] H. Sheng, X. Chen, J. Su, R. Rajagopal, and A. Ng, “Effective data fusion with generalized vegetation index: Evidence from land cover segmentation in agriculture,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. Workshops (CVPRW), Jun. 2020, pp. 267–276.

[3] L. Ding, J. Zhang, and L. Bruzzone, “Semantic segmentation of largesize VHR remote sensing images using a two-stage multiscale training architecture,” IEEE Trans. Geosci. Remote Sens., vol. 58, no. 8, pp. 5367–5376, Aug. 2020.

[4] Q. Wang, J. Gao, and X. Li, “Weakly supervised adversarial domain adaptation for semantic segmentation in urban scenes,” IEEE Trans. Image Process., vol. 28, no. 9, pp. 4376–4386, Sep. 2019.

[5] E. Shelhamer, J. Long, and T. Darrell, “Fully convolutional networks for semantic segmentation,” IEEE Trans. Pattern Anal. Mach. Intell., vol. 39, no. 4, pp. 640–651, Apr. 2017.

[6] O. Ronneberger, P. Fischer, and T. Brox, “U-Net: Convolutional networks for biomedical image segmentation,” in Proc. Int. Conf. Med. Image Comput. Comput.-Assist. Intervent. (MICCAI), vol. 9351. Cham, Switzerland: Springer, Nov. 2015, pp. 234–241.

[7] Z. Zhou, M. M. R. Siddiquee, N. Tajbakhsh, and J. Liang, “UNet++: Redesigning skip connections to exploit multiscale features in image segmentation,” IEEE Trans. Med. Imag., vol. 39, no. 6, pp. 1856–1867, Jun. 2020.

[ 8 ] H . Z h a o , J . S h i , X . Q i , X . W a n g , a n d J . J i a , “ P y r a m i d s c e n e p a r s i n g network,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jul. 2017, pp. 6230–6239.

[9] T.-Y . Lin, P . Dollár, R. Girshick, K. He, B. Hariharan, and S. Belongie, “Feature pyramid networks for object detection,” in Proc. CVPR, Jul. 2017, pp. 936–944.

[10] J. Xie, L. Fang, B. Zhang, J. Chanussot, and S. Li, “Super resolution guided deep network for land cover classification from remote sensing images,” IEEE Trans. Geosci. Remote Sens., vol. 60, pp. 1–12, 2022.

[11] N. He, L. Fang, and A. Plaza, “Hybrid first and second order attention UNet for building segmentation in remote sensing images,” Sci. China Inf. Sci., vol. 63, no. 4, pp. 1–12, Apr. 2020.

[12] K. He, X. Zhang, S. Ren, and J. Sun, “Deep residual learning for image recognition,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jan. 2016, pp. 770–778.

[13] K. Simonyan and A. Zisserman, “Very deep convolutional networks for large-scale image recognition,” 2014, arXiv:1409.1556.

[14] Y .-H. Tsai, W.-C. Hung, S. Schulter, K. Sohn, M.-H. Y ang, and M. Chandraker, “Learning to adapt structured output space for semantic segmentation,” in Proc. CVPR, Jun. 2018, pp. 7472–7481.

[15] Y . Luo, L. Zheng, T. Guan, J. Y u, and Y . Y ang, “Taking a closer look at domain shift: Category-level adversaries for semantics consistent domain adaptation,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2019, pp. 2502–2511.

[16] H. Wang, T. Shen, W. Zhang, L. Duan, and T. Mei, “Classes matter: A fine-grained adversarial approach to cross-domain semantic segmentation,” in Proc. Eur. Conf. Comput. Vis. (ECCV), Aug. 2020, pp. 642–659.

[17] X. Wang, Y . Jin, M. Long, J. Wang, and M. I. Jordan, “Transferable normalization: Towards improving transferability of deep neural networks,” in Proc. Adv. Neural Inf. Process. Syst. (NIPS), Jul. 2019, pp. 1–11.

[18] Q. Lian, L. Duan, F. Lv, and B. Gong, “Constructing self-motivated pyramid curriculums for cross-domain semantic segmentation: A nonadversarial approach,” in Proc. IEEE/CVF Int. Conf. Comput. Vis. (ICCV), Oct. 2019, pp. 6757–6766.

[19] Y . Zou, Z. Y u, B. V . Kumar, and J. Wang, “Unsupervised domain adaptation for semantic segmentation via class-balanced self-training,” in Proc. Eur. Conf. Comput. Vis., Sep. 2018, pp. 289–305.

[20] K. Mei, C. Zhu, J. Zou, and S. Zhang, “Instance adaptive self-training for unsupervised domain adaptation,” in Proc. Eur. Conf. Comput. Vis. (ECCV), Aug. 2020, pp. 415–453.

[21] I. Goodfellow et al., “Generative adversarial nets,” 2014, arXiv:1406.2661.

[22] O. Tasar, S. L. Happy, Y . Tarabalka, and P . Alliez, “ColorMapGAN: Unsupervised domain adaptation for semantic segmentation using color mapping generative adversarial networks,” IEEE Trans. Geosci. Remote Sens., vol. 58, no. 10, pp. 7178–7193, Oct. 2020.

[23] S. Ji, D. Wang, and M. Luo, “Generative adversarial network-based fullspace domain adaptation for land cover classification from multiplesource remote sensing images,” IEEE Trans. Geosci. Remote Sens., vol. 59, no. 5, pp. 3816–3828, May 2021.

[24] L. Y an, B. Fan, H. Liu, C. Huo, S. Xiang, and C. Pan, “Triplet adversarial domain adaptation for pixel-level classification of VHR remote sensing images,” IEEE Trans. Geosci. Remote Sens., vol. 58, no. 5, pp. 3558–3573, May 2020.

[25] O. Tasar, A. Giros, Y . Tarabalka, P . Alliez, and S. Clerc, “DAugNet: Unsupervised, multisource, multitarget, and life-long domain adaptation for semantic segmentation of satellite images,” IEEE Trans. Geosci. Remote Sens., vol. 59, no. 2, pp. 1067–1081, Feb. 2021.

[26] L. Zhang, M. Lan, J. Zhang, and D. Tao, “Stagewise unsupervised domain adaptation with adversarial self-training for road segmentation of remote-sensing images,” IEEE Trans. Geosci. Remote Sens., vol. 60, pp. 1–13, 2022.

[27] J. Wang, Z. Zheng, A. Ma, X. Lu, and Y . Zhong, “LoveDA: A remote sensing land-cover dataset for domain adaptive semantic segmentation,” in Proc. Neural Inf. Process. Syst. Track Datasets Benchmarks, v o l . 1 . J. V anschoren and S. Y eung, 2021, pp. 1–12.

[Online]. Available: https://datasets-benchmarks-proceedings.neurips.cc/paper/2021/file/4e73 2ced3463d06de0ca9a15b6153677-Paper-round2.pdf

[28] Q. Zhang, J. Zhang, W. Liu, and D. Tao, “Category anchorguided unsupervised domain adaptation for semantic segmentation,” in Proc. Adv. Neural Inf. Process. Syst. (NIPS), Oct. 2019, pp. 433–443.

[29] Z. Wang et al., “Differential treatment for stuff and things: A simple unsupervised domain adaptation method for semantic segmentation,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2020, pp. 12632–12641.

[30] H. Ma, X. Lin, Z. Wu, and Y . Y u, “Coarse-to-fine domain adaptive semantic segmentation with photometric alignment and category-center regularization,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2021, pp. 4050–4059.

[31] X.-Y . Tong et al., “Land-cover classification with high-resolution remote sensing images using transferable deep models,” Remote Sens. Environ., vol. 237, Feb. 2020, Art. no. 111322.

[32] A. Zheng, M. Wang, C. Li, J. Tang, and B. Luo, “Entropy guided adversarial domain adaptation for aerial image semantic segmentation,” IEEE Trans. Geosci. Remote Sens., vol. 60, pp. 1–14, 2022.

[33] K. Saito, Y . Ushiku, T. Harada, and K. Watanabe, “Maximum classifier discrepancy for unsupervised domain adaptation,” in Proc. IEEE Int. Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2018, pp. 3723–3732.

[34] Y .-H. Chen, W.-Y . Chen, Y .-T. Chen, B.-C. Tsai, Y .-C.-F. Wang, and M. Sun, “No more discrimination: Cross city adaptation of road scene segmenters,” in Proc. IEEE Int. Conf. Comput. Vis. (ICCV), Oct. 2017, pp. 2011–2020.

[35] G. Kang, L. Jiang, Y . Y ang, and A. G. Hauptmann, “Contrastive adaptation network for unsupervised domain adaptation,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2019, pp. 4888–4897.

[36] J. Hoffman, D. Wang, F. Y u, and T. Darrell, “FCNs in the wild: Pixel-level adversarial and constraint-based adaptation,” 2016, arXiv:1612.02649.

[37] T.-H. Vu, H. Jain, M. Bucher, M. Cord, and P . Perez, “ADVENT: Adversarial entropy minimization for domain adaptation in semantic segmentation,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2019, pp. 2512–2521.

[38] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Y uille, “DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs,” IEEE Trans. Pattern Anal. Mach. Intell., vol. 40, no. 4, pp. 834–848, Apr. 2018.

[39] X. Chen and K. He, “Exploring simple Siamese representation learning,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2021, pp. 15745–15753.

[40] L. van der Maaten and G. Hinton, “Visualizing data using t-SNE,” J. Mach. Learn. Res., vol. 9, pp. 2579–2605, Nov. 2008.

[41] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei, “ImageNet: A large-scale hierarchical image database,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2009, pp. 248–255.

[42] E. Tzeng, J. Hoffman, N. Zhang, K. Saenko, and T. Darrell, “Deep domain confusion: Maximizing for domain invariance,” 2014, arXiv:1412.3474