目录

Randomized Controlled Trials(RCT)

ATT Average Treatment Effect on the Treated

三 Propensity Modeling? (倾向建模流程)

四 Propensity Score Methods(倾向得分方法)

(1)采样手段:without replacement v.s. with replacement

(3)相似度度量:Nearest Neighbor v.s Caliper distance

(4)匹配数量:one-to-one v.s. many-to-one

3 Stratification and Interval on the Propensity Score

4 Inverse Probability of Treatment Weighting Using the Propensity Score

5 Covariate Adjustment Using the Propensity Score

?1.可量化的指标——标准化偏差 Standardized Bias?

Propensity Score Matching——一种去偏方法

PSM是一种处理基于观测数据进行因果建模的方法。PSM解决的是选择偏差问题(即控制混杂因素),倾向得分配比就是利用倾向评分值,从对照组中为处理做中的每个个体寻找一个或多个背景特征相同或相似的个体作为对照。这样就最大程度降低了其他混杂因素的干扰。

文章主要介绍倾向得分匹配(PSM, Propensity Score Matching)方法的原理以及实现。这是一种理论稍微复杂、但实现较为容易的分析方法,适合非算法同学的使用。可用于(基于观察数据的)AB实验、增量模型搭建等领域。

一 前置知识

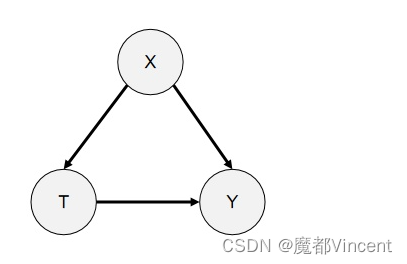

大家已知的是,观测数据是有偏的,即存在特征X既影响目标outcome Y,又影响Treatment T。那么在进行因果建模之前,我们需要进行去偏处理,使得Treatment Y独立于特征X,此时的观测数据近似相当于RCT数据,之后我们就可以使用因果模型进行CATE评估了。

干预效果 Treatment Effect

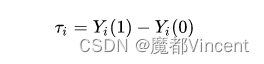

干预效果(Treatment Effect):干预下的潜在结果减去未干预时的潜在结果,即

其中 Yi 表示潜在结果,1和0分别代表是否受到干预。

举个例子:我们想知道我买车给我提升了多少幸福度,理想情况下就是用我买车时的幸福度减去我不买车时的幸福度.

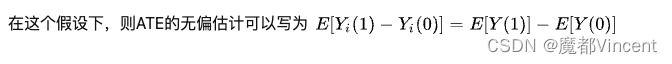

ATE (Averaged Treatment Effect) 是计算整体的 Treatment Effect, 例如我们实验有一个 Control 组, 一个 Treatment 组. ATE 会计算这个 Treatment 对于这个组会产生怎样的 Effect. 这个指标在我们实际的算法过程中很少用.

Randomized Controlled Trials(RCT)

在RCT中,实验组和对照组的样本是随机分流的,这就保证了实验组和对照组的样本在分布上是一致的,此时有? 即我们的协变量X和Treatment之间没有confounder:

?

Observational Studies

Observational studies和RCT在实验设计上存在区别为,即对于样本是实验组还是对照组并不是完全随机的,即存在X同时影响着T和Y。

实验组和对照组的样本分布存在差异使得 ? (对照测试组同样)

因此我们无法通过观测数据得到一个无偏的ATE。因此我们需要采用例如Propensity score methods的方法来帮助我们估计ATE。

ATT Average Treatment Effect on the Treated

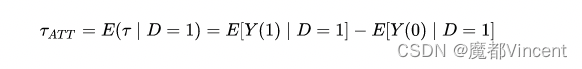

相较于个人的干预效果,我们更希望了解人群整体的干预效果,毕竟我们通常用策略干预的是一个人群。

应用PSM,我们通常希望计算得到被干预的用户的平均干预效果,即ATT(average treatment effect on the treated)

其中变量 D 代表是否收到干预。

可以看到 E[Y(0) | D = 1] 代表被干预的用户假如不被干预的情况下的潜在结果,是一个无法观测的数值。

倘若可以建立AB测试,我们利用对照组则可以得到该结果,在无法进行AB测试的情况(例如 D 是一个主动的行为)下,我们可以通过PSM拟合一个虚拟的对照组进行计算。

1. 计算ATT所需满足的假设

这里引入一个新的概念,倾向性得分(Propensity Score),即用户受到(参与)干预的概率:

P(X) = P(D=1 | X)

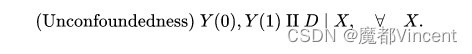

a.条件独立假设 CIA (Conditional Independence Assumption)

给定一系列可观测的协变量 X ,潜在结果和干预分配相互独立。

?可认为所有影响到干预分配与潜在结果的变量都同时被观测到。此时X可能是高维度的

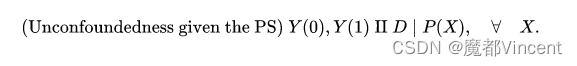

若上式成立,则干预分配与潜在结果基于 X 同样条件独立[可证明],即

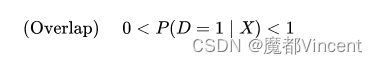

?b.共支撑 Common Support

在一些文献中,该条件也被称为strong ignorability.

除了独立外的另一个条件是存在重叠的部分,即:

?这个条件能够排除掉——给定 X 时能准确确定D的情况(也因为如此才有匹配的空间)。

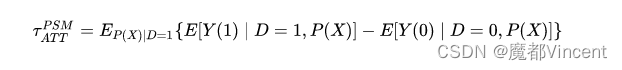

?2. 估算ATT

在满足CIA和common support的情况下,我们能够对ATT进行估算:

?即:在common support 上,以倾向分为权重、对实验组与对照组平均值的差值进行求和。

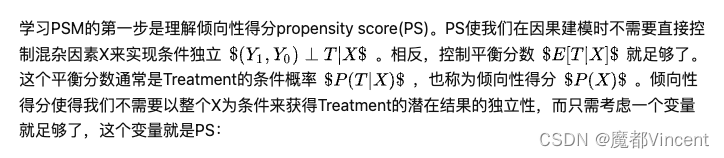

二 Propensity Score(倾向得分)

Propensity score主要是用来估计给定样本协变量情况下,被施加treatment的概率,

即 ??

在RCT实验中,Propensity score是实验设置的参数,它是已知的;但在Observational study中,实际的Propensity score我们并不知道,因此需要通过数据进行估计。一般来说使用逻辑回归根据变量来预估样本被施加treatment的概率,实际上通过任意二分类模型都可以用来估计Propensity score。

Propensity score的一个假设是“no unmeasured confounders”,通俗点讲就是所有影响treatment的变量都可观测且可度量。即实际对Propensity score建模时,要把所有影响treatment的变量都考虑到。

关于Propensity Score建模时的特征选择上,目前学术界并没有一个一致。

但propensity score的变量一般包含以下四个方面:

- all measured baseline covariates 所有测量的基线协变量

- all baseline covariates that associated with treatment assignment 所有与治疗分配相关的基线协变量

- all covariates that affect the outcome(the potential confounders) 影响结果的所有协变量 (潜在的混杂因素)

- all covariates that affect both treatment assignment and the outcome(true confounders) 所有影响治疗分配和结果的协变量 (真正的混杂因素)

因为propensity score本质上是指样本被施加treatment的概率,因此也有理论证明只需要包含影响treatment assignment的变量即可。

三 Propensity Modeling? (倾向建模流程)

倾向建模尝试预测访客,潜在顾客和客户执行某些操作的可能性。这是一种统计方法,它考虑了影响所述行为的所有独立变量和混杂变量。

因此,例如,倾向建模可以帮助营销团队预测潜在客户转化为客户的可能性。否则客户会流失。甚至是电子邮件收件人将退订。

那么,倾向得分就是访问者,潜在顾客或客户将执行特定操作的概率。

用倾向建模的技术来分析喝soylent饮料到底有什么作用。为了解释清楚这个概念,接下来要开始一场思想实验。

假定Brad Pitt有一个双胞胎的哥哥,兄弟俩哪都一样:Brad1和Brad2一起起床,吃一样的事物,进行同样强度的体能锻炼等等。有一天,Brad 1 碰巧从街上的促销员那里得到了最后一打Soylent饮料,但Brad 2没有这样的好运气。所以Soylent只出现在了Brad1的食谱上。在这种情况下,可以认为,双胞胎此后出现的任何行为差异就是这个饮料造成的。

将这种情景带入现实世界,我们用下面的方法来估计Soylent对健康的影响:

-

对于每一个喝Soylent的人来说,找到一个各方面都比较接近他的不喝这个饮料的人。比如我们会将喝Soylent的Jay-Z和不喝Soylent的Kanye当做一组,或者喝Soylent的Keira 配对不喝Soylent的Knightley这样。

-

接下来我们就观察二者的不同之处来量化soylent的影响。

然而,在实践时找到两个非常相近的双胞胎是很困难的,如果Jay-Z比Kanye平均多睡一个小时,那么怎么保证二者真的很接近呢?

Propensity modeling(倾向建模)就是这种双胞胎匹配过程的简化。我们并不是根据所有的变量来匹配两个个体,而是根据一个简单的数字来匹配所有用户-----他们喝soylent的可能性(“倾向”)

?直观上,从因果图上可以看出,当以P(X)为条件时,X和T相互独立。因此,我们可以将倾向性得分看作是在特征空间上执行某种降维操作。它将X中的所有特征压缩到一个Treatment倾向上。

如何建立倾向模型

-

首先,选定一些变量作为特征(比如吃的食物种类,睡眠时间,居住地点等)

-

根据这些变量建立一个概率模型(即逻辑斯特回归)预测人们是否会喝Soylent。比如说,我们的训练集由一群人组成,其中有一部分人在2014年3月的第一周订购了Soylent,我们会训练一个分类器来对哪些人会喝Soylent进行建模。

-

该模型将用户开始饮用Soylent的概率估计称为“倾向得分”

-

形成一定数量的“桶”,比如总计有十个等级(第一个桶代表喝饮料的倾向是0.0-0.1,第二个桶是0.1-0.2,以此类推),将所有的实验数据放入对应的“桶”中。

-

最后,比较每个桶中喝饮料与不喝饮料的样本数据(比如测量他们随后的身体素质、体重或者任何其他健康指标)来估计Soylent的因果效应。

选择了适合您的模型后(在本文中,我们将重点介绍回归),构建模型包括三个步骤:

a. 选择您的倾向模型的特征

首先,您需要为倾向模型选择功能。例如,您可以考虑:

- 产品里程碑;

- 应用和主题下载;

- 人口统计资料;

- 设备使用情况;

- 购买历史;

- 计划选择。

您的想象力是唯一的极限。

当您仅对预测感兴趣时,选择功能会更容易。您可以只添加您知道的所有功能。特征的相关性越差,系数就越接近0。如果您想了解该预测的因素,则变得更加困难。

假设在训练模型时,您在历史数据的50%上对其进行训练,并在剩余的50%上对其进行测试。换句话说,您可以在测试组中的模型中隐藏要预测的变量,并尝试使模型预测值—这样一来,您便可以了解如何对已经具有实际值的事物进行预测。

b.建立您的倾向模型;

在回归分析中,回归方程中的系数是实际总体参数的估计值。我们希望这些系数估算值是最好的估算值.

假设您要求一个估算,例如您正在考虑的服务成本。您将如何定义一个合理的估计?

- 估算应该趋于正确。它们不应系统地过高或过低。换句话说,它们应该平均无偏或正确。

- 认识到估计几乎永远不会完全正确,因此您希望将估计值与实际值之间的差异最小化。大的差异是不好的.

- 在线性回归中,结果是连续的,这意味着它可以具有无限数量的潜在值。它非常适合体重,小时数等。在逻辑回归中,结果的潜在值数量有限。是/否,1st / 2nd / 3rd等的理想选择。

c 计算您的倾向得分:

因变量为是否被干预Treatment,自变量为用户特征变量。套用LR或者其他更复杂的模型,如LR + LightGBM等模型估算倾向性得分。

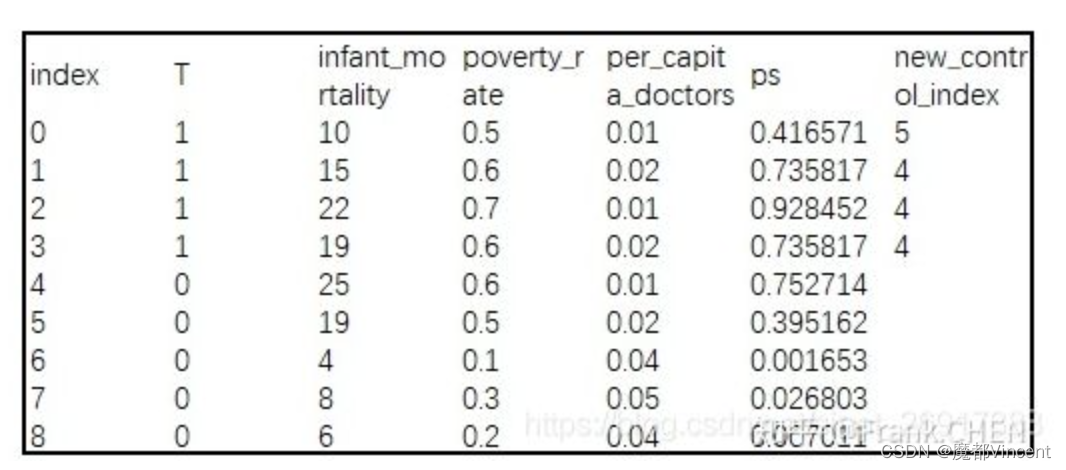

对比对照组和实验组项目实施前和项目实施后的新生儿死亡率,进行Difference in Difference 的研究,目前我们假设,并没有历史的新生儿死亡率数据 数据样式:

这里把treatment-T(有没有诊所),Outcome - Y(infant mortality 死亡率),都标明了;两个混杂变量,poverty rate 贫穷率 和 per capita doctors 人均医生数。

目标:为每一个实验组的村庄创建/找到新的对照组: 针对每一个实验组的村庄,找到其特征类似的对照组。

不是Y ~ f(T,X),而是T~f(Y,X)

那么最终出来的结果就是,每个村庄有诊所的可能性。

构建倾向性模型后,在计算倾向性分数之前,先使用数据集对其进行训练。如何训练倾向模型和计算倾向分数取决于您选择线性回归还是逻辑回归。

在线性回归模型中,它将字面上的系数乘以值,然后得到一个连续的数。因此,如果您的公式是customer_value = 0.323(每月会话数),其中0.323是每月会话数的系数,则它将您当月的会话数乘以0.323。

对于逻辑回归,预测值将为您提供对数奇数,并且计算可以将其转换为概率。这个概率就是我们所说的“分数”。

倾向模型必须与您的实际数据配合使用,这一点很重要。这是倾向建模和实验如何相辅相成的完美示例。实验可以验证倾向得分的准确性。

无论您对准确性有多自信,都可以进行实验。可能有您尚未考虑的因素。或者,例如,该模型可能会意外地针对数量(例如,会话到潜在顾客的转化率)进行优化,而不考虑对质量的影响(例如,潜在顾客到客户的转化率,保留率等)

使用实验来验证倾向模型至关重要。它使您高枕无忧。

同样,倾向建模是优化器可以使用的工具,而不是完全了解实验和优化的工具。充分利用开放式回归的优势–深入了解并确保正在查看的数据在变得疯狂之前是有意义的。

d.?倾向得分Matching

匹配的概念就简单了。即对于实验组的每一个样本,在对照组找到与之匹配(即二者相似)的一个样本,组成一个样本对,最后基于所有的样本对进行建模,以达到控制混淆的目的。这里的匹配方法如果用的是倾向性得分PS,那就是PSM的概念了。

计算出Propensity Score后,在对照组中需要寻找到与实验组行为(贫穷率、人均医生数)相似的村庄,此过程被称为Matching。 在这里我们采取最简单的临近匹配法,对每一个实验组村庄进行遍历,找到ps值最接近的对照组村庄作为新对照组集合中的元素,即为new_control_index。

因为我们需要为有诊所的村庄(T = 1) 一一对应找无诊所(T=0)村庄 所以,以index=0的实验组村庄为例(ps=0.416571),在健康诊所项目启动前,与其贫穷率、人均医生数最为接近的对照组成员为index=5村庄(ps=0.395162)。

这里的计算方式就是非常简单的:ps(index=5) - ps(index = 1)是最小

?到此为止,每个实验组村庄都找到了其新的对照组归宿~

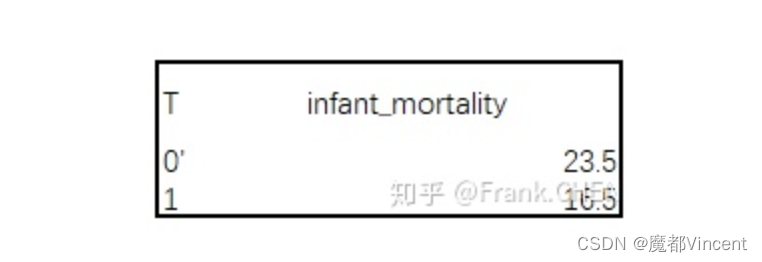

实验组 VS 新对照组 评估建立健康诊所对新生儿死亡率的影响

新对照组村庄(未建立健康诊所)新生儿死亡率比实验组村庄(建立健康诊所)足足高出7%,从而证明这个NGO组织的健康诊所项目对新生儿死亡率的降低有显著作用。

如何使用倾向模型进行更智能的实验

在回归模型中,您不能假定要素与尝试预测的变量具有因果关系。

可以轻松查看模型,例如,可以看到在试用期间下载X应用程序可以很好地表明潜在客户会转化为客户。但是,绝对没有证据表明在试用期间增加更多的应用下载量将使任何人更有可能转化为客户。

不要用倾向得分代替(非常有价值的)优化知识。倾向建模与其他工具一样,不会告诉您如何进行优化,您可以使用自己的经验,知识和直觉来挖掘这些见解。

例如,您可能知道,由于您的倾向模型,客户很可能流失。但是,您花费在防止客户流失上的价值是否高于该客户的生命周期价值?您的模型无法回答这个问题,它不能代替批判性思维。

当我们轻轻地跨过所有注意事项时,让我们看一下优化器可以利用的三个有价值的倾向模型:

- 购买或转换的倾向。访客,潜在顾客和客户进行购买或转换到渠道下一步的可能性有多大?倾向得分较低的人比其他人需要更多的动机(例如,如果您是电子商务商店,则可以提供更高的折扣)。

- 退订的倾向。收件人,潜在客户和客户退订您的电子邮件列表的可能性有多大?对于倾向得分较高的用户,您可以尝试减少电子邮件的发送频率或发送特别优惠以增强保留订户的价值。

- 易流失。谁是您的潜在客户和潜在客户?如果他们的倾向得分较高,则可以尝试进行产品内赢回广告系列,或分配客户专职人员,使其与您的核心价值主张重新建立联系。

倾向建模不是规定性的。知道一组线索具有更高的单独转换倾向并不是特别有价值。有价值的是将这些知识与优化知识相结合,以运行更智能,更有针对性的实验并提取可传递的见解。

未来不是一门精确的科学。(可以说,精确科学不是精确科学。)但是,您可以通过倾向建模以合理的确定性程度预测未来。您所需要的只是一个严格的流程和一位数据科学家。

这是逐步的过程:

- 与一组领域专家一起选择功能。仔细考虑您是否要解释系数。

- 选择线性或逻辑回归后,构建模型。

- 使用数据集训练模型并计算您的倾向得分。

- 使用实验来验证您的倾向得分的准确性。

- 将倾向性建模与您的优化专业知识相结合,以运行更智能,更有针对性的实验,从而获得更有价值,更可移植的见解。

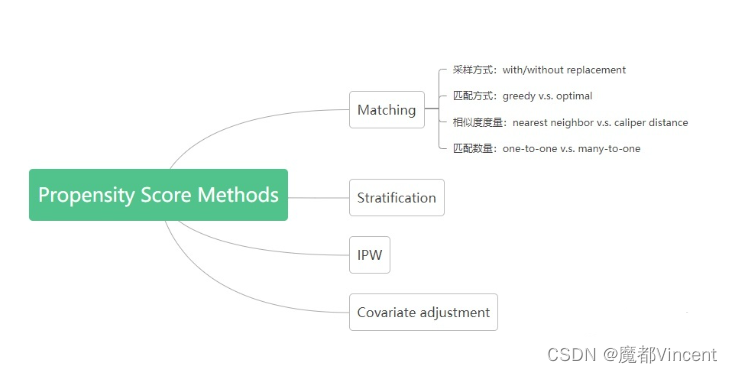

四 Propensity Score Methods(倾向得分方法)

想研究‘读研究生’对于收入的影响。一种简单的做法是直接对比‘读过’和‘没有读过’这两类群体的收入差异,但这种做法并不科学。因为还可能存在其他变量影响着研究结果,如性别,年龄,父母学历,父母是否做教育工作等因素都会干扰到研究。

因此,PSM正是为了减少这种干扰。PSM可实现找到类似的两类人,他们的基本特征都基本一致,主要区别在于‘是否读过’研究生。这样可减少干扰因素差异带来的数据偏差和混杂干扰。

倾向得分匹配的实现步骤其实就如其名称中提到的,主要有两步:倾向得分的计算,以及基于倾向得分的匹配。

目前主要的4种propensity score方法包括:Matching,Stratification,IPW,covariate adjustment。在各种方法中,具体的实现上又有一定的区别。

1 倾向得分预测

预测用户被干预的概率,其实就是一个常见的二分类问题,常见的机器学习模型都可以在这里使用。

特征选择

需要注意的是在特征选择上,具体需要哪些特征呢?有两个基本的原则是需要遵守的:

- 同时影响干预分配和结果的变量应该被包括(使CIA成立)

- 被干预项影响的变量应该排除(变量需要在干预项前计算)

而至于特征的量级,不同的文献中有不同的说法:

?为方便起见,通常在实际应用中我们会选取尽量多的特征,同时也会用到一些机器学习中常规的特征筛选方法。

重要特征

当我们已知一些特征十分重要(对干预、结果)时,我们可能通过一些方式加强这些特征对匹配的影响:

- 在匹配时在该特征上两组一致,如男性只跟男性匹配

- 在子人群中做匹配(男性、女性分别做匹配)

换句话说:就是在重要特征上做完全匹配,再辅助倾向分匹配(当预期在不同分组上会有不同的ATT时尤其推荐这么做)。

2 Propensity Score Matching

当不使用propensity score时,可以直接基于协变量进行匹配,直接计算两个样本协变量之间的马氏距离,这种方式通常称为CVM(Coviate Matching)。

完成倾向分模型及预测后,每个样本会得到一个propensity score,此时便可以进行匹配步骤了:为每个被干预的样本匹配一个(或多个)虚拟的对照样本。

matching 也无法解决隐形的遗漏变量问题(或内生性问题)。

Matching 是一个有争议的方法,我认识很多老师他们对PSM 包括其它传统的matching是有看法的,觉得有点鸡肋, 原因一是任何matching都是基于一套weighting 规则, 怎么证明这套weighting 规则就比你直接加控制变量进去好? 原因二是有时候用了matching 也构建不出一个很好的对照组,规则严了找不到好的common support,规则松了对照组和不matching 前也差不了多少。

匹配的基础思路很简单,即找到一个距离最近的样本,实现的具体方法按照渐进的顺序阐述如下:

Matching的过程

- 训练propensity score model,得到所有样本的score

- 遍历实验组中的每个样本,在对照组中寻找score最接近的样本,构成pair对

- 重复第二步直到实验组样本全部遍历完

Matching方法的整体思路相对简单,但实际实现中在细节上有所不同,也就出现了matching的很多变种。

(1)采样手段:without replacement v.s. with replacement

即在matching过程中,我们对于untreated样本是否允许重复采样。在with replacement模式下,同一个untreated样本可能会出现在多个pair对中,即我们构造的数据中存在大量重复样本,此时需要考虑方差估计的问题(是否会出现过拟合);在without replacement模式下,untreated样本一旦被某个treated样本匹配后便不再使用。

?实现上,会有有放回和无放回两种实现方式:

- 有放回(对照组样本可重复使用):此时整体匹配质量上升,bias下降,当干预组与对照组倾向分分布差异较大时推荐应用。此时使用的对照组样本数会减少,导致variance上升。

- 无放回:此时匹配结果与匹配顺序有关,顺序需要保证随机

除了是否放回之外,还有一个可调整的地方在于对单个用户是否可匹配多个样本(over-sampling):通过匹配最近的多个邻居降低了variance,提升了匹配的稳定性。但此时需要给每个邻居赋予权重(eg. 按距离衰减)。

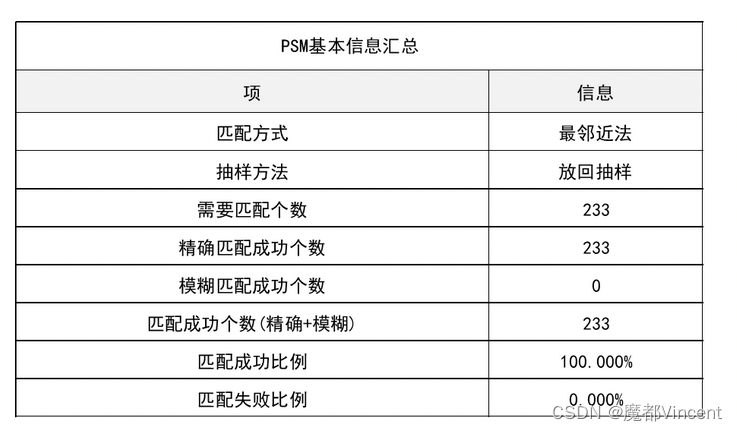

从上表可知:本次PSM分析使用最邻近匹配方式,并且精确匹配优先的算法,且使用放回抽样方法。总共待匹配项(‘读过研究生’的样本数量)为233个,全部都实现精确匹配成功,匹配成功率为100%。

(2)匹配方式:greedy v.s. optimal

greedy matching时,treated样本是随机选择的,然后从untreated中选择与当前treated样本score相似的样本;停止条件是untreated样本与所有的treated样本构成了pair对,或者穷尽完了所有可以匹配到untreated样本的treated样本。之所以这个方法称为greedy,是因为在每一次给treated样本匹配untreated样本时,都选择当前score最接近的样本(尽管这个untreated可能和后续某个treated样本更合适),因此这样的步骤是贪心的。

对于optimal matching,其形成pair的过程是minimize the total within-pair difference of propensity score,即全局优化。但是这两者在生成balanced matched samples上效果基本相当。

(3)相似度度量:Nearest Neighbor v.s Caliper distance

在上述matching过程中,如何衡量untreated和treated之间的相似度呢?

有两种主要的方法:

- Nearest Neighbor Matching 对干预组中的用户,选取对照组中在倾向分上相差最小的用户做匹配。

- Caliper and Radius Matching 有边界限制的半径匹配

前者就是在选择score与当前treated样本最接近的untreated样本,当有多个同距离的untreated样本时,随机选择一个即可。但是这种方法并没有对最大可接受的距离做限制,因此无法保证选出的untreated样本就是好的。

后者相比于前者就是增加了一个caliper distance的限制,即对于给定的treated样本,先圈定这个样本的caliper distance范围,接着在这个范围中去寻找score最近的untreated样本,如果没有的话,当前treated样本就被丢弃。可以看到caliper distance的方法更注重样本的质量。

当最近的邻居也相距很远的时候,Nearest Neighbor 匹配会存在低质匹配的风险。很自然的,我们想到可以限定样本间分数差值的上限,即caliper。

- Caliper Matching:匹配时引入倾向分差值的忍受度,高于忍受度的样本丢弃。理论上通过避免低质量匹配降低了bias,但在样本数量较少时也可能因为匹配过少而升高了variance

- Radius Matching:不止匹配caliper中的最近样本,使用caliper中的所有样本进行匹配。这种方法的优势在于,当有高质量匹配时使用了更多的样本、而当缺乏高质量匹配时则使用较少的样本

对于caliper width(即我们最多能接大能接受的距离范围)的设定目前还没有统一的标准。有一种方法是选择和logit of propensity score的标准差成比例的caliper distance(有理论证明logit of propensity score大概率是服从正态分布的)。假设treated和untreated样本中的propensity score同方差,使用总体样本的标准差*0.2作为caliper width可以减少confounders带来的bias。

(4)匹配数量:one-to-one v.s. many-to-one

Matching中最基本的方式就是one-to-one,即一个treated样本对应一个untreated样本。

除此之外还有many-to-one maching,即m个untreated样本与1个treated样本匹配,对于不同的treated样本,m也是可变的;相比于固定的m,动态的m值可以带来bias reduction。

Full matching指一个treated和至少一个untreated,或者一个untreated和至少一个treated样本。

3 Stratification and Interval on the Propensity Score

分层匹配可以看作radius matching的一种相似版本,即将倾向得分分成多个区间,在每个区间内进行匹配。需要注意的是,分层的依据除了propensity score,也可以用一些我们认为重要的特征(如性别、地区),在相同特征的用户间进行匹配。

根据样本的propensity score进行分层。先对样本的propensity score进行排序,然后对样本分桶。常见的一种做法是等频分成5个桶。当然,随着分桶数的增多,桶内样本的相似度会增大,桶间样本的相似度会减少,可以带来进一步bias reduction的收益。在每个分层下,treated和untreated样本的propensity score是相似的,进而可以近似进行ATE的估计。

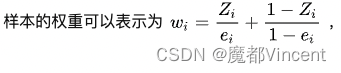

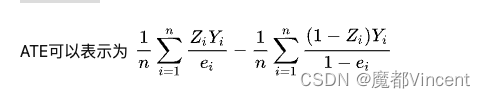

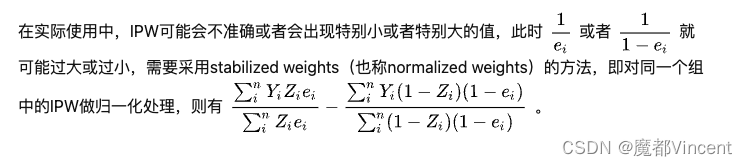

4 Inverse Probability of Treatment Weighting Using the Propensity Score

IPTW(简称IPW)是使用propensity score来对样本进行加权从而生成同分布的synthetic sample。这种方法最早是由Rosenbaum在1987年提出的。

5 Covariate Adjustment Using the Propensity Score

Covariate adjustment方法是这四种方法中唯一一个需要额外建模的方法。它本质上是做了一个线性回归(outcome是binary时候使用逻辑回归),模型的X是treatment status+propensity score,Y是outcome。此时treatment的效应就是由回归的系数所决定。

五 匹配质量检验与匹配增量计算

鉴于我们基于倾向分做匹配,完成后需要检测其他特征在实验组与对照组之间的分布是否相近。

1.可量化的指标——标准化偏差 Standardized Bias?

通过标准化偏差我们可以衡量 X 在实验组与对照组分布的差异大小,通常我们认为低于5%的偏差是可以接受的(当然越小越好)

其中 V1m 代表匹配后实验组特征X的方差。?

我们也可以在匹配前后分别计算该值,去看看通过匹配让Standardized Bias减少了多少。

2. 对样本均值的假设检验——T检验

我们也可以通过双侧T检验去判断两组的变量均值 X 是否有显著差异。缺点是匹配前后偏差的减少量无法很直观的感受到。进一步的,我们也可以基于倾向分先做一个分层,再进行T-Test。这样可以看到不同分值下匹配的质量。

3. 联合显著性/伪 R2

另一种思路是我们把特征 X 当作自变量,是否干预当作因变量,计算判定系数R2.在完成匹配后,两组间的协变量 X 应该不存在系统性差异(即无法通过X预测用户是否受到干预),从而R2 应该很低。类似的,可以对所有变量做一个联合F-Test,匹配有效的话,匹配后会拒绝假设(即解释变量对被解释变量的共同影响不显著)

除此之外,我们还可以通过QQplot的可视化、计算匹配后两组方差的比值、计算匹配前后倾向分偏差减小量等方式衡量匹配质量。但总体来说还是推荐前两种方式——计算SB和T检验,它们兼具了可解释性和可量化性。假如匹配的质量达不到要求,那么我们就要回到上一步对匹配算法进行调整。

4.? 匹配结果示例

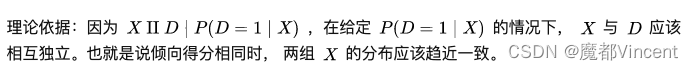

匹配之后,常见的趋势会如下图一所示:

- 在干预之前,匹配后的实验组和对照组呈现几乎相同或平行的趋势(匹配质量较好的情况下)

- 在干预后,两组用户在目标指标上会开始出现差异,可以认为是干预带来的影响

?

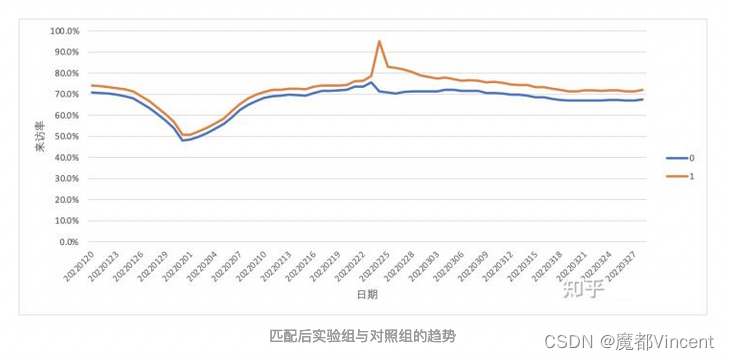

5 增量计算

因为满足平行趋势假设,我们可以用双重差分法(DID)去计算干预带来的增量;需注意的是,计算实验组与对照组的差异时,我们通常需要取一段时间的均值,避免波动带来的影响。

最终得到的结论类似于:用户在购买商品后,能够给来访率带来1.5%(30天日均)的提升。

6 其他情况

在一些情况下,也会有其他结果的出现。

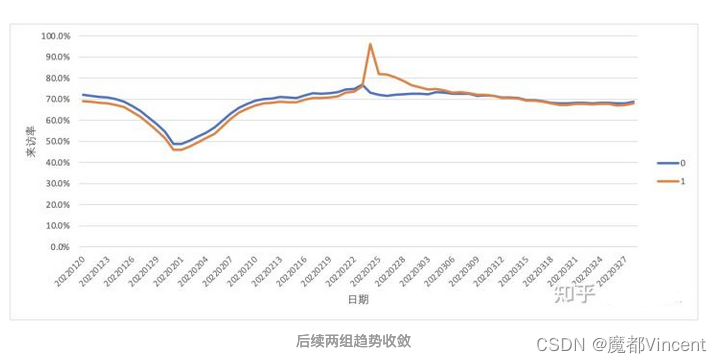

a. 无显著增量

用户在干预之后来访率有一个短暂的提升,但随着时间的推移两组用户趋于一致。这种情况下我们通常认为干预并没有给用户来访带来显著的提升。为了识别出这种情况,我们也可以通过假设检验或计算差值中位数的方式进行验证。

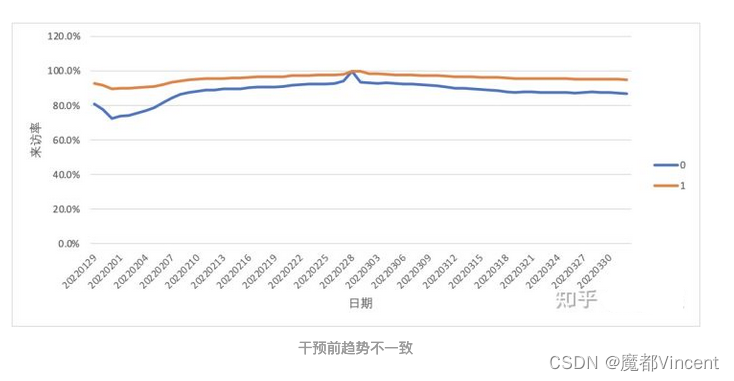

b 不满足平行趋势假设

从下图可以看到,左侧区域实验组与对照组的趋势不一致(不平行),这代表我们前面完成的匹配质量较差,需要优化匹配模型。对于平行趋势的检验,除了图示法(肉眼看是否平行)我们也可以通过T检验的方式来验证。

六 其他相关

1 PSM存在的问题

PSM+DID的方式会存在以下两个问题:

- 局部性:因为PSM是针对common support的部分进行计算,所以通过DID计算的增量其实是一个局部的增量,可能不具有代表性;

- 混淆因子:理想情况下, X 应该包含所有同时影响treatment和outcome的特征。但实际上我们无法严格论证说我们已经把所有影响到的因子都包含进特征里了。

2 ATT与ATE的区别

- ATE:average treatment effect

- ATT:average treatment effect on the treated

可以认为ATE是人群整体的干预增量效果,而ATT是实际被干预人群的干预增量效果。通常我们通过PSM+DID计算的是ATT,因为ATE还会涉及人群的干预率。更详细的解释可以参考stackexchange上的这个回答:

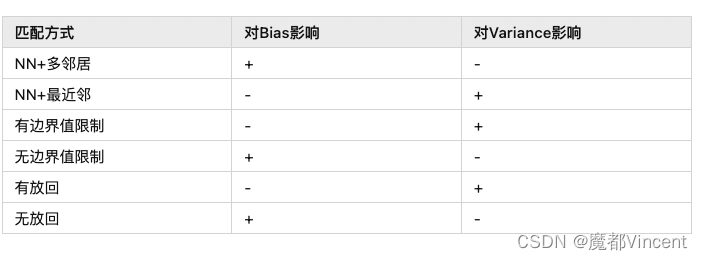

3 Bias与Variance的Trade-offs

在匹配算法的步骤,我们有提到bias与variance:

- Bias 偏差:期望预测与真实结果之间的偏离程度,刻画算法本身的拟合能力

- Variance 方差:同样大小训练集的变动所导致的学习性能变化,刻画数据扰动所造成的影响

可以认为bias代表算法本身的拟合能力而variance代表算法的稳定性,在匹配的不同方法中它们也存在trade-offs:

4 敏感性测试 Sensitivity Analysis

在前置知识介绍的部分有提到,做PSM需要满足两个假设——条件独立和共支撑。

对于第一个条件,其含义便是我们需要观测到所有同时影响到treatment和outcome的特征,否则估算的ATT会存在偏差。对于common support,我们实际上计算的是倾向得分重叠区域的ATT,其实际上也可能是有偏的。在这种情况下,我们需要去进行sensitivity analysis。换句话说,我们计算得到的增量结果其实是不稳健的,我们可以通过纳入不确定性的估计来估算一个ATT的区间,使之稳定性得到提升。

总结

在文章的最后,我们对PSM的整体流程进行一个梳理(可以看到真的不复杂),同时对PSM的优点与缺点进行简单的介绍。

1 完整流程

- 选择同时影响treatment与outcome的特征,基于特征对treatment进行二分类建模,得到倾向分;

- 在支撑集上,基于重要特征与倾向分进行匹配,为被干预用户找到匹配的样本;

- 对匹配结果的质量进行检验,检验通过的话进入下一步,否则返回第二步进行匹配的优化;

- 基于匹配的结果进行平行趋势验证,验证通过后通过双重差分法进行增量计算。

2 PSM的优缺点

优点

- 在无法进行随机试验的情况下,可构建虚拟的对照组并对增量进行可信的估算;

- 实现较为容易,实验组的样本能够充分的利用。

缺点

- PSM最主要的一个缺点是——使用者永远无法保证所有的混淆变量都被包含在建模用的特征当中;

- 但可通过敏感性分析校验:如增减混淆变量后重复完成计算步骤观测结果是否一致,或通过纳入不确定性对估算增量的区间值

- 当支撑集(实验、对照组的倾向分交集)较小时,PSM+DID估计的局部样本的增量,可能无法代表整体。

整体来说,若不过分追求准确性,PSM+DID是一个对因果增量预估的较为靠谱的方式。当实现过程中存在卡点或假设无法满足时,除了优化模型还可以尝试看看逆概率加权和合成控制法等其他方法。

参考文章:

倾向得分匹配(PSM)的原理以及实现 - 知乎

倾向性预测模型:基于数据,机器学习和专业知识的客户行为预测模型_子清-商业新知

一文读懂因果推测、倾向模型(结合实例)

【因果推断/uplift建模】Propensity Score Matching(PSM) - 知乎 (zhihu.com)

Propensity Score Methods总结 - 知乎 (zhihu.com)