作者: 19届 lz

论文:《Rogue Signs: Deceiving Traffic Sign Recognition with Malicious Ads and Logos》

问题

对虚拟系统的攻击并不能直接转化为现实世界。这是因为为生成虚拟对抗样本而解决的优化问题没有考虑到变化的物理条件,这些物理条件可能包括亮度、方向和距离变化、相机伪影、阴影、反射和图像大小调整造成的细节损失。

贡献:

1)我们提出了一种新的现实世界对交通标志识别系统的攻击:标志嵌入攻击修改了无害的标志,使其被归类为交通标志。我们的攻击管道创建了对抗性示例,即使在现实环境中也很有效。

2)我们提出并检查了一个端到端的管道,用于创建能够欺骗标志识别系统的对抗样本,并且对图像捕获阶段可能发生的图像噪声转换具有弹性。

3) 我们对各种参数集的物理和虚拟设置的攻击进行了广泛的评估。在虚拟环境中,我们的攻击在测试时没有随机图像变换的成功率为 99.07%,而使用随机图像变换的成功率为 95.50%。

相关工作

威胁模型: 我们考虑了常用的白盒威胁模型,用于生成针对深度神经网络的对抗性示例。 在白盒设置中,我们假设对手可以完全访问交通标志识别模型,包括其架构和权重。 此外,我们专注于创建有针对性的对抗样本,因为这些样本与旨在错误分类交通标志的对手更相关。

虚拟对抗样本: 为了从分类器 f 的良性样本 x 开始生成有针对性的对抗样本 x,以下为最新的导致成功的最优化问题:

f(·,·)是分类器的损失函数,

d是适当的距离度量,

T是目标类,

C是对输入空间的约束。

交通标志检测和分类: 我们的交通标志识别管道包括两个阶段:检测和分类。我们利用基于霍夫变换的常用识别管道。基于形状的检测器使用圆形 Hough 变换来识别视频帧中包含圆形交通标志的区域。在使用霍夫变换之前,我们使用高斯滤波器平滑视频帧,然后使用 Canny 边缘检测仅提取边缘。三角形符号可以通过中描述的类似方法检测。检测到的图像块被裁剪并传递给神经网络分类器,以确定它是否是交通标志并分配其标签。以低置信度得分分类的图像被丢弃作为检测的误报。

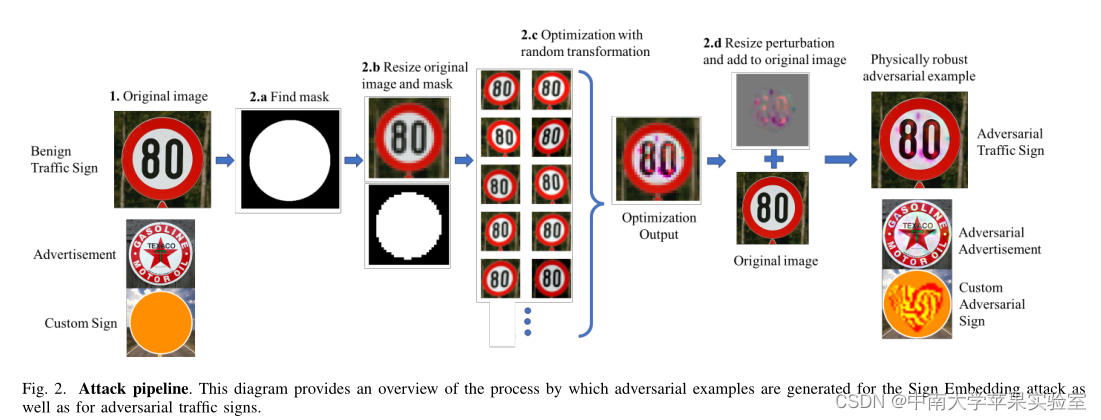

攻击管道:我们的管道包含三个步骤:

步骤 1. 获取原始图像 x 并选择对抗样本 ~x 应归为的目标类 T。

步骤 2. 生成物理上稳健的对抗性示例的数字版本,如下所示:

- 为原始图像生成掩码 M(需要一个掩码以确保在向背景添加扰动时不会利用对手的扰动预算。)

- 将原始图像和掩码都调整为目标的输入大小分类器(在我们的例子中为 32 × 32 像素)。

- 运行方程 2 的优化以获得扰动 δ。

- 重新调整输出扰动 δ 的大小并将其添加到原始图像中。

步骤 3. 测试并打印生成的对抗性标志。

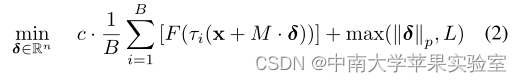

优化问题: 对抗性示例生成方法涉及使用 Adam 优化器启发式地解决非凸优化问题。稳健的对抗性示例可以写成下面给出的任何输入 x 的最小化问题的解决方案:

*F(x)=max(maxj≠T{Z(x)j}?Z(x)t,?K)是 Carlini-Wagner 的 L2 攻击的目标函数,

L2是Z(x)j目标网络的第一个 logit(softmax 之前的层)。

τi : Rn → Rn 是图像空间(n = 32 × 32 × 3)内的变换函数映射。

M 是mask或具有与输入图像相同宽度和高度的 0 和 1 的矩阵,

M · δ 是mask和将可行区域约束到符号区域的扰动的元素乘积。

目标值受到扰动 δ 的 pnorm 的惩罚,以保持对抗性扰动不被人类察觉,并相应地调整常数 c 以平衡真实目标函数和惩罚项。

常数 K 决定了期望的目标值,因此控制了对抗样本的置信度得分。

作者引入了一个额外的常数 L 来明确鼓励扰动的范数至少为 L,因为在打印和视频捕获过程中,过小的扰动可能会消失。

论文实验了两种攻击方式

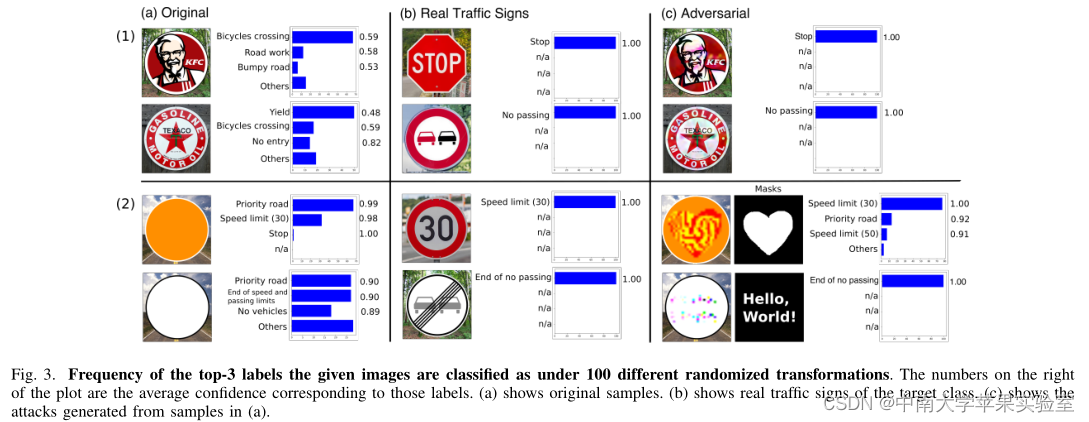

标志攻击: 在这种攻击中,对常见标志的图像进行修改,以便以高可信度将它们检测并分类为交通标志(图 3(1.a)和(1.c))。由于这些徽标无处不在,它们允许对手在各种环境中进行攻击。

自定义标志攻击: 在这种攻击中,攻击者创建了一个从空白标志开始的对抗性自定义标志(图 3(2.a)和(2.c))。这允许对手在几乎任何可以想象的环境中创建对抗性标志,方法是使用掩码创建适合周围环境的图像或文本。通过将 c 和 L 设置为一些较大的数字,也可以通过相同的优化问题执行这种攻击,以便优化将集中在最小化损失而不惩罚扰动范数。

实验结果

拟环境中的评估:使用所提出的方法,我们在从 GTSRB 的测试数据中选择的 1000 个交通标志的随机子集上评估我们的对抗性标志以及由 Carlini-Wagner (CW) 方法生成的对抗性标志。我们的攻击实现了 99.07% 的攻击成功率,而 CW 攻击的攻击成功率为 96.38%。此外,与 CW 攻击的 89.75% 相比,我们的攻击具有 3.6% 的劣化率要低得多。劣化率是在对它们应用随机图像变换后不再具有对抗性的对抗性示例的一部分。