以下是对PIFU文章的翻译与理解?

[1] Saito S , ?Huang Z , ?Natsume R , et al. PIFu: Pixel-Aligned Implicit Function for High-Resolution Clothed Human Digitization[J]. arXiv e-prints, 2019.

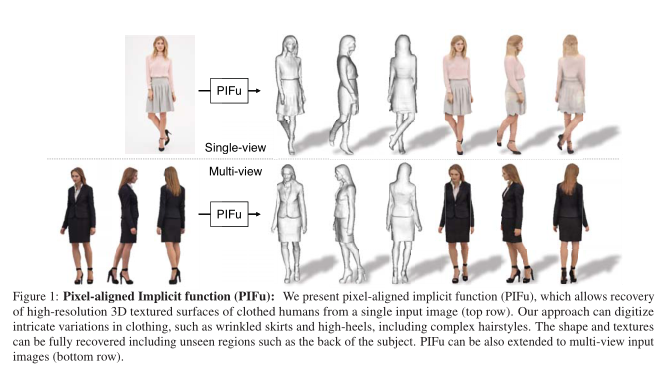

PIFU是首个提出一种新的像素对齐隐式函数 (PIFu) 表示,用于 3D 深度学习,以解决从单个或多个输入图像中对穿着衣服的 3D 人体进行纹理表面推断的挑战性问题。

基于隐函数[10,41,35]的方法依赖于图像的全局上下文来推断整体形状,这可能无法准确地与输入图像对齐。另一方面,PIFu 以完全卷积的方式将像素级别的单个局部特征与整个对象的全局上下文对齐,并且不需要像基于体素的表示那样占用大量内存。

具体来说,我们训练编码器来学习图像的每个像素的单个特征向量,并考虑相对于其位置的全局上下文。给定每个像素的特征向量和沿从该像素传出的相机光线的指定 z 深度,我们学习了一个隐式函数,该函数可以分类对应于该 z 深度的 3D 点是在表面内部还是外部。特别是,我们的特征向量在空间上将全局 3D 表面形状与像素对齐,这使我们能够保留输入图像中存在的局部细节,同时在看不见的区域中推断出合理的细节。

我们的端到端和统一的数字化方法可以直接预测具有复杂发型和穿着任意服装的人的高分辨率 3D 形状。尽管有很多看不见的区域,特别是对于单视图输入,我们的方法可以生成一个完整的模型,类似于从多视图立体摄影测量或其他 3D 扫描技术获得的模型。如图 1 所示,我们的算法可以处理各种复杂的服装,例如裙子、围巾,甚至高跟鞋,同时在像素级别捕获与输入图像匹配的皱纹等高频细节。

通过简单地采用隐式函数对沿射线的每个查询点的 RGB 值进行回归,PIFu 可以自然地扩展到推断每个顶点的颜色。因此,我们的数字化框架还生成了完整的表面纹理,同时预测了看不见的区域中看似合理的外观细节。通过额外的多视图立体约束,PIFu 也可以自然地扩展到处理多个输入图像,这通常是实际人体捕捉设置所需要的。由于已经可以从单个输入图像生成完整的纹理网格,因此添加更多视图只会通过为看不见的区域提供额外信息来进一步改善我们的结果。

我们展示了我们的方法在各种具有挑战性的现实世界和无约束的穿着主题图像上的有效性和准确性。我们还首次展示了从视频序列重建的动态穿着人体的单目和纹理 3D 重建的高分辨率示例。我们使用通过高端摄影测量获得的地面实况 3D 扫描数据集对我们的方法进行全面评估。我们将我们的方法与之前的工作进行了比较,并在公共基准上展示了最先进的性能,用于数字化穿着衣服的人。

2. Related Work

纹理推断。从单个图像重建 3D 模型时,可以轻松地从输入中采样纹理。然而,为了获得完整的纹理,需要推断遮挡区域的外观。与 3D 纹理推断问题相关的是视图合成方法,它可以从单个图像 [63、40] 或多个图像 [50] 中预测新的视图。在穿衣人体纹理网格推断的背景下,[36] 引入了一种视图合成技术,可以从前面预测后面的视图。然后前视图和后视图都用于纹理最终的 3D 网格,但是无法处理自遮挡区域和侧视图。类似于图像修复问题 [42],[37] 修复从检测到的表面点的输出中采样的 UV 图像,并且 [52, 20] 推断每个体素颜色,但输出分辨率非常有限。 [28] 直接预测 UV 参数化的 RGB 值,但他们的技术只能处理具有已知拓扑的形状,因此不适合服装推断。我们提出的方法可以以端到端的方式预测每个顶点的颜色,并且可以处理具有任意拓扑的表面。

3. PIFu: Pixel-Aligned Implicit Function

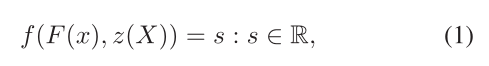

给定单视图或多视图图像,我们的目标是重建穿着衣服的人的下划线 3D 几何和纹理,同时保留图像中存在的细节。为此,我们引入了像素对齐隐式函数 (PIFu),它是一种用于 3D 表面的内存高效且空间对齐的 3D 表示。隐式函数将曲面定义为函数 f 的水平集,例如f(X) = 0 [46]。这导致不需要显式存储表面嵌入的空间的表面的内存有效表示。所提出的像素对齐隐函数由一个全卷积图像编码器 g 和一个由多层感知器 (MLP) 表示的连续隐函数 f 组成,其中表面定义为

?其中对于一个 3D 点 X,x = π(X) 是它的 2D 投影,z(X) 是相机坐标空间中的深度值,F(x) = g(I(x)) 是 x 处的图像特征。我们假设一个弱透视相机,但扩展到透视相机很简单。请注意,我们使用双线性采样获得像素对齐的特征 F (x),因为 X 的 2D 投影是在连续空间而不是离散空间(即像素)中定义的。

关键的是我们在 3D 空间上学习了一个具有像素对齐图像特征而不是全局特征的隐式函数,这允许学习的函数保留图像中存在的局部细节。 PIFu 的连续性允许我们以内存有效的方式生成具有任意拓扑的详细几何图形。此外,PIFu 可以作为一个通用框架,可以扩展到各种共域,例如 RGB 颜色。

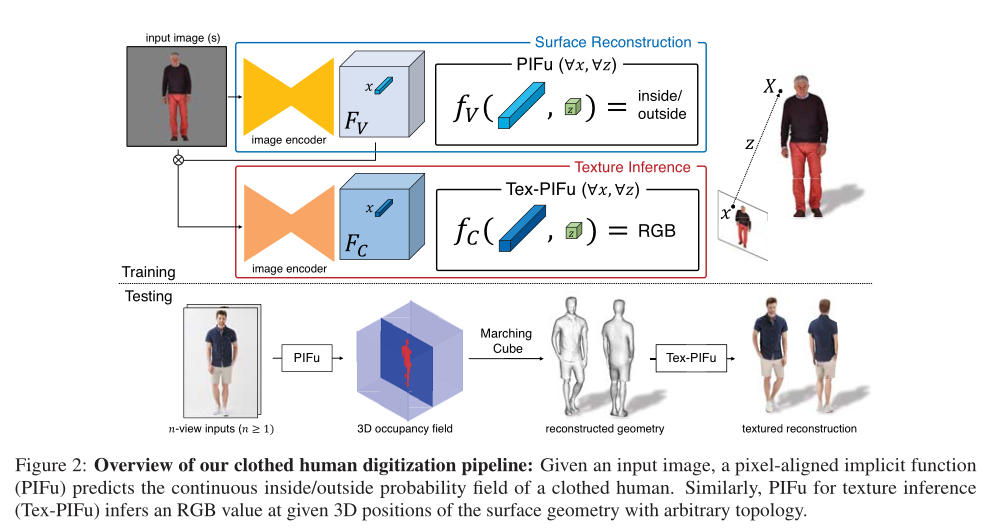

Digitization Pipeline.

图 2 说明了我们框架的概述。给定输入图像,用于表面重建的 PIFu 预测穿着衣服的人的连续内部/外部概率场,其中等值面可以很容易地提取(第 3.1 节)。类似地,用于纹理推断的 PIFu (Tex-PIFu) 在表面几何的 3D 位置输出 RGB 值,从而能够在自遮挡表面区域和任意拓扑形状中进行纹理推断(第 3.2 节)。此外,我们展示了所提出的方法可以自然地处理单视图和多视图输入,这使我们能够在更多视图可用时产生更高保真度的结果(第 3.3 节)。

3.1. Single-view Surface Reconstruction

对于表面重建,我们将真实表面表示为连续 3D 占用场的 0.5 水平集:

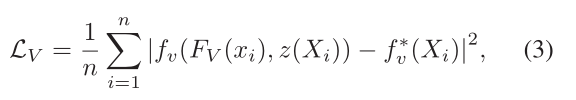

?我们通过最小化均方误差的平均值来训练像素对齐的隐函数 (PIFu) fv:

?其中 ?∈

,

(x) = g(I(x)) 是来自图像编码器 g 在 x = π(X) 处的图像特征,n 是采样点的数量。给定一对输入图像和与输入图像在空间上对齐的相应 3D 网格,图像编码器 g 和 PIFu

的参数通过最小化方程来联合更新。 3. 就像?Bansal 等人[6] 展示了语义分割,与使用所有像素进行训练相比,使用像素子集训练图像编码器不会损害收敛性。在推理过程中,我们在 3D 空间上对概率场进行密集采样,并使用 Marching Cube 算法 [33] 在阈值 0.5 处提取概率场的等值面。这种隐式表面表示适用于具有任意拓扑的详细对象。除了 PIFu 的表现力和记忆效率之外,我们还开发了一种空间采样策略,该策略对于实现高保真推理至关重要。

Spatial Sampling(空间采样).

训练数据的分辨率在实现隐函数的表达性和准确性方面起着核心作用。与基于体素的方法不同,我们的方法不需要对地面实况 3D 网格进行离散化。相反,我们可以使用有效的光线追踪算法 [56] 直接从原始分辨率的地面实况网格中动态采样 3D 点。请注意,此操作需要防水网格。在非防水网格的情况下,可以使用现成的解决方案来使网格防水 [7]。此外,我们观察到采样策略可以在很大程度上影响最终的重建质量。如果在 3D 空间中对点进行均匀采样,则大多数点都远离等值面,这将不必要地将网络加权到外部预测。另一方面,仅在等值面周围采样会导致过度拟合。因此,我们建议结合基于表面几何的均匀采样和自适应采样。我们首先在表面几何上随机采样点,并为 x、y 和 z 轴添加具有正态分布 N (0, σ) (在我们的实验中为 σ = 5.0 cm)的偏移量,以扰乱它们在表面周围的位置。我们使用 16:1 的比率将这些样本与边界框内的均匀采样点结合起来。我们在补充材料中提供了关于我们的采样策略的消融研究。

3.2. Texture Inference

虽然纹理推断通常在表面 [28, 19] 或视图空间 [36] 的 2D 参数化上执行,但 PIFu 使我们能够通过将公式(1)中的 s 定义为 RGB 矢量场而不是标量场来直接预测表面几何上的 RGB 颜色。这支持具有任意拓扑和自遮挡的形状的纹理。然而,将 PIFu 扩展到颜色预测是一项艰巨的任务,因为 RGB 颜色仅在表面上定义,而 3D 占用场在整个 3D 空间上定义。在这里,我们强调 PIFu 在训练过程和网络架构方面的修改。

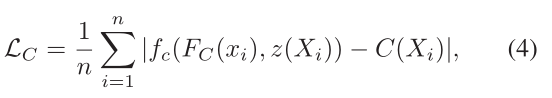

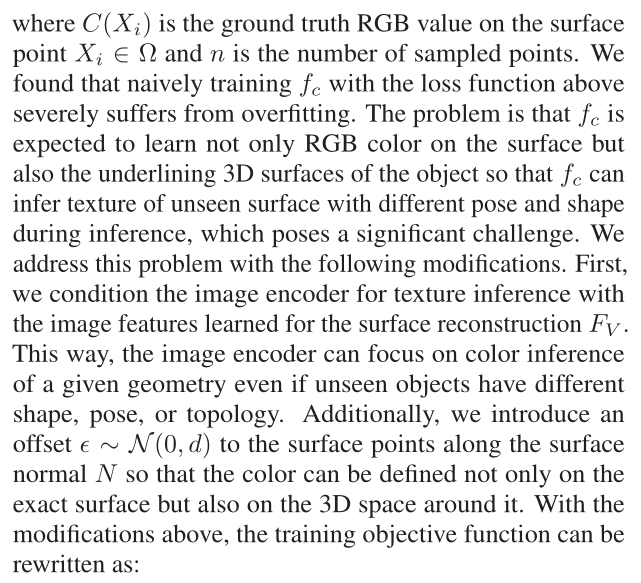

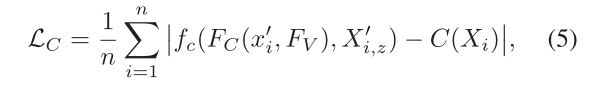

给定表面 X ∈ Ω 上的采样 3D 点,纹理推断的目标函数是采样颜色的 L1 误差的平均值,如下所示:

?其中 C(Xi) 是表面点 Xi ∈ Ω 上的地面实况 RGB 值,n 是采样点的数量。我们发现,用上述损失函数训练 fc 会严重受到过度拟合的影响。问题在于,fc 不仅要学习表面上的 RGB 颜色,还要学习物体的下划线 3D 表面,以便 fc 在推理过程中可以推断出具有不同姿势和形状的看不见表面的纹理,这带来了很大的挑战。我们通过以下修改解决了这个问题。首先,我们使用为表面重建 ?学习的图像特征来调节图像编码器的纹理推断。这样,即使看不见的物体具有不同的形状、姿势或拓扑,图像编码器也可以专注于给定几何图形的颜色推断。此外,我们沿曲面法线N向曲面点引入偏移

~N(0, d) ,因此不仅可以在精确的表面上定义颜色,而且可以在其周围的 3D 空间上定义颜色。通过上述修改,训练目标函数可以重写为:

?

?

?4. Experiments

我们在各种数据集上评估了我们提出的方法,包括RenderPeople[45]和BUFF[61],这两个数据集具有地面真实性测量,以及DeepFashion[31],其中包含各种复杂的服装。

Implementation Detail.

由于PIFu的框架不限于特定的网络结构,因此技术上可以使用任何完全卷积的神经网络作为图像编码器。对于曲面重建,我们发现堆叠沙漏结构在真实图像上有更好的泛化效果。用于纹理推断的图像编码器采用CycleGAN[64]的体系结构,由残差块[26]组成。隐式函数基于多层感知器,感知器的层与图像特征F(x)和深度z之间有跳跃连接,以有效传播深度信息。Tex-PIFu将FC(x)和用于曲面重建的图像特征FV(x)作为输入。对于多视图PIFu,我们只需将中间层输出作为特征嵌入,并应用平均池来聚合来自不同视图的嵌入。有关网络架构和训练程序的更多详细信息,请参阅补充资料。

4.1. Quantitative Results

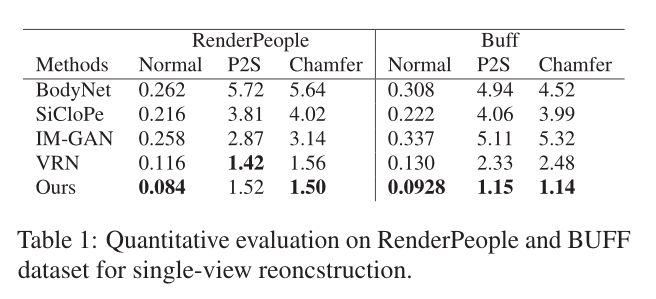

我们用三个指标来定量评估我们的重建精度。在模型空间中,我们测量从重建曲面上的顶点到地面真值曲面的点到曲面的平均欧氏距离(P2S),单位为cm。我们还测量了重建曲面和地面真值曲面之间的倒角距离。此外,我们引入了法线重投影误差来衡量重建局部细节的精细度,以及输入图像的投影一致性。对于重建曲面和地面真值曲面,我们分别从输入视点在图像空间中渲染它们的法线贴图。然后我们计算这两个法线映射之间的L2误差。

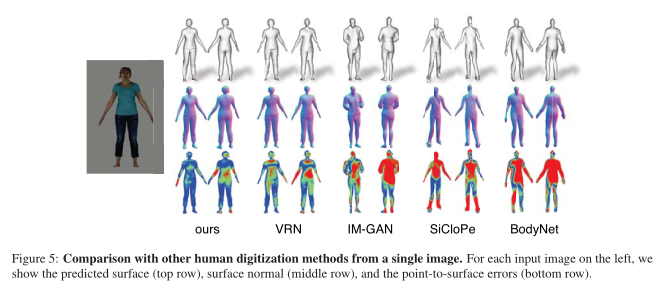

Single-View Reconstruction.

在表 1 和图 5 中,我们评估了 Buff 和 RenderPeople 测试集上每种方法的重建误差。请注意,虽然体素回归网络 (VRN) [24]、IM-GAN [10] 和我们的网络使用与我们的方法相同的高保真衣服人类数据集进行了重新训练,但 [36、53] 的重建来自他们训练有素的模型作为现成的解决方案。由于单视图输入使比例因子不明确,因此使用所有方法的已知比例因子进行评估。与使用隐式函数 (IM-GAN) [9] 从每个图像的一个全局特征重建表面的最先进的单视图重建方法相比,我们的方法输出像素对齐的高分辨率表面重建,该重建捕捉发型和衣服的褶皱。与体素相比,我们还展示了我们的 PIFu 表示的表现力。虽然 VRN 和我们的图像编码器共享相同的网络架构,但隐式表示的更高表达性使我们能够实现更高的保真度。

?

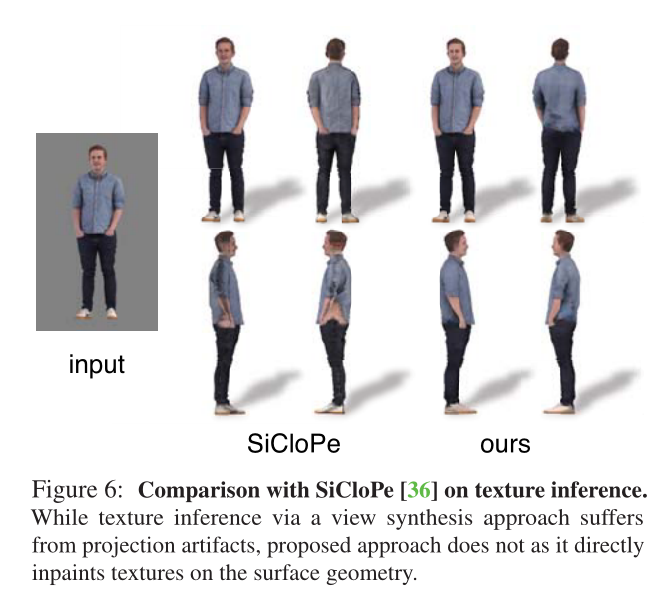

在图6中,我们还将我们的单视图纹理推断与穿着衣服的人的最先进的纹理推断方法SiCloPe[36]进行了比较,后者从后视图推断2D图像,并将其与输入的前视图图像缝合在一起,以获得纹理网格。SiCloPe在轮廓边界周围存在投影失真和瑕疵,但我们的方法直接预测曲面网格上的纹理,从而消除投影瑕疵。

4.2. Qualitative Results

在图4中,我们使用来自DeepFashion数据集的真实输入图像展示了数字化结果[31]。我们展示了我们的PIFu可以处理各种各样的衣服,包括裙子、夹克和连衣裙。我们的方法可以产生高分辨率的局部细节,同时在看不见的区域推断出合理的3D曲面。完整的纹理也可以从单个输入图像中成功推断出来,这使我们能够360度查看3D模型。我们参考补充视频2了解更多静态和动态结果。特别是,我们展示了如何从单个2D输入视频中在3D中数字化动态服装人体表演和复杂变形。

?5. Discussion

我们引入了一种新的像素对齐隐式函数,该函数将输入图像的像素级信息与3D对象的形状在空间上对齐,用于基于深度学习的3D形状和纹理推断。我们的实验表明,在保留图像中存在的高频细节的同时,可以推断出高度合理的几何图形,包括基本上看不见的区域,如人的背部。与基于体素的表示不同,我们的方法可以产生高分辨率的输出,因为我们不受体积表示的高内存要求的限制。此外,我们还演示了如何自然地扩展此方法,以推断给定部分观察的人的整个纹理。与现有的基于图像空间中正面视图合成背面区域的方法不同,我们的方法可以直接预测表面上看不见、凹面和侧面区域的颜色。特别是,我们的方法是第一种可以修复任意拓扑形状纹理的方法。由于我们能够从单个RGB摄像头生成衣服上的纹理3D表面,我们正在朝着从视频中单目重建动态场景的方向迈进一步,而无需模板模型。我们处理任意附加视图的能力也使我们的方法特别适用于使用稀疏视图的实用高效三维建模设置,而传统的多视图立体或运动结构将无法实现。

Future Work.

虽然我们的纹理预测是合理的,并且不受推断出的3D表面的拓扑或参数化的限制,但我们相信可以推断出更高分辨率的外观,可能使用生成性对抗网络或增加输入图像的分辨率。在这项工作中,重建在像素坐标空间中进行,将对象的比例作为预处理进行对齐。与其他单视图方法一样,推断比例因子仍然是一个悬而未决的问题,未来的工作可以解决这个问题。最后,在我们所有的例子中,没有一个分割的对象被任何其他对象或场景元素遮挡。在现实环境中,经常会发生遮挡,可能只有身体的一部分被相机框住。能够在部分可见的环境中数字化和预测完整的对象,对于在不受约束的环境中分析人类可能非常有价值。

这个文章很好