摘要:

在进入神经网络之前,一个token一般会转换成对应的onehot表示,这是词汇表的离散分布。平滑表示是从预训练的掩码语言模型中获得的候选标记的概率,可以看作是对 one-hot 表示的信息更丰富的替代。我们提出了一种有效的数据增强方法,称为文本平滑,通过将句子从其单热表示转换为可控平滑表示。我们在资源匮乏的情况下在不同的基准上评估文本平滑。实验结果表明,文本平滑在很大程度上优于各种主流数据增强方法。此外,文本平滑可以与那些数据增强方法相结合,以获得更好的性能。

1.介绍

数据增强是一种广泛使用的技术,尤其是在资源匮乏的情况下。它增加了训练数据的大小以减轻过度拟合并提高深度神经网络的鲁棒性。在自然语言处理(NLP)领域,已经提出了各种数据增强技术。一种最常用的方法是随机选择句子中的标记,并用语义相似的标记替换它们以合成一个新句子(Wei and Zou, 2019; Kobayashi, 2018; Wu et al., 2019)。 (Kobayashi,2018)提出了上下文增强,通过使用 LSTM 语言模型并根据概率分布对替换标记进行采样来预测替换标记的概率分布。 (Wu et al., 2019) 使用 BERT 的 (Devlin et al., 2018) 掩码语言建模 (MLM) 任务来扩展上下文增强。通过考虑深度双向上下文。 (Kumar et al., 2020) 进一步提出使用不同类型的基于 Transformer 的预训练模型在资源匮乏的情况下进行条件数据增强。

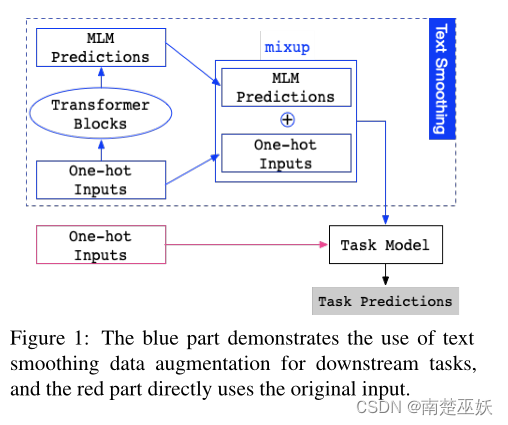

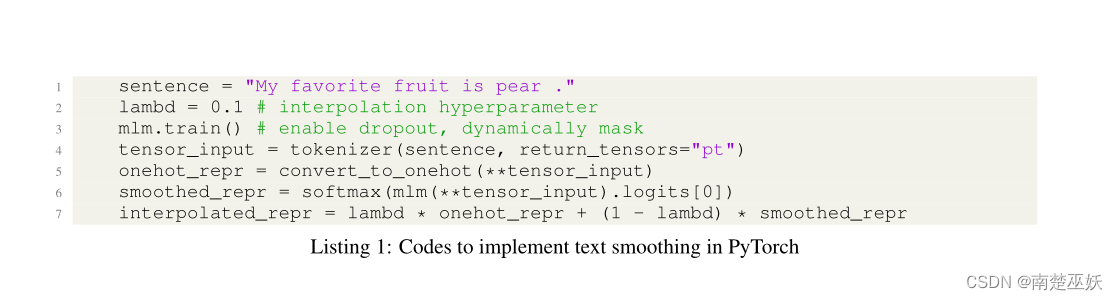

MLM 将掩码句子作为输入,通常句子中 15% 的原始标记将被 [MASK] 标记替换。在进入MLM之前,需要将句子中的每个token转换为其one-hot表示,只有一个位置的词汇量向量为1,其余位置为0。MLM输出每个掩码词汇量的概率分布位置。通过大规模预训练,期望概率分布尽可能接近ground-truth one-hot表示。与onehot表示相比,预训练MLM预测的概率分布是一种“平滑”表示,可以看作是一组具有不同权重的候选token。通常,大多数权重分布在上下文兼容的标记上。将平滑表示乘以词嵌入矩阵可以得到候选词的词嵌入的加权求和,称为平滑嵌入,它比单词的信息量和上下文更丰富。hot的embedding是通过lookup操作得到的。因此,使用平滑表示代替 one-hot 表示作为模型的输入可以看作是一种有效的加权数据增强方法。为了在 MLM 中只用一个前向过程获得整个句子的所有标记的平滑表示,我们没有显式地屏蔽输入。相反,我们打开 MLM 的 dropout,并在每一层动态随机丢弃一部分权重和隐藏状态。

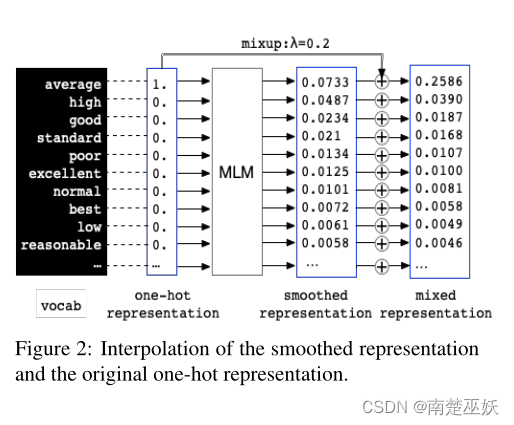

一个不可忽视的情况是,在预训练期间,某些token在相似上下文中出现的频率高于其他token,这将导致模型对这些token产生偏好。这对细粒度情感分类等下游任务是有害的。例如,给定“这件衬衫的质量是平均的。”,“平均”标记与标签最相关。通过MLM在“平均”位置的平滑表示如图2所示。虽然“平均”的概率最高,但更多的概率集中在与任务标签冲突的标记上,例如“高”、“好” ”或“差”。这种平滑的表示对于任务来说几乎不是一个很好的增强输入。为了解决这个问题,(Wu et al., 2019) 提出训练标签嵌入来约束 MLM 预测标签兼容令牌。但是,在资源匮乏的情况下,想要有足够的标签数据来提供监督并不容易。我们从计算机视觉领域的实用数据增强方法 mixup (Zhang et al., 2017) 中获得灵感。我们用原始的 onehot 表示对平滑表示进行插值。通过插值,我们可以放大原始token的概率,概率仍然大多分布在上下文兼容词上,如图2所示。

我们将这两个阶段结合为文本平滑:通过 MLM 获得平滑表示并进行插值以使表示更可控。为了评估文本平滑的效果,我们在三个分类基准上使用低资源设置进行实验。在所有实验中,文本平滑都比其他数据增强方法取得了更好的性能。此外,我们很高兴地发现文本平滑可以与其他数据增强方法相结合,以进一步改进任务。据我们所知,这是第一种方法改进多种主流数据增强方法。

2 相关工作

已经提出了各种 NLP 数据增强技术,它们主要分为两类:一类是直接修改原始输入,另一类是干扰嵌入(Miyato et al., 2016; Zhu et al., 2019)。修改原始输入最常用的方法是token替换:随机选择句子中的token,用语义相似的token替换,合成一个新句子。 (Wei and Zou, 2019) 直接使用同义词表 WordNet(Miller, 1998) 进行替换。 (Kobayashi,2018 年)提出了上下文增强,以使用两种因果语言模型来预测替换标记的概率分布。 (Wu et al., 2019) 使用 BERT (Devlin et al., 2018) 掩码语言建模 (MLM) 扩展上下文增强以考虑双向上下文。 (Gao et al., 2019) 通过用机器翻译中因果语言模型提供的词汇分布替换其 one-hot 表示来软增强句子中随机选择的标记。与 (Gao et al., 2019) 不同,我们使用 MLM 生成平滑表示,它更充分地考虑了深度双向上下文。并且我们的方法具有更好的并行性,可以在一个前向过程中有效地获得整个句子的平滑表示。此外,我们建议通过分类任务的插值来约束更可控的平滑表示。

3 我们的方法

3.1 平滑表示

我们使用 BERT 作为 MLM 的代表示例。给定一个下游任务数据集,即 D = {ti, pi, si, li}Ni=1,其中 N 是实例数,ti 是文本(单个句子或句子对)的 one-hot encoding, pi 是 ti 的位置编码,si 是 ti 的段编码,li 是这个实例的标签。我们将 one-hot 编码 ti、位置编码 pi 以及段编码 si 输入到 BERT 中,并在 BERT 中获取 Transformer 编码器最后一层的输出,表示为:

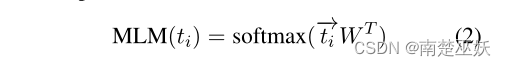

其中 - →ti ∈ Rseq_len,emb_size 是形状为 [sequence_len, embedding_size] 的二维密集向量。然后我们将 ? →ti 与 BERT 中的词嵌入矩阵 W ∈ Rvocab_size,embed_size 相乘,得到 MLM 预测结果,定义为:

其中 MLM(ti) 中的每一行是令牌词汇表上的概率分布,表示在预训练的 BERT 学习的输入文本的该位置中与上下文兼容的令牌选择。

3.2 混淆策略

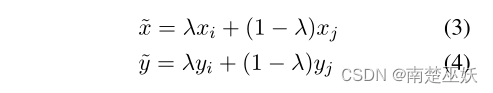

混淆(Zhang et al., 2017)定义为:

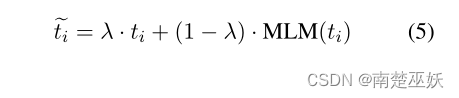

其中 (xi, yi) 和 (xj, yj) 是从训练数据中随机抽取的两个特征目标向量,λ ∈ [0, 1]。在文本平滑中,one-hot表示和平滑表示来自相同的原始输入,它们的标签是相同的,插值操作不会改变标签。所以混合操作可以简化为:

其中 ti 是 one-hot 表示,MLM(ti) 是平滑表示,eti 是插值表示,λ 是用于控制插值强度的平衡超参数。在下游任务中,我们使用插值表示而不是原始的 one-hot 表示作为输入。

4 实验

4.1 基线方法

EDA(Wei and Zou,2019)由四个简单的操作组成:同义词替换、随机插入、随机交换和随机删除。

反向翻译 (Shleifer, 2019) 将句子翻译成临时语言 (EN-DE),然后将之前翻译的文本翻译回源语言 (DE-EN)。

CBERT (Wu et al., 2019) 掩盖了一些标记,并使用预训练的 BERT 预测它们的上下文替换。

BERTexpand、BERTprepend (Kumar et al., 2020) 通过在给定类的所有示例前添加类标签来调节 BERT。 “扩展”一个标签来模拟词汇,而“前置”没有。

GPT2context (Kumar et al., 2020) 为预训练的 GPT 模型提供提示,并不断生成直到 EOS 代币。

BARTword、BARTspan (Kumar et al., 2020) 通过在给定类的所有示例前面添加类标签来调节 BART。 BARTword 屏蔽单个单词,而 BARTspan 屏蔽连续块

4.2 实验设置

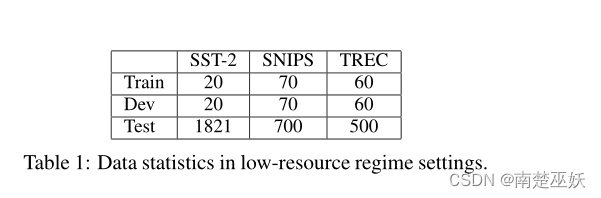

我们的实验严格遵循(Kumar et al., 2020)论文中的设置,对从链接 1 下载的三个文本分类数据集进行设置。

SST-2 (Socher et al., 2013) 是一个带有两个标签的电影评论情感分类任务。

SNIPS (Coucke et al., 2018) 是一项包含 16,000 多个众包??查询的任务,分布在 7 个不同复杂度的用户意图中。

TREC (Li and Roth, 2002) 包含从 4,500 个英语问题中收集的六种问题类型。

我们为每个实验随机抽取每个类 10 个样本,用于训练和开发集,以模拟低资源状态。三个数据集的数据统计如表 1 所示。在 (Kumar et al., 2020) 之后,我们将数字类标签替换为其文本版本。

我们首先比较了文本平滑和基线数据增强方法对低资源状态下不同数据集的影响。然后我们进一步探索将文本平滑与每种基线方法相结合的效果。考虑到合并后数据量增加到2倍,为了比较的公平性,我们将baseline实验中使用的数据扩大到相同的数量。所有实验重复 15 次以解释随机性,结果报告为整个测试集的平均 (STD) 精度。

4.3 实验结果

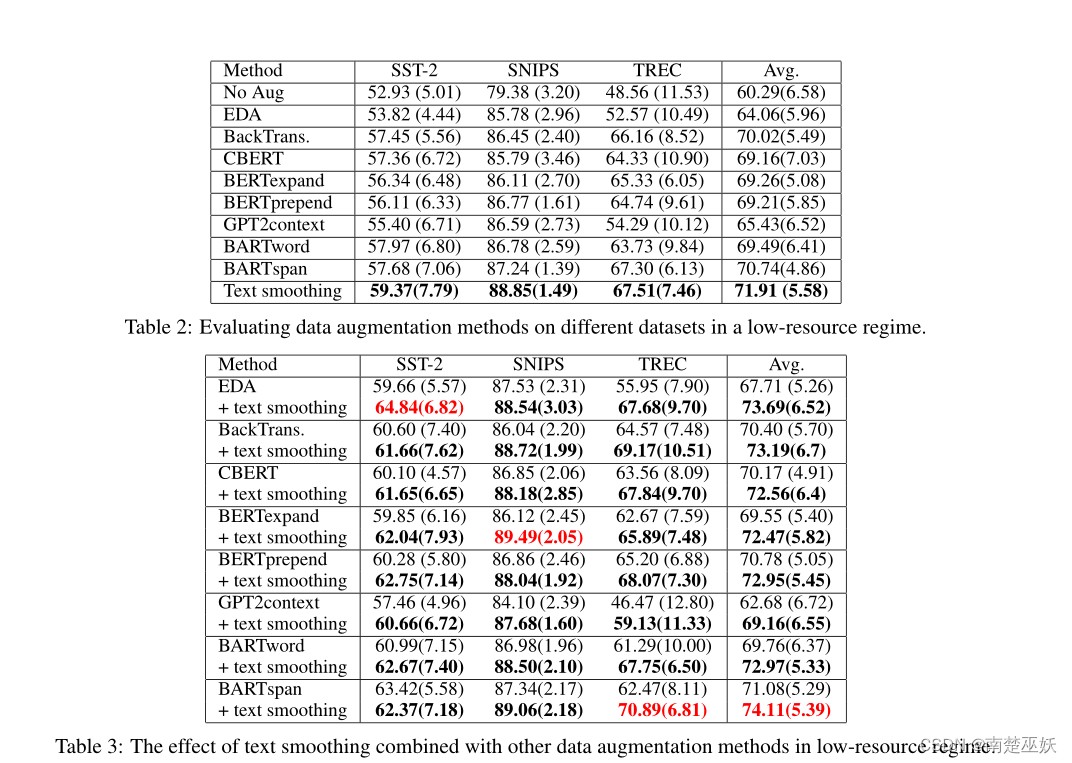

如表2所示,与其他数据增强方法相比,文本平滑在三个数据集上为模型带来了最大的改进。与没有数据增强的训练相比,文本平滑在三个数据集上平均实现了 11.62% 的改进,这是非常显着的。之前最好的方法是 BARTspan,文本平滑平均超过了 1.17%。

此外,我们很高兴地发现文本平滑可以很好地与各种数据增强方法相结合,进一步改进了基线数据增强方法。如表3所示,文本平滑可以为EDA、BackTrans、CBERT、BERTexpand、BERTprepend、GPT2context、BARTword、和 BARTspan,分别。据我们所知,这是改进各种主流数据增强方法的第一种方法。

5 结论

本文提出了文本平滑,一种有效的数据增强方法,通过将句子从其单热表示转换为可控平滑表示。在数据量少的情况下,文本平滑明显优于各种数据增强方法。此外,文本平滑可以进一步与各种数据增强方法相结合,以获得更好的性能。