Time-Series Representation Learning via Temporal and Contextual Contrasting(通过时间和上下文对比的时间序列表示学习)

论文信息

论文地址: https://arxiv.org/pdf/2106.14112.pdf

源码地址:https://github.com/emadeldeen24/TS-TCC

摘要

Learning decent representations from unlabeledtime-series data with temporal dynamics is avery challenging task. In this paper, we pro-pose an unsupervised Time-Series representationlearning framework via Temporal and ContextualContrasting (TS-TCC), to learn time-series repre-sentation from unlabeled data. First, the raw time-series data are transformed into two different yetcorrelated views by using weak and strong augmen-tations. Second, we propose a novel temporal con-trasting module to learn robust temporal represen-tations by designing a tough cross-view predictiontask. Last, to further learn discriminative represen-tations, we propose a contextual contrasting mod-ule built upon the contexts from the temporal con-trasting module. It attempts to maximize the sim-ilarity among different contexts of the same sam-ple while minimizing similarity among contexts ofdifferent samples. Experiments have been carriedout on three real-world time-series datasets. The re-sults manifest that training a linear classifier on topof the features learned by our proposed TS-TCCperforms comparably with the supervised training.Additionally, our proposed TS-TCC shows highefficiency in few-labeled data and transfer learn-ing scenarios.

从具有时间动态性的未标记时间序列数据中学习合理的表示是一项非常具有挑战性的任务。本文提出一种无监督的时间序列表示学习框架( TS-TCC ),用于从未标注数据中学习时间序列表示。首先,利用弱和强两种增强方式,将原始时间序列数据转化为两种不同但相关的视图。其次,我们提出了一种新的时间对比模块,通过设计一个艰巨的跨视图预测任务来学习鲁棒的时间表示。最后,为了进一步学习区分性表示,我们从时间对比模块出发,提出了基于上下文的上下文对比模块。它试图最大化同一样本的不同上下文之间的相似性,同时最小化不同样本上下文之间的相似性。在三个真实时间序列数据集上进行了实验。实验结果表明,在TS - TCC模型学习的特征基础上训练线性分类器,与有监督训练相比具有更好的性能。此外,我们提出的TS-TCC在少标记数据和迁移学习场景中表现出很高的效率。

主要贡献

- 针对无监督时间序列表示学习,提出一种新的对比学习框架;

- 在对比学习框架中,针对时间序列数据设计了简单而高效的增强;

- 通过设计一个跨视图预测任务,提出一种新的时间对比模块来从时间序列数据中学习具有鲁棒性的表示。此外,提出一个上下文对比模块来进一步学习基于鲁邦表示的区分性表示;

- 利用三个公开的数据集对提出的通过时间和上下文对比的时间序列表示学习(TS-TCC)框架进行实验,表明在有监督学习、半监督学习和迁移学习环境下,所学习的表征对下游任务是有效的。

论文结构

1. Introduction

首先介绍对时间序列数据进行标记的困难性,然后分别介绍自监督学习和对比学习的应用,最后介绍提出的时间序列表示学习框架(TS-TCC)。

2. Related Works

- 介绍自监督学习的研究现状;

- 介绍自监督学习在时间序列数据上的流行趋势;

3. Methods

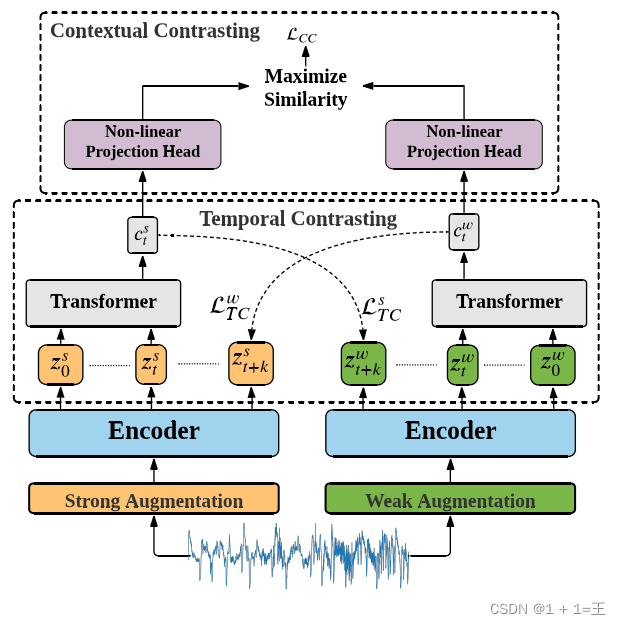

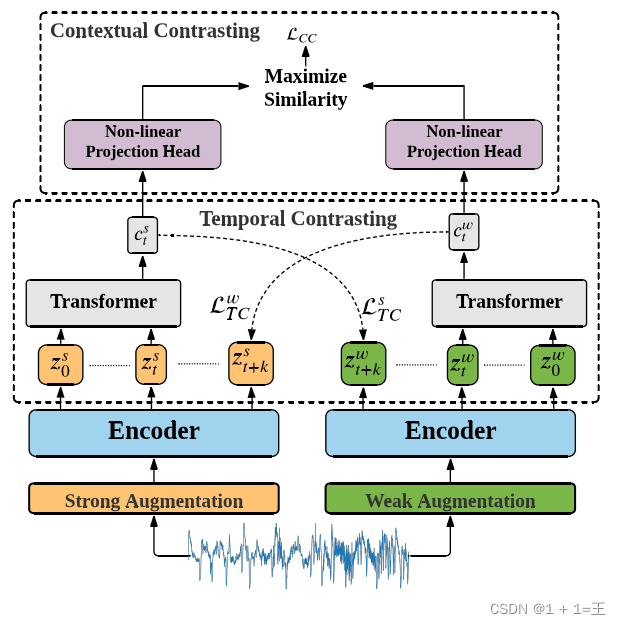

详细介绍了提出的时间序列表示学习框架(TS-TCC),主要包括三个模块:

- Time-Series Data Augmentation(时间序列数据增强)

- Temporal Contrasting(时间对比模块)

- Contextual Contrasting(上下文对比模块)

Architecture of proposed TS-TCC model

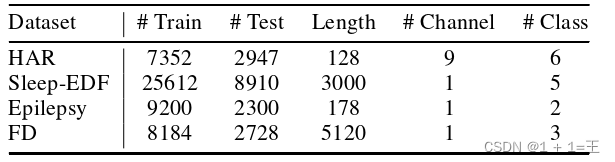

4. Experimental Setup

- 介绍实验数据集

Human Activity Recognition (HAR)【人类活动识别数据集】、Sleep Stage Classification【睡眠阶段分类数据集】、Epilepsy Seizure Prediction【癫痫发作预测数据集】、Fault Diagnosis (FD)【故障诊断数据集】

2. 介绍实验细节

2. 介绍实验细节

5. Results

介绍实验结果与分析。

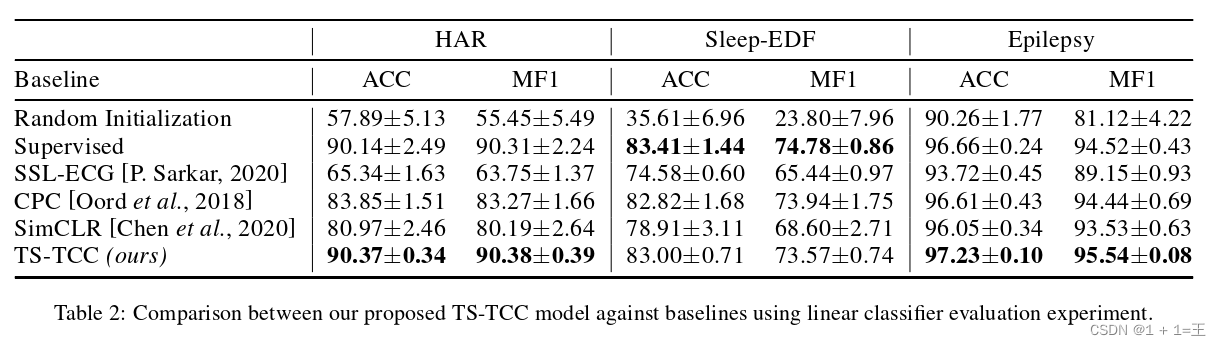

为了显示提出的TS-TCC的有效性,在线性评价、半监督训练和转移学习三种不同的训练设置上进行了测试。为了更好地评价不平衡数据集,采用精度和宏观平均F1 - score ( MF1 )两个指标来评价性能。

6. Conclusions

总结。

时间序列表示学习框架(TS-TCC)方法

数据增强(Data Augmentation)

包括两方面的工作:数据增强和编码。具体如下:

- 数据增强

首先基于强增强(Strong Augmentation)和弱增强(Weak Augmentation)生成两种不同但相关的输入数据视图,然后将这些视图传递给编码器以提取它们的高维潜在表示。

- 弱增强(Strong Augmentation)

一种jitter-and-scale(抖动和缩放)策略,即将随机变化添加到信号中,并放大其幅度。 - 强增强(Weak Augmentation)

一种permutation-and-jitter(排列和抖动)策略,即先将信号分成随机数目的段并打乱次序,再将随机抖动添加到置换信号中。

- 编码

将增强后的两种视图通过Encoder(编码器),以提取它们的高维潜在表示。

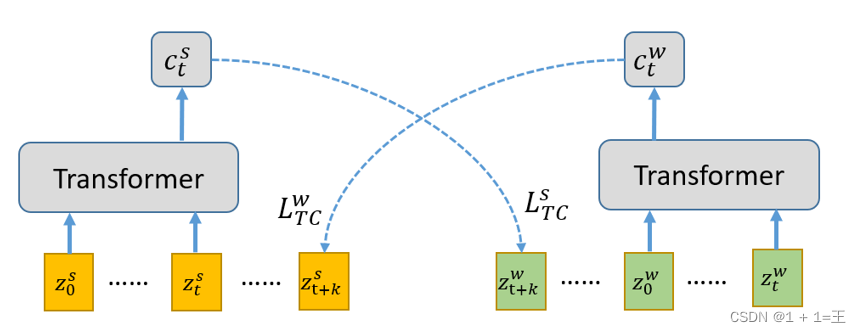

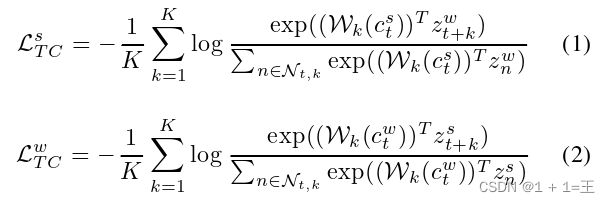

时间对比模块(Temporal Contrasting)

使用一个视图的过去来预测另一个视图的未来,从而执行跨视图预测任务。

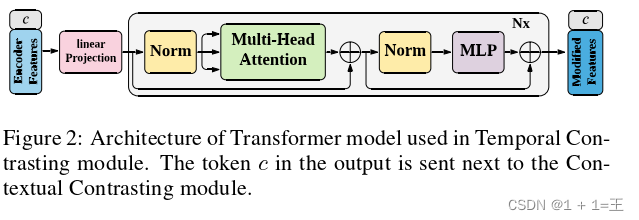

将编码后的视图(zw、zs)经过一个Transformer结构得到一个结果(cw、cs)。其中zs表示强增强编码结果和zw表示弱增强编码结果。

使用的Transformer结构如下:

然后,使用cw预测zs,cs预测zw,损失设计为:利用时间对比损失最小化同一样本的预测表示和真实表示之间的点积,同时最大化与批量内其他样本点积。

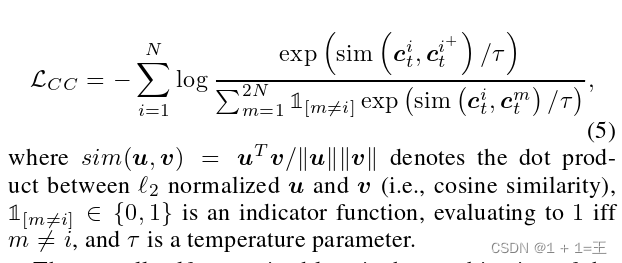

上下文对比模块(Contextual Contrasting)

给定一批N个输入样本,我们将从其两个增强视图中为每个样本设置两个上下文,从而拥有2N个上下文。

定义同一输入的两个增强视图为一个正对,与同批内其他输入为负对。

通过上下文对比损失来最大化正对之间的相似度,最小化负对之间的相似度。损失函数如下:

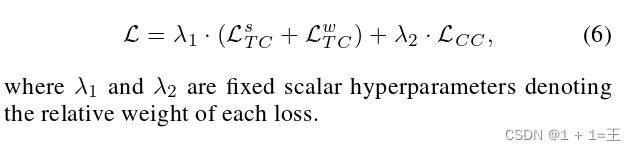

从而,架构总体损失为: