Deep Graph Memory Networks for Forgetting-Robust Knowledge T racing(遗忘鲁棒知识的深图记忆网络)

文章目录

翻译:

摘要

学生的知识对于定制学习体验至关重要。最近的知识追踪方法倾向于通过建模学习概念中的知识状态动态来应对这些挑战。然而,他们仍然面临一些固有的挑战,包括:建模遗忘行为和确定潜在概念之间的关系。 为了应对这些挑战,本文提出了一种新的知识跟踪模型,即深度图存储网络(DGMN)。在该模型中,我们在注意记忆结构中加入遗忘门机制,以便在知识追踪过程中动态捕捉遗忘行为。特别是,考虑到潜在概念之间的相互依赖性,这种遗忘门机制建立在潜在概念的注意力遗忘特征之上。此外,该模型还能够根据学生不断变化的知识状态,从动态潜在概念图中学习潜在概念之间的关系。使用四个完善的基准数据集进行了综合实验评估。结果表明,在所有数据集上,DGMN始终优于最先进的KT模型。我们的实验还分析了遗忘行为建模和学习潜在概念图的有效性。

1 、介绍

知识追踪(Knowledge tracing,KT)是人类学习中的一个基本问题,近年来受到了越来越多的关注。从概念上讲,KT问题是根据问答顺序的历史来预测正确回答新问题的概率[1]。早期的工作试图使用贝叶斯方法解决KT问题[1]、[2]、[3]、[4]。通常,这些方法使用状态空间模型(例如,隐马尔可夫模型)作为二元随机变量跟踪知识状态(即,0表示未知,1表示已知),并预测正确回答问题的概率。然而,这些方法的一个主要限制是,它们依赖于关于知识状态和潜在概念的过于简化的假设,以保持贝叶斯推理的计算可处理性。为了克服这一局限性,人们提出了深度学习的方法。例如,Piech等人[5]引入了一种称为深度知识T竞赛(DKT)的递归神经网络,以跟踪问答序列中的知识状态。最近的几次尝试[6]、[7]、[8]进一步增强了deep KT模型,使用外部存储结构来表示知识状态。这些深度学习模型在成熟的KT数据集上展示了最先进的结果。尽管如此,他们仍面临以下固有挑战 :

(1) 关于人类记忆的认知建模研究显示,由于遗忘行为,随着时间的推移,知识呈下降趋势,这被称为遗忘曲线理论[9]。然而,将此类遗忘行为(例如,遗忘行为发生的时间和方式)建模为知识状态,并将其反映在预测学生学习成绩的KT模型中是一个挑战。

(2) 概念学习是人类的一种非凡能力,它涉及从问题(例如数学课程中的学习主题)中提取潜在概念,并确定它们之间的关系[10]。然而,目前尚不清楚在KT模型中,潜在概念及其关系在多大程度上可以被明确建模并用于预测学生的学习成绩。

在这项工作中,我们的目标是通过引入一种新的遗忘鲁棒KT模型,即深度图存储网络(DGMN),来应对这些挑战。该模型的新颖之处在于三个方面:(1)在考虑概念空间中潜在概念的相互关系的同时,对其遗忘特征进行建模;(2) 学习动态潜在概念图,以反映学生知识状态对潜在概念及其关系的动态;(3) 结合遗忘门控机制来解释遗忘特征对学生学习成绩的影响。下面,我们简要介绍我们提出的DGMN模型的这三个新方面。

最近KT解决遗忘行为的努力往往有局限性。一个方向[11]遵循了建模遗忘的深度学习方法,它假设只有一个潜在概念存在,这不是一个现实的假设,因为在许多现实世界中,可能有多个概念(例如,数学课程中的加减和乘法等主题)。此外,这种假设使得遗忘特征的计算基于问题本身,因为所有问题都有相同的概念,导致对遗忘的估计不准确,如图1所示。另一个方向[12]采用贝叶斯方法,该方法假设学生知识状态的先验信息跨越概念,并考虑忘记概念,但与概念之间的相互关系(例如,课程主题之间的先决条件依赖性)隔离,因为它们缺乏表示这些关系的方法。与贝叶斯方法相比,深度学习方法在绕过关于学生知识状态先验信息存在的假设方面具有优势;因此,它可以在冷启动情况下运行。据我们所知,本文的工作是第一种深度学习方法,它考虑了学生在多个概念上的遗忘行为,并解释了它们之间的相互关系。

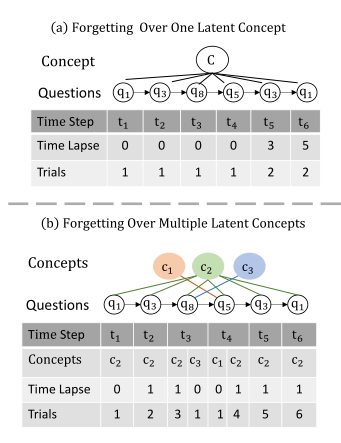

然而,在现实世界中,学生往往会忘记或记住潜在概念(即基本技能),而不是问题本身,这些潜在概念之间的关系会影响每个潜在概念的遗忘效果。例如,一个学生在掌握了一个新的数学问题背后的潜在概念(例如点积)后,可能能够正确地回答一个她以前从未见过的新数学问题。图1展示了两种不同的遗忘建模范式:跨问题共享的超过一个潜在概念,以及跨问题共享的超过多个潜在概念。让我们考虑两个遗忘特征[11]:(i)Time Lapse - 计算自上次回答问题以来经过的时间步数的时间间隔,以及(ii)Trials- 指学生回答问题的总次数的时间间隔。如图1所示。a、 遗忘是在一个潜在的概念上建模的,这个概念由所有通过问题标签识别的问题共享,如图1所示。b、 遗忘是在多个概念上建模的,这些概念由它们的概念标签识别,并由问题共享。我们可以看到问题q1在这个序列中出现了两次。因此,在时间步t6,q1在图1(a)中具有遗忘特征 Time Lapse=5 和Trials=2。在图1(b)中Time Lapse=1 and Trials=6。 因此,,q1遗忘被认为可能发生在图1(a)中。 然而,由于q1背后的概念是c2,这确实是这个序列中所有问题(即q1、q3、q5和q8)的基础,学生已经通过所有这些问题学习了c2,并且在时间步骤t6不太可能发生遗忘。因此,在多个概念上建模遗忘特征可以提高对学生知识状态的追踪能力,而在一个概念上建模则无法实现这一结果。

图1:一个示例,用于说明在一个潜在概念和多个潜在概念上建模遗忘之间的区别,其中时间推移和时间间隔是用于建模遗忘的两个遗忘特征。

尽管如此,当在概念空间中学习遗忘特征时,一个困难出现了:因为只有一个问答序列可用,我们如何根据问题背后的潜在概念而不是问题本身来有效地建模遗忘特征?我们观察到,解决这一难题的关键是设计一个KT模型,该模型不仅可以通过问答序列学习问题背后的潜在概念,还可以捕获潜在概念之间的关系。更重要的是,这种KT模型应该能够根据学生随时间的表现动态跟踪潜在概念及其关系的变化。在此之前,已经提出了几种基于图形的KT方法[15],[16]。然而,这些方法假设潜在概念的图形是基于训练数据中的基本事实预定义的,因此无法捕捉学生知识状态的动态,即他们对潜在概念的掌握程度及其随时间的联系。在这项工作中,我们的DGMN模型通过设计一个深度图存储结构克服了这个问题,该结构包括一个专注的键值存储,用于动态捕获学生对潜在概念的知识状态,以及一个用于动态学习潜在概念之间关系的潜在概念图 。

即使将概念空间中的遗忘特征建模到深度图记忆结构上,仍有一个问题需要回答:我们如何有效地使用遗忘特征来反映学生的遗忘行为(即记忆保留时间的下降),并计算其对预测答案的影响?这就需要找到一种将遗忘特征与知识状态特征(即技能掌握信息)结合起来的好方法。为了解决这个问题,我们的DGMN模型结合了遗忘选通机制,可以在训练期间学习这两组特征的最佳组合,从而能够综合分析它们对预测答案的联合影响。此外,这种遗忘门机制引入的非线性可以增强在知识追踪中表示信息特征的学习能力,从而预测学生的学习成绩。

综上所述,这项工作的主要贡献如下:

- 我们提出了一个新的KT模型,即DGMN,该模型通过一个深度图存储结构来动态跟踪学生在关注的键值记忆中对潜在概念的知识状态,以及潜在概念图中潜在概念之间的关系。

- 在我们提出的DGMN模型中,我们考虑了遗忘特征在潜在概念空间中的相互关系,设计了遗忘特征的建模,并设计了遗忘门机制,将遗忘特征与知识状态特征相结合,用于预测学生的学习成绩。

- 我们建议在动态潜在概念图中捕捉潜在概念及其关系的嵌入表示,并利用其有用信息对问题进行排序,以改进模型优化。

- 通过在四个成熟的KT数据集上与最先进的深度学习和图形KT模型进行比较,我们广泛评估了我们提出的DGMN模型的性能。

本文的提醒如下。第2节定义了研究问题。第3节描述了我们提出的KT方法。第四部分介绍了实验设计。第5节讨论了实验结果和发现。第6节回顾了相关工作,第7节总结了本文。

2、问题定义

定义1。给定一个问答序列xt和一个输入问题qt∈ Q、 知识追踪(KT)问题是预测qt正确回答的概率

在KT问题中,Q中的问题对应于许多潜在概念C={c1,c2,…,cn}。一个问题可能与一个或多个潜在概念有关,反之,一个潜在概念可能与一个或多个问题有关。然而,这些潜在概念之间的关系是未知的(即,未预先定义)。因此,解决知识追踪问题的一个重要任务是学习潜在概念及其关系的有效表示(即嵌入),以及追踪学生对潜在概念的知识状态,即他们对潜在概念的掌握程度。

当学生回答问题时,学生的知识状态在不断变化。因此,每个学生都与一系列知识状态(s1,…,st)相关联,其中s1,st指时间步骤1,t、 分别。在这项工作中,我们通过开发一个机器学习模型 M_θ 来解决KT问题,该模型由θ参数化。具体来说,给定一个问答序列xt和一个输入问题qt∈ Q, KT模型Mθ可以跟踪每个时间步t的知识状态st,并生成正确回答问题qt的概率pt作为输出,即pt=p(yt=1 | xt,st,qt)。

3、深图存储网络

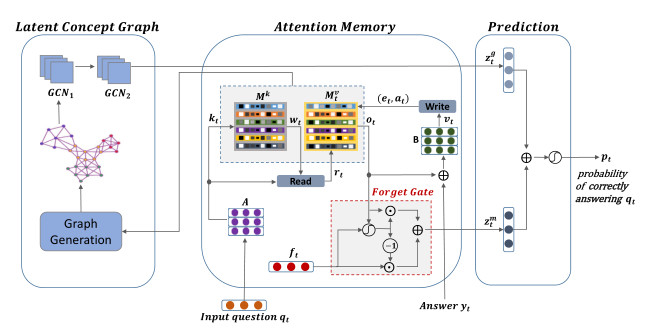

在本节中,我们将介绍深度图记忆网络(DGMN),它有两个模块:注意记忆(AM)和潜在概念图(LCG)。图2显示了DGMN的模型架构。

图2:我们提出的DGMN模型的模型架构,其中潜在概念图(LCG)模块位于左侧,注意记忆(AM)模块位于中间,答案预测层位于右侧。

3.1注意记忆

本模块的目的是学习在KT任务中嵌入潜在概念的表示,并跟踪学生知识状态的动态。

3.1.1概念嵌入存储器( M k M^k Mk)

该内存存储每个潜在概念的嵌入向量(即内存槽)。它被表示为矩阵Mk∈ RN×dk,其中N是潜在概念的数量,dk是嵌入维度。

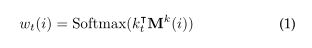

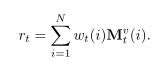

给定一个热编码向量δ(qt)∈ 问题qt的R | Q |,我们将其与可学习的嵌入矩阵a相乘∈ R | Q |×dk得到一个问题嵌入向量kt∈ Rdk。然后,将kt和Mk之间的内积提供给Softmax层以获得相关向量wt∈ RN,根据

其中,

和Mk(i)是第i个潜在概念的嵌入向量。该关联向量wt反映了当前问题qt与存储在Mk中的每个潜在概念嵌入之间的关联。因此,它随后用于从概念状态记忆中读取学生的知识状态 。

3.1.2概念状态存储器( M t v M^v_t Mtv?)

这种记忆保存着学生当前的概念状态,用矩阵表示

其中N是潜在概念的数量,dv是状态维。

其中N是潜在概念的数量,dv是状态维。

给定一个相关向量wt,我们得到一个向量rt, 使用跨内存插槽的加权和从概念状态存储器获得。

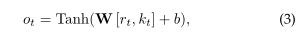

在这里,rt 表示来自 M^v_t 的与输入问题相关的概念状态信息,但它不包括关于问题本身的信息。为了解决这个问题,我们将其与问题嵌入向量kt线性结合,然后将它们提供给Tanh层,以计算概念摘要向量ot∈ RN as

3.1.3遗忘门机制

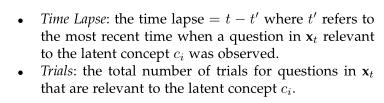

为了模拟学生的遗忘行为,我们首先需要根据输入问题的潜在概念确定与该问题相关的问题。设C(qt)为问题qt的潜在概念集,即每个潜在概念ci∈ C(qt),相关权重wt(i)到Mk(i)大于相关阈值τ。先前在xt中出现的问题qj与ci有关∈ C(qj)。因此,在每个时间步t,我们获得两个遗忘特征:

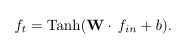

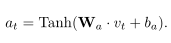

在时间步长t计算N个潜在概念的这些遗忘特征,得到一个矩阵 Ft∈ RN×2。得到一个组合遗忘向量ft∈ RN,我们将矩阵Ft展平为一个输入向量fin∈ R2N,并将其发送到Tanh层,如下所示:

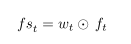

为了衡量ft对输入问题qt的重要性,我们对相关向量wt进行元素相乘∈ RN获得一个 遗忘摘要向量fst∈ RN as

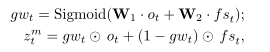

然后,我们使用遗忘门机制来组合来自概念摘要向量ot和遗忘摘要向量fst的信息。遗忘选通机制分两步工作。首先,一个门向量gwt∈ RN是通过对向量ot和fst的线性组合应用Sigmoid函数生成的。然后,我们计算组合的存储向量zmt∈ RN基于选通向量gwt:

3.1.4记忆更新程序

更新状态记忆M^v_t由两个信号控制:add signal at和erase signal et。这些信号决定了在观察学生提出的新问题及其答案后,Mvt上改变的信息比例。at决定将新信息写入存储器,而et决定将旧信息从存储器中删除。

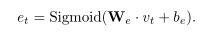

假设(δ(qt),yt)是最近观察到的问答元组,我们用嵌入矩阵B将其嵌入∈ R2 | Q |×dv以获得嵌入向量vq t∈ Rdv。然后,我们将这个嵌入向量与摘要向量ot连接起来,将最新问题答案的信息与相应的知识状态摘要结合起来。连接的更新向量vt=[vqt,ot]∈ R(dv+N)用于使用擦除和添加信号更新Mvt存储器[17]。擦除信号是et∈ Rdv由以下方程式得出:

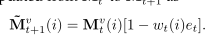

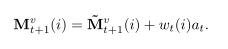

概念状态存储器从Mvt更新

at的获得

最终的概念存储器更新方式

3.2潜在概念图(LCG)

虽然注意记忆模块捕捉学生知识状态的时间动态,但它不能表示潜在概念之间的关系。例如,观察给定潜在概念的知识增长会影响对相关潜在概念答案的预测。因此,我们学习了一种图形表示法来捕捉这种关系 :

给定一个注意记忆(

M

k

,

M

t

v

M_k,M^v_t

Mk?,Mtv?),在(

M

k

,

M

t

v

M_k,M^v_t

Mk?,Mtv?)上的潜在概念图(LCG)是一个加权图 G=(V,E,ω),其中V中的每个顶点对应于

M

k

M_k

Mk? 中的一个潜在概念,E 中的每个边根据它在

M

t

v

M^v_t

Mtv? 中连接的两个潜在概念的相似性进行加权。具体来说,我们定义ω:

M

t

v

M^v_t

Mtv?×

M

t

v

M^v_t

Mtv?→ [0,1]使得 ω(

M

t

v

(

i

)

M^v_t(i)

Mtv?(i),

M

t

v

(

j

)

M^v_t(j)

Mtv?(j))≥ μ,即两个潜在概念ci和cj之间的边缘的相似性值不小于μ,其中Mvt(i)和Mvt(j)分别是ci和cj的概念状态向量,以及μ∈ [0,1]是一个相似性阈值。

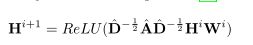

为了从潜在概念图中提取有用信息,我们使用图卷积网络[18],[19]。这是通过对图中每个顶点的邻域应用卷积来实现的。GCN层的输入包括1)嵌入记忆Mk的潜在概念∈ 在我们的例子中是RN×dk,以及2)具有自循环的图邻接矩阵?A=A+I和?A∈ RN×N,其中I是单位矩阵,3)对角度矩阵?D∈ RN×N包含?A中每个顶点的度信息。通过卷积过程计算GCN层的传播规则[19]:

其中,ReLU(u)=max(0,u)是一个非线性激活函数,Wi是一个可学习的权重矩阵。你好∈ RN×dk是一个输入特征矩阵,它是前一个GCN层的输出,对于第一个GCN层,H0=Mk。

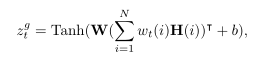

最后,我们计算了图汇总向量zgt∈ RN,它使用相关向量wt处理当前问题qt的GCN输出

W在哪里∈ RN×dk是一个可学习的权重矩阵,H是我们模型中最后一个GCN层的输出矩阵,b是一个偏差向量。