论文阅读07——《Deep Attention-guided Graph Clustering with Dual Self-supervision》

原文地址:论文阅读07——《Deep Attention-guided Graph Clustering with Dual Self-supervision》

作者:Zhihao Peng, Hui Liu, Yuheng Jia, Junhui Hou

发表时间:2021年11月

论文地址:https://arxiv.org/pdf/2111.05548.pdf

目录

Ideas:

- 作者认为之前的深度聚类方法有以下四个缺陷:

- 它们简单地将节点内容和拓扑结构信息的重要性等同起来;

- 它们忽略了嵌入不同层的多尺度信息;

- 先前的方法未能很好地利用来自聚类分配的可用判别信息;

- 大多数现有方法通常利用两阶段处理技术来学习嵌入并执行k-means算法产生聚类结果,这忽略了掐你如学习和聚类分配之间的相互作用

- 针对以上问题,作者提出了一种新颖的深度嵌入聚类方法,着重综合考虑DAE和GCN中的多个现成的信息,并充分利用聚类分配中的可用判别信息。这一点与我们之前论文阅读中的分析如出一辙。

- 提出具有双重自监督的深度注意力引导图聚类模型。

Model:

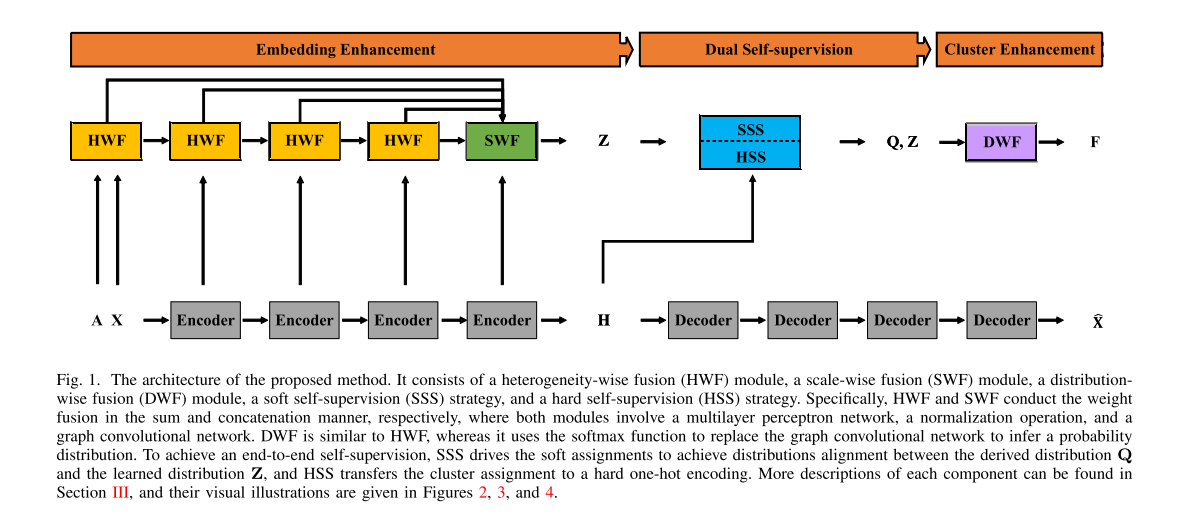

这篇文章是在《Attention-driven Graph Clustering Network》的基础上进行优化,模型的基础结构没变,增加了一个分布融合模块,以及新型的双重自监督,为什么说新,接下来会详细解释。

与AGCN相似的内容就不再介绍,下面详细介绍分布融合模块和双重自监督模块。

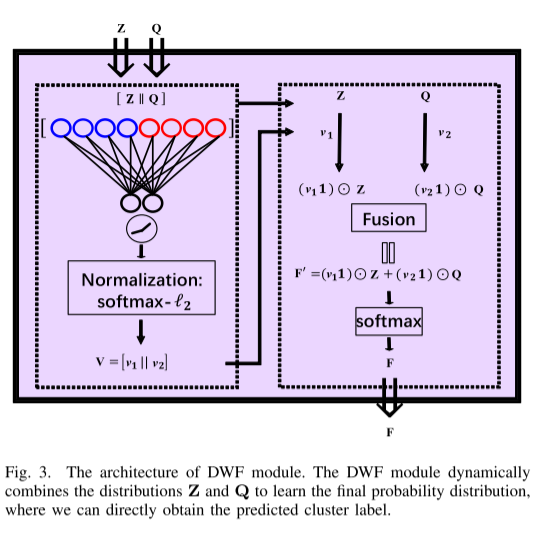

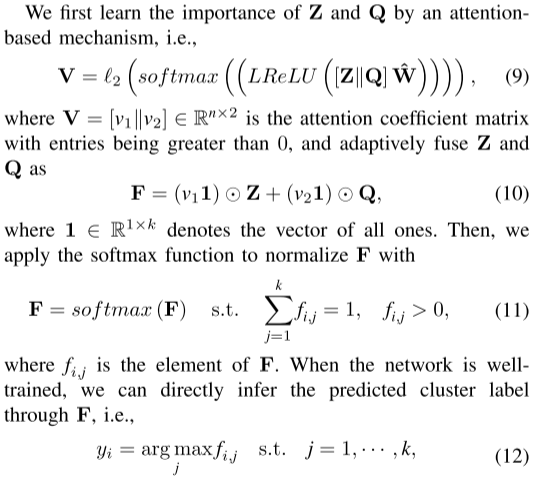

分布融合模块

顾名思义,分布融合就是将不同的分布通过某种方式结合起来,按照AGCN的思想,显然是通过加权求和,权重系数通过注意力机制计算。确实如此,我们看一下文章中的模型。

文章将分布Z和分布Q进行加权融合,用公式表示为:

双重自监督模块

前面说这个双重自监督的模块比较新,主要是因为这里双重自监督不再是SDCN中那样,通过目标分布P去联合优化Q和Z,而是两种自监督策略相结合。具体来说,作者提出了一种具有三元组KL散度损失的软自监督策略(SSS)以及一种具有伪监督损失的硬自监督策略(HSS)。

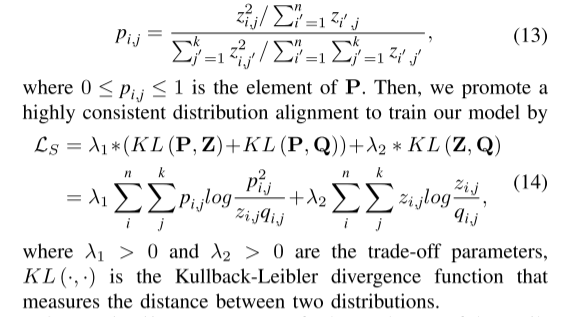

软自监督(SSS)

说白了软自监督就是通过优化分布函数间的KL散度损失进行训练,具体如下:

其中KL(P,Q),KL(P,Z)是SDCN中采用的双重自监督,这里作者又加入了Z和Q之间的KL散度损失,为什么这么做我还不太清楚,如果有理解的小伙伴欢迎在评论区留言~

硬自监督(HSS)

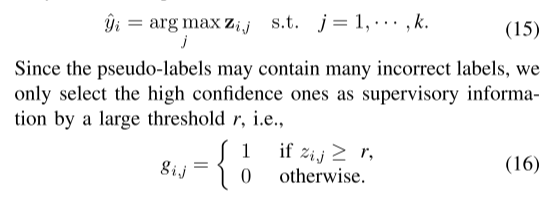

硬自监督作者也说了是一种伪监督,那么很容易想到伪标签,将概率最大的那个或者说置信度最高的标签赋予该类簇,形式化为:

这里作者将阈值r设置为0.8,也就是说,当概率或置信度大于0.8,将放大伪标签的影响,小于0.8将缩小伪标签的影响,按照作者的想法,这种操作可以减小错误标签的影响。

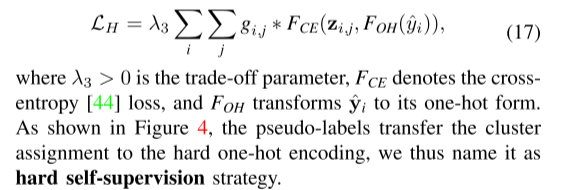

构造出以下硬自监督损失函数

这样总的损失函数为:

LR是自编码器的重建损失。

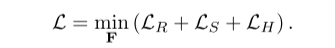

算法伪代码

源码尚未公开,作者只提供了数据集:https://github.com/ZhihaoPENG-CityU/DAGC

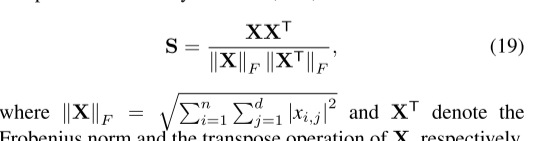

细节

使用欧几里德距离度量的 KNN 图构建未能利用几何结构信息,因此无法提供有效的 KNN 图。相反,我们使用余弦相似度度量作为距离度量来进行 KNN-k 图构建,因为来自同一簇的两个样本往往比位于不同簇中的样本具有更大的绝对余弦值。