本例中展示了 如何训练一个简单的卷积神经网络 (CNN) 来对 CIFAR 图像进行分类。由于本教程使用的是 Keras Sequential API,创建和训练模型只需要几行代码。

1. CIFAR10数据集准备

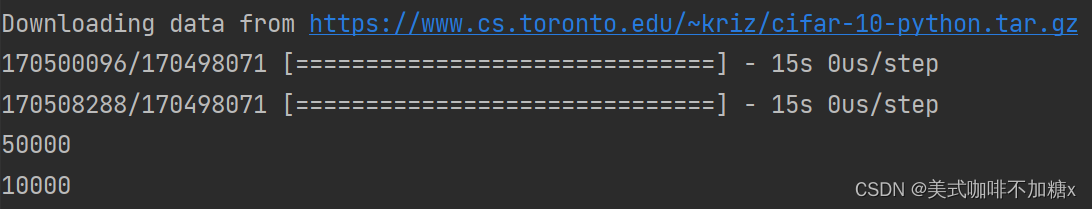

CIFAR10 数据集包含 10 类,共 60000 张彩色图片,每类图片有 6000 张。**此数据集中 50000 个样例被作为训练集,剩余 10000 个样例作为测试集。**类之间相互独立,不存在重叠的部分。

首先我们需要导入相关的包:

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

import matplotlib.pyplot as plt

下载并准备CIFAR10数据集:

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()

train_images, test_images = train_images/255.0, test_images/255.0 # 对图片进行归一化

print(len(train_images)) # 50000

print(len(test_images)) # 10000

# print(train_images.shape) # (50000, 32, 32, 3)

# print(train_labels.shape) # (50000, 1)

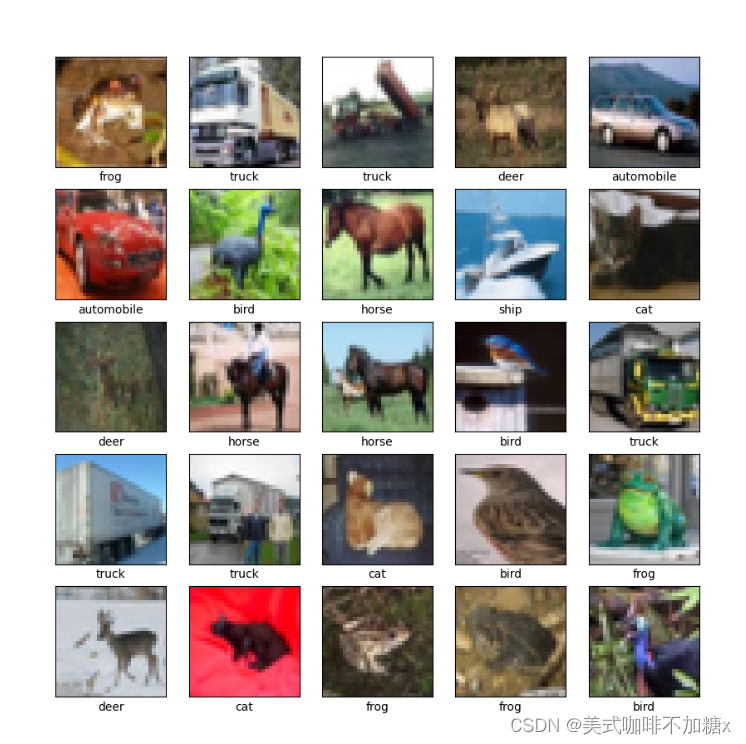

验证数据:为了验证数据集看起来是否正确,我们绘制训练集中的前 25 张图像并在每张图像下方显示类名称。

class_names = ['airplane', 'automobile', 'bird', 'cat', 'deer', 'dog', 'frog', 'horse', 'ship', 'truck']

plt.figure(figsize=(10, 10))

for i in range(25):

plt.subplot(5, 5, i+1)

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(train_images[i])

plt.xlabel(class_names[train_labels[i][0]])

plt.show()

2. 构造卷积神经网络模型

**CNN 将形状为 (image_height, image_width, color_channels) 的张量作为输入,**忽略批次大小。如果您不熟悉这些维度,color_channels 是指 (R,G,B)。在此示例中,您将配置 CNN 以处理形状为 (32, 32, 3) 的输入,即 CIFAR 图像的格式。您可以通过将参数 input_shape 传递给第一层来实现此目的。

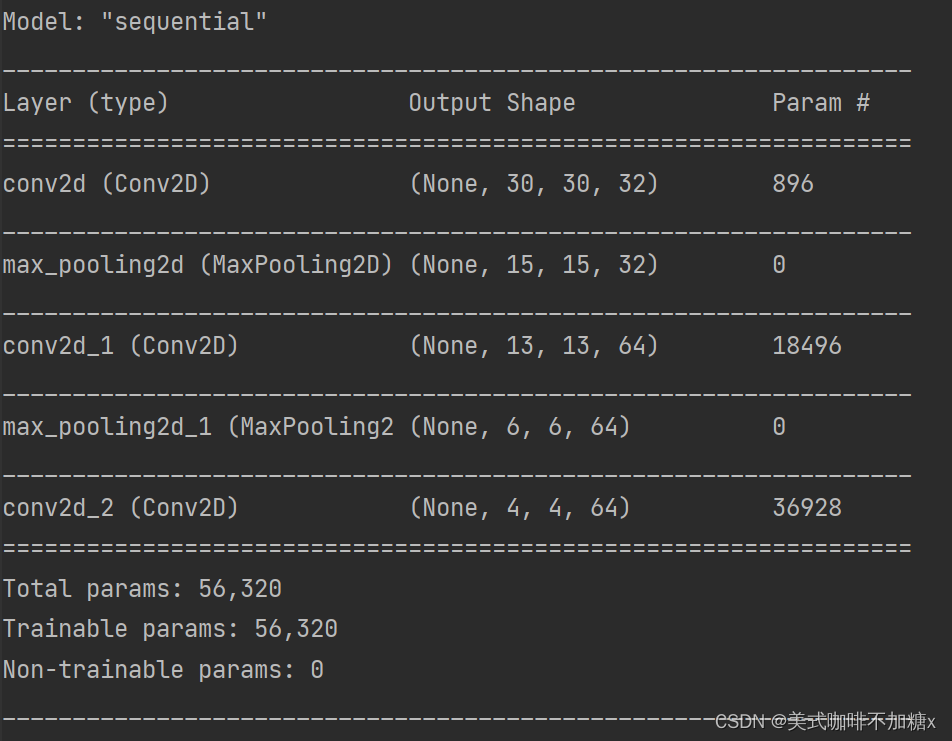

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.MaxPool2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPool2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.summary()

在上面的结构中,您可以看到每个 Conv2D 和 MaxPooling2D 层的输出都是一个三维的张量 (Tensor),其形状描述了 (height, width, channels)。越深的层中,宽度和高度都会收缩。每个 Conv2D 层输出的通道数量 (channels) 取决于声明层时的第一个参数(如:上面代码中的 32 或 64)。这样,由于宽度和高度的收缩,您便可以(从运算的角度)增加每个 Conv2D 层输出的通道数量 (channels)。

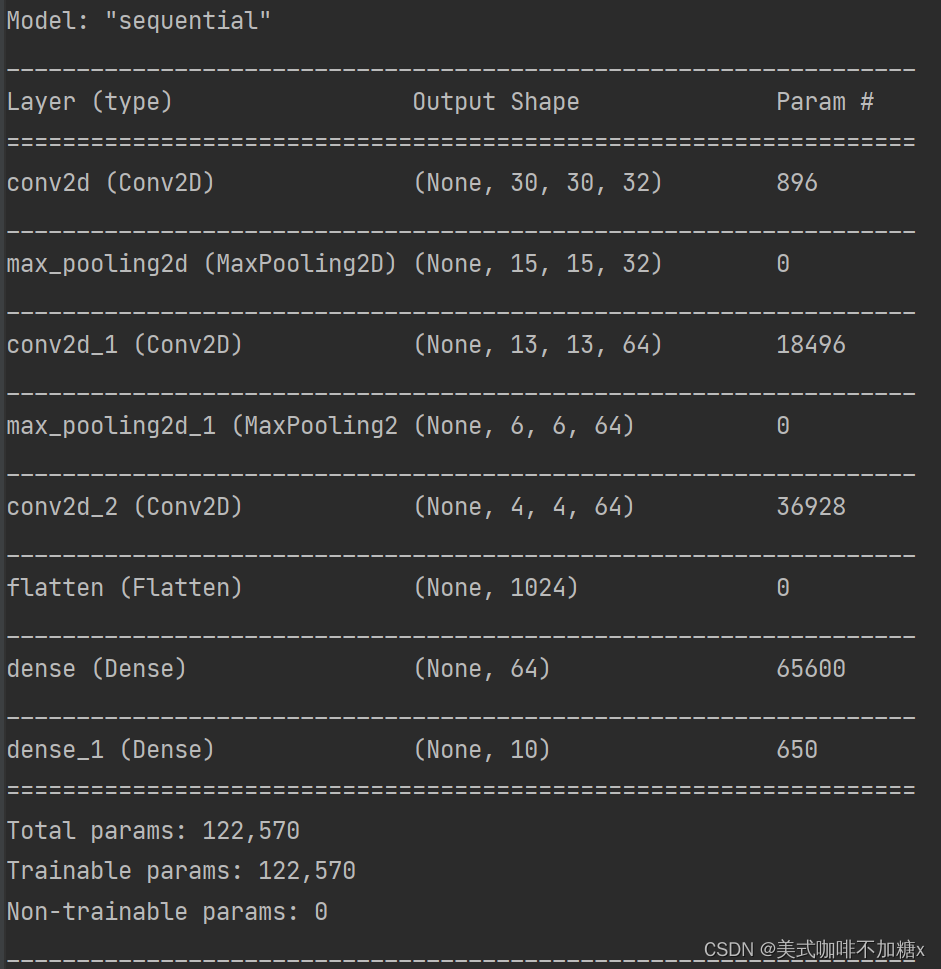

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.MaxPool2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPool2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

# 增加Dense层

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10))

增加Dense层后,模型的框架如下所示:

网络摘要显示 (4, 4, 64) 输出在经过两个 Dense 层之前被展平为形状为 (1024) 的向量。

3. 编译并训练模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

history = model.fit(train_images, train_labels, epochs=10,

validation_data=(test_images, test_labels))

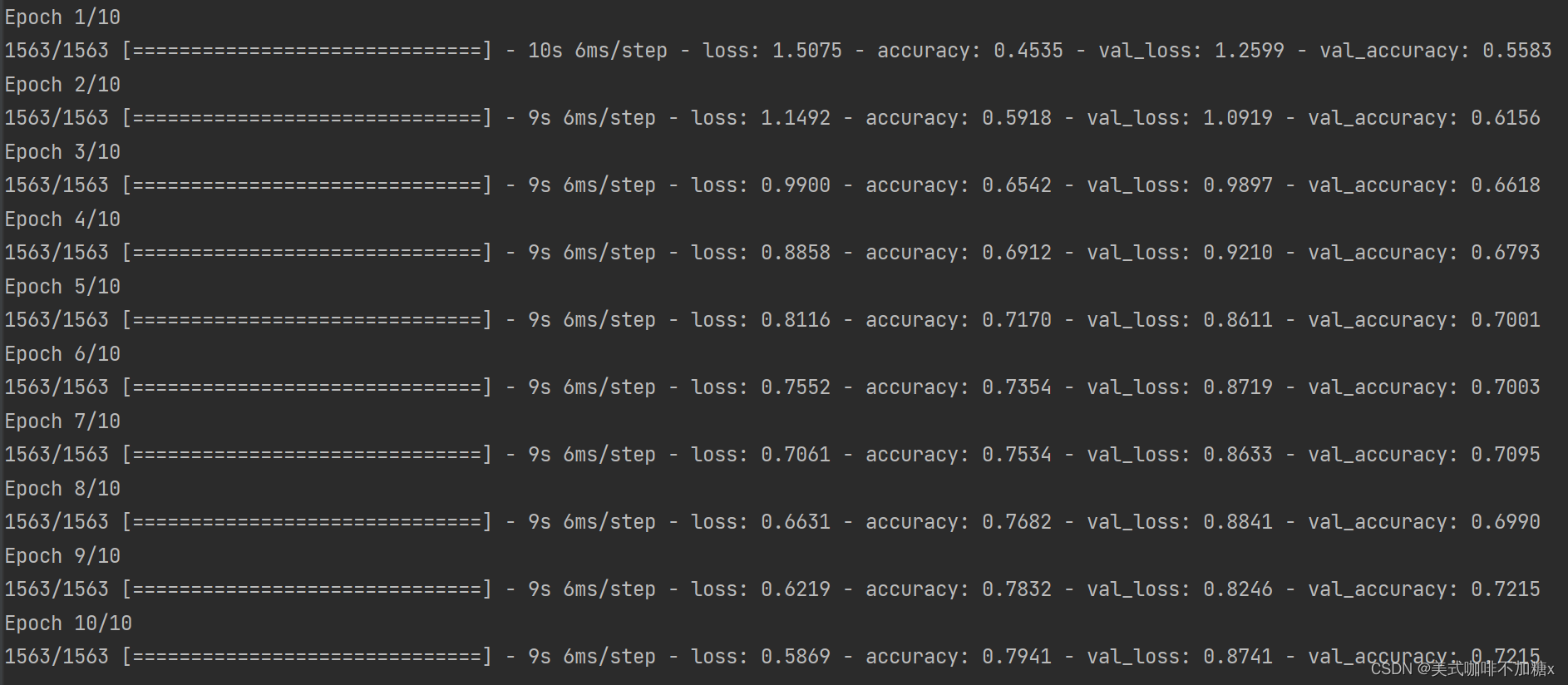

训练结果如下所示:

4. 评估模型

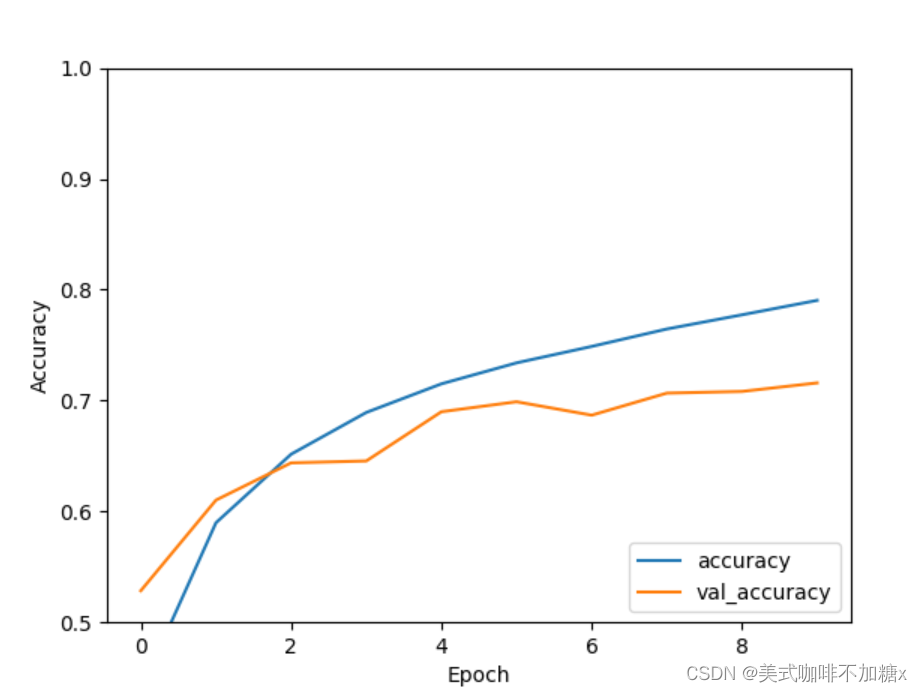

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label='val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0.5, 1])

plt.legend(loc='lower right')

plt.show()

我们可以看到准确率是随着epoch的增加而增加的。我们用model.evaluate()来评估模型的准确率。

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print(test_acc) # 0.7170000076293945

我们可以将epoch数值改成50/100,观察模型的效果会如何变化?

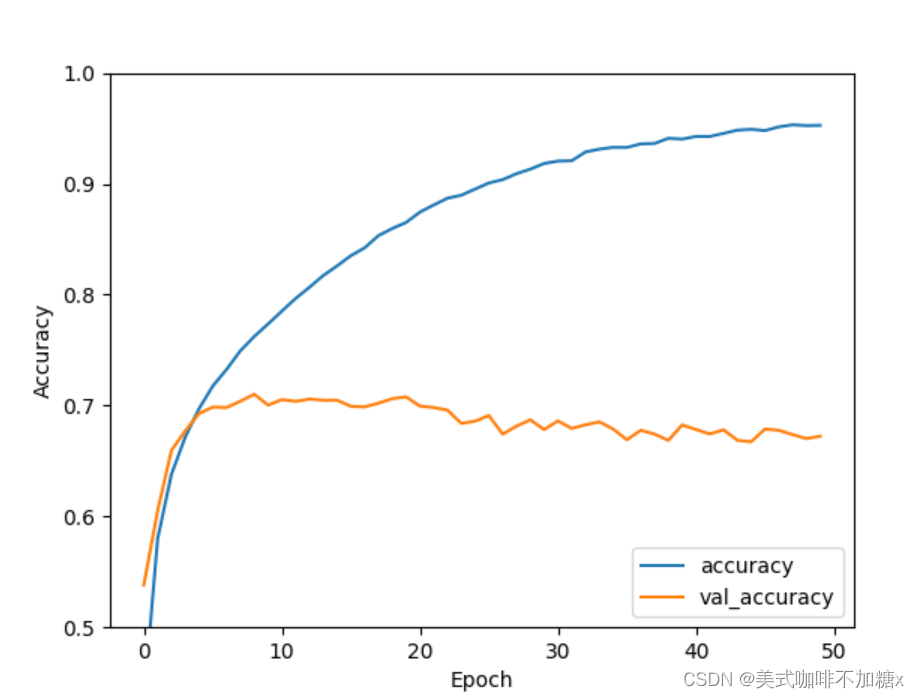

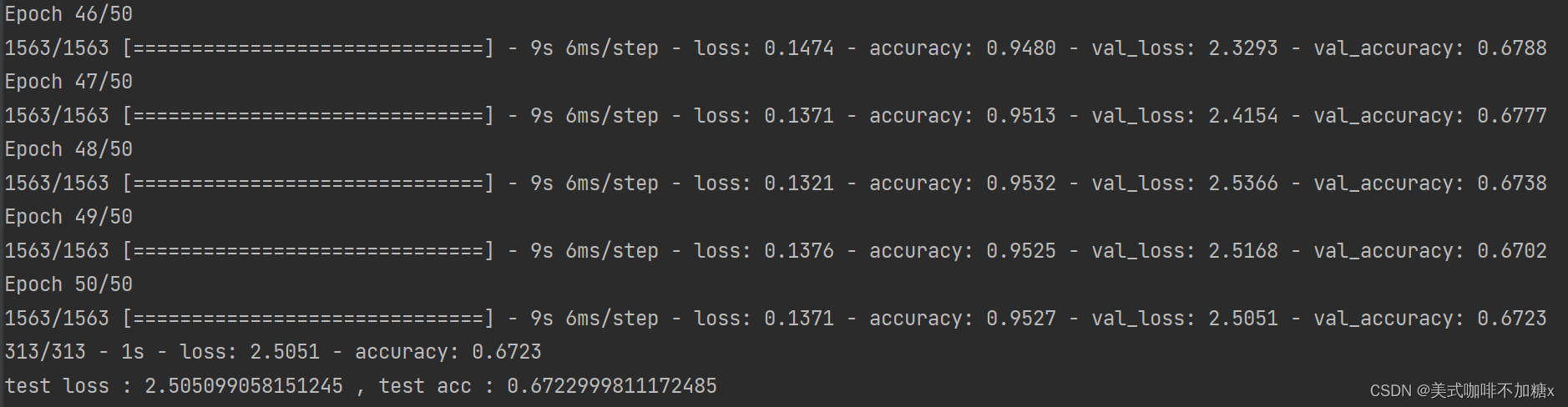

当epoch为50时,准确率如下所示:

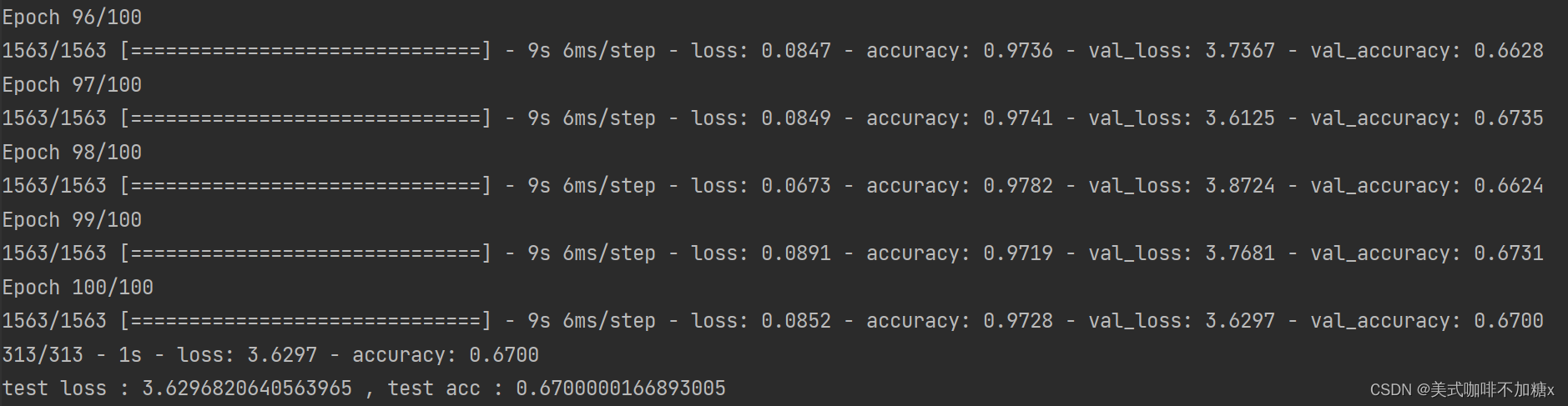

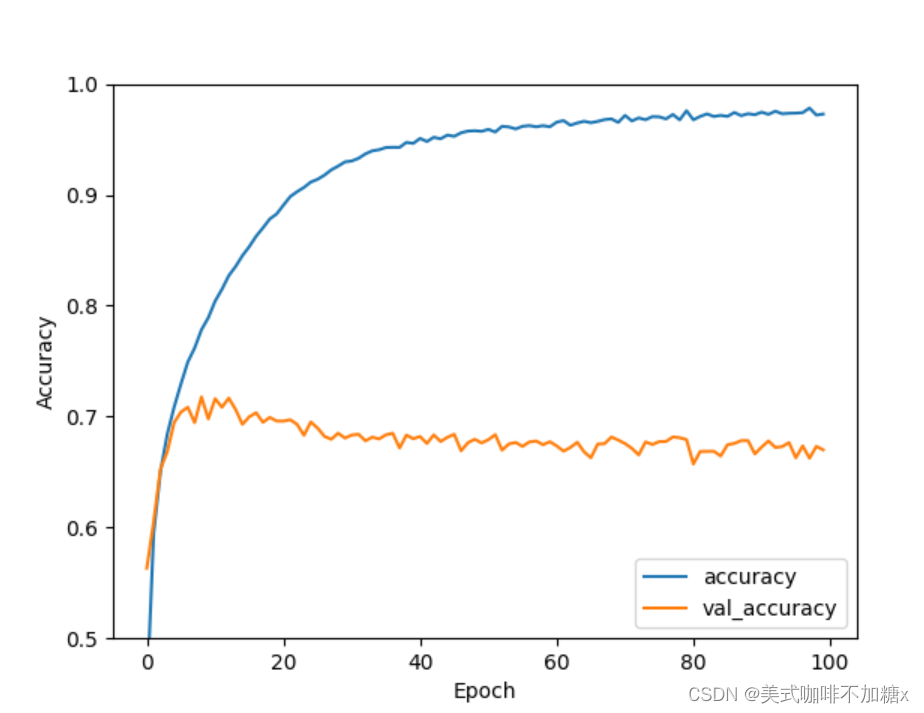

当epoch为100时,我们可以看到验证集准确率在第20-40个epoch中间呈现下降趋势(训练集准确率增长趋于缓慢)。

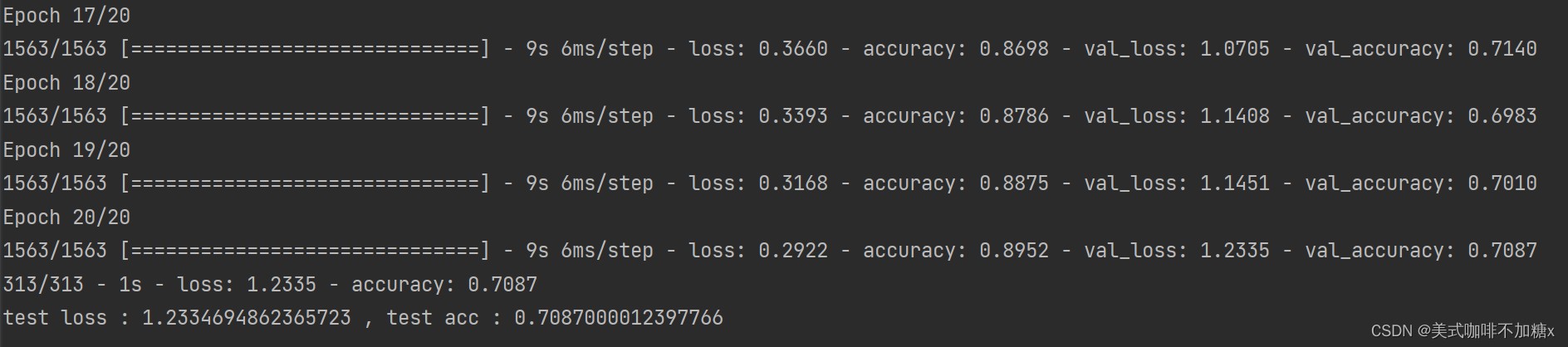

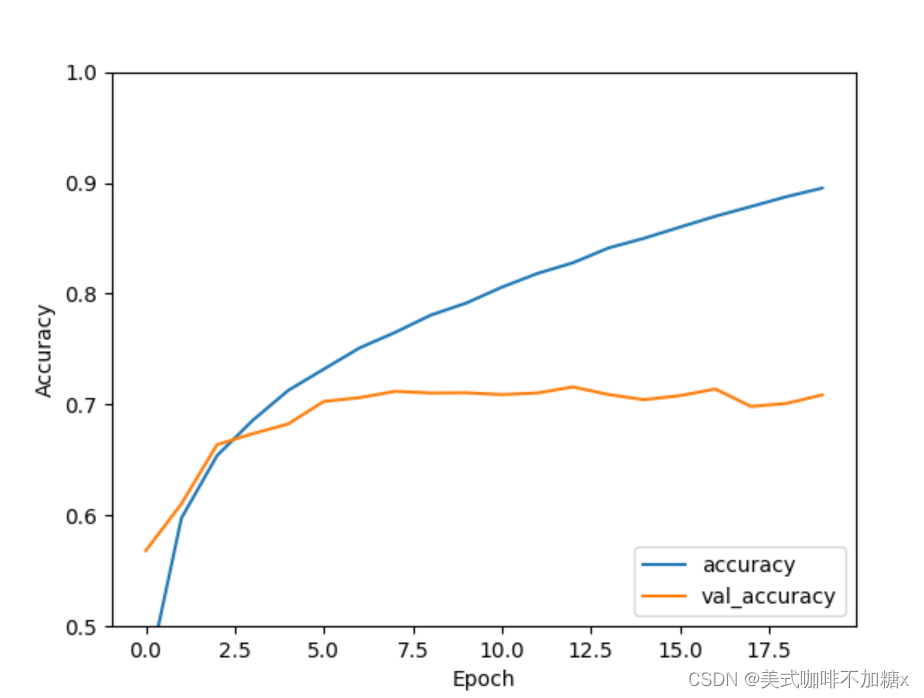

基于上述准确率的变化,我们将epoch设置为20,查看效果。

当epoch为20时,模型性能明显优于epoch为100时。我们认为,可能是因为当epoch=100时,模型过拟合。

上述我们构建的简单的CNN准确率已经达到了70%以上。对于只有几行的代码来说,效果不错!