本次学习笔记主要记录学习深度学习时的各种记录,包括吴恩达老师视频学习、花书。作者能力有限,如有错误等,望联系修改,非常感谢!

神经网络和深度学习(四)- 深层神经网络

- 一、深层神经网络(Deep L-layer neural network)

- 二、深层网络中的前向传播(Forward propagation in a Deep Network)

- 三、前向传播和反向传播(Forward and backward propagation)

- 四、核对矩阵的维数(Getting your matrix dimensions right)

- 五、为什么使用深层表示(Why deep representations?)

- 六、搭建神经网络块(Building blocks of deep neural networks)

- 七、参数vs超参数(Parameters vs Hyperparameters)

- 八、深度学习和大脑的关联性(What does this have to do with the brain)

第一版???????2022-05-15????????初稿

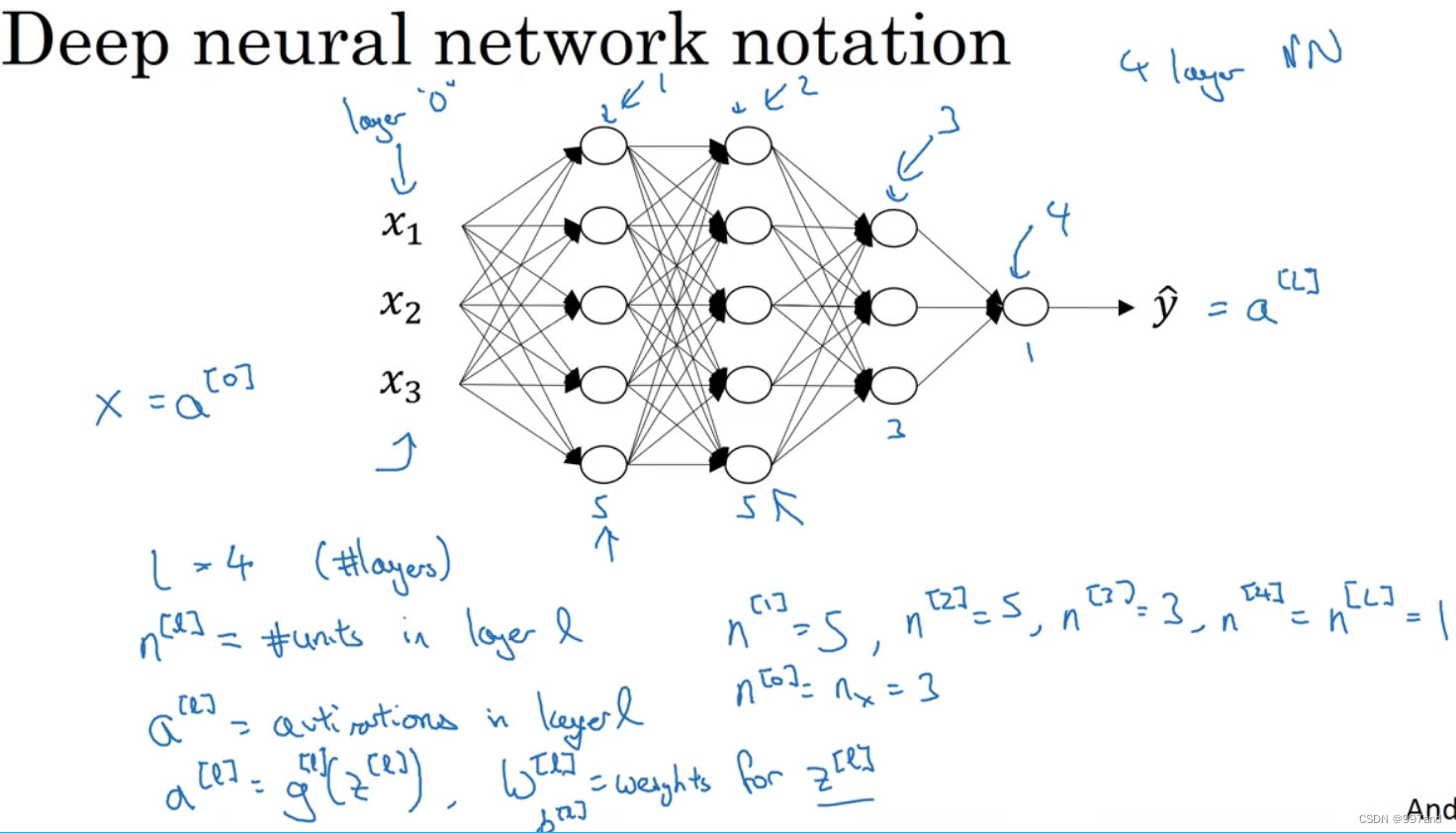

一、深层神经网络(Deep L-layer neural network)

1.逻辑回归是一个浅层模型

2.双层神经网络

3个隐藏层,其单元数目分别为5、5、3。

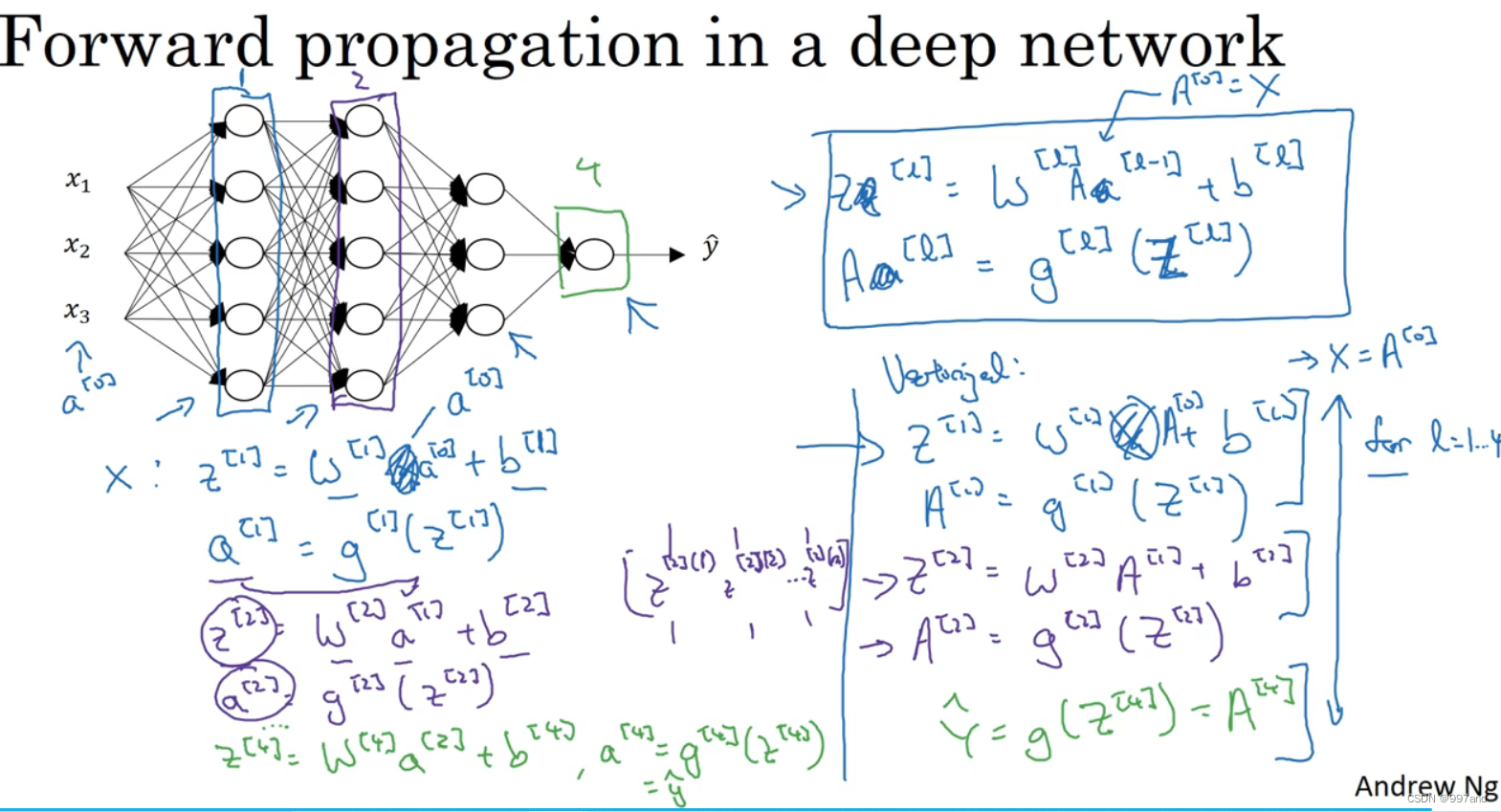

二、深层网络中的前向传播(Forward propagation in a Deep Network)

第一个隐藏层如图蓝色,第二个隐藏层如图紫色。

绿色为输出层。

向量化则用竖线右侧A。

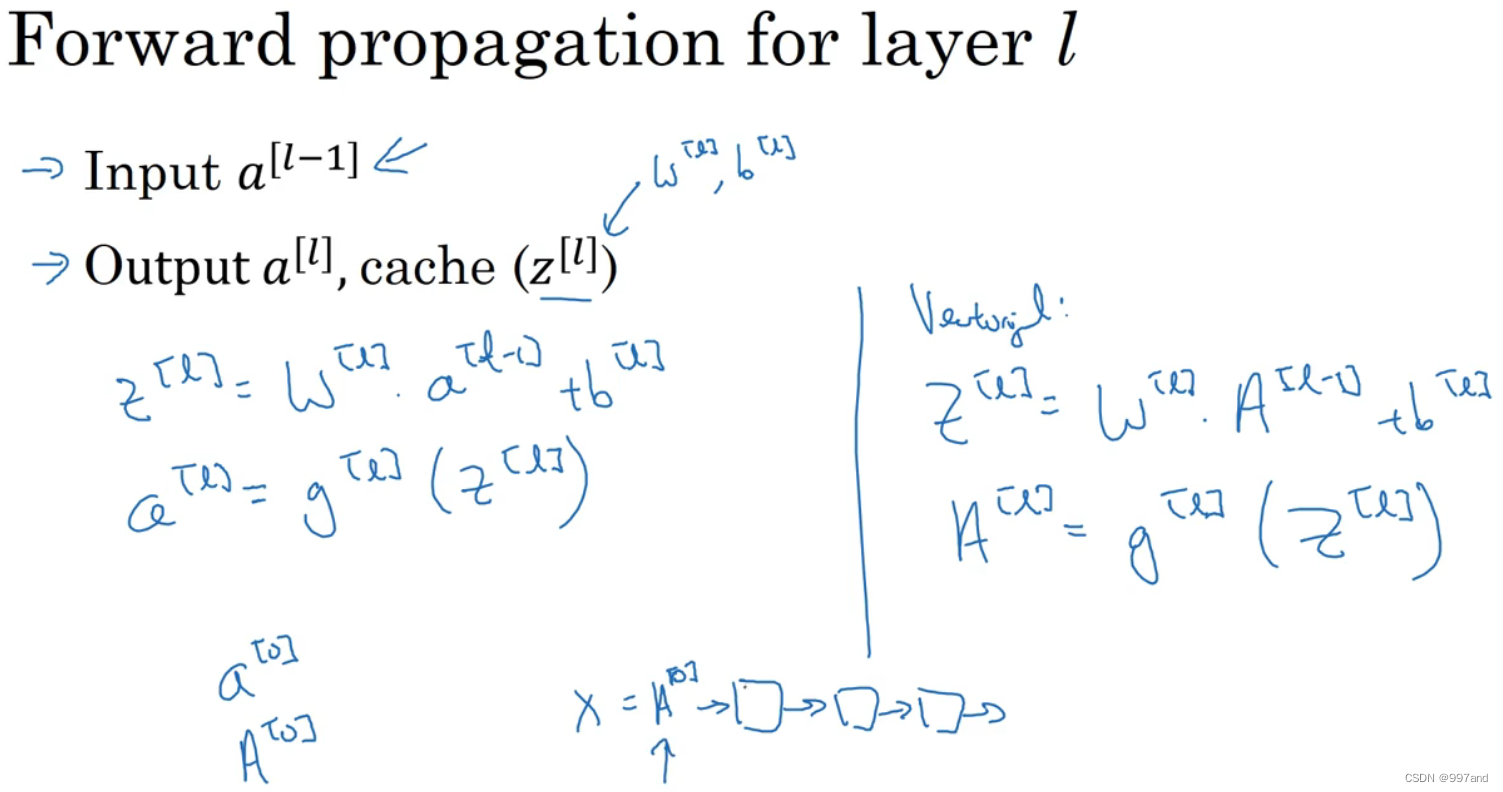

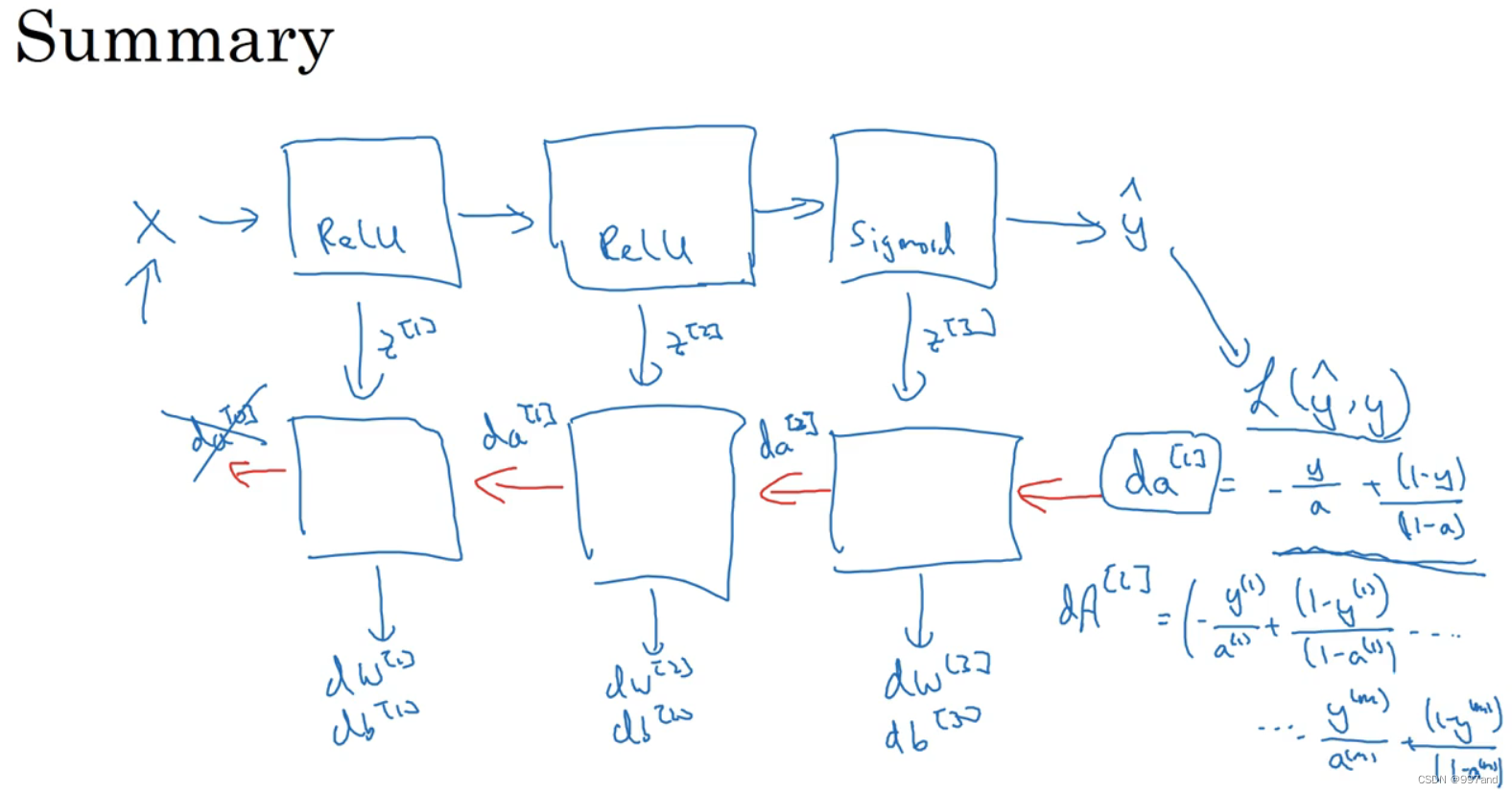

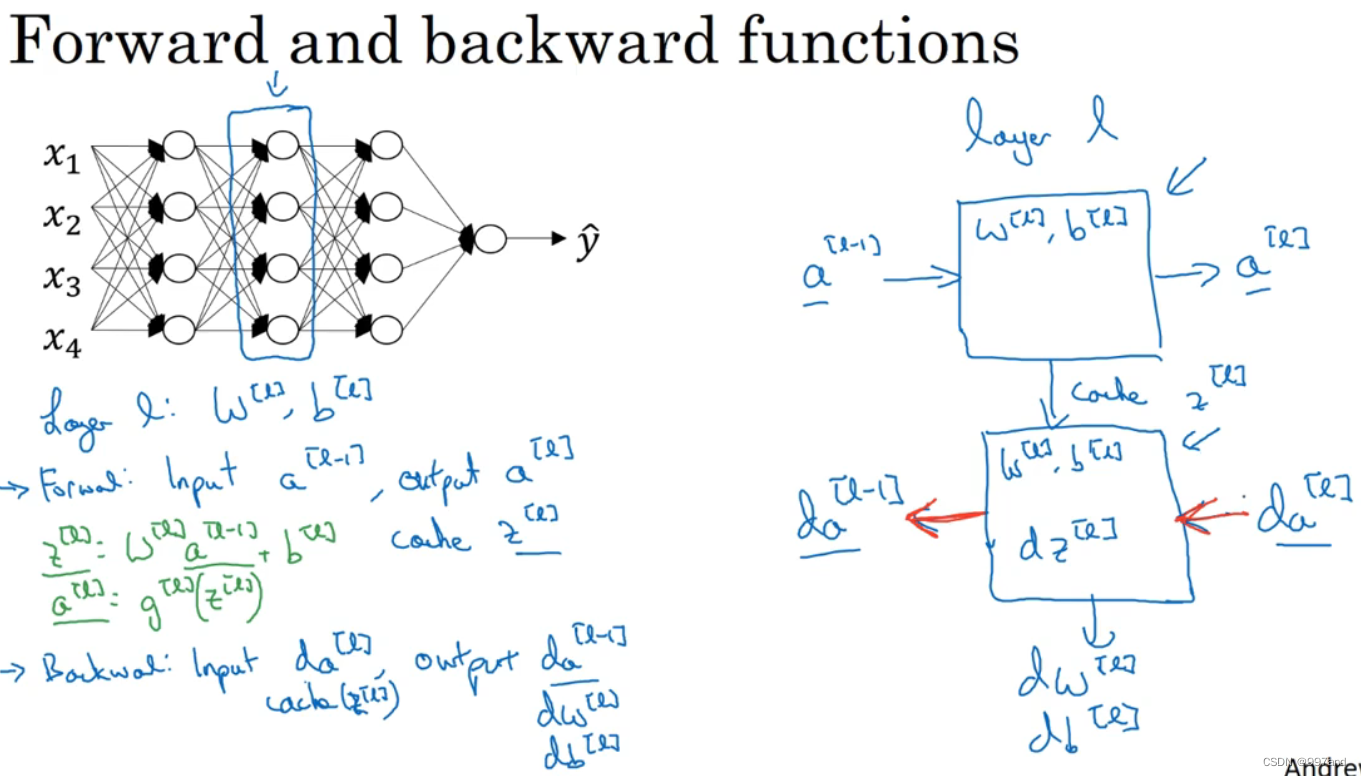

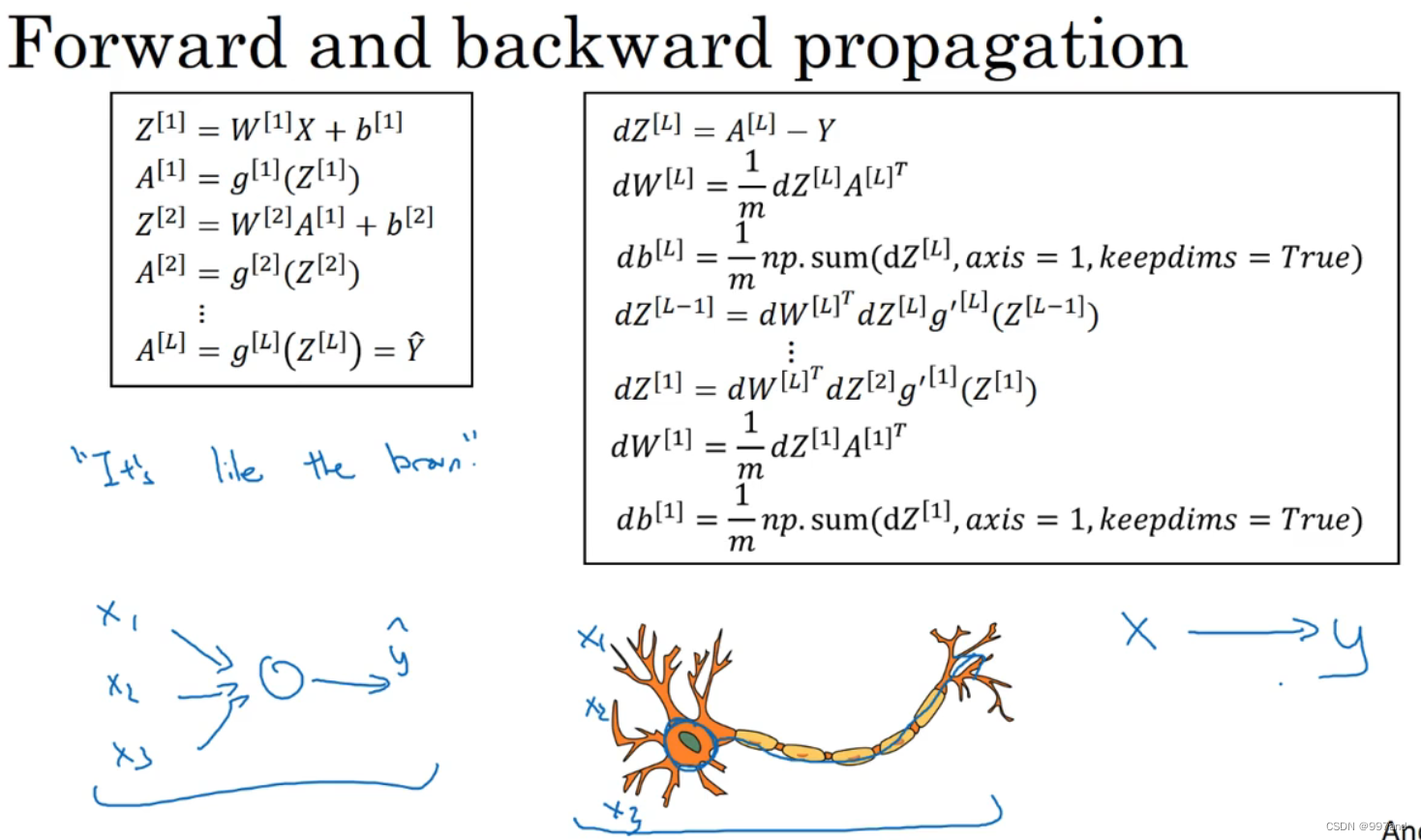

三、前向传播和反向传播(Forward and backward propagation)

先写出一模型,第一层Relu函数,第二层Relu,第三层sigmoid函数(做二分类的话),计算yhat,然后就可以向后迭代进行反向传播求导。

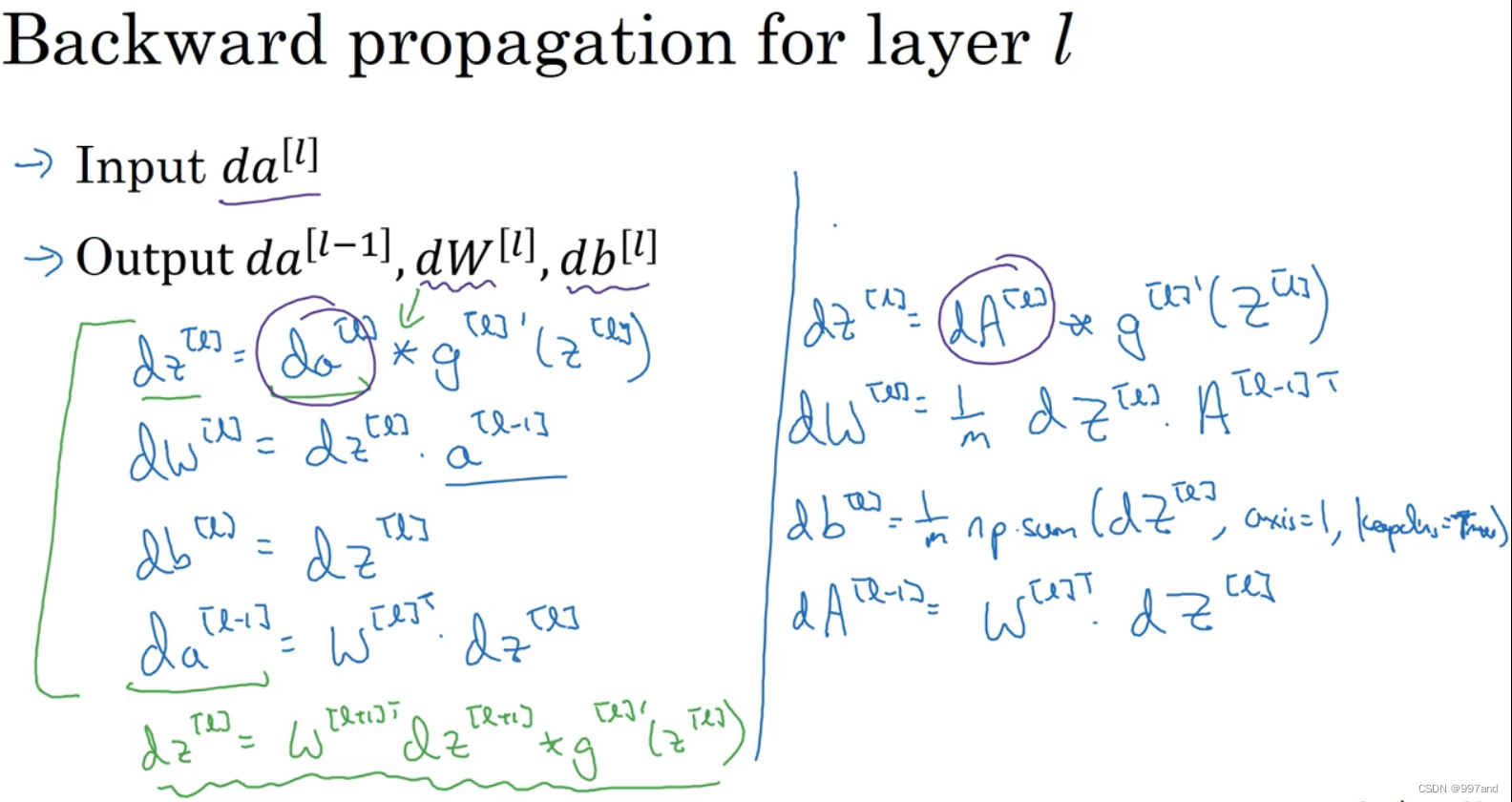

如图是 逻辑回归做二分分类时da,若想要向量化实现过程,就要用到dA。

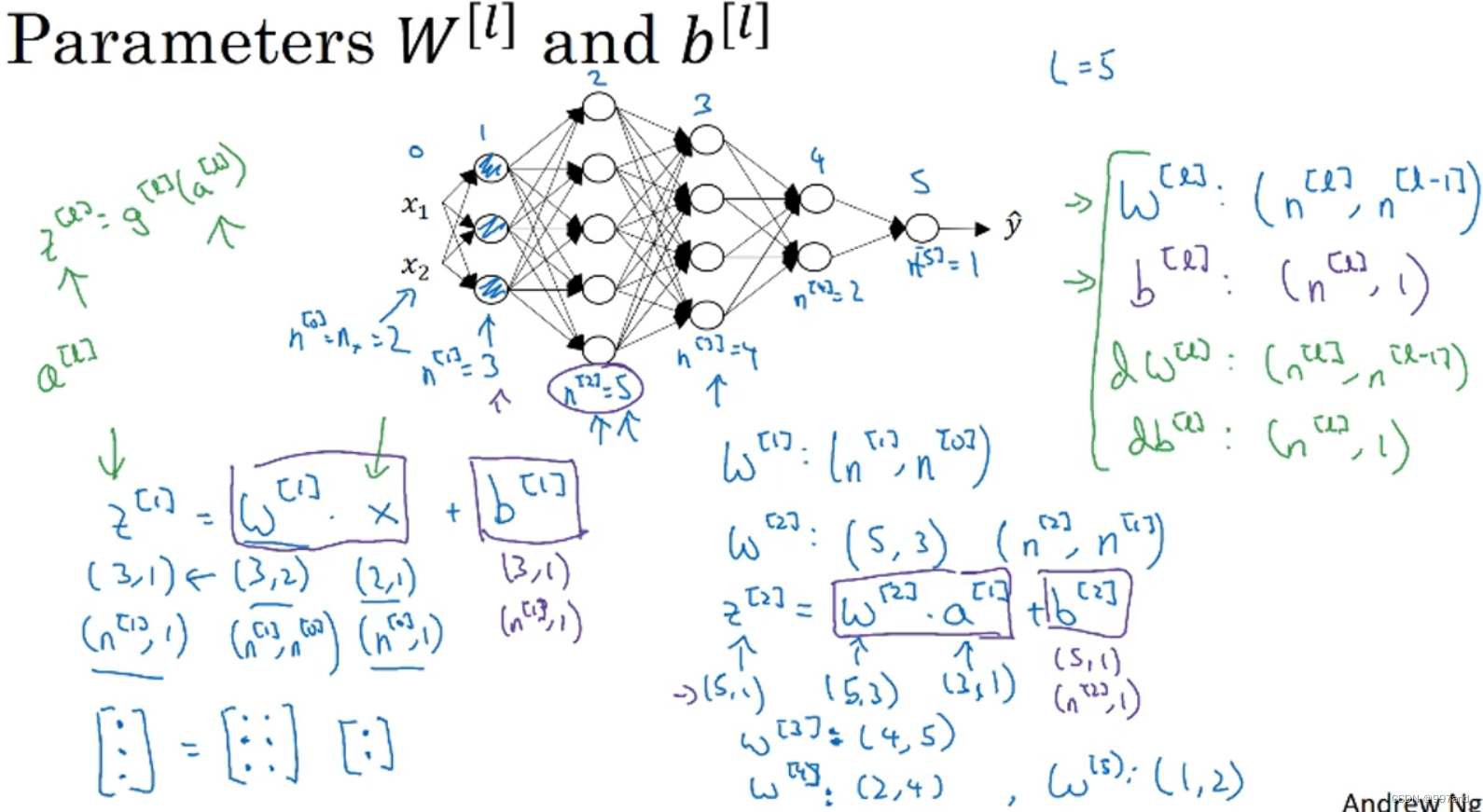

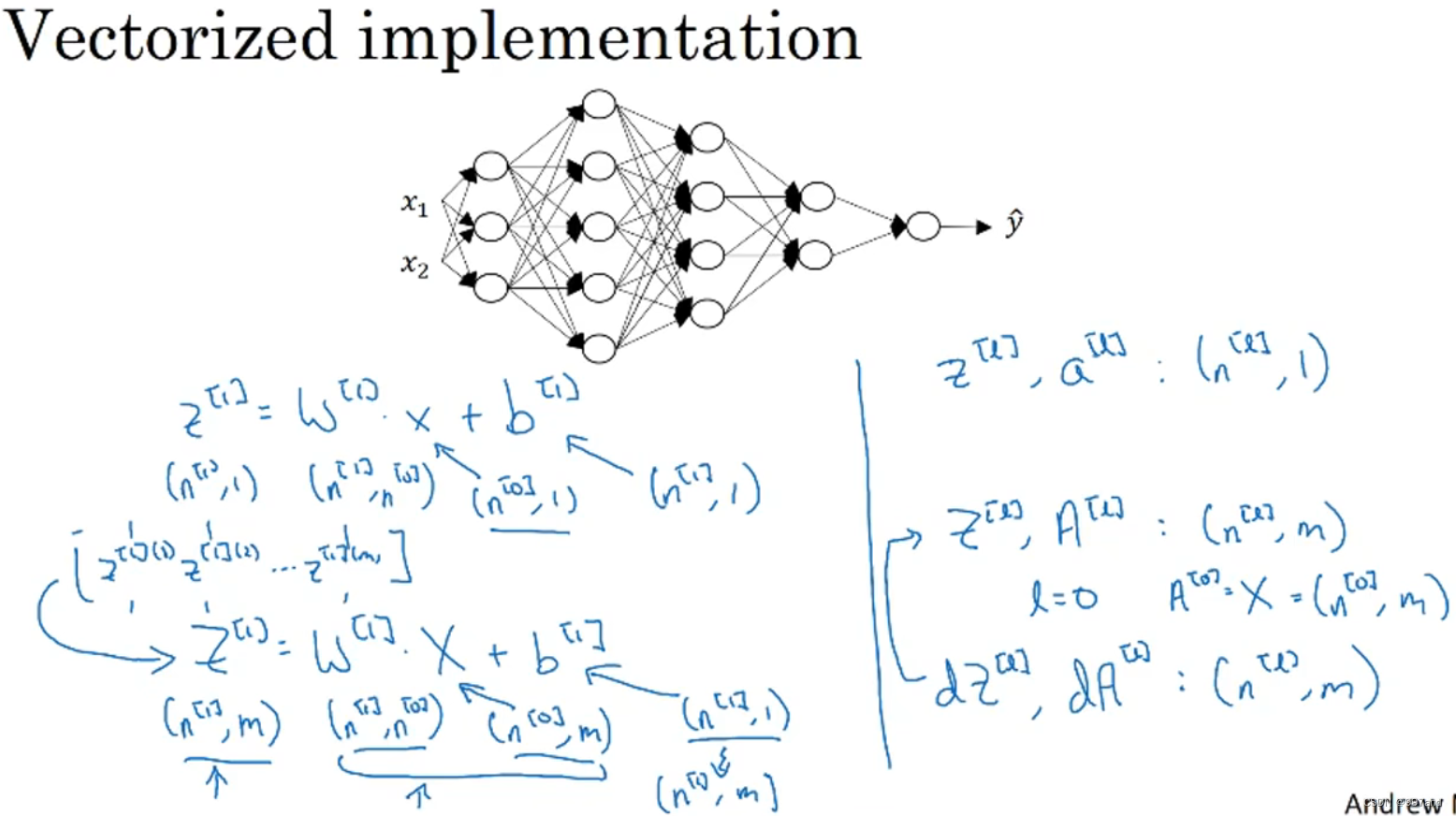

四、核对矩阵的维数(Getting your matrix dimensions right)

n[i]代表第i层的单元数目。

z是第一个隐藏层激活函数向量,z[i]维度(n[i],1)。

x的维度为(n[0],1),w[1]维度:(n[1],n[0])

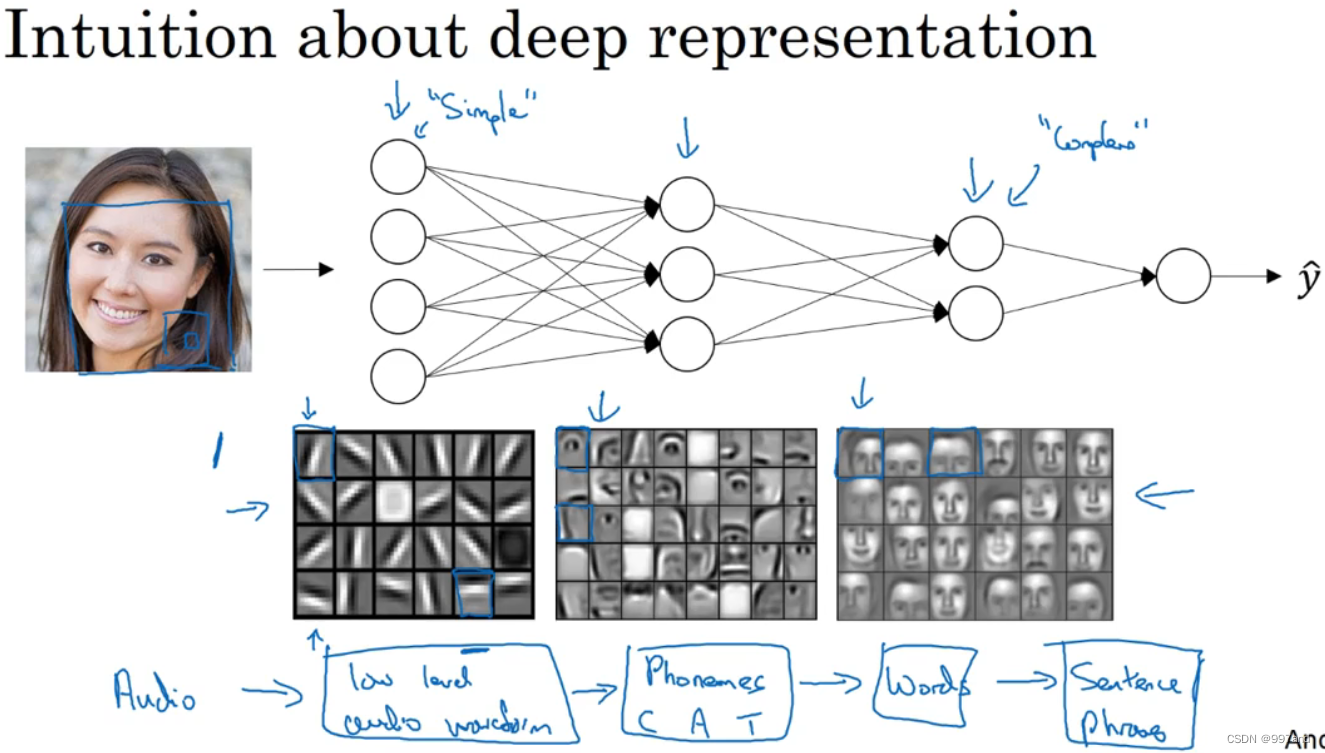

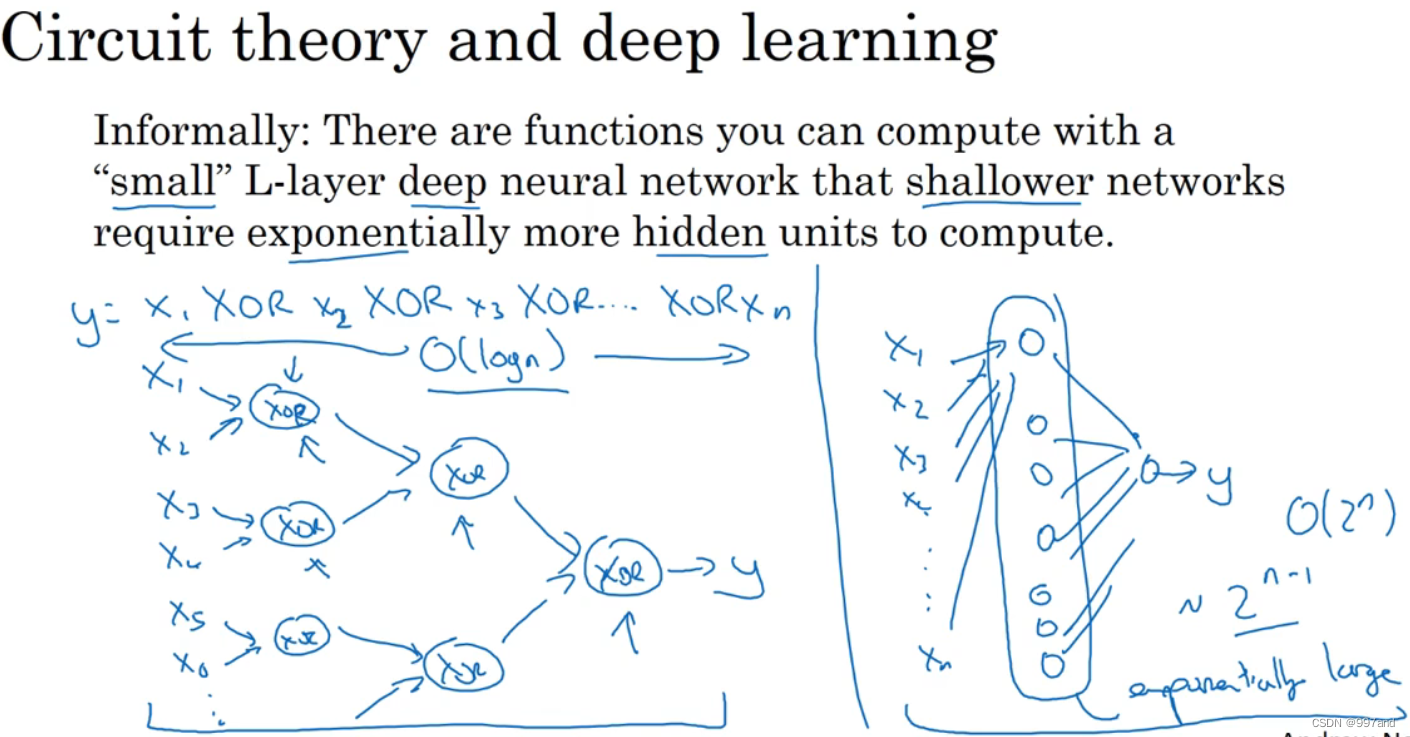

五、为什么使用深层表示(Why deep representations?)

输入图片,大概有20个隐藏单元的深度神经网络,或输入声频。

电路知识相关,与或非门。

六、搭建神经网络块(Building blocks of deep neural networks)

如上图方式计算后向传播的方式。

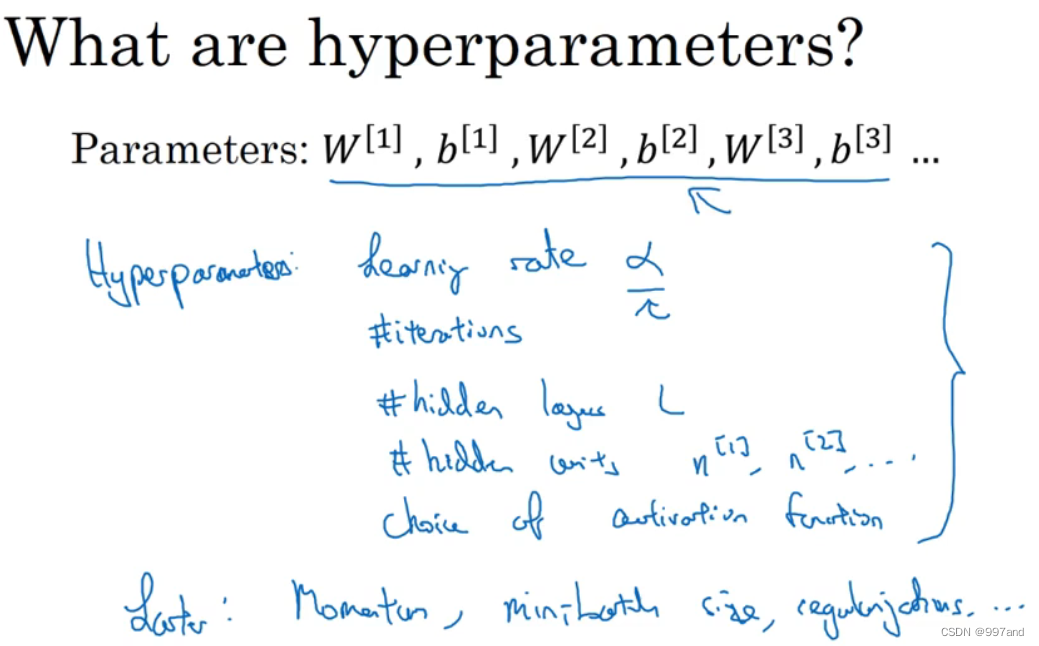

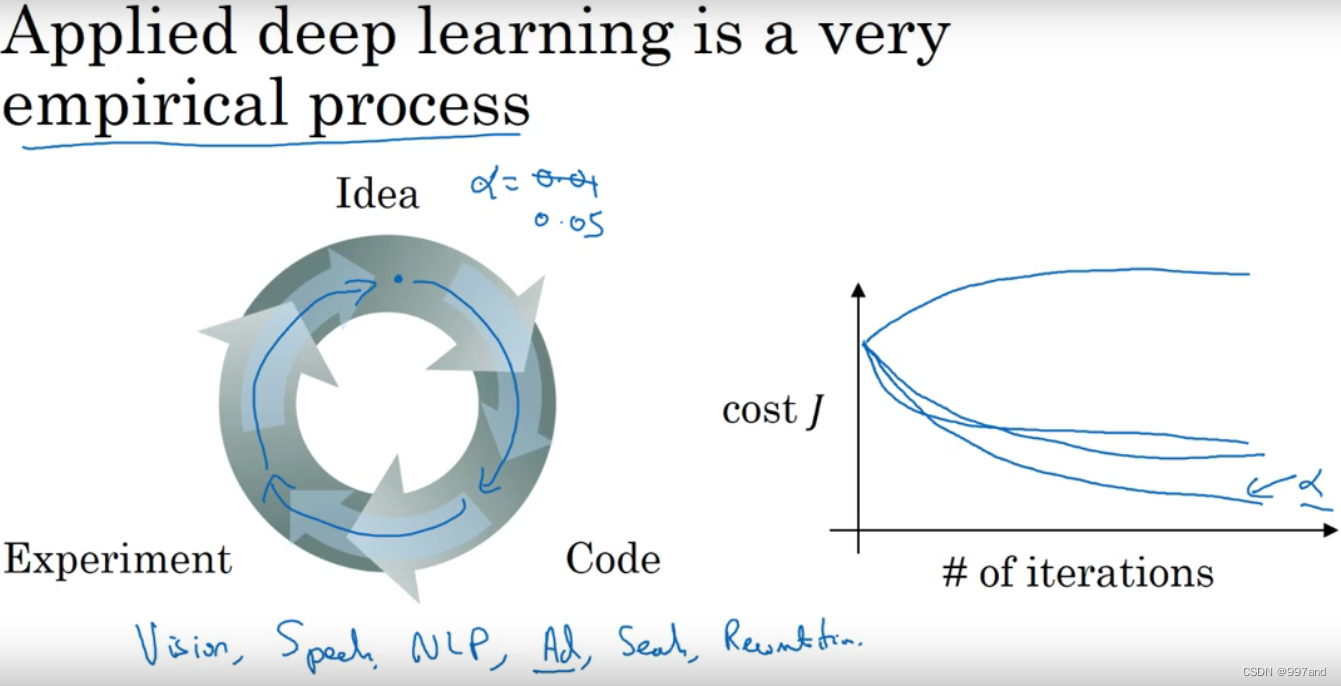

七、参数vs超参数(Parameters vs Hyperparameters)

w,b都是参数

超参数:学习率α等

八、深度学习和大脑的关联性(What does this have to do with the brain)

神经元似的。