监督学习和非监督学习

监督学习: 有标签的,回归和分类,场景:用户流失预测

非监督学习:无标签,聚类和降维,场景:用户细分

数据不平衡

类别不平衡。数据在某些维度上多,在有些维度上少。如流失用户比例多于非流失用户。

数据倾斜

分类问题:

给定一个分类问题,通常各类别中的训练数据并不完全均匀,尤其是在金融、医疗、交通等领域,数据高等倾斜,类间严重失衡的情况,那些样本数量与占据了样本容量绝大部分的主要种类比较,差距悬殊的少数样本恰恰是最重要的,在欺诈识别、欺诈识别、疾病检测、事故监控等方面具有广泛应用价值,多数类则可能会支配代价函数并阻止模型从倾斜数据中正确学习。

解决方法:

可以先尝试选择与权重相关的分类算法重塑类间权数以支持机器学习过程

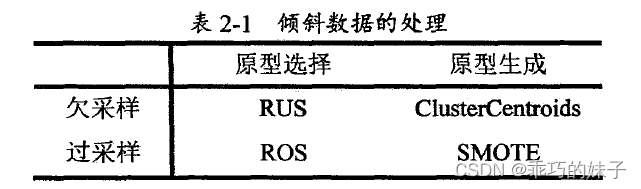

方法效果不佳的情况下,改从数据角度来找答案,从数据入手采取一些措施解决数据不平衡问题的思路其实很简单,无非就是使用数据采样算法转换训练数据以平衡类别分布,使各类别样本在数量上相等,按照采样结果分类,可分为欠采样和过采样,按照采样进行的方式,可分为原型选择和原型生成

随机欠采样(Random Under Sampler,RUS)从多数派中随机删除一些,随

机过采样(Random Over Sampler,ROS)从少数派中随机复制一些,ClusterCentroids基于K-Means聚类算法合成一些多数类样本,SMOTE基于KNeighbors分类器生成一些少数类样本。

在这里插入图片描述

- SMOTE(Synthetic Minority Over-sampling Technique)过采样小样本(扩充小类,产生新数据)

即该算法构造的数据是新样本,原数据集中不存在的。该基于距离度量选择小类别下两个或者更多的相似样本,然后选择其中一个样本,并随机选择一定数量的邻居样本对选择的那个样本的一个属性增加噪声,每次处理一个属性。这样就构造了更多的新生数据。(优点是相当于合理地对小样本的分类平面进行的一定程度的外扩;也相当于对小类错分进行加权惩罚(解释见3))

特征工程

输入空间 映射 特征空间

特征方法