文章目录

1.论文地址

https://arxiv.org/abs/1311.2901

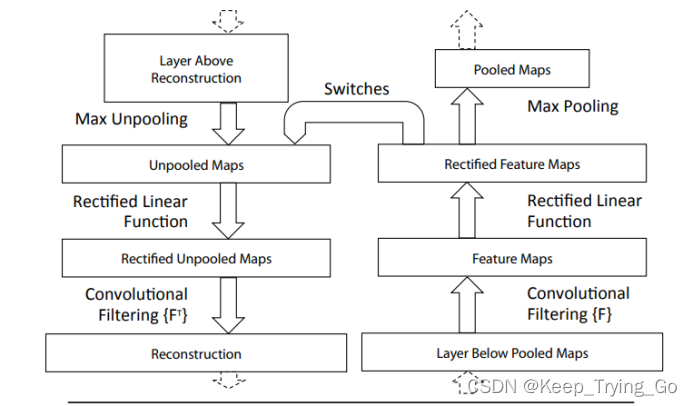

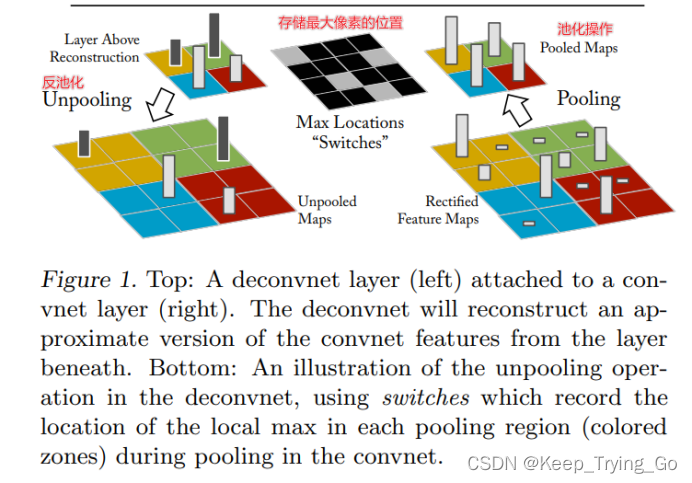

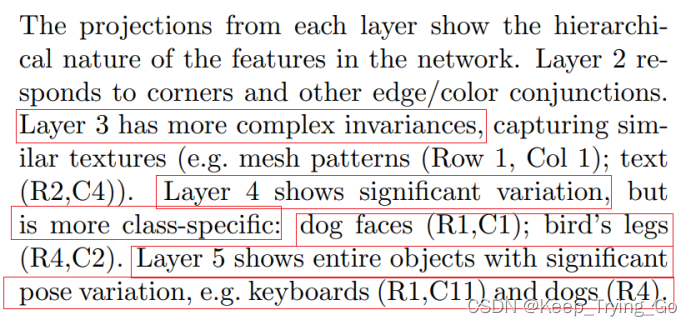

2.反卷积可视化

首先找到时激活最大的原始图像,将原始图像经过卷积之后,再将中间层的feature map重构回原始输入像素空间可视化。

3.为什么要可视化卷积神经网络呢?

主要是因为卷积的过程是一个黑箱子,知道卷积神经网络可以提取特征进行分类,但是却不知道其中到底提取的是什么特征,那么对模型的改进就是一个试错和碰运气的过程。所以需要对卷积层的特征图进行可视化,便于对其中提取的特征很好的理解。

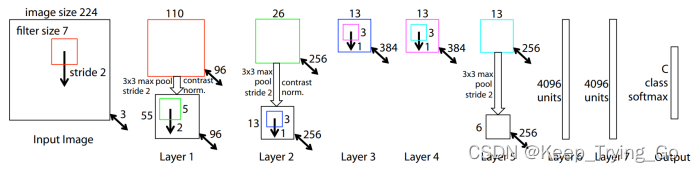

4.改进的AlexNet

将卷积层的第一层卷积的11x11改为7x7;将conv3,4,5的卷积核从384,384,256改为512,1024,512.

注:AlexNet

https://mydreamambitious.blog.csdn.net/article/details/124077928

注:是什么致使卷积神经网络有很好的突破效果呢?

(1)大规模的数据集:Imagenet;

(2)计算机的计算性能提升;

(3)新的正则化方法:Dropout——防止过拟合;

5.反池化

最大池化不是可逆的,但是可以存储在采样最大像素的位置;反池化时就可以还原了,但是不可避免的会丢失非极大值像素信息。

6.反激活和反卷积

正向的时候使用的ReLU激活函数保留正值;反卷积时也使用ReLU保留正值。

反卷积:使用转置后的卷积核(使用的卷积核是同一个)。

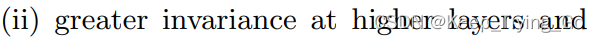

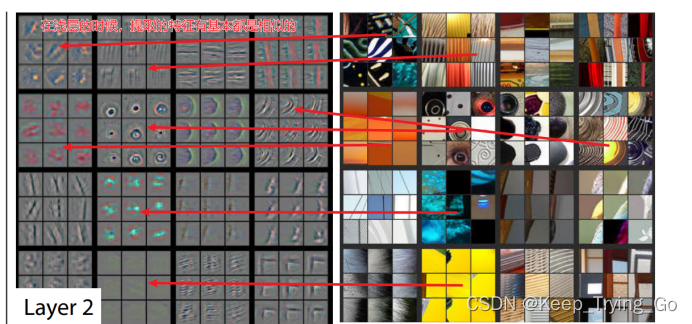

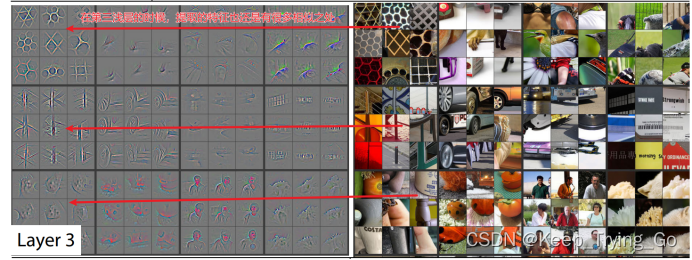

7.不变性

不变性:随着网络的加深,从不同的图像中提取到相同的部分,越来越关注图像的语义信息,而非空间信息。

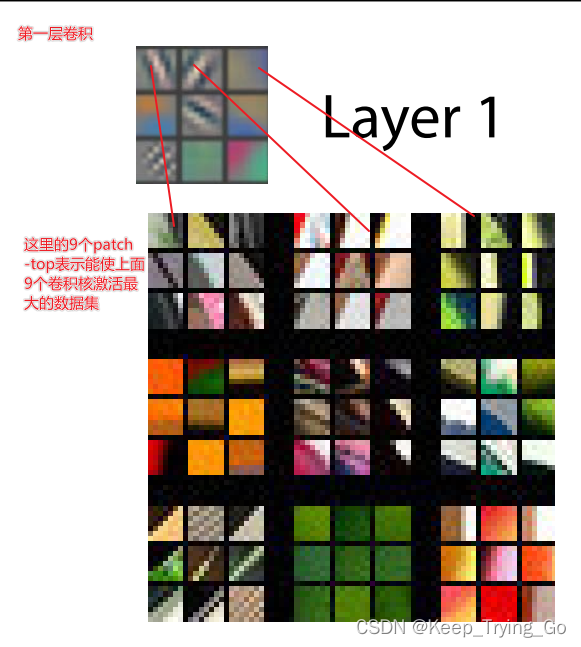

从下面的图可以看到:当在卷积浅层的时候,提取的特征很相似,同时对应的原始图像都有很多相同的特点;然而在卷积深层的时候,可以看到大部分的图片相似性很少,但是提取的特征却都是相似的,同时也说明的上面的不变性;

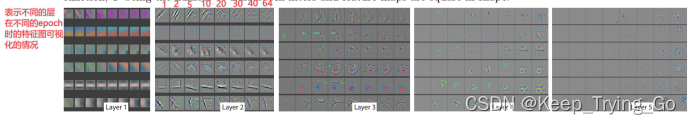

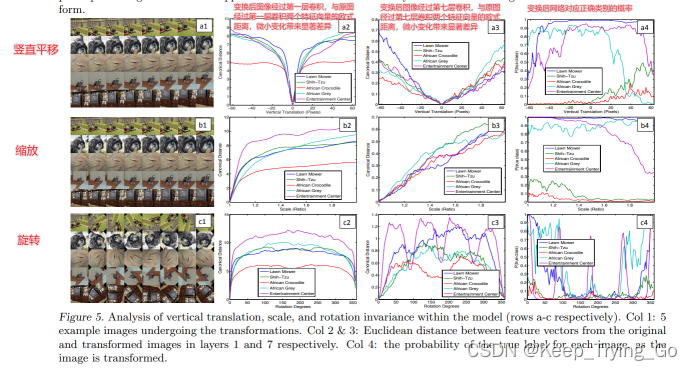

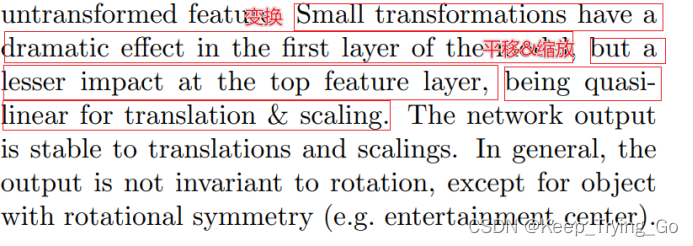

8.训练过程中不同层特征演化可视化,平移,缩放和旋转敏感分析

变换对底层的影响更加的显著,对高层的影响较小;网络对平移,缩放不是很敏感;对旋转敏感显著。同时也说明了深层提取的是高级特征,而浅层关注的是空间特征。

随着层数的增加,提取的特征发生了改变,说明层数的增加,提取的特征也越来越高级和特化。

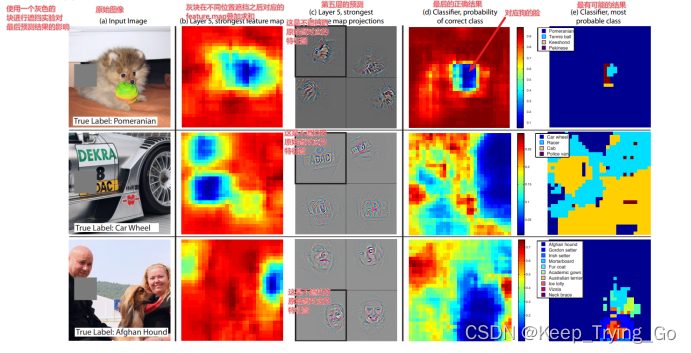

9.遮挡敏感分析

网络关注的是局部的区域呢,还是关注的是整体呢?

第一列图是原始的输入图像,第二列是使用灰块遮挡之后对应的feature map叠加之后的结果,可以看到当对敏感的区域遮挡之后,最后的结果显著降低;

第三列是激活最大的元数图,经过重构之后的特征图feature map,可以看到敏感的区域是狗脸,字母和人脸;画黑框是表示不进行遮挡对应的特征图feature map;

第四列对应的是最后正确类别的结果;

第五列是最后最可能的结果。

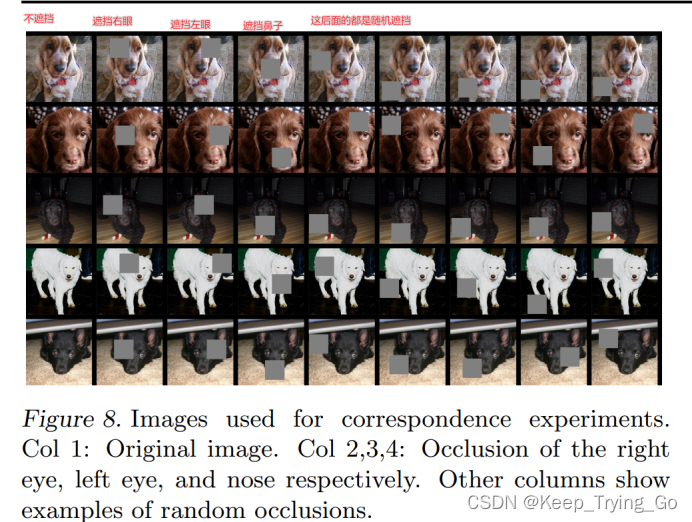

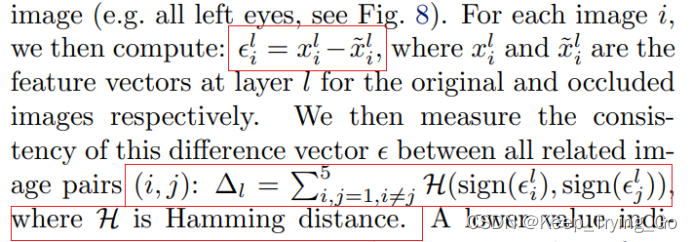

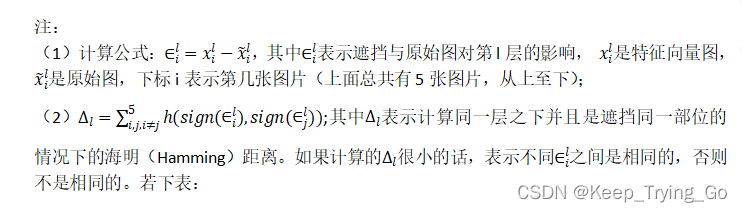

10.局部相关性遮挡分析

深度学习并没有显式的定义图像中各部分的关系,而实际上像人的脸,眼睛和鼻子之间是相关的。所以猜想深度学习模型隐式的定义之间的关系,为了验证这个猜想,使用局部相关性遮挡分析:

从上面的表可以看到,对于不同的特这图,遮右眼,遮左眼,遮鼻子造成的结果是一样的,也就是对网络提取的特征影响是相同的,说明了右眼是被隐式的定义在了模型之中。

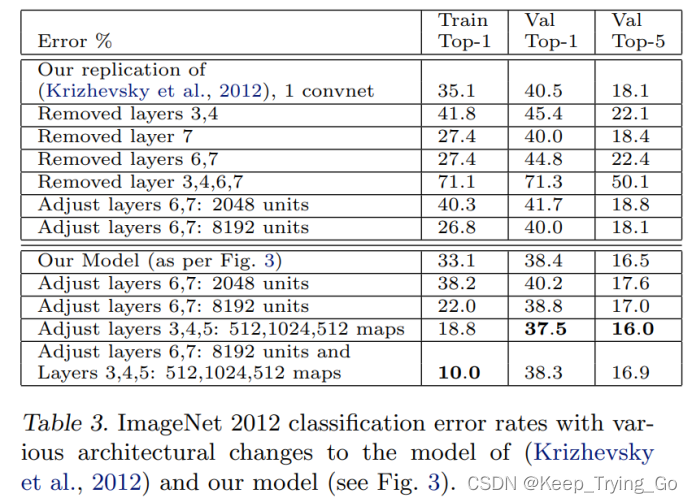

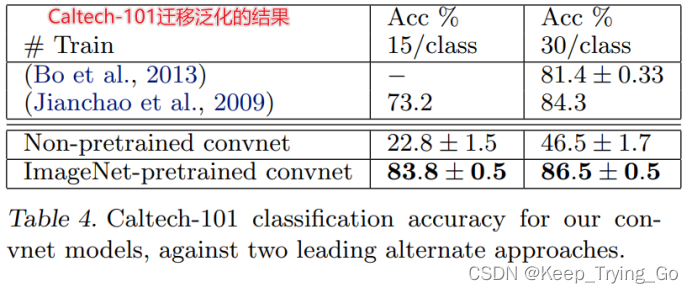

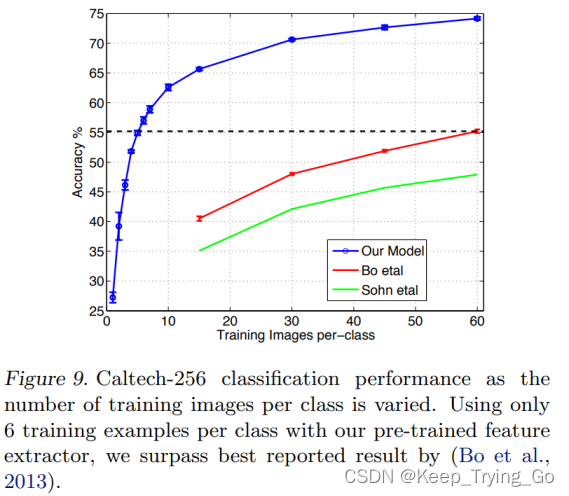

11.在Imagenet上训练的模型迁移学习泛化分析;Caltech-101,Caltech-256,PASCAL VOC 2012;全连接层和卷积层去除的性能分析;各层特征有效性能分析

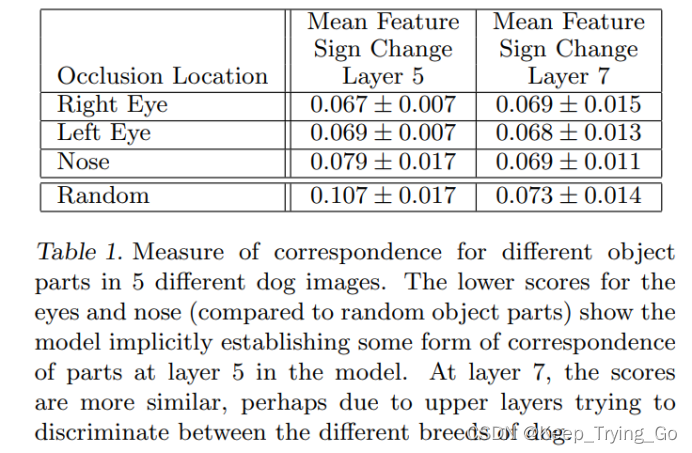

从表中可以得到:当去掉卷积层3,4的时候,影响不大;当去掉卷积层7 的时候影响也不大;当去掉卷积层6,7的时候影响也不大;但是当去掉卷积层3,4,6,7的时候,错误率将很大;增加神经元的个数会出现过拟合;将卷积层的3,4,5增加到512,1024和512的时候效果最好。

可以看到在Imagenet数据集上迁移泛化的结果很不错,主要是因为Imagenet数据集中很多的图像都是只包含一个物体,所以迁移泛化之后每个类别只需要少量的图片进行训练就可以达到很好的效果;而对于PASCAL VOC 2012上进行迁移学习泛化的结果不怎么好,主要是因为PASCAL数据集中很多的图片都是一张图片包含很多个物体。

关于使用ResNet50微调(迁移学习)训练数据对比:

https://mydreamambitious.blog.csdn.net/article/details/123966676