文章目录

- Challenges, Techniques, and Trends of Simple Knowledge Graph Question Answering: A Survey

- Abstract

- 1 Introduction

- 2 Methodology

- 3 Result

- 4 Discussion

- 4.1 Existing KGSQA Systems with Its Models, Achievements, and Strengths and Weaknesses

- 4.1.1 Bordes et al.’s System

- 4.1.2. Yin et al.’s System

- 4.1.3. Dai et al.’s System

- 4.1.4. He and Golub’ System

- 4.1.5. Lukovnikov et al.’s System

- 4.1.6. Zhu et al.’s System

- 4.1.7. Türe and Jojic’s System

- 4.1.8. Chao and Li’s System

- 4.1.9. Zhang et al.’s System

- 4.1.10. Huang et al.’s System

- 4.1.11. Wang et al.’s System

- 4.1.12. Lan et al.’s System

- 4.1.13. Lukovnikov et al.’s System

- 4.1.14. Zhao et al.’s System

- 4.1.15. Luo et al.’s System

- 4.1.16. Zhang et al.’s System

- 4.1.17. Li et al.’s System

- 4.2. Open Challenges in the Future Research

- 4.3. Recommendation建议

- 5. Conclusion

Challenges, Techniques, and Trends of Simple Knowledge Graph Question Answering: A Survey

Yani, M.; Krisnadhi, A.A.

Challenges, Techniques, and Trends

of Simple Knowledge Graph

Question Answering: A Survey .

Information 2021, 12, 271. https://

doi.org/10.3390/info12070271

Abstract

简单问题是用于评估知识图问答(KGQA)的最常见问题类型。简单问题是一个问题,它的答案可以被一个带有一个关系或谓词的factoid statement(事实陈述)捕获。知识图问答(KGQA)系统的目标是在知识图(KG)上自动回答自然语言问题(NLQ)。在这一领域有各种不同的研究方法。然而,缺乏一项全面的研究来关注从各个方面解决简单问题,这是显而易见的。在本文中,我们对回答简单问题进行了全面调查,对现有技术进行分类,并比较其优缺点,以便更好地了解现有问题,并提出建议,指导未来的工作。

关键词:知识图;问答;简单的问题;调查

1 Introduction

知识图问答(KGQA)系统使用户能够从知识图(KG)中检索数据,而无需完全理解KG模式。用户可以通过自然语言问题(NLQ)的形式表达他们的信息需求,而不是用特定的正式查询语言表达精确的查询,从而从KG获取数据。

实现这样一个系统需要解决输入NLQ(非结构化)和KG中数据表示的期望答案之间的差距,KG中的数据是结构化的,可能在复杂模式下指定。这一挑战并不令人惊讶,因为开发性能良好的KGQA系统需要完成许多子任务,例如实体链接、关系链接和答案检索。对这些任务的各种解决方案的研究导致KGQA成为一个令人兴奋的研究方向。过去几年中,许多KGQA系统的开发也表明了这一点。

1.1. Motivation: Why Simple Questions?

这项调查的重点是在KGQA(简而言之,KGSQA)中回答简单问题的问题。==简单问题与复杂问题的区别在于前者隐式包含一个关系实例,而后者包含多个关系实例。==例如,“印度尼西亚的首都在哪里?”这是一个简单的问题,因为它只对应于一个关系实例,即“谁是日本首都的市长?”是一个复杂的问题,因为它包含两个关系实例,即“is mayor of”和“is capital of”,假设上述关系实例是目标KG词汇表的一部分。请注意,一个问题中关系实例的数量也代表了需要从KG获得答案的三重陈述的数量。

许多设计用于处理复杂问题的KGQA系统通过将输入的复杂问题分解为简单问题[1–9]来接近复杂KGQA。由于这些KGQA系统将KGSQA的解决方案作为整个系统的关键构建块,因此它们的端到端性能显然取决于KGSQA的解决程度。此外,分解方法通常优于其他方法,因此更加强调解决KGSQA的重要性。

即使是设计用于处理复杂问题的最先进的KGQA系统,在处理简单问题时也会遇到性能问题,这一事实进一步==突显了KGSQA解决方案对复杂KGQA的重要性。==例如,Yang等人[1]提出的系统在处理由单个谓词或关系组成的琐碎问题时会产生错误。同时,在Hu等人[12]提出的系统中,简单的问题会导致关系映射中31%的错误。同时,参考文献[13–15]认识到,输入的简单问题(即问题内容不明确)和生成的问题候选答案中的模糊性都会导致性能问题。此外,正如我们的调查所发现的,目前性能最好的KGSQA解决方案[16]的准确率仅低于90%。这表明,对KGSQA进行进一步研究是合理的,对这一领域进行重点调查将对其有益。

KGSQA研究的另一个方面是基准数据。KGQA系统有几个用于衡量性能的基准数据集。这些数据集中的大多数,如WebQuestions[17]、ComplexWebQuestions[18]和LC QuAD 2.0[19] 都包括简单问题和复杂问题。SimpleQuestions数据集[20]是一个例外,它是唯一一个只包含简单问题的数据集。该数据集也是所有现有基准数据集中最大的,有超过10万个Freebase问题,因此被视为KGSQA的事实基准。然而,自2016年以来,Freebase已经停产,这给数据集的使用带来了一些实际困难。幸运的是,已经有人尝试分别使用Wikidata[21]和DBPedia[22] 作为基础KG来开发该数据集的替代版本。还要注意的是,即使在包含简单问题和复杂问题的数据集中,它们所包含的简单问题的比例也可能很大。例如,WebQuestions包含85%的问题,可以通过单个谓词/关系[2]直接解决。大量简单问题数据集的可用性为KGQA系统采用深度学习铺平了道路,这是我们调查的一个关键点。

最后,从实用的角度来看,2019年和2020年谷歌搜索引擎上最常见的100个问题都是简单的问题。

1.2. Related Surveys

以下是过去四年在KGQA领域发布的另外三份调查报告。首先,H?ffner等人[23]对语义Web中的问题回答问题进行了调查。在他们的调查中,H?ffner等人使用术语(语义网)知识库来指代知识图。从2010年到2015年,他们调查了72份出版物中描述的62个系统。他们认为KGQA系统必须面对的七个公开挑战,即多语言、歧义、词汇差距、分布式知识、复杂的查询、非事实(即程序、时间和空间)问题以及模板。然后,调查根据这些挑战对系统进行了分类,而不是具体讨论它们的优缺点。调查也没有讨论被调查系统在多大程度上实现了端到端KGQA性能。

Diefenbach等人[24]提出了另一项关于(语义网)知识库的QA调查。主要集中在已在QALD基准系列上明确评估的KGQA系统;该基准测试系列在附录A中简要描述,涵盖2012年至2017年发布的33个系统。在他们的调查中,Diefenbach等人确实对WebQuestions和SimpleQuestions数据集上评估的几个KGQA系统进行了简短的讨论,但这并不是主要关注点。只有2017年出版的两个系统被提及;其余的都是早些时候发表的。调查本身是基于KGQA中不同的子任务进行组织的,即问题分析、短语映射、消歧、查询构建和分布式知识。 在精确度、查全率和f -测度方面提供了比较。对于每个讨论的子任务,对相关的研究挑战进行了简要的讨论。此外,最后还对这些挑战的演变进行了一般性讨论。

相比之下,我们的调查除了对这5个系统进行详细阐述外,还涵盖了另外12个KGQA系统,包括最近发布的,即2017年之后发布的系统。并且涵盖了许多使用各种深度学习模型的方法。

最后,Fu等人[25]的调查是KGQA中最新的调查,尽管在我们撰写调查时,该调查仅在预印本库arXiv中可用;因此,它还没有发表在任何参考期刊或其他出版场所。范围仅限于复杂的KGQA,而不是KGSQA。对2013年至2020年29个复杂问题KGQA系统进行了简要讨论,主要分为基于传统方法、基于信息检索方法和基于神经语义解析方法。然后,调查总结了未来的挑战,这一主题领域通过一个简单的前沿趋势分析。

1.3. Aim of the Survey

- 是第一个关注KGSQA最新技术的机构;

- 详细阐述了KGSQA的挑战、技术、解决方案性能和趋势,特别是KGSQA中使用的各种深度学习模型;

- 提供了新的关键建议,这些建议不仅对开发KGSQA有用,而且还可以扩展到更通用的KGQA系统。

本文其余部分:

在第2节中,我们将介绍本调查中使用的方法。

在第3节中,我们描述了搜索和选择过程的结果,并显示了基于主题分析选择的文章。

在第4节中,我们将讨论现有KGSQA系统所使用的技术以及它们所达到的性能水平,并对KGQA系统未来面临的挑战提出见解。

第5部分总结了本次调查。

2 Methodology

![[…/attachments/images/Pasted image 20220504160643.png]]

文章的筛选通过三个选择步骤,即基于标题和摘要的选择,快速阅读的选择,完整阅读的选择

在最后的选择步骤中,我们删除了86篇文章,剩下的17篇文章将在第4节中充分讨论。

3 Result

3.1 Terminology术语

KGQA文献中的KG主要指有向边标记的图数据模型。在这个数据模型中,KG是一组K的断言,每个断言都表示为(s, p, o)。三元组的主语和宾语是一些表示实体的标识符,而它的谓词是一个标识符,它指的是从主体实体到客体实体的(二进制)关系。图数据模型有时允许文字值位于三元组的对象位置。三元组可以概括为三元组模式,三元组模式与三元组类似,只是其主语、宾语和/或谓语除了实体/关系标识符之外,还可以是变量。

这种数据模型被W3C标准化为资源描述框架(RDF)[30]。相应的查询语言也被标准化为SPARQL[31]。

大型数据库的实际例子包括YAGO (https://yago-knowledge.org于2021年6月27日访问),Freebase (FB), DBPedia (dbpedia.org于2021年6月27日访问),Wikidata (wikidata.org于2021年6月27日访问),LinkedGeoData (http://linkedgeodata.org于2021年6月27日访问),OpenStreeMap (OSM) (https://www.openstreetmap.org于2021年6月27日访问)和Acemap知识图(AceKG) (https://archive.acemap.info/ app/AceKG/于2021年6月27日访问)。

设K为KG, EK = {e1,…, eN}是定义在K中的所有实体的集合,并且RK = {r1,…, rM}是定义在K中的所有关系的集合。实体和K中的关系构成了它的词汇。让q是一个自然的语言问题,方便地表示为一个词袋q = [w1,…, wt]。,如果q只包含一个三元组,我们称q为简单问题。否则,q是一个复杂的问题。

KGQA的一种传统方法是语义解析,首先将给定的问题翻译成它的语义表示,即一个“等效的”查询,然后在KG上执行以检索答案。

另一种使用基于神经网络的模型,问题和KG(或其部分)在向量空间中表示,并使用向量空间操作来获得答案。一个端到端的KGQA系统通常由两个主要部分组成。这两个部分传统上被安排在一个管道中,它们之间有明显的分离,尽管通过采用深度学习,原则上可以有一个真正的端到端解决方案。

第一部分处理通过输入问题的关键术语和结构来理解其意图的问题,称为问题理解[32,33]或实体标识[34]。

第二部分处理利用第一部分中提取的术语和结构从KG中获得匹配答案的问题。如果显式构造了KG查询,则称为查询求值[32,33]或查询选择[34],如果使用向量空间操作而不是显式KG查询,则称为在嵌入空间上进行联合搜索[35]。

KGQA系统的性能评估通常通过使用基准数据集来完成。这样就可以对31个系统中的2021年KGQA信息进行可靠的评估和比较。常用的性能指标包括准确性、召回率、精确度和Fmeasure[24]。附录A总结了KGQA中目前使用的现有基准数据集。

3.2. Tasks and Challenges in KGSQA

确定了两类任务:实体/关系检测/预测/链接和答案匹配。表1总结了上述任务的所有变体,以及它们提出的解决方案的参考文献,并根据发布年份列出。

每年每项KGSQA任务发表文章。一些文章提出了多个任务的解决方案:

![![[../attachments/images/Pasted image 20220504165249.png]]](https://img-blog.csdnimg.cn/5c2f58f41e564c97be9fae05fb8bf18f.png)

3.2.1 Entity and Relation Detection, Prediction, and Linking

实体/关系预测的目的是将q归类到由实体e∈EK(实体预测)或关系r∈RK(关系预测)标记的类别中,其中e和r是q中提到的实体和关系。

实体/关系链接的目的是关联q中提到的所有实体/关系,以纠正k中的实体/关系。

在KGSQA中,q只包含一个实体和一个关系。例如,考虑q =“Where is the capital of the Empire of Japan?”另外,假设Japan是一个实体,capital of是一个关系。

在实体/关系检测中,“the Empire of Japan”应该被检测为一个实体,“is the capital of”应该被检测为一个capital of。在实体/关系预测中,Japan和capital of被视为可能多个类别标签中的一个。然后需要将问题q分配给Japan和capital,也就是说,标签是针对问题的。

在实体/关系链接中,Japan和capital of再次被视为capital of,但与实体/关系预测不同的是,其目的是明确地标记,即将“the Empire of Japan””与“Japan”对应,将“is the capital of ”与“capital of”对应。

在实体/关系预测/链接中可能会出现许多问题。这两个主要问题涉及词汇空缺和歧义,这也适用于KGSQA。由于表达相同或相似含义的方式有多种,因此会出现词汇差异。歧义可能以同音异义的形式出现(篮球运动员“迈克尔·乔丹”和演员“迈克尔·乔丹”)或一词多义的形式出现(“man”指整个人类物种,“man”指男性).

3.2.2 Answer Matching

答案匹配任务涉及的是从底层KG中获取答案的实际过程.,KGSQA只包含一个问题提到的一个单一的实体e和单一关系r, 只要r e从K中正确识别,答案可以很容易地通过两个查询{(?)x, r, e)}∪{(e, r, ?x)}获得,其中?x是q的答案的一个变量,但是由于k中存在噪声和信息的不完全性,e和r的正确识别是重要的,识别中的错误也可能传播到最终结果。因此,另一种观点是将q和/或K嵌入向量空间,然后使用深度学习模型在它们之间建立高质量的关联,而无需实际构造显式查询。

此外,q中可能提到多个实体/关系,它们都具有相对较高的置信度。因此,一些KGSQA系统将子图选择作为附加任务来执行。在这个任务中,给定实体/关系提到等锚点信息,只选择K中相关的部分作为基础进行匹配。选择的部分可以是一组三元组的形式,即一个较小的KG,或一组实体和/或关系,即EK或RK的子集。

除了在答案匹配过程中可能出现的词汇缺口和歧义问题外,另一个问题涉及到答案的不确定性。出现这个问题的原因是,KGQA系统通常通过一系列模型生成答案,每个模型都引入了一定程度的不确定性,这些不确定性可能会沿着管道传播,并影响最终结果。因此,一个好的方法来估计答案的不确定性将有助于减少答案中的错误或解释这些错误发生的原因。

3.3. State-of-the-Art Approaches in KGSQA

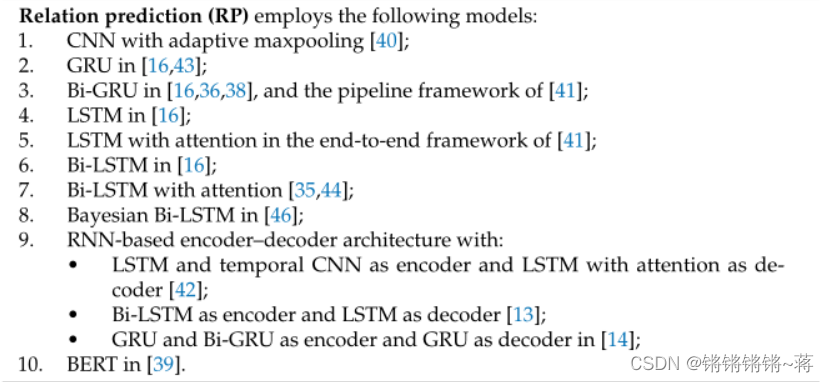

不同类型的深度学习模型。它们包括记忆网络(MemNN)、卷积神经网络(CNNs)、门控递归单元(GRU)及其双向变体(Bi-GRU)、长短期记忆(LSTM)及其双向变体(Bi-LSTM),以及Transformer结构。

#实体相关

下表列出了被调查的17个KGSQA系统中任何一个用于解决实体检测、实体预测、实体链接和关系预测任务的模型/方法。【9个】

![![[../attachments/images/Pasted image 20220504212530.png]]](https://img-blog.csdnimg.cn/26efb5c057404082b2f33ad2f05cdfec.png)

其主要思想是将实体检测视为一个序列标记问题,这自然是使用rnn建模的。

事实上,这9个系统中除了一个以外都采用了Bi-GRU和Bi-LSTM。此外,只有Türe和Jojic[16]探索了GRU和LSTM的vanilla和双向变体的所有组合。

文献[14,36]提出了Bi-GRU与条件随机场(CRF)层的结合,CRF层可以理解为类似于logistic/多项回归的分类层,但适用于序列。

作为Bi-GRU的替代方案,其他人提出Bi-LSTM[16,35,38,41]也可与CRF[37,40]联合使用。根据Türe和Jojic[16]的结论,Bi-LSTM似乎在这项任务中表现得更好。

同时,唯一已知的不基于rnn的方法是BERT[39],这是一种比rnn更晚提出的变压器体系结构。众所周知,BERT在许多NLP任务中优于传统的rnn。然而,对于KGSQA中的实体检测,这种改进还没有得到验证。

#答案匹配和子图选择

下表列出了用于解决答案匹配和子图选择任务的模型/方法。【9个】

![![[../attachments/images/Pasted image 20220504212609.png]]

![[../attachments/images/Pasted image 20220507223549.png]]](https://img-blog.csdnimg.cn/f85aeb36e2764770bf82c8156a455059.png)

这个任务也被视为一个序列标记问题,尽管标签是针对整个问题的(而不是单独查看问题中提到的内容)。与实体检测一样,RNN模型也使用了各种各样的模型,特别是对问题进行编码,通常也对KG中的实体进行编码。预测是通过使用某种形式的似然或距离优化将问题的嵌入与正确实体的嵌入配对完成的。

对于RNN模型,Lukovnikov等[43]采用GRU, Dai等[36]采用Bi-GRU。

Li等人[41]在端到端框架中注意使用LSTM执行实体预测(结合关系预测)。文献[35,44]注意使用了Bi-LSTM,而Zhang等人[14]引入了Bi-LSTM的贝叶斯版本,用于测量答案的不确定性。基于rnn的编码器-解码器架构也被提出[13,42]。

最后,RNN的一个例外是Luo等人[45]提出的基于bert的解决方案。这些实体预测模型不需要实体检测,因为它们直接在问题-实体对上训练。即使两者都存在,例如Dai et al.[36],实体检测的结果也不会被实体预测组件使用。

同时,只有6个系统中存在不同的实体连接组件。其中5个[14,16,20,37,45]使用各种形式的字符串或N-gram匹配问题中提到的实体与KG实体。主要原因是,要么是通过实体检测模型识别了提到的实体,要么是一个KG实体已经预测到与问题有关;因此,只需将它与提到的正确的N-gram进行匹配。

使用深度学习的唯一解决方案来自Zhao et al.[40],他使用带有自适应maxpooling的CNN,在计算联合评分之前应用它来获得最可能的答案。使用关系预测组件的方法本质上遵循与实体预测相似的思路,即将其视为序列标记问题。因此,类似的RNN模型也用于该问题。

两个例外是Zhao等人[40]使用自适应maxpooling的CNN和Lukovnikov等人[39]使用BERT。

有趣的是,一些系统[15,20,37,45]完全跳过了关系预测任务。即在执行实体检测和/或实体预测后,直接进行匹配任务。

同时,答案匹配任务的解也更加多样化。大多数方法使用各种形式的字符串匹配、结构匹配或直接查询构造[13、16、36、38、39、41-44]。原则上,这些方法对KG(或部分)执行知情搜索,查找可以作为答案返回的三元组。使用诸如字符串标签相似度或图结构相似度等标准。后者是可行的,因为在简单的问题中,相关的结构可以被一个简单的三重模式捕获。一些解[20,35,40,46]也进行基于相似性的搜索,但它们在包含KG实体和问题表示的嵌入空间中执行。

Zhang等人[14]使用SVM。

Yin等人[37]使用带注意maxpooling的CNN,而[15,45]提供了自定义架构作为解决方案。前者主要基于带注意的LSTM,后者由BERT、注意网络和Bi-LSTM组成。

最后,只有7个系统进行子图选择[35,36,38 - 40,43,46]。它们都在提到/检测到的实体和KG实体/关系之间使用某种形式的字符串匹配。

此外,Zhao等[40]还将字符串匹配与提到实体的共出现概率和KG实体组合成一个子图选择标准。

值得注意的是,其他被调查的KGSQA系统不包括特定的子图选择方法。这表明在这个方向上还有探索的空间。

#关系检测和链接

没有针对关系检测和链接提出具体的解决方案,这可能是因为简单的问题只涉及一个实体和一个关系。对于前者,一旦在问题中检测到一个实体,就可以推断出剩下的单词(减去问题单词)对应关系。至于后者,一旦我们可以预测或链接一个实体在一个问题,而不是直接在问题中提到的可能关系和KG中提到的关系之间找到联系,,它会更容易直接查询KG获得(或候选人)的关系。因此,通过在KGSQA中执行实体检测/预测/链接,可以跳过关系检测和链接。

4 Discussion

KGSQA系统及其模型、优缺点和端到端性能

4.1 Existing KGSQA Systems with Its Models, Achievements, and Strengths and Weaknesses

4.1.1 Bordes et al.’s System

Bordes等人的系统在实体链接任务中使用n-gram匹配将从问题中提取的实体链接到KG中的实体。在答案匹配方面,它们测量KG实体/关系的嵌入与问题的嵌入之间的相似度得分。为了处理输入问题包含KG中不知道的事实的可能性,Bordes等人[20]使用ReVerb从web语料库中提取三元组来增强事实。ReVerb中的主体和对象使用由Lin等人[51]提出的预先计算的实体链接链接到KG。这种方法对于KGSQA系统想要回答与KG中关系名称不同的关系表达式的问题很有帮助,因为关系是用向量值表示的,可能会导致得到关系名称所使用的相似词。

虽然这个模型被认为是一个可以在自然语言上工作的模型,但是KG和ReVerbs之间的模式差异导致了更多的努力来保持一致。然而,这种方法以63.9%的准确率为端到端KGSQA性能提供了良好的基线

4.1.2. Yin et al.’s System

Yin等人[37]提出了两种链接器,称为主动实体链接器和被动实体链接器。这两个链接器用于产生排名前n的候选实体。

- 根据题目类型,求KG生成的题目与实体候选人之间的最长公共连续子序列。

- 使用Bi-LSTM + CRF进行实体检测,并找到最长公共连续子序列。

该方法的优点是体系结构简单。实体链接器可以覆盖地面真实实体的更高覆盖率。但是,它不包括实体的语义。

在答案匹配方面,他们使用CNN和 attentive max-pooling。最后,事实选择器通过计算问题中的实体和关系与KG中的事实之间的相似性来选择合适的事实。该模型的最佳端到端性能达到76.4%

4.1.3. Dai et al.’s System

Dai等人的[36]模型处理了实体和关系预测以及子图选择。他们使用Conditional Focused条件聚焦(CFO),在关系预测建模p(s, r|q) = p(r|q)·p(s|q, r)。同时,他们使用Bi-GRU通过选择最大化p(s, r|q)的s, r进行实体预测。

此外,由于搜索空间非常大,他们在子图选择任务中提出了子图剪枝,通过Bi-GRU和线性链CRF的实体检测对(s, r)的候选空间进行剪枝。通过子图选择算法,该模型可以减少推理过程中主题提及的搜索空间。

然而,其结果是获得的实体表示不够平滑(smooth)。因此,虽然该方法在修剪搜索空间方面做得更好,但端到端精度的实现略低于Zhu et al.[13]提出的实体链接器,即75.7% 的精度。这是因为CFO的学习实体表示并不比Zhu等人[13]的实体链接器方法更平滑。

4.1.4. He and Golub’ System

He和Golub[42]结合LSTM编码器(提问)、时态CNN编码器(KG查询)、LSTM解码器(注意)进行实体和关系预测以及语义关联函数(预测)。一旦预测了实体和关系,系统就会通过查询直接匹配答案。

该模型的优点是:

- 使用较少的参数和较小的数据进行学习;

- 可用于推广不可见的实体。然而,该模型仍然不能解决词汇缺口问题。

该模型的最佳端到端性能达到**70.9%**的准确率

4.1.5. Lukovnikov et al.’s System

该模型处理实体和关系的预测,以及实体和关系的选择。GRU用于实体关系预测[43]。同时,在实体和关系选择方面,Lukovnikov等人分别使用了n-gram过滤和基于候选实体的关系选择。

该模型有一个缺点,即使用它很难解决歧义问题。

然而,该模型的优点是

- 它可以处理罕见词和词汇外的问题,

- 它不需要完整的NLP管道建设,

- 它避免了错误传播,

- 它可以适应不同的领域。

该模型的最佳端到端性能为71.2%

4.1.6. Zhu et al.’s System

Zhu等[13]提出了KGSQA的三个任务,即实体与关系预测和答案匹配。实体和关系预测任务使用seq2seq联合完成,seq2seq由Bi-LSTM编码器和具有生成、复制和解释模式的自定义LSTM解码器组成。同时,通过对预测的实体-关系对进行查询,可以简单地进行答案匹配。

模型可以解决同义词问题。它也提高了KGSQA系统的端到端性能,与仅使用Bi-LSTM相比,其准确率提高了11%,即77.4%。但是,使用较大的KG将导致较低的端到端性能。

4.1.7. Türe and Jojic’s System

Türe和Jojic提出了一种方法来解决四个任务,即实体检测和链接、关系预测和答案匹配。

它们使用GRU+Bi+GRU和LSTM+Bi-LSTM进行实体检测和关系预测。同时,对于实体链接,他们对KG中每个n-gram的实体别名(针对整个实体名称)使用倒序索引和tf-idf加权。从实体文本中,计算所有具有tf-idf权重的匹配实体。从每个候选实体,他们构建一个单跳邻居图。从这些邻居中,选择路径与预测关系一致的所有邻居。最后,选择得分最高的实体[16]。采用的模型虽然简单,但准确率达到了88.3%。

不足之处在于,该模型无法识别以不同方式表达的实体或关系,如“la kings”和“Los Angeles kings”。为了解决这个问题,实现了存储同义词的索引。然而,由于该模型是一个监督的模型,预测出在训练中根本不作为目标类出现的关系很困难。

4.1.8. Chao and Li’s System

该模型处理了实体检测、关系预测和答案匹配三个任务。Chao和Li[38]使用Bi-LSTM和n-gram匹配来检测问题中的实体。此外,利用GRU进行关系预测。一旦得到一个实体和一个关系,该模型根据outdegree和Freebase显著类型构建一个排名,将它们与一个答案匹配。结合Freebase显著类型有助于区分多义实体。

然而,其他的歧义问题,如上义和下义仍然难以解决。从性能(66.6%)也可以看出这一点,低于Bordes等人的模型。

4.1.9. Zhang et al.’s System

不同于Chao和Li使用的Bi-LSTM, Zhang等人使用的实体检测模型[14]由Bi-GRU、GRU和CRF组合而成。此外,它们还使用了一种组合的方法进行关系预测,即使用GRU编码器、Bi-GRU编码器和GRU解码器。在答案匹配方面,该模型使用了SVM。

该模型在预测与多目标实体相关的正确关系路径方面具有较强的鲁棒性。然而,它在预测其释义或同义词关系时容易出错。尽管如此,总体而言,它优于[36,37,42]方法,达到81.7% 的准确率。

4.1.10. Huang et al.’s System

Huang等[35]利用Bi-LSTM从输入问题中学习关系的嵌入空间表示。用一个相似的模型从问题中学习实体的嵌入空间表示。本文采用了基于Bi-LSTM的实体检测模型来减少问题候选实体的数量。

一旦从一个问题中找到实体和关系的嵌入表示,Huang等人[35]使用基于翻译的嵌入(如TransE[52])来计算候选事实作为输入问题的答案。通过对嵌入空间上的一个特定联合距离度量进行优化,得到实际问题的解答。该模型能够解决KGSQA中实体和关系的模糊性问题。该模型还可以将Chao2018系统的端到端性能提高到1.2%的精度,即75.4% 的精度。然而,该模型不适用于非kg的嵌入。

4.1.11. Wang et al.’s System

Wang等人的[44]模型使用带有注意力池的Bi-LSTM来预测实体。这个模型对于学习问题中提到的一系列单词或字符是至关重要的。通过将实体表示为向量,可以使用相似函数计算KG中的实体与问题中的实体之间的相似度。同时,在关系预测方面,Wang等人没有像He和Golub[42]那样使用主题实体,而是使用多级目标注意力(Multilevel Target Attention, MLTA)结合Bi-LSTM,将关系候选对象作为问题注意池的查询。通过这种方法,Wang等人的模型可以捕获关系依赖的问题表示。然而,该模型在处理词汇差距和同义词问题时遇到了一些困难。尽管如此,Wang等人的模型的端到端性能优于He和Golub的模型(70.9%),即准确率为82.2%。

4.1.12. Lan et al.’s System

在Lan et al.[15]之前,现有KGSQA系统面临的一个问题是不能很好地捕获特定的问题上下文。为了解决这个问题,Lan等人提出了使用**“匹配-聚合”框架 ** 进行序列匹配。具体来说,该框架由单个ReLU线性层、注意力机制和LSTM作为答案匹配任务的聚合器组成。此外,为了丰富语境,Lan等人还利用带注意机制的LSTM对额外的语境信息进行了建模。

Lan等人的模型支持问句的语境意图。然而,当问题模糊不清时,很难选择正确的事实路径。尽管如此,除[14,16]外,该模型仍优于以往的研究。准确率达80.9%。

4.1.13. Lukovnikov et al.’s System

以前的KGSQA系统广泛使用rnn来获得输入问题的嵌入空间表示以及KG实体和关系,而Lukovnikov等[39]利用==BERT[==53]来帮助检测实体和预测关系。在实体检测中,该模型预测实体跨度的起始和结束位置。该模型使用反向索引生成候选实体,并使用字符串信息的相似函数和出度对其进行排序。

同时,Lukovnikov等人使用BERT和softmax层来预测关系。然后使用预测的实体和关系,通过基于标签相似性的查询(实体谓词对)排序来获得答案。BERT的使用使所提出的模型在NLQ中的序列学习中具有强大的功能。然而,由于BERT使用了大量的参数,因此它的运行代价很高。尽管如此,实验表明BERT在KGSQA中是有前景的。端到端性能达到77.3% 的准确率

4.1.14. Zhao et al.’s System

Zhao等人的模型[40]处理KGSQA的四个任务,即实体检测、子图选择、实体链接和关系预测。对于实体检测,他们使用Bi-LSTM和CRF。由于实体检测的搜索空间太宽,他们提出了一种基于n-gram的子图选择。根据实体与提及的最长公共子序列长度和两者的共现概率对子图进行排序。同时,在实体链接和关系预测方面利用CNN产生相似性得分,联合优化利用 well-order损失。

该模型可以使用文字和语义方法解决不精确匹配的情况。然而,在模糊的情况下,该模型并没有解决这个问题。Zhao等人的实验表明,该模型的端到端性能优于除Türe和Jojic模型外的所有前人的模型,准确率为85.4%。

4.1.15. Luo et al.’s System

Lukovnikov等人的模型[39]不使用BERT进行实体链接,而Luo等人[45]不仅使用BERT进行实体检测,还使用BERT进行实体链接。实体链接任务是通过查询检测到的实体来执行的。通过实体链接的输出,可以得到与实体链接的关系。同时,使用BERT进行答案匹配时不需要进行显式的关系预测。此外,它还使用了关系感知注意网络、Bi-LSTM和线性层对分数进行组合。

该模型支持解决问题和KGs之间的语义差距,虽然该模型实现了一种基于语义的方法,但该模型存在缺陷:

- 未解决歧义问题,

- 无法识别千克数冗余问题。KG冗余意味着一些实体具有相同的属性,但id不同。一词多义)。

该模型的最佳端到端性能为80.9%。它是一种很有前途的扩展方法,可以提高性能。

4.1.16. Zhang et al.’s System

Zhang等[46]提出了一个模型,该模型解决了KGSQA的三个任务,即实体与关系预测和答案匹配。使用n-gram匹配直接选择每个问题的候选实体集。然后选择每个候选实体的候选关系。每个候选实体和关系都用贝叶斯Bi-LSTM编码,隐式训练为实体和关系预测模型,因为只考虑了表示(不预测实际的实体/关系)。最后,通过最大池化实体与训练过的谓词表示之间的联合分数(点积)矩阵计算,实现端到端的答案匹配。

该模型易于使用和针对不同领域进行再培训。然而,模糊性问题仍然是该模型面临的一个挑战。然而,作为第一次尝试给出答案不确定性的明确估计,该模型达到了良好的端到端性能,即75.1% 的准确率

4.1.17. Li et al.’s System

Li等[41]针对KGSQA提出了两种解决方案。

第一个是分别解决实体检测和关系预测任务的流水线框架。前者采用Bi-LSTM,后者采用Bi-GRU。与Chao和Li[38]相似,该模型也使用了Freebase显著类型来提高实体选择的性能。此外,该模型还采用了外部实体。结合上下文信息提高了KGSQA的准确性,但端到端性能仍然较低,为71.8%。然而,尽管该模型的端到端准确性较低,但该模型有三个优势:

- 运行时间较低,

- 可以解决多义实体问题,

- 基于语义的方法。

第二种解决方案是一个完全的端到端框架,其中使用了具有自注意力的LSTM。与其他系统不同,这个端到端框架有一个语义编码层,用于捕获输入问题和KG事实的表示。框架的其余部分作为语义关联计算器,允许人们获得输入问题与主体实体之间以及输入问题与谓词关系之间的相似度得分。这个端到端框架的一个优点是语义表示的准确性更好。然而,该框架在模型训练中效率低下。

4.2. Open Challenges in the Future Research

本节介绍了现有工作的缺点和未来的公开挑战。有四个主要的未解决的问题,即释义问题、歧义问题、基准数据集问题和成本问题。

4.2.1. Paraphrase Issue

虽然使用单词嵌入方法(如[35,38,43]提出的系统)可以解决使用不同单词的问题,但它无法轻松地与问题转述一起工作。原因有两方面。

首先,SimpleQuestions数据集没有提供问题的解释,因此,很难训练一个模型来捕捉它们。

其次,现有的模型没有从训练数据中的简单问题数据集构建或生成问题的释义。因此,当给出一个与数据中含义相同的问题,但使用不可见的释义表达时,这些模型无法正确预测答案。

4.2.2. Ambiguity Issue 歧义问题

在已有的作品中也揭示了歧义问题。目前的作品至少面临着两种歧义,即实体歧义和问题歧义。

实体歧义可分为三个主要问题。尽管Lukovnikov等人[43]已经揭示了这些类型的模糊性,但这些问题仍然是KGSQA系统的缺点。

- 第一个问题涉及难以区分的实体。当两个(实际上不同的)实体具有完全相同的名称和类型时,就会发生这种情况。例如,“what song was on the recording indiana?”将返回KG中的多个实体,标签名称为“indiana”,标签类型为“musical recording”。

- 第二个问题涉及硬模糊性。当两个实体具有相同的标签但类型不同时,就会发生这种情况。此外,问题也没有明确指出预期是哪一个实体。例如,“托马斯出生在哪里?”,棒球运动员托马斯和电影演员托马斯是排名最好的两个候选人,问题本身并没有表明谁更受青睐。

- 第三个问题涉及软歧义。这类似于硬歧义,除了问题提供了一些提示,关于哪个实体是预期的。从直觉上来说,这比难以理解的歧义更具挑战性,因为人们可以尝试从问题中提取相关的上下文来帮助回答问题。然而,这个问题在很大程度上仍未解决。

同时,问题歧义是当问题本身包含歧义描述时发生的问题。例如,“who was Juan Ponce de Leon family”这个问题可能会在预测和实际情况之间产生一个不同的实体。在这个例子中,一个预测可能输出“Barbara Ryan”,而真实值是“Elizabeth Ryan”。这是因为用来得到答案的关系与期望的关系是不同的。前者来自于“父母”,后者来自于“子女”。

4.2.3. Benchmark Data Set Issue 基准数据集问题

SimpleQestions包含遵循严格模式的问题。这导致了两个缺点。

- 首先,当模板被用于训练机器学习模型时,僵化的模板会导致过拟合问题。

- 第二,模板不能用于将问题模式概括为更高级的问题类型。

4.2.4. Computational Cost Issue 计算成本问题

通常,一个KG包含数十亿个事实。例如,两个较大的KGs,即Wikidata (https://dumps.wikimedia.org于2021年6月27日被访问)和Freebase (https:// developers.google.com/freebase于2021年6月27日被访问),尽管后者现在已经停止。KG的庞大规模意味着现有的方法需要在编码/解码KG事实方面更加努力。

此外,最近深度学习的进步带来了规模越来越大的新模型。因此,计算成本的问题变得更加明显。关于这个问题,可以考虑的一种努力是**提供 KG 完整版本的有用的(和小得多的)子集 **。此类子集的自由基版本可用(FB2M 和 FB5M)。然而,自从 Freebase 停止使用,研究已经转移到使用 Wikidata 和/或 DBpedia。不幸的是,Wikidata 或 DBpedia 中没有类似的子集。

4.3. Recommendation建议

今后的研究应更多地转向基于语义的方法,而不是基于语法的方法。一些嵌入方法可以用来编码和解码单词或句子表征中的事实和问题。因此,可以利用嵌入的方法来解决实体歧义和问题歧义。表7提供了关于嵌入方法的调查论文,这些嵌入方法可以洞察用于基于向量表示的现有技术。根据表5,我们简要地概述了基于语义的方法构建KGQA系统的潜在方法。

![[…/attachments/images/Pasted image 20220505230617.png]]

语义匹配模型如RESCALL[57]和tatatec[58]可以扩展到未来的KGQA中,通过探索基于相似性的评分函数来匹配事实。虽然这些方法的时间复杂度有点高[54],但它们可以在其表示向量中匹配关系和实体的潜在语义。

此外,==TransH[59]和KG2E[60]==等翻译模型的其他变体也可以被认为是TransE和TransR之外的方法。这些方法除了空间复杂度和时间复杂度都小于[54]外,还具有TransE和TransR所不具备的优势。

通过在实体和关系之间使用不同的角色,TransH可以通过定义关系是传入关系还是传出关系来确定合适的关系。因此,机器可以理解问题所需要的一对主谓和一对谓宾。KG2E将关系和实体建模为随机变量,而不是向量空间中的确定性点。因此,它改善了KGs中不确定性关系和实体的有效性模型。

为了解决歧义问题,可以考虑使用混合方法来学习给定文本或事实的语义,而不是Zhu等人[13]提出的Bi-LSTM和seq2seq。混合模型是一种为数据[55]使用KGs和文本语料库的技术。使用的表示资源越多,机器就能更好地确定事实的语义。概念表示的一个潜在的非kg来源是Wikipedia,因为它的实体概念通常链接到任何kg,如Wikidata和DBPedia。为此,可以考虑[61-63]的方法。

使用预训练的自然语言处理(NLP)任务模型可以全面学习句子的上下文,也可以考虑获得问题的提及(实体和关系),用于将它们链接到KG中的实体和关系。为了包装模型,现有的库,如HuggingFace的Transformer[64],可以用于KGQA系统的特定任务。表8描述了Wolf等人[64]提出的Transformer任务总结,可用于KGQA系统任务的实体和关系链接。(https://huggingface。co于2021年6月27日进入。)

#未来KGQA

表8中提到的任务可用于未来的KGQA(特别是问题理解和答案检索或查询评估阶段[32,33])。掩蔽语言模型Masked language model(MLM)和NER可以用来提取和定义问题中提到的关系和实体。同时,将上下文抽取应用于问题,可以获得更丰富的问题表示。这可以使答案更精确。SimpleTransformer等漂亮的包装器可以是一种有用的工具,用于简化开发(https://simpletransformers。ai于2021年6月27日获得通过)。

此外,在基准数据集构建方面,一个新的数据集应该包括各种各样的问题释义。释义可以在词汇层面或问题层面进行建构。因此,未来的研究可以使用更丰富的问题集,以获得能够以更细粒度的方式捕捉问题感觉的模型。问题生成工具可以用来从一组原始问题中立即生成转述的问题。Madnani和Dorr[65]的一项调查对使用数据驱动的短语进行了全面的调查。

一个可以同时适用于词汇级和问题级释义的例子:在左列中,原始问题是Bordes等人[20]的SimpleQuestions示例。在中间一栏中,通过将动词die改为同义词(如decease),逐字逐句地进行释义。在最后一篇专栏文章中,释义是通过问题层次构建的。![[…/attachments/images/Pasted image 20220506160837.png]]

此外,在训练模型时,使用更多样化的问题模板构建基准数据集并确保数据平衡对避免过拟合至关重要。Besides,一个包含复杂问题及其子问题的突破性基准数据集可以帮助开发用子问题(简单问题)回答复杂问题的新方法。此外,这种新的数据集还可以用于评估问题分解任务,在未来的KGQA中,沿着这条线的方法已经显示出解决复杂问题的良好结果[3,7 - 9]。

随着像BERT这样的语言模型越来越大,一个明显的反方法是尝试用更少的参数提出更简单的架构,这样可以降低培训成本。从数据的角度来看,通过选择对KG中所有事实具有代表性的事实来创建大型KG的有用子集(如Wikidata或DBPedia)也可以减少数据的大小。这样就可以降低培训成本。

#图卷积网络(GCN)

此外,基于深度学习的方法建模数据中的非线性结构,同时编码KG数据的成本也更低,如图卷积网络(GCN),可以是一个很好的探索选择[66]。GCN除了降低维数外,还可以利用之前迭代的信息得到新的嵌入,从而避免不必要的计算[56,66]。

5. Conclusion

基于2010年1月至2021年6月的文献,我们获得了2015-2021年发表的17篇与KGSQA高度相关的文献。在过去的五年中,我们看到人们对解决KGSQA现有挑战的兴趣越来越大。这些文章认为最具挑战性的任务是实体检测/预测/链接和关系预测,其次是答案匹配和子图选择。Türe和Jojic[16]使用的Bi-GRU和Bi-LSTM导致迄今为止KGSQA系统的最佳性能,即88.3%的准确率。相比之下,He和Golub[42]使用的LSTM给出了最低的性能,准确率为70.9%

此外,在此期间还有四个突出未解决的问题,即释义问题、歧义问题、基准数据集问题和计算成本问题。今后的研究应着眼于更基于语义的方法,而不是基于语法的方法来克服这些问题。嵌入方法的使用可以解决或至少减少实体或问题歧义问题。使用预先训练的NLP模型,如Transformer,可以促进KGQA系统中的不同任务。此外,可以考虑采用一种混合方法来丰富数据的语义表示(即KGs和问题),以帮助机器更好地确定给定问题对应于KG事实的意义。此外,需要低复杂度的简单模型,以解决未来数据量较大所带来的计算成本问题。未来的KGQA还可以探索并可能采用现有的RESCALL和TATEC等方法,以提高低复杂度语义匹配中的匹配精度性能。也可以考虑将实体和关系建模为随机变量而不是向量空间中的确定性点的嵌入模型,对KGs中的不确定性实体和关系进行编码和解码。

同时,在数据集构建方面,一个新的数据集应该包括转述的问题,而不仅仅是原始的问题。它可以帮助新颖的KGQA系统学习各种形式的问题**。词汇层面和问题层面的变化** 可以用来产生转述的问题。此外,数据集还应该包含更多样化的模式,而不是僵化的模式,以帮助避免在训练过程中过拟合。