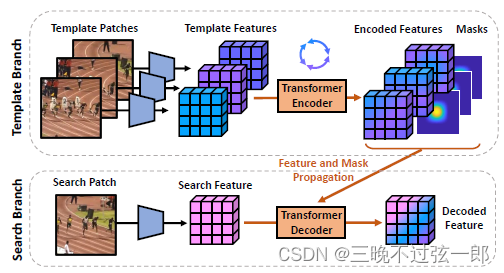

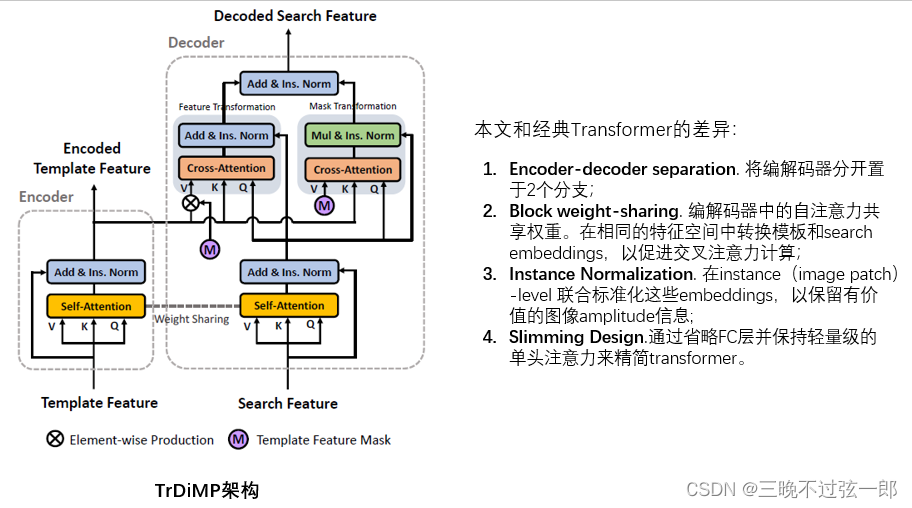

先贴一下本文的核心框架图:

Abstract

发现问题:视频目标跟踪任务中,在连续帧之间存在着丰富的时域上下文关系,其在现存的跟踪器中常常被忽略。

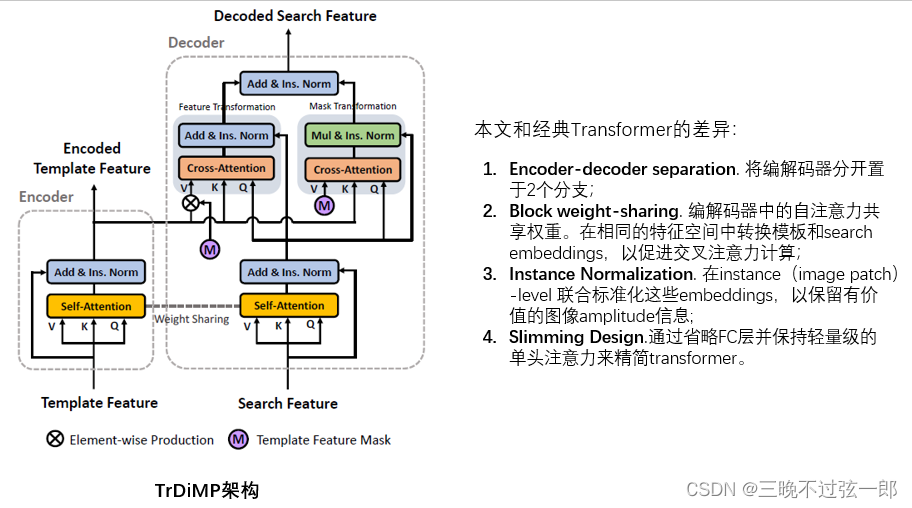

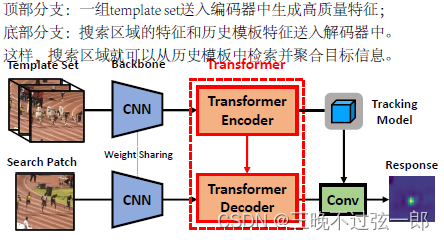

本文工作:本文通过transformer结构探索视频帧之间的时间上下文关系,以实现鲁棒的跟踪。不同于NLP领域中经典的transformer使用,本文将编解码器分为2个平行的分支并在Siamese pipeline中仔细地设计编解码器的具体结构。

本文具体做法:编码器通过基于注意力的特征强化提升目标模板,有利于生成高质量的跟踪模型。解码器将跟踪的相关线索从先前的模板传播到当前帧,有助于目标的搜索。

本文优势:网络结构整洁以端到端的方式训练,性能达到了SOTA。

1. Introduction

VOT问题介绍:VOT是CV领域中的一个基础任务,其在目标遮挡,形变等方面还存在一定的挑战。随着时域误差的累计,这些挑战也会在在线过程中进一步放大。

已有方法对时序信息的利用:在视频流中,丰富的时域信息非常重要。但是大部分跟踪范式都是通过逐帧目标检测的方式来处理的,其极大程度忽略了连续帧之间的时域关系。1. 一些方法只利用初始帧作为模板匹配,其唯一使用的时间信息是假设目标平滑移动这样的运动先验(例如,余弦窗口)来实现,该方法已经在VOT任务上广泛采用。2. 一些方法采取了更新机制,其收集了历史帧的预测结果去逐步更新跟踪模型。尽管这些方法考虑了历史帧的信息,但视频帧仍然是作为独立的个体,没有任何交互信息。而在实际生活中,一些帧不可避免地包含噪声(被遮挡/模糊),那这些帧将会阻碍模型更新。因此,帧间丰富的信息加强是一个重要问题,本文认为不应该孤立地处理视频帧,并且由于忽略逐帧关系,VOT的性能提升被极大地阻碍。

本文提出:

2. Related Work

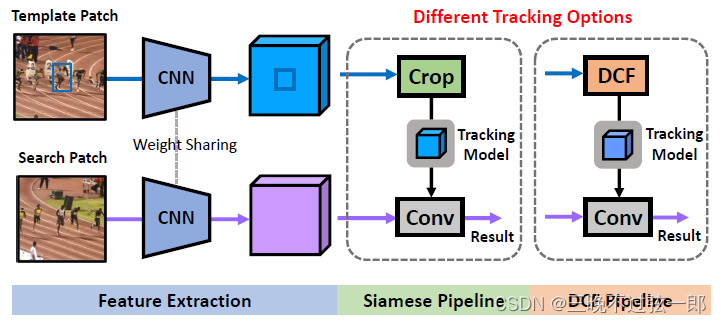

- Siamese网络解决VOT问题的本质是模板匹配(template matching),改进Siamese网络的方法包括:注意力机制、强化学习、目标感知的模型精调、无监督训练、精细的骨干网络、级联框架、模型更新机制等,

- DCF方法解决VOT问题的本质是过在傅里叶域内解决岭回归问题。最近研究发现岭回归问题可以以深度学习的框架解决,其避免了传统DCF的边界效应。这些方法学习判别性 CNN 内核与搜索区域卷积以生成响应,包括ATOM,DiMP方法等。

以上方法探索时域信息的技术包括GNN, 时空正则化,光流等。而本文利用transformer建模帧间关系,传递时域信息。

3. Revisting Tracking Frameworks

Siamese网络和DCF方法的pipeline总结如下图:

4. Transformer for Visual Tracking

4.1. Transformer Overview

4.2. Transformer Encoder

4.3. Transformer Decoder

4.4. Tracking with Transformer enhanced Features

以以下2种范式利用模板特征T_{encoded}和搜索特征S_{decoded}学习跟踪模型:

- Siamese Pipeline. 简单裁剪T_{encoded}的目标特征作为目标CNN核,并结合S_{decoded}来生成响应,其与SiamFC中的互相关操作相同;

- DCF Pipeline. 沿用DiMP中端到端的DCF优化技术,利用T_{encoded}和S_{decoded}生成鉴别式CNN核。

- 模板集成T的更新方式:每5帧丢弃T中最旧的帧并添加最新收集的模板特征。T中最多包含20个模板特征。一旦T被更新,通过编码器计算新的编码特征T_{encoded}。