原文名称

End-to-end Trainable Deep Neural Network for Robotic Grasp Detection and Semantic Segmentation from RGB

写在前面

???本篇是上述论文的略读笔记,本篇论文原文中网络结构和训练过程介绍的比较清晰,而且本篇论文在github由代码,这里只是本人略读后整理出的一些信息,后续如果精读再更新

摘要

-

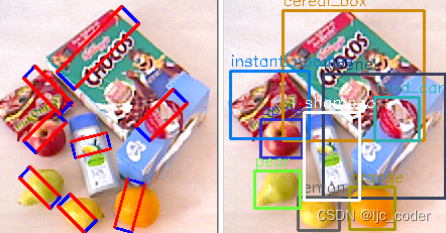

Tip1: 本文是针对平行夹具机械爪的抓取预测(实际预测结果如下图),是一种端到端可训练的CNN网络

-

Tip2: 提出一个模块,利用先前计算的抓取检测候选信息和语义分割结合,提高抓取准确率

-

Tip3: 扩展了OCID数据集,使可以抓取场景中的特定对象

相关工作

机器人抓取检测

- 抓取检测方面,本篇采用传统的g=(x,y,w,h,θ)来描述抓取框(x,y为抓取中心点;w,h为矩形抓取框宽高;θ为抓取框鱼水平的夹角)

语义分割

- Tip1: 语义分割的任务是为图像中的每个像素指定一个类别标签

- Tip2: 对于不可见的抓取检测,将语义集定义为{可抓取、不可抓取}

方法

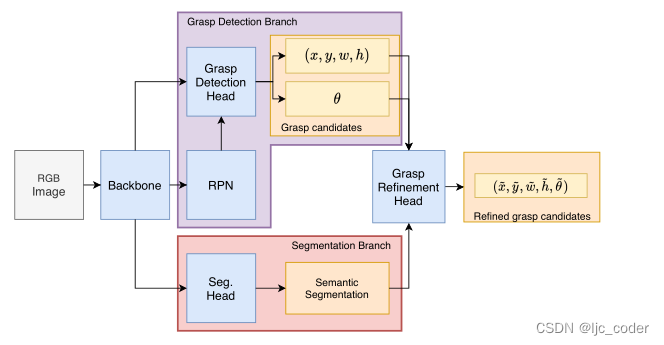

- 网络结构如下,通过共享backbone提取特征,分别进行抓取检测和语义分割,将两者结合,提高抓取准确性

Backbone

- BackBone采用的是作者微改的ResNet-101

抓取检测

- 抓取检测部分基于Faster-RCNN,由RPN和检测结构组成

语义分割

- 主要用到Mini-DeepLab模块

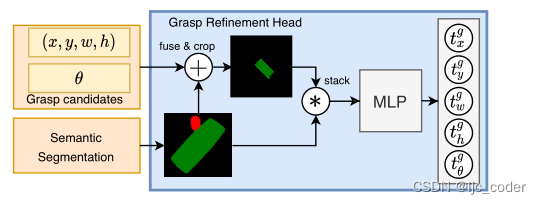

融合head

- 这部分主要是将将前两个head的信息结合起来,通过MLP得到最终的五维输出

- ? 这里是通过MLP将抓取候选对象的几何信息与有关对象形状的信息相结合

总结

- Tip1: 提出新的CNN结构,共享backbone提取特征,联合抓取检测和语义分割

- Tip2: 在复杂场景中保持抓取的高精度

- Tip3: 展示了如何通过语义分割将候选对象分配给特定对象(将候选对象分配给指定对象,从而获取场景中的特定对象)