论文地址:https://arxiv.org/pdf/2101.00529.pdf

相关博客:

【自然语言处理】【多模态】CLIP:从自然语言监督中学习可迁移视觉模型

【自然语言处理】【多模态】ViT-BERT:在非图像文本对数据上预训练统一基础模型

【自然语言处理】【多模态】BLIP:面向统一视觉语言理解和生成的自举语言图像预训练

【自然语言处理】【多模态】FLAVA:一个基础语言和视觉对齐模型

【自然语言处理】【多模态】SIMVLM:基于弱监督的简单视觉语言模型预训练

【自然语言处理】【多模态】UniT:基于统一Transformer的多模态多任务学习

【自然语言处理】【多模态】Product1M:基于跨模态预训练的弱监督实例级产品检索

【自然语言处理】【多模态】ALBEF:基于动量蒸馏的视觉语言表示学习

【自然语言处理】【多模态】VinVL:回顾视觉语言模型中的视觉表示

一、简介

? 视觉语言预训练 ( VLP ) (\text{VLP}) (VLP)被证明在广泛的视觉语言任务 ( VL ) (\text{VL}) (VL)中是有效的。典型的 VLP \text{VLP} VLP由两阶段组成:(1) 一个预训练的目标检测模型,用于编码图像中的视觉目标至特征向量;(2) 一个预训练的跨模态融合模型,用于融合文本和视觉特征。现有的 VLP \text{VLP} VLP研究主要专注在改善跨模型融合模型,本文则专注在改善以目标为中心的视觉表示,并且提出了一个全面的实证研究来证明 VL \text{VL} VL模型中视觉特征的重要性。

? 在先前的工作中,广泛使用的目标检索模型是在 Visual?Genome \text{Visual Genome} Visual?Genome数据集上训练的。目标检测模型提供了一个以目标为中心的图像表示,并且作为黑盒被用在各种 VL \text{VL} VL模型中。在本文中,作者基于 ResNetXt-152?C4 \text{ResNetXt-152 C4} ResNetXt-152?C4架构预训练了一个大规模的目标-属性检测模型。相比于之前的目标检测模型,新模型针对 VL \text{VL} VL任务进行了更好的设计,并且规模更大、在更大数据量上进行训练,合并了多个公开的目标检测数据集,包括: COCO \text{COCO} COCO、 OpenImages(OI) \text{OpenImages(OI)} OpenImages(OI)、 Ojbects365 \text{Ojbects365} Ojbects365和 Visual?Genome(VG) \text{Visual Genome(VG)} Visual?Genome(VG)。最终,本文的目标检测模型在广泛的 VL \text{VL} VL任务上实现了更好的结果。相比于其他的目标检测模型,例如 X152-FPN \text{X152-FPN} X152-FPN在 OpenImages \text{OpenImages} OpenImages上训练,本文的新模型能够编码更多样的视觉目标和概念集合。

? 为了验证新目标检测模型的有效性,作者在包含了885万个text-image对的数据集上预训练了一个基于

Transformer

\text{Transformer}

Transformer的跨模型融合模型

OSCAR+

\text{OSCAR+}

OSCAR+,其中图像的视觉表示由新的目标检测模型生成,并且在

OSCAR+

\text{OSCAR+}

OSCAR+预训练时被固定。然后在广泛的下游任务中微调预训练的

OSCAR+

\text{OSCAR+}

OSCAR+,包括像

VQA

\text{VQA}

VQA、

GQA

\text{GQA}

GQA、

NLVR2

\text{NLVR2}

NLVR2这样的

VL

\text{VL}

VL理解任务,以及

COCO

\text{COCO}

COCO text-image检索,以及像

COCO?image?cpationing

\text{COCO image cpationing}

COCO?image?cpationing和

NoCaps

\text{NoCaps}

NoCaps这样的

VL

\text{VL}

VL生成任务。结果线上,由新目标检测模型产生的以目标为中心的表示极大的改善了各种

VL

\text{VL}

VL任务,通常比使用经典目标检测模型的baseline强很多,在各种任务上创造了新的

SOTA

\text{SOTA}

SOTA。

? 本文的主要贡献总结如下:(1) 提出了一个全面的实证研究来表明

VL

\text{VL}

VL模型中的视觉特征至关重要;(2) 开发了一个新的目标检测模型,相比于传统的目标检测模型,其能够产生更好的视觉特征,并且在所有主要的

VL

\text{VL}

VL任务的多个公开基准上实现了state-of-the-art结果;(3) 提供了详细的预训练目标检测的消融实验。

二、改善视觉语言 ( VL ) (\text{VL}) (VL)中的视觉 ( V ) (\text{V}) (V)

? 基于深度学习的

VL

\text{VL}

VL模型通常由两个模块组成:一个图像理解模块

Vision

\text{Vision}

Vision和一个跨模态理解模块

VL

\text{VL}

VL:

(

q

,

v

)

=

Vision

(

I

m

g

)

,

y

=

VL

(

w

,

q

,

v

)

(1)

(\textbf{q},\textbf{v})=\textbf{Vision}(Img),\quad y=\textbf{VL}(\textbf{w},\textbf{q},\textbf{v}) \tag{1}

(q,v)=Vision(Img),y=VL(w,q,v)(1)

其中,

I

m

g

Img

Img和

w

\textbf{w}

w是视觉模态和语言模态的输入。

Vision

\textbf{Vision}

Vision模块的输出有

q

\textbf{q}

q和

v

\textbf{v}

v构成。

q

\textbf{q}

q图像的语义表示,例如标签或者检测到的对象,并且

v

\textbf{v}

v图像在高维隐空间中的分布式表示,例如由

VG-pretrained?Faster-RCNN

\text{VG-pretrained Faster-RCNN}

VG-pretrained?Faster-RCNN产生的box或者区域特征。大多数的

VL

\textbf{VL}

VL模型仅使用视觉特征

v

\textbf{v}

v,而近期提出的

OSCAR

\text{OSCAR}

OSCAR模型显示

q

\textbf{q}

q可以作为学习更好视觉语言联合表示的锚点,并且改善各种

VL

\text{VL}

VL任务的表现。等式

(

1

)

(1)

(1)中

VL

\textbf{VL}

VL模块的

w

\textbf{w}

w和

y

y

y在不同的

VL

\textbf{VL}

VL任务中是不同的。在

VQA

\text{VQA}

VQA中,

w

\textbf{w}

w是问题且

y

y

y是被预测的答案。在text-image检索中,

w

\textbf{w}

w是一个句子而

y

y

y是句子和图像对的匹配分数。在image captioning任务中,

w

\textbf{w}

w没有给定且

y

y

y是生成的caption。

? 受预训练语言模型在各种自然语言处理任务上巨大成功的启发,

VLP

\text{VLP}

VLP在改善跨模态理解模块

VL

\textbf{VL}

VL上实现了显著的成功,通过:(1) 使用

Transformer

\text{Transformer}

Transformer统一建模视觉和语言;(2) 使用大规模的text-image语料来预训练统一的

VL

\textbf{VL}

VL。然而,大多数

VLP

\text{VLP}

VLP工作将图像理解模块

Vision

\text{Vision}

Vision作为一个黑盒,并且未对视觉特征进行改进。尽管如此,目标检测的改进已经有了许多进展,通过:(1) 开发了更多样、丰富并且更大的训练集;(2) 在目标检测算法上有了更多的洞见,例如:feature pyramid network、one-stage dense prediction和anchor-free detectors;(3) 利用更强劲的

GPU

\text{GPU}

GPU训练更大的模型。

? 在本工作中,作者专注在改善

Vision

\textbf{Vision}

Vision来获得更好的视觉表示。作者开发了一个新的

OD

\text{OD}

OD模型,通过丰富视觉对象和属性类别,增大模型尺寸,在一个更大的

OD

\text{OD}

OD数据集上训练,从而在广泛的

VL

\text{VL}

VL任务上达到的state-of-the-art。

1. 目标检测预训练

? 为了改善 VL \text{VL} VL任务的 OD \text{OD} OD模型,作者利用了4个公开的目标检测数据集。由于许多数据集都没有属性标注,作者采用预训练和微调的策略来构建 OD \text{OD} OD模型。首先在一个包含四个公开数据集上的大规模语料上预训练 OD \text{OD} OD模型,然后在 Visual?Genome \text{Visual Genome} Visual?Genome上微调具有额外属性分支的模型,使其能够检测目标和属性。

1.1 数据

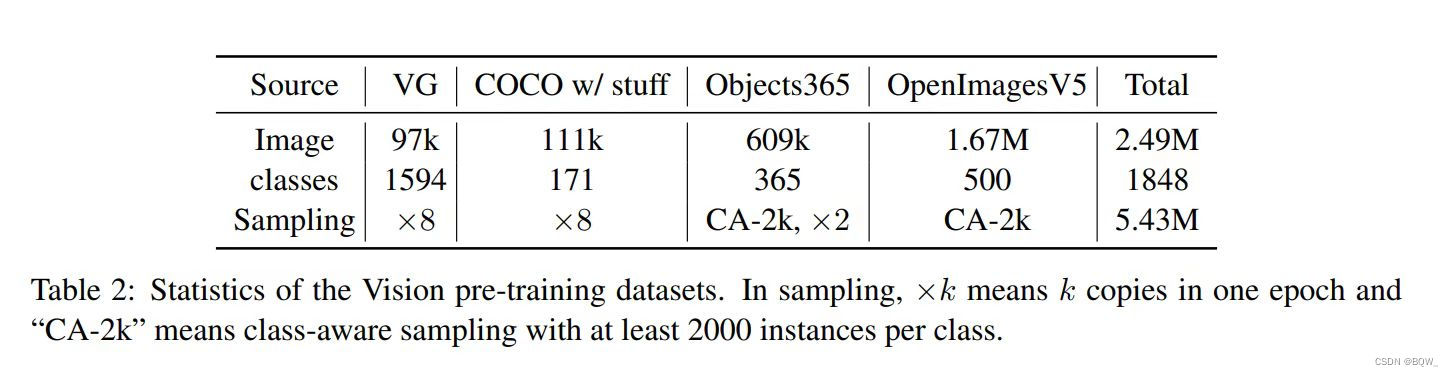

? 上表汇总了本目标检索预训练使用的四个数据集的统计信息,包括: COCO \text{COCO} COCO、 OpenImagesV5(OI) \text{OpenImagesV5(OI)} OpenImagesV5(OI)、 Objects365V1 \text{Objects365V1} Objects365V1和 Visual?Genome(VG) \text{Visual Genome(VG)} Visual?Genome(VG)。这些数据集具有互补的特征,并且在数据尺寸、目标词表和每个类别的标准数量上都极度不平衡。例如, VG \text{VG} VG数据集对于目标和属性具有丰富且多样的标注。但是,它的标注有噪音并且会受到缺失标注的影响。另一方面, COCO \text{COCO} COCO数据集则标注的非常好,但是覆盖的视觉对象和属性远低于 VG \text{VG} VG。遵循下游的步骤来合并4个数据集来构建一个统一的语料。

- 首先,为了增强尾部类别的视觉概念,在

OpenImages

\text{OpenImages}

OpenImages和

Objects365

\text{Objects365}

Objects365上执行类别意识的采样来获得每个类别至少2000个实例,最终得到

2.2M和0.8M图像。 - 为了平衡每个数据集的贡献,作者合并四个数据集使用, COCO \text{COCO} COCO的8个拷贝 ( 8 × 0.11 M ) (8\times 0.11M) (8×0.11M)、 VG \text{VG} VG的8个拷贝 ( 8 × 0.1 M ) (8\times 0.1M) (8×0.1M)、类别意识采样 Objects365 \text{Objects365} Objects365的2个拷贝 ( 2 × 0.8 M ) (2\times 0.8M) (2×0.8M)、类别意识采样 OpenImages \text{OpenImages} OpenImages的1个拷贝 (2.2M) \text{(2.2M)} (2.2M)。

- 为了统一对象词表,作者使用 VG \text{VG} VG词表以及对象的别名作为基础的词表,然后将其他三个数据集中的与 VG \text{VG} VG类别相匹配的类别合并至 VG \text{VG} VG,若不匹配则添加一个新类别。

- 最后,作者保留了

VG

\text{VG}

VG中至少有30个实例的类别,最终有

1594个 VG \text{VG} VG类别,以及来自其他三个数据集中无法映射至 VG \text{VG} VG词表的254个类别,最终合并的目标检测数据集包含1848个类别。

1.2 模型架构( FPN?vs?C4 \text{FPN vs C4} FPN?vs?C4)

? 虽然研究现实 FPN \text{FPN} FPN模型在目标检测上效果优于 C4 \text{C4} C4,但最近的研究表明 FPN \text{FPN} FPN并不能向 VL \text{VL} VL提供比 C4 \text{C4} C4更好的区域特征。因此,本文作者精心设计了一组实验并发现了主要的原因。首先, C4 \text{C4} C4中用于区域特征抽取的所有层都是使用 ImageNet \text{ImageNet} ImageNet预训练过的,而 FPN \text{FPN} FPN模型的 MLP \text{MLP} MLP头则没有。这也证明了 VG \text{VG} VG数据集对于 VL \text{VL} VL任务生成足够好的视觉特征仍然是太小了,并且使用 ImageNet \text{ImageNet} ImageNet预训练权重是有益的。其次是由于不同的网络架构 ( CNN?vs.?MLP ) (\text{CNN vs. MLP}) (CNN?vs.?MLP)。相较于 FPN \text{FPN} FPN中的 MLP \text{MLP} MLP头, C4 \text{C4} C4中使用的卷积头能够在编码视觉信息时更好的归纳偏差。因此,本文中使用 C4 \text{C4} C4架构用于 VLP \text{VLP} VLP。

1.3 模型预训练

? 遵循目标检测训练中的常用实践,冻结第一个卷积层、第一个残差层和所有的batch-norm层。使用几种数据增强的方法,包括:horizontal flipping和multi-scale training。为了使用

X152-C4

\text{X152-C4}

X152-C4架构训练检测模型,从

ImageNet-5K?checkpoint

\text{ImageNet-5K checkpoint}

ImageNet-5K?checkpoint中初始化模型主干,并以batch size为16张图片训练1.8M次迭代。

2. 向模型中注入属性信息

? 向预训练 OD \text{OD} OD模型上添加一个属性分支,然后在 VG \text{VG} VG上微调 OD \text{OD} OD模型来注入属性信息。由于在目标检测预训练阶段已经对目标表示进行了预训练,通过使用一个更大的属性损失函数权重1.25来使 VG \text{VG} VG微调专注在学习属性。这种方式得到的模型在 VG \text{VG} VG上检测目标和属性显著超越了先前的模型。

3. 用于 VL \text{VL} VL任务的区域特征抽取器

? 随着视觉对象和属性的丰富,传统的类别感知非最大抑制后处理

NMS

\text{NMS}

NMS来删除重叠的bounding boxes,这使得特征抽取过程非常的慢。为了改善效率,使用类别不可知

NMS

\text{NMS}

NMS来替换类别感知

NMS

\text{NMS}

NMS,这样仅执行

NMS

\text{NMS}

NMS一次。作者也将耗时的膨胀卷积替换为非膨胀卷积。这两个替换使得区域特征抽取过程快了许多,并且在

VL

\text{VL}

VL任务上没有准确率的损失。

? 综上所述,预训练 OD \text{OD} OD模型作为图像 理解模块来产生视觉表示 ( q , v ) (\textbf{q},\textbf{v}) (q,v)用来下游的 VL \text{VL} VL任务。这里, q \textbf{q} q是检测到目标的名称集合,且 v \textbf{v} v是区域特征集合。每个区域特征都被表示为 ( v ^ , z ) (\hat{v},z) (v^,z),其中 v ^ \hat{v} v^是来自检测头最后线性分类层输入的 P P P维表示,并且 z z z是区域的 R R R维度位置编码。

三、 OSCAR \text{OSCAR} OSCAR+预训练

?

VLP

\text{VLP}

VLP的成功在于为广泛的

VL

\text{VL}

VL任务使用统一的架构,并且使用与下游

VL

\text{VL}

VL任务表现相关的目标函数来大规模预训练统一模型。本文中,作者预训练一个改善版本的

OSCAR

\text{OSCAR}

OSCAR,称之为

OSCAR+

\text{OSCAR+}

OSCAR+模型,使用图像的标签作为锚点来学习联合image-text表示。

1. 预训练语料

? 基于现有的三个视觉和

VL

\text{VL}

VL数据集构建预训练语料:(1) image captioning数据集,具有人工标注的captions

w

\textbf{w}

w和机器生成的图像标签

q

\textbf{q}

q,包括:

COCO

\text{COCO}

COCO、

Conceptual?Captions(CC)

\text{Conceptual Captions(CC)}

Conceptual?Captions(CC)、

SBU?cpations

\text{SBU cpations}

SBU?cpations和

flicker30k

\text{flicker30k}

flicker30k;(2) 具有问题

w

\textbf{w}

w和人工标注答案

q

\textbf{q}

q的视觉

QA

\text{QA}

QA数据集,包括:

GQA

\text{GQA}

GQA、

VQA

\text{VQA}

VQA和

VG-QAs

\text{VG-QAs}

VG-QAs;(3) 具有机器生成captions

w

\textbf{w}

w和人工标注标签

q

\textbf{q}

q的image tagging数据集,包括

OpenImages

\text{OpenImages}

OpenImages的一个子集。总的来说,语料包括565万个唯一图片,885万个text-tag-image三元组。数据集的详细统计信息见附录。通过合并大规模的image tagging数据集,预训练语料的规模显著增加,例如

OpenImages(9M?images)

\text{OpenImages(9M images)}

OpenImages(9M?images)和

YFCC(92M?images)

\text{YFCC(92M images)}

YFCC(92M?images)。

2. 预训练目标

?

OSCAR+

\text{OSCAR+}

OSCAR+预训练损失函数包含两个项:

L

P

r

e

?

t

r

a

i

n

i

n

g

=

L

MTL

+

L

CL3

(2)

\mathcal{L}_{Pre-training}=\mathcal{L}_{\text{MTL}}+\mathcal{L}_{\text{CL3}} \tag{2}

LPre?training?=LMTL?+LCL3?(2)

L

MTL

\mathcal{L}_{\text{MTL}}

LMTL?是定义在文本模态(

w

\textbf{w}

w和

q

\textbf{q}

q)上的Masked Token Loss。

L

CL3

\mathcal{L}_{\text{CL3}}

LCL3?是一个新颖的三路对比损失函数。不同于

OSCAR

\text{OSCAR}

OSCAR中使用的二元对比损失函数,提出的三路对比损失函数能够有效的优化

VQA

\text{VQA}

VQA和text-image matching使用的目标函数。如等式

(

3

)

(3)

(3)所属,

L

CL3

\mathcal{L}_{\text{CL3}}

LCL3?会考虑两种类型的训练样本

x

\textbf{x}

x:在image captioning和image tagging数据中的{caption,image-tags,image-features}三元组,以及

VQA

\text{VQA}

VQA数据中的{question,answer,image-features}三元组。

x

?

(

w

?

caption

,

q,v

?

tags&image

)

or

(

w,q

?

Q&A

,

v

?

image

)

(3)

\textbf{x}\triangleq (\underbrace{\textbf{w}}_{\text{caption}},\underbrace{\textbf{q,v}}_{\text{tags\&image}})\quad \text{or}\quad(\underbrace{\textbf{w,q}}_{\text{Q\&A}},\underbrace{\textbf{v}}_{\text{image}}) \tag{3}

x?(caption

w??,tags&image

q,v??)or(Q&A

w,q??,image

v??)(3)

? 为了计算对比损失函数,需要构造负样本。作者为两类训练样本构造了两种类型的负三元组。一种是使用破坏的captions

(

w

′

,

q

,

v

)

(\textbf{w}',\textbf{q}, \textbf{v})

(w′,q,v),另一种是使用破坏的answers

(

w

,

q

′

,

v

)

(\textbf{w},\textbf{q}',\textbf{v})

(w,q′,v)。为了分类caption-tags-image三元组是否包含被破坏的caption是一个text-image匹配任务。为了分类一个question-answer-image三元组是否包含被破坏的answer是一个

VQA

\text{VQA}

VQA的答案选择任务。由于[CLS]的编码能够被看作是三元组

(

w

,

q

,

v

)

(\textbf{w},\textbf{q}, \textbf{v})

(w,q,v)的一个表示,所以在其上应用全链接层来作为三分类器,用于预测三元组为匹配

(

c

=

0

)

(c=0)

(c=0)、包含被破坏的

w

(

c

=

1

)

\textbf{w}(c=1)

w(c=1)、或者包含被破坏的

q

(

c

=

2

)

\textbf{q}(c=2)

q(c=2)。三路对比损失函数定义为:

L

CL3

=

?

E

(

w

,

q

,

v

;

c

)

~

D

~

log

??

p

(

c

∣

f

(

w

,

q

,

v

)

)

(4)

\mathcal{L}_{\text{CL3}}=-\mathbb{E}_{(\textbf{w},\textbf{q},\textbf{v};c)\sim\tilde{D}}\text{log}\;p(c|f(\textbf{w},\textbf{q},\textbf{v})) \tag{4}

LCL3?=?E(w,q,v;c)~D~?logp(c∣f(w,q,v))(4)

其中,数据集

(

w

,

q

,

v

;

c

)

∈

D

~

(\textbf{w},\textbf{q},\textbf{v};c)\in\tilde{D}

(w,q,v;c)∈D~包含50%的匹配三元组,25%的破坏

w

\textbf{w}

w三元组和25%的破坏

q

\textbf{q}

q三元组。为了更加有效的实现,被破坏的

w

′

\textbf{w}'

w′是从所有

w

\textbf{w}

w中均匀采样的,并且

q

′

\textbf{q}'

q′是从所有

q

\textbf{q}

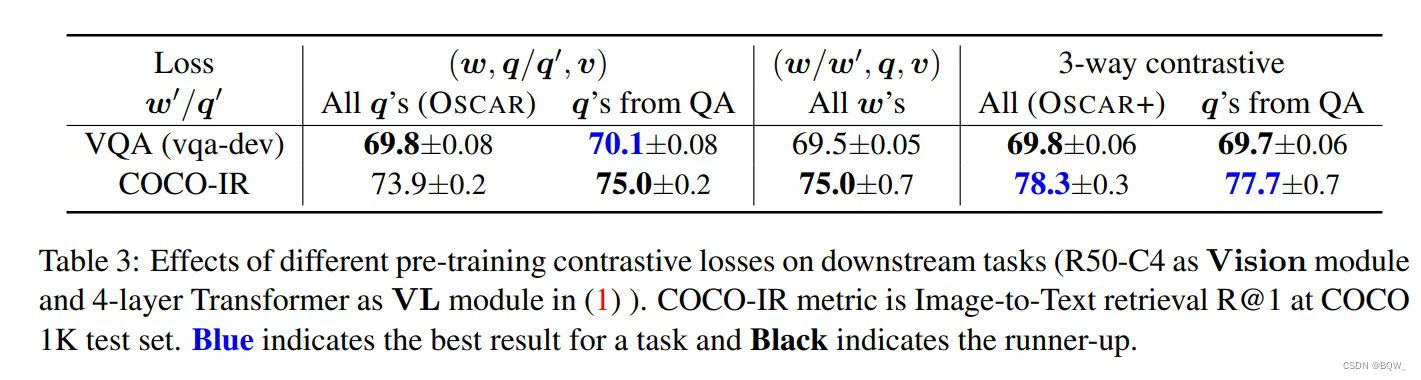

q中均匀采样的。正如上表所示,当仅使用被破坏答案的三元组,即从QA数据集中的

q

\textbf{q}

q中采样

q

′

\textbf{q}'

q′而得到的三元组

(

w

,

q

′

,

v

)

(\textbf{w},\textbf{q}',\textbf{v})

(w,q′,v),对比损失函数会模拟近似

VQA

\text{VQA}

VQA任务的目标函数,而不是text-image检索任务。因此,预训练模型能够有效的适应

VQA

\text{VQA}

VQA,但不能适应text-image检索。作为对比,提出的三路对比损失函数能够在两个任务上都很好的迁移。

3. 预训练模型

? 作者预训练了两个模型变体,表示为

OSCAR+

B

\text{OSCAR+}_{B}

OSCAR+B?和

OSCAR+

L

\text{OSCAR+}_{L}

OSCAR+L?,其分别使用

BERT?base

\text{BERT base}

BERT?base和

BERT?large

\text{BERT large}

BERT?large的参数

θ

BERT

\theta_{\text{BERT}}

θBERT?进行初始化。为了确保图像区域特征的输入embeddings尺寸与

BERT

\text{BERT}

BERT相同,作者通过一个具有矩阵

W

\textbf{W}

W的线性投影来转换位置增强的区域特征。可训练参数为

θ

=

{

θ

BERT

,

W

}

\theta=\{\theta_{\text{BERT}},\textbf{W}\}

θ={θBERT?,W}。

OSCAR+

B

\text{OSCAR+}_{B}

OSCAR+B?至少训练1M steps,学习率为

1

e

?

4

1e^{-4}

1e?4并且batch size为1024。

OSCAR+

L

\text{OSCAR+}_{L}

OSCAR+L?则以学习率

3

e

?

5

3e^{-5}

3e?5和batch size为1024训练了至少1M steps。

四、适应 VL \text{VL} VL任务

? 作者将预训练模型应用于7个下游的 VL \text{VL} VL任务,包括5个理解任务和2个生成任务。本小节会简要介绍任务以及微调策略。

VQA & GQA

? 这两个是研究社区用于评估

VL

\text{VL}

VL模型广泛使用的理解任务。该任务需要模型基于图像来回答自然语言问题。在本文中,在广泛使用的VQA v2.0和GQA数据集上执行实验。对于每个问题,模型会从共享的答案集合中挑选一个答案。当将一个

VLP

\text{VLP}

VLP模型应用在

VQA

\text{VQA}

VQA任务中,作者将给定的问题、目标标签和目前区域特征进行拼接来构造输入,然后将

OSCAR+

\text{OSCAR+}

OSCAR+输出的[CLS]对应的特征输入至一个任务相关的分类器,进行答案预测。

Image Captioning & NoCaps

? captioning任务是对于给定的图像生成一个自然语言的caption。其是被研究社区广泛使用的

VL

\text{VL}

VL生成任务,截止2020年12月10日,

Image?Captioning?Leaderboard

\text{Image Captioning Leaderboard}

Image?Captioning?Leaderboard有超过260个模型。为了实现caption生成,使用seq2seq目标函数来微调

OSCAR+

\text{OSCAR+}

OSCAR+。每个训练样本都会被转换为一个三元组,该三元由一个caption、图像区域特征集合、以及目标标签集合组成。随机遮蔽caption中15%的tokens,并使用余下内容的编码来预测被遮蔽的tokens。对自注意力掩码进行约束,使其只能关注caption中当前位置之前的tokens来模拟单向生成的过程。所有的caption token都会全部注意力至图像区域和目标标签。在推断的过程中,先编码图像区域、目标标签以及特定token [CLS]作为输入。然后模型通过输入[MASK] token来生成caption,并基于token的概率输出从词表中采样token。接下来,前面输入序列中的[MASK] token被替换为采样的token,并且添加一个新的[MASK]用于下一个词的预测。当模型输出[STOP] token或者生成的句子超过预定义的最大长度,则生成过程终止。在COCO image captioning数据集上执行图像实验。

Novel?Ojbect?Captioning?at?Scale

\text{Novel Ojbect Captioning at Scale}

Novel?Ojbect?Captioning?at?Scale扩展了图像captioning任务来测试模型描述训练集中未出现的新目标的能力。遵循

NoCaps

\text{NoCaps}

NoCaps的限制,使用预测的

Visual?Genome

\text{Visual Genome}

Visual?Genome和

Open?Images

\text{Open Images}

Open?Images标签来形成输入标签序列,并直接在

COCO

\text{COCO}

COCO上训练

OSCAR+

\text{OSCAR+}

OSCAR+,而不适应预训练进行初始化。

Image(-to-Text) Retrieval & Text(-to-Image) Retrieval

? 这两个任务都需要模型来计算图像和句子的相似分数。因此,该任务被广泛应用于直接衡量跨模态

VL

\text{VL}

VL表示的质量。将该任务形式化为一个二分类问题,给定一个匹配的image-text对,随机的选择不同的图像或者不同的句子来形成不匹配对。[CLS]表示被用作分类器的输入来预测一个分数,该分数表示给定的样本对是否匹配。在测试中,预测的分数被用于排序给定的image-text对。作者报告了在1K和5K COCO测试集上的top-K检索结果。

NLVR2

? 该数据集用于自然语言和图像的联合推理。该任务需要确认关于一对图像的文本描述是否为真。为了微调,先构造两个输入序列,每个序列包含给定文本描述和一个图像的拼接,并且从

OSCAR+

\text{OSCAR+}

OSCAR+中输出的两个[CLS]被拼接来形成输入,用于二分类预测。