深度学习分类网络总结

前言

Network in Network中提出了两个重要的思想,分别为:

- 1×1卷积实现跨通道信息交互,增加非线性表达

- 结合增强的局部建模,可以用全局平均池化替代全连接层,更具解释性,减轻过拟合

这两点在后来的Inception系列网络和ResNet中都得以体现。

1. 网络结构

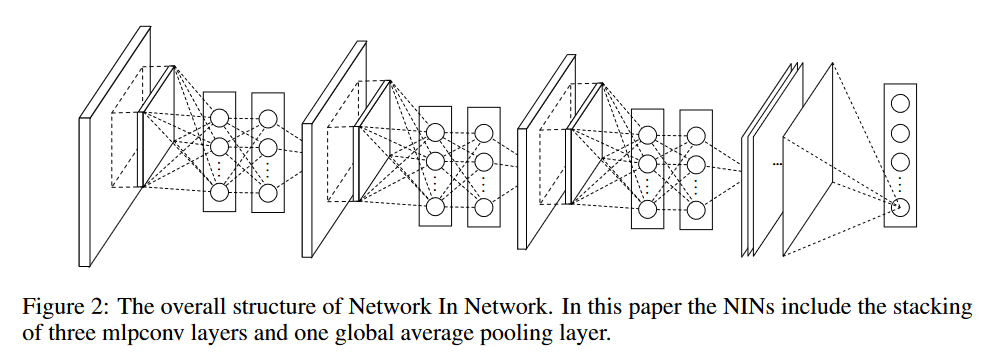

网络结构比较简洁,由三个mlpconv层和一个全局平均池化层组成。所谓的mlpconv在实现的时候就是3×3卷积+两个1×1卷积。

2. 要点

2.1 mlpconv

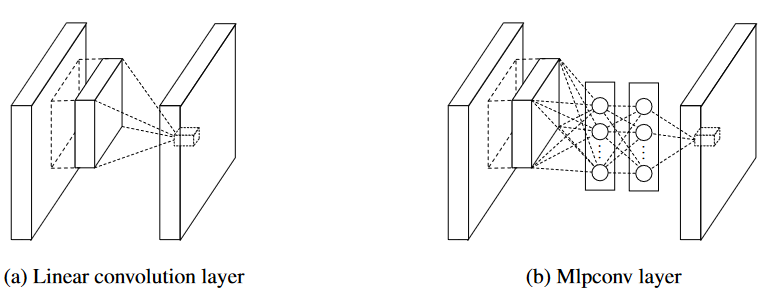

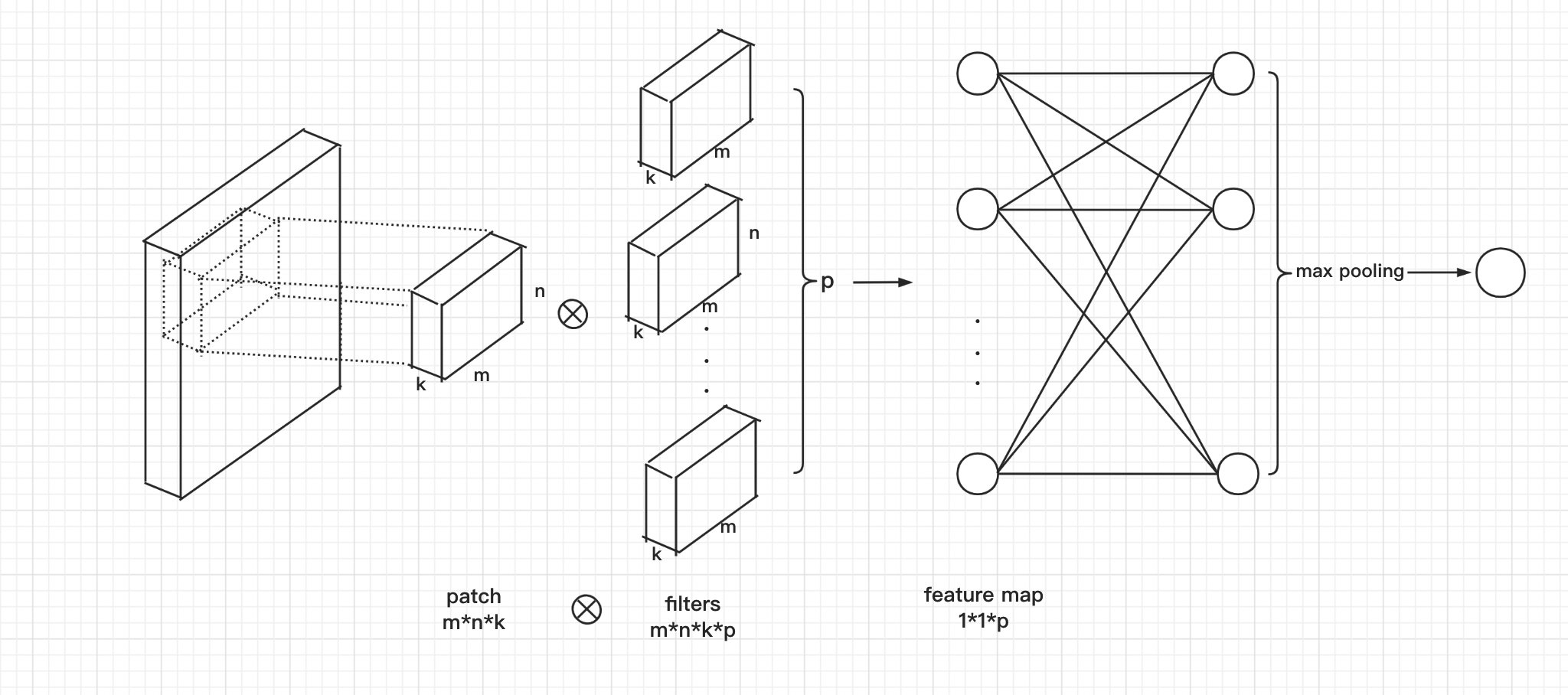

ZFNet中使用可视化技术揭示了特征图中的激活值对应一些潜在概念(类别信息),激活值越大,对应输入patch中包含潜在概念的概率越大。当潜在概念线性可分时,传统的线性卷积+非线性激活的模式能够鉴别,但是潜在概念的置信度通常是输入的高度非线性函数。因此,论文中提出使用micro network来代替线性卷积+非线性激活,以增强局部潜在概念建模。作者使用多层感知机(MLP)作为micro network的实例化,因为MLP是一个通用的函数逼近器和一个可通过反向传播训练的神经网络,基于MLP建立的micro network被命名为mlpconv。

这里引用一下这篇博客中的一张图,一目了然,我觉得能够清晰地解释Mlpconv层。

2.2 全局平均池化

在NIN中没有采用传统的全连接层进行分类,而是通过全局平均池化层直接输出最后一个mlpconv层的特征映射的平均值作为类别的置信度,然后将得到的向量输入softmax层。这样做有两个好处:

- 可解释性更强:类别信息是直接由特征图全局平均池化所得,加强了特征映射和类别之间的对应关系;

- 避免过拟合:全局平均池化本身是一个结构正则化器,可以防止对整体结构的过拟合。

参考资料

[1] Lin M, Chen Q, Yan S. Network in network[J]. arXiv preprint arXiv:1312.4400, 2013.

[2] 【论文精读】Network In Network(1*1 卷积层代替FC层 global average pooling)