Abstract

我们提出了一个概念上简单、灵活和通用的目标实例分割框架。我们的方法有效地检测图像中的目标,同时为每个实例生成高质量的分割mask。该方法称为Mask R-CNN,通过添加用于预测目标mask的分支与用于边界框识别的现有分支并行来扩展Faster R-CNN。 Mask R-CNN很容易训练,并且只为Faster R-CNN增加了一点开销,运行速度为5 fps。此外,Mask R-CNN很容易推广到其他任务,例如,允许我们在同一框架中估计人体姿态。我们在COCO挑战套件的所有三个轨道中展示了最佳结果,包括实例分割、边界框目标检测、和人物关键点检测。没有花里胡哨的东西,Mask R-CNN在每项任务上都优于所有现有的单一模型条目,包括COCO 2016挑战赛的获胜者。我们希望我们简单而有效的方法将作为一个坚实的基准,并有助于简化未来在实例级识别方面的研究。代码已在以下位置提供:https://github.com/facebookresearch/Detectron。

1. Introduction

视觉社区在短时间内迅速改进了目标检测和语义分割结果。在很大程度上,这些进步是由强大的baseline系统推动的,例如分别用于目标检测和语义分割的Fast/Faster RCNN[12, 36]和全卷积网络(FCN)[30]框架。这些方法在概念上很直观,提供了灵活性和鲁棒性,以及快速的训练和推理时间。我们在这项工作中的目标是为实例分割开发一个类似的支持框架。

实例分割具有挑战性,因为它需要正确检测图像中的所有目标,同时还要精确分割每个实例。因此,它结合了目标检测的经典计算机视觉任务中的元素,其中目标是对单个目标进行分类并使用边界框定位每个目标,以及语义分割,其中目标是将每个像素分类为一组固定的类别而不区分目标实例(按照通用术语,我们使用目标检测来表示通过边界框而不是mask进行检测,并使用语义分割来表示逐像素分类而不区分实例。然而,我们注意到实例分割既是语义又是一种检测形式。)。鉴于此,人们可能期望需要一种复杂的方法才能获得良好的结果。然而,我们展示了一个令人惊讶的简单、灵活和快速的系统可以超越先前最先进的实例分割结果。

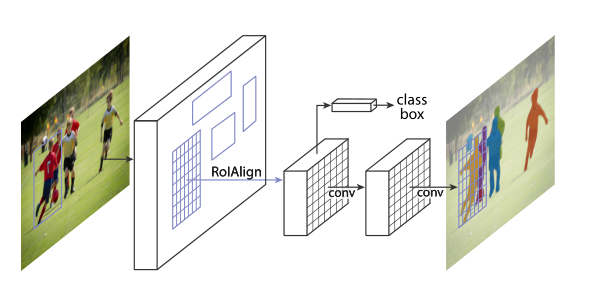

图 1. 用于实例分割的Mask R-CNN框架。

我们的方法称为Mask R-CNN,扩展了Faster R-CNN[36],方法是在每个感兴趣区域(RoI)上添加一个用于预测分割mask的分支,与用于分类和边界框回归的现有分支并行(图1)。mask分支是应用于每个RoI的小型FCN,以像素到像素的方式预测分割mask。鉴于Faster R-CNN框架,Mask R-CNN易于实现和训练,这有助于广泛的灵活架构设计。此外,mask分支仅增加了少量计算开销,从而实现了快速系统和快速实验。

原则上,Mask R-CNN是Faster R-CNN的直观扩展,但正确构建mask分支对于获得良好结果至关重要。最重要的是,Faster RCNN并不是为网络输入和输出之间的像素到像素对齐而设计的。这在RoIPool[18, 12](用于处理实例的事实上的核心操作)如何为特征提取执行粗略空间量化时最为明显。为了解决错位问题,我们提出了一个简单的quantization-free层,称为RoIAlign,它忠实地保留了精确的空间位置。尽管看起来很小的变化,但RoIAlign产生了很大的影响:它将mask准确率提高了10%到50%,在更严格的定位指标下显示出更大的收益。其次,我们发现解耦mask和类别预测至关重要:我们独立地为每个类别预测一个二进制mask,没有类别之间的竞争,并依靠网络的RoI分类分支来预测类别。相比之下,FCN通常执行逐像素多类分类,将分割和分类结合起来,并且根据我们的实验,实例分割效果不佳。

没有花里胡哨的东西,Mask R-CNN在COCO实例分割任务[28]上超越了所有以前最先进的单模型结果,包括2016年竞赛获胜者的精心设计的条目。作为额外实验,我们的方法在COCO目标检测任务上也表现出色。在消融实验中,我们评估了多个基本实例,这使我们能够证明其稳健性并分析核心因素的影响。

我们的模型可以在GPU上以每帧约200毫秒的速度运行,而在COCO上的训练在单个8-GPU机器上需要一到两天时间。我们相信,快速的训练和测试速度,以及框架的灵活性和准确性,将有利于并简化未来对实例分割的研究。

最后,我们通过在COCO关键点数据集[28]上进行人体姿态估计的任务展示了我们框架的通用性。通过将每个关键点视为one-hot二进制mask,只需进行最小修改,Mask R-CNN就可以用于检测特定于实例的姿态。 Mask R-CNN超越了2016年COCO关键点竞赛的获胜者,同时以5 fps的速度运行。因此,Mask R-CNN可以被更广泛地视为实例级识别的灵活框架,并且可以很容易地扩展到更复杂的任务。

我们已经发布了代码以促进未来的研究。

2. Related Work

R-CNN: 基于区域的CNN(R-CNN)方法[13]用于边界框目标检测,关注可管理数量的候选目标区域[42,20]并在每个RoI上独立评估卷积网络[25,24]。扩展了R-CNN[18,12]以允许使用RoIPool关注特征地图上的ROI,从而提高速度和准确性。Faster R-CNN[36]通过学习区域提议网络(RPN)的注意机制推进了这种流。Faster R-CNN对于许多后续改进(例如[38,27,21])是灵活和健壮的,并且在几个基准中是当前领先的框架。

实例分割: 在RCNN的有效性驱动下,许多实例分割方法都是基于分割proposal的。早期的方法[13, 15, 16, 9]采用自下而上的分割[42, 2]。DeepMask[33]和后续作品[34, 8]学习提出候选分割,然后由Fast R-CNN分类。在这些方法中,分割先于识别,这是缓慢且不太准确的。同样,Dai等人[10]提出了一种复杂的多阶段级联,从边界框proposal中预测分割proposal,然后进行分类。相反,我们的方法基于mask和类标签的并行预测,更简单、更灵活。

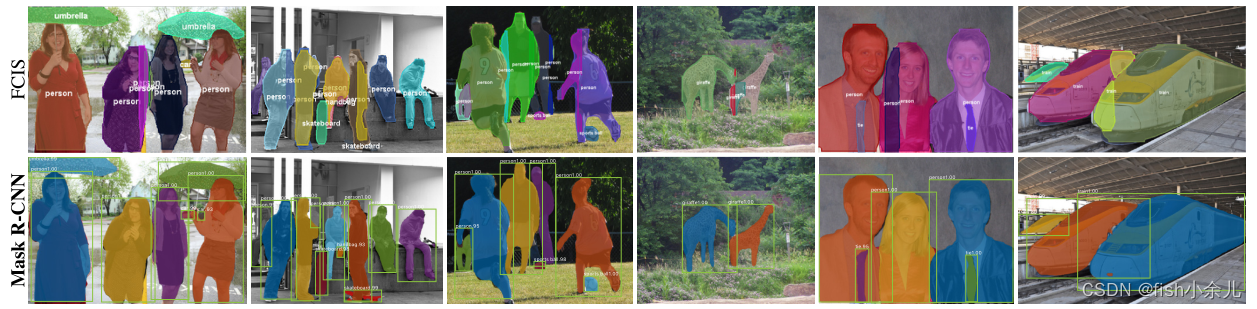

最近,Li等人[26]将[8]中的分割proposal系统和[11]中的目标检测系统结合起来用于“全卷积实例分割”(FCIS)。 [8, 11, 26] 中的共同思想是全卷积地预测一组位置敏感的输出通道。这些通道同时处理目标类、框和mask,使系统运行速度更快。但是FCIS在重叠实例上表现出系统错误并产生虚假边缘(图6),表明它受到分割实例的基本困难的挑战。

另一个实例分割的解决方案系列[23, 4, 3, 29]是由语义分割的成功驱动的。从每个像素的分类结果(如FCN输出)开始,这些方法试图将同一类别的像素切割成不同的实例。与这些方法的分割优先策略相比,Mask R-CNN是基于实例优先策略的。我们期望未来能对这两种策略进行更深入的整合研究。

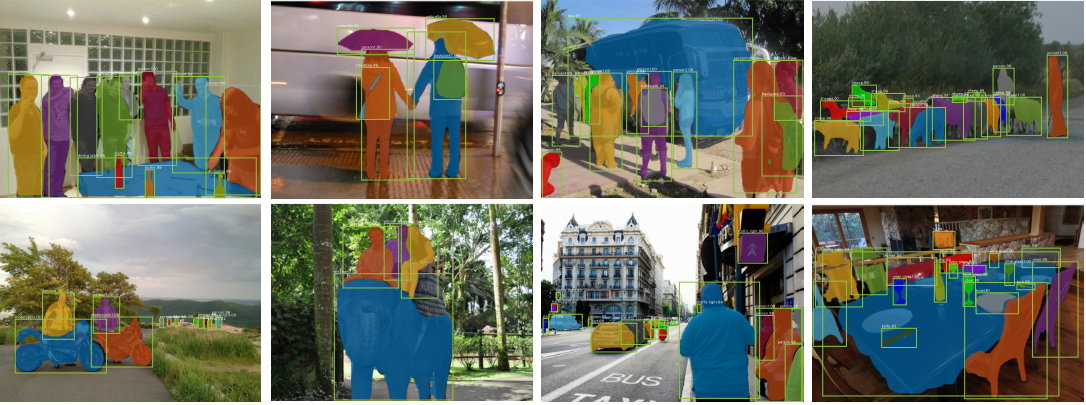

图 2. COCO测试集上的Mask R-CNN结果。这些结果基于ResNet-101[19],实现了35.7的掩码AP并以5 fps运行。mask以颜色显示,并且还显示了边界框、类别和置信度。

3. Mask R-CNN

Mask R-CNN在概念上很简单:Faster R-CNN对每个候选目标有两个输出,一个类标签和一个边界框偏移量;为此,我们添加了输出目标mask的第三个分支。因此,Mask R-CNN是一个自然而直观的想法。但是额外的mask输出与类和框输出不同,需要提取更精细的目标空间布局。接下来,我们介绍Mask R-CNN的关键元素,包括像素到像素对齐,这是Fast/Faster R-CNN的主要缺失部分。

Faster R-CNN: 我们首先简要回顾Faster R-CNN检测器[36]。 Faster R-CNN由两个阶段组成。第一阶段称为区域提议网络(RPN),提出候选目标边界框。第二阶段本质上是Fast R-CNN[12],使用RoIPool从每个候选框中提取特征,并执行分类和边界框回归。两个阶段使用的特征可以共享以加快推理速度。我们推荐读者参考[21],以了解Faster R-CNN和其他框架之间的最新、全面的比较。

Mask R-CNN: Mask R-CNN采用相同的两阶段过程,具有相同的第一阶段(即RPN)。在第二阶段,在预测类和框偏移的同时,Mask R-CNN还为每个RoI输出一个二进制mask。这与最近的系统形成对比,后者的分类取决于mask预测(例如[33, 10, 26])。我们的方法遵循Fast R-CNN[12]的精神,并行应用边界框分类和回归(事实证明,这在很大程度上简化了原始R-CNN[13]的多阶段管道。

正式地,在训练期间,我们将每个采样RoI上的多任务损失定义为 L = L c l s + L box? + L mask? L=L_{c l s}+L_{\text {box }}+L_{\text {mask }} L=Lcls?+Lbox??+Lmask??。分类损失 L c l s L_{c l s} Lcls?和边界框损失 L box? L_{\text {box }} Lbox??与[12]中定义的相同。mask分支对每个RoI都有一个 K m 2 K m^{2} Km2维输出,它编码分辨率为 m × m m \times m m×m的 K K K个二进制mask,每个 K K K个类别一个。为此,我们应用每像素sigmoid,并将 L m a s k L_{mask} Lmask?定义为平均二进制cross-entropy损失。对于与ground-truth类 k k k相关的RoI, L m a s k L_{mask} Lmask?仅在第 k k k个mask上定义(其他mask输出对损失没有贡献)。

我们对 L m a s k L_{mask} Lmask?的定义允许网络为每个类生成mask,而不会在类之间进行竞争;我们依靠专用的分类分支来预测用于选择输出mask的类标签。这将mask和类别预测解耦。这与将FCN[30]应用于语义分割时的常见做法不同,后者通常使用每像素softmax和多项交叉熵损失。在这种情况下,不同类别的面具会相互竞争;在我们的例子中,对于每像素sigmoid和二元损失,它们不会。我们通过实验表明,该公式是获得良好实例分割结果的关键。

mask表示: mask对输入目标的空间布局进行编码。因此,与通过全连接(fc)层不可避免地折叠成短输出向量的类标签或框偏移不同,提取mask的空间结构可以通过卷积提供的像素到像素的对应关系自然地解决。

具体来说,我们使用FCN[30]从每个RoI预测一个 m × m m \times m m×m mask。这允许mask分支中的每一层保持明确的 m × m m \times m m×m目标空间布局,而不会将其折叠成缺乏空间维度的向量表示。与以前使用fc层进行mask预测的方法不同[33、34、10],我们的完全卷积表示需要更少的参数,并且如实验所示更准确。

这种像素到像素的行为要求我们的RoI特征(它们本身就是小特征图)能够很好地对齐,以忠实地保留显式的每像素空间对应关系。这促使我们开发以下RoIAlign层,该层在mask预测中起关键作用。

RoIAlign: RoIPool[12]是一种标准操作,用于从每个RoI中提取一个小的特征图(例如,7×7)。 RoIPool首先将一个浮点数RoI量化为特征图的离散粒度,然后将这个量化的RoI细分为空间bin,这些空间bin本身也进行了量化,最后聚合每个bin覆盖的特征值(通常通过最大池化)。例如,通过计算 [ x / 16 ] [x / 16] [x/16]在连续坐标 x x x上执行量化,其中16是特征图步幅, [ ? ] [\cdot] [?]是舍入;同样,在划分为bin(例如,7×7)时执行量化。这些量化会在RoI和提取的特征之间引入错位。虽然这可能不会影响分类,分类对小平移很稳健,但它对预测像素精确的mask有很大的负面影响。

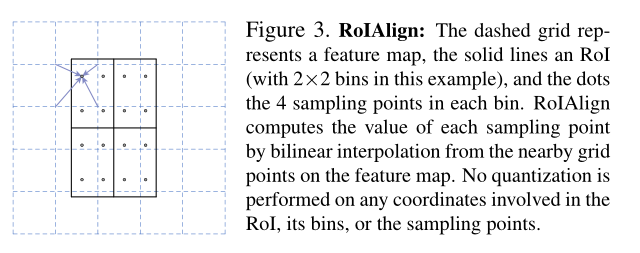

为了解决这个问题,我们提出了一个RoIAlign层,它消除了RoIPool的苛刻量化,将提取的特征与输入正确对齐。我们提出的改变很简单:我们避免对RoI边界或bin进行任何量化(即,我们使用 x / 16 x / 16 x/16而不是 [ x / 16 ] [x / 16] [x/16])。我们使用双线性插值[22]来计算每个RoI bin中四个定期采样位置的输入特征的精确值,并聚合结果(使用最大值或平均值),详见图3。我们注意到,只要不执行量化,结果对确切的采样位置或采样的点数不敏感。

如第4.2节所示,RoIAlign带来了巨大的改进。我们还比较了[10]中提出的RoIWarp操作。与RoIAlign不同,RoIWarp忽略了对齐问题,并在[10]中实现为像RoIPool一样量化RoI。因此,即使RoIWarp也采用了由[22]推动的双线性重采样,它的性能与实验所示的RoIPool相当(表2c中的更多细节),证明了对齐的关键作用。

图 3. RoIAlign:虚线网格表示特征图,实线表示RoI(在本例中为 2×2 bin),点表示每个bin中的4个采样点。 RoIAlign通过特征图上附近网格点的双线性插值计算每个采样点的值。不对任何涉及RoI、其bin或采样点的坐标执行量化。

网络架构: 为了展示我们方法的通用性,我们用多种架构实例化了Mask R-CNN。为清楚起见,我们区分:(i)用于对整个图像进行特征提取的卷积骨干架构,以及(ii)用于边界框识别(分类和回归)和mask预测的网络头,分别应用于每个RoI。

我们使用命名网络深度特征来表示骨干架构。我们评估深度为50或101层的ResNet[19]和ResNeXt[45]网络。使用ResNets[19]的Faster R-CNN的原始实现从第4阶段的最终卷积层中提取特征,我们称之为C4。例如,具有ResNet-50的主干由ResNet-50-C4表示。这是[19, 10, 21, 39]中使用的常见选择。

我们还探索了Lin等人[27]最近提出的另一个更有效的主干网络,称为特征金字塔网络(FPN)。 FPN使用带有横向连接的自上而下的架构,从单尺度输入构建网络内特征金字塔。具有FPN主干的Faster R-CNN根据其规模从特征金字塔的不同级别提取RoI特征,但除此之外,该方法的其余部分类似于vanilla ResNet。使用ResNet-FPN骨干网和Mask RCNN进行特征提取可以在准确度和速度上获得出色的提升。有关FPN的更多详细信息,我们请读者参考[27]。

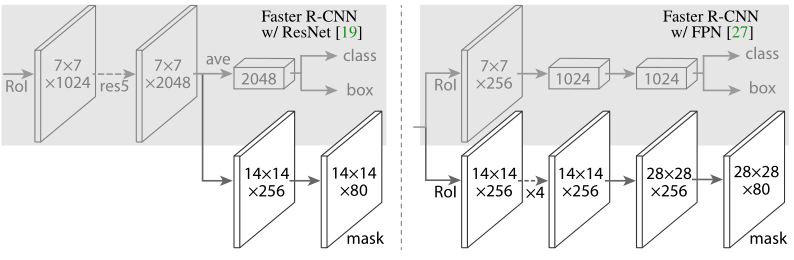

对于网络头,我们密切遵循之前工作中提出的架构,我们在其中添加了一个全卷积的mask预测分支。具体来说,我们从ResNet[19]和FPN[27]论文中扩展了Faster R-CNN框头。详细信息如图4所示。ResNet-C4主干上的头部包括ResNet的第5阶段(即9层“res5”[19]),这是计算密集型的。对于FPN,主干已经包含res5,因此允许使用更少过滤器的更高效的头部。

我们注意到我们的mask分支具有简单的结构。更复杂的设计有可能提高性能,但不是这项工作的重点。

图 4. 头部架构:我们扩展了两个现有的Faster RCNN头部[19, 27]。左/右面板分别显示了来自[19]和[27]的ResNet C4和FPN主干的头部,其中添加了mask分支。数字表示空间分辨率和通道。箭头表示可以从上下文推断的conv、deconv或fc层(conv保留空间维度,而deconv增加它)。所有的conv都是3×3,除了输出conv是1×1,deconv是2×2,步长为2,我们在隐藏层中使用ReLU[31]。左:“res5”表示ResNet的第五阶段,为简单起见,我们对其进行了更改,以便第一个conv在7×7的RoI上运行,步幅为1(而不是[19]中的14×14 / 步幅 2)。右图:“×4”表示四个连续转换的堆叠。

3.1. Implementation Details

我们根据现有的Fast/Faster R-CNN工作[12、36、27]设置超参数。尽管这些决策是在原始论文[12、36、27]中针对目标检测做出的,但我们发现我们的实例分割系统对它们来说是稳健的。

训练: 与Fast R-CNN一样,如果RoI的IoU与ground-truth box至少为0.5,则认为RoI为正,否则为负。mask损失 L m a s k L_{mask} Lmask?仅在正RoI上定义。mask目标是RoI与其关联的ground-truth mask之间的交集。

我们采用以图像为中心的训练[12]。图像被调整大小,使其比例(较短的边缘)为800像素[27]。每个mini-batch每个GPU有2个图像,每个图像有 N N N个采样的RoI,正负比为1:3[12]。对于C4主干网络, N N N为64(如[12, 36] 中),对于FPN为512(如[27]中)。我们在8个GPU(因此有效的minibatch大小为16)上训练160k次迭代,学习率为0.02,在120k次迭代时降低了10。我们使用0.0001的权重衰减和0.9的动量。使用ResNeXt[45],我们使用每个GPU的1张图像和相同的迭代次数进行训练,起始学习率为0.01。

RPN anchors跨越5个尺度和3个纵横比,遵循[27]。为了方便消融,RPN是单独训练的,不与 Mask R-CNN共享特征,除非另有说明。对于本文中的每个条目,RPN和Mask R-CNN具有相同的主干,因此它们是可共享的。

推断:在测试时,C4骨干网的proposal编号为300(如[36]中),FPN为1000(如[27]中)。我们在这些proposal上运行框预测分支,然后是非最大抑制[14]。然后将mask分支应用于得分最高的100个检测框。尽管这与训练中使用的并行计算不同,但它加速了推理并提高了准确性(由于使用了更少、更准确的RoI)。mask分支可以预测每个RoI的K个mask,但我们只使用第 k k k个mask,其中 k k k是分类分支预测的类。然后将 m × m m \times m m×m浮点数mask输出调整为RoI大小,并二值化阈值为0.5。

请注意,由于我们只计算前100个检测框上的mask,Mask R-CNN为其Faster R-CNN对应物增加了少量开销(例如,在典型模型上约为20%)。

图 6. FCIS+++ [26](上)与 Mask R-CNN(下,ResNet-101-FPN)。 FCIS 在重叠目标上展示系统伪影。

References

[1] M. Andriluka, L. Pishchulin, P . Gehler, and B. Schiele. 2D human pose estimation: New benchmark and state of the art analysis. In CVPR, 2014. 8

[2] P . Arbeláez, J. Pont-Tuset, J. T. Barron, F. Marques, and J. Malik. Multiscale combinatorial grouping. In CVPR, 2014. 2

[3] A. Arnab and P . H. Torr. Pixelwise instance segmentation with a dynamically instantiated network. In CVPR, 2017. 3, 9

[4] M. Bai and R. Urtasun. Deep watershed transform for instance segmentation. In CVPR, 2017. 3, 9

[5] S. Bell, C. L. Zitnick, K. Bala, and R. Girshick. Insideoutside net: Detecting objects in context with skip pooling and recurrent neural networks. In CVPR, 2016. 5

[6] Z. Cao, T. Simon, S.-E. Wei, and Y . Sheikh. Realtime multiperson 2d pose estimation using part affinity fields. In CVPR, 2017. 7, 8

[7] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele. The Cityscapes dataset for semantic urban scene understanding.In CVPR, 2016. 9

[8] J. Dai, K. He, Y . Li, S. Ren, and J. Sun. Instance-sensitive fully convolutional networks. In ECCV, 2016. 2

[9] J. Dai, K. He, and J. Sun. Convolutional feature masking for joint object and stuff segmentation. In CVPR, 2015. 2

[10] J. Dai, K. He, and J. Sun. Instance-aware semantic segmentation via multi-task network cascades. In CVPR, 2016. 2, 3, 4, 5, 6

[11] J. Dai, Y . Li, K. He, and J. Sun. R-FCN: Object detection via region-based fully convolutional networks. In NIPS, 2016. 2

[12] R. Girshick. Fast R-CNN. In ICCV, 2015. 1, 2, 3, 4, 6

[13] R. Girshick, J. Donahue, T. Darrell, and J. Malik. Rich feature hierarchies for accurate object detection and semantic segmentation. In CVPR, 2014. 2, 3

[14] R. Girshick, F. Iandola, T. Darrell, and J. Malik. Deformable part models are convolutional neural networks. In CVPR, 2015. 4

[15] B. Hariharan, P . Arbeláez, R. Girshick, and J. Malik. Simultaneous detection and segmentation. In ECCV. 2014. 2

[16] B. Hariharan, P . Arbeláez, R. Girshick, and J. Malik. Hypercolumns for object segmentation and fine-grained localization. In CVPR, 2015. 2

[17] Z. Hayder, X. He, and M. Salzmann. Shape-aware instance segmentation. In CVPR, 2017. 9

[18] K. He, X. Zhang, S. Ren, and J. Sun. Spatial pyramid pooling in deep convolutional networks for visual recognition. In ECCV. 2014. 1, 2

[19] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In CVPR, 2016. 2, 4, 7, 10

[20] J. Hosang, R. Benenson, P . Dollár, and B. Schiele. What makes for effective detection proposals? PAMI, 2015. 2

[21] J. Huang, V . Rathod, C. Sun, M. Zhu, A. Korattikara, A. Fathi, I. Fischer, Z. Wojna, Y . Song, S. Guadarrama, et al.Speed/accuracy trade-offs for modern convolutional object detectors. In CVPR, 2017. 2, 3, 4, 6, 7

[22] M. Jaderberg, K. Simonyan, A. Zisserman, and K. Kavukcuoglu. Spatial transformer networks. In NIPS, 2015. 4

[23] A. Kirillov, E. Levinkov, B. Andres, B. Savchynskyy, and C. Rother. Instancecut: from edges to instances with multicut. In CVPR, 2017. 3, 9

[24] A. Krizhevsky, I. Sutskever, and G. Hinton. ImageNet classification with deep convolutional neural networks. In NIPS, 2012. 2

[25] Y . LeCun, B. Boser, J. S. Denker, D. Henderson, R. E.Howard, W. Hubbard, and L. D. Jackel. Backpropagation applied to handwritten zip code recognition. Neural computation, 1989. 2

[26] Y . Li, H. Qi, J. Dai, X. Ji, and Y . Wei. Fully convolutional instance-aware semantic segmentation. In CVPR, 2017. 2, 3, 5, 6

[27] T.-Y . Lin, P . Dollár, R. Girshick, K. He, B. Hariharan, and S. Belongie. Feature pyramid networks for object detection.In CVPR, 2017. 2, 4, 5, 7

[28] T.-Y . Lin, M. Maire, S. Belongie, J. Hays, P . Perona, D. Ramanan, P . Dollár, and C. L. Zitnick. Microsoft COCO: Common objects in context. In ECCV, 2014. 2, 5

[29] S. Liu, J. Jia, S. Fidler, and R. Urtasun. SGN: Sequential grouping networks for instance segmentation. In ICCV, 2017. 3, 9

[30] J. Long, E. Shelhamer, and T. Darrell. Fully convolutional networks for semantic segmentation. In CVPR, 2015. 1, 3, 6

[31] V . Nair and G. E. Hinton. Rectified linear units improve restricted boltzmann machines. In ICML, 2010. 4

[32] G. Papandreou, T. Zhu, N. Kanazawa, A. Toshev, J. Tompson, C. Bregler, and K. Murphy. Towards accurate multiperson pose estimation in the wild. In CVPR, 2017. 8

[33] P . O. Pinheiro, R. Collobert, and P . Dollar. Learning to segment object candidates. In NIPS, 2015. 2, 3

[34] P . O. Pinheiro, T.-Y . Lin, R. Collobert, and P . Dollár. Learning to refine object segments. In ECCV, 2016. 2, 3

[35] I. Radosavovic, P . Dollár, R. Girshick, G. Gkioxari, and K. He. Data distillation: Towards omni-supervised learning.arXiv:1712.04440, 2017. 10

[36] S. Ren, K. He, R. Girshick, and J. Sun. Faster R-CNN: Towards real-time object detection with region proposal networks. In NIPS, 2015. 1, 2, 3, 4, 7

[37] S. Ren, K. He, R. Girshick, and J. Sun. Faster R-CNN: Towards real-time object detection with region proposal networks. In TPAMI, 2017. 10

[38] A. Shrivastava, A. Gupta, and R. Girshick. Training regionbased object detectors with online hard example mining. In CVPR, 2016. 2, 5

[39] A. Shrivastava, R. Sukthankar, J. Malik, and A. Gupta. Beyond skip connections: Top-down modulation for object detection. arXiv:1612.06851, 2016. 4, 7

[40] C. Sun, A. Shrivastava, S. Singh, and A. Gupta. Revisiting unreasonable effectiveness of data in deep learning era. In ICCV, 2017. 10

[41] C. Szegedy, S. Ioffe, and V . V anhoucke. Inception-v4, inception-resnet and the impact of residual connections on learning. In ICLR Workshop, 2016. 7

[42] J. R. Uijlings, K. E. van de Sande, T. Gevers, and A. W.Smeulders. Selective search for object recognition. IJCV, 2013. 2

[43] X. Wang, R. Girshick, A. Gupta, and K. He. Non-local neural networks. arXiv:1711.07971, 2017. 10

[44] S.-E. Wei, V . Ramakrishna, T. Kanade, and Y . Sheikh. Convolutional pose machines. In CVPR, 2016. 8

[45] S. Xie, R. Girshick, P . Dollár, Z. Tu, and K. He. Aggregated residual transformations for deep neural networks. In CVPR, 2017. 4, 10