CVPR2022:SurroundDepth: Entangling Surrounding Views for Self-Supervised Multi-Camera Depth Estimation

Code:https://github.com/weiyithu/SurroundDepth

论文提出了SurroundDepth,将来自多个周围视图的信息合并到一起,以预测摄像头之间的深度图,具体地说:

- 使用一个联合网络(joint network)来处理所有周围的视图

- 并提出了一个交叉视图转换器(cross-view transformer)来有效地融合来自多个视图的信息、全局交互

- 给定多摄像机外部矩阵( extrinsic matrices)、采用SFM(structure from motion)的稀疏深度来预训练模型,以预测真实世界的尺度

- 估计车辆的整体自我运动(universal ego-motion),并将其传输到每个视图,以实现多视图一致性

解决痛点:

- 尽管现代自动驾驶汽车通常配备多个摄像头来拍摄360度全景,现有的大多数方法仍然侧重于从单目图像预测深度图,而忽略了周围视图之间的相关性

- 由于时间光度一致性(temporal photometric consistency)只能推断相对尺度,这些自监督单目深度估计方法无法产生尺度感知深度。然而,由于多摄像机外部矩阵中的平移向量获得了真实世界的尺度,因此可以获得尺度感知预测。

单目深度估计

一个深度估计网络

- 只估计单图深度,多次估计获得多张无关联的深度图

一个位姿估计网络

- 只估计一个相机的两帧间位姿,多个相机的位姿没有关联性

多目环绕深度估计

多目深度估计网络

- 同时时刻的多目图像联合估计深度

多目位姿估计网络

- 不同时刻之间的多个相机的深度图联合估计位姿

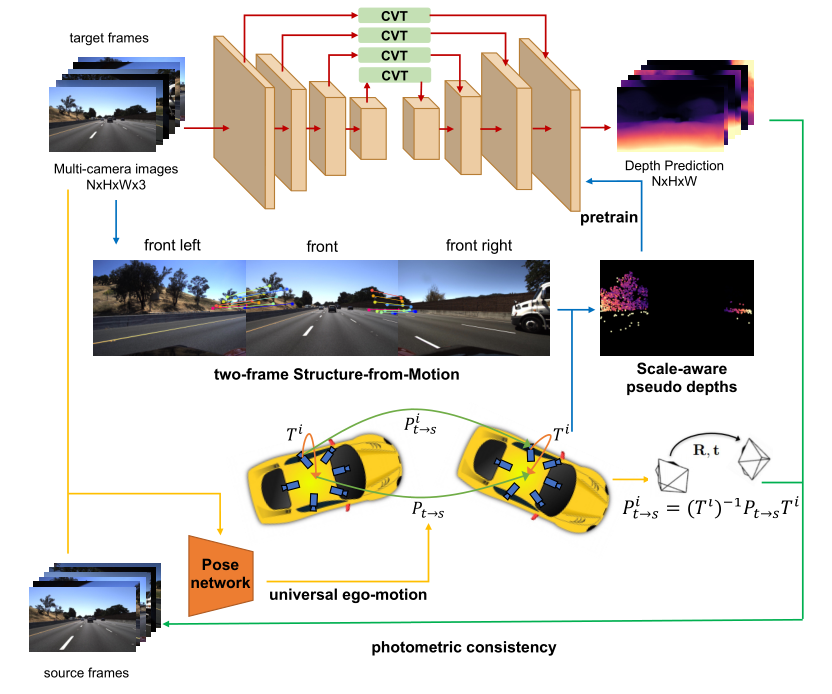

Overview

Depth Net:shared encoder and decoder

Pose Net: universal ego-motion PoseNet

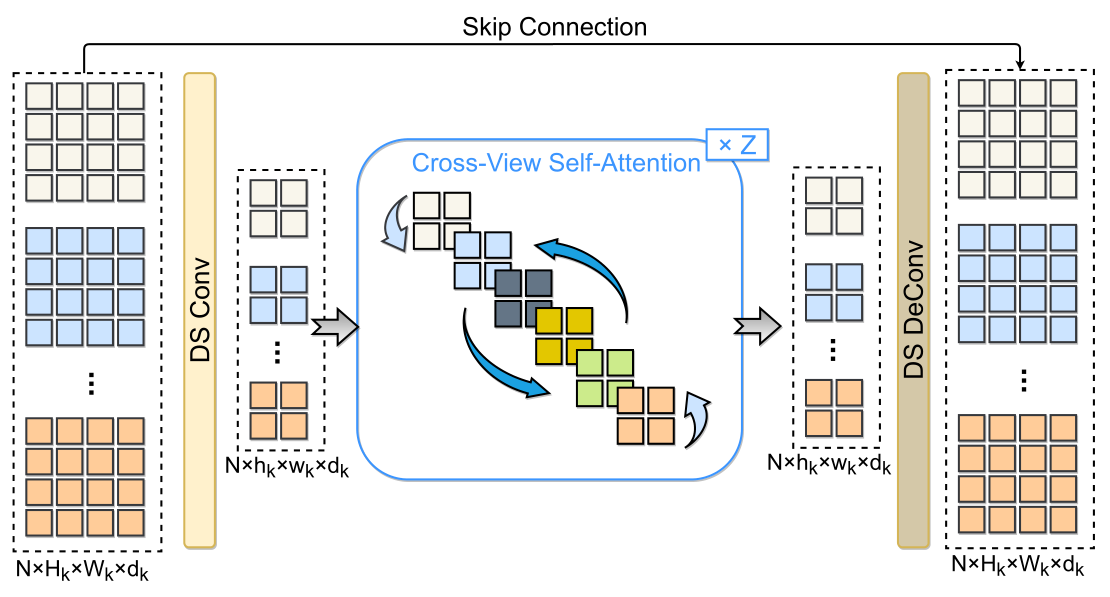

Cross view transformer

- depthwise separable convolutions降低图像分辨率后

- 使用 cross-view attention整合全局信息

- 再反卷积回原图像大小

SFM pretraining

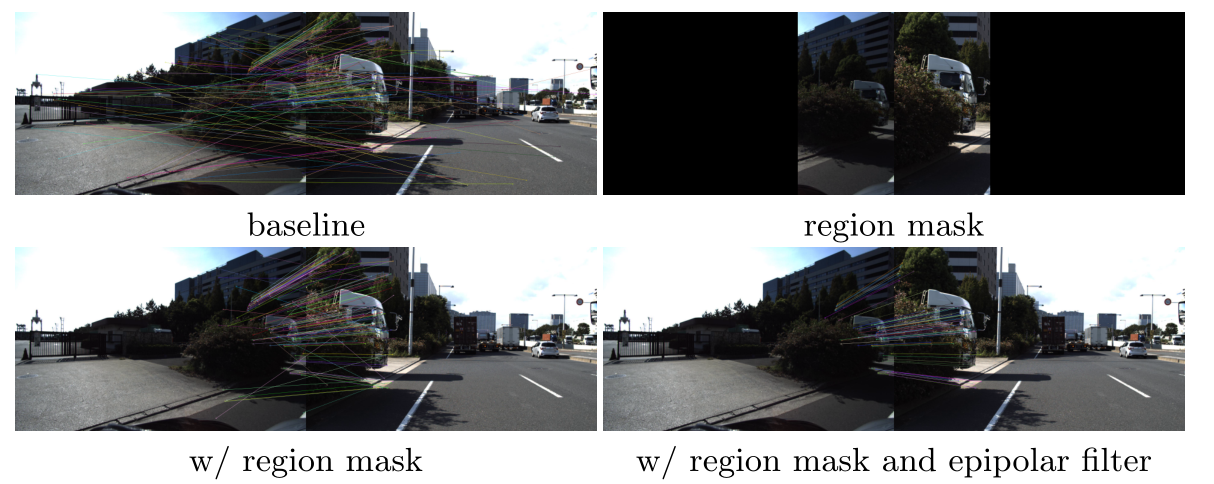

- 首先采用SIFT特征提取匹配

- 由于小重叠和大视图变化,相邻视图只取相邻的 1 3 \frac{1}{3} 31? 部分匹配

- 用epipolar geometry 过滤 outliers.

- 使用相机外部矩阵进行三角测量来计算稀疏深度

- 利用这些稀疏深度以及时间光度损失(temporal photometric loss)来预训练depth和pose网络

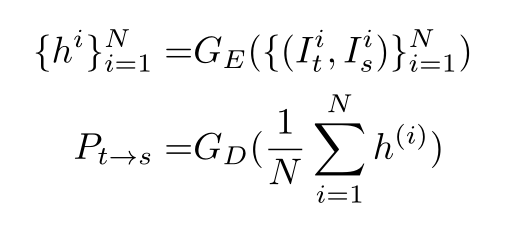

Joint pose estimation

分为两部分:

- 整体位姿估计

- 整体到局部位姿的转换

将N个target image和对应的N个source image一次喂到PoseNet 的encode,并在decode之前对提取的特征进行平均

获得整体位姿后,利用外参矩阵算单个相机的位姿: