Fully Attentional Network for Semantic Segmentation

1. 摘要+引言

问题

通过压缩空间维度或通过压缩通道的相似图来描述沿通道或空间维度的特征关系,这种做法往往会沿着其他维度压缩特征依赖关系,从而导致注意力缺失,这可能导致小/薄类别的结果较差或大对象内部的分割不一致。

提出方法

全注意力网络 (FLANet),将空间注意力和通道注意力编码在单个相似度图中,同时保持高计算效率。对于每个通道图,我们的 FLANet 可以通过一个新颖的全注意力模块从所有其他通道图以及相关的空间位置中获取特征响应。

基本思想

在计算通道注意力图时利用全局上下文信息接收空间响应,从而在单个注意力单元中实现全注意力,计算效率高。具体来说,我们首先使每个空间位置能够从具有相同水平和垂直坐标的全局上下文中获取特征响应。其次,我们使用自注意力机制来捕获任意两个通道图和相关空间位置之间的完全注意力相似性。最后,通过整合所有通道图和相关全局线索之间的特征,使用生成的完全注意力相似性来重新加权每个通道图。

(The basic idea is to。。。。Specifically, we first。。。。Second, we use 。。。。Finally, the generated fully attentional similarities are)

2. Method

主干网络

(1)主干网络:ResNet-101 (He et al. 2016) and HRNetV2-W48 (Sun et al. 2019)。

(2)FLA作用于主干网络的最后特征层:输出特征图放大到输入图像的 1/8。输入图像由主干网络处理以生成特征图 X。之后,我们首先在 X 上应用卷积层以降低通道维度并获得特征图 Fin。然后,特征图 Fin 将被送入全注意力块 (FLA) 并生成新的特征图 Fo,该特征图聚合了所有维度的非局部上下文信息。最后,将密集的上下文特征 Fo 发送到预测层以生成最终的分割图。

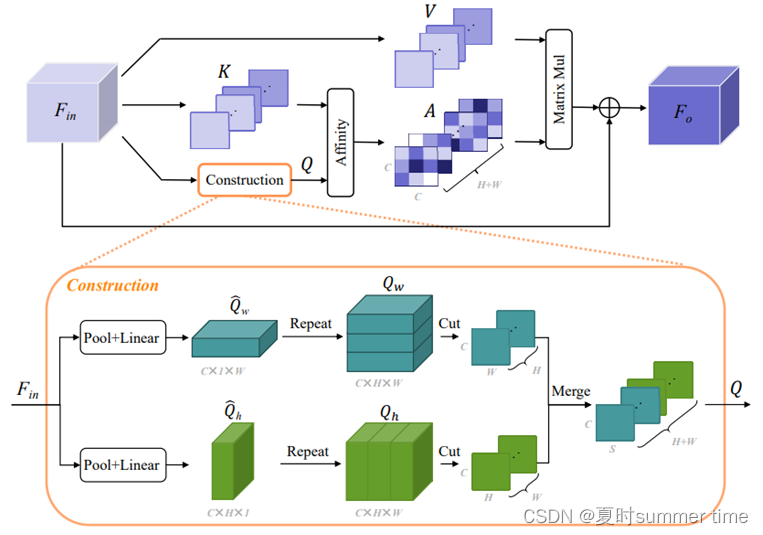

Fully Attentional Block

如上图:共有三个计算支路:

(1) construction:见上图:利用全局平均池化结果作为全局上下文先验,将空间交互引入通道 NL 机制,池化核大小:H1,1W。Qw 和 Qh 分别表示水平和垂直方向的全局先验,它们将用于实现相应维度的空间交互。此外,我们沿 H 维切割 Qw,从中我们可以生成一组大小为 RC×W 的 H 切片。类似地,我们沿 W 维度切割 Qh。然后我们合并这两组以形成最终的全局上下文 Q ∈ R(H+W)×C×S。

(2) K: 沿着H维度切割,然后沿着W维度切割,将它们聚合形成特征K ∈ R(H+W )×S×C

(3) V: 沿着H维度切割,然后沿着W维度切割,将它们聚合形成特征K ∈ R(H+W )×S×C

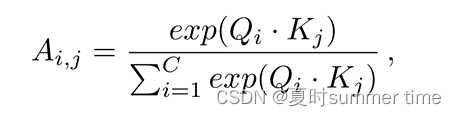

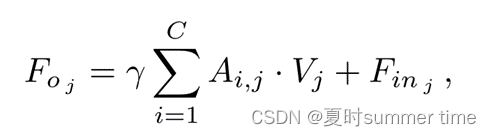

Affinity 操作:

然后我们在 A 和 V 之间执行矩阵乘法,以使用生成的全注意力更新每个通道图。之后,我们将结果重新整形为两组,每组的大小为 RC×H×W(即合并的逆运算)。我们将这两组相加以形成远程上下文信息。最后,我们将上下文信息乘以尺度参数 γ,并对输入特征图 Fin 进行元素求和运算,得到最终输出 Fo ∈ RC×H×W,如下所示:

值得注意的是,与通过将来自同一位置的空间信息相乘来探索通道相关性的传统 Channel NL 方法不同**,FLA 实现了不同空间位置之间的空间连接,**即,利用单个注意图。通过这种方式,我们的 FLA 具有更全面的上下文视图,并且对不同的场景更加稳健。此外,构建的先验表示带来了全局感受野,有助于提高特征辨别能力。

(It is noted that different from 。。。。。 which。。。our FLA enables 。。。。。In this way, our FLA

has。。。。。Moreover, the constructed prior representation brings a global receptive field and helps to boost the feature discrimination ability.)

Complexity Analysis:复杂性分析

(1) Spatial NL:O((HW )2C)

(2) Channel NL:O(C2HW )

(3) FLA block:O(C2(H + W )S)

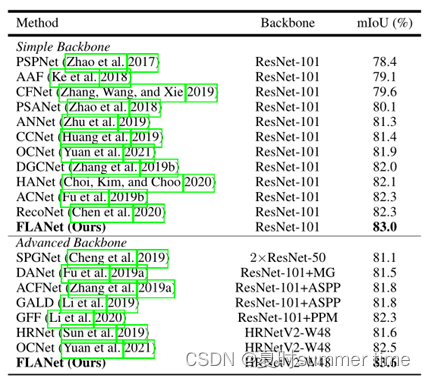

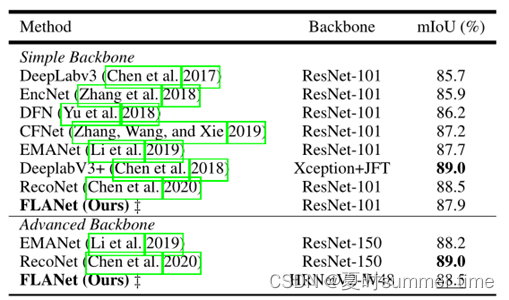

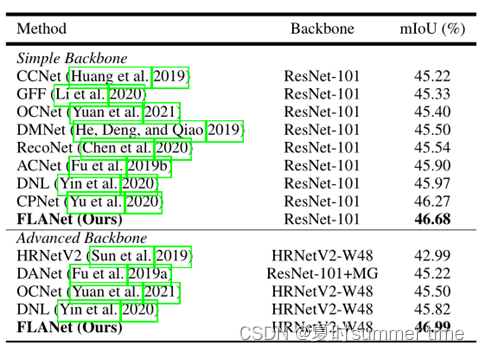

3. Experiments:

数据集: Cityscapes (Cordts et al. 2016)、ADE20K (Zhou et al. 2017) 和 PASCAL VOC (Everingham et al. 2009)

值得注意的是,FLA 的参与特征图比 Channel NL 的更结构化和更详细。例如,所有图像都会突出显示远处的极点和对象边界。特别是,FLA 还可以区分不同的类别,例如第三排的公共汽车和汽车。这些可视化结果进一步表明,全注意力模块可以捕获空间相似性并将其编码到通道注意图中以实现完全注意。