TMI2021医学图像分割论文

SMU-Net: Saliency-guided Morphology-aware U-Net for Breast Lesion Segmentation in Ultrasound Image

SMU-Net: 显著引导形态感知U-Net用于超声图像乳腺病变分割

目录

2.1?Main Network and Auxiliary Network

摘要

深度学习方法,尤其是卷积神经网络已成功应用于乳腺超声(BUS)图像的病变分割。然而,周围组织(即背景)与病灶区域(即前景)之间的模式复杂性和强度相似性给病灶分割带来了挑战。由于背景中包含了如此丰富的纹理信息,很少有方法试图探索和利用背景显著性表示来辅助前景分割。

此外,BUS图像的其他特征,如1)低对比度外观和边界模糊,2)病变的形状和位置变化明显,也增加了准确分割病变的难度。在本文中,我们提出了一种显著引导的形态感知U-Net (SMU-Net)用于BUS图像中的病灶分割。smu网络由一个带有附加中流的主网络和一个辅助网络组成。具体地说,我们首先提出生成显著性地图,它结合了低水平和高水平的图像结构,为前景和背景。然后,这些显著性映射引导主网络和辅助网络分别学习前景显著性和背景显著性表征。此外,我们设计了一个额外的中间流,主要由背景辅助融合、形状感知、边缘感知和位置感知单元组成。该流接收来自主网络和辅助网络的粗到细表示,有效融合前景显著性和背景显著性特征,增强网络的形态信息学习能力。在5个数据集上的大量实验表明,在超声图像乳腺病变分割中,深度学习方法比几种最新的深度学习方法具有更高的性能和对数据集规模的鲁棒性。

一、主要亮点

- 提出了一个统一的框架,由一个具有额外中流的UNet和一个辅助网络组成。与单一U-Net相比,该方法在中流和辅助网络的辅助下,可以显著获得更好的性能

- 根据BUS图像的特点,中流网络从主网络和辅助网络接收粗到细的表示,有效地融合前景显著性和背景显著性特征,学习形态学信息。

二、METHOD

1. Saliency Map Generation

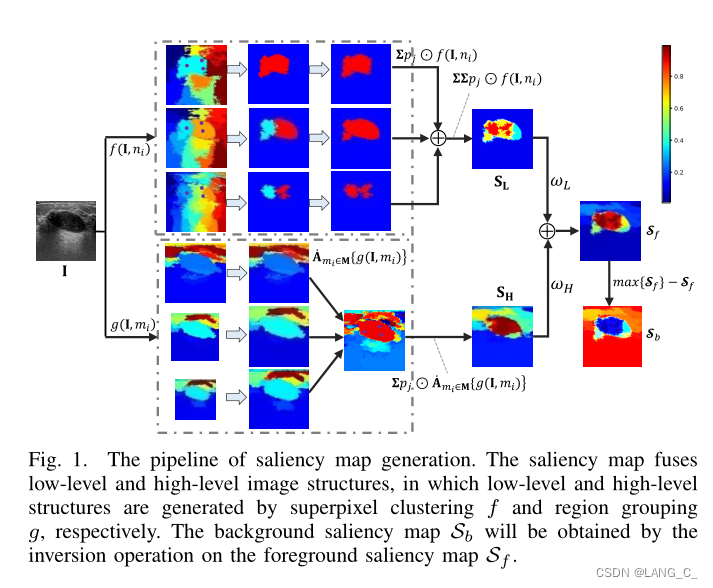

本研究通过生成显著性地图来突出BUS图像中潜在显著区域,从而指导前景显著性和背景显著性表征学习。为了有效地表示BUS图像的复杂结构,特别是当病变区域呈现在一个低对比度且外观易混淆的场景时,我们建议将低层和高层图像结构合并生成显著性映射,其中低层(如灰度和纹理)和高层(如基于区域的对象)分别通过超像素聚类和区域分组生成。

1.1?Low-level Saliency Map

图1的上方就是处理低级显著图,作者使用了超像素分割的方法来提取特征图,与以往不同的是,第一步这里选取了三簇聚类数,分别是8、15、50,这是因为图像中的病灶大小会改变,用一个聚类数会造成一定误差,最终得到的是三个超像素置信度映射;第二步是在三个超像素map中的每一个map进行种子点选取,每个map选择3个种子点,注意这里是手动交互选择的。

1.2?High-level Saliency Map

为了能更好地表征病灶区域,基于多尺度结构生成了3个更高层次的显著性映射。首先在每个尺度上独立进行区域分组的高层层次聚类分别得到3个映射图,然后将这些层次对齐,并将它们集成到一个统一的多尺度集群层次结构中,最后,我们提取这些覆盖三个随机种子点的区域,并合并形成高水平显著性map。

从图1中我们可以看出,与低水平显著图相比,高水平显著图对病变区域的置信度(即重红色)更高,对周围组织的信息更多。

![]()

?加权后得到最终的显著图。值得一提的是,背景中没有ground truth或者先验信息来为突出突出区域提供线索。因此,为了尽可能突出不同区域,提供互补信息,本文将的反演视为背景

的显著性图.

![]()

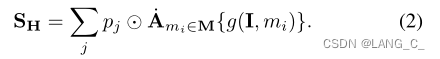

2. Network Architecture

SMU网络由主网络(橙色路径)、中间网络(蓝色路径)和辅助网络(绿色路径)组成;主网络在的先验信息指导下学习前景突出表示。同时,辅助网络(绿色周围网络)利用

的先验线索学习背景显著性表征。此外,设计额外的中流(蓝色中流)接收来自主网络和辅助网络的粗到细表征,有效融合前景显著性和背景显著性特征,增强形态学信息的学习能力。

2.1?Main Network and Auxiliary Network

????????主干网络将前景显著图和原始图像作为多通道输入,显著图可以提供一些先验知识来指导学习前景显著表示。也是一个U型网络;

????????同样,辅助网络将与原始图像的背景显著性图作为多通道输入,与主网络共享相同的架构,中间块来学习背景显著性表示,而且

会送入主干网络中去辅助学习。

2.2?The Middle Stream

? ? ? ? 中间网络看起来较为复杂,由4个部分组成,分别是背景辅助融合单元、形状感知单元、边缘感知单元和位置感知单元,用于融合前景显著特征和背景显著特征,增强形态学信息的学习能力。

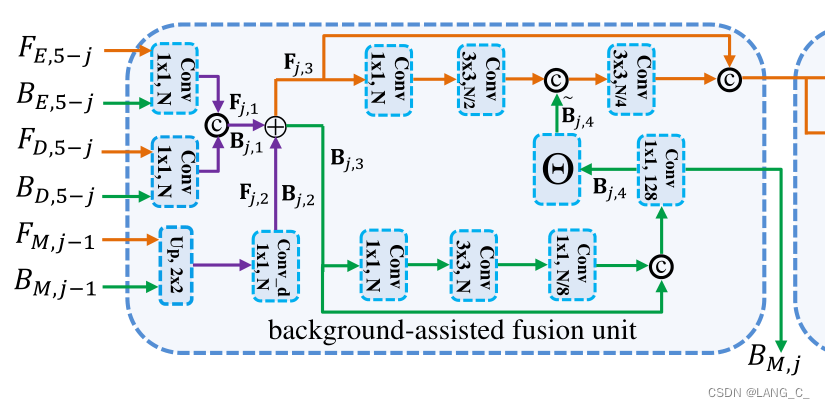

A.Background-assisted Fusion Unit

????????该单元用于反馈背景显著性上下文信息和融合前景显著图表征。

????????考虑到编码流和解码流分别倾向于关注低级纹理和高级语义,单元首先使用两个1×1卷积层从和

(橙色箭头)独立提取特征,然后使用两个1×1卷积层从

和

(绿色箭头)独立提取特征,分别得到

和

。然后

和

用上采样操作充分利用多尺度信息来恢复分辨率,利用扩张率为2的扩张卷积层来扩大接收野,以捕获全局信息得到

和

。

???????(

),并与

(

)取均值,得到汇聚多尺度信息的

(

),

然后经过一系列卷积操作得到

(也称

)作为下一个

块的输入。

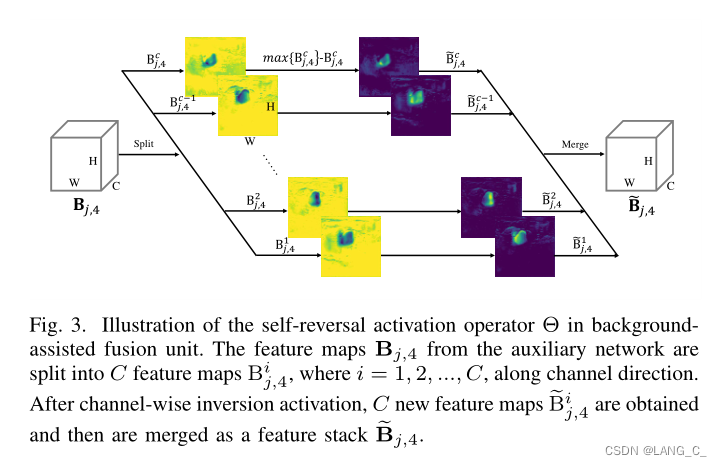

?提出了一个自逆激活算子操作,以下操作是为了增强前景显著性信息,通过作用在

。最后,利用跳跃连接算子将融合特征与Fj,3作为背景辅助融合单元的输出进行拼接

![]()

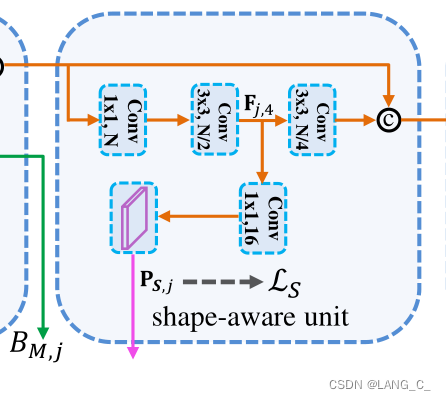

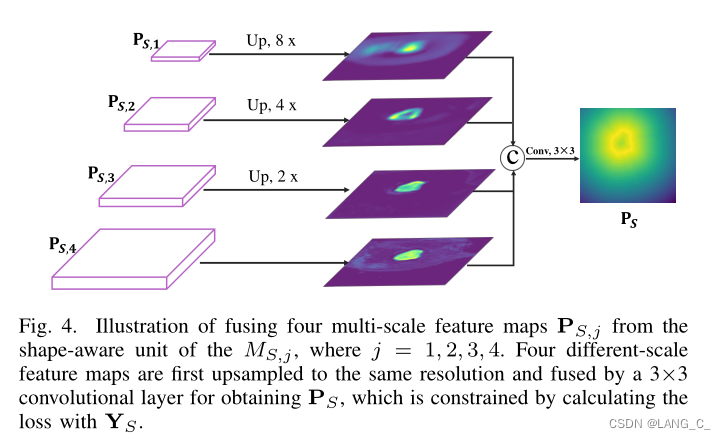

B.Shape-aware Unit?

????????为了使网络更关注病变区域的形状信息,开发了形状感知单元,并将其嵌入到中流的每个块中。

????????该单元首先使用一组1×1和3×3卷积层提取特征,其处理路径有两种:(I)经过一个3×3的卷积层,结合背景辅助融合单元生成的特征作为最终输出。(II)将它们送入1 × 1卷积层,得到形状预测映射

与其他块产生的(上采样/下采样)多尺度预测映射融合形成

(如图4所示),

在形状

的监督下学习。(4个

分别是4个

块生成的,最后用

作监督计算loss)

?

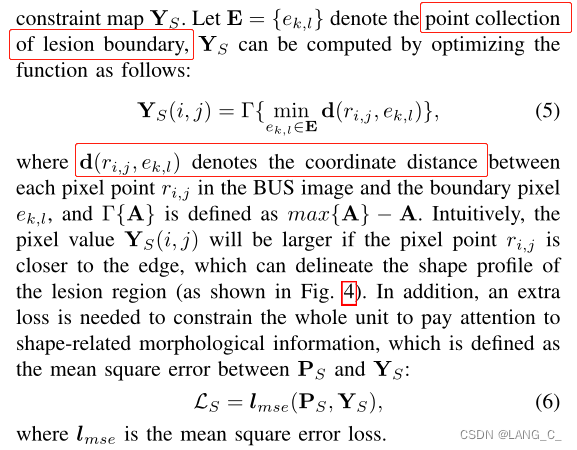

????????直观上看,像素点越靠近边缘,像素值

(i, j)越大,可以勾勒出病变区域的形状轮廓(如图4所示)。另外,还需要额外的损失来约束整个单元关注与形状相关的形态信息,定义为

与

之间的均方误差.

????????这一部分用通俗的话来讲就是:通过计算所有像素点与病灶边界的距离来决定的显著程度,从图中可以看出,离边界越近越亮,这部分的loss就是通过显著图来约束网络。

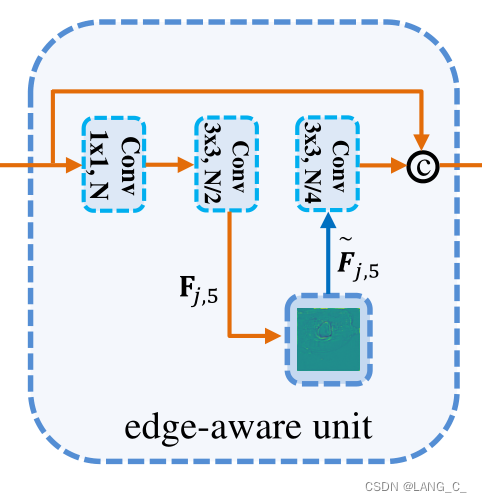

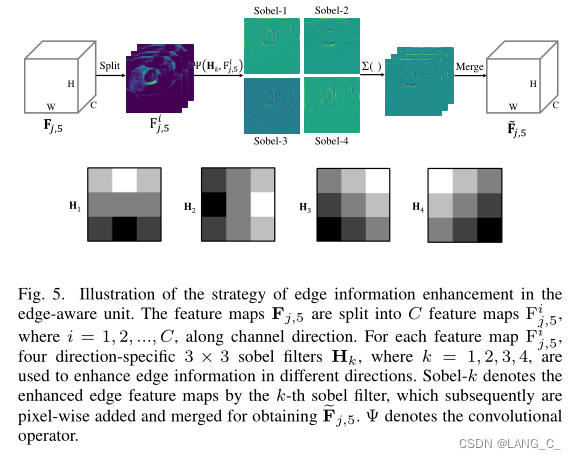

C. Edge-aware Unit

在处理BUS图像[30]中难以区分和不规则的病变区域时,边缘上下文有助于保持被研究对象的完整性和独特性。因此,边缘感知单元旨在增强网络对边界特征的识别能力,对病变区域不明显的边缘分割进行细化。在边缘感知单元中,首先使用1 × 1和3 × 3卷积层提取特征;然后,提出了一种边缘增强算子,通过融合方向特异性边缘滤波器来锐化病变边缘特征。具体来说,feature map

∈

被分解为二维feature map的集合。即

=

。对于每个特征图

,使用4个方向特定的3 × 3 sobel滤波器沿相应方向增强边缘轮廓,然后集成到一个统一的特征图中。更正式地说,这个过程可以表述如下:?

?四种sobel滤波器强调水平、垂直和对角边缘特征

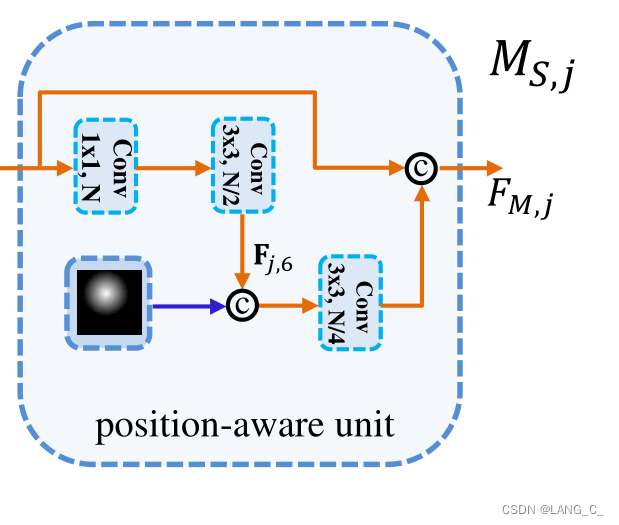

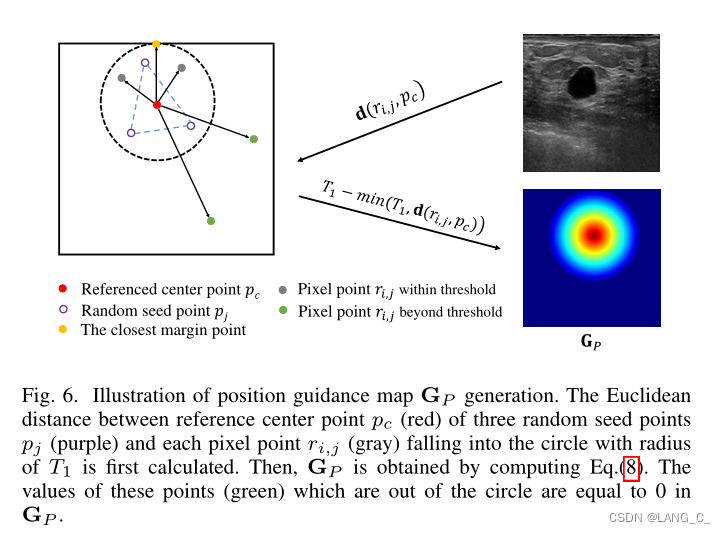

D. ?Position-aware Unit

病变区域的位置也是分割[40]的影响因素。为此,我们设计了一种位置感知单元来提供病变区域的位置信息,并与形状感知单元和边缘感知单元协同提高性能。具体来说,我们首先找到三个随机种子点用于显著图生成的中心参考点

。参考点

可近似认为是病变区域的位置。在[41]-[43]的激励下,我们计算每个像素点

与参考点

之间的欧氏距离作为位置引导图

,其表达式为:

![]()

其中T是一个阈值距离,表示到图像最近边缘的距离(如图6所示)。阈值T的目的是减少

生成的计算成本。由式(8)可知,像素点

越接近

,像素值

(i, j)越大,也是一个显著图。如图2所示,将

与通过1 × 1和3 × 3卷积层提取的特征映射

进行拼接,再送入3 × 3卷积层进行进一步的信息融合。融合后的特征与边缘感知单元的特征相结合,作为位置感知单元的输出,记为

(也称

)。值得一提的是,将位置感知融合单元和背景辅助融合单元分别产生的电流块的输出

和

作为中流下一个块的输入。

3.损失函数

我们设计了一种混合损耗来有效训练我们提出的SMU-Net,其中前景的ground-truth作为弱监督指导用于辅助网络的训练(即不直接计算ground-truth与辅助网络输出之间的损耗)。总损耗L为主网、中流

、形状感知单元

损耗的权重组合:

![]()

三、实验部分

1. 5个不同尺度的公共数据集

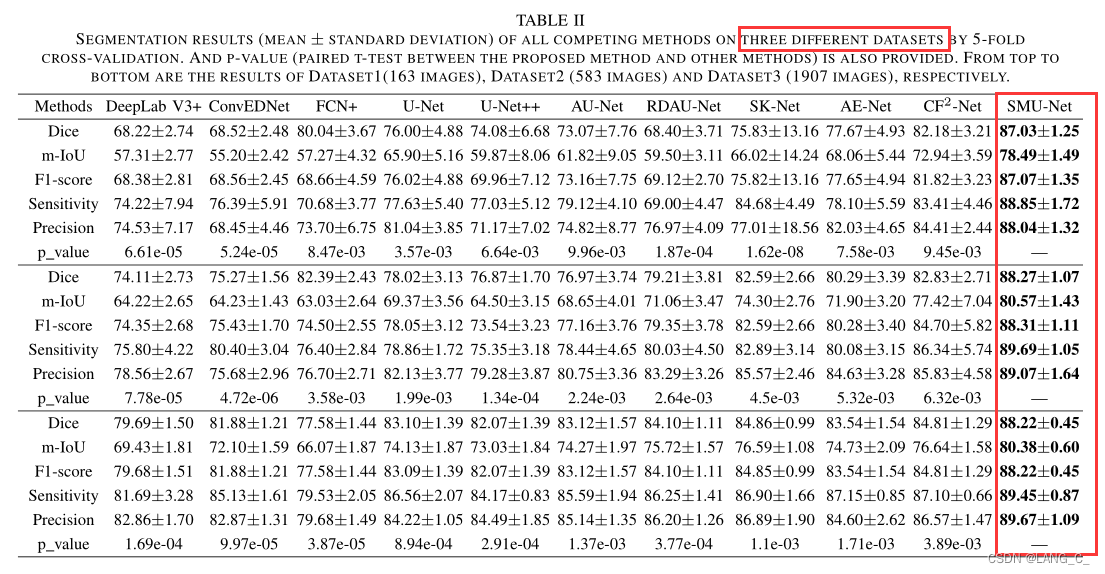

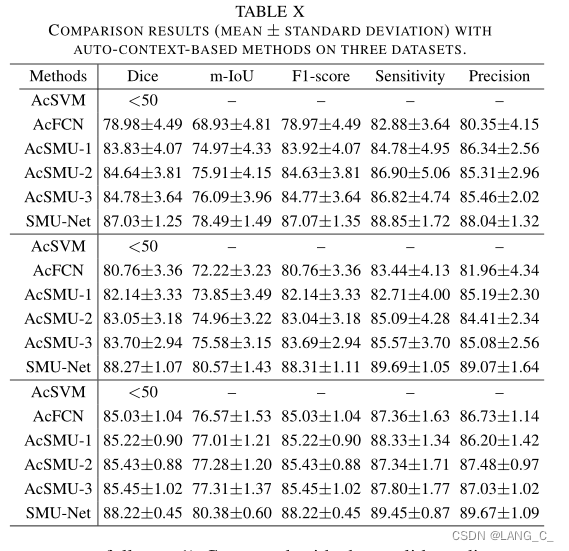

表II给出了所有方法在三个数据集上的实验结果。从表2中,我们可以观察到四个关键点。

首先,一般来说,U-Net变体在三个数据集上的性能与基于fcn的变体不相上下。实际上,BUS图像包含高度复杂的图案和不规则的模糊边缘。U-Net变体中使用的Skip连接操作将编码流中的底层上下文特征传输到解码流中,补充解码流的模式细节,有助于提高分割性能。其次,注意机制和额外的边缘约束是促进边缘识别和病灶分割的关键。例如,RDAU-Net和CF2-Net在注意力模块和边缘提取器的两个相对较大的数据集上始终优于它们的主干,即U-Net。

SK-Net也通过注意力机制和多尺度特征融合策略获得竞争性能。第三,AE-Net和CF2-Net在大多数情况下都比其他竞争方法取得了更好的效果。一个潜在的原因是它们都使用显著性地图作为网络或注意模块的输入,可以提供一些先验,并在视觉上突出突出的区域,以提高网络的分割性能。

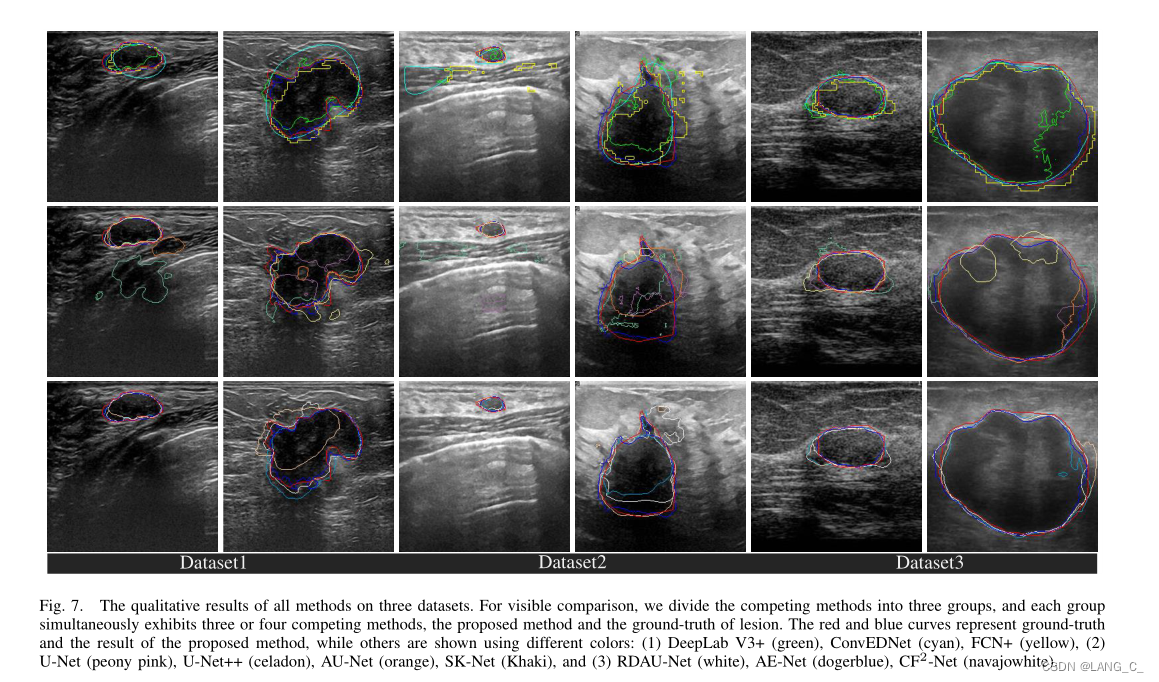

最后,无论在小数据集还是大数据集上,我们提出的方法都能以最高的度量获得最佳的性能。同时,我们的方法在所有不同规模的数据集上都呈现出相对稳定的结果,这表明了所提方法的鲁棒性。与其他方法相比,该方法具有以下几个潜在优势:(1)显著图协同低水平和高水平形态结构引导前景显著和背景显著表征学习。(二)辅助网络提供背景的上下文信息,辅助前景分割。(III)中流接收来自主网和辅助网的多尺度表示,有效融合前景显著性和背景显著性特征。此外,根据总线图像的特点,流附加臂具有形状感知、边缘感知和位置感知单元,可将形态信息与空间信息相结合。为了进一步对比,在三个数据集上,所有方法的视觉分割结果如图7所示。我们可以观察到,所提出的SMU-Net(蓝色)与其他方法相比,在视觉上获得了最优的结果,其预测图更接近于病变区域的ground-truth(红色)。

值得注意的是,该方法对低对比度模糊图像的处理效果也较好,这可能是由于在低显著性和高显著性地图的指导下进行了显著性表征学习。此外,所提出的方法保持形态学的完整性

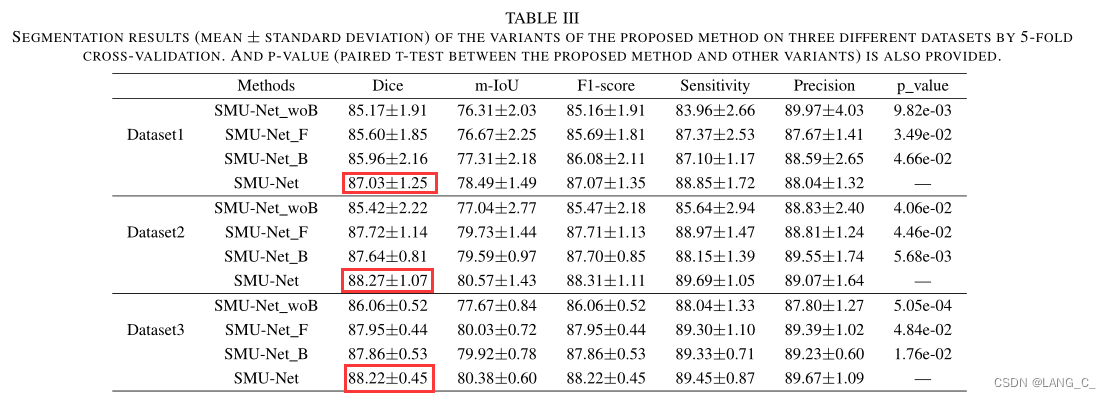

2.辅助网络与背景辅助融合器的效果分析

辅助网络(绿色路径)和背景辅助融合单元是该方法的重要组成部分。我们进行了实验来验证它们的有效性。由于辅助网络和后台辅助融合单元是不可分割的,因此我们开发了一种SMU-Net的变体(称为SMUNet woB),同时去除它们。同时,我们进一步研究了弱监督策略对辅助网络训练的影响。具体来说,我们利用前景或背景的ground truth训练了两个模型,以强监督的方式直接约束辅助网络(简称SMU-Net F和SMU-Net B)。

实验结果如表三所示。由表三可以看出:(I) SMU-Net woB vs SMU-Net, SMU-Net在三个数据集上都取得了显著的改进,验证了辅助网络和后台辅助融合单元的有效性。一种可能的解释是,辅助网络在显著性映射的指导下学习背景显著性表示,基于此,背景辅助融合单元可以有效地将这些上下文信息反馈到主网络中,以提高分割性能。(II)相对于SMU-Net F和SMU-Net B,弱监督训练策略下的SMU-Net表现出更好的性能。我们推测原因如下:第一,背景获取了大量的冗余信息(如未经校正的区域、散斑噪声和

与前景不同,背景中的显著区域是不确定的,这意味着指定一个确定的groundtruth来训练辅助网络并不是一个好的选择。

其次,具有强监督训练策略的辅助网络的丢失也会干扰主网和中流的训练,因为它们被整合到一个统一的框架中。因此,对于辅助网络来说,以弱监督和任务驱动的方式学习背景显著性表示更有利于辅助病灶分割。

3.感知单元消融实验?

为了验证各形态感知单元在中流中的消融效果,进行了一系列的消融实验。图8给出了三个数据集上所有消融实验的结果。

(1)形状感知单元的有效性:我们开发了拟议模型的两种变体。一种是没有形状感知单元的模型(记为SMUNet woS),另一种是最后一个形状感知单元只有一个输出但没有多尺度地图融合的模型(记为SMU-Net woM)。从图8可以看出,SMU-Net和SMU-Net woM的性能都优于SMU-Net woS。结果表明,形状约束在该方法中起着重要作用。此外,SMU-Net的性能比SMU-Net的woM有更明显的改善,这意味着形状预测映射的多尺度融合是我们方法的更好选择。

(2)边缘感知单元的有效性:在边缘感知单元中,通过融合方向特异性边缘滤波器,利用边缘增强算子对病灶边缘进行锐化处理。为了进行比较,我们实现了没有边缘感知单元的模型(称为SMU-Net woE)和只有单向滤波器的四个模型(称为SMU-Net Sobeli,其中i∈{1,2,3,4})。从图8中可以观察到两个关键点。首先,SMU-Net和SMU-Net Sobel-i的度量值高于SMU-Net woE,这是因为边缘增强算子对不明显的边缘分割进行了细化。其次,仅使用单向滤波器的四种模型在性能上并没有明显的差异,融合方向特定边缘滤波器(即SMU-Net)的模型在大多数情况下都优于其他模型。这并不奇怪,因为病变区域边缘差的方向通常是随机的,而SMU-Net可以增强多向边缘。

(3)位置感知单元的有效性:我们通过移除位置感知单元(记为SMU-Net woP)来实现SMU-Net的变体。同时,我们使用4个不同阈值距离(第2、第3、第4和图像边缘的平均距离,分别表示为T2、T3、T4、Ta)生成的位置引导图来训练模型。SMU-Net woP与SMU-Net相比,SMU-Net优于SMU-Net woP,说明该单元提供的位置信息有助于缓解BUS图像中病灶位置不一致的问题。与通过4种不同阈值距离生成位置制导图的模型相比,该模型具有更好的分割效果。实际上,较大的阈值距离会导致位置引导图覆盖较广的区域,其中可能包含更多的未校正区域。此外,较大的位置引导地图阈值也需要计算成本。因此,最接近的阈值距离是我们所提出的方法的最佳选择。

4.参数分析?

在这一小节中,我们研究了关键参数对所提出的方法的影响,包括随机种子点的数量、ωL和ωH的比例以及混合损失函数权重系数

(I)随机生成种子点,以鼓励置信度图尽可能覆盖显著区域。同时,还用于确定位置引导图的参考中心点。我们通过改变点数(即1,3,5)来进行实验。从图9中可以看出,正如预期的那样,随着点的增加,模型的性能进一步提高,因为越多的点会覆盖更大的显著区域,提供更多的先验信息。然而,在显著图生成过程中,点数越多,计算成本也越高。因此,建议在模型中采用3个随机种子点。

(II)我们通过设置不同的权重系数(即ωL: ωH ={1:0, 0:1, 1:1, 2:1})来进一步生成融合显著图,以了解它们对所提方法的影响。从图9中我们可以看出,我们所提出的方法中2:1的比例是我们所提出的模型的权衡选择,在低水平显著图中赋予较大的权重系数,以保留更多底层视觉结构的细节,而较大的权重系数会导致淹没低水平信息。

(III)为了确定混合损失函数的参数(λ1, λ2, γ1,μ1和μ2),我们分别对每个参数(在{0.5,1,1.5,2}范围内)进行了固定研究。从图10可以看出,不同参数下的SMU-Net性能略有波动,说明我们的方法对这些参数具有较强的鲁棒性或不敏感性。根据三个数据集的平均结果,提出了λ1 = 1、λ2 = 1、γ1 = 0.5、μ1 = 1和μ2 = 1的参数。

5.鲁棒性分析

1)良恶性病灶分割的稳健性:一般情况下,恶性病灶比良性病灶大小较大、形状不规则、边界模糊。此外,恶性病变的灰度差异通常较良性病变模糊。为了研究所提出的SMU-Net在良、恶性病变分割上的鲁棒性,我们分别测试了其在良、恶性病变分割上的性能。从表四可以看出两个关键点。首先,对于相对较小的数据集,SMU-Net对恶性病变的检测性能低于良性病变。这并不奇怪:(1)恶性病变通常比良性病变更难分割,因为其边界更不规则、更模糊。

(2)本数据集中恶性病变的数量少于良性病变的数量(约为2:1),如表1所示,这导致模型在训练阶段更多地关注良性病变。其次,随着样本数量的增加,差距逐渐减小,尤其是在Dataset3上。值得一提的是,Dataset3的类别比例是相对平衡的(约1:1)。这表明,SMU-Net在使用大型和类别平衡的数据集进行网络训练时,可以很好地进行恶性病变的分割,这可能得益于显著的表征学习和形态学单元捕捉形状、边缘和位置特征。

6.讨论

6.1 与半自动交互方法的比较

目前,针对语义分割设计了许多半自动交互式深度学习方法,这证明了人工生成先验信息可以促使网络获得更好的性能[54]-[56]。鉴于本文方法用户交互简单的要求,我们比较了iFCN[56]和DeepIGeoS[55]两种半自动交互方法,它们都提供种子点以方便分割。结果见表九。从表IX中我们可以看到:首先,iFCN在三个数据集上的表现优于DeepIGeoS。一个可能的原因是,DeepIGeoS的初始分割不充分,可能会对后续的微调模型造成很大的负面影响。其次,SMU-Net的表现优于iFCN和DeepIGeoS,原因如下:

1)与iFCN的欧氏距离图和DeepIGeoS的测地距离图相比,SMU-Net中的显著性图包含更丰富的层次结构和更多的上下文信息,更有利于总线的分割。

2)尽管所有的方法都提供了先验信息来引导网络学习特征,但SMU-Net进一步受益于分别提取粗到细的前景显著性和背景显著性表征,并有效地将它们与形态学特征融合。

6.2?与基于自动上下文的方法的比较

近年来,针对图像分割任务提出了许多基于上下文的自动分割方法,并取得了很好的效果[57]-[61]。这些基于上下文的自动方法将低级外观特征与来自概率(或分类置信度)映射的上下文和隐式形状信息集成在一起,迭代直到收敛[57]。基于自动上下文的模型与SMU-Net之间存在一些相似之处,即显著性映射类似于分类置信图。

因此,我们实现了两种基于自动上下文的方法进行比较,包括自动上下文支持向量机(AcSVM)[57]和自动上下文FCN (AcFCN)[60]。同时,受自动上下文机制的启发,我们开发了一个基于自动上下文的SMU-Net变体,称为AcSMU。AcSMU利用未使用种子点的(前景和背景)显著性图作为SMU-Net的输入进行1-st迭代。

将由SMU-Net生成的判别概率图作为前景显著图,通过反转前景显著图得到背景显著图,作为下一次迭代的输入。值得一提的是,所有基于自动上下文的方法的迭代次数都被设置为3次。

实验结果如表X所示,其中AcSMU-i表示AcSMU的第i次迭代。我们可以观察到几个关键点。首先,对于两种基于自动上下文的方法,AcFCN优于AcSVM。可能的原因是AcSVM从BUS图像中采样一个局部图像patch作为输入,在像素分类的基础上进行分割,可能缺乏全局信息,忽略邻域关系。此外,BUS图像的模式复杂度和强度相似度也给AcSVM带来了挑战。其次,SMU-Net和AcSMU的表现优于AcSVM和AcFCN。虽然它们都为网络/分类器提供了先验信息,但基于自上下文的模型与本文方法的区别如下:

1)基于自上下文的模型仅使用后验概率图作为背景来指导前景分割,而AcSMU和SMU-Net使用显著性图来指导前景显著性和背景显著性表示学习,并使用背景上下文来辅助前景分割。

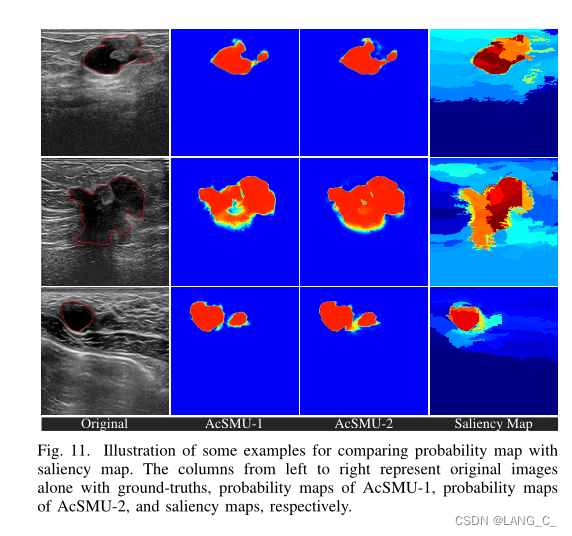

2)性能的提高也得益于中流,中流接收粗到细的表示,有效地融合前景显著性和背景显著性特征,并学习形态感知信息。SMU-Net的性能优于AcSMU,这意味着种子点可以通过鼓励它们尽可能集中在病变区域,从而有助于生成更优的显著性图,而且不需要迭代处理。为了进一步说明,AcSMU在第1-st次迭代和第2- 2次迭代时的概率图如图11所示。

从图中可以看出,AcSMU-1和AcSMU-2的概率图倾向于提供确定性的置信度,即概率的分布极化到接近1或0。然而,提出的显著性地图显示了明确的分层结构,包含了病变区域及其周围组织的潜在显著模式,这对指导学习前景显著性和背景显著性表征并融合它们进行病变分割具有意义。

实际上,这些分割不足的情况(如图中的第一行和第二行)可能无法通过迭代的自动上下文策略进行补救,因为这些分割不足的区域受到零值置信度的限制。

总结

本文根据BUS图像的特点,提出了一种显著引导形态感知U-Net (salix -guided morphologyaware U-Net, SMU-Net)用于BUS图像的病灶分割。SMU-Net的主要优点之一是在显著图的指导下共同学习前景显著和背景显著表示,充分利用背景中包含的丰富纹理信息来辅助前景分割。此外,该网络还具有高效融合粗、细特征和增强形态信息的能力。

在5个公共数据集上的大量实验结果表明,与几种最新的深度学习方法相比,深度学习方法在乳腺病变分割中具有更高的性能和对数据集规模的鲁棒性