发表年份:2021.8

发表单位:Vellore Institute of Technology,Vellore, India

期刊/会议:CVPR

摘要

????????近年来,注意机制在计算机视觉领域中得到了广泛的应用。为了提高网络的性能,已经做了大量的工作,尽管几乎总是会导致计算复杂性的增加。在本文中,我们提出了一种新的注意力模块,与大多数现有模型相比,该模块不仅实现了最佳性能,而且具有较少的参数。我们的注意力模块可以很容易地与其他卷积神经网络集成,因为它的轻量级特性。提出的双多尺度注意网络(DMSANet)由两部分组成:第一部分用于提取不同尺度的特征并对其进行聚合,第二部分使用空间和通道注意模块并行地自适应地将局部特征与其全局依赖性相结合。我们在ImageNet数据集上测试了我们的网络性能,在MS COCO数据集上测试了图像分类、对象检测和实例分割。

1.Introduction

????????人眼的局部感受野促成了卷积神经网络的构建,这为计算机视觉的最新进展提供了动力。著名的InceptionNet中使用的多尺度体系结构(Szegedy et al.,2016)从不同大小的卷积核中聚合多尺度信息。注意力网络最近吸引了很多注意力,因为它允许网络只关注关键方面,而忽略那些没有用处的方面(Li et al.,2019),(Cao et al.,2019)和(Li et al.,2019)。

????????利用注意机制在计算机视觉中成功地解决了图像分类、图像分割、目标检测和图像生成等诸多问题。大多数注意机制可大致分为通道注意和空间注意两种类型,这两种类型都通过使用不同的聚合策略、转换和强化功能聚合所有位置的相同特征来强化原始特征(Zhang等人,2021)。

????????一些工作将这两种机制结合在一起,并取得了更好的结果(Cao等人,2019年)和(Woo等人,2018年)。通过使用有效的通道注意和1×1卷积,计算负担减少了(Wang et al.,2020)。最流行的注意力机制是Squeeze and Excitation模块(Hu等人,2018b),它可以以相当低的成本显著提高性能。使用“通道重排”操作(Zhang和Yang,2021)实现两个分支之间的信息通信。它使用分组策略,将输入特征映射沿通道维度划分为多个组。

2 Related Work

????????阻碍这一领域发展的主要问题有两个:1)空间和通道注意以及两者结合使用的网络只使用局部信息,而忽略了长距离的通道依赖性;2)以前的体系结构未能捕获不同尺度的空间信息,以提高鲁棒性并处理更复杂的问题。这两项挑战分别由(Duta等人,2020年)和(Li等人,2019年)解决。这些体系结构的问题是参数的数量大幅增加。

????????金字塔分割注意(PSA)(Zhang等人,2021)能够在多个尺度上处理输入张量。采用多尺度金字塔卷积结构,在每个通道特征图上集成不同尺度的信息。提取多尺度特征图的通道方向注意权重,从而实现长距离通道依赖。

????????非局部块(Wang et al.,2018)旨在构建密集的空间特征图,并使用非局部操作捕获长期依赖关系。(Li等人,2019)使用了一种动态选择注意机制,允许每个神经元根据输入特征图的多个尺度自适应调整其感受野大小。(Fu等人,2019)提出了一个网络,通过将来自不同分支的这两个注意模块相加,将局部特征与其全局依赖性相结合。

????????多尺度体系结构已成功应用于许多视觉问题(?),(Hu等人,2018b)和(Sagar和Soundrapandiyan,2020)。(Fu等人,2019年)通过将来自不同分支的两个注意模块相加,自适应地将局部特征与其全局依赖性相结合。(Hu等人,2018a)使用空间扩展,使用深度卷积来聚合单个特征。我们的网络借鉴了(Gao et al.,2018)的思想,利用网络捕捉局部跨通道互动。

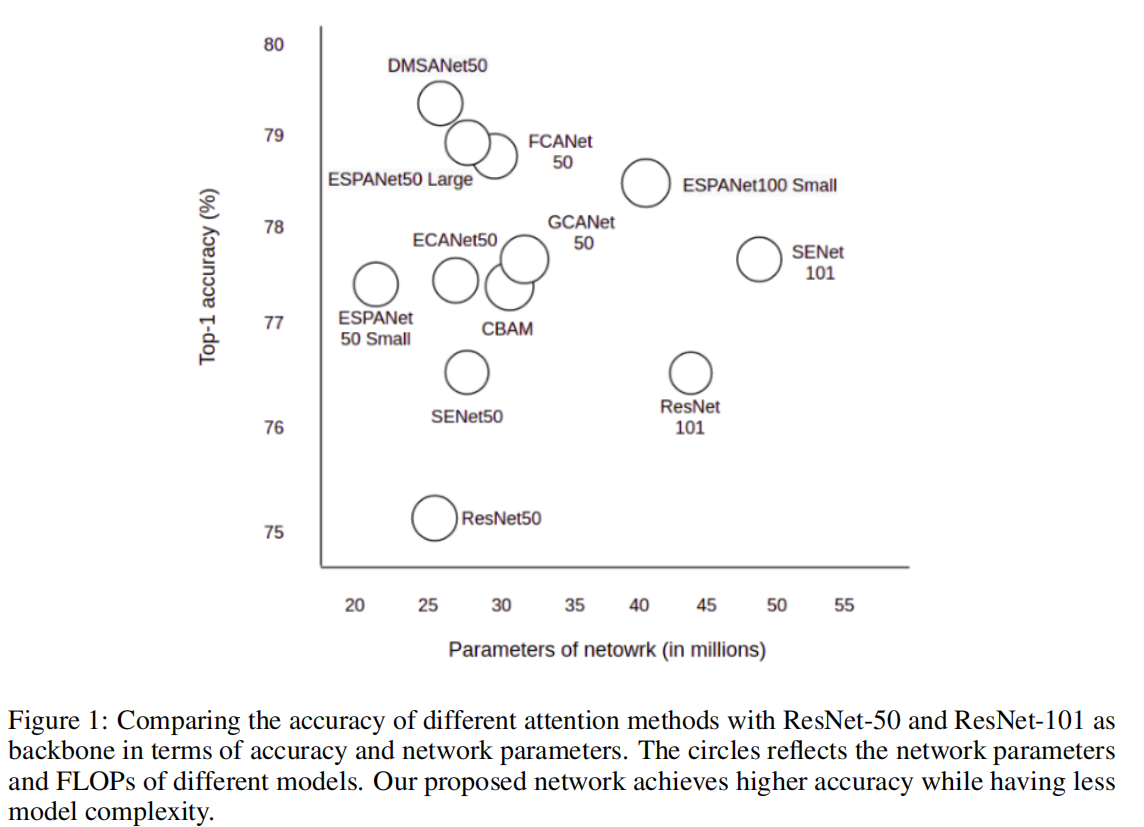

????????最先进的注意力模块的性能(精度)与计算复杂性(参数数量)如图1所示:

?????????我们的主要贡献总结如下:

- 提出了一个新的注意模块,该模块在不同尺度上聚合特征信息。我们的网络具有可扩展性,可以轻松插入各种计算机视觉问题。

- 我们的网络在不同尺度上利用空间和通道注意力捕获更多上下文信息。

- 我们的实验表明,我们的网络性能优于以前的最新技术,计算成本更低。

3 Method

3.1 Feature Grouping

????????Shuffle Attention模块将输入的特征映射划分为多个组,并使用Shuffle单元将通道注意和空间注意集成到每个组的一个块中。子特征被聚合,并使用“通道重排”操作在不同子特征之间传递信息。

????????对于给定的特征映射,其中C、H、W分别表示通道数、高度和宽度,shuffle attention模块将X沿通道维度分为G组,即X=[

,

],

。注意模块用于衡量每个特征的重要性。Xk的输入沿通道尺寸

![]() 分为两个网络。第一个分支用于利用通道之间的关系生成通道注意图,而第二个分支用于利用不同特征的空间关系生成空间注意图。

分为两个网络。第一个分支用于利用通道之间的关系生成通道注意图,而第二个分支用于利用不同特征的空间关系生成空间注意图。

3.2 Channel Attention Module

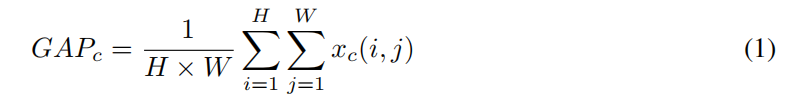

????????通道注意模块用于有选择地加权每个通道的重要性,从而产生最佳输出特性。这有助于减少网络参数的数量。让表示输入特征图,其中H、W、C分别表示输入通道的高度、宽度和数量。SE块由squeeze和excitation两部分组成,分别用于编码全局信息和自适应地重新校通道关系。全局平均池(GAP)操作可通过公式1计算:

?????????SE块中第c个通道的注意权重可以如等式2所示写入:

![]()

? ? ? ? ?其中和

表示完全连接(FC)层。符号σ表示激活函数,其中通常使用Sigmoid函数。

????????我们计算来自原始特征的通道注意图

。我们将A重塑为

,然后在A和A的转置之间执行矩阵乘法。然后我们应用softmax层来获得通道注意图

,如式3所示:

?????????其中,i测量第i个通道对第j个通道的影响。我们在X和a的转置之间执行矩阵乘法,并将其结果重塑为

。我们还将结果乘以比例参数β,并对a执行元素求和运算,以获得最终输出

,如式4所示:

3.3 Spatial Attention Module

????????我们使用上的实例规范化(IN)来获得空间方面的统计信息。F c()操作用于增强

的表示。空间注意力的最终输出是通过W2和b2是形状为

![]() 的参数来获得的。之后,将两个分支连接起来,使通道数等于输入数。

的参数来获得的。之后,将两个分支连接起来,使通道数等于输入数。

? ? ? ? ?将由A∈表示的局部特征送入卷积层,生成两个新的特征映射B和C,其中B,C∈

。我们将其重塑为

,其中N=H×W是像素数。接下来,在C和B的转置之间进行矩阵乘法,并应用softmax层来计算空间注意图S∈

。此操作如等式1所示:

?????????其中,测量第i个位置对第j个位置的影响。接下来,我们将特征A输入到卷积层,以生成新的特征映射D∈

并将其重塑为

。我们在D和S的转置之间执行矩阵乘法,并将结果整形为

。我们将其乘以比例参数α,并对特征a执行元素求和运算,以获得最终输出E∈

,如式2所示:

3.4 Aggregation

????????在网络的最后部分,所有子特征都被聚合。我们使用“通道重排”操作来实现沿通道维度的跨组信息流。我们模块的最终输出与输入大小相同,这使得我们的注意力模块很容易与其他网络集成。

????????整个多比例尺预处理特征图可通过方程7中定义的串联方式获得:

![]()

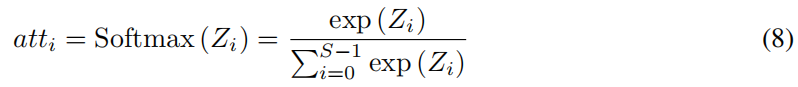

?????????其中F∈是获得的多尺度特征图。我们的注意模块在特征描述符的引导下,跨通道自适应地选择不同的空间尺度。该操作在等式8中定义:

?????????最后,我们将多尺度通道注意力的重新校准权重乘以相应尺度

的特征图,如等式9所示:

![]()

?3.5 Network Architecture

????????我们提出了DMSA模块,目的是构建更高效和可扩展的体系结构。我们网络的第一部分借鉴了(Li et al.,2019)和(Zhang and Yang,2021)的观点。输入特征图X沿着通道维度拆分为N个部分。对于每个分割的部分,它有个公共通道,第i个特征图为Xi∈

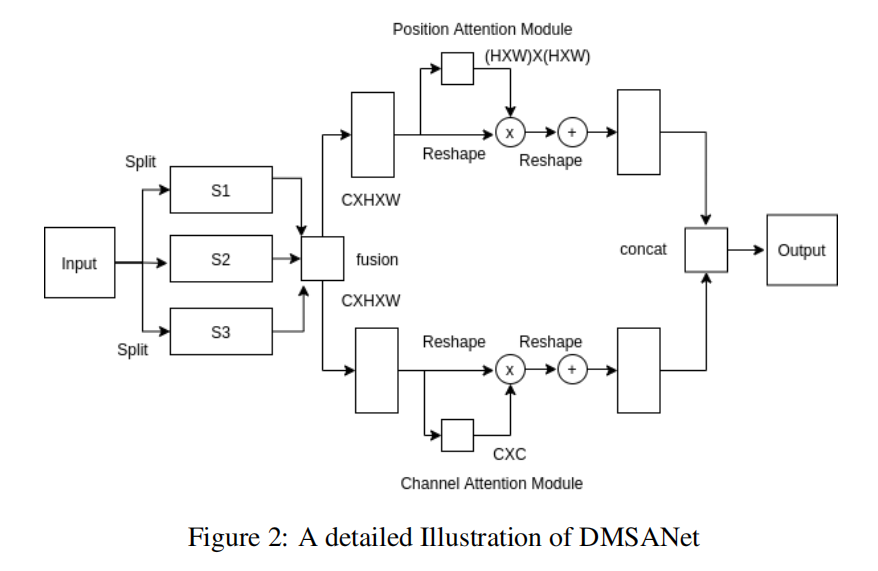

。各个特征在传递到两个不同的分支之前进行融合。

????????这两个分支由位置注意模块和通道注意模块组成,如(Fu et al.,2019)中提出的语义分割。我们网络的第二部分做了以下工作:1)构建一个空间注意矩阵,该矩阵对特征的任意两个像素之间的空间关系进行建模;2)注意矩阵与原始特征之间的矩阵乘法。3) 对得到的矩阵和原始特征进行元素求和运算。

????????操作符concat和sum用于重塑特征。来自两个并行分支的特征被聚合以生成最终输出。完整的网络架构如图2所示:

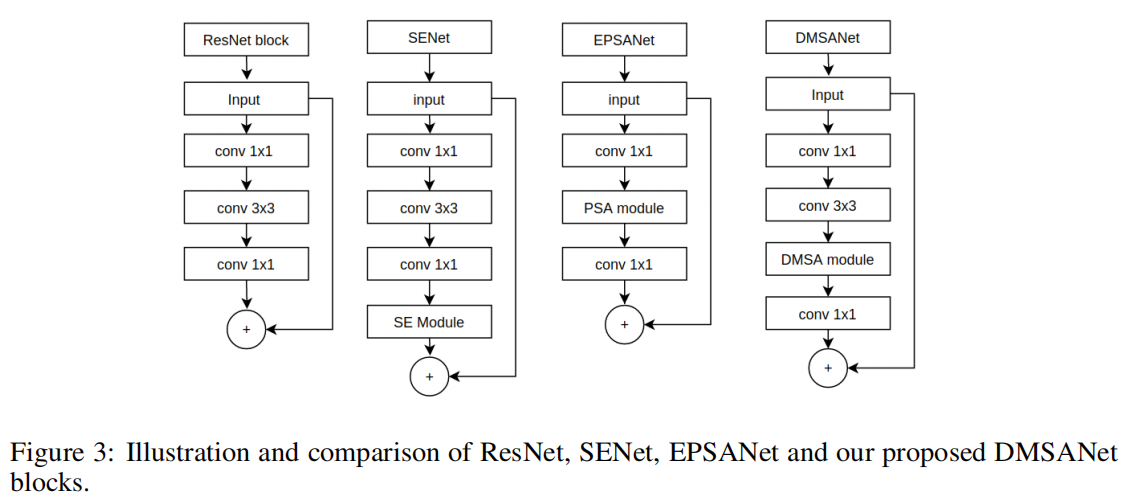

?????????图3中,我们将我们的网络架构与Resnet(Wang et al.,2017)、SENet(Hu et al.,2018b)和EPSANet(Zhang et al.,2021)进行了比较。我们在3×3卷积和1×1卷积之间使用DMSA模块。我们的网络能够提取不同尺度的特征,并在通过注意模块之前聚合这些单独的特征。

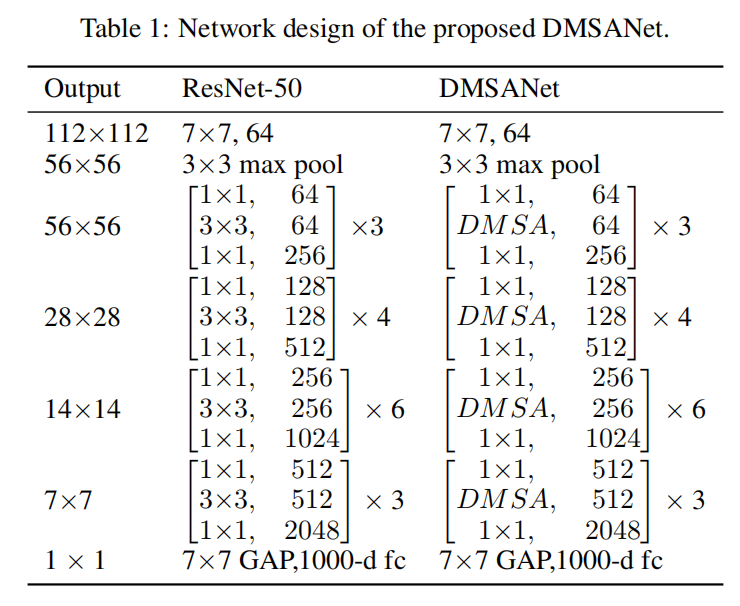

?????????我们提议的注意力网络的架构细节如表1所示:

3.6 Implementation Details

????????我们使用残差网络(He et al.,2016)作为主干,这在Imagenet数据集的图像分类文献中被广泛使用(Deng et al.,2009)。数据扩充用于增加数据集的大小,输入张量裁剪为224×224。使用随机梯度下降作为优化器,学习率为1e?4动量为0.9,最小批量为64。学习率最初设定为0.1,在总共50个epochs中,每20个epochs降低10倍。

????????我们使用残差网络和FPN作为目标检测的骨干网络(Lin等人,2017a)。我们基准测试的检测器是MS-COCO数据集上的Faster RCNN(Ren et al.,2015)、Mask RCNN(He et al.,2017)和RetinaNet(Lin et al.,2017b)(Lin et al.,2014)。使用随机梯度下降作为优化器,权重衰减为1e?4,动量为0.9,每个GPU的batchsize为16,持续10个epoch。学习速率设置为0.01,每10个epoch减少10倍。

????????例如,分割我们使用Mask RCNN(He et al.,2017)和FPN(Lin et al.,2017a)作为主干。使用随机梯度下降作为优化器,权重衰减为1e?4,动量为0.9,批处理大小为10个时代的每个GPU 4个。学习速率设置为0.01,每10个历元减少10倍。

4 Results

4.1 Image Classification on ImageNet

????????我们将我们的网络与之前在ResNet上的最新技术进行了比较,共有50层和101层。

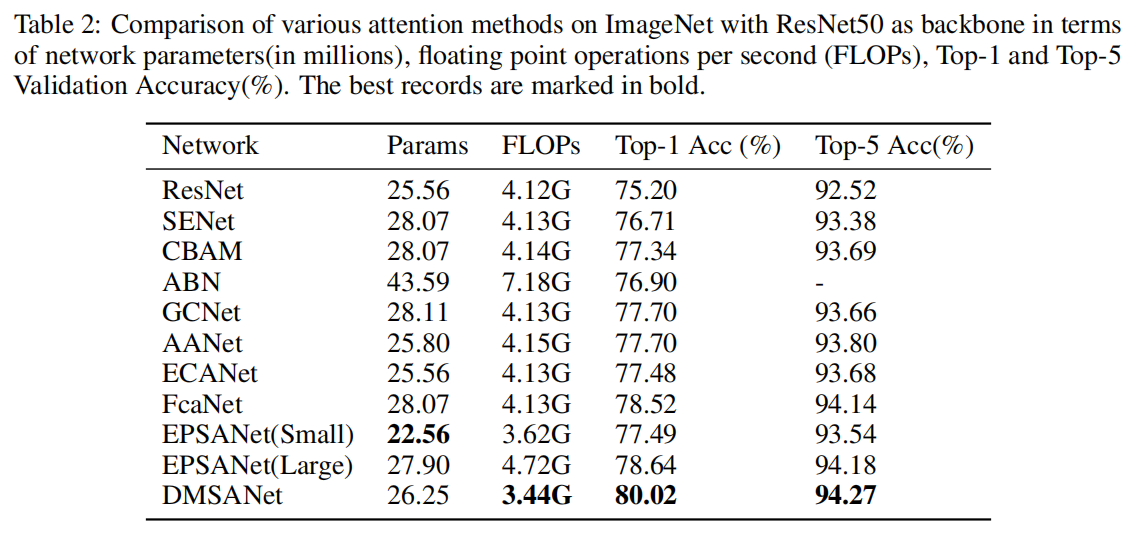

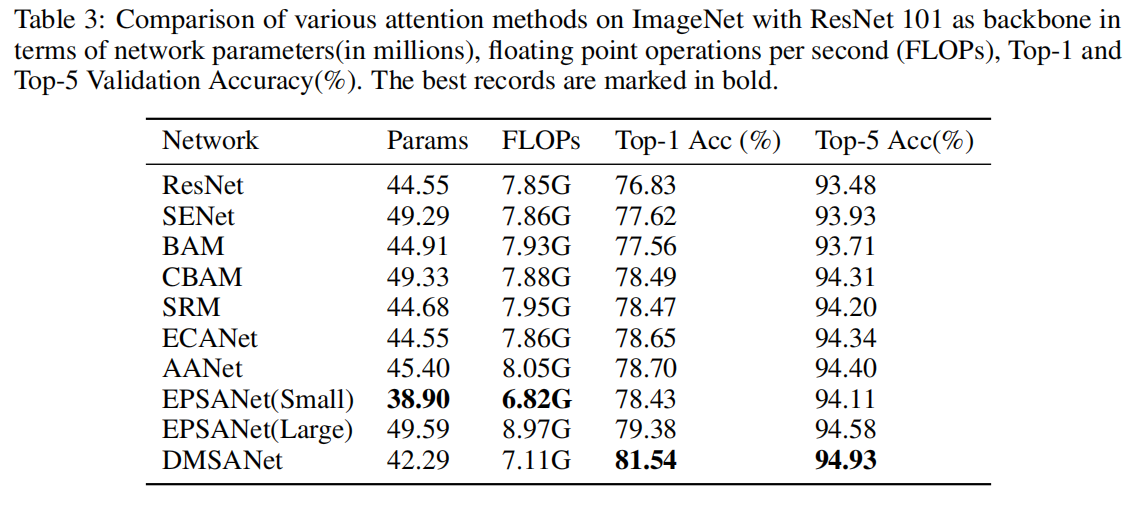

????????我们的网络在准确性方面表现出了最好的性能,与之前的所有注意力模型相比,取得了相当大的改进,同时计算成本更低。表2显示了我们的网络与以前以ResNet50为主干的最先进技术的比较:表3显示了我们的网络与以前以ResNet101为主干的最先进技术的比较:

?4.2 Object Detection on MS COCO

?4.2 Object Detection on MS COCO

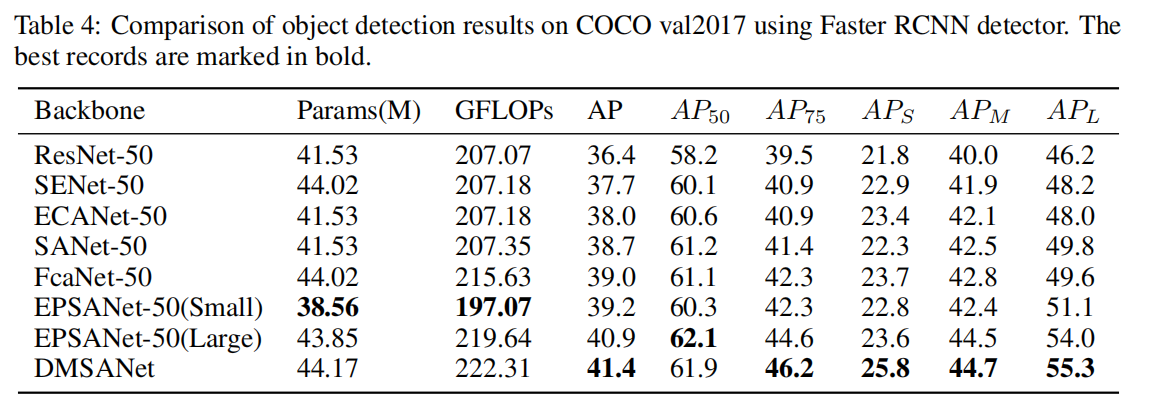

????????表4显示了我们使用Faster RCNN检测器的网络与以前的最新技术状态的比较:

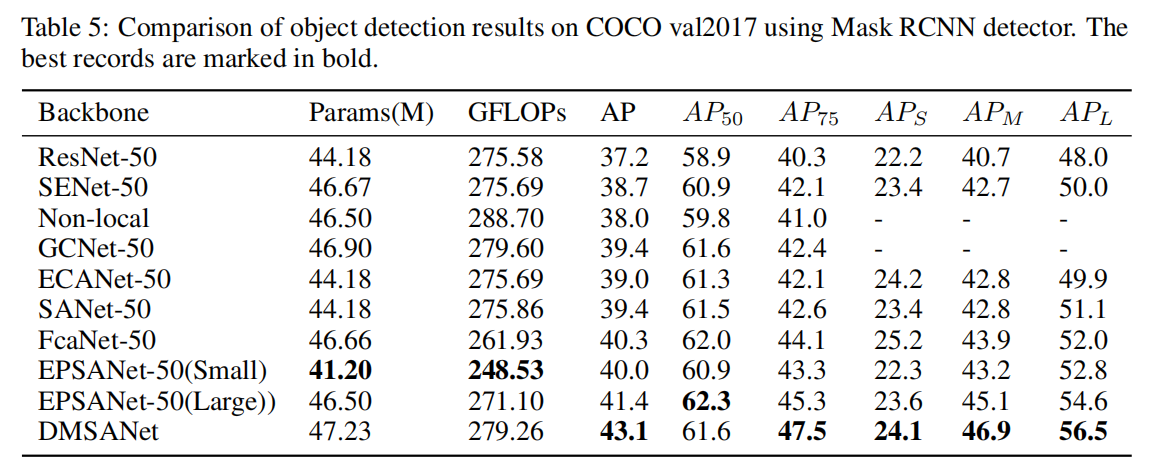

????????表5显示了我们使用Mask RCNN检测器的网络与以前的最新技术状态的比较:

?

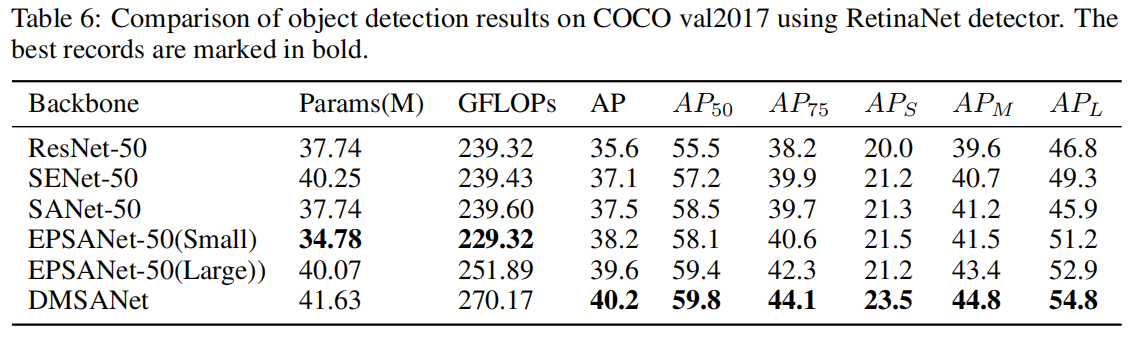

????????表6显示了我们使用RetinaNet检测器的网络与以前最先进的网络的比较:

?

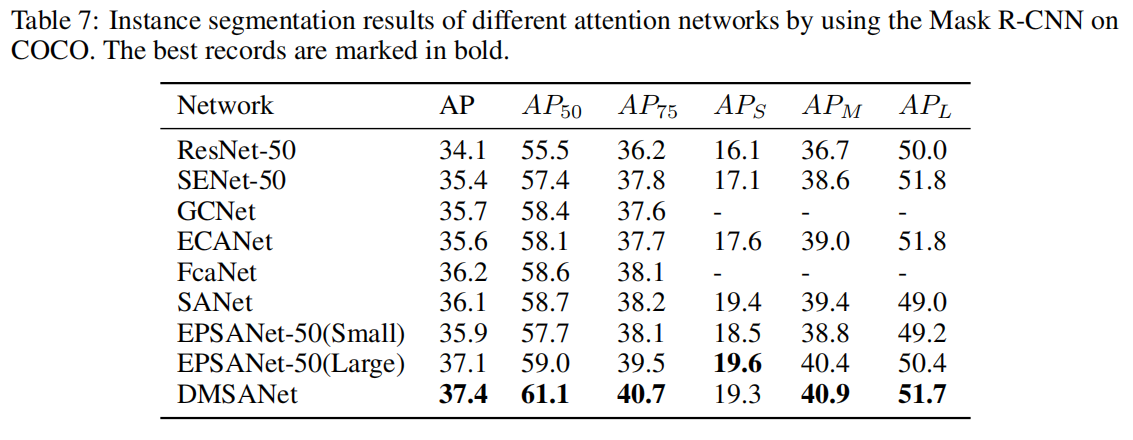

4.3 Instance Segmentation on MS COCO

????????我们使用Mask RCNN(He et al.,2017)作为MS-COCO数据集的基准(Lin et al.,2014)。表7显示了我们使用MS COCO数据集进行的网络实例分割与以前最新技术的比较结果:

4.4 Ablation Study

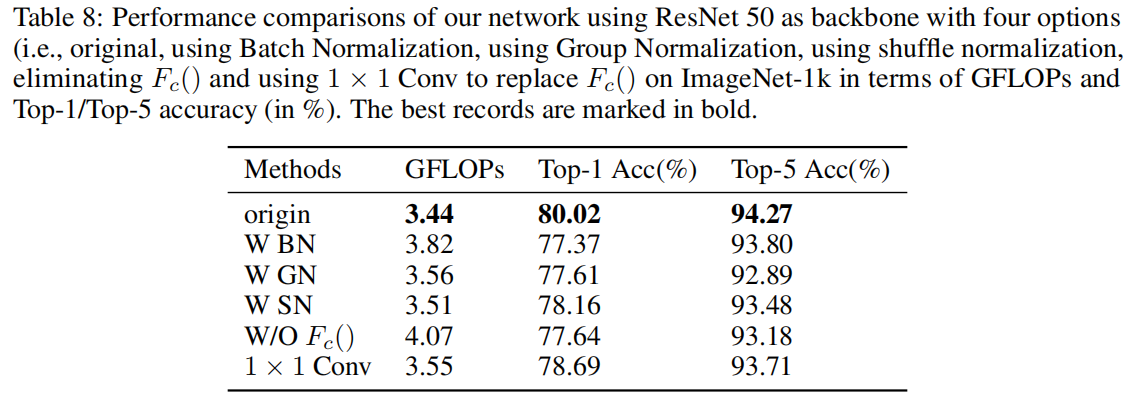

????????我们网络结构的消融实验如表8所示。最好使用实例归一化(IN)来获得结果。与原始网络相比,删除Fc()和使用1×1 Conv都会导致性能降低。前者是因为Fc()用于增强单个功能的性能,而后者是因为每个子功能中的通道数量太少,所以在不同通道之间交换信息并不重要。

5 Conclusions

????????在本文中,我们提出了一种新的注意模块,称为双多尺度注意网络(DMSANet)。我们的网络由两部分组成:1)第一部分用于聚合不同尺度的特征信息;2)第二部分由位置和通道注意模块组成,用于并行捕获全局上下文信息。在对我们的网络进行定性和定量评估后,我们发现我们的网络在图像分类、目标检测和实例分割问题上都优于以前的最新技术。消融实验表明,我们的注意力模块在不同的尺度上有效地捕获远程上下文信息,从而使其可推广到其他任务。DMSANet注意力模块最棒的部分是它非常轻量级,因此可以在需要时轻松插入各种自定义网络。