出品人:Towhee 技术团队

Facebook AI 提出了一种 TimeSformer(Time-Space transformer)的视频理解新架构,完全基于Transformer,能够彻底摆脱 CNN!仅用三分之一的时间训练,TimeSformer 就能以十倍的速度推理,并且在多个行为识别数据集得到超群的效果。论文中使用的数据集包括 Kinetics-400,Kinetics-600、Something-Something-v2 、Diving-48 和 HowTo100M ,均验证了 TimeSformer 的高性能!

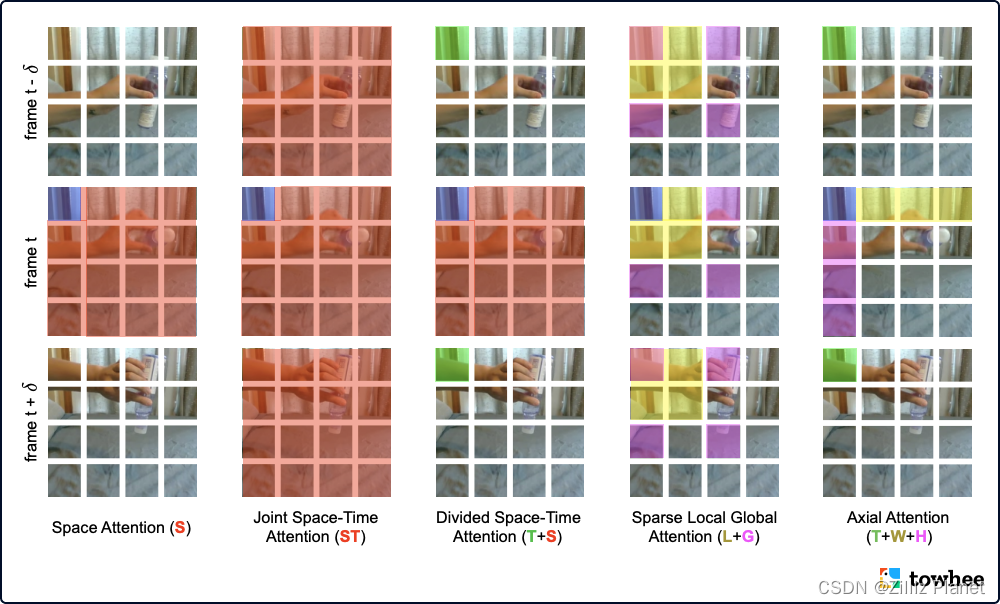

?TimeSformer: Visualization of 5 space-time self-attention schemes

TimeSformer 可以捕获整个视频的时间和空间依赖性。它将输入视频视为一个时空序列,由每一帧中提取的图像小块 (patches) 组成,类似 Transformer 在 NLP 中的部分用法。与现代的 3D 卷积神经网络相比,TimeSformer 不仅加速了训练过程,也大幅减少了推理时间。除此之外,由于 TimeSformer 的可拓展性,它更具发展潜力,能够处理更长的视频片段、训练更大的模型。

参考资料:

模型用例:action-classification/timesformer

论文地址:Is Space-Time Attention All You Need for Video Understanding?

其他资料:

Facebook AI 提出 TimeSformer:完全基于 Transformer 的视频理解框架

TimeSformer 解析:视频理解中的transformer

更多项目更新及详细内容请关注我们的项目(?https://github.com/towhee-io/towhee/blob/main/towhee/models/README_CN.md?) ,您的关注是我们用爱发电的强大动力,欢迎 star, fork, slack 三连 :)

zilliz用户交流

?