1.回归的定义:找到一个函数,输出一个特征值,后输出数值。

如:以过去房价数据预测未来的房价,李宏毅老师油管过去节目观看人数预测未来的最近节目观看人数。

2.模型步骤:

(1) 模型假设–线性模型:yi=xi*w+b

其中x为features,w为weight,b为bias;xi可以为多个feature.

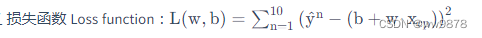

(2)模型评估–损失函数

在模型训练资料后得到了资料的分布,从数学的角度真实值y^到y轴的垂直函数的最小距离来判断模型的好坏(欧几里距离),损失函数如下:

一般来说,损失函数越小模型越好,但不代表越小的损失函数模型就越好。

3.最佳模型-梯度下降

为了找出最好的函数,我们需要确定w和b的值。而w和b的值不止一个。我们需要使用梯度下降的方法来不停迭代w和b的值,来找到最好的函数。

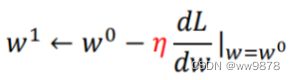

例w的更新:

随机选取一个w0,对其求导数。w0的导数(斜率)决定了其前进方向。

之后引入步长 决定因素,η(学习率:人工设参),从而得到w1的更新(w2…wn,b1…bn同理)找到当前最小值。:

3.过拟合以及优化:

使用使用训练集和测试集的平均误差来验证模型的好坏 ,当测试集的平均误差大于训练集误差时,过拟合现象出现。(训练集比较理想,而测试集过程却比较糟糕)

优化步骤:

1.将多个线性模型合并到一个线性模型中

2.加入更多的特征xi,

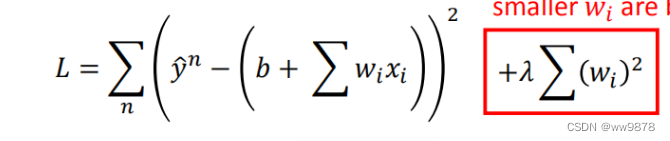

但加入更多特征后导致w会使一些特征权重过大,仍然过拟合

3.加入正则化

(正则化这里不是了解后续去补)

目前的理解是:在损失函数中增加一项,那么其实梯度下降是要减少损失函数的大小,减 少这个正则项的大小,那么也就是会减少W权重的大小。

越小的wi使函数越平滑,我们则认为越平滑的函数则可能是正确的。而b趋向于0对于函数的平滑程度没有影响。