评价指标

1. TP、FP、TN、FN

-

P (Positive) 和 N(Negative) 代表模型的判断结果

-

T (True) 和 F(False) 评价模型的判断结果是否正确

-

FP: 假正例,模型的判断是正例 § ,实际上这是错误的(F),连起来就是假正例

-

FN:假负例,模型的判断是负例(N),实际上这是错误的(F),连起来就是假正例

-

TP:真正例, 模型的判断是正例(P),实际上它也是正例,预测正确(T),连起来就是真正例

-

TN:真负例,模型的判断是负例(N),实际上它也是负例,预测正确(T),就是真正例

2. 常用指标

- 准确率:T/(T+F),也就所有预测正确的和所有test集的比例。

- 查准率:TP/(TP+FP),用于衡量模型对某一类的预测有多准。

- 召回率:TP/(TP+FN),指的是某个类别的Recall。Recall表示某一类样本,预测正确的与所有Ground Truth的比例。

- FPR负正类率:FP/(FP+TN),代表分类器预测的正类中实际负实例占所有负实例的比例。

- TPR真正类率:TP/(TP+FN),

代表分类器预测的正类中正实例占所有正实例的比例,

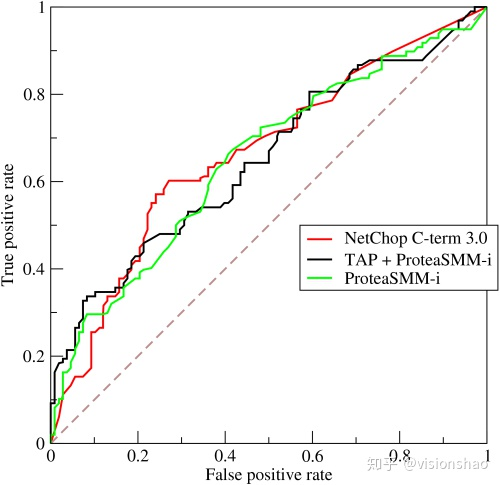

3. ROC

对于样本数据,我们使用分类器对其进行分类,分类器会给出每个数据为正例的概率,我们可以针对此来设定一个阈值,当某个sample被判断为正例的概率大于这个阈值时,认为该sample为正例,小于则为负例,然后通过计算我们就可以得到一个(TPR , FPR)对,即图像上的一个点,我们通过不断调整这个阈值,就得到若干个点,从而画出一条曲线。

4. AUC

AUC,(Area Under Curve),被定义为ROC曲线下的面积,显然这个面积小于1,又因为ROC曲线一般都处于y=x这条直线的上方,所以AUC一般在0.5到1之间。使用AUC值作为评价标准是因为很多时候ROC曲线并不能清晰的说明哪个分类器的效果更好,而作为一个数值,对应AUC更大的分类器效果更好。

- AUC的含义为,当随机挑选一个正样本和一个负样本,根据当前的分类器计算得到的score将这个正样本排在负样本前面的概率。

从AUC判断分类器(预测模型)优劣的标准:

- AUC = 1,是完美分类器,采用这个预测模型时,存在至少一个阈值能得出完美预测。绝大多数预测的场合,不存在完美分类器。

- 0.5 < AUC < 1,优于随机猜测。这个分类器(模型)妥善设定阈值的话,能有预测价值。

- AUC = 0.5,跟随机猜测一样(例:丢铜板),模型没有预测价值。

- AUC < 0.5,比随机猜测还差;但只要总是反预测而行,就优于随机猜测。