本博客系博主根据个人理解所写,非逐字逐句翻译,预知详情,请参阅论文原文。

论文标题:InfoSurgeon: Cross-Media Fine-grained Information Consistency Checking for Fake News Detection;

作者:Yi R. Fung1, Chris Thomas2, Revanth Reddy1, Sandeep Polisetty3, Heng Ji1, Shih-Fu Chang2, Kathleen McKeown2, Mohit Bansal4, Avirup Sil5;

- 1 University of Illinois at Urbana-Champaign

- 2 Columbia University

- 3 UMass Amherst,

- 4 University of North Carolina at Chapel Hill,

- 5 IBM

发表地点:ACL 2021;

论文下载链接:https://aclanthology.org/2021.acl-long.133.pdf

代码链接:https://github.com/yrf1/InfoSurgeon

摘要:

为了对抗神经网络生成的虚假新闻(fake news),急需一种有效的机制。

本文构造了一个新的知识元素级的基准数据集(benchmark at the knowledge element level),同时提出了一个知识元素(knowledge element, KE)级别的虚假新闻检测方法,通过检查跨模态信息的一致性实现对导致虚假的细粒度知识元素的检测。

由于KE级别虚假新闻检测方向的训练数据缺乏,本文制定了一种新的数据合成方法,通过修改知识图谱中的知识元素来产生特定的、难以检测的、包含已知不一致性的,噪声训练数据。

本文的虚假信息检测方法超过现有SOTA(准确率最多超过16.8%),且对于虚假信息的检测提供了细粒度的可解释性。

本文动机及现有方法的问题:

- 现有fake news detection方法大多使用word emb或者semantic emb构建基于document-level的检测模型。但是,虚假新闻fake news通常是对真实新闻real news进行了小幅度的修改得到的,比如夸大,伪造其中关键的知识元素;或者fn是由于没被证实(实时性);还有fn需要其他模态的补充信息才能验证其真假性(不一致性)。这些情况下,细粒度的fake使用document-level的模型就可能检测不出来了。

- 通过挖掘多模态news的自身不一致性(比如图像内容和文本内容相悖),或者与既有事实的不一致性,来检测news里面的mis KEs。这种方式对于判定fake有更好的可解释性。

- KE级的fake news一个大问题是缺乏训练数据,因此本文提出了一种方法,将real news构建为图,然后替换或者插入节点或者边,得到虚假的图,再将图转变为text,就实现有效的KE-level的training fake news的生成。

本文主要贡献:

- 通过将news表示为一个多模态知识图谱(knowledge graph, KG)的方式,检测其中mis的元素pieces,以带来强可解释性;

- 本文模型同时利用fake news的source context,语义表示,多模态信息,和背景知识,实现fake news的检测;

- 创建了一个benchmark数据集,KE level的;

本文模型及方法:

1. 问题定义:

给定一条多媒体新闻X,如上图最左边所示,虚假新闻检测任务的目的就是判断该新闻的真假性。该新闻数据包含以下3个方面:

- 新闻的主体内容:body text bt;

- 若干图像 im_1,..., im_i,及其对应的若干标题 c_1, ..., c_i;

- 新闻的元数据metadata,m包含所属领域domain,发布时间date,作者author,标题headline;

本文的虚假新闻检测目的是在两种level上检测新闻的真假性:

- document-level:针对每一条多媒体新闻,检测该新闻整体的真假性;

- knowledge element-level:检测一条新闻中,导致其虚假的特定的知识元素(本文将要检测的KE定义为信息网络中的实体entities,关系relations,事件events,以及子图subgraphs或者元路径metapaths,这些元素);

2. 模型整体结构:

如上图中间部分所示,本文将每一条多媒体新闻构造为一个多媒体知识图(multimedia knowledge graph)KG=(N, E),其中N是节点,由实体 t 构成;E是边,包含关系 r,事件元素角色 a。

?那么本文两种level的虚假新闻检测实际转化为:

- document-level:检测一个多媒体知识图整体的真假性,使用准确率作为评估指标;

- KE-level:检测知识图中边edge的真假性(因为实体本身是没有真假性之说的,所以实际反映真假的只有graph中的边关系),使用F-score作为评估指标;

3. 模型特征初始化:

如上图中间所示,本文模型同时从global context和local KG提取特征:

3.1. global context是news所包含的原始数据:body text,image,cpations,metadata(是否只有节点,形成边吗?)。

该部分的特征初始化方法:

- body test和caption使用变体的BERT,对encoded token进一步学习句子级表示;

- 对元数据metadata,将他们输入text encoder得到特征表示;

- 对图像,拼接其object级特征和event级特征;

- 上述数据提取的nodes间的edge,使用node features间基于attention的语义相似性构建;

3.2. local KG是通过将news中提取的nodes与KG中实体nodes连接,构成最终graph。

每个news构成一个KG,先用IE系统从news中提取实体关系等,然后进行entity? linking将提取的东西map到现有知识图库中(没见过的实体就用聚类去map)。

该KG中所有节点和边的初始化特征由以下三个部分组成:

- background embeddings:对于KG中的实体节点N_t,通过Freebase数据库找到它的wikipedia页面,然后将该页面第一段的文本输入基于LSTM的语义表示模型,得到N_t的特征表示;对于边edge而言,是将其连接的两个节点的wikipedia介绍一起输入LSTM型模型,得到edge的特征表示;对于没有wikipedia页面对应的节点和边,该部分向量置为0;

- news embeddings:News-based node features are initialized from passing an LSTM through the word embeddings of the canonical entity mention extracted(这部分我没有看明白,但是博主猜测可能是用news中对于该实体节点或者关系边的相关text经过LSTM网络来获得他们的news embeddings);

- source attribution:这是一个4维的二进制向量,代表该向量是来自新闻的哪一部分数据,body text,image, caption,还是metadata;

4. 特征传递和联合学习:

作者认为所构造的KG中non-fake的triplets(包含两个节点和一条边)想比较于fake的triplets而言,它的边与node关系更近。因此要学习节点之间连接的credibility来反映真假性。

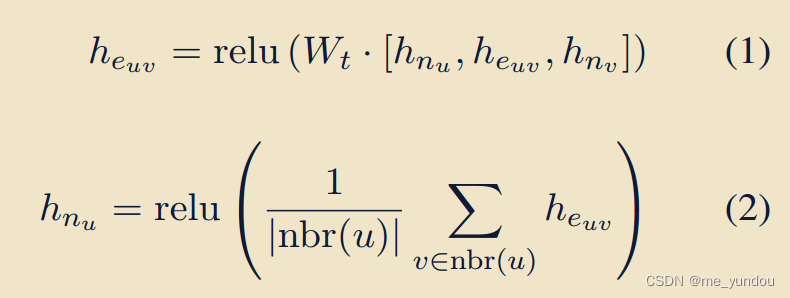

- 具体而言,针对global context subgraph中的节点u,利用其邻居节点v来传递和更新它的特征表示,具体公式如下(GNN类似):

- 针对local KG网络,给定其中两个节点u和v,利用上述公式(1)计算他们之间的credibility。

- 最后通过图注意力和消息传递机制,将global context和local KG的特征信息联合起来。(问题:一条新闻不是被构建成了一个多媒体的图吗?这里为什么又分成了两个图?这两个图还各自有自己的学习方法?然后再结合起来?)

5. 模型检测部分:

- document-level检测:前面已经学到了graph中节点和边的特征表示,可以用avg或者max pooling从node/edge feature得到graph feature。然后对graph feature进行线性分类就可以实现真假性检测。另外本文在分类前还用了一些指示变量to strengthen signals,这些指示变量可以反映重复实体数目(增加指示变量这有什么好处?暂时不明白)。

- KE-level检测:就是对KG中边进行分类,检测这些关系或者事件角色是否正常。

6. 虚假新闻生成:

由于KE级的虚假新闻标注数据太少,而人工标注成本太高,所以本文提出两种方法构建可控的合成的虚假新闻,并且能够为KE自动生成标签(有关真假的标签)。

给定一个真实新闻集合X_{real},针对他们所构建的KG,作者有意地修改KG中的显著KEs,得到一个修改后的虚假的KG‘;那么,被修改的KEs就能够自动拥有其标签---fake,未被修改的KEs就是real的,同时在document-level上,修改后的KG’再转化为text之后,得到就是fake的新闻。

6.1 合成的KG to text

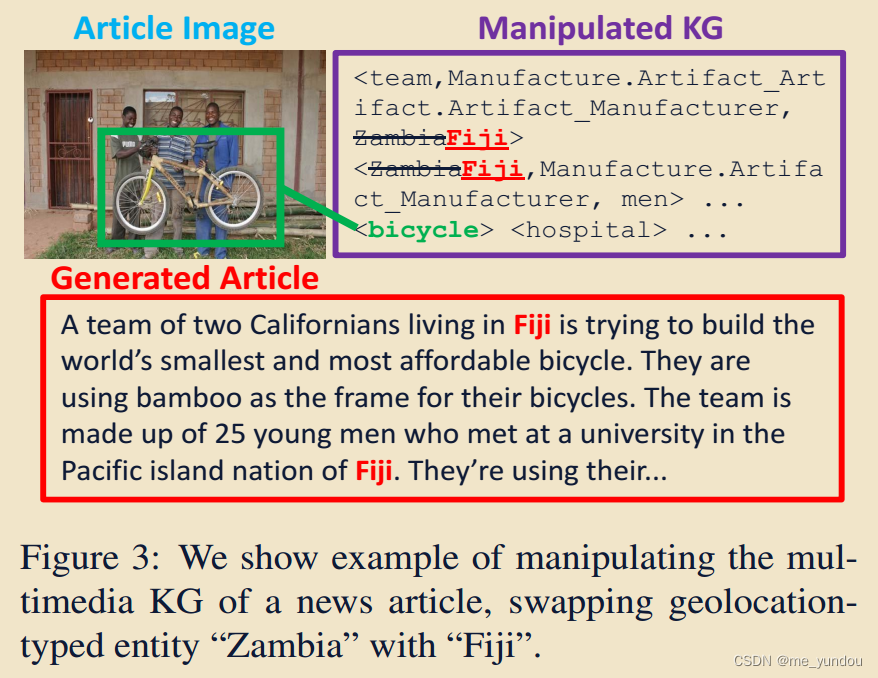

在KG的基础上修改特定KE实现虚假text的生成。具体包括修改实体,关系,和事件。

- 实体替换:将原始实体替换为同类型的其他实体;

- 增加新关系或者事件:对于KG中现有的实体,随机选择其一个关系或者事件,然后为该实体和关系添加一个新的实体(相当于给定头实体和关系,增加一个尾实体);

- 子图替换:用另一个新闻中的子图替换当前新闻中的子图(包含特定的node的子图);

本文同时考虑过去掉node或者edge,但是发现缺失信息对于检测任务而言太难了。所以最终没有选择去掉显著KEs的方式。

最后,得到合成的KG’后,通过fine-tuning一个BART-large模型,生成对应的虚假新闻。如下图3所示,是一个实体替换的例子。

6.2 合成的AMR to text

前人工作发现caption对于检测虚假新闻非常有用,因此本文还通过现有的real news的captions来合成虚假新闻,通过修改caption中实体之间的关系。

作者首先提取real news的captions的抽象语义表示(Abstract Meaning Representation ,AMR,能够捕获丰富的句子级语义特征)图,然后修改这些AMR graphs,最后将修改后的虚假AMR graph转化为text,得到虚假news。如下图4所示是一个例子。

具体修改AMR graph的方式这里不再赘述,详细请看论文原文4.2章节。

实验:

数据集:

- NYTimes-NeuralNews,这是一个多媒体的虚假新闻检测基准数据集,由[1],[2]文章提出;

- VOA-KG2txt,这是本文使用合成KG to text 的方式自己构建的虚假新闻数据集;

对比方法:[2] 和 [3];

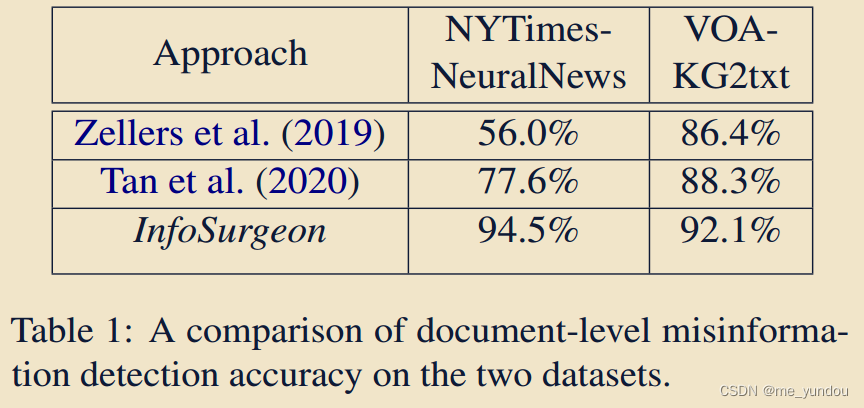

document-level的检测结果分析:

如下表1所示,在两个数据集上,本文方法都高于另外两个baseline很多。

作者认为,相比于tan 2020的方法,本文优势在于使用了多媒体结构推理,借助了额外的KG中background信息,还能捕获实体,关系这些结构信息。

同时作者认为,VOA这个本文构建的数据集,本身对于infoSurgeon来说是有特定难度的,但是本文方法仍然表现最好。

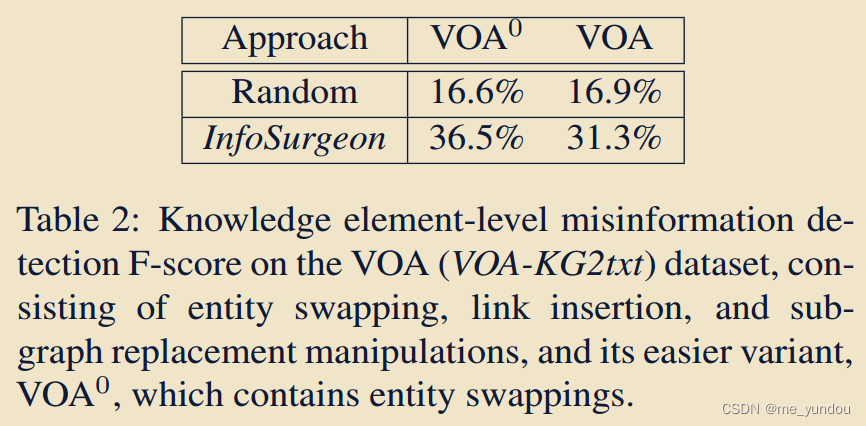

KE-level的检测结果:

针对KE-level的虚假检测有利于虚假新闻检测的可解释性,能够告诉我们是什么导致了新闻的fake。

但是由于数据的缺乏,目前只能在本文自己构建的VOA数据集上进行KE-level的检测实验。如下表2所示,与随机方法相比,本文方法明显性能更好。

另一方面,整体检测准确率很低,是因为针对KE-level的虚假检测难度较大,需要higher-level的推理,基于多媒体和事实信息进行检测。

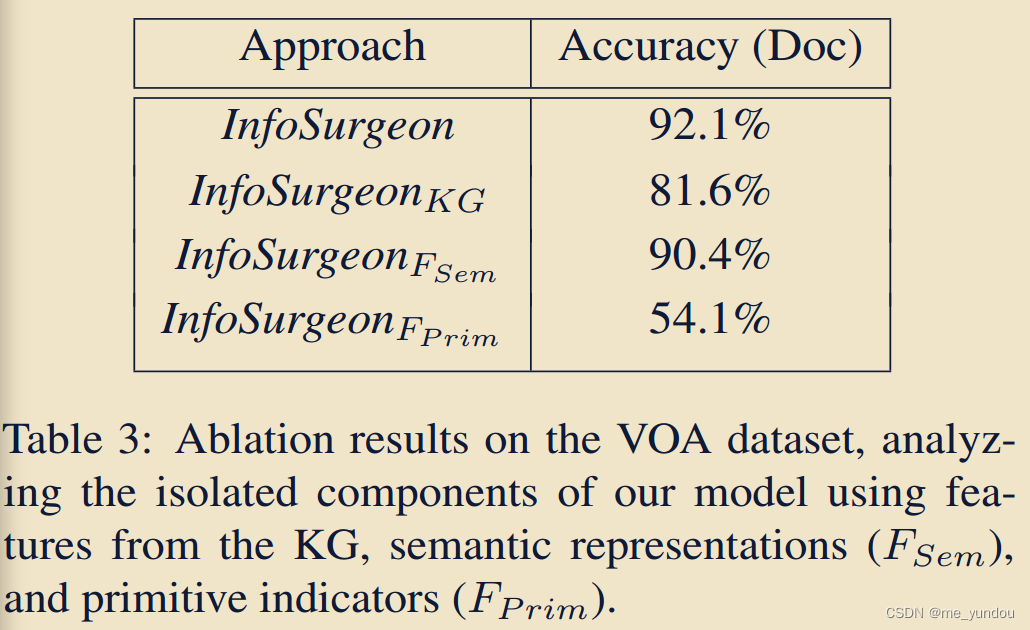

消融实验分析和样例展示(论文5.4章节):

如下表3所示,分别给出仅使用KG,semantic features,和指示值的本文变体模型所得的虚假新闻检测结果,从中可以看出语义特征对检测虚假最有效(就是news的text,image和captions这些semantic features),KG对细粒度的虚假KE检测有辅助作用。

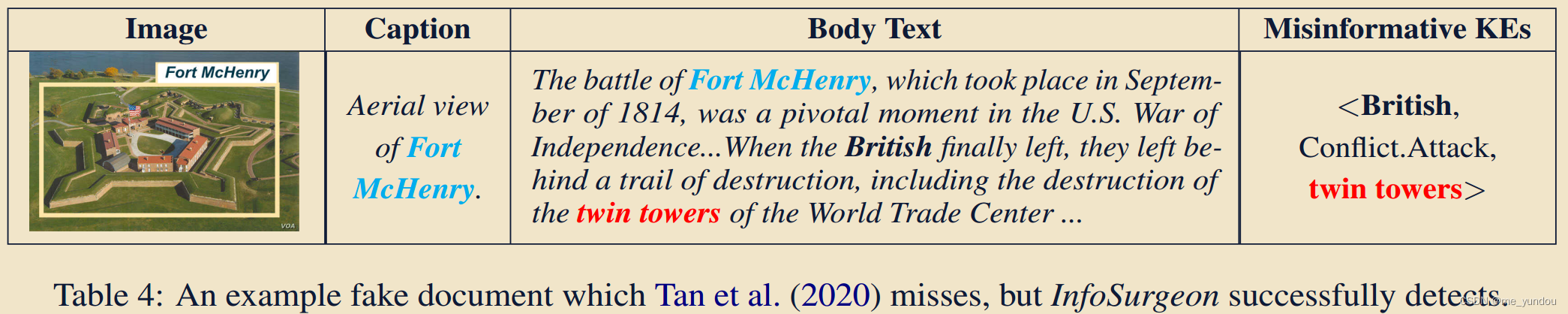

如下表4所示,是一个 虚假新闻的例子,Tan 2020的方法认为该新闻是real,而本文的方法正确识别出了该新闻为fake的,并且从KE-level定位出它的错误在于“twin towers”这个实体。附录中有其他此类样例,感兴趣的可以去论文原文查看。

对生成文本的人工图灵测试:

为了测试本文KG-to-text生成新闻的质量,作者进行了人工测试。随机选取了100篇新闻,一半real一半fake,让16个人判断这些新闻的真假。

最后的结果是:整体的判断准确率是61.6%,真新闻的判断准确率是81.2%,假新闻的判断准确率只有41.9%。有三分之一的假新闻几乎一半的人都判断错误了。

实验结果表明,本文自动生成的虚假新闻对于人类而言是较难判断的(也就是具有较高质量的text)。

总结及展望:

本文提出了一个新的方法在检测多媒体虚假新闻任务上能达到92%-95%的准确率,充分利用跨模态的不一致性和KE-level的关系,实现细粒度的可解释性的虚假新闻检测。

在未来,作者们计划从更多的模态上进行虚假内容的检测,比如结合text,image,video,audio等各种信息;从multiple documents或者在常识knowledge上进行一致性推理;推广到open-domain的document 检测上,比如多源的,多语言的,多文化的。

长远来看,作者计划创造更多人工生成的数据,能够包含更多类型的虚假,比如实体新颖性,新闻价值等。

注意:为了避免不怀好意的人创造更多虚假新闻,本文不公开虚假新闻的生成器部分模型;同时公开虚假新闻检测方面模型,以供大家更好地打击虚假新闻。详见论文原文第8章节。

个人理解和问题:

1.本文实验上只选用了两个数据集,其中一个还是自己创建的,不能体现本文模型针对不同数据集,在不同领域新闻上的泛化性。为什么不多用几个数据集呢?

2.本文对比方法只选用了两个,现有的虚假新闻检测的多模态模型已经很多了,为什么不进行对比呢?

参考文献:

[1] Ali Furkan Biten, Lluis Gomez, Marc?al Rusinol, and Dimosthenis Karatzas. 2019. Good news, everyone! context driven entity-aware captioning for news images. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 12466–12475.

[2] Reuben Tan, Bryan Plummer, and Kate Saenko. 2020. Detecting cross-modal inconsistency to defend against neural fake news. In Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), pages 2081–2106, Online. Association for Computational Linguistics.

[3] Rowan Zellers, Ari Holtzman, Hannah Rashkin, Yonatan Bisk, Ali Farhadi, Franziska Roesner, and Yejin Choi. 2019. Defending against neural fake news. In Advances in Neural Information Processing Systems, pages 9054–9065