本文是来自2019年IJCAI的CNN-Based Chinese NER with Lexicon Rethinking,用于中文NER的识别。

Pass1

看标题:我们知道有不少中文NER引入了词表以提高正确率,例如Lattice LSTM。和Lattice LSTM不同的是,本文采用了CNN结构与词表进行联合使用。Rethinking是什么暂时不知道,具体看文章。

看摘要:Lattice LSTM作为一种利用字符、词语信息的NER方法,取得了重要的成功。但是该方法并不能充分利用GPU的并行能力,并且存在“词语冲突”问题。本文采用了基于CNN与Rethinking机制,得到了一种高效的中文NER方法。作者认为Rethinking机制可以利用高层的特征信息,解决词语的冲突问题。在四个数据集上均取得了SOTA的结果,并取得了更高的速度。

看总结:本网络通过CNN可以显著的提升运行效率,达到并行计算。本网络通过增加高级特征的反馈层,可以提升效果,解决潜在的词语冲突问题。实验结果取得了显著的提升。

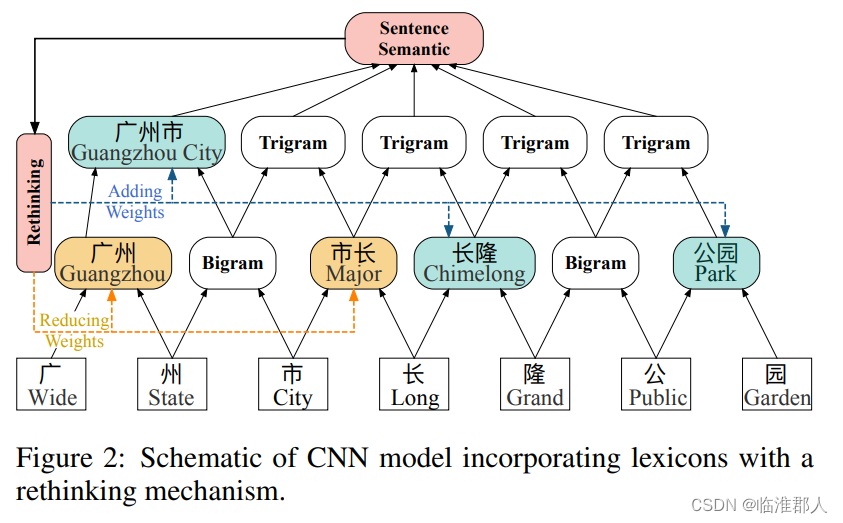

关键图:

我们看图大概可以知道CNN的作用,以及所谓的Rethinking的意思了。CNN其实就是textCNN,咱们已经见过很多次了。低层次的卷积可以捕捉邻接词语的信息,高层次的CNN就可以捕捉到较长距离的信息了。Rethinking就是把CNN提取到的高层次信息再拿回到低层次,重新结合处理。

结论图表有很多,我们暂时先不看。

Pass2

1.简介

NER任务是NLP中的关键的、基础性的工作,并且在很多的下游任务中都会起到作用,例如在信息检索(Information retrieval)、关系抽取(relation extraction)、问答(question answering)系统中起到作用。而中文NER由于没有天然的分词边界(uncertain boundaries),并且存在复杂的词语组合现象(complex compositions), 以及嵌套实体(NE definitions within the nest)问题。典型的方法包括先分词,再做序列标注的流水线方法。

但是由于我们难以获得真实的分割(gold-standard segmentation),因此直接分词错误造成的误差传播比较难受。因此有一些通过预训练词表增强的方法。但是这些方法往往基于RNN方法,基于RNN的方法存在两个问题:

- 不能最高效的利用GPU的并行计算能力,计算效率不高;特别的像Lattice LSTM甚至不能进行batch的计算,效率更低。

- 词表也存在冲突,例如一个字符完全可能从属于多个词语,例如上面关键图Figure2中,“长"可以从属于市长,但其实从属于”长隆公园“。这样的词语冲突,也必须在整个语句的语义视角下才能解决。

因此,本问题处了一个具有Rethinking机制的CNN网络分别解决上述两个问题。

- CNN网络剋高效的并行计算;并且即使单层的网络窗口不大,堆叠多层后也具有较大的感受野,相当于捕捉n元语法的信息。

- Rethinking机制相当于利用第一次提取的高层信息,再送回到底层信息去做“重新思考”与修改。启发式的,这样的重新思考可以解决词语冲突问题。

2.相关工作

中文NER:关于中文NER,主要集中于word-based以及character-based的方法,由于CWS(中文分词系统)的效率一般,因此基于character-based的方法反而更好。此外,Lattice-LSTM取得了较好的成功,但是其存在前文所述的不足。

NER计算效率:此前有人提出了TextCNN方法,取得了不错的效果。在序列标注(sequence labeling tasks)的任务中,CNN一般被用来捕捉低层次的信息,并用作其它结构的输入。CNN也是有多种的,例如空洞卷积(dilated convoutional NN)。但是空洞卷积并不利于引入词语信息,因为他会跳过很多的字符。

Rethinking机制:Rethinking机制可以备用来解决图像分类中的occlusion and noise问题,提升feature mao的质量。本文沿用了这一方法。

3. Lexicon Rethinking CNN

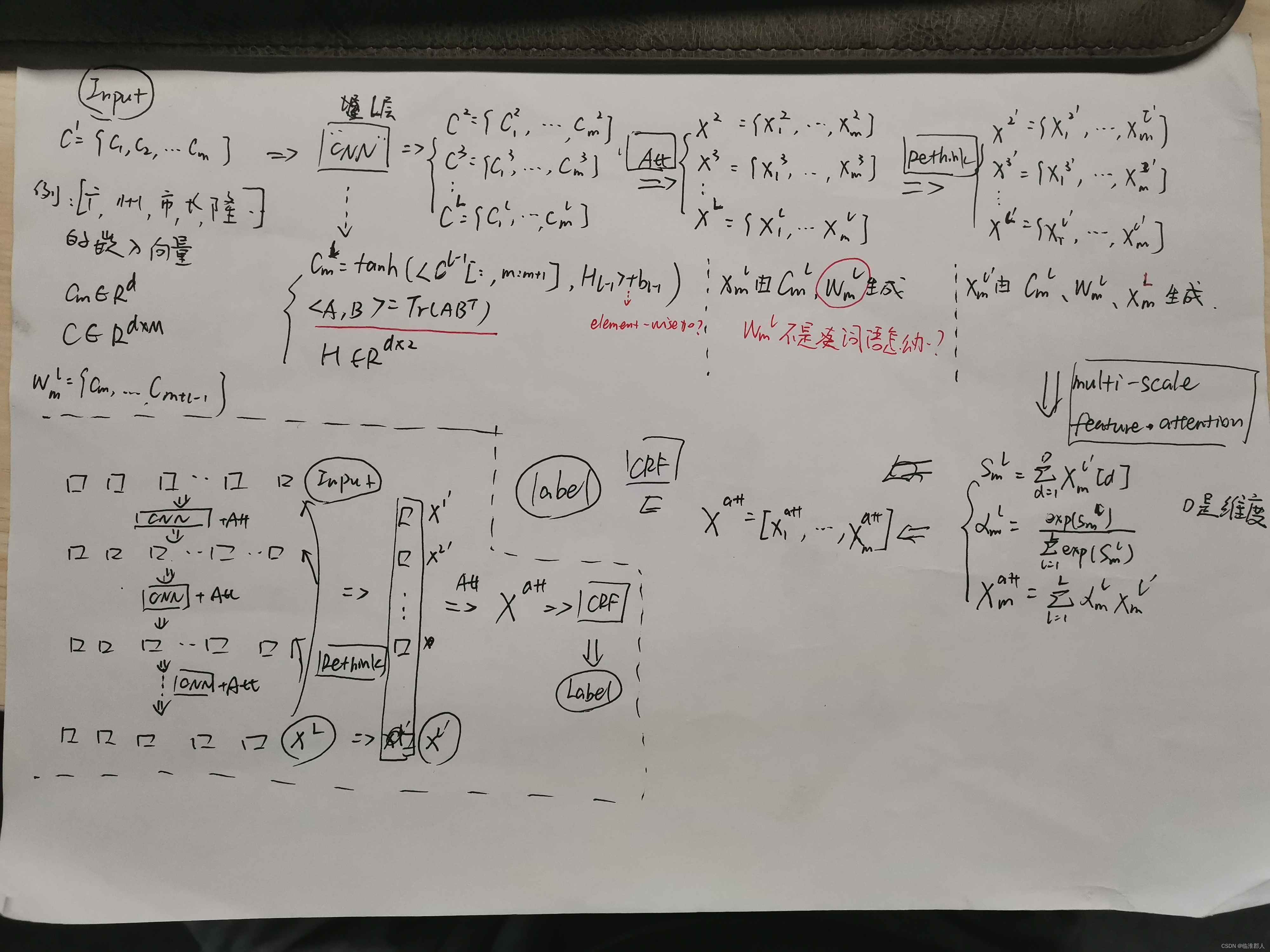

这里为了方便,就直接画图说话了。总体网络其实是一个CNN+Attention构成的结构,其中Attention有门控(同一CNN引入其它信息),也有纵向的注意力结构(同一词语的,不同CNN层次的注意力)。

其中,虚线框内的是“形象一点”的结果,外部是一个流程图。由于存在Rethinking,而且整体网络结构复杂,因此确实不容易在一幅图里画的好看。。

原文将操作分为3步,分别是CNN、Rethinking、CRF推理。但是更细致的来看,可以分为5步,在CNN中分为特殊卷积、词语Attention两步,在Rethinking中,分为“memory注意力”、纵向注意力两部,最后是CRF推理。

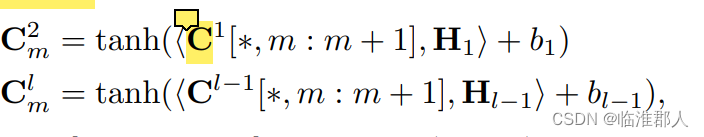

3.1 特殊卷积

特殊卷积的形式如下:

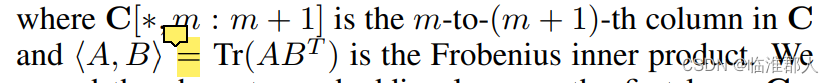

其中H是窗口大小为2的卷积核,而“卷积”具体采用的是F内积:

这里的内积得到的是一个标量,而

C

m

l

C^l_m

Cml?应该是一个

d

d

d维度的向量,因此tanh和其内部的那个

+

b

l

?

1

+b_{l-1}

+bl?1?,应该都是element-wise运算,不然维度不对了。

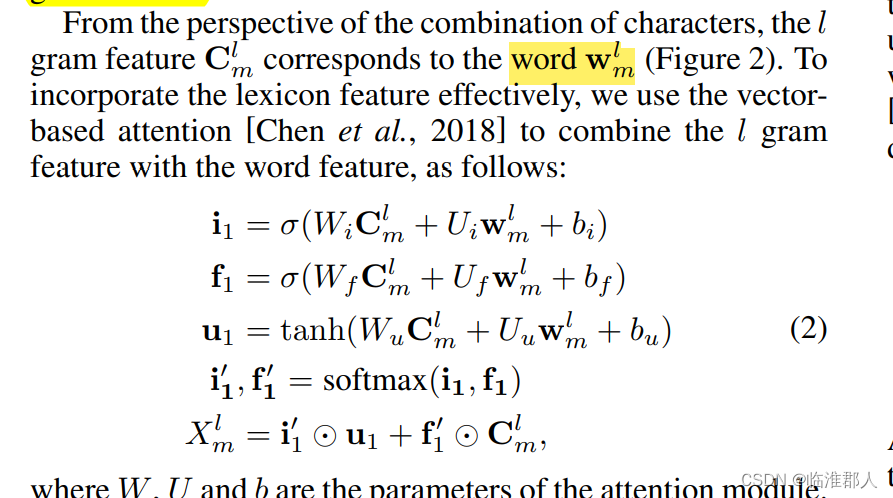

3.2 词语注意力

这里通过注意力的形式融入词语的信息

w

m

l

w^l_m

wml?,形式如下。但是问题来了,原文的

w

m

l

w_m^l

wml?表示的是

c

m

,

c

m

+

1

,

.

.

.

,

c

m

+

l

?

1

c_m,c_{m+1},...,c_{m+l-1}

cm?,cm+1?,...,cm+l?1?,显然并不是所有的

w

m

l

w^l_m

wml?都是词语,而且随着

l

l

l的增大,如果不进行padding处理,那么显然我们不能保证

w

w

w的下标还能是m。因此,这里处理的细节需要注意,而原文并没有说。

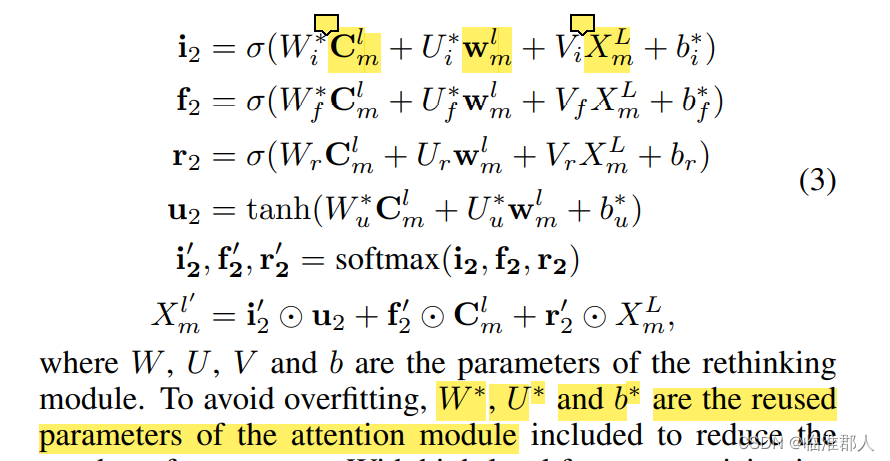

3.3 memory注意力

已经来到Rethinking步骤,由于需要反复使用 X L X^L XL的顶层特征向量,因此我称呼其为memory,而其

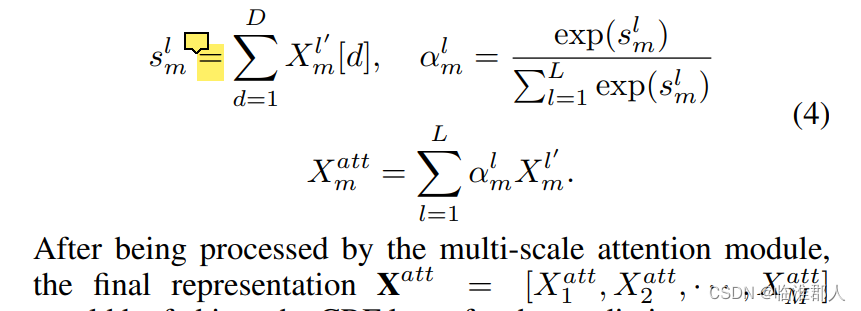

3.4 纵向注意力

原文中称呼为multi-scale feature attention。其实是把各个层次中的特征再融合一下,获得最终字符序列的总特征。

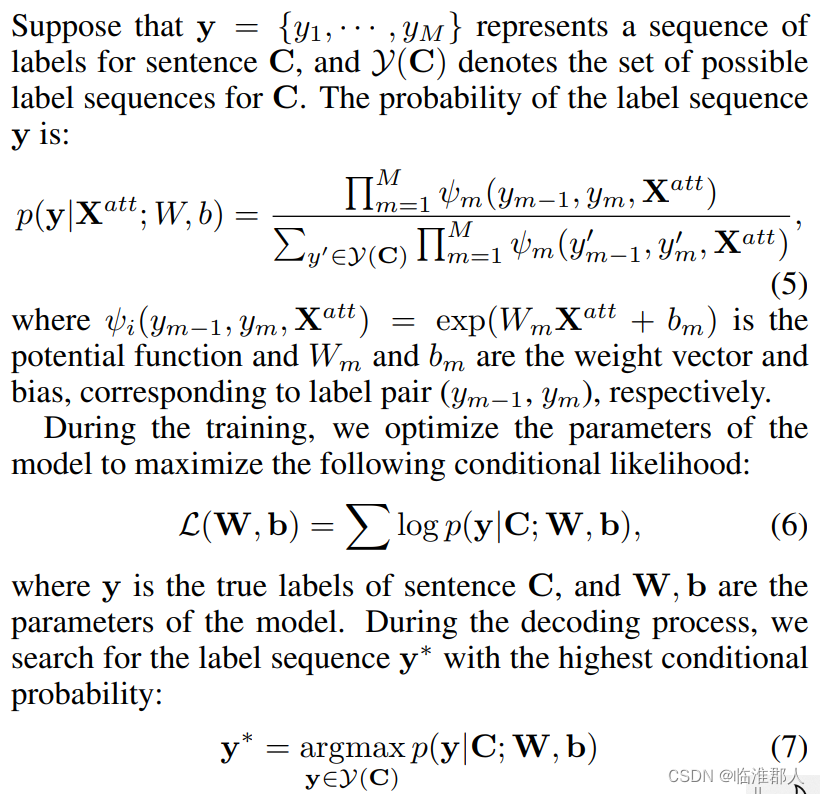

3.5 CRF

CRF推理几乎是现在的中文NER必备,这里直接把原文截图下来看看就行。包括概率分布计算、损失函数计算、推理得到结果三个部分。

4.实验

暂略