Semi-Supervised Cloud Detection in Satellite Images by Considering the Domain Shift Problem考虑区域偏移问题的卫星图像半监督云检测

0.摘要

在半监督云检测工作方面,正在努力通过有限数量的像素级标记图像和大量未标记图像学习一个有前途的云检测模型。然而,从同一卫星传感器获取的遥感图像往往会出现数据分布漂移问题,因为地球表面的云形状和陆地覆盖类型不同。因此,标记卫星图像与未标记卫星图像之间存在区域分布空白。为了解决这一问题,我们在半监督学习(SSL)网络中考虑了域转移问题。通过特征级和输出级的域适配,减小了有标记图像和无标记图像之间的域分布差距,提高了SSL网络预测结果的准确性。在Landsat-8 OLI和GF-1 WFV多光谱图像上的实验结果表明,在使用有限数量的标记样本时,所提出的半监督云检测网络(SSCDnet)能够实现有前景的云检测性能,并优于几种最先进的SSL方法。

1.概述

随着地球观测技术的发展,越来越多的光学卫星被发射用于地球观测任务。从光学卫星获取的遥感图像可以用于环境保护[1]、全球气候变化[2]、水文[3]、农业[4]、城市发展[5]和军事侦察[6]。然而,由于60%的地球表面被云层覆盖,获取的光学遥感(RS)图像经常受到云层的污染[7]。在气象领域,遥感图像的云信息在天气预报中很有用[8],而对于地表观测任务,云覆盖会降低卫星图像的质量。因此,通过云检测提高遥感图像质量至关重要。

在过去的几十年里,从遥感图像中检测云引起了人们的广泛关注。许多先进的云检测技术已经被提出。在本文中,我们将这些方法大致分为基于规则的方法和基于机器学习的方法。基于规则的方法大多是从光谱/空间域发展而来[9-12]。这些方法通过利用可见光、短波红外和热波段的反射率变化来区分云和晴空像素。基于规则的方法有明显的缺陷,即它们强烈依赖于特定的传感器模型,泛化性能较差。例如,为Sentinel-2和Landsat 4/5/7/8卫星图像开发了Fmask算法[9-11],而多特征组合(MFC)方法[12]仅为GF-1广域视图(WFV)卫星图像开发。此外,基于机器学习的云检测方法因其强大的数据适应性而备受关注。最具代表性的基于机器学习的云检测方法是最大似然[13,14]、支持向量机(SVM)[15,16]和神经网络[17,18]。然而,这些方法在很大程度上依赖于手工制作的特征,如颜色、纹理和形态特征,以区分云和晴空像素

近年来,随着深度学习的发展,深度卷积神经网络(DCNN)方法得到了快速发展,并广泛应用于遥感图像的云检测。例如,U-Net和SegNet变体云检测框架[19-23],以及多尺度/级别特征融合云检测框架[24-28]。此外,开发了先进的卷积神经网络(CNN)模型,如CDnetV2[7]和ACDnet[29],用于从云雪共存的遥感图像中检测云。为了实现实时和机载处理,提出了轻型神经网络,如[30–32],用于从遥感图像中进行像素云检测。然而,以前大多数基于CNN的云检测方法都基于监督学习框架。尽管这些基于CNN的云检测方法取得了令人印象深刻的性能,但它们严重依赖于具有强大像素注释的大量训练数据。最近的一些云检测工作,如无监督域自适应(UDA)[33,34]和域转换策略[35],已经开始探索如何避免使用像素注释进行云检测网络训练。然而,这些无像素注释的方法并不是真正的无标签方法,因为它们依赖于其他标签数据集。

获取数据标签是一项昂贵且耗时的任务,尤其是像素注释。如cityscapes数据集注释工作[36]所示,从像素大小为1024×2048的高分辨率城市场景图像中标记像素级注释通常需要1.5小时。对于像素大小为8k×8k的遥感图像,根据这种经验,可能需要更多的时间来标记整个场景的遥感图像。虽然单独标记云像素级样本更容易,但对于包含大量细云的困难情况,可能仍需要三到四个小时,这无疑增加了手动标记的高昂成本。相比之下,未标记的遥感图像比标记的图像更容易获取[37]。因此,迫切需要研究如何利用大量未标记数据来提高云检测模型的性能。

在本文中,我们提出使用半监督学习(SSL)方法[38,39]来训练云检测网络。因为SSL方法能够减少手动数据集标记的高昂成本。在半监督分割框架中,如DAN[37]和s4GAN[40],分割网络(云检测网络)能够同时利用大量未标记样本和有限数量的标记样本进行网络参数学习。SSL方法的核心是自训练[41]策略,该策略能够利用大量未标记样本生成的伪标签来监督分段网络训练[42]。这也意味着准确的伪标签标记是自训练的关键。因此,最先进的SSL方法(如[40,43])侧重于改进未标记样本的伪标签,以提高SSL网络的性能。

为传统自然图像分割开发的SSL网络,如[38–40,43],可能无法实现卫星图像云检测的良好性能,因为遥感图像不同于传统的摄像机自然图像。此外,由于不同卫星图像上的云形状和土地覆盖类型不同,在有限数量的标记样本和大量未标记样本之间可能会出现数据漂移问题。由于数据漂移问题,用标记样本训练的SSL网络很难推广到未标记样本。在训练期间,当网络输入未标记的数据时,SSL网络可能会产生确定性较低的预测结果[40]。未标记样本的预测结果具有较低的确定性,无法生成准确的伪标签,这使得自训练不利于提供网络训练的监督信号。

为了解决这个问题,我们考虑了SSL框架的域转移问题。本文受UDA方法[44]的启发,在提出的半监督云检测网络(SSCDnet)中,应用特征级[45]和输出级[46,47]的域适应来解决数据漂移问题。在本文中,我们使用了两个可用的云覆盖验证数据集,即Landsat-8 OLI (Operational Land Imager)[48]云覆盖验证数据集(https://landsat.usgs.gov/ Landsat-8 -cloud-cover-assessment-validation-data,于2022年4月24日访问)和GF-1 WFV[12]云和云阴影覆盖验证数据集(http://sendimage.whu.edu.cn/en/mfc-validation-data/, accessed on 24 April 2022),,以全面评估拟议的SSCDnet。这两个数据集被广泛用于评估基于监督cnn的云检测方法的性能[19 - 23,27]

综上所述,本文的主要贡献如下

- 我们提出了一个半监督云检测框架,名为SSCDnet,该框架从有限数量的像素级标记样本和大量的未标记样本中学习知识,用于云检测。

- 我们考虑了标记图像和未标记图像之间的域转移问题,提出了特征级和输出级的域适应方法,以减少域分布差距。

- 我们提出了一种双阈值伪标记方法来获得可信的伪标记,这有助于尽可能地避免噪声标签对自我训练的影响,进一步提高SSCDnet的性能。

2.拟议的方法

在本节中,我们详细介绍了提出的SSCDnet,包括传统的半监督分割框架、提出的SSCDnet整体工作流、特征/输出域适应、可信伪标签标注、云检测网络和鉴别器网络结构。

2.1. 传统的半监督分割框架

图1。传统的半监督分割框架。

在传统的半监督分割框架[37-40]中,如图1所示,分割网络G同时利用大量未标记样本和有限数量的标记样本对网络进行参数训练。在这个框架中,有两个数据集,分别是有标记的数据集Ml = {xl, yl}和无标记的数据集Mu = {xu},其中xl和xu是分割网络G的输入数据,yl是xl的像素级标签。pl和pu分别代表xl和xu的预测结果。p?u代表pu的伪标签。

在训练过程中,给定一个标记为图像xl的输入,分割网络G由一个标准的交叉熵损失Lce监督。当使用未标记的数据xu时,分割网络被一个自我训练的损失Lst进一步监督。即我们用预测结果pu生成的伪标签p?u作为“ground truth”进行自训练,以增强语义分割网络G。因此,分割网络G的总训练目标LG定义如下:

λst权值用于最小化目标LG。

如图2所示,不同地方的遥感图像由于地球表面云的形状和土地覆盖类型的不同,彼此之间的域分布差距较大。因此,SSL的训练数据集中有标记的样本和没有标记的样本之间存在数据漂移。在SSL框架中,由于数据漂移问题,用标记样本训练的分割网络G很难推广到未标记的样本。对于未标记样品,很难产生高度确定的预测结果。低确定性的预测结果会导致低质量的伪标签,从而影响自训练损失Lst提供的监督信号,进而影响分割网络g的性能。因此,提高未标记样本预测结果的确定性是半监督学习框架的关键。

2.2. 提出的半监督云检测框架

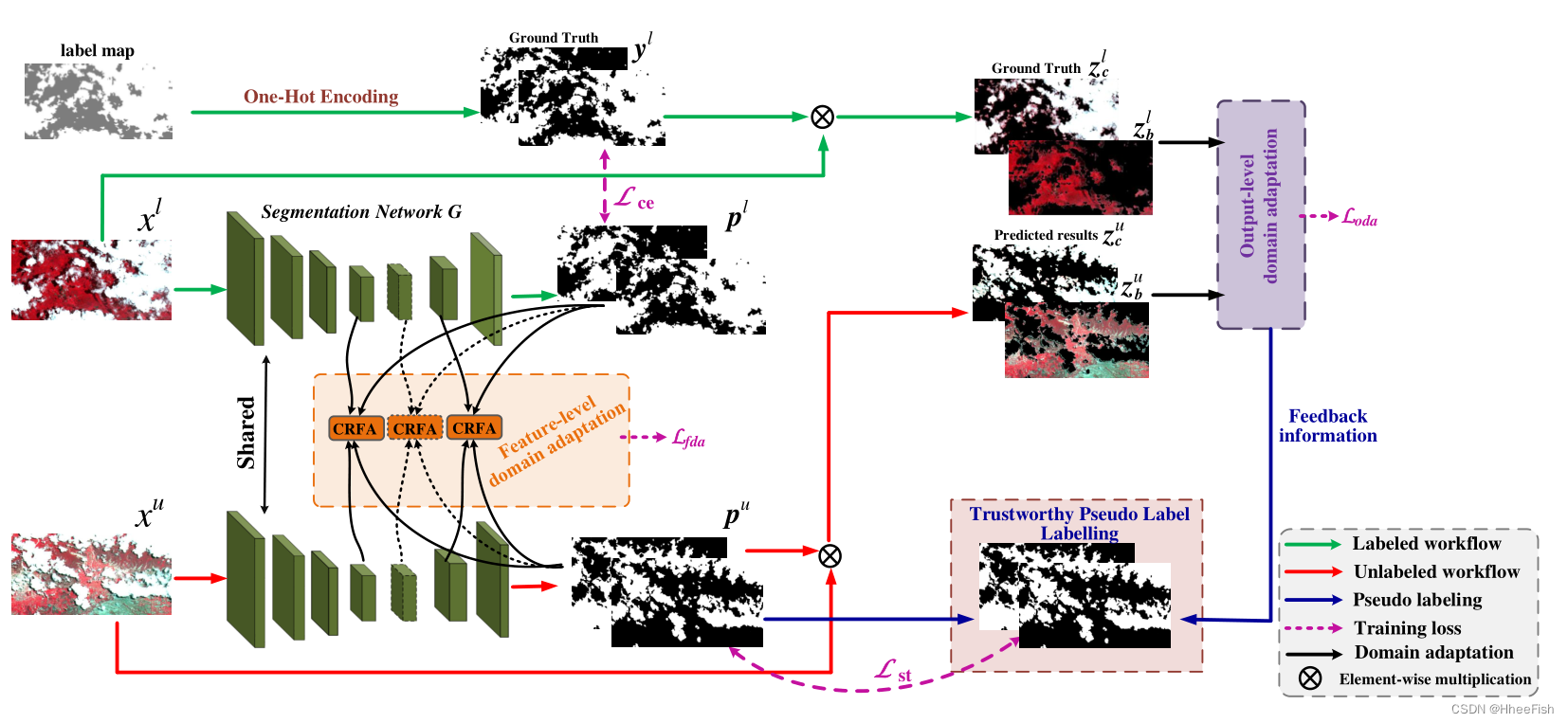

图3。拟议SSCDnet的详细结构。

在本文中,我们在半监督学习(SSL)框架中考虑了域转移问题,以提高分割网络的泛化能力,生成可信的伪标签进行自我训练。我们采用UDA策略对标准SSL网络进行改进,提出了一种改进的半监督云检测网络,如图3所示。UDA方法能够帮助语义分割网络学习不同表示层的域不变特征,如输入级(像素级)[49],特征级[45],或输出级[46,47]。

与传统的SSL框架不同,我们在网络中间层和终端层分别采用特征级和输出级域适配,以减少域分布间隙,提高SSCDnet的泛化性能。对于未标记的样本,高度泛化的网络能够产生高度确定的预测结果。为了进一步提高伪标签的质量,我们没有直接利用未标记样本的预测结果进行网络训练,而是提出了一种可信的伪标签标注方法,以获得高质量的伪标签。具体来说,类似于[40,43],我们利用outputlevel域适应的反馈信息来获得高质量的候选标签。然后,我们使用阈值策略从高质量的候选标签中获得可信区域。最后,通过自我训练损失,将可信区域作为网络训练的地面真实标签

在训练过程中,给定一个标记为xl的输入图像,其对应的预测结果为pl,云检测网络由一个标准的交叉熵损失Lce[27]监督。当输入未标记数据xu时,分割网络G预测其对应的结果pu。然后,利用所提出的可信伪标签标注方法,由预测结果pu生成伪标签p?u。伪标签p?u作为自训练的“ground truth”来增强语义分割网络g。因此,在输入未标记数据时,进一步对语义分割网络进行自训练损失Lst和特征级域适应损失Lfda以及输出级域适应损失Loda的监督。半监督云检测网络名为SSCDnet,其总损耗定义如下:

其中λst、λoda和λfda是三个调节参数,用于最小化目标LG。

在训练过程中,我们最小化LG来更新分割网络g的参数。本文提出的特征/输出级域适应策略和可信伪标签标注方法的详细信息将在下面的小节中介绍。

2.3. 缩小域分布间隙

2.3.1. 特征级的领域适应

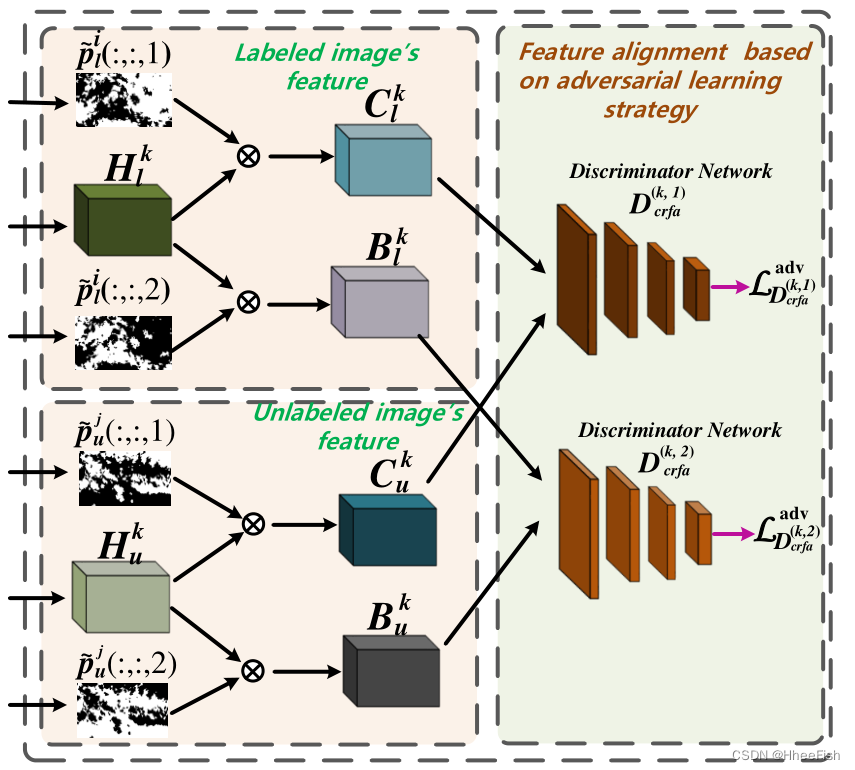

图4。提出的类相关特征对齐模块的结构。

为了减少特征层上的域分布差距,我们提出了一种类相关特征对齐(CRFA)策略。如图4所示,我们使用每个类(即云类和背景类)的预测得分图作为注意力图,获得类相关特征。然后,我们设计一个标准的二值分类网络作为判别器,帮助分割网络G生成域不变的特征表示,从而在特征层面上减少标记样本和未标记样本的域分布差距。因此,本文提出的CRFA域适应包括两个阶段:(i)类相关特征选择和(ii)类相关特征对齐。

其中Hkl∈RW×H×C和Hku∈RW×H×C分别表示从网络G的第k个中间隐含层提取的已标记样本和未标记样本的特征。p?il(:,:, 1)和p?il(:,:, 2)分别表示标记样品的云和背景区域的空间注意图。然后对被标记样本的特征Hkl∈RW×H×C的云相关特征Ckl∈RW×H×C和背景相关特征Bkl∈RW×H×C定义如下:

式中F(·)为采样算子,包括下采样算子和上采样算子。同样,我们可以获得未标记样本的特征Hku∈RW×H×C的云相关特征Ckul∈RW×H×C和背景相关特征Bku∈RW×H×C

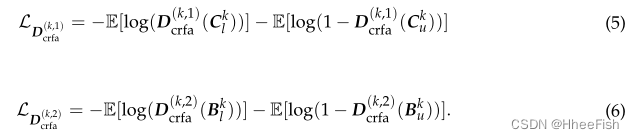

在获得这些类相关的特征之后,我们将这些特征输入到识别器中,如图4所示。对于鉴别器训练,鉴别器D(k,1)crfa和D(k,2)crfa使用领域分类交叉熵损失[44]作为目标函数。它们的定义如下:

对于分割网络训练,判别器(D(k,1)crfa和D(k,2)crfa)提供的对抗目标定义如下:

因此,第k个中间隐藏特征的类相关特征对齐损失Lkcrfa定义如下:

由于本文提出的特征级域适应是在多个中间层进行的,因此特征级域适应损失Lfda由所有中间层的CRFA损失{Lkcrfa}K k=1提供,即

式中Lkcrfa为第k个中间隐藏特征的特征域适应损失。

2.3.2. 输出级领域适应

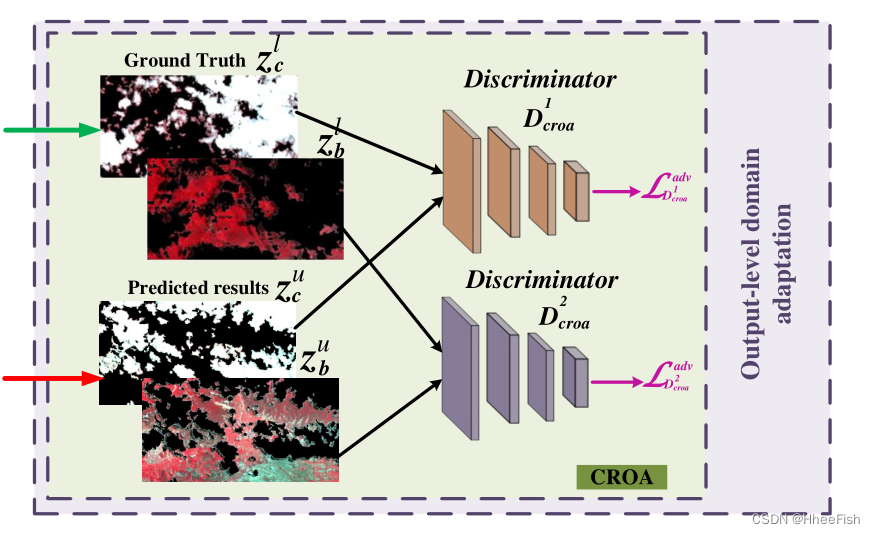

图5。拟议CROA的结构

我们不是直接对齐预测结果,而是通过提出的类相关输出对齐(CROA)方法,分别对从标记样本和未标记样本中提取的云和背景目标图像进行对齐。与CRFA方法相似,CROA方法建立在标准的对抗性学习框架上。CROA由两个鉴别器组成,分别用于对云图和背景图进行对齐。如图5所示,我们使用两个标准的二进制分类网络作为鉴别器,以减少有标记数据集和无标记数据集在输出层面的域分布差距,提高无标记样本xu预测结果zu的确定性。

如图5所示,我们使用从原始图像中提取的云和背景对象作为不同鉴别器的输入数据。其中zuc = pu(:,:, 1)?xu, zub = pu(:,:, 2)?xu表示未标记样品中提取的云和背景物。类似地,让zlc = pl(:,:, 1)?xl和zlb = pl(:,:, 2)?xl表示已标记样本中提取的云和背景对象,其中?表示逐像素乘法。

在鉴别器训练中,鉴别器D1croa和D2croa都以交叉熵域分类损失[44]为目标函数。鉴别器损失定义如下:

对于分割网络训练,这些鉴别器提供的对抗目标定义如下:

因此,输出级域适应目标Loda定义如下:

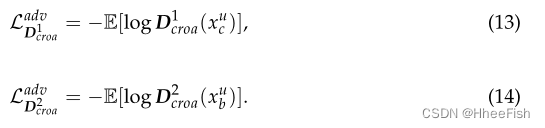

如图6所示,我们在GF-1 WFV图像上展示了应用或不应用域适应的可视化实验结果。结果表明,应用域适应能够改进分割网络,对未标记样本产生较高的确定性预测结果,如图6c所示。较高的确定性预测结果保证了我们能够获得可信的伪标签进行自我训练,从而提高了网络的云检测性能。更详细的信息可以在章节4.1(消融研究)中找到。

图6。未标记遥感图像的实验结果。(a)输入GF-1 WFV图像;(b)未应用的域适应结果;?应用的域适应结果。

2.4. 可信赖的伪标签生成

伪标签标签是SSL框架中自我训练的主要工作[38 - 40,43,50]。在自我训练过程中,分割模型预测的伪标签作为“ground truth”,为网络训练提供额外的监督信号,这使得分割网络能够利用未标记的数据。本文提出了一种双阈值伪标记方法,可以有效地从伪标记中获取可信区域。我们使用可信区域作为网络训练的地面真相。

2.4.1. 候选标签选择

图7。用于自我训练的双阈值伪标记方法。

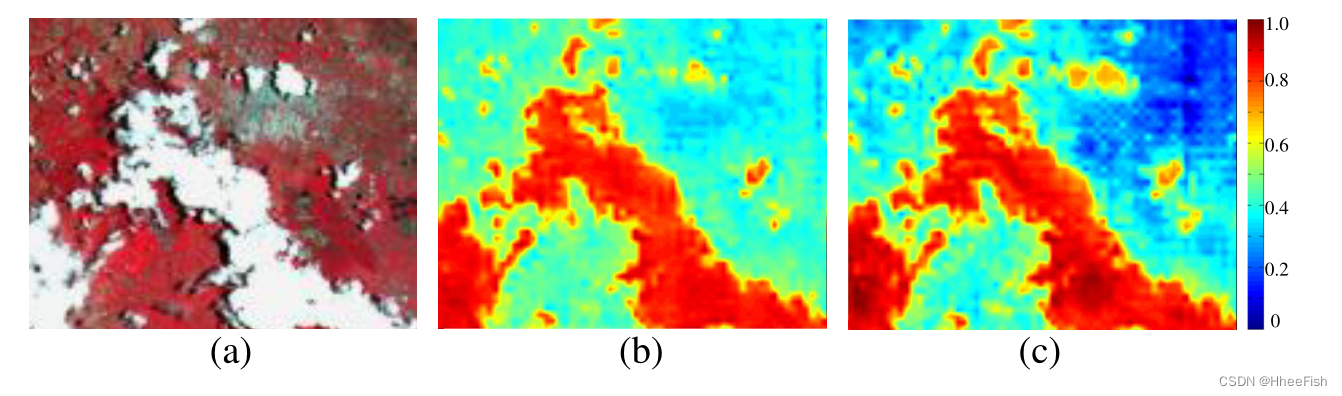

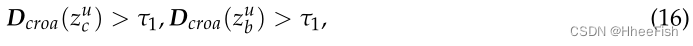

如图7所示,我们将未标记的图像xu采样到分割网络G中,得到其对应的预测概率图pu = G(xu),以及提取的云和背景对象zuc和zub。我们首先使用来自输出级域适应的反馈信息来获得候选标签。具体来说,我们基于输出级域适应的两个鉴别器得分在线选择高质量的伪标签,即

其中τ1为临界值。式(16)为输出级域适应反馈信息。我们将满足式(16)的这些预测标签作为候选标签。如果不满意,直接设自我训练损失Lst = 0。

2.4.2. 从候选标签中选择可信区域

在获得候选标签后,我们设置一个置信阈值τ2来发现可信区域,即:

公式(17)表明,如果这些区域的预测概率大于τ2,我们将这些可信区域作为自训练的基础真值

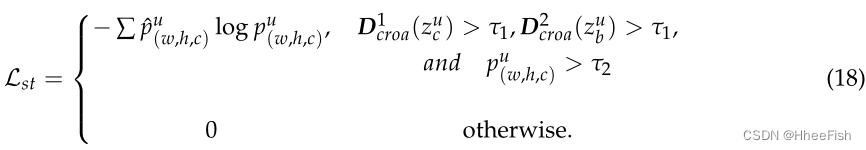

2.4.3. 自我训练Lst损失

根据上述方法,定义自训练损失Lst为:

其中p?u是通过使用独热编码方案从预测映射pu生成的伪标签。pu(w,h,c)表示c通道(h,w)位置的预测概率。

2.5.网络架构

2.5.1. 云检测网络

与大多数SSL方法相似[40,43],我们使用DeepLabv2[51]作为我们的主云检测框架,并以ResNet-101[52]为骨干提取语义分割信息。DeepLabv2使用atrous空间金字塔池化(ASPP)模块[51],该模块融合了多个不同采样率的并行扩展卷积层[53],以捕获多尺度特征,实现鲁棒性云检测。在本文中,我们将预测概率图的分辨率设为输入图像的1/8 × 1/8大小,以便与之前基于DeepLabv2的半监督作品(如[37,40])进行公平的比较。然后,我们直接上采样预测概率映射到与输入图像相同的大小,以获得最终的预测结果。

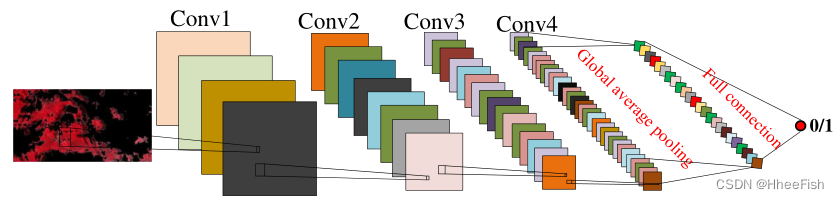

2.5.2. 鉴别器网络

在本文中,我们设计了一个标准的二进制分类网络作为CRFA和CROA模块的鉴别器。图8说明了设计的鉴别器的详细结构。该鉴别器包含四个卷积层、一个全局平均池化层和一个全连接层。具体来说,卷积层有4 × 4个核。CRFA和CROA模块的4个卷积层的通道分别为{256,192,128,64}和{64,128,256,512}。每个卷积层共享相同的步幅(stride = 2),同时有一个Leaky-ReLU激活(slope = 0.2)和一个dropout层(dropout-rate = 0.5)。经过这些卷积运算后,设计一个全局平均池化层和一个全连接层,对每个输入图像进行置信度评分。

图8。提出的鉴别器网络结构

3.实验

3.1.网络训练设置

SSCDnet在PyTorch框架下进行培训(https://pytorch.org/,于2022年4月24日访问)。操作系统为Ubuntu 14.04,搭载NVIDIA GTX 1080 Ti GPU。我们分别使用SGD算法[55]和Adam优化器[56]对分割(发生器)和鉴别器网络进行优化。在训练过程中,这两个数据集共享以下参数设置。即生成器和鉴别器网络的学习率分别为2.5 × 10?4和1 × 10?4。训练衰减策略是“poly”[57]。小批量大小、动量和重量衰减数分别为4、0.9和5 × 10?4。SSCDnet分别在Landsat-8 OLI和GF-1 WFV数据集上训练20和15个epoch

此外,为了提高性能,我们使用在ImageNet数据集[58]上预训练的模型来微调骨干网(ResNet-101)的参数。我们在Conv4_x和Conv5_x残差块K = 2的末尾进行特征级域适应任务。我们对GF-1数据集设置权重参数λst = 1.0, λfda = 0.001, λoda = 0.1,对Landsat-8 OLI数据集设置权重参数λst = 1.0, λfda = 0.001, λoda = 0.01。此外,我们通过经验设置阈值参数τ1 = 0.6和τ2 = 0.55对GF-1和Landsat-8 OLI数据集都能准确地生成可信的伪标签。

3.2.消融实验

3.2.1.损失函数的消融

表2:GF-1 WFV数据上不同消融网络的云提取精度(%)。其中1/200、1/100、1/40和1/20是数据集中用作标签数据的总训练图像的部分,其余的数据没有标签。粗体表示本文中的最大值。

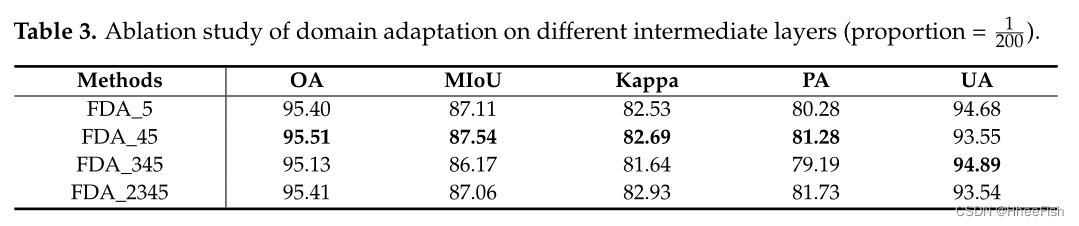

3.2.2.特征层数的消融

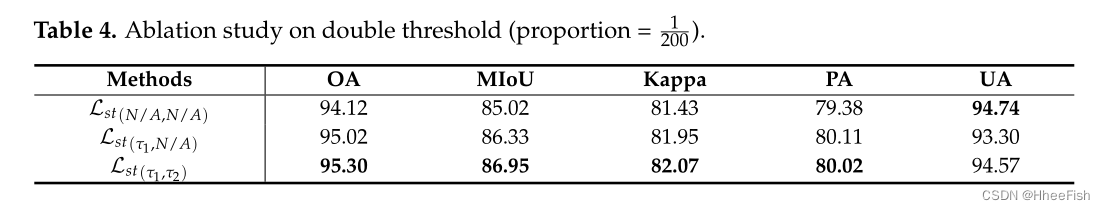

3.2.3.阈值的消融

3.2.4.超参数的分析

3.3.与其他先进方法的对比

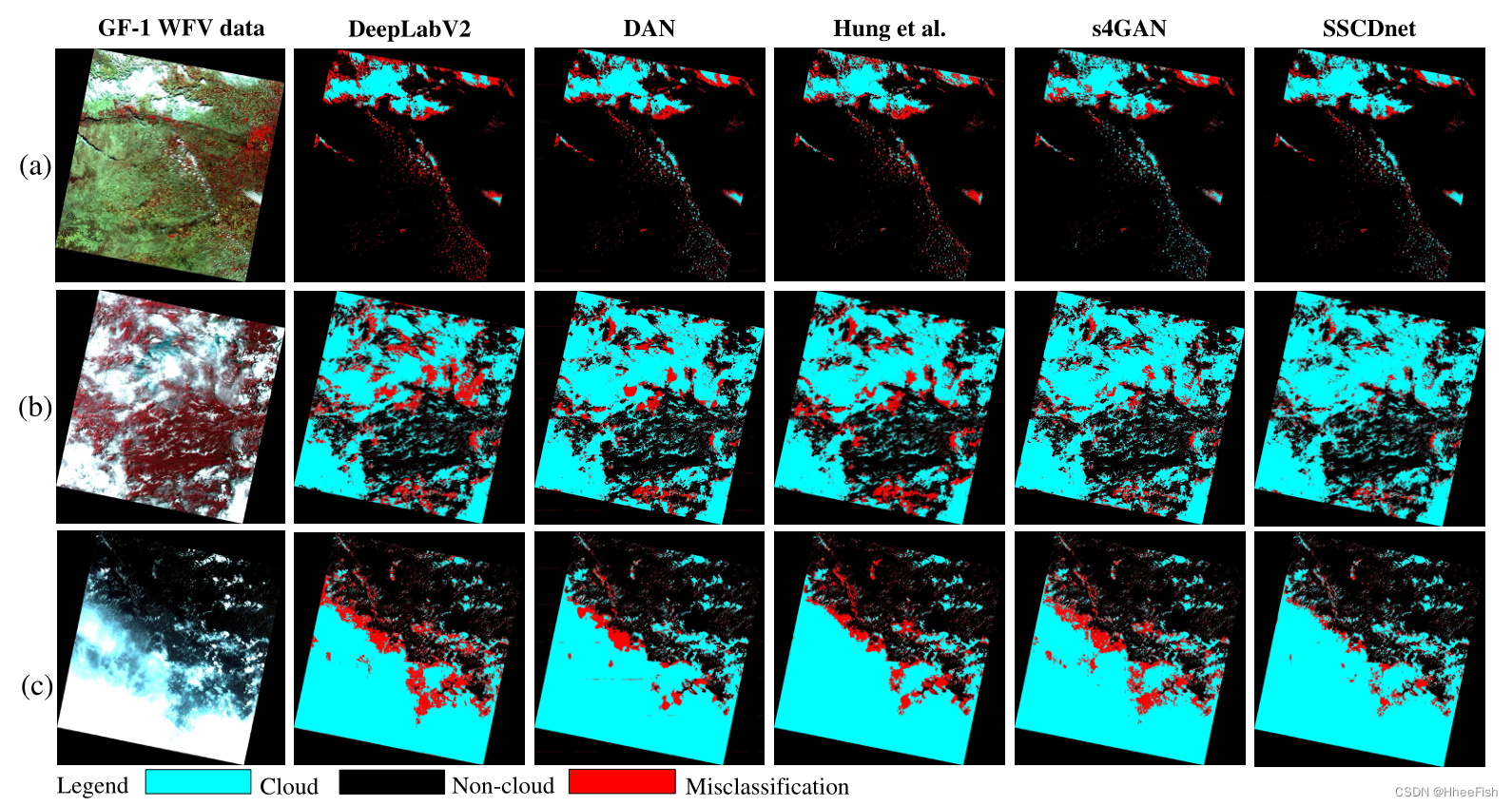

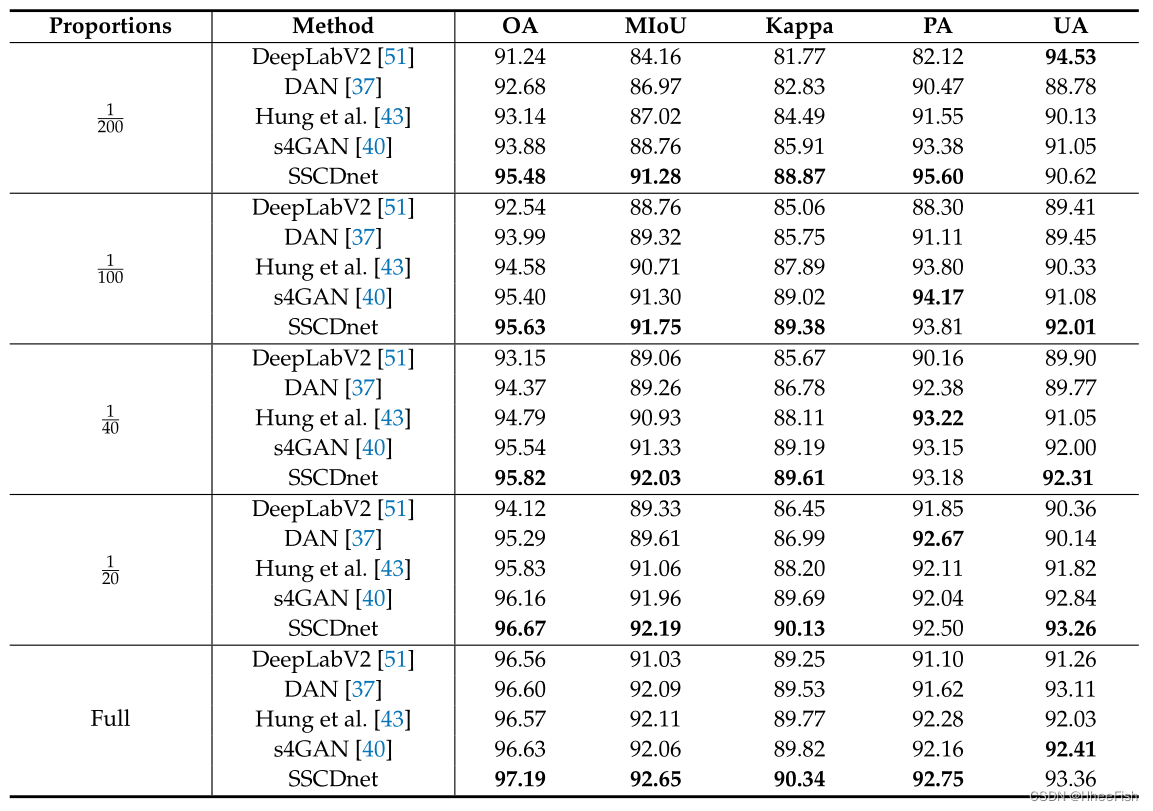

Table6。不同比较网络对GF-1 WFV数据的云提取精度(%)。所有结果都是所有测试图像的平均结果。

表7。Landsat-8 OLI数据上不同比较网络的云提取精度(%)。所有结果均为所有测试图像的平均结果。

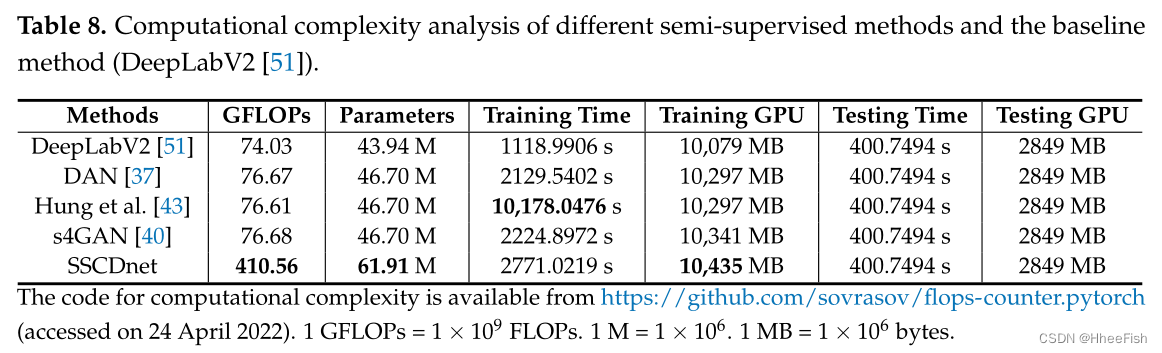

3.4.计算复杂度分析

参考文献

- Zhao, S.; Wang, Q.; Li, Y .; Liu, S.; Wang, Z.; Zhu, L.; Wang, Z. An overview of satellite remote sensing technology used in China’s environmental protection. Earth Sci. Inform. 2017, 10, 137–148. [CrossRef]

- Yang, J.; Gong, P .; Fu, R.; Zhang, M.; Chen, J.; Liang, S.; Xu, B.; Shi, J.; Dickinson, R. The role of satellite remote sensing in climate change studies. Nat. Clim. Chang. 2013, 3, 875–883. [CrossRef]

- Schmugge, T.J.; Kustas, W.P .; Ritchie, J.C.; Jackson, T.J.; Rango, A. Remote sensing in hydrology . Adv. Water Resour. 2002, 25, 1367–1385. [CrossRef]

- Shanmugapriya, P .; Rathika, S.; Ramesh, T.; Janaki, P . Applications of remote sensing in agriculture—A Review. Int. J. Curr.

Microbiol. Appl. Sci. 2019, 8, 2270–2283. [CrossRef] - Kabisch, N.; Selsam, P .; Kirsten, T.; Lausch, A.; Bumberger, J. A multi-sensor and multi-temporal remote sensing approach to detect land cover change dynamics in heterogeneous urban landscapes. Ecol. Indic. 2019, 99, 273–282. [CrossRef]

- Bachagha, N.; Wang, X.; Luo, L.; Li, L.; Khatteli, H.; Lasaponara, R. Remote sensing and GIS techniques for reconstructing the military fort system on the Roman boundary (Tunisian section) and identifying archaeological sites. Remote Sens. Environ. 2020, 236, 111418. [CrossRef]

- Guo, J.; Yang, J.; Yue, H.; Tan, H.; Hou, C.; Li, K. CDnetV2: CNN-Based Cloud Detection for Remote Sensing Imagery with Cloud-Snow Coexistence. IEEE T rans. Geosci. Remote Sens. 2020, 59, 700–713. [CrossRef]

- Sliwa, B.; Falkenberg, R.; Liebig, T.; Piatkowski, N.; Wietfeld, C. Boosting vehicle-to-cloud communication by machine learningenabled context prediction. IEEE T rans. Intell. T ransp. Syst. 2019, 21, 3497–3512. [CrossRef]

- Zhu, Z.; Wang, S.; Woodcock, C.E. Improvement and expansion of the Fmask algorithm: Cloud, cloud shadow, and snow detection for Landsats 4–7. 8, and Sentinel 2 images. Remote Sens. Environ. 2015, 159, 269–277. [CrossRef]

- Qiu, S.; He, B.; Zhu, Z.; Liao, Z.; Quan, X. Improving Fmask cloud and cloud shadow detection in mountainous area for Landsats-8 images. Remote Sens. Environ. 2017, 199, 107–119. [CrossRef]

- Qiu, S.; Zhu, Z.; He, B. Fmask 4.0: Improved cloud and cloud shadow detection in Landsats 4–8 and Sentinel-2 imagery . Remote Sens. Environ. 2019, 231, 111205. [CrossRef]

- Li, Z.; Shen, H.; Li, H.; Xia, G.; Gamba, P .; Zhang, L. Multi-feature combined cloud and cloud shadow detection in GaoFen-1 wide field of view imagery. Remote Sens. Environ. 2017, 191, 342–358. [CrossRef]

- Alonso-Montesinos, J.; Martínez-Durbán, M.; del Sagrado, J.; del águila, I.; Batlles, F. The application of Bayesian network classifiers to cloud classification in satellite images. Renew. Energy 2016, 97, 155–161. [CrossRef]

- Xu, L.; Wong, A.; Clausi, D.A. A novel Bayesian spatial–temporal random field model applied to cloud detection from remotely sensed imagery . IEEE T rans. Geosci. Remote Sens. 2017, 55, 4913–4924. [CrossRef]

- Latry , C.; Panem, C.; Dejean, P . Cloud detection with SVM technique. In Proceedings of the 2007 IEEE International Geoscience and Remote Sensing Symposium, Barcelona, Spain, 23–27 July 2007; pp. 448–451.

- Ishida, H.; Oishi, Y .; Morita, K.; Moriwaki, K.; Nakajima, T.Y . Development of a support vector machine based cloud detection method for MODIS with the adjustability to various conditions. Remote Sens. Environ. 2018, 205, 390–407. [CrossRef]

- Hughes, M.J.; Hayes, D.J. Automated detection of cloud and cloud shadow in single-date Landsat imagery using neural networks and spatial post-processing. Remote Sens. 2014, 6, 4907–4926. [CrossRef]

- Jang, J.d.; Viau, A.A.; Anctil, F.; Bartholomé, E. Neural network application for cloud detection in SPOT VEGETATION images.

Int. J. Remote Sens. 2006, 27, 719–736. [CrossRef] - Jeppesen, J.H.; Jacobsen, R.H.; Inceoglu, F.; Toftegaard, T.S. A cloud detection algorithm for satellite imagery based on deep learning. Remote Sens. Environ. 2019, 229, 247–259. [CrossRef]

- Wieland, M.; Li, Y .; Martinis, S. Multi-sensor cloud and cloud shadow segmentation with a convolutional neural network. Remote Sens. Environ. 2019, 230, 111203. [CrossRef]

- Chai, D.; Newsam, S.; Zhang, H.K.; Qiu, Y .; Huang, J. Cloud and cloud shadow detection in Landsat imagery based on deep convolutional neural networks. Remote Sens. Environ. 2019, 225, 307–316. [CrossRef]

- Dr?nner, J.; Korfhage, N.; Egli, S.; Mühling, M.; Thies, B.; Bendix, J.; Freisleben, B.; Seeger, B. Fast cloud segmentation using convolutional neural networks. Remote Sens. 2018, 10, 1782. [CrossRef]

- Lopez, J.; Santos, S.; Atzberger, C.; Torres, D. Convolutional Neural Networks for Semantic Segmentation of Multispectral Remote Sensing Images. In Proceedings of the 2018 IEEE 10th Latin-American Conference on Communications (LATINCOM), Guadalajara, Mexico, 14–16 November 2018; pp. 1–5.

- Zhan, Y .; Wang, J.; Shi, J.; Cheng, G.; Yao, L.; Sun, W. Distinguishing cloud and snow in satellite images via deep convolutional network. IEEE Geosci. Remote Sens. Lett. 2017, 14, 1785–1789. [CrossRef]

- Morales, G.; Huamán, S.G.; Telles, J. Cloud Detection in High-Resolution Multispectral Satellite Imagery Using Deep Learning.

In Proceedings of the International Conference on Artificial Neural Networks, Rhodes, Greece, 4–7 October 2018; pp. 280–288. - Li, Z.; Shen, H.; Cheng, Q.; Liu, Y .; You, S.; He, Z. Deep learning based cloud detection for medium and high resolution remote sensing images of different sensors. ISPRS J. Photogramm. Remote Sens. 2019, 150, 197–212. [CrossRef]

- Yang, J.; Guo, J.; Yue, H.; Liu, Z.; Hu, H.; Li, K. CDnet: CNN-Based Cloud Detection for Remote Sensing Imagery . IEEE T rans.

Geosci. Remote Sens. 2019, 57, 6195–6211. [CrossRef] - Shao, Z.; Pan, Y .; Diao, C.; Cai, J. Cloud Detection in Remote Sensing Images Based on Multiscale Features-Convolutional Neural Network. IEEE T rans. Geosci. Remote Sens. 2019, 57, 4062–4076. [CrossRef]

- Chen, Y .; W eng, Q.; T ang, L.; Liu, Q.; Fan, R. An Automatic Cloud Detection Neural Network for High-Resolution Remote Sensing Imagery With Cloud–Snow Coexistence. IEEE Geosci. Remote Sens. Lett. 2022, 19, 6004205. [CrossRef]

- Zhang, Z.; Iwasaki, A.; Xu, G.; Song, J. Cloud detection on small satellites based on lightweight U-net and image compression. J.

Appl. Remote Sens. 2019, 13, 026502. [CrossRef] - Zhang, J.; Li, X.; Li, L.; Sun, P .; Su, X.; Hu, T.; Chen, F. Lightweight U-Net for cloud detection of visible and thermal infrared remote sensing images. Opt. Quantum Electron. 2020, 52, 397. [CrossRef]

- Li, J.; Wu, Z.; Hu, Z.; Jian, C.; Luo, S.; Mou, L.; Zhu, X.X.; Molinier, M. A Lightweight Deep Learning-Based Cloud Detection Method for Sentinel-2A Imagery Fusing Multiscale Spectral and Spatial Features. IEEE T rans. Geosci. Remote Sens. 2021, 60, 1–19.

[CrossRef] - Guo, J.; Yang, J.; Yue, H.; Li, K. Unsupervised Domain Adaptation for Cloud Detection Based on Grouped Features Alignment and Entropy Minimization. IEEE T rans. Geosci. Remote Sens. 2021, 1–13. [CrossRef]

- Guo, J.; Yang, J.; Yue, H.; Liu, X.; Li, K. Unsupervised Domain-Invariant Feature Learning for Cloud Detection of Remote Sensing Images. IEEE T rans. Geosci. Remote Sens. 2022, 60, 5405715. [CrossRef]

- Guo, J.; Yang, J.; Yue, H.; Chen, Y .; Hou, C.; Li, K. Cloud Detection From Remote Sensing Imagery Based on Domain Translation Network. IEEE Geosci. Remote Sens. Lett. 2022, 19, 5000805. [CrossRef]

- Cordts, M.; Omran, M.; Ramos, S.; Rehfeld, T. The Cityscapes Dataset for Semantic Urban Scene Understanding. arXiv 2016, arXiv:1604.01685.

- Zhang, Y .; Yang, L.; Chen, J.; Fredericksen, M.; Hughes, D.P .; Chen, D.Z. Deep Adversarial Networks for Biomedical Image Segmentation Utilizing Unannotated Images. In Proceedings of the Medical Image Computing and Computer Assisted Intervention (MICCAI 2017), Quebec City , QC, Canada, 11–13 September 2017; pp. 408–416.

- Hong, S.; Noh, H.; Han, B. Decoupled Deep Neural Network for Semi-supervised Semantic Segmentation. arXiv 2015, arXiv:1506.04924.

- Mostafa S, I.; Arash, V .; Mani, R.; William G, M. Semi-Supervised Semantic Image Segmentation with Self-correcting Networks.

arXiv 2020, arXiv:1811.07073. - Mittal, S.; Maxim, T.; Thomas, B. Semi-Supervised Semantic Segmentation with High- and Low-level Consistency . IEEE T rans.

Pattern Anal. Mach. Intell. 2021, 43, 1369–1379. [CrossRef]

[PubMed] - Massih-Reza, A.; Vasilii, F.; Loic, P .; Emilie, D.; Yury , M. Self-Training: A Survey . arXiv 2022, arXiv:2202.12040.

- Rajat, R.; Alexis, B.; Honglak, L.; Benjamin, P .; Andrew, Y .N. Self-taught learning: Transfer learning from unlabeled data. In Proceedings of the Twenty-fourth International Conference on Machine Learning, Corvalis, OR, USA, 20–24 June 2007.

- Hung, W.; Tsai, Y .; Liou, Y .; Lin, Y .Y .; Yang, M.H. Adversarial Learning for Semi-Supervised Semantic Segmentation. arXiv 2018, arXiv:1802.07934.

- Goodfellow, I.; Pouget-Abadie, J.; Mirza, M.; Xu, B.; Warde-Farley , D.; Ozair, S.; Courville, A.; Bengio, Y . Generative adversarial networks. In Proceedings of the Advances in Neural Information Processing Systems, Montreal, QC, Canada, 8–13 December 2014; pp. 2672–2680.

- Ren, Z.; Lee, Y .J. Cross-Domain Self-Supervised Multi-task Feature Learning Using Synthetic Imagery . In Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City , UT, USA, 18–22 June 2018; pp. 762–771.

- Tuan-Hung, V .; Himalaya, J.; Maxime, B.; Matthieu, C.; Patrick, P . ADVENT: Adversarial Entropy Minimization for Domain Adaptation in Semantic Segmentation. arXiv 2019, arXiv:1811.12833.

- Tsai, Y .; Sohn, K.; Schulter, S.; Chandraker, M. Domain Adaptation for Structured Output via Discriminative Patch Representations.

In Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision, Seoul, Korea, 27 October–2 November 2019; pp. 1456–1465. - Foga, S.; Scaramuzza, P .L.; Guo, S.; Zhu, Z.; Dilley , R.D., Jr.; Beckmann, T.; Schmidt, G.L.; Dwyer, J.L.; Hughes, M.J.; Laue, B. Cloud detection algorithm comparison and validation for operational Landsat data products. Remote Sens. Environ. 2017, 194, 379–390. [CrossRef]

- Chen, Y .; Lin, Y .; Yang, M.; Huang, J. CrDoCo: Pixel-Level Domain Transfer With Cross-Domain Consistency . In Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, CA, USA, 16–20 June 2019; pp. 1791–1800.

- Souly , N.; Spampinato, C.; Shah, M. Semi Supervised Semantic Segmentation Using Generative Adversarial Network. In Proceedings of the 2017 IEEE International Conference on Computer Vision (ICCV), V enice, Italy , 22–29 October 2017; pp. 5689–5697.

- Chen, L.; Papandreou, G.; Kokkinos, I.; Murphy, K.; Yuille, A.L. DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs. IEEE T rans. Pattern Anal. Mach. Intell. 2018, 40, 834–848. [CrossRef]

[PubMed] - He, K.; Zhang, X.; Ren, S.; Sun, J. Deep Residual Learning for Image Recognition. In Proceedings of the The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las V egas, NV , USA, 27–30 June 2016.

- Yu, F.; Koltun, V . Multi-Scale Context Aggregation by Dilated Convolutions. arXiv 2016, arXiv:1511.07122.

- Geirhos, R.; Rubisch, P .; Michaelis, C.; Bethge, M.; Wichmann, F.A.; Brendel, W. ImageNet-trained CNNs are biased towards texture; increasing shape bias improves accuracy and robustness. arXiv 2018, arXiv:1811.12231.

- Bengio, Y . Practical recommendations for gradient-based training of deep architectures. In Neural Networks: T ricks of the T rade; Springer: Berlin/Heidelberg, Germany , 2012; pp. 437–478.

- Kingma, D.; Ba, J. Adam: A Method for Stochastic Optimization. arXiv 2014, arXiv:1412.6980v9.

- Chen, L.C.; Papandreou, G.; Schroff, F.; Adam, H. Rethinking atrous convolution for semantic image segmentation. arXiv 2017, arXiv:1706.05587.

- Russakovsky , O.; Deng, J.; Su, H.; Krause, J.; Satheesh, S.; Ma, S.; Huang, Z.; Karpathy , A.; Khosla, A.; Bernstein, M.; et al.

Imagenet large scale visual recognition challenge. Int. J. Comput. Vis. 2015, 115, 211–252. [CrossRef] - Everingham, M.; Van Gool, L.; Williams, C.K.I.; Winn, J.; Zisserman, A. The PASCAL Visual Object Classes Challenge 2012 (VOC2012) Results. Available online: http://host.robots.ox.ac.uk/pascal/VOC/voc2012/ (accessed on 24 April 2022).