目录

- 课程概述

- Lecture 1-5 Supervised Learning

- Lecture 7 Self-supervised Learning

- Lecture 6 Generative Adversarial Network

- Lecture 12 Reinforcement Learning

- Lecture 8 Anomaly Dectection 异常检测

- Lecture 9 Explainable AI

- Lecture 10 Model Attack 模型攻击

- Lecture 11 Domain Adaptation

- Lecture 13 Network Compression

- Lecture 14 Life-long Learning

- Lecture 15 Meta Learning(亦称 Few-shot learning)

课程概述

本专栏将开启李宏毅老师机器学习深度学习的课程学习,课程不仅用于自我记录,也希望能帮到更多志同道合的朋友,ok,废话少说,直接开始。

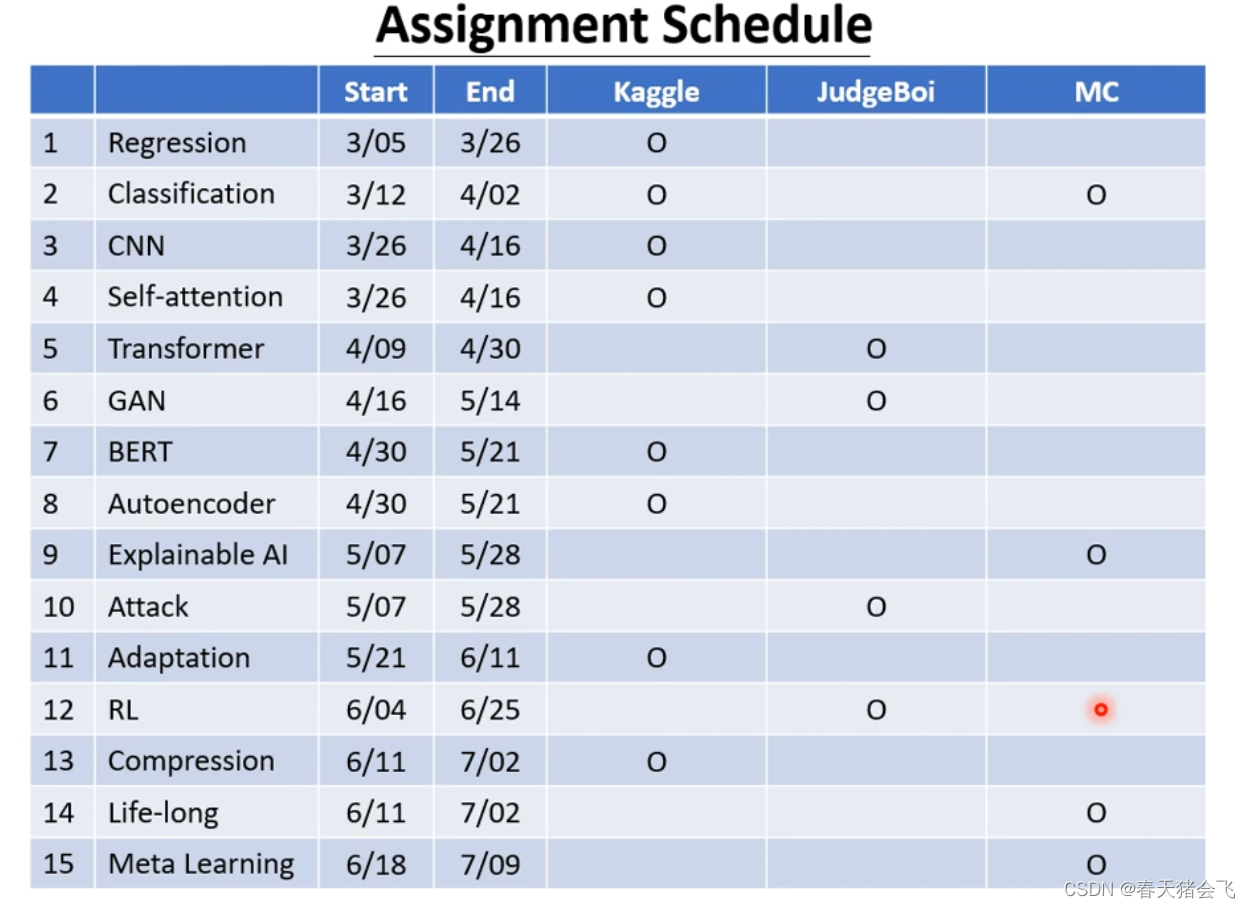

课程将总共划分为15讲,以下罗列的顺序按照李老师讲课顺序排列。

综述:

Machine Learning ≈ Looking for Function 也即寻找到一个只靠人力很难找到的函数

它的输入可以是向量、矩阵和序列,而经过函数处理后,可以得到一个标量,或者做到分类,甚至翻译等。

Lecture 1-5 Supervised Learning

Lecture 7 Self-supervised Learning

区别:相比较Supervised Learning 有一个明显的不同是,增加了pre-trained Model(预训练模型,典型的有Bert等),当经过训练后,遇到真正需要解决的任务(也称为 Downstream Tasks 下游任务)即可达到不错的解决效果。

李老师提到,pre-trained Model 和 Downstream Tasks就类比于OS与其Applications

注:pre-trained Model 亦称为 Foundation Model

Lecture 6 Generative Adversarial Network

不需要我们标注x1对应y1这样的关系,而是可以自动寻找关联的一种解决方案

Lecture 12 Reinforcement Learning

不知道如何标记时,只知道怎样定义成功时的一种解决方案

如:下围棋

Lecture 8 Anomaly Dectection 异常检测

即让机器回答:我不知道

Lecture 9 Explainable AI

让机器能解释自己的选择与输出

Lecture 10 Model Attack 模型攻击

李老师给了一张猫的两个图片,其中一张被识别为猫,另一张识别为海星,区别就在于第二张只是加了一点小小的杂点,为什么出现这样的现象,如何解决,这一节将会讲述

Lecture 11 Domain Adaptation

训练数据与测试数据极为相似,在测试数据上也能表现很好,但是换了新数据却正确率暴跌,为什么出现这样的现象以及如何解决?本节给出答案

Lecture 13 Network Compression

当运算资源有限的时候,很难在一些设备(如手表,无人机等)上跑巨大的模型,如何解决?

Lecture 14 Life-long Learning

为什么没有办法让机器不断学习不断进化?

Lecture 15 Meta Learning(亦称 Few-shot learning)

即机器如何自己学习,仅依靠少量数据便可自动获得演算算法