目录

第八章? ? ? ? 深度置信网络

8.1? ? ? ? 深度置信网络介绍

深度置信网络:神经网络的一种。本质是特征的过程,即如何得到更好的特征表达。既可用于非监督学习,尽可能保留原始特征的特点,降低特征的维度,类似一个自编码器;也可用于监督学习,使得分类错误率尽可能地小,作为分类器。

玻尔兹曼机:学习一种数据的内在表示。

特点:每个随机变量都是二值的(0或1);所有节点是全连接的;两个节点之间的相互影响是对称的。训练时间长

受限玻尔兹曼机:层内的神经元无连接关系,只有两层。

深度置信网络的训练法则:逐层进行,每一层都用用户数量来推断隐层,再把这个隐层作为数据向量来推断下一个隐层。最顶层两层连接是无向的,多个受限玻尔兹曼机连接形成深度置信网络。

第九章? ? ? ? 卷积神经网络

9.1? ? ? ? 卷积神经网络回顾

CNN:分为卷积层(特征提取),去除冗余信息,保留显著特征;池化层(降低特征图参数量和解决图像不变性等);全连接层(将特征图映射为向量,以便分类)。广泛应用于人工智能特别是计算机视觉的主要原因是卷积神经网络具有高精确度与自动提取的优点。

核心思想:参数共享和局部感知。时域卷积=频域相乘。

9.2????????经典CNN网络

AlexNet:ReLU代替Sigmoid激活函数,实现快速收敛;重叠的Pooling:stride<kernel size,减轻过拟合;数据增强:原始图像(256*256)随机剪裁为224*224的图像;图像水平单转;随机增加光照,防止过拟合;Dropout:每个隐藏层神经元的输入以0.5的概率输出为0,防止过拟合。

VGGNet:使用简单的3*3卷积核,不断重复卷积层,池化,最后经过全连接、softmax,得到输出类别概率。

GoogleNet:用更多的卷积,更深的层次可以得到更好的结构。

Inception结构

RrsNet:设计的残差结构防止训练时的梯度消失。

SENet:子结构,可嵌入到其他网络结构中.

第十章? ? ? ? 循环神经网络

10.1? ? ? ? 循环神经网络回顾

前馈神经网络的缺点:连接只存在于层与层之间,每一层中的节点无连接关系;每次的输入是独立的,分割了前后数据之间的联系·;输入和输出的维度是固定的,无法处理变长数据。

标准RNN结构的问题:解决了信息记忆的问题,但是对长时间记忆的信息会衰减。基本的循环神经网络存在梯度爆炸和梯度消失问题,不能真正的处理好长距离的依赖。

10.2??????? RNN变种

长短期记忆网络(LSTM):一种特殊的RNN类型,可以学习长期依赖信息。

GRU:简化的LSTM,因为LSTM终,遗忘门与输入门的关系互补,所以GRU用一个门代替。

在LSTM中引入了三个门函数:输入门、遗忘门和输出门来控制输入值、记忆值和输出值。而在GRU模型中只有两个门:更新门和重置门。

ResNet-经典卷积神经网络

?

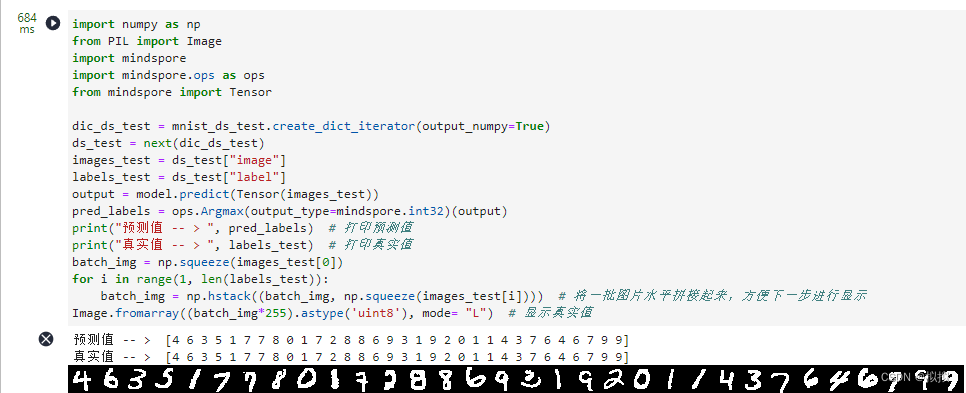

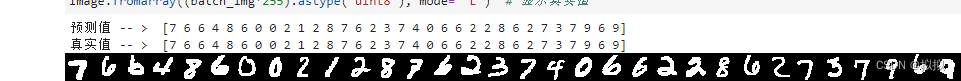

?从多次预测结果中得出,64张图片均为预测出错,说明模型的预测效果较好。