Abstract&Introduction&Related Work

- 研究任务

大规模端到端弱监督Visual Language Model - 已有方法和相关工作

- 面临挑战标注数据的规模有限,为了提高性能,引入了各种特定于任务的辅助损失,这些设计选择使VLP的预训练范式复杂化,为进一步提高质量造成了瓶颈

- 基于预训练-finetune的模型缺少zero-shot的能力

- 之前的工作都是基于特定的任务上,很依赖于目标检测模型和数据

- 最近的一些研究也探索了没有目标检测模块的VLP,但它们仅使用小规模的纯预训练数据,因此其zero-shot能力有限

- 创新思路

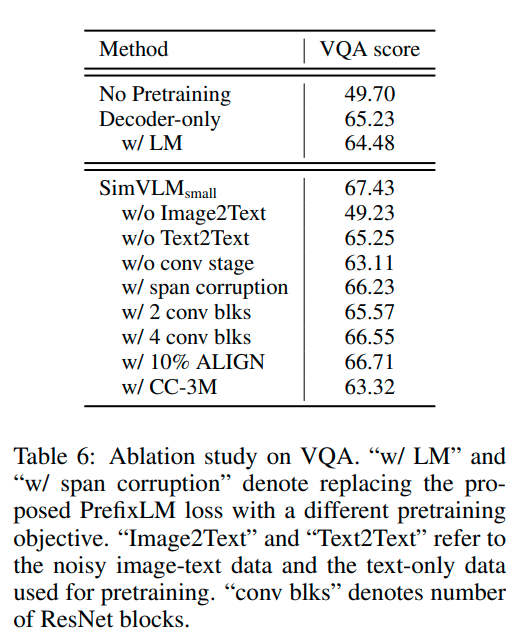

- 通过仅利用弱对齐图像-文本对上的语言建模目标,显著简化了VLP

- 仅仅使用了language model 的 loss

- 实验结论

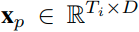

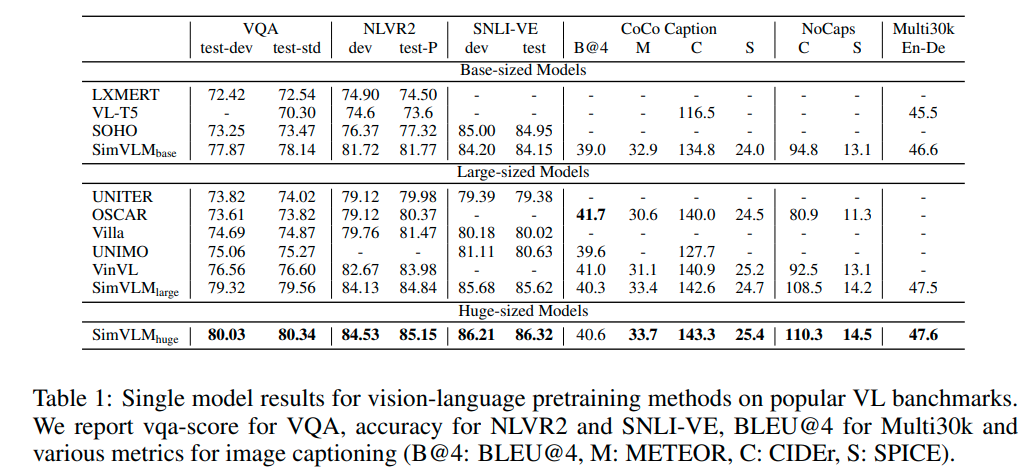

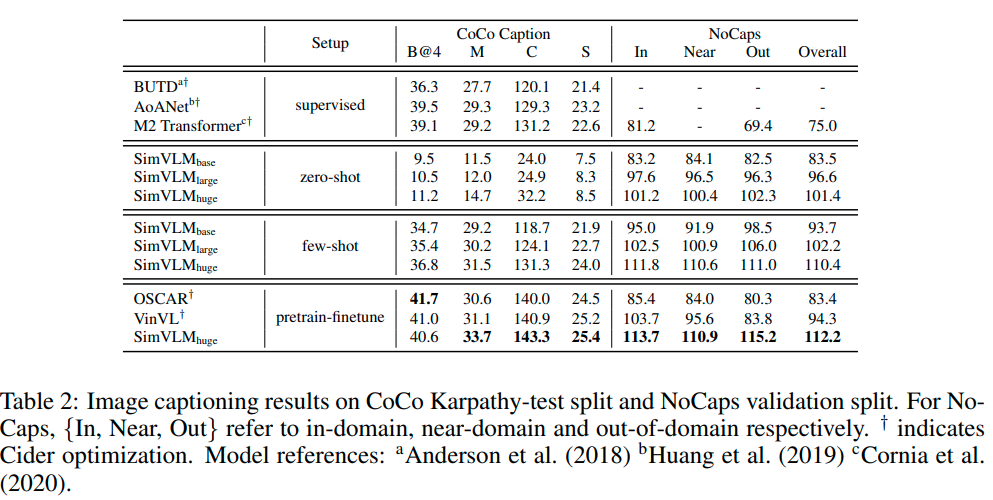

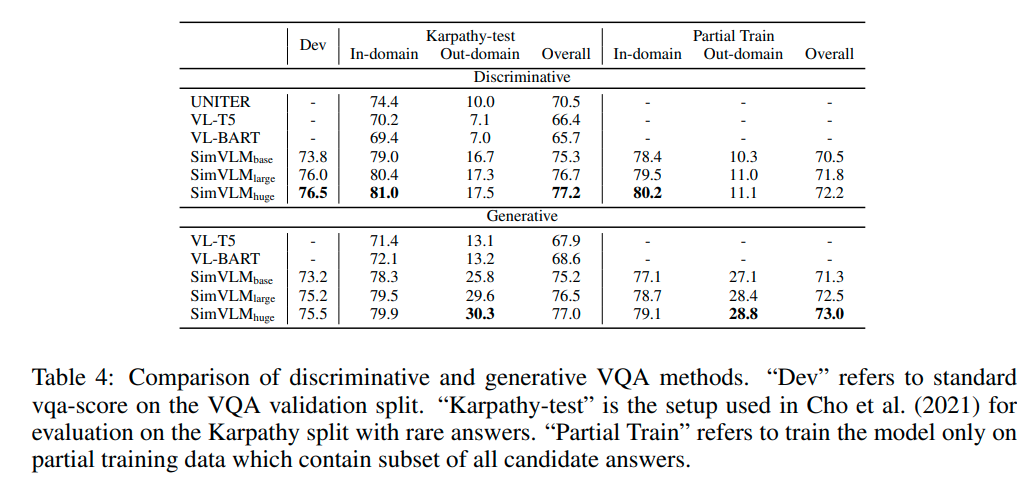

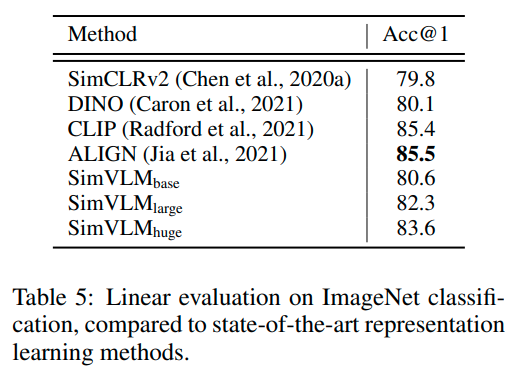

在判别和生成的vision-language benchmarks都达到了sota

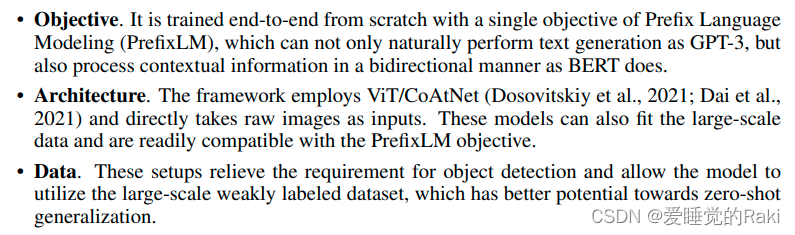

SimVLM

MLM风格的预训练已在以前的VLP模型中广泛采用,其中输入是图像-文本对,模型需要通过利用图像ROI(region-of-interest)特征来预测Masked Token

或者,单向语言建模(LM)训练模型,以在正向自回归因子分解下直接最大化序列x的可能性:

PROPOSED OBJECTIVE: PREFIX LANGUAGE MODELING

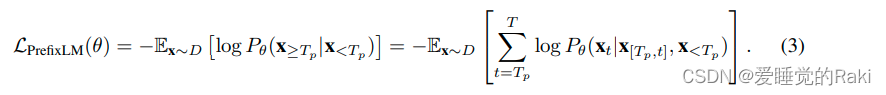

受LM损失预训练引入的zero-shot能力的启发,我们提出使用Prefix Language Modeling (PrefixLM)预处理视觉-语言表示

PrefixLM不同于标准语言模型,因此它允许对前缀序列进行双向注意力(例如,等式(3)中的x<

T

p

T_p

Tp? ),并且仅对剩余的token(例如,x)进行自回归因子分解≥式(3)中的

T

p

T_p

Tp?)。在预训练期间,长度为(随机选择的)

T

p

T_p

Tp? 的token前缀序列从输入序列中截断,训练目标变为:

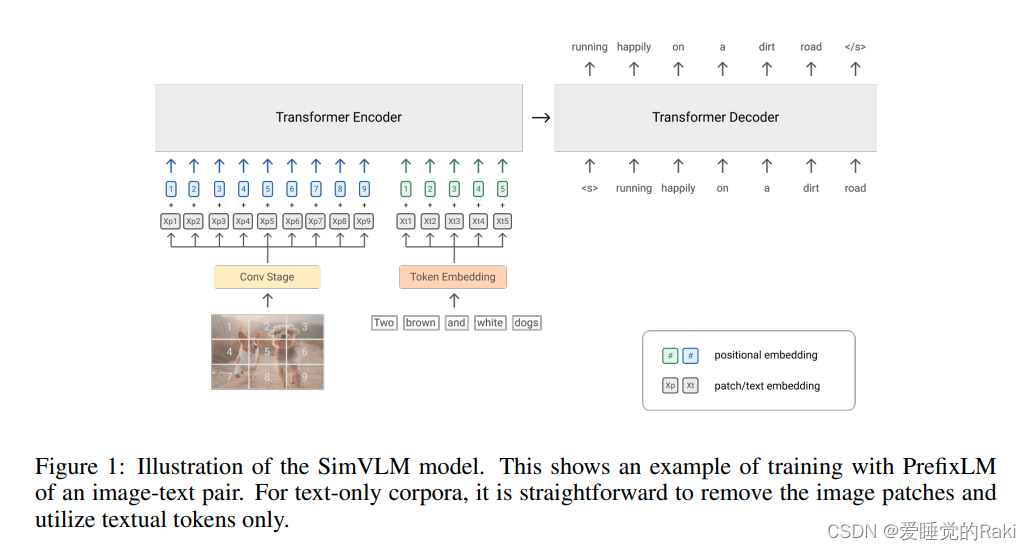

直观地说,图像可以被视为其文本描述的前缀,因为它们通常出现在web文档中的文本之前。因此,对于给定的图像-文本对,我们将长度为

T

i

T_i

Ti? 的图像特征序列预先添加到文本序列中,并强制该模型对长度为

T

p

T_p

Tp? 的前缀进行采样≥

T

i

T_i

Ti? 仅计算文本数据上的语言模型损失如图1

与以前的MLM风格的VLP方法相比,我们在序列到序列框架下的PrefixLM模型不仅享有MLM中的双向上下文表示,而且可以执行类似于LM的文本生成

使用transformer做骨干网络

与标准LM不同,PrefixLM支持前缀序列内的双向注意力,因此它仅适用于decoder和encoder-decoder seq2seq语言模型。在我们的初步实验中,我们发现编码器-解码器模型引入的inductive bias将编码与生成解耦,有助于改善下游任务

将三维的图片

展平成一维的patch作为transformer的输入

D是固定的transformer的隐藏层大小

T i T_i Ti? = H W P 2 \frac{HW}{P^2} P2HW? is the length of the image tokens for a given patch size P.

我们使用由前三个ResNet块组成的卷积来提取上下文patch,其优于ViT中使用的朴素线性投影(相当于1×1 Conv层)

对于文本模态,我们遵循标准实践将输入句子分词为sub-word token,并针对固定词汇学习嵌入

为了保留位置信息,我们分别为图像和文本输入添加了两个可训练的1D position embedding,此外,我们还为transofrmer层内的图像块添加了2D相对注意力

Experiments

由于我们的方法不依赖于对象检测模块,仅使用原始图像块输入,因此我们使用大规模有噪图像文本数据从头开始预训练所有模型参数,这对于zero-shot泛化具有更好的潜力

另一方面,我们的PrefixLM公式是模态无关的,因此我们可以另外包括纯文本语料库,以补偿alt文本数据中的噪声文本监督。正如我们后面的实验所示,这种统一的PrefixLM公式减少了模态差异,提高了模型质量

与以往由两个预训练阶段和多个辅助目标组成的VLP方法相比,我们的模型只需要一次预训练,使用端到端的单语言建模损失,因此被称为SimVLM

Conclusions

在这项工作中,我们提出了一个简单而有效的视觉语言预训练框架。与以前使用object proposal systems和辅助损失的工作不同,我们的模型将整个图像处理为patches,并使用单前缀语言建模目标进行端到端训练

我们的工作为现有的VLP范式提供了一个很有前途的替代方案,我们希望我们的工作能够启发生成VLP的未来研究

Remark

特别简单并且work的好工作,属于多模态的奠基工作,好!